Suite à la sortie de Windows Copilot, la popularité de la conférence Microsoft Build a été déclenchée par un discours.

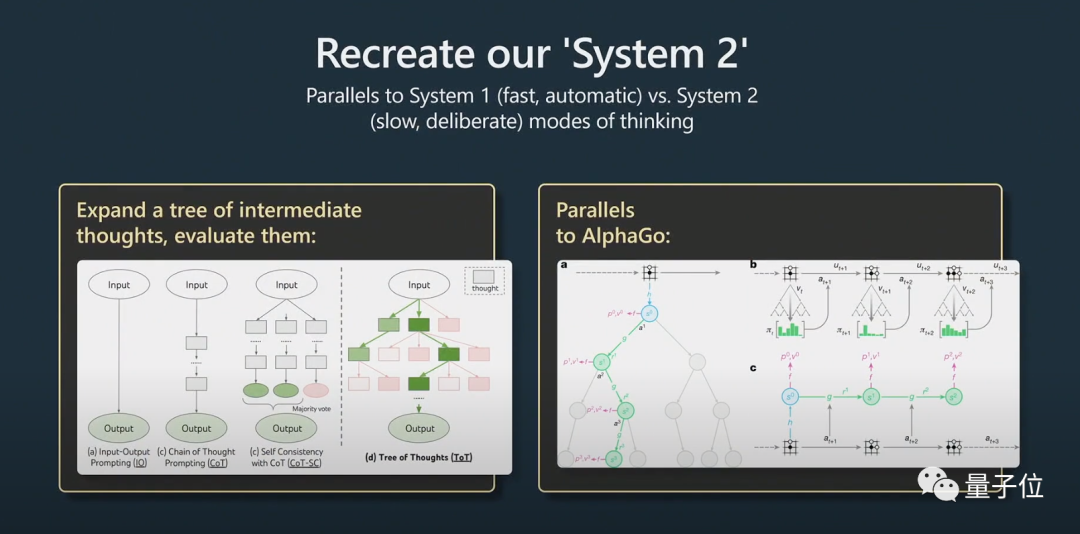

L'ancien directeur de l'IA de Tesla, Andrej Karpathy, a cru dans son discours que l'arbre des pensées est similaire au Monte Carlo Tree Search (MCTS) d'AlphaGo !

Les internautes ont crié : C'est le guide le plus détaillé et le plus intéressant sur la façon d'utiliser les grands modèles de langage et les modèles GPT-4 !

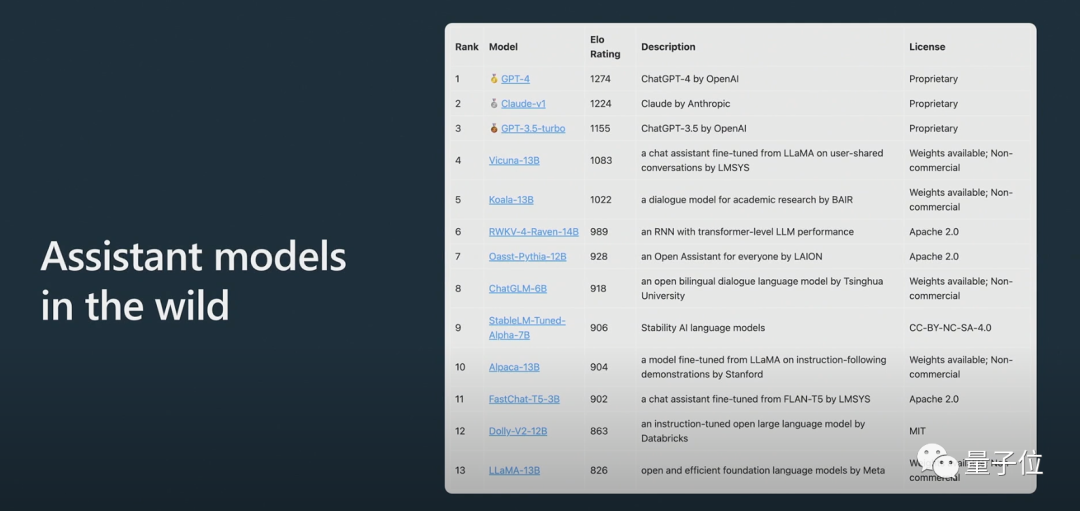

De plus, Karpathy a révélé que LLAMA 65B est "nettement plus puissant que GPT-3 175B" en raison de la formation et de l'expansion des données, et a présenté le grand modèle d'arène anonyme ChatBot Arena :

Claude obtient des scores entre ChatGPT Entre 3.5 et ChatGPT 4.

Les internautes ont déclaré que les discours de Karpathy sont toujours excellents et que le contenu cette fois n'a pas déçu tout le monde, comme toujours.

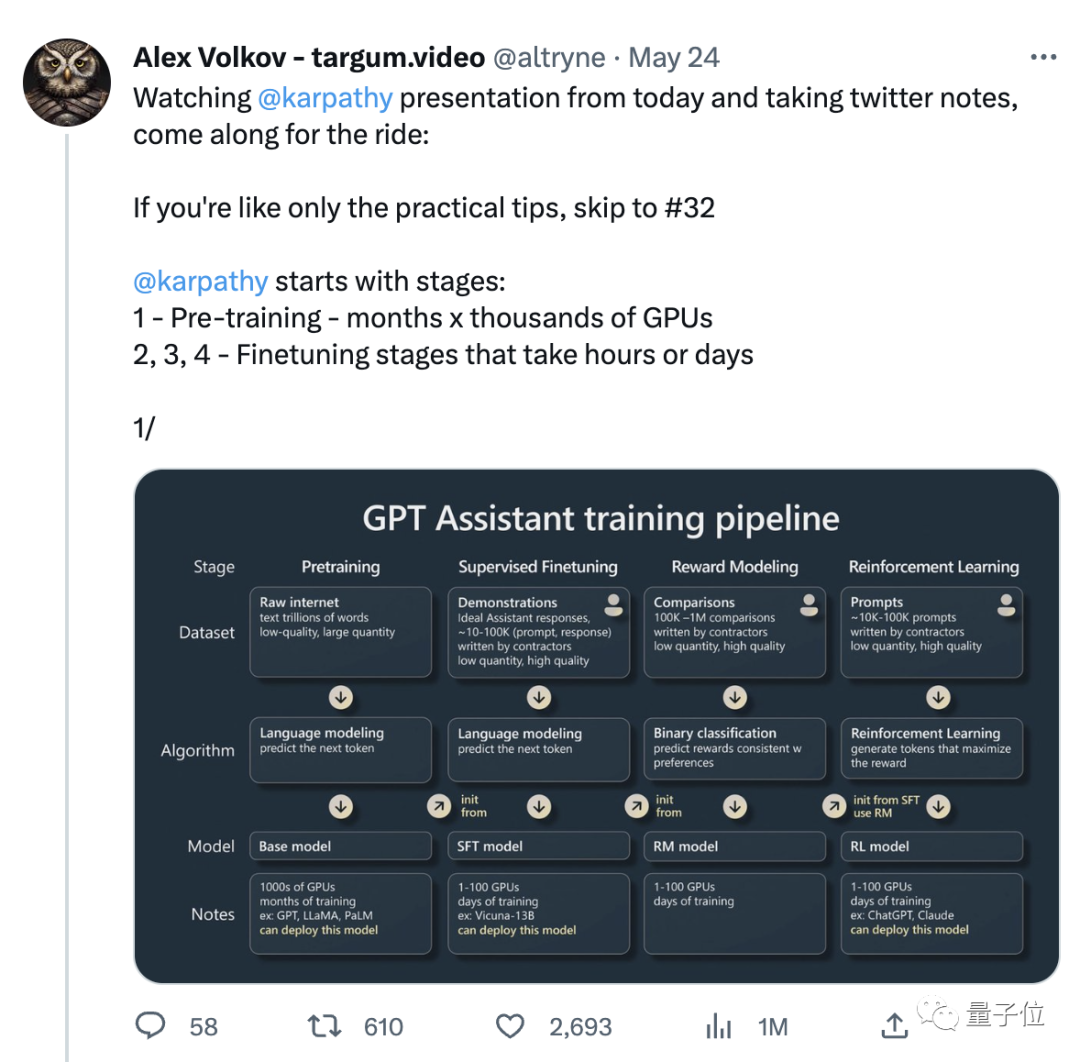

Avec le discours, il y a aussi une note que les utilisateurs de Twitter ont compilée sur la base du discours. Il y a 31 notes, et le nombre de likes a dépassé les 3000+ :

Donc, ce paragraphe est préparé. Un contenu spécifique a été mentionné dans le discours et a attiré beaucoup d'attention ?

Le discours de Karpathy est cette fois principalement divisé en deux parties.

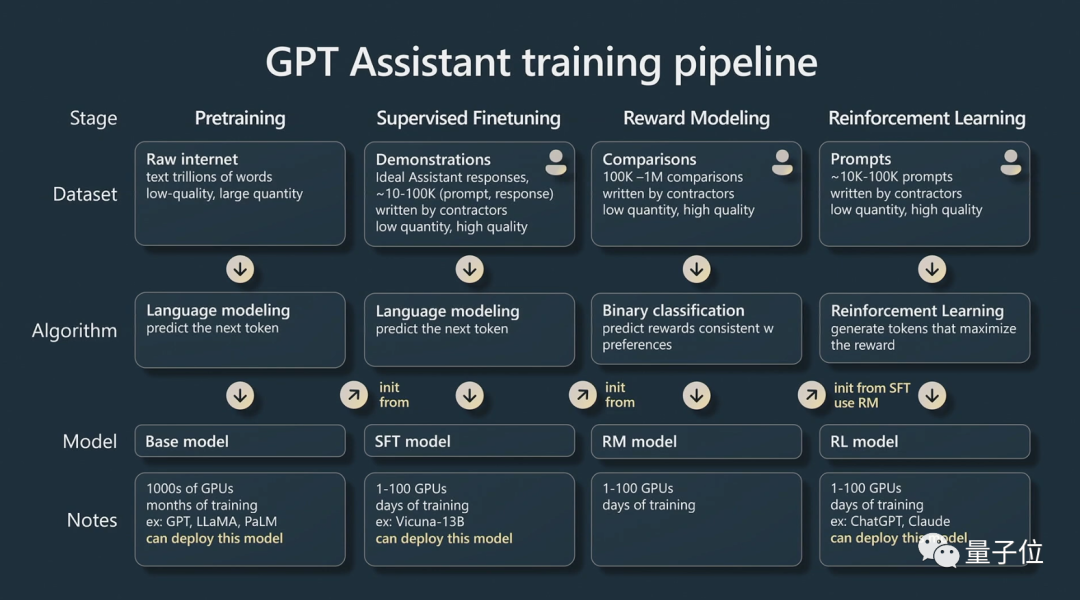

Partie 1, il a expliqué comment former un "Assistant GPT".

Karpathy parle principalement des quatre étapes de formation de l'assistant IA :

pré-formation, réglage fin supervisé, modélisation des récompenses et apprentissage par renforcement.

Chaque étape nécessite un ensemble de données.

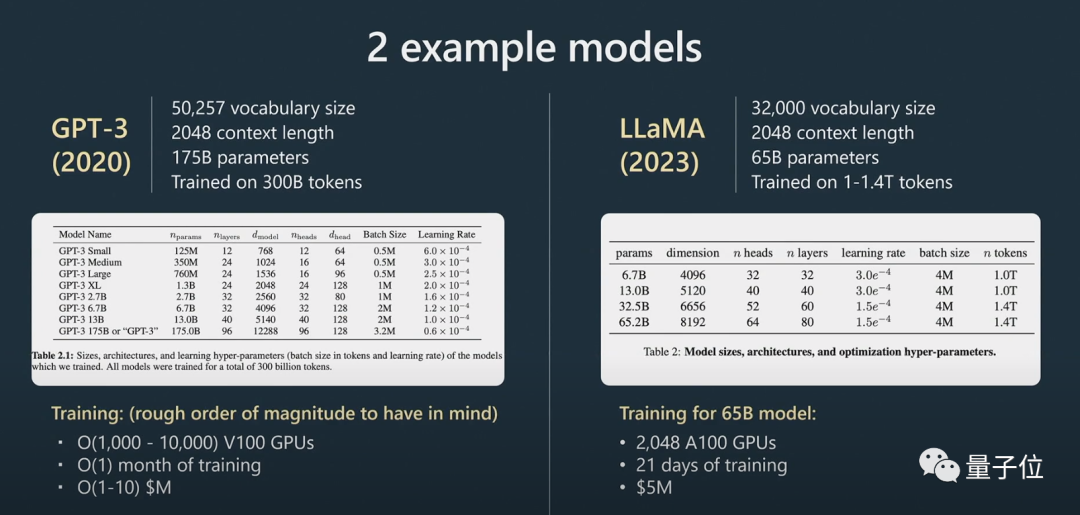

Dans la phase de pré-formation, une grande quantité de ressources informatiques doit être utilisée pour collecter un grand nombre d'ensembles de données. Un modèle de base est formé sur un vaste ensemble de données non supervisées.

Karpathy a utilisé plus d'exemples pour compléter :

Ensuite, nous entrons dans la phase de mise au point.

Utilisez un ensemble de données supervisées plus petit et affinez ce modèle de base grâce à l'apprentissage supervisé pour créer un modèle d'assistant qui peut répondre à la question.

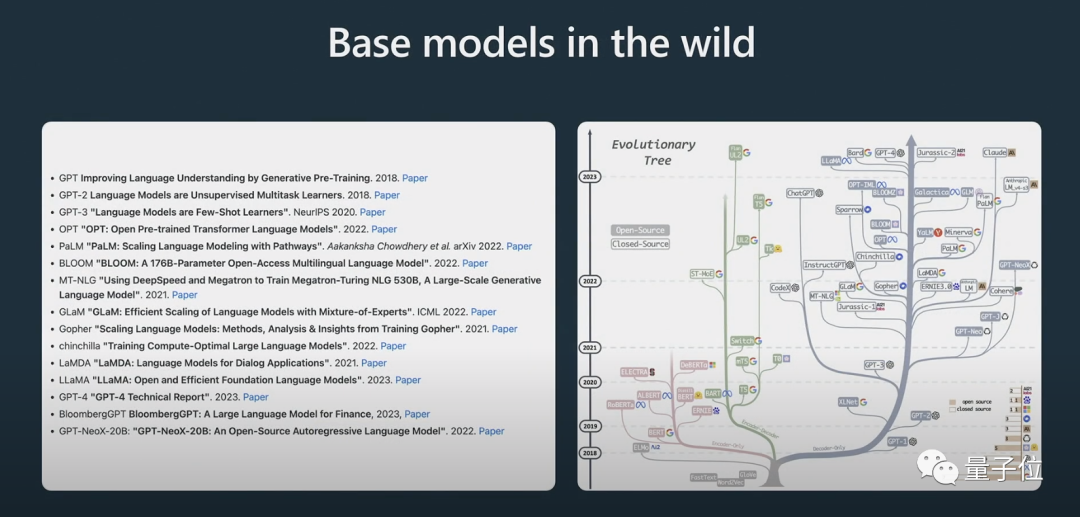

Il a également montré le processus d'évolution de certains modèles. Je crois que beaucoup de gens ont déjà vu l'image de "l'arbre évolutif" ci-dessus.

Karpathy estime que le meilleur modèle open source actuellement est la série LLaMA de Meta (car OpenAI n'a rien open source sur GPT-4).

Ce qui doit être clairement souligné ici, c'est que le modèle de base n'est pas un modèle assistant.

Bien que le modèle de base ait la capacité de résoudre le problème, les réponses qu'il donne ne sont pas dignes de confiance, tandis que le modèle assistant peut fournir des réponses fiables. Le modèle d'assistant supervisé et affiné est formé sur la base du modèle de base, et ses performances dans la génération de réponses et la compréhension de la structure du texte seront meilleures que celles du modèle de base.

L'apprentissage par renforcement est un autre processus clé lors de la formation de modèles linguistiques.

Des données annotées manuellement de haute qualité sont utilisées pendant le processus de formation et une fonction de perte est créée de manière à modéliser les récompenses pour améliorer ses performances. La formation de renforcement peut être réalisée en augmentant la probabilité de notation positive et en diminuant la probabilité de notation négative.

Le jugement humain est crucial pour améliorer les modèles d'IA lorsqu'il s'agit de tâches créatives, et les modèles peuvent être formés plus efficacement en intégrant les commentaires humains.

Après un apprentissage par renforcement avec feedback humain, un modèle RLHF peut être obtenu.

Une fois les modèles formés, l'étape suivante consiste à savoir comment utiliser efficacement ces modèles pour résoudre des problèmes.

Dans la deuxième partie de , Karpathy discute des stratégies d'incitation, des réglages fins, de l'écosystème d'outils en évolution rapide et de l'expansion future.

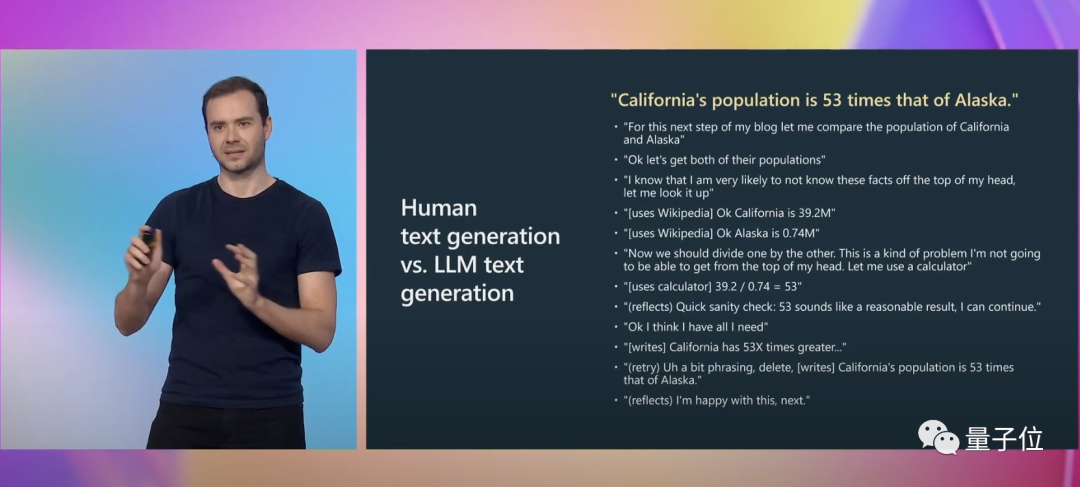

Karpathy a donné un autre exemple précis pour illustrer :

Lors de l'écriture , nous devons effectuer de nombreuses activités mentales, notamment déterminer si notre expression est exacte. Pour GPT, il s’agit simplement d’une séquence de jetons balisés.

Et invite peuvent combler cet écart cognitif.

Karpathy a expliqué plus en détail comment les invites THINKLINK fonctionnent.

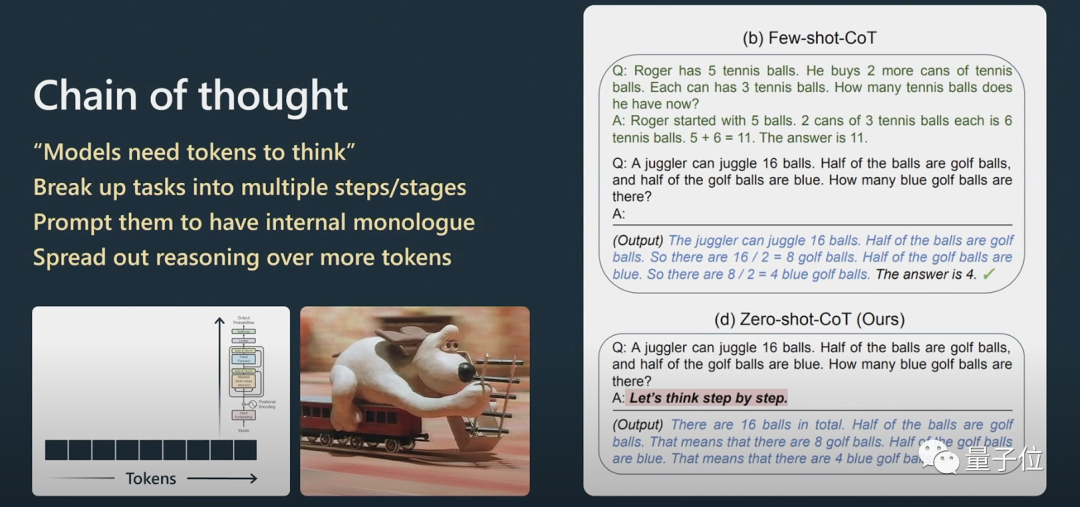

Pour les problèmes de raisonnement, si vous souhaitez que Transformer soit plus performant dans le traitement du langage naturel, vous devez le laisser traiter les informations étape par étape au lieu de lui lancer directement un problème très complexe.

Si vous lui donnez quelques exemples, il imitera le modèle de cet exemple et le résultat final sera meilleur. Un modèle ne peut répondre aux questions dans sa séquence que si ce qu'il génère est faux. Oui, vous pouvez l'inviter à se régénérer.

Si vous ne lui demandez pas de vérifier, il ne se vérifiera pas tout seul.

Le lauréat du prix Nobel d'économie Daniel Kahneman a proposé dans "Penser vite et lentement" que le système cognitif humain se compose de deux sous-systèmes, Système1 et Système2. System1 repose principalement sur l'intuition, tandis que System2 est un système d'analyse logique.Cela implique le problème du Système1 et du Système2.

En termes simples, System1 est un processus rapide et généré automatiquement, tandis que System2 est une partie bien pensée.

Quand AlphaGo joue au Go, il doit réfléchir à l'endroit où placer la pièce suivante. Au départ, il a appris en imitant les humains.

Quand AlphaGo joue au Go, il doit réfléchir à l'endroit où placer la pièce suivante. Au départ, il a appris en imitant les humains.

À cet égard, Karpathy a également mentionné AutoGPT :

Je pense que son effet n'est pas très bon à l'heure actuelle, et je ne le recommande pas vous la pratiquez. Je pense qu’avec le temps, nous pourrons peut-être tirer des leçons de son évolution.

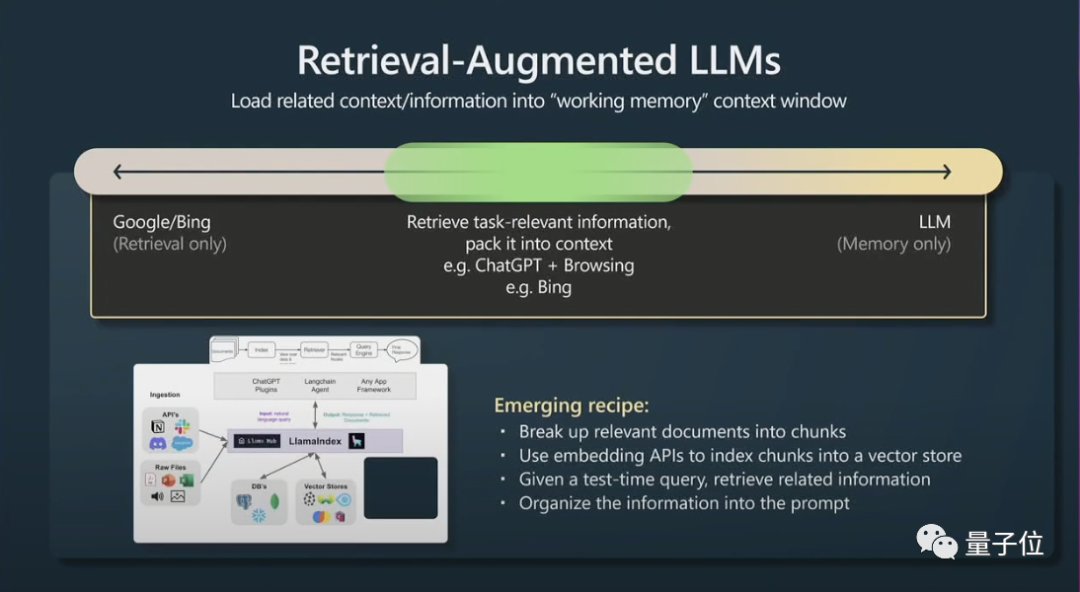

Le contenu du contexte de la fenêtre est la mémoire de travail des transformateurs au moment de l'exécution. Si vous pouvez ajouter des informations relatives aux tâches au contexte, alors ses performances seront très bonnes, car il peut accéder à ces informations maintenant. .Deuxièmement, il y a une petite astuce pour récupérer la génération améliorée (récupération de génération agumentée) et efficace indice.

En bref, cela signifie que les données pertinentes peuvent être indexées afin que le modèle soit accessible efficacement.

Les Transformers fonctionneront mieux s'ils ont également un fichier principal à référencer.

Enfin, Karpathy a brièvement parlé de l'incitation et du réglage des contraintes dans les grands modèles de langage.

Les grands modèles de langage peuvent être améliorés grâce à des conseils de contraintes et à des ajustements précis. Les conseils de contraintes appliquent les modèles dans la sortie de modèles de langage volumineux, tandis que le réglage fin ajuste les pondérations du modèle pour améliorer les performances.

Je recommande d'utiliser de grands modèles de langage dans des applications à faible risque, en les combinant toujours avec une supervision humaine, en les traitant comme une source d'inspiration et de conseils, et en envisageant des copilotes plutôt que d'en faire des agents totalement autonomes.

Le premier emploi du Dr Andrej Karpathy après l'obtention de son diplôme était d'étudier la vision par ordinateur à OpenAI.

Plus tard, Musk, l'un des co-fondateurs d'OpenAI, est tombé amoureux de Karpathy et l'a embauché chez Tesla. Musk et OpenAI étaient en désaccord sur la question, et Musk a finalement été exclu. Karpathy est responsable du pilote automatique, du FSD et d'autres projets de Tesla.

En février de cette année, 7 mois après avoir quitté Tesla, Karpathy a de nouveau rejoint OpenAI.

Récemment, il a tweeté qu'il était actuellement très intéressé par le développement de l'écosystème de grands modèles de langage open source, ce qui est un peu comme les signes de l'explosion cambrienne précoce.

Portail :

[1]https://www.youtube.com/watch?v=xO73EUwSegU (discours vidéo)

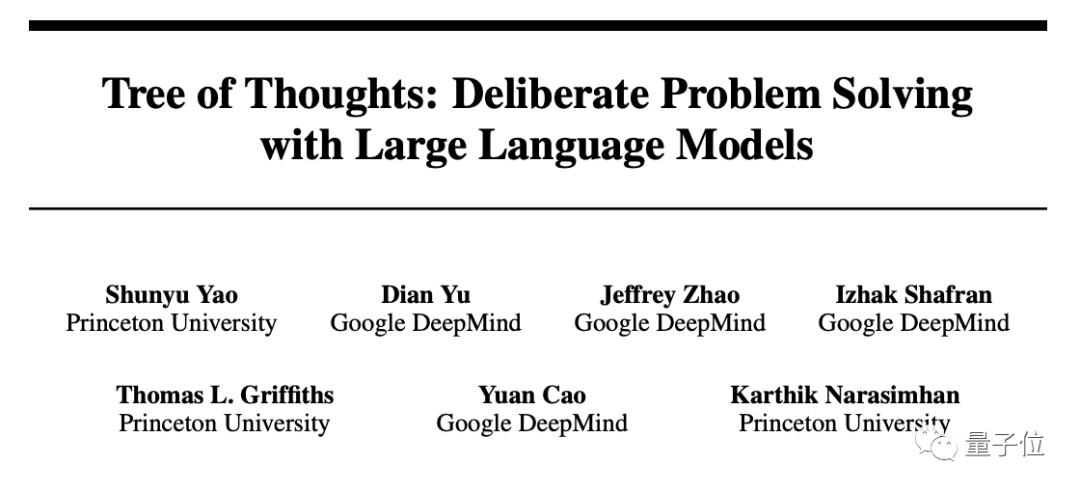

[2]https://arxiv . org/PDF/2305.10601.pdf (Thèse "Arbre de la Pensée")

Lien de référence :

[1] https://twitter.com/altryne/status/16612367888832896

[ 2 ]https://www.reddit.com/r/MachineLearning/comments/13qrtek/n_state_of_gpt_by_andrej_karpathy_in_msbuild_2023/

[3]https://www.wisdominanutshell.academy/state-of-gpt/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment vérifier l'utilisation de la mémoire JVM

Comment vérifier l'utilisation de la mémoire JVM

Comment résoudre le problème selon lequel la valeur de retour scanf est ignorée

Comment résoudre le problème selon lequel la valeur de retour scanf est ignorée

Quels sont les paramètres du chapiteau ?

Quels sont les paramètres du chapiteau ?

Utilisation de la fonction ppf en Python

Utilisation de la fonction ppf en Python

Top 10 des échanges de devises numériques les plus sécurisés en 2024

Top 10 des échanges de devises numériques les plus sécurisés en 2024

La différence entre mysql et sql_server

La différence entre mysql et sql_server

Solution au code d'erreur d'affichage de l'ordinateur 651

Solution au code d'erreur d'affichage de l'ordinateur 651

Que dois-je faire si chaturbate est bloqué ?

Que dois-je faire si chaturbate est bloqué ?