Ce modèle de segmentation vidéo de la Southern University of Science and Technology peut suivre tout ce qui se trouve dans la vidéo.

Non seulement il peut « regarder », mais il peut aussi « couper ». Il lui est également facile de supprimer des individus de la vidéo.

En termes de fonctionnement, il vous suffit de quelques clics de souris.

L'artiste d'effets spéciaux semble avoir trouvé un sauveur après avoir vu la nouvelle, affirmant sans ambages que ce produit va changer les règles du jeu dans l'industrie CGI.

Ce modèle s'appelle TAM (Track Anything Model). Est-il similaire au nom du modèle de segmentation d'image de Meta, SAM ?

En effet, TAM étend SAM au domaine vidéo, éclairant l'arbre de compétences du Dynamic Object Tracking.

Le modèle de segmentation vidéo n'est en fait pas une nouvelle technologie, mais le modèle de segmentation traditionnel n'allège pas le travail humain.

Les données d'entraînement utilisées par ces modèles nécessitent toutes une annotation manuelle et doivent même être initialisées avec les paramètres de masque d'objets spécifiques avant utilisation.

L'émergence de SAM fournit une condition préalable pour résoudre ce problème - au moins les données d'initialisation n'ont plus besoin d'être obtenues manuellement.

Bien sûr, TAM n'utilise pas SAM image par image pour ensuite le superposer. La relation spatio-temporelle correspondante doit également être construite.

L'équipe a intégré SAM avec un module de mémoire appelé XMem.

Il vous suffit d'utiliser SAM pour générer les paramètres initiaux dans la première image, et XMem peut guider le processus de suivi ultérieur.

Il peut y avoir de nombreuses cibles de suivi, comme la scène de la rivière Qingming ci-dessous :

Même la scène change, cela n'affecte pas les performances de TAM :

Nous l'avons expérimenté et avons constaté que TAM adopte Interactive interface utilisateur, très simple et conviviale à utiliser.

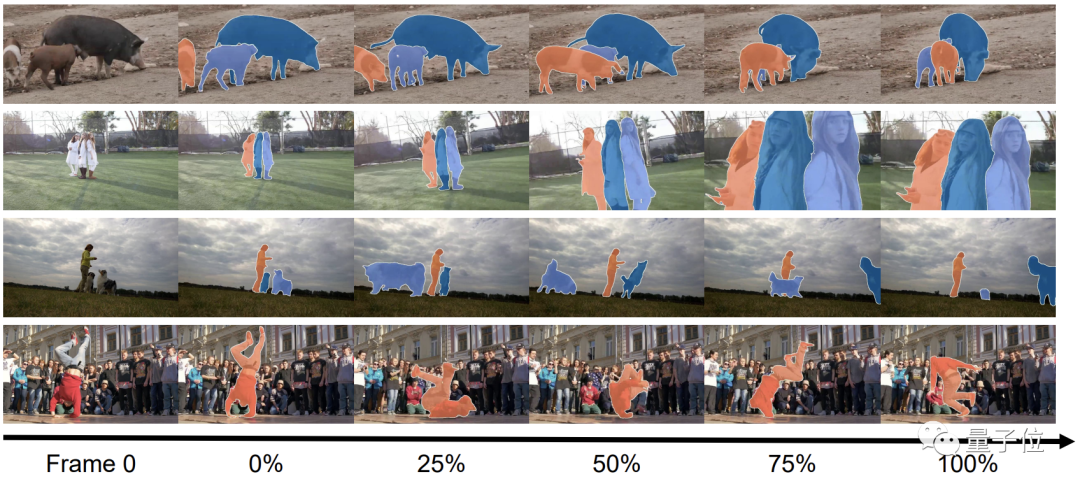

En termes de puissance dure, l'effet de suivi de TAM est en effet bon :

Cependant, la précision de la fonction d'élimination dans certains détails doit être améliorée.

Comme mentionné précédemment, TAM est implémenté sur la base de SAM en combinant les capacités de mémoire pour établir une corrélation spatio-temporelle.

Plus précisément, la première étape consiste à initialiser le modèle à l'aide des capacités de segmentation d'images statiques de SAM.

En un seul clic, SAM peut générer les paramètres de masque initiaux de l'objet cible, remplaçant ainsi le processus d'initialisation complexe des modèles de segmentation traditionnels.

Avec les paramètres initiaux, l'équipe peut le confier à XMem pour une formation d'intervention semi-manuelle, réduisant considérablement la charge de travail humaine.

Dans ce processus, certains résultats de prédiction manuelle seront utilisés pour comparer avec la sortie de XMem.

Dans le processus réel, au fil du temps, il devient de plus en plus difficile pour XMem d'obtenir des résultats de segmentation précis.

Lorsque l'écart entre les résultats et les attentes est trop important, l'étape de re-segmentation sera saisie, et cette étape est quand même complétée par SAM.

Après la réoptimisation de SAM, la plupart des résultats de sortie sont plus précis, mais certains nécessitent encore un ajustement manuel. Le processus de formation de

TAM est à peu près comme ceci, et les compétences d'élimination d'objets mentionnées au début sont formées en combinant TAM avec E2FGVI.

E2FGVI lui-même est également un outil d'élimination d'éléments vidéo Avec le soutien de la segmentation précise de TAM, son travail est plus ciblé.

Pour tester TAM, l'équipe l'a évalué à l'aide des ensembles de données DAVIS-16 et DAVIS-17.

Le ressenti intuitif est toujours très bon, et c'est vrai d'après les données.

Bien que TAM ne nécessite pas de réglage manuel des paramètres du masque, ses deux indicateurs J (similitude régionale) et F (précision des limites) sont très proches du modèle manuel.

Fonctionne même légèrement mieux que STM sur l'ensemble de données DAVIS-2017.

Parmi d'autres méthodes d'initialisation, les performances de SiamMask ne peuvent pas du tout être comparées à celles de TAM

Bien qu'une autre méthode appelée MiVOS soit plus performante que TAM, elle a évolué pendant 8 tours après ; tous ……

TAM vient de l'Intelligence Visuelle et de la Perception de Laboratoire de l'Université des sciences et technologies du Sud (VIP).

Les axes de recherche du laboratoire incluent l’apprentissage multimodèle texte-image-son, la perception multimodèle, l’apprentissage par renforcement et la détection de défauts visuels.

Actuellement, l'équipe a publié plus de 30 articles et obtenu 5 brevets.

Le chef de l'équipe est le professeur agrégé Zheng Feng de l'Université des sciences et technologies du Sud. Il a obtenu un doctorat de l'Université de Sheffield au Royaume-Uni. l'Académie chinoise des sciences, Tencent Youtu et d'autres institutions. Il est entré à l'Université des sciences et technologies du Sud en 2018 et sera admis en 2021. Promu professeur associé.

Adresse papier :

https://arxiv.org/abs/2304.11968

Page GitHub :

https://github.com/gaomingqi/Track-Anything

Lien de référence : #🎜🎜 #

https://twitter.com/bilawalsidhu/status/1650710123399233536?s=20

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Que faire avec la carte vidéo

Que faire avec la carte vidéo

Comment télécharger des vidéos de Douyin

Comment télécharger des vidéos de Douyin

La différence entre les serveurs d'applications légers et les serveurs cloud

La différence entre les serveurs d'applications légers et les serveurs cloud

Comment utiliser la fonction valeur

Comment utiliser la fonction valeur

Comment résoudre l'erreur d'analyse

Comment résoudre l'erreur d'analyse

qu'est-ce que Hadoop

qu'est-ce que Hadoop

Temps de panne du service Windows 10

Temps de panne du service Windows 10

Construisez votre propre serveur git

Construisez votre propre serveur git