Xi Xiaoyao Technology Talk Original

Auteur | iven

Le populaire AutoGPT[1] a dépassé les 100 000 collections sur Github. Cet agent auto-planifiant et auto-exécutable se concentre pour la première fois sur l’auto-ajustement et l’optimisation au sein du modèle d’intelligence artificielle.

Cependant, de nombreux internautes ont constaté que les performances d'AutoGPT sont instables et que les boucles infinies sont le phénomène le plus courant. De plus, la vitesse d'exécution d'AutoGPT est très lente. Selon les tests effectués par les internautes, New Bing met 8 secondes pour terminer la tâche, tandis qu'AutoGPT a mis 8 minutes complètes !

Le fonctionnement d'AutoGPT nécessite d'appeler l'API plusieurs fois pour une seule tâche. On calcule que le coût d'une seule tâche dépasse 100 yuans ! Évidemment, ces coûts sont élevés pour un usage personnel.

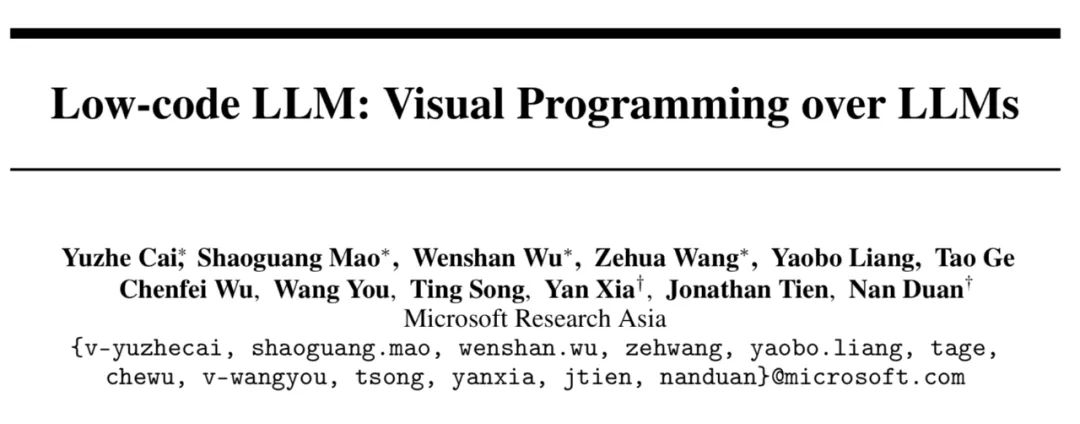

Les nouveaux travaux récents de Microsoft Research proposent un LLM Low-code, qui peut collaborer avec des agents par glisser-déposer via des opérations visuelles simples.

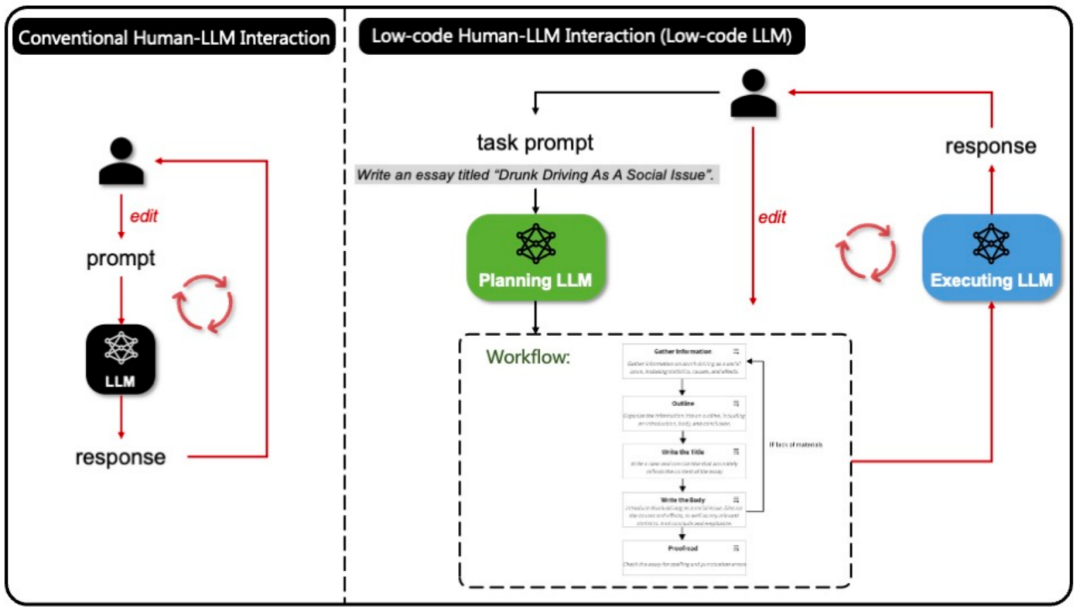

Ce mode permet d'abord à GPT de générer un organigramme de tâches, qui est très similaire à la logique d'auto-planification et d'auto-exécution d'AutoGPT, mais la différence est que les utilisateurs peuvent comprendre et modifier intuitivement et facilement l'ensemble de l'exécution. processus, contrôlant ainsi efficacement le fonctionnement de l’intelligence artificielle.

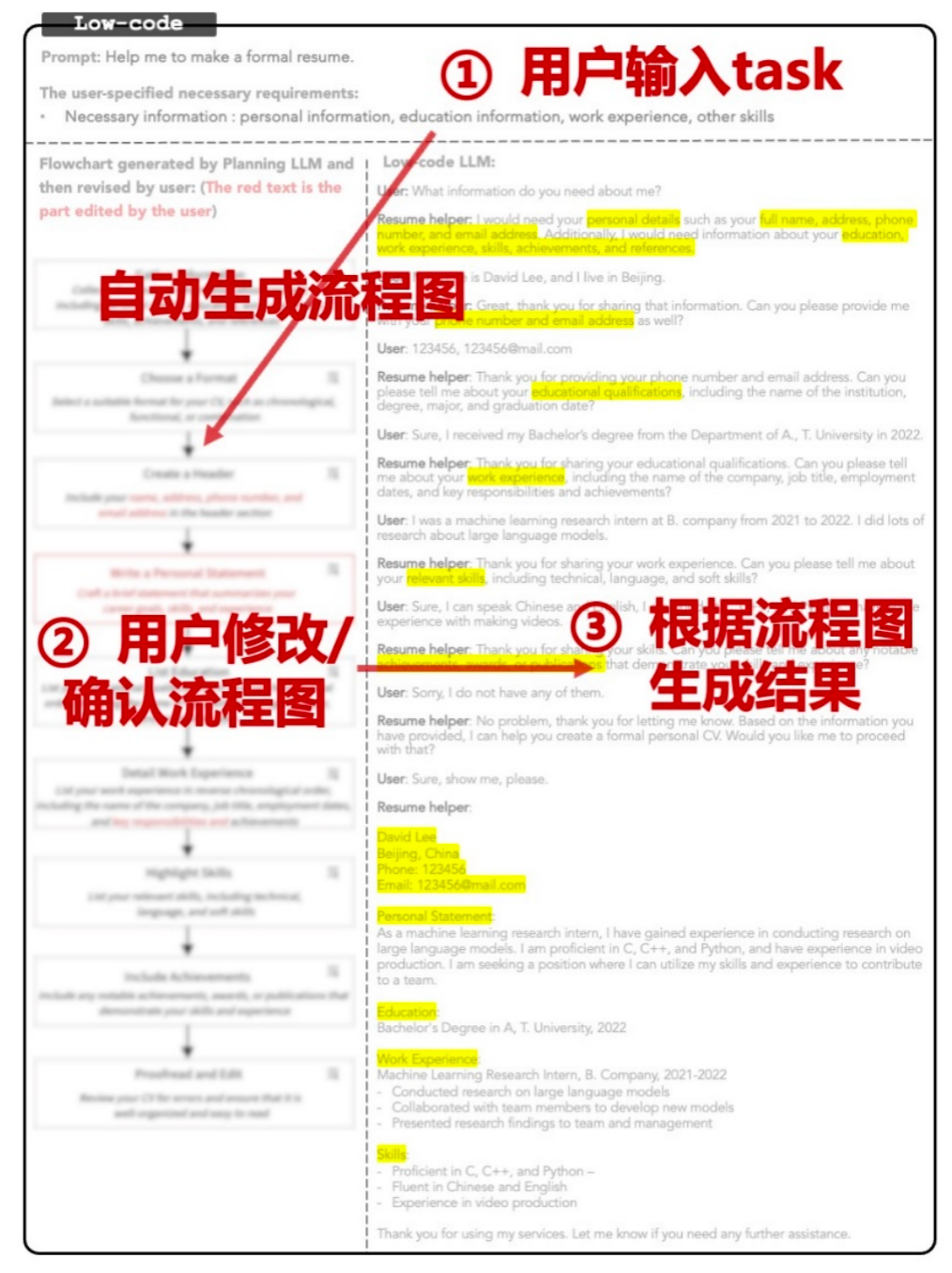

Il est appelé « Low-code » car il adopte le concept de programmation visuelle et les utilisateurs peuvent ajuster le processus par de simples clics et glissements. Pour les tâches complexes, les utilisateurs peuvent contrôler efficacement l'agent avec leurs propres idées ou préférences.

Low-code LLM génère l'organigramme en une seule conversation, et le coût d'appel de l'API est fondamentalement négligeable. De plus, cette génération unique de l'organigramme évite également le problème des boucles infinies dans AutoGPT, rendant le service plus. écurie!

L'auteur a découvert que ce travail est placé dans le Repo de Microsoft TaskMatrix.ai[2], qui a dépassé les 30 000 étoiles. Visual ChatGPT[3] fait également partie de la même équipe. TaskMatrix.AI montre comment connecter des modèles de base et un grand nombre d'API dans divers domaines pour implémenter l'automatisation des tâches (Visual ChatGPT est un exemple classique dans le domaine visuel). Le LLM Low-code récemment lancé peut jouer un rôle dans l'interaction avec les utilisateurs, en les aidant à permettre à l'IA de mieux comprendre ce que l'utilisateur veut faire.

Adresse de l'article : //m.sbmmt.com/link/de9240f5c623bf031dcf0fca9770db44

Titre de l'article : "LLM Low-code : Programmation visuelle sur LLM."

Code source ouvert : https: //m.sbmmt.com/link/141aa4fef48df77f954d60a373a3c322

6 types d'opérations low code prédéfinis

Les avantages de ce mode sont les suivants :

De plus, Low-code LLM peut également être étendu avec des API externes pour enrichir davantage les applications de scénarios. Par exemple, transmettre efficacement les idées et les préférences des utilisateurs et aider les utilisateurs à automatiser les tâches. Lors de la connexion avec d'autres outils, diverses fonctions telles que la vision et la voix peuvent être intégrées.

AutoGPT et Low-code LLM travaillent dur pour améliorer les performances et l'effet des modèles d'intelligence artificielle. Le premier se concentre sur l'auto-optimisation et l'apprentissage au sein du modèle, et le second se concentre sur la collaboration et l'interaction entre les utilisateurs et les modèles. Ces deux méthodes peuvent se compléter et obtenir de meilleures performances dans différents scénarios et tâches.

La section de remerciements du journal mentionne également qu'une partie de cet article a été générée grâce à ce modèle de coopération. Il semble qu'à l'avenir, ce n'est plus un rêve pour les gens et les grands modèles de travailler en étroite collaboration pour créer.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Obtenir la méthode du handle de fenêtre

Obtenir la méthode du handle de fenêtre

La différence entre l'API de repos et l'API

La différence entre l'API de repos et l'API

La différence entre tas et pile

La différence entre tas et pile

Quelles sont les manières d'exécuter des scripts Shell ?

Quelles sont les manières d'exécuter des scripts Shell ?

Comment utiliser le logiciel de programmation jsp

Comment utiliser le logiciel de programmation jsp

Introduction à l'emplacement d'ouverture d'exécution de Windows 10

Introduction à l'emplacement d'ouverture d'exécution de Windows 10

Que signifie l'enregistrement d'écran ?

Que signifie l'enregistrement d'écran ?

fermer le port

fermer le port