Il était une fois, l'intelligence artificielle est entrée dans un goulot d'étranglement qui a duré des décennies en raison d'une puissance de calcul insuffisante, et le GPU a déclenché l'apprentissage profond. À l'ère de ChatGPT, l'IA est à nouveau confrontée au problème de la puissance de calcul insuffisante en raison des grands modèles. Existe-t-il un moyen pour NVIDIA de le faire cette fois-ci ?

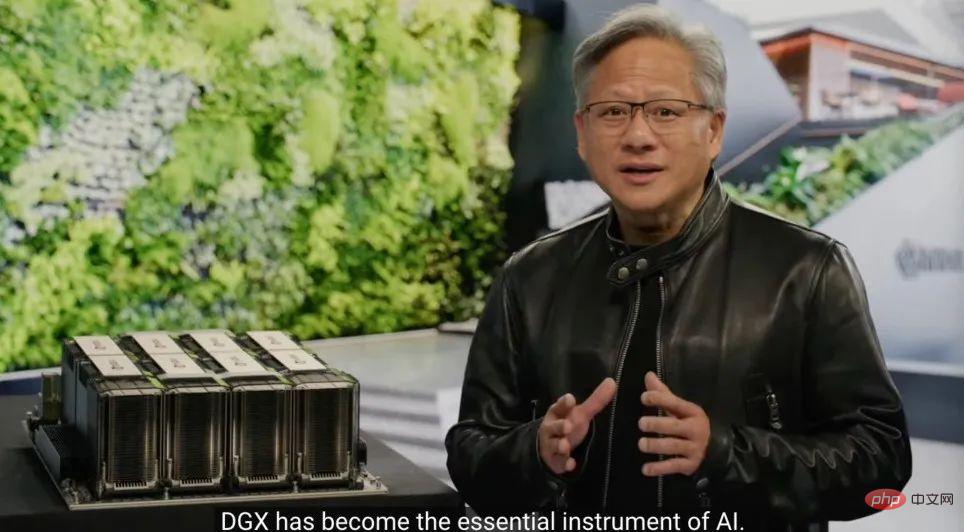

Le 22 mars, la conférence GTC a eu lieu officiellement lors de la Keynote qui vient de se tenir, le PDG de NVIDIA, Jensen Huang, a sorti les puces préparées pour ChatGPT.

"Accélérer l'informatique n'est pas facile. En 2012, le modèle de vision par ordinateur AlexNet utilisait GeForce GTX 580 et pouvait traiter 262 PetaFLOPS par seconde. Ce modèle a déclenché une révolution dans l'IA technologie Explosion", a déclaré Huang. "Dix ans plus tard, Transformer est apparu. GPT-3 a utilisé 323 ZettaFLOPS de puissance de calcul, 1 million de fois celle d'AlexNet, pour créer ChatGPT, une IA qui a choqué le monde. Une nouvelle plate-forme informatique est apparue et l'ère de l'IA sur iPhone est arrivée. ”

Le boom de l'IA a fait grimper le cours de l'action de Nvidia de 77 % cette année. est de 6 400 milliards, soit près de cinq fois celui d'Intel. Cependant, la sortie d’aujourd’hui nous indique que Nvidia ne s’est pas encore arrêté.

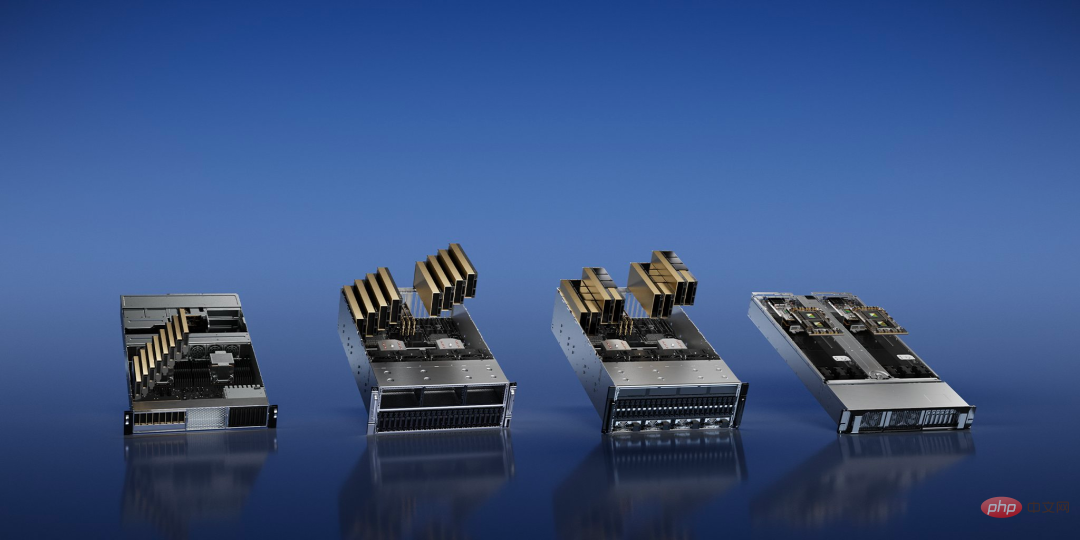

Le développement de l'IA générative (AIGC) change les besoins des entreprises technologiques en matière de puissance de calcul, NVIDIA une fois de plus, quatre plates-formes d'inférence pour les tâches d'IA sont présentées, qui utilisent toutes une architecture unifiée.

Parmi eux, NVIDIA L4 offre « des performances vidéo pilotées par l'IA 120 fois supérieures à celles du processeur, et 99 % de moins » L'« efficacité » énergétique peut être utilisée pour le streaming vidéo, l'encodage et le décodage, ainsi que pour la génération de vidéos AI ; le NVIDIA L40 avec une puissance de calcul plus élevée est spécialement utilisé pour la génération d'images 2D/3D.

En réponse à ChatGPT, qui nécessite une énorme puissance de calcul, NVIDIA a publié NVIDIA H100 NVL, un grand modèle de langage (LLM) avec 94 Go de mémoire et un Transformer Engine accéléré. Solution, GPU PCIE H100 équipé du double GPU NVLINK.

"Le seul GPU actuel capable de gérer ChatGPT est le NVIDIA HGX A100. Par rapport au premier, maintenant Un serveur standard équipé de quatre paires de H100 et d'un double NVLINK peut être 10 fois plus rapide, ce qui peut réduire d'un ordre de grandeur le coût de traitement des grands modèles de langage", a déclaré Huang.

Enfin, il y a NVIDIA Grace Hopper pour les modèles de recommandation, qui en plus d'être optimisé pour les tâches de recommandation, peut également alimenter les réseaux de neurones graphiques et les bases de données vectorielles.

Actuellement, le processus de production de semi-conducteurs s'approche des limites que la physique peut atteindre. Après le processus 2 nm, quel est le point de rupture ? NVIDIA a décidé de commencer par l'étape la plus primitive de la fabrication des puces : la photolithographie.

Fondamentalement parlant, il s'agit d'un problème d'imagerie à la limite physique. Dans le cadre de processus avancés, de nombreuses caractéristiques de la puce seront plus petites que la longueur d'onde de la lumière utilisée dans le processus d'impression, et la conception du masque doit être constamment modifiée, une étape appelée correction optique de proximité. La lithographie informatique simule le comportement de la lumière lorsqu'elle interagit avec la résine photosensible à travers l'original. Ces comportements sont décrits selon les équations de Maxwell. Il s'agit de la tâche la plus exigeante en termes de calcul dans le domaine de la conception et de la fabrication de puces.

Jen-Hsun Huang a annoncé une nouvelle technologie appelée CuLitho au GTC pour accélérer la conception et la fabrication de semi-conducteurs. Le logiciel utilise des puces Nvidia pour accélérer les étapes entre la conception logicielle de la puce et la fabrication physique des masques de photolithographie utilisés pour imprimer le motif sur la puce.

CuLitho fonctionne sur des GPU et offre des performances 40 fois supérieures à celles des technologies de lithographie actuelles, accélérant ainsi les charges de travail informatiques à grande échelle qui consomment actuellement des dizaines de milliards d'heures CPU par an. "La construction du H100 nécessite 89 masques. Lorsqu'il est exécuté sur le processeur, un masque prend deux semaines, mais si le H100 est utilisé pour fonctionner sur CuLitho, cela ne prend que 8 heures", a déclaré Huang.

Cela signifie que 500 systèmes NVIDIA DGX H100 peuvent remplacer le travail de 40 000 systèmes CPU et exécuter toutes les parties du processus de lithographie informatique, contribuant ainsi à réduire les besoins en énergie et l'impact potentiel sur l'environnement.

Cette avancée permettra aux transistors et aux circuits des puces d’être plus petits qu’aujourd’hui, tout en accélérant les délais de commercialisation des puces et en améliorant l’efficacité énergétique dans les énormes centres de données qui fonctionnent 24 heures sur 24 pour piloter le processus de fabrication.

Nvidia a déclaré qu'elle travaillait avec ASML, Synopsys et TSMC pour mettre la technologie sur le marché. Selon certaines informations, TSMC commencera à préparer la production d'essai de cette technologie en juin.

"L'industrie des puces constitue le fondement de presque toutes les autres industries dans le monde", a déclaré Huang. "Avec la technologie de lithographie aux limites de la physique, grâce à CuLitho et en collaboration avec nos partenaires TSMC, ASML et Synopsys, les usines de fabrication peuvent augmenter leur production, réduire leur empreinte carbone et jeter les bases du 2 nm et au-delà

Lors de l'événement d'aujourd'hui, NVIDIA a également annoncé un nouveau système construit à l'aide de machines quantiques, qui offre aux chercheurs travaillant sur l'informatique classique quantique hautes performances et à faible latence une nouvelle architecture révolutionnaire.

En tant que premier système informatique quantique accéléré par GPU au monde, NVIDIA DGX Quantum combine la plate-forme informatique accélérée la plus puissante au monde (implémentée par la super puce NVIDIA Grace Hopper et le modèle de programmation open source CUDA Quantum) avec le plus puissant au monde, combiné à la plate-forme de contrôle quantique avancée OPX (fournie par Quantum Machines). Cette combinaison permet aux chercheurs de créer des applications d'une puissance sans précédent qui combinent l'informatique quantique avec l'informatique classique de pointe pour permettre l'étalonnage, le contrôle, la correction d'erreurs quantiques et les algorithmes hybrides.

Au cœur de DGX Quantum se trouve un système NVIDIA Grace Hopper connecté par PCIe aux Quantum Machines OPX+, permettant une latence inférieure à la microseconde entre le GPU et l'unité de traitement quantique (QPU).

Tim Costa, directeur du HPC et du quantique chez NVIDIA, a déclaré : « Le supercalcul accéléré quantique a le potentiel de remodeler la science et l'industrie, et NVIDIA DGX Quantum permettra aux chercheurs de repousser les limites de l'informatique quantique classique. »

Oui Par conséquent, NVIDIA a intégré le GPU à architecture Hopper hautes performances avec le nouveau processeur Grace de la société dans "Grace Hopper" pour fournir une super puissance aux applications géantes d'IA et HPC. Il offre des performances jusqu'à 10 fois supérieures pour les applications exécutant des téraoctets de données, donnant ainsi aux chercheurs quantiques classiques plus de puissance pour résoudre les problèmes les plus complexes au monde.

DGX Quantum équipe également les développeurs avec NVIDIA CUDA Quantum, une puissante pile logicielle unifiée désormais open source. CUDA Quantum est une plate-forme informatique hybride quantique-classique qui intègre et programme des QPU, des GPU et des CPU dans un seul système.

37 000 $ par mois pour former votre propre ChatGPT sur la page WebMicrosoft a dépensé des centaines de millions de dollars pour acheter des dizaines de milliers d'A100 afin de construire un superordinateur dédié à GPT. Vous souhaiterez peut-être maintenant louer OpenAI et Microsoft pour former ChatGPT. et vous devez rechercher le même GPU pour entraîner votre propre grand modèle.

Le DGX Cloud proposé par NVIDIA fournit un cluster de supercalcul IA NVIDIA DGX dédié, associé au logiciel NVIDIA AI. Ce service permet à chaque entreprise d'accéder au supercalcul IA à l'aide d'un simple navigateur Web, éliminant ainsi le besoin d'acquisition, de déploiement et de gestion. complexité de l’infrastructure sur site.

Selon les rapports, chaque instance DGX Cloud dispose de huit GPU Tensor Core H100 ou A100 de 80 Go, avec un total de 640 Go de mémoire GPU par nœud. Une structure hautes performances et à faible latence construite avec NVIDIA Networking garantit que les charges de travail peuvent évoluer sur des clusters de systèmes interconnectés, permettant à plusieurs instances d'agir comme un GPU géant pour répondre aux exigences de performances de la formation avancée en IA.

Désormais, les entreprises peuvent louer un cluster DGX Cloud sur une base mensuelle pour faire évoluer rapidement et facilement le développement de grandes charges de travail de formation multi-nœuds sans attendre des ressources informatiques accélérées qui sont souvent très demandées.

Le prix de location mensuel, selon Huang Renxun, commence à 36 999 $ par instance et par mois.

"Nous sommes à l'heure de l'intelligence artificielle sur iPhone", a déclaré Huang. "Les startups se précipitent pour créer des produits et des modèles commerciaux révolutionnaires, et les opérateurs historiques cherchent à réagir. DGX Cloud offre aux clients un accès instantané au supercalcul NVIDIA AI à l'échelle mondiale. dans le cloud. "

Pour aider les entreprises à adopter la vague de l'IA générative, NVIDIA a également annoncé une série de services cloud qui permettent aux entreprises de créer et d'améliorer des modèles de langage personnalisés à grande échelle et des modèles d'IA générative.

Les utilisateurs peuvent désormais utiliser les services linguistiques NVIDIA NeMo et les services d'image, vidéo et 3D NVIDIA Picasso pour créer des applications d'IA générative propriétaires et spécifiques à un domaine pour une conversation intelligente et un support client, la création de contenu professionnel, la simulation numérique, etc. Par ailleurs, NVIDIA a annoncé de nouveaux modèles du service cloud de biologie NVIDIA BioNeMo.

"L'IA générative est un nouveau type d'ordinateur qui peut être programmé en langage humain naturel. Cette capacité est considérable : tout le monde peut commander des ordinateurs pour résoudre des problèmes, ce qui était il n'y a pas si longtemps le domaine des programmeurs. Brevet," » dit Huang.

À en juger par la publication d’aujourd’hui, NVIDIA améliore non seulement continuellement la conception matérielle pour les charges de travail d’IA des entreprises technologiques, mais propose également de nouveaux modèles économiques. Aux yeux de certains, Nvidia veut être « TSMC dans le domaine de l'IA » : en fournissant des services de fonderie de productivité avancés, comme une usine de plaquettes, en aidant d'autres entreprises à former des algorithmes d'IA pour leurs scénarios spécifiques.

Utiliser la formation sur les supercalculateurs de NVIDIA pour éliminer directement le besoin d'intermédiaires pour gagner la différence de prix, sera-ce l'orientation du futur développement de l'IA ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!