ChatGPT est le dernier modèle de langage publié par OpenAI, qui est considérablement amélioré par rapport à son prédécesseur GPT-3. Semblable à de nombreux modèles linguistiques à grande échelle, ChatGPT peut générer du texte dans différents styles et à des fins différentes, avec de meilleures performances en termes de précision, de détails narratifs et de cohérence contextuelle. Il représente la dernière génération de grands modèles de langage d’OpenAI et est conçu en mettant fortement l’accent sur l’interactivité.

OpenAI utilise une combinaison d'apprentissage supervisé et d'apprentissage par renforcement pour affiner ChatGPT, le composant d'apprentissage par renforcement rendant ChatGPT unique. OpenAI utilise la méthode de formation « apprentissage par renforcement avec retour humain » (RLHF), qui utilise le retour humain dans la formation pour minimiser les résultats inutiles, déformés ou biaisés.

Cet article analysera les limites du GPT-3 et les raisons pour lesquelles il découle du processus de formation. Il expliquera également le principe du RLHF et comprendra comment ChatGPT utilise le RLHF pour surmonter les problèmes du GPT-3. il explorera les limites de cette méthode.

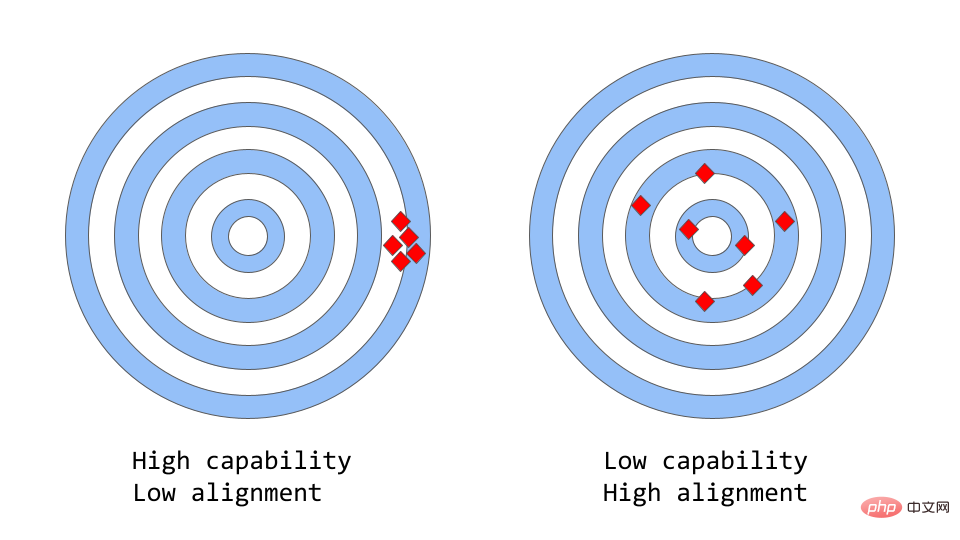

« Cohérence contre capacité » peut être considérée comme une analogie plus abstraite de « Précision contre précision ».

Dans l'apprentissage automatique, la capacité d'un modèle fait référence à la capacité du modèle à effectuer une tâche ou un ensemble de tâches spécifique. La capacité d'un modèle est généralement évaluée par la mesure dans laquelle il est capable d'optimiser sa fonction objective. Par exemple, un modèle utilisé pour prédire les prix du marché peut avoir une fonction objective qui mesure l'exactitude des prévisions du modèle. Un modèle est considéré comme ayant une grande capacité de performance s’il peut prédire avec précision les changements de tarifs au fil du temps.

La cohérence se concentre sur ce que vous voulez réellement que le modèle fasse, et non sur ce pour quoi il a été formé. La question qu'il soulève est de savoir « si la fonction objectif répond aux attentes », en fonction de la mesure dans laquelle les objectifs et les comportements du modèle répondent aux attentes humaines. Supposons que vous souhaitiez entraîner un classificateur d'oiseaux à classer les oiseaux comme « moineaux » ou « merles », en utilisant la perte logarithmique comme objectif de formation, et que le but ultime soit une très grande précision de classification. Le modèle peut avoir une faible perte de log, c'est-à-dire qu'il est plus performant mais moins précis sur l'ensemble de test. Il s'agit d'un exemple d'incohérence, dans lequel le modèle est capable d'optimiser l'objectif de formation mais est incohérent avec l'objectif final.

Le GPT-3 original est un modèle non uniforme. Les grands modèles de langage comme GPT-3 sont formés sur de grandes quantités de données textuelles provenant d'Internet et sont capables de générer du texte de type humain, mais ils ne produisent pas toujours un résultat qui correspond aux attentes humaines. En fait, leur fonction objectif est une distribution de probabilité sur une séquence de mots, utilisée pour prédire quel sera le prochain mot de la séquence.

Mais dans les applications réelles, le but de ces modèles est d'effectuer une certaine forme de travail cognitif précieux, et il existe une nette différence entre la manière dont ces modèles sont formés et la manière dont ils sont censés être utilisés. Bien que mathématiquement parlant, les machines calculant des distributions statistiques de séquences de mots puissent constituer un choix efficace pour modéliser le langage, les humains génèrent le langage en sélectionnant les séquences de texte qui correspondent le mieux à une situation donnée, en utilisant des connaissances de base connues et du bon sens pour faciliter ce processus. Cela peut poser un problème lorsque les modèles linguistiques sont utilisés dans des applications qui nécessitent un degré élevé de confiance ou de fiabilité, telles que les systèmes conversationnels ou les assistants personnels intelligents.

Bien que ces grands modèles entraînés sur d’énormes quantités de données soient devenus extrêmement puissants au cours des dernières années, ils ne parviennent souvent pas à exploiter leur potentiel lorsqu’ils sont utilisés dans la pratique pour faciliter la vie des gens. Les problèmes de cohérence dans les grands modèles de langage se manifestent souvent par :

Mais d'où vient exactement le problème de cohérence ? La manière dont le modèle linguistique est formé est-elle elle-même sujette à des incohérences ?

La prédiction du jeton suivant et la modélisation du langage masqué sont les technologies de base utilisées pour former des modèles de langage. Dans la première approche, le modèle reçoit une séquence de mots en entrée et est invité à prédire le mot suivant dans la séquence. Si vous fournissez au modèle la phrase d'entrée :

"Le chat s'est assis sur le"

il pourrait prédire le mot suivant comme "tapis", "chaise" ou "sol" car dans le contexte précédent, ces mots Le la probabilité d'occurrence est élevée ; le modèle linguistique est en fait capable d'évaluer la probabilité de chaque mot possible compte tenu de la séquence précédente. La méthode de modélisation du langage masqué est une variante de la prédiction du prochain jeton dans laquelle certains mots de la phrase d'entrée sont remplacés par des jetons spéciaux, tels que [MASK]. Il est ensuite demandé au modèle de prédire le mot correct qui doit être inséré dans la position du masque. Si le modèle reçoit une phrase :

"Le [MASQUE] est assis sur le "

il peut prédire que les mots qui doivent être renseignés dans la position MASQUE sont "chat" et "chien".L'un des avantages de ces fonctions objectives est qu'elles permettent au modèle d'apprendre la structure statistique du langage, comme les séquences de mots courantes et les modèles d'utilisation des mots. Cela aide souvent le modèle à générer un texte plus naturel et plus fluide, et constitue une étape importante dans la phase de pré-formation de chaque modèle de langage.

Cependant, ces fonctions objectives peuvent également causer des problèmes, principalement parce que le modèle ne peut pas faire la distinction entre les erreurs importantes et les erreurs sans importance. Un exemple très simple est si vous saisissez la phrase dans le modèle :

"L'Empire romain [MASK] avec le règne d'Auguste."

Il peut prédire que la position MASQUE doit être remplie par "commencé" ou ". terminé", Car la probabilité d'apparition de ces deux mots est très élevée.En général, ces stratégies de formation peuvent entraîner des incohérences dans les modèles de langage dans certaines tâches plus complexes, car un modèle entraîné uniquement pour prédire le mot suivant dans une séquence de texte n'apprendra pas nécessairement sa signification. Certaines représentations de niveau supérieur. . Par conséquent, le modèle est difficile à généraliser aux tâches qui nécessitent une compréhension plus approfondie du langage.

Les chercheurs étudient diverses méthodes pour résoudre le problème de cohérence dans les grands modèles de langage. ChatGPT est basé sur le modèle GPT-3 original, mais il a été formé davantage à l'aide de commentaires humains pour guider le processus d'apprentissage afin de résoudre les incohérences du modèle. La technologie spécifique utilisée est la RLHF susmentionnée. ChatGPT est le premier modèle à utiliser cette technologie dans des scénarios réels.

Alors, comment ChatGPT utilise-t-il les commentaires humains pour résoudre le problème de cohérence ?

Apprentissage par renforcement à partir des commentaires humains

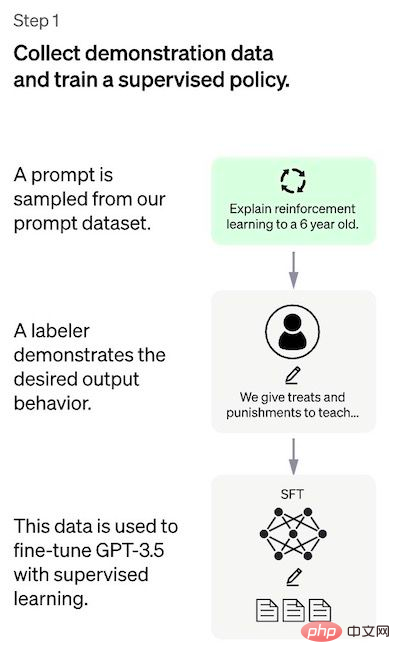

L'approche se compose généralement de trois étapes différentes :Réglage supervisé : un modèle de langage pré-entraîné est réglé sur une petite quantité de données étiquetées pour apprendre une politique supervisée (c'est-à-dire Modèle SFT) qui génère une sortie à partir d'une liste donnée d'invites ;

Étape 1 : Modèle de réglage supervisé

La première étape consiste à collecter des données pour former un modèle de politique supervisé.

Pour créer un chatbot universel comme ChatGPT, les développeurs s'adaptent à un "modèle de code" plutôt qu'à un modèle de texte brut.

En raison de la quantité limitée de données à cette étape, le modèle SFT obtenu par ce processus peut générer un texte qui ne préoccupe toujours pas l'utilisateur et souffre souvent d'incohérences. Le problème ici est que l’étape d’apprentissage supervisé a un coût d’évolutivité élevé.

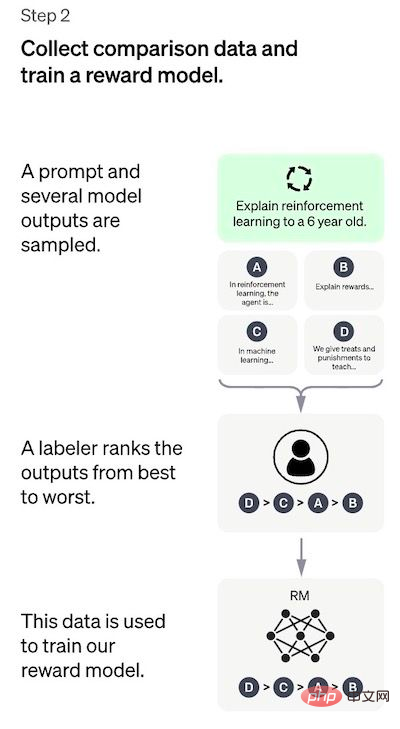

Pour surmonter ce problème, la stratégie utilisée consiste à demander à des annotateurs humains de trier les différentes sorties du modèle SFT pour créer le modèle RM, plutôt que de demander aux annotateurs humains de créer un ensemble de données organisé plus grand.

Étape 2 : Entraînement du modèle de récompense

Le but de cette étape est d'apprendre la fonction objectif directement à partir des données. Le but de cette fonction est d'évaluer les résultats du modèle SFT, ce qui représente à quel point ces résultats sont souhaitables pour les humains. Cela reflète fortement les préférences spécifiques des annotateurs humains sélectionnés et les lignes directrices communes qu'ils acceptent de suivre. En fin de compte, ce processus aboutira à un système qui imite les préférences humaines à partir des données.

Comment cela fonctionne :

Il est beaucoup plus facile pour l'annotateur de trier le résultat que de l'étiqueter à partir de zéro, et le processus peut évoluer plus efficacement. En pratique, le nombre d'invites sélectionnées est d'environ 30 à 40 000 et comprend différentes combinaisons de sorties triées.

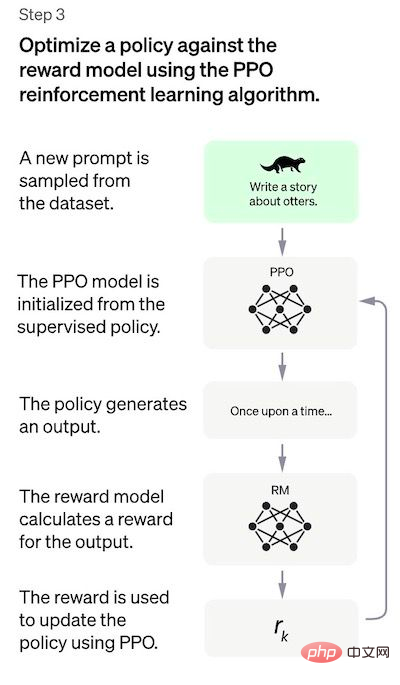

Étape 3 : Affiner le modèle SFT à l'aide du modèle PPO

Dans cette étape, l'apprentissage par renforcement est appliqué pour affiner le modèle SFT en optimisant le modèle RM. L'algorithme spécifique utilisé est appelé optimisation de politique proximale (PPO) et le modèle de réglage est appelé modèle d'optimisation de politique proximale.

Qu'est-ce que la PPO ? Les principales caractéristiques de cet algorithme sont les suivantes :

Dans cette étape, le modèle PPO est initialisé par le modèle SFT et la fonction valeur est initialisée par le modèle RM. Cet environnement est un « environnement de bandit » qui génère des invites aléatoires et attend des réponses aux invites. Pour une invite et une réponse données, il génère une récompense correspondante (déterminée par le modèle RM). Le modèle SFT ajoute un facteur de pénalité KL à chaque jeton pour tenter d'éviter une sur-optimisation du modèle RM.

Étant donné que le modèle est formé sur la base d'une entrée annotée par l'homme, la partie centrale de l'évaluation est également basée sur l'entrée humaine, c'est-à-dire en demandant aux annotateurs d'évaluer la qualité de la sortie du modèle. Pour éviter de surajuster les jugements des annotateurs impliqués dans la phase de formation, l'ensemble de tests a utilisé des invites d'autres clients OpenAI qui n'apparaissaient pas dans les données de formation.

Le modèle est évalué selon trois critères :

Le modèle a également été évalué sur les performances de l'apprentissage zéro-shot sur les tâches PNL traditionnelles telles que la réponse aux questions, la compréhension en lecture et le résumé. Les développeurs ont constaté que le modèle fonctionnait moins bien que GPT-3 sur certaines de ces tâches. . , qui est un exemple de « taxe d’alignement » dans laquelle les procédures d’alignement basées sur l’apprentissage par renforcement par rétroaction humaine se font au détriment de la performance sur certaines tâches.

La régression des performances sur ces ensembles de données peut être considérablement réduite par une astuce appelée mélange de pré-entraînement : lors de l'entraînement du modèle PPO via la descente de gradient, les mises à jour de gradient sont calculées en mélangeant les gradients du modèle SFT et du modèle PPO.

Une limitation très évidente de cette méthode est que les données utilisées pour le modèle de réglage fin sont soumises à une variété de facteurs complexes et subjectifs dans le processus d'alignement du modèle de langage avec l'intention humaine. Les influences incluent principalement :

Les auteurs de ChatGPT reconnaissent également le fait évident que les annotateurs et les chercheurs impliqués dans le processus de formation peuvent ne pas représenter pleinement tous les utilisateurs finaux potentiels des modèles de langage.

En plus de cette limitation "endogène" évidente, cette méthode présente également d'autres défauts et problèmes qui doivent être résolus :

Lecture connexe :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!