Ces dernières années, les modèles augmentés de big data sont devenus le paradigme standard pour la modélisation dans le domaine de l'IA. Dans la scène publicitaire, les grands modèles utilisent plus de paramètres de modèle et utilisent plus de données de formation. Les modèles ont des capacités de mémoire et de généralisation plus fortes, ouvrant plus d'espace pour améliorer les effets publicitaires. Cependant, les ressources requises pour les grands modèles dans le processus de formation ont également augmenté de façon exponentielle, et la pression de stockage et de calcul constitue d'énormes défis pour la plate-forme d'apprentissage automatique.

La plate-forme d'apprentissage automatique Tencent Taiji continue d'explorer des solutions de réduction des coûts et d'amélioration de l'efficacité. Elle utilise des ressources de déploiement hybrides dans des scénarios de formation publicitaire hors ligne pour réduire considérablement les coûts des ressources. Elle fournit chaque jour à Tencent Advertising des ressources de déploiement hybrides bon marché de 50 W. La formation du modèle hors ligne Tencent Advertising est réduite de 30 % et grâce à une série de méthodes d'optimisation, la stabilité des ressources colocalisées est égale à celle des ressources normales.

Ces dernières années, alors que les grands modèles ont obtenu un grand succès dans le balayage de diverses commandes de Big Data dans le domaine de la PNL, les modèles Big Data et sont devenus le paradigme standard pour la modélisation dans le domaine de l'IA. La modélisation de la recherche, de la publicité et des recommandations ne fait pas exception. Avec des centaines de milliards de paramètres à chaque tour, les modèles de taille T sont devenus la norme pour les principaux scénarios de prédiction. Les capacités des grands modèles sont également devenues le point central de la course aux armements parmi les principales technologies. entreprises.

Dans la scène publicitaire, les grands modèles utilisent plus de paramètres de modèle et utilisent plus de données de formation. Le modèle a des capacités de mémoire et de généralisation plus fortes, ouvrant plus d'espace pour l'amélioration des effets publicitaires. Cependant, les ressources requises pour les grands modèles dans le processus de formation ont également augmenté de façon exponentielle, et la pression de stockage et de calcul constitue d'énormes défis pour la plate-forme d'apprentissage automatique. Dans le même temps, le nombre d'expériences que la plate-forme peut prendre en charge affecte directement l'efficacité des itérations de l'algorithme. La manière de fournir davantage de ressources expérimentales à moindre coût est au centre des efforts de la plate-forme.

La plate-forme d'apprentissage automatique Tencent Taiji continue d'explorer des solutions de réduction des coûts et d'amélioration de l'efficacité. Elle utilise des ressources de déploiement hybrides dans des scénarios de formation publicitaire hors ligne pour réduire considérablement les coûts des ressources. Elle fournit chaque jour à Tencent Advertising des ressources de déploiement hybrides bon marché de 50 W. La formation du modèle hors ligne Tencent Advertising est réduite de 30 % et grâce à une série de méthodes d'optimisation, la stabilité des ressources colocalisées est la même que celle des ressources normales.

La plateforme d'apprentissage automatique Taiji s'engage à permettre aux utilisateurs de se concentrer davantage sur la résolution de problèmes et les applications de l'IA d'entreprise, et aux ingénieurs en algorithmes de solutions uniques pour proposer le traitement dans le processus de candidature à l'IA, la formation des modèles, le service de modèles et d'autres problèmes d'ingénierie. Actuellement, il prend en charge des activités clés telles que la publicité interne, la recherche, les jeux, Tencent Conference et Tencent Cloud.

Taiji Advertising Platform est une plate-forme d'apprentissage automatique haute performance conçue par Taiji Advertising System qui intègre la formation de modèles et le raisonnement en ligne. La plate-forme possède les capacités de formation et de raisonnement de modèles à mille milliards de paramètres. Actuellement, la plate-forme prend en charge le rappel publicitaire Tencent, le classement approximatif, le classement fin, des dizaines de formations de modèles et l'inférence en ligne en même temps, la plate-forme Taiji fournit un enregistrement de fonctionnalités à guichet unique, un enregistrement supplémentaire d'échantillons, une formation de modèles, une évaluation de modèles et des tests en ligne ; capacités, améliorant considérablement les capacités Améliorer l'efficacité des développeurs.

Avec le développement continu de la plateforme Taiji, le nombre de tâches et de types de tâches augmentent et les besoins en ressources sont également en augmentation. Afin de réduire les coûts et d'augmenter l'efficacité, la plateforme de Tai Chi, d'une part, améliore les performances de la plateforme et accélère la formation, d'autre part, nous recherchons également des ressources moins chères pour répondre à la demande croissante de ressources ;

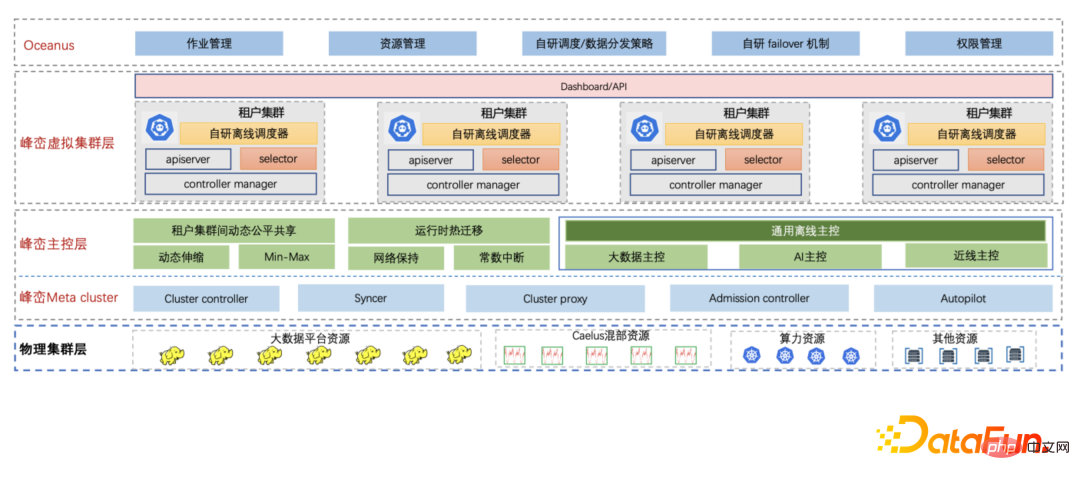

Fengluan - La plate-forme Big Data interne cloud native de Tencent utilise la technologie cloud native pour mettre à niveau l'ensemble de l'architecture Big data de l'entreprise. Afin de répondre à la demande croissante en ressources des entreprises du Big Data, Fengluan a introduit des ressources de colocalisation, qui peuvent non seulement répondre à la demande en ressources, mais également réduire considérablement les coûts des ressources. Fengluan propose une série de solutions pour les ressources de colocalisation dans différents scénarios, transformant les ressources de colocalisation instables en ressources stables et transparentes pour l'entreprise. La capacité de colocalisation de Fengluan prend en charge trois types de ressources de colocalisation :

Dans le même temps, Fengluan introduit la technologie de cluster virtuel cloud-native pour protéger les caractéristiques de dispersion causées par les ressources de colocalisation sous-jacentes provenant de différentes villes et régions. La plate-forme Taiji se connecte directement au cluster de locataires Fengluan, qui correspond à une variété de ressources de colocalisation sous-jacentes. Le cluster de locataires a une perspective de cluster indépendante et complète, et la plate-forme Taiji peut également être connectée de manière transparente.

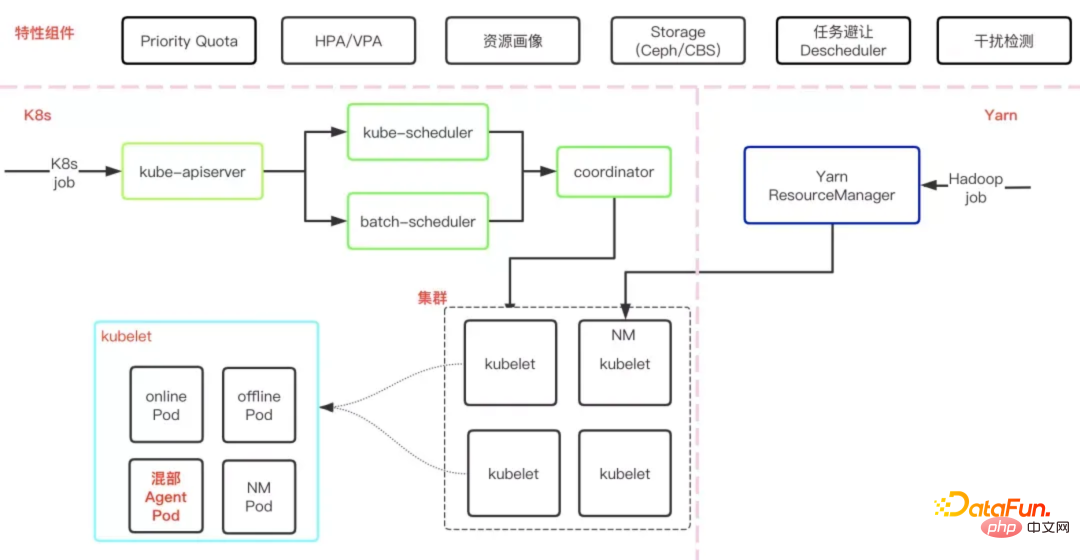

Fengluan a auto-développé la solution de colocalisation hors ligne Caelus pour tous les scénarios, en mélangeant les opérations en ligne et les opérations hors ligne Cette méthode exploite pleinement les ressources inutilisées des machines en ligne, améliore l'utilisation des ressources des machines en ligne et réduit le coût des ressources des opérations hors ligne.

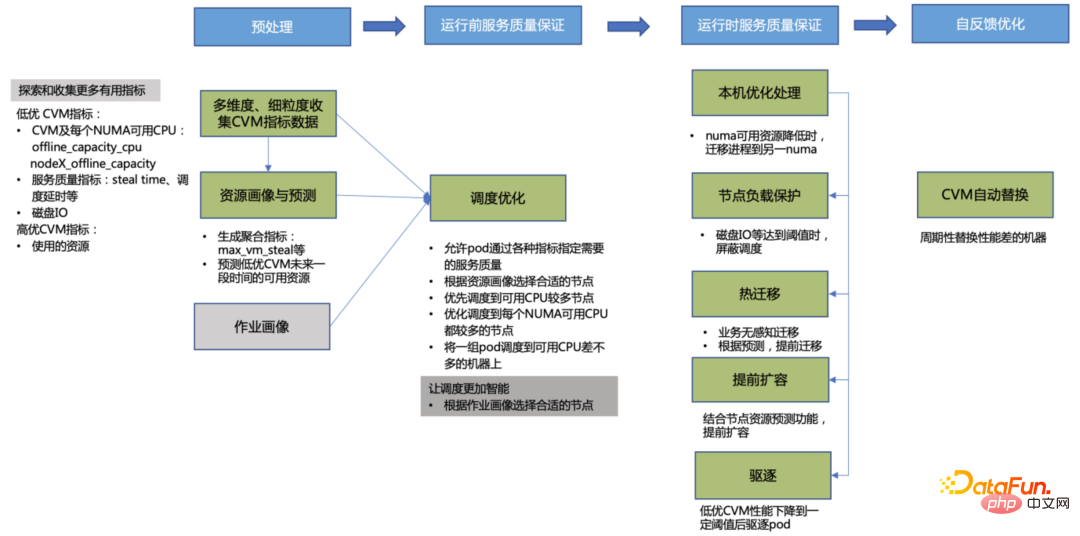

Comme le montre la figure ci-dessous, il s'agit de l'architecture de base de Caelus. Les différents composants et modules coopèrent entre eux pour assurer la qualité du déploiement mixte sous de nombreux aspects.

Tout d'abord, Caelus garantit la qualité de service des opérations en ligne de manière globale, ce qui est également l'une des conditions préalables importantes à la colocalisation. Par exemple, grâce à des mécanismes de détection et de traitement rapides des interférences, il détecte activement. la qualité des services en ligne, les gère en temps opportun et prend en charge la méthode d'extension du plug-in qui prend en charge les exigences spécifiques de détection des interférences de l'entreprise grâce à une isolation complète des ressources, des stratégies de gestion flexibles des ressources, etc., elle garantit la haute qualité des services en ligne ; priorité aux services en ligne.

Deuxièmement, Caelus assure le SLO des emplois hors ligne sous de nombreux aspects, tels que : faire correspondre les ressources appropriées aux emplois via des ressources de colocalisation et des portraits d'emploi hors ligne pour éviter la concurrence des ressources, optimiser les stratégies d'expulsion d'emplois hors ligne, hiérarchiser les expulsions et soutenir une sortie en douceur ; , la stratégie est flexible et contrôlable. Contrairement aux tâches hors ligne Big Data, qui sont pour la plupart des tâches courtes (minutes, voire secondes), la plupart des tâches de Tai Chi prennent plus de temps à s'exécuter (heures, voire jours). Grâce à la prévision des ressources à long terme et aux portraits d'emploi, nous pouvons mieux guider la planification pour trouver des ressources appropriées pour les travaux avec des durées d'exécution différentes et des besoins en ressources différents, et éviter que les emplois ne soient expulsés après avoir fonctionné pendant des heures, voire des jours, entraînant une perte de statut d'emploi. perte de ressources et de temps. Lorsqu'une tâche hors ligne doit être expulsée, la migration dynamique d'exécution sera d'abord utilisée pour migrer l'instance de tâche d'une machine à une autre, tout en gardant l'état de la mémoire et l'adresse IP inchangés. Il n'y aura presque aucun impact sur la tâche, ce qui améliore considérablement la situation. efficacité du travail. Afin de mieux utiliser les ressources de colocalisation, Caelus dispose également de plus de fonctionnalités. Pour plus de détails, consultez la solution de colocalisation hors ligne avec scénario complet de Caelus(//m.sbmmt.com. /link /caaeb10544b465034f389991efc90877).

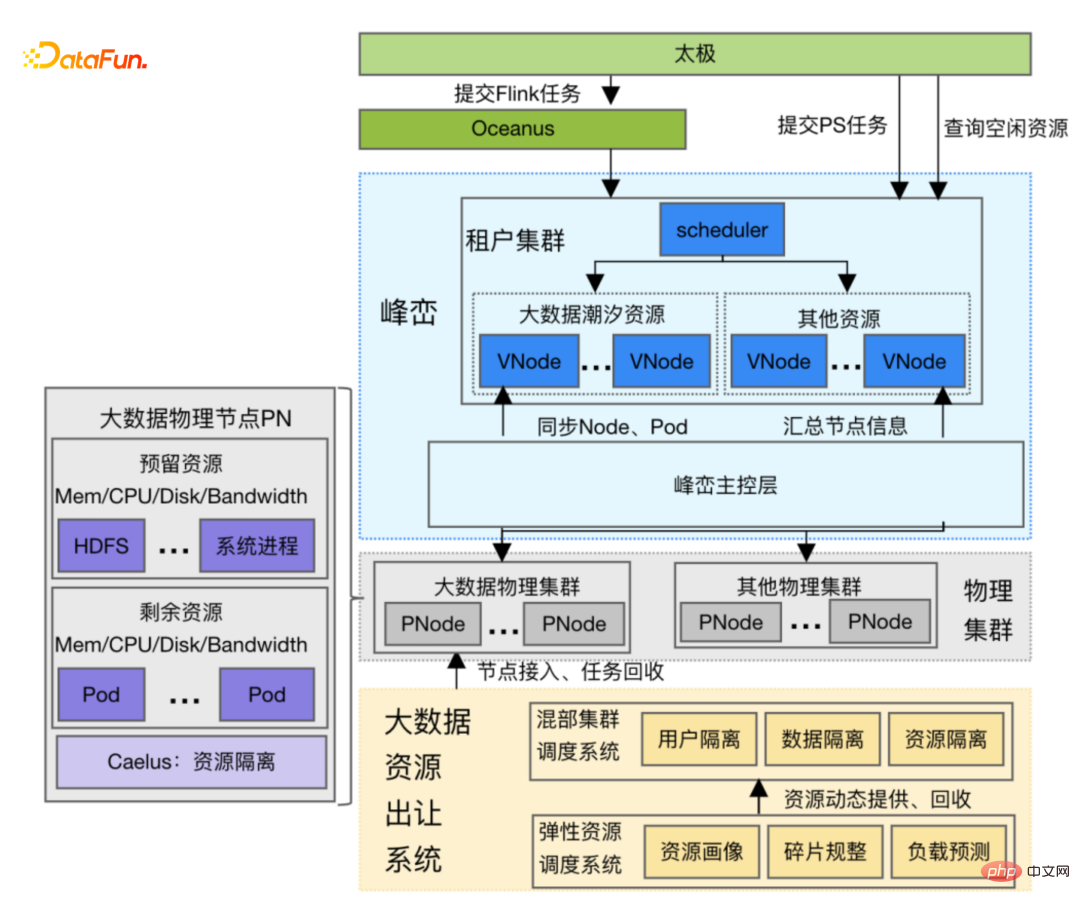

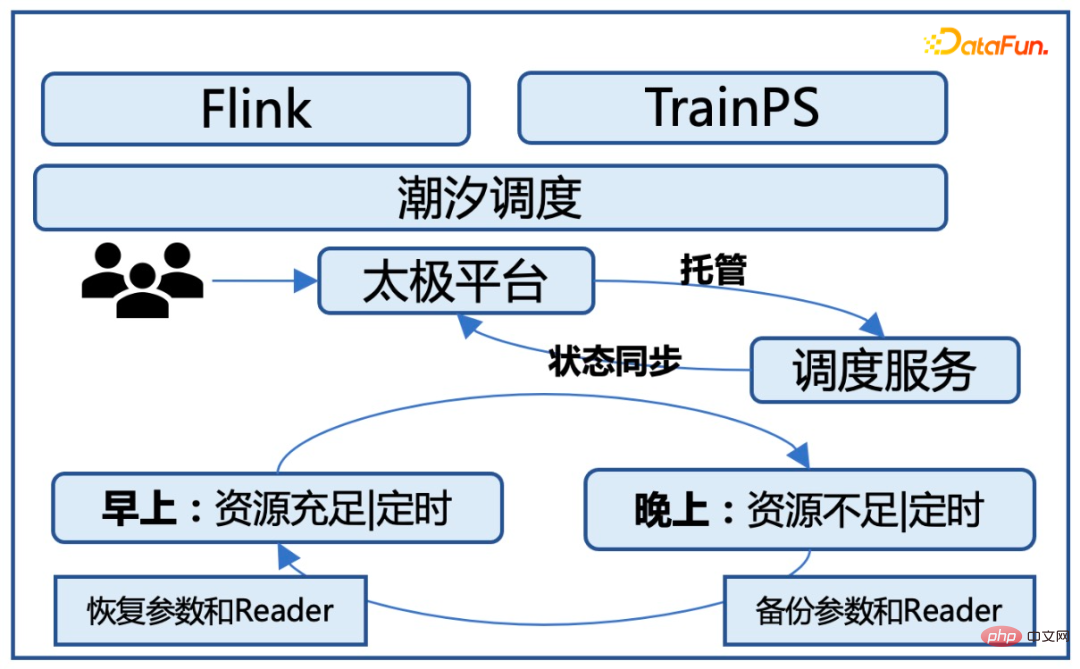

Les tâches Big Data ont généralement relativement peu de tâches pendant la journée et plus de tâches la nuit. Fengluan transfère une partie des ressources Big Data inutilisées pendant la journée vers la plate-forme Taiji, et. recycle cette partie les ressources nocturnes, nous appelons cette ressource ressources marémotrices. La caractéristique des ressources Tidal est que les tâches Big Data sur les nœuds sont presque complètement abandonnées, mais le service de stockage Big Data HDFS est toujours conservé sur les nœuds. Le service HDFS ne peut pas être affecté lors de l'exécution de tâches de Tai Chi. Lorsque la plate-forme Taiji utilise des ressources marémotrices, elle doit parvenir à un accord avec la plate-forme Fengluan. La plate-forme Fengluan examinera à l'avance un lot de nœuds sur la base des données historiques à un moment précis. Une fois la tâche Big Data terminée, elle le fera. informez la plate-forme Taiji que de nouveaux nœuds ont rejoint, et la plate-forme Taiji commencera à Le cluster de locataires soumet plus de tâches. Avant l'heure d'emprunt, Fengluan informe Taiji Platform que certains nœuds doivent être recyclés, et Taiji Platform renvoie les nœuds de manière ordonnée.

Comme le montre la figure ci-dessous, l'excavation, la gestion et l'utilisation des ressources marémotrices impliquent la division du travail et la coopération de plusieurs systèmes :

La caractéristique des ressources informatiques est qu'elles présentent un CVM exclusif à l'entreprise, qui est plus convivial pour le côté business. Cependant, le défi de l'utilisation des ressources informatiques est que les ressources CPU du CVM de mauvaise qualité au niveau de la machine mica seront supprimées à tout moment par le CVM en ligne, ce qui entraînera des ressources informatiques très instables :

Afin de résoudre le problème de l'instabilité des ressources informatiques, diverses capacités sont étendues à travers la couche de contrôle principale de pointe, et les ressources informatiques sont optimisées sous de nombreux aspects pour améliorer la stabilité de la puissance de calcul :

① Portrait des ressources et prédiction : Explorez et collectez divers indicateurs de performances de la machine, générez des indicateurs agrégés et prédisez les ressources disponibles du CVM faiblement optimal à l'avenir. Ces informations sont utilisées par le planificateur pour planifier les pods et l'expulsion. composant pour expulser les pods afin de répondre aux exigences en ressources du pod.

② Optimisation de la planification : Afin d'assurer la qualité de service des opérations de Tai Chi, en fonction des besoins du travail et des caractéristiques des ressources, il existe de nombreuses optimisations dans la stratégie de planification, ce qui améliore la performance du travail. de plus de 2 fois.

③ Assurance qualité du service d'exécution

④ Optimisation de l'auto-feedback : grâce au profilage des ressources, les machines aux performances médiocres sont périodiquement remplacées et connectées à la plate-forme sous-jacente pour obtenir une séparation en douceur du CVM, donnant aux sommets et aux montagnes la possibilité de n'avoir aucun impact sur l'entreprise Migrez les instances d'application une par une pour réduire l'impact sur les instances.

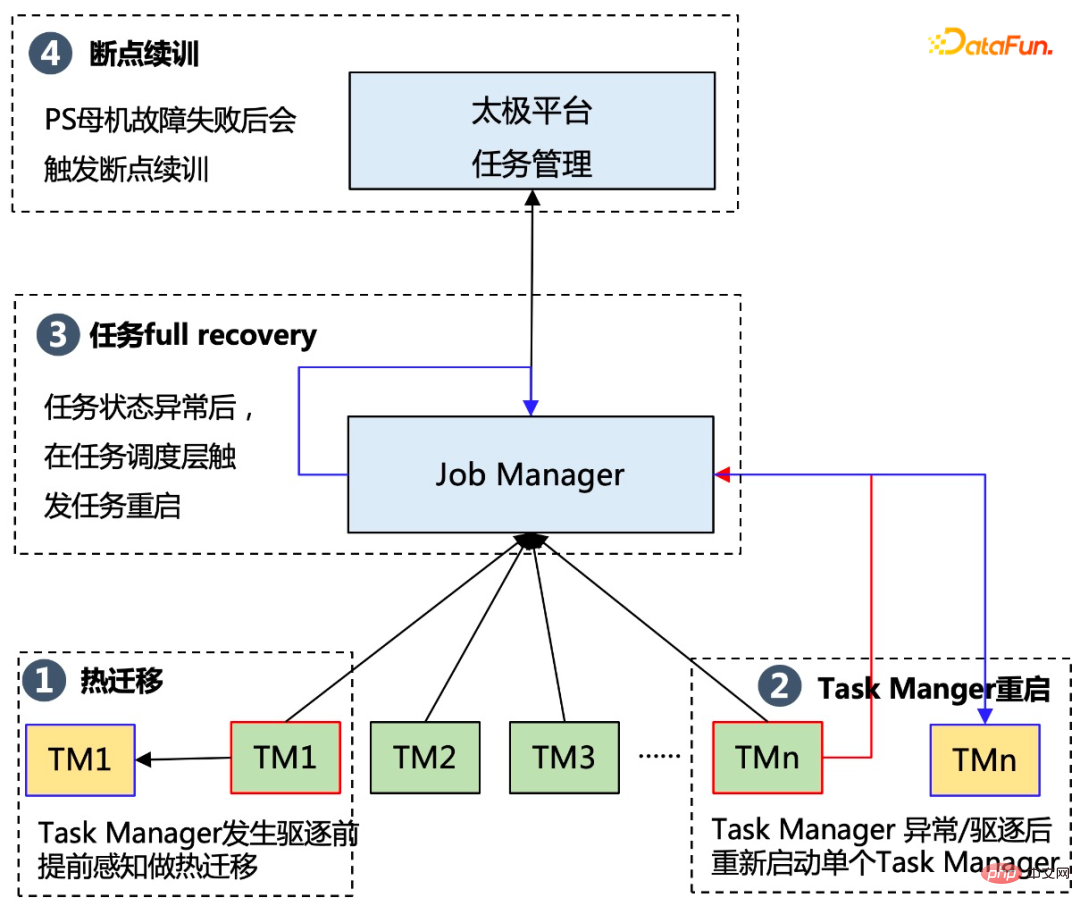

⑤ Améliorez la capacité de reprise après sinistre de la couche Flink, prenez en charge le redémarrage en un seul point et la planification hiérarchique

La capacité de redémarrage en un seul point de TM (Task Manager) évite l'échec de la tâche provoquant l'échec de l'ensemble du DAG et peut mieux s'adapter à l'informatique Il possède des fonctionnalités de prévention des forces ; la planification hiérarchique évite les attentes de travail excessives causées par la planification des gangs et évite le gaspillage lié à une application excessive des TM Pods.

Une condition préalable majeure à l'utilisation de ressources bon marché pour les tâches de formation hors ligne est qu'elle ne peut pas affecter le fonctionnement normal des tâches d'origine sur les ressources, donc les ressources de colocalisation présentent les défis clés suivants :

Afin de garantir que les tâches peuvent s'exécuter de manière stable sur les ressources de colocalisation, la plateforme utilise une stratégie de tolérance aux pannes à trois niveaux. Les solutions spécifiques sont les suivantes :

.Grâce à la tolérance aux pannes de la couche métier, la stabilité des tâches exécutées sur des ressources de colocalisation est passée de moins de 90 % initialement à 99,5 % à la fin, ce qui est fondamentalement la même que la stabilité des tâches exécutées. sur des ressources ordinaires exclusives.

Selon les besoins en ressources de marée, les tâches de formation hors ligne ne peuvent être utilisées que pendant la journée et doivent être fournies pour une utilisation professionnelle en ligne la nuit. Par conséquent, la plate-forme de Tai Chi doit démarrer automatiquement la formation. tâches en fonction de la disponibilité des ressources pendant la journée ; la nuit Effectuer une veille froide pour la tâche et arrêter en même temps la tâche de formation correspondante. Dans le même temps, la priorité de chaque planification de tâche est gérée via la file d'attente de gestion des tâches. Les nouvelles tâches démarrées la nuit entreront automatiquement dans l'état de file d'attente et attendront que de nouvelles tâches soient démarrées le lendemain matin.

Grâce à ces optimisations, nous pouvons garantir que les tâches peuvent s'exécuter de manière stable sur les ressources de marée et ignorent fondamentalement la couche métier. Dans le même temps, la vitesse d'exécution de la tâche ne sera pas grandement affectée et la surcharge supplémentaire causée par la planification du démarrage et de l'arrêt des tâches est contrôlée dans la limite de 10 %.

La solution d'optimisation de la distribution hybride hors ligne de Tai Chi a été mise en œuvre dans les scénarios publicitaires de Tencent. Elle fournit des ressources de déploiement hybrides de base de 30 W et des ressources de marée de base de 20 W pour la recherche et le modèle de publicité hors ligne de Tencent. formation quotidienne pour prendre en charge le rappel publicitaire, mise en page approximative, formation de modèles multi-scénarios de mise en page fine. En termes de coût en ressources, pour des tâches avec la même charge de calcul, le coût en ressources du déploiement hybride est 70 % de celui des ressources ordinaires. Après optimisation, la stabilité du système et le taux de réussite des tâches du cluster physique sont fondamentalement les mêmes.

À l'avenir, d'une part, nous continuerons d'augmenter l'utilisation de ressources informatiques hybrides, en particulier l'application de ressources informatiques hybrides, d'autre part, les activités en ligne de l'entreprise deviennent basées sur des GPU, donc dans l'application de ressources mixtes, en plus des ressources CPU traditionnelles, il essaiera également d'utiliser les ressources GPU en ligne lors de la formation hors ligne.

C'est tout pour le partage d'aujourd'hui, merci à tous.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Quels sont les quatre outils d'analyse du Big Data ?

Quels sont les quatre outils d'analyse du Big Data ?

Comment utiliser Swagger

Comment utiliser Swagger

Comment afficher les processus sous Linux

Comment afficher les processus sous Linux

La différence entre php et js

La différence entre php et js

niveau d'isolement des transactions par défaut de MySQL

niveau d'isolement des transactions par défaut de MySQL

^quxjg$c

^quxjg$c

Comment masquer les extensions de fichiers

Comment masquer les extensions de fichiers

Quelle est la commande cmd pour nettoyer les fichiers indésirables du lecteur C ?

Quelle est la commande cmd pour nettoyer les fichiers indésirables du lecteur C ?