La popularité de ChatGPT est évidente pour tous, et pour la technologie derrière son succès, le réglage fin de l'instruction supervisée et l'apprentissage par renforcement basé sur les commentaires humains sont cruciaux. Ces techniques s’étendent également progressivement à d’autres domaines de l’IA, notamment la vision par ordinateur (CV).

Nous savons que lorsqu'il s'agit de résultats complexes en vision par ordinateur, le principal critère de réussite n'est pas la façon dont le modèle est optimisé pour les objectifs de formation, mais la façon dont les capacités prédictives correspondent à la tâche, c'est-à-dire dans quelle mesure le modèle fonctionne pour l'usage prévu.

Afin de poursuivre cette cohérence, certains chercheurs ont apporté quelques améliorations à l'architecture des modèles, aux données, à l'optimisation, à l'échantillonnage, au post-traitement, etc. Par exemple, dans la tâche de détection d'objets, les chercheurs ont utilisé NMS (suppression non maximale), une perte globale basée sur un ensemble et la modification des données d'entrée pour obtenir des modèles avec un comportement amélioré au moment du test. Bien que ces méthodes apportent des avantages significatifs, elles ne sont souvent utiles que pour des tâches spécifiques et n’optimisent qu’indirectement les risques de la mission.

Non seulement le CV, mais aussi le traitement du langage naturel (NLP), l'apprentissage par renforcement (RL) et d'autres domaines étudient également largement ce phénomène. Dans ces domaines, il est très difficile de formuler des objectifs d’optimisation pour des tâches moins bien définies, comme la traduction ou la génération de résumés. Face à ce type de problème, Une approche populaire consiste à apprendre à imiter le résultat de l'exemple, puis à effectuer un apprentissage par renforcement pour aligner le modèle avec la fonction de récompense. Le domaine de la PNL a produit des résultats passionnants grâce à cette approche, qui utilise de grands modèles de langage pré-entraînés et des récompenses définies par la rétroaction humaine pour aborder des tâches autrement difficiles à spécifier.

De plus, la même méthode est largement utilisée dans les tâches de sous-titrage d'images, où CIDEr (proposé par Vedantam et al. 2015) est utilisé comme récompense. Néanmoins, à notre connaissance, l’optimisation des récompenses n’a pas encore été explorée dans les tâches de vision par ordinateur (non textuelles).

Récemment, des chercheurs de l'équipe Google Brain ont prouvé dans l'article "Tuning Computer Vision Models with Task Rewards" que utilise l'algorithme REINFORCE (proposé par Williams en 1992) pour régler (Tuning) un modèle pré-entraîné avec une fonction de récompense Peut être utilisée pour une variété de tâches de vision par ordinateur prêtes à l'emploi .

En fait, de nombreuses études sur les tâches d'apprentissage par renforcement mentionneront l'algorithme REINFORCE de Williams, ce qui montre l'importance de cet algorithme. On peut dire que l'algorithme REINFORCE est un représentant typique du gradient politique et même de l'apprentissage par renforcement.

Adresse papier : https://arxiv.org/pdf/2302.08242v1.pdf

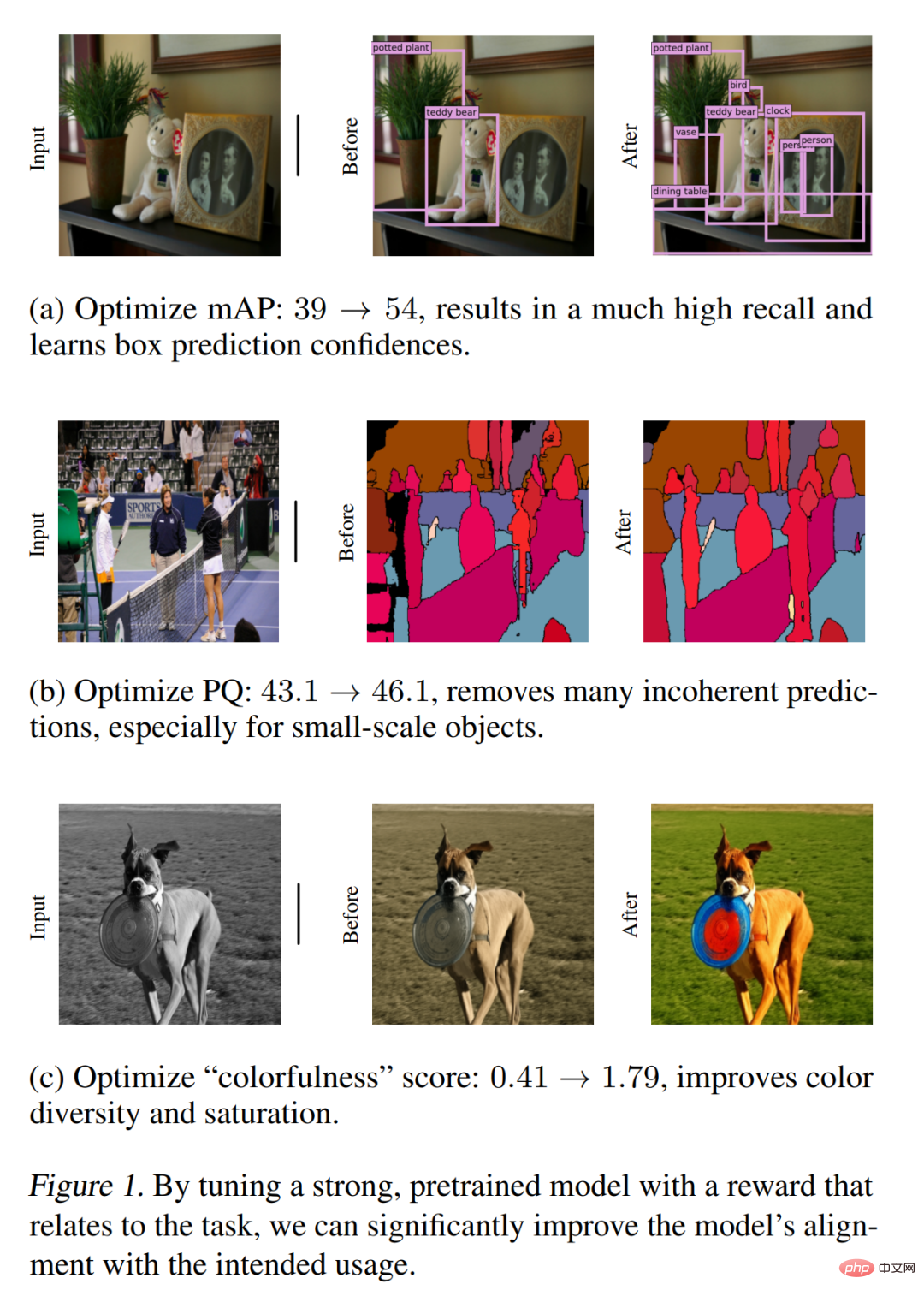

La figure 1 montre quelques résultats clés, comprenant principalement des bandes d'optimisation de récompense pour la détection de cibles, la segmentation panoramique et la coloration quantitative des images. et des améliorations qualitatives. La méthode proposée dans cette étude est simple et efficace pour gérer diverses tâches de CV, démontrant sa polyvalence et son adaptabilité. Bien que cet article utilise principalement des récompenses sous forme de mesures d'évaluation, ces résultats préliminaires montrent que cette méthode peut également être un moyen efficace d'optimiser les modèles de vision par ordinateur qui ont des récompenses plus complexes et difficiles à spécifier, telles que la rétroaction humaine ou les performances globales des systèmes. .

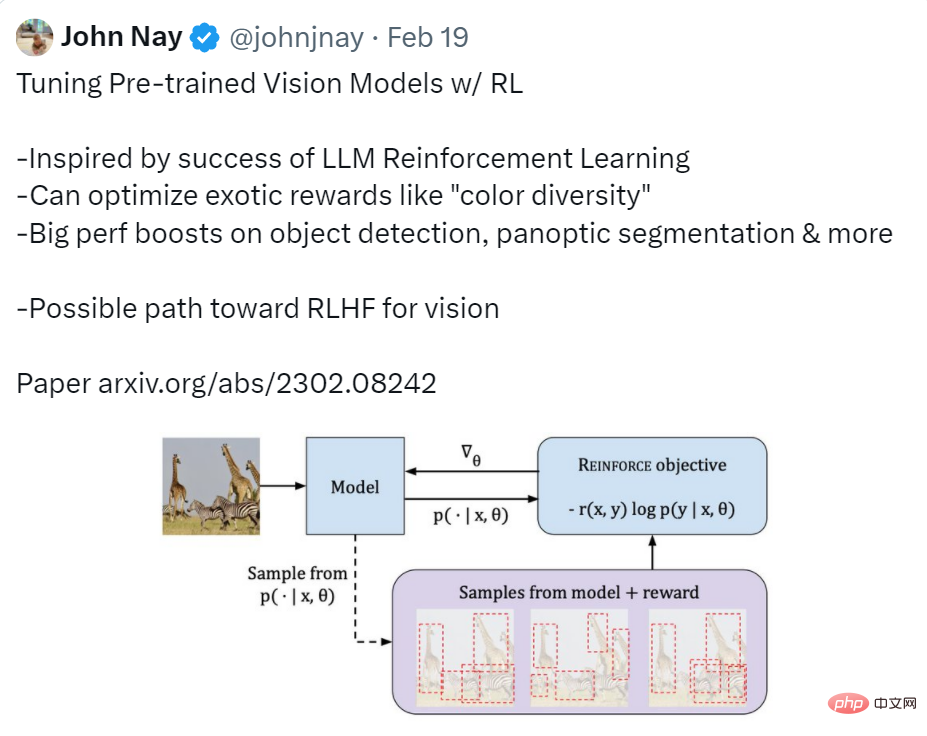

Les utilisateurs de Twitter ont donné un résumé relativement complet de cet article, c'est-à-dire que la fonction implémentée dans cet article est d'utiliser RL pour ajuster le modèle visuel pré-entraîné. La motivation de la recherche a été inspirée par le succès de l'apprentissage par renforcement LLM ; l'effet a été une amélioration significative des performances en matière de détection de cibles, de segmentation panoramique, etc. Il a également déclaré que cette recherche pourrait être un moyen efficace d’obtenir un RLHF visuel (Reinforcement Learning from Human Feedback).

Source : https://twitter.com/johnjnay/status/1627009121378598912

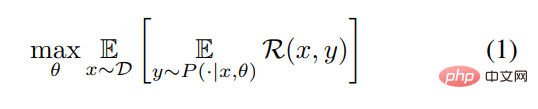

Sans perte de généralisation, l'étude décrit la tâche CV comme le processus d'apprentissage d'une fonction qui mappe l'entrée x (c'est-à-dire l'image) à la sortie y = [y_1, y_1,… , y_n] (séquence de jetons de texte, séquence de boîtes englobantes, etc.). Cette recherche vise à apprendre une distribution conditionnelle P (y|x, θ) avec θ comme paramètre pour maximiser la fonction de récompense R. Pour utiliser une formule abstraite pour le décrire, cet article résoudra les problèmes d'optimisation suivants.

Maintenant que le problème est là, l'étape suivante consiste à savoir comment le résoudre. Cet article comprend deux étapes : premièrement, utilisez l'estimation du maximum de vraisemblance pour pré-entraîner le modèle, puis utilisez l'algorithme REINFORCE ; régler le modèle. Jetons un coup d'œil au processus spécifique de ces deux étapes :

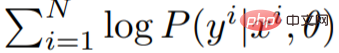

Pré-entraînement du maximum de vraisemblance

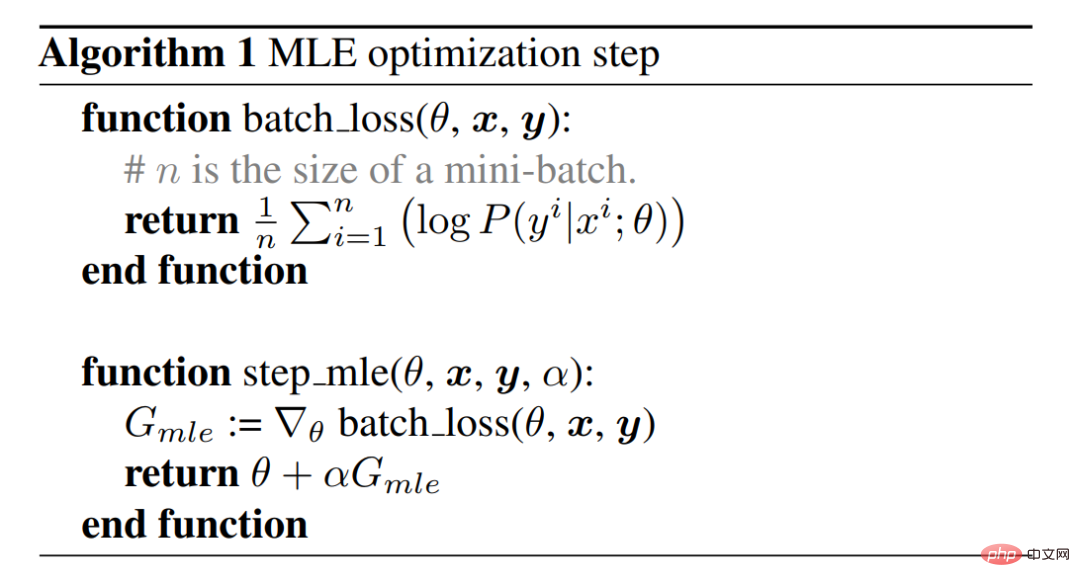

Utilisez d'abord le principe du maximum de vraisemblance pour estimer le paramètre θ et capturer la distribution des données d'entraînement. Ceci est réalisé à l'aide de l'algorithme de descente de gradient, qui fonctionne en maximisant la vraisemblance logarithmique

des données d'entraînement. L'algorithme 1 et la figure 2 décrivent l'étape d'optimisation MLE (estimation du maximum de vraisemblance), qui est la méthode la plus courante pour l'entraînement des modèles. La réalisation de cette étape aboutira à un modèle MLE.

des données d'entraînement. L'algorithme 1 et la figure 2 décrivent l'étape d'optimisation MLE (estimation du maximum de vraisemblance), qui est la méthode la plus courante pour l'entraînement des modèles. La réalisation de cette étape aboutira à un modèle MLE.

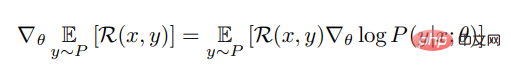

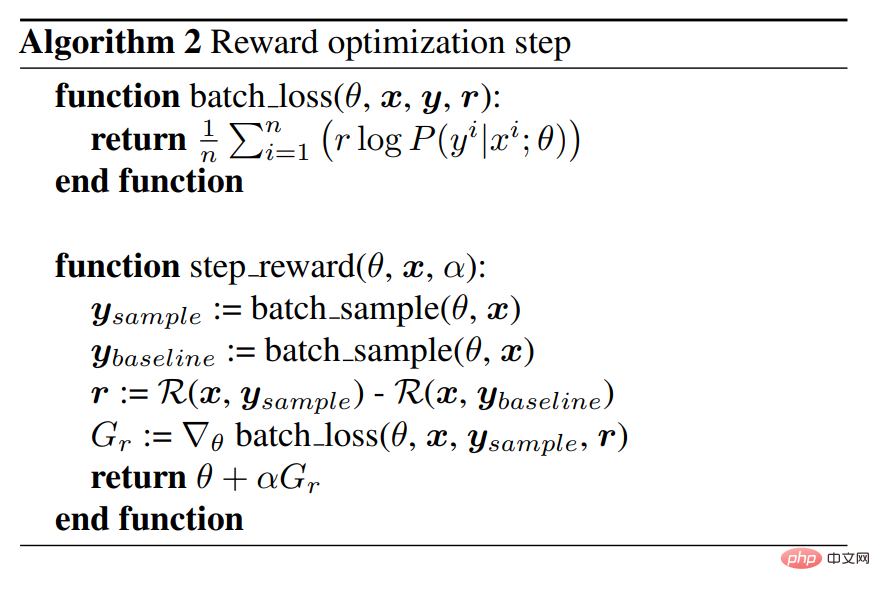

L'algorithme REINFORC maximise la récompense

Afin de mieux optimiser le modèle MLE pour s'adapter au risque de la tâche, il est également nécessaire de maximiser la fonction de récompense. Pour une entrée x donnée, cette étude utilise l'algorithme REINFORCE pour estimer le gradient de la récompense attendue pour un x donné, et la formule est la suivante :

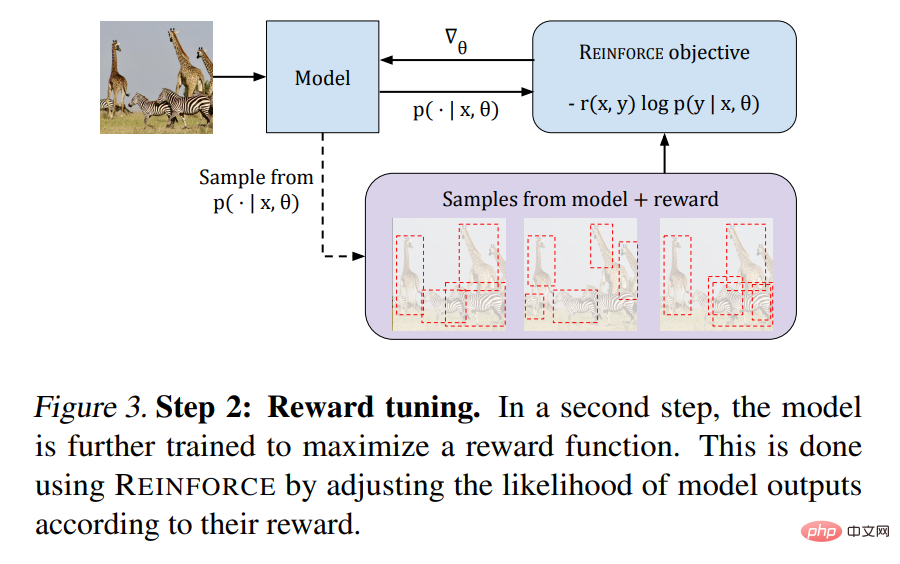

L'algorithme 2 fournit un pseudocode, et la figure 3 illustre le processus. :

Ensuite, jetons un coup d'œil aux performances de la méthode proposée dans cet article sur les tâches visuelles.

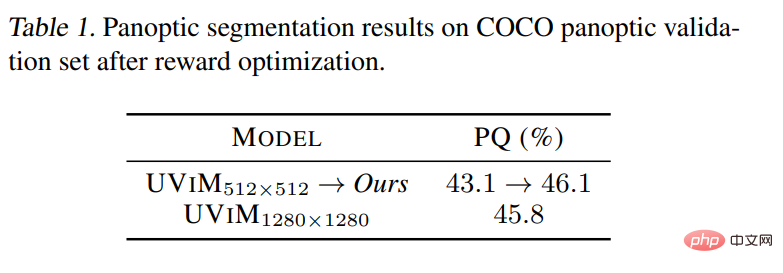

Segmentation panoramique

Comme le montre le tableau 1 ci-dessous, le processus de réglage améliore considérablement le modèle MLE. Les résultats après inspection visuelle montrent que le modèle après réglage est plus efficace pour éviter les prédictions incohérentes, en particulier pour les objets à petite échelle, voir Figure 1. Le tableau 2 montre que grâce à l'optimisation, cette étude améliore considérablement le score mAP du modèle MLE original de 39,2 % à 54,3 %. Dans Pix2seq, le modèle ViT-B de même taille avec une résolution légèrement plus grande de 1333×1333 et de nombreuses heuristiques a atteint 47,1 %. En utilisant le plus grand squelette ViT-L, Pix2seq a rapporté le meilleur résultat de détection de cible de 50,0 %.

Coloriage Les résultats qualitatifs présentés dans la figure 4 montrent clairement que le nouveau modèle produit systématiquement des images plus colorées.

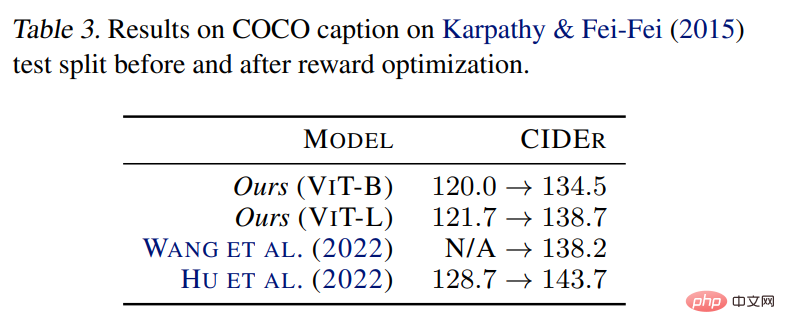

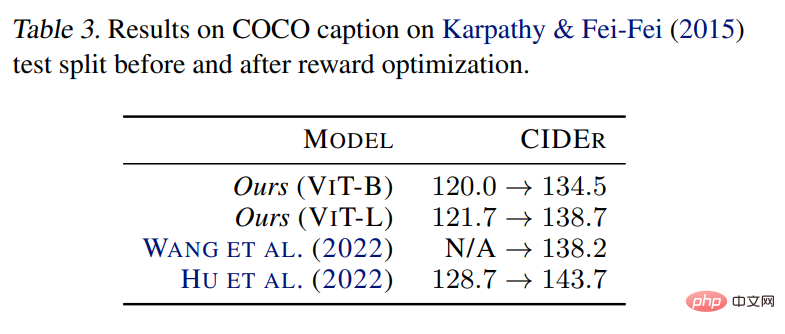

Description de l'image

Tableau 3 Les résultats montrent que l'application de la méthode proposée peut améliorer le modèle MLE, ce qui est cohérent avec les observations précédentes de la littérature, démontrant que la méthode est adapté à l’efficacité du réglage pour des risques spécifiques à la mission.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Quelles compétences sont nécessaires pour travailler dans l'industrie PHP ?

Quelles compétences sont nécessaires pour travailler dans l'industrie PHP ?

Quel est le système Honor ?

Quel est le système Honor ?

Comment configurer la passerelle par défaut

Comment configurer la passerelle par défaut

Comment nettoyer le lecteur C de l'ordinateur trop plein

Comment nettoyer le lecteur C de l'ordinateur trop plein

Collection complète de balises HTML

Collection complète de balises HTML

Comment définir le style de lien en CSS

Comment définir le style de lien en CSS

Comment installer le filtre PS

Comment installer le filtre PS

Erreur d'application plugin.exe

Erreur d'application plugin.exe