Après avoir converti du texte en image pendant plus de six mois, les géants de la technologie tels que Meta et Google ont jeté leur dévolu sur un nouveau champ de bataille : le texte en vidéo.

La semaine dernière, Meta a annoncé un outil capable de générer de courtes vidéos de haute qualité - Make-A-Video. Les vidéos générées à l'aide de cet outil sont très imaginatives.

Bien sûr, Google n'est pas en reste. Tout à l'heure, le PDG de l'entreprise, Sundar Pichai, a personnellement annoncé ses dernières réalisations dans ce domaine : deux outils de conversion texte-vidéo – Imagen Video et Phenaki. Le premier se concentre sur la qualité vidéo, tandis que le second remet principalement en question la longueur de la vidéo. On peut dire que chacun a ses propres mérites.

L'ours en peluche qui fait la vaisselle ci-dessous a été généré à l'aide d'Imagen Video. Comme vous pouvez le constater, la résolution et la cohérence de l'image sont garanties dans une certaine mesure.

La modélisation générative a fait des progrès significatifs dans les récents systèmes d'IA texte-image, tels que DALL-E 2, Imagen, Parti, CogView et Latent Diffusion . En particulier, les modèles de diffusion ont obtenu un grand succès dans diverses tâches de modélisation générative telles que l'estimation de la densité, la synthèse texte-parole, image-image, texte-image et 3D.

Ce que Google veut faire, c'est générer une vidéo à partir de texte. Les travaux antérieurs sur la génération vidéo se sont concentrés sur des ensembles de données restreints avec des modèles autorégressifs, des modèles à variables latentes avec des a priori autorégressifs et, plus récemment, des méthodes à variables latentes non autorégressives. Les modèles de diffusion ont également démontré d’excellentes capacités de génération vidéo à moyenne résolution.

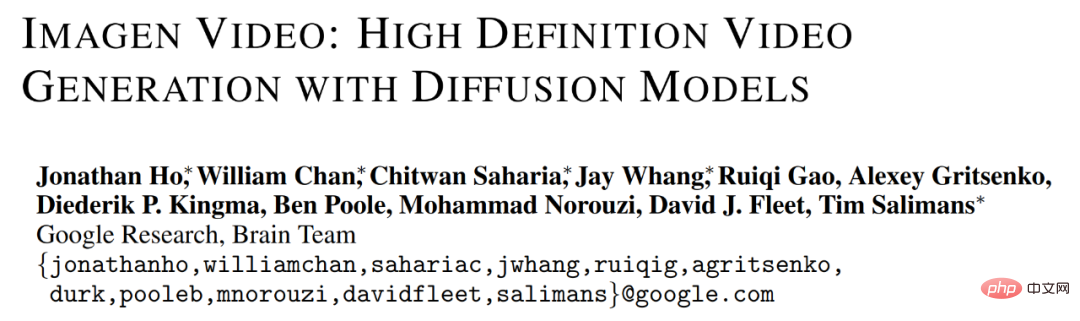

Sur cette base, Google a lancé Imagen Video, un système de génération vidéo conditionnelle de texte basé sur le modèle de diffusion vidéo en cascade. À partir d'une invite de texte, Imagen Video peut générer une vidéo haute définition grâce à un système composé d'un encodeur de texte T5 figé, d'un modèle de génération vidéo de base et d'un modèle de super-résolution vidéo spatio-temporelle en cascade.

Adresse papier : https://imagen.research.google/video/paper.pdf

Dans le document, Google décrit en détail comment étendre le système en un texte haute définition Modèle vers vidéo, y compris des décisions de conception telles que la sélection d'un modèle de super-résolution spatio-temporelle entièrement convolutionnel à certaines résolutions et la sélection du paramétrage en V du modèle de diffusion. Google a également migré avec succès les résultats de recherches précédentes sur la génération d'images basées sur la diffusion vers un paramètre de génération vidéo.

Google a découvert qu'Imagen Video peut convertir la vidéo 24 ips 64 images 128×128 générée par des travaux précédents en 128 images 1280×768 vidéo HD. De plus, Imagen Video possède un haut degré de contrôlabilité et de connaissance du monde, peut générer des animations vidéo et textuelles dans divers styles artistiques et possède des capacités de compréhension d'objets 3D.

Profitons d'autres vidéos générées par Imagen Video, comme un panda conduisant une voiture :

Un bateau en bois voyageant dans l'espace :

Pour plus de vidéos générées, veuillez voir : https://imagen.research.google/video/

Méthodes et expériences

Dans l'ensemble, le cadre de génération vidéo de Google est une cascade de sept modèles de diffusion sous-vidéo, qui effectuent respectivement la génération vidéo conditionnelle au texte, la super-résolution spatiale et la super-résolution temporelle. En utilisant toute la cascade, Imagen Video est capable de produire 128 images de vidéo HD 1280×768 (environ 126 millions de pixels) à 24 images par seconde.

Pendant ce temps, grâce à la distillation progressive, Imagen Video génère des vidéos de haute qualité en utilisant seulement huit étapes de diffusion dans chaque sous-modèle. Cela accélère le temps de génération vidéo d’environ 18 fois.

La figure 6 ci-dessous montre l'ensemble du pipeline en cascade d'Imagen Video, y compris 1 encodeur de texte figé, 1 modèle de diffusion vidéo de base, 3 modèles de super-résolution spatiale (SSR) et 3 super-résolution temporelle (TSR). Les sept modèles de diffusion vidéo comptent au total 11,6 milliards de paramètres.

Pendant le processus de génération, le modèle SSR améliore la résolution spatiale de toutes les images d'entrée, tandis que le modèle TSR améliore la résolution temporelle en remplissant les images intermédiaires entre les images d'entrée. Tous les modèles génèrent simultanément un bloc complet de trames afin que le modèle SSR ne souffre pas d'artefacts notables.

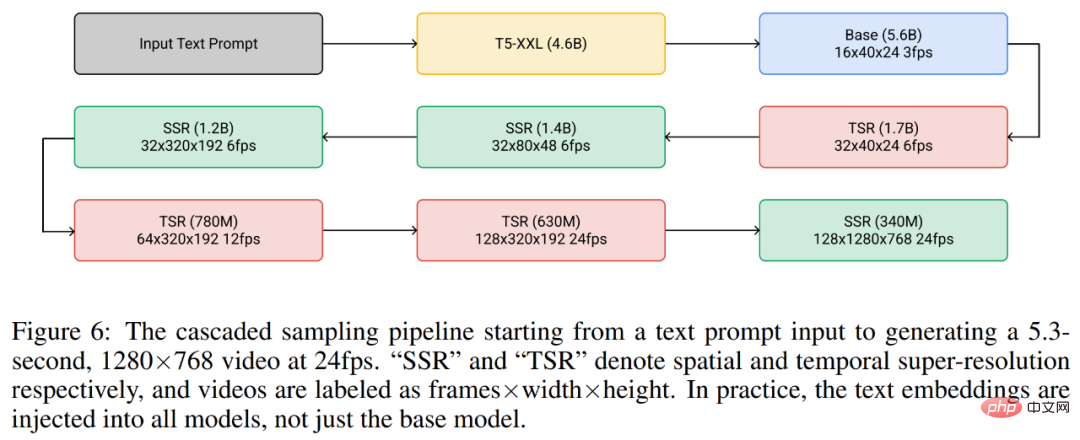

Imagen Video est construit sur l'architecture vidéo U-Net, comme le montre la figure 7 ci-dessous.

Dans le cadre d'expériences, Imagen Video est formé sur l'ensemble de données image-texte LAION-400M accessible au public, 14 millions de paires vidéo-texte et 60 millions de paires image-texte. En conséquence, comme mentionné ci-dessus, Imagen Video est non seulement capable de générer des vidéos haute définition, mais possède également des fonctionnalités uniques que les modèles génératifs non structurés qui apprennent uniquement à partir de données n'ont pas.

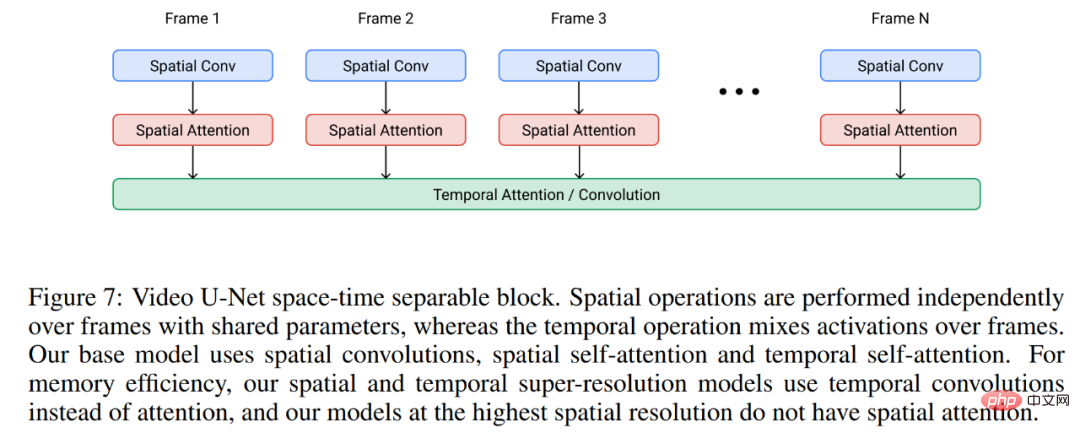

La figure 8 ci-dessous montre la capacité d'Imagen Video à générer des vidéos avec des styles artistiques tirés des informations sur l'image, tels que le style de peinture de Van Gogh ou des vidéos de style aquarelle.

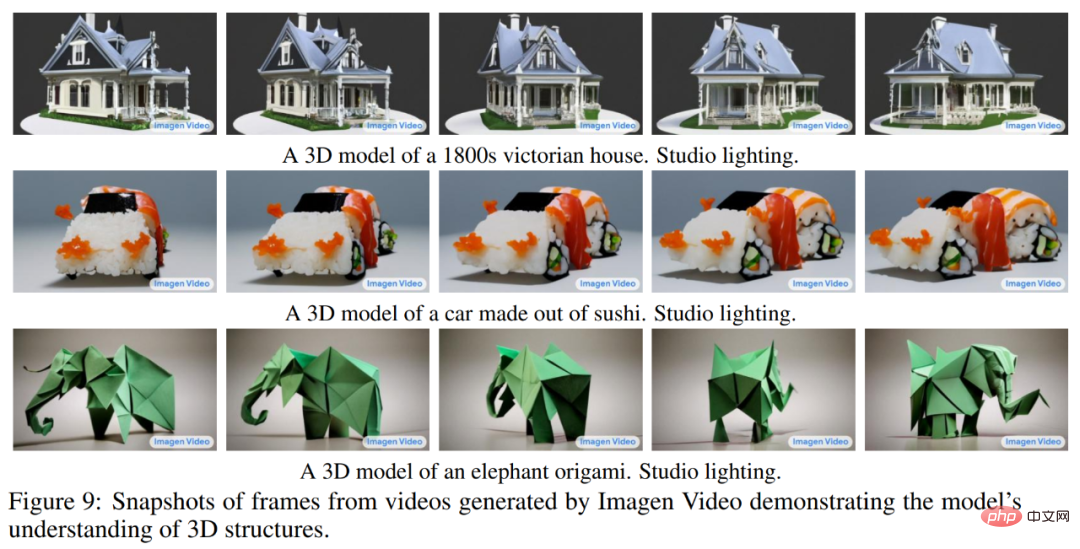

La figure 9 ci-dessous montre la capacité d'Imagen Video à comprendre les structures 3D. Elle peut générer des vidéos d'objets en rotation tout en conservant la structure générale de l'objet.

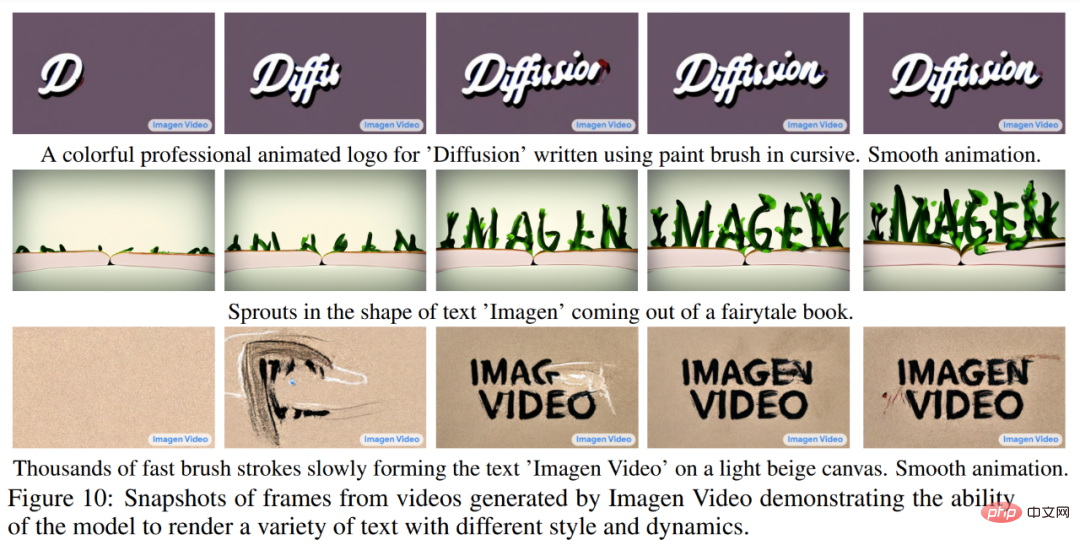

La figure 10 ci-dessous montre comment Imagen Video peut générer de manière fiable du texte dans une variété de styles animés, dont certains sont difficiles à créer à l'aide d'outils traditionnels.

Veuillez vous référer à l'article original pour plus de détails expérimentaux.

Nous savons que même si une vidéo est essentiellement une série d'images, générer une longue vidéo cohérente n'est pas si simple car dans cette tâche, la haute qualité disponible les données sont rares et les tâches elles-mêmes sont exigeantes en termes de calcul.

Ce qui est plus gênant, c'est que les invites de texte courtes utilisées pour la génération d'images comme auparavant ne suffisent généralement pas pour fournir une description complète de la vidéo. La vidéo a besoin d'une série d'invites ou d'histoires. Idéalement, un modèle de génération vidéo doit être capable de générer des vidéos de n'importe quelle longueur et d'ajuster les images vidéo générées en fonction des changements d'invite à un certain instant t. Ce n'est qu'avec cette capacité que les œuvres générées par le modèle peuvent être appelées « vidéo » plutôt que « images animées » et ouvrir la voie à des applications créatives réelles dans les domaines de l'art, du design et de la création de contenu.

Des chercheurs de Google et d'autres institutions ont déclaré : "À notre connaissance, la génération de vidéos conditionnelles basées sur des histoires n'a jamais été explorée auparavant, et il s'agit du premier article précoce allant dans ce sens

."

En l’absence d’ensembles de données basés sur des histoires sur lesquelles apprendre, les chercheurs n’ont aucun moyen de s’appuyer simplement sur les méthodes traditionnelles d’apprentissage en profondeur (simplement apprendre à partir des données) pour accomplir ces tâches. Ils ont donc conçu un modèle spécialement pour cette tâche.

Ce nouveau modèle texte-vidéo s'appelle Phenaki, qui utilise les données « texte-vidéo » et « texte-image » pour s'entraîner conjointement. Le modèle a les capacités suivantes :

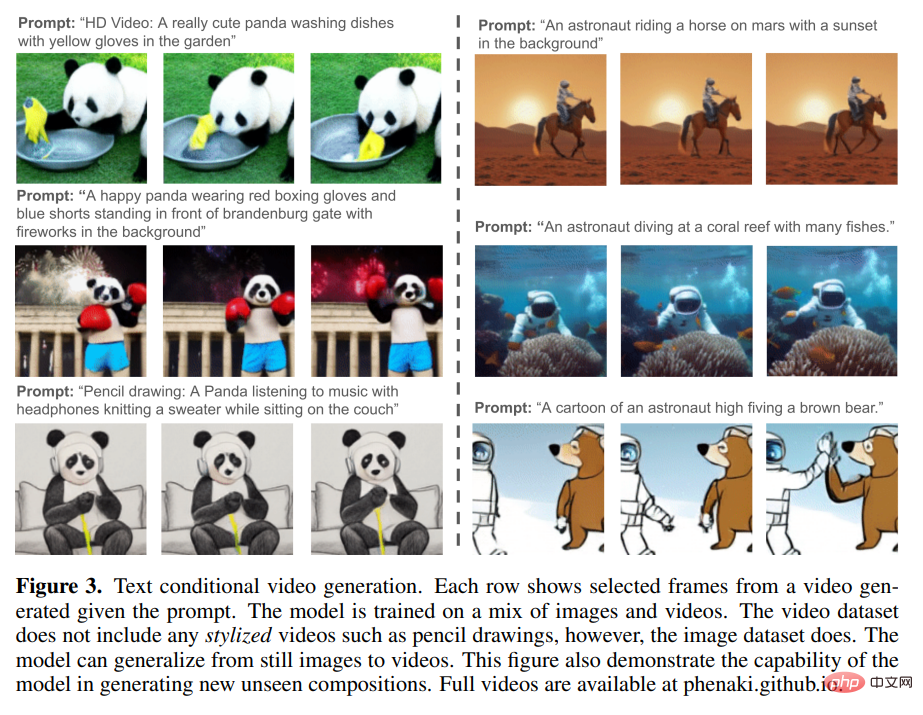

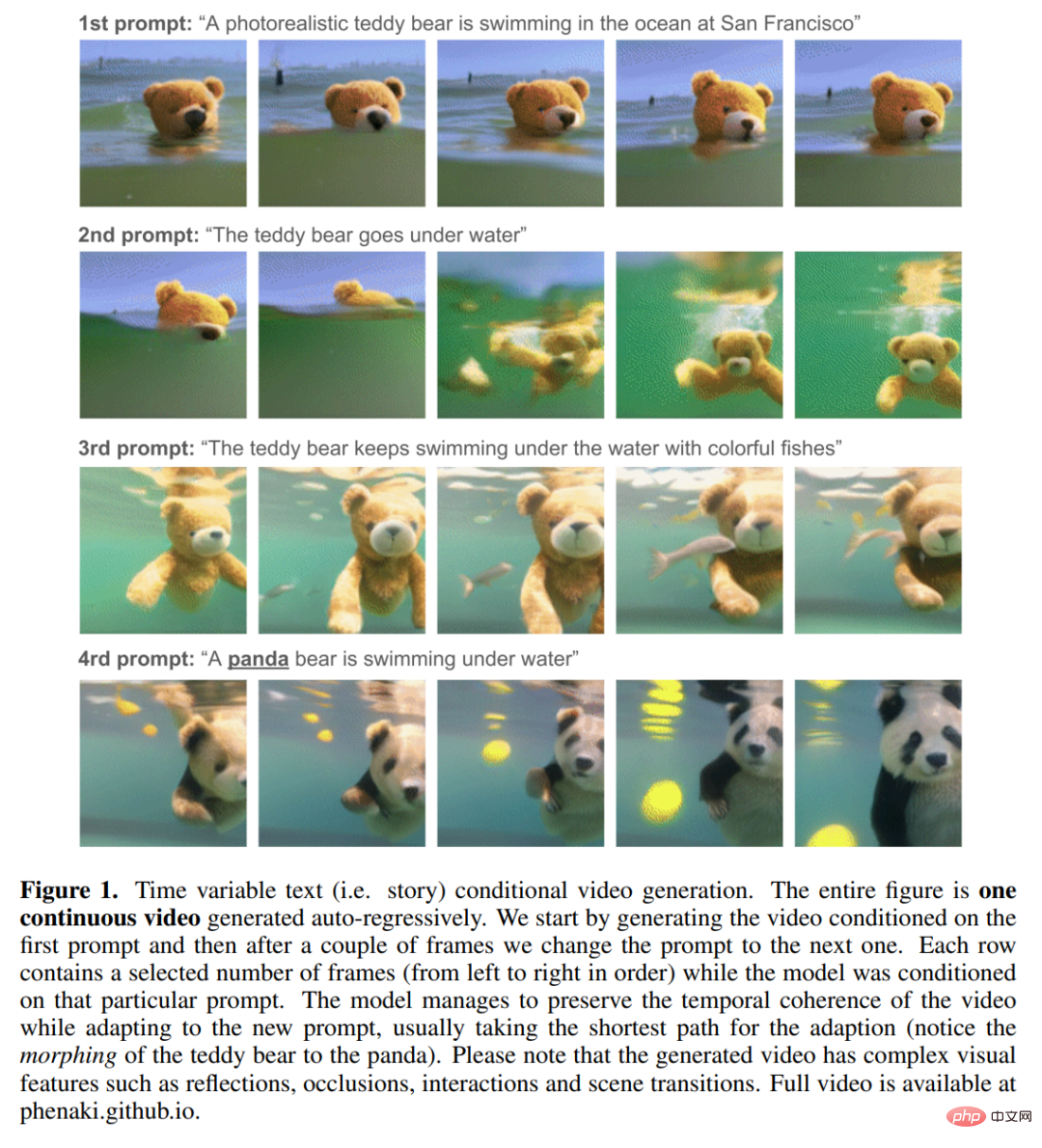

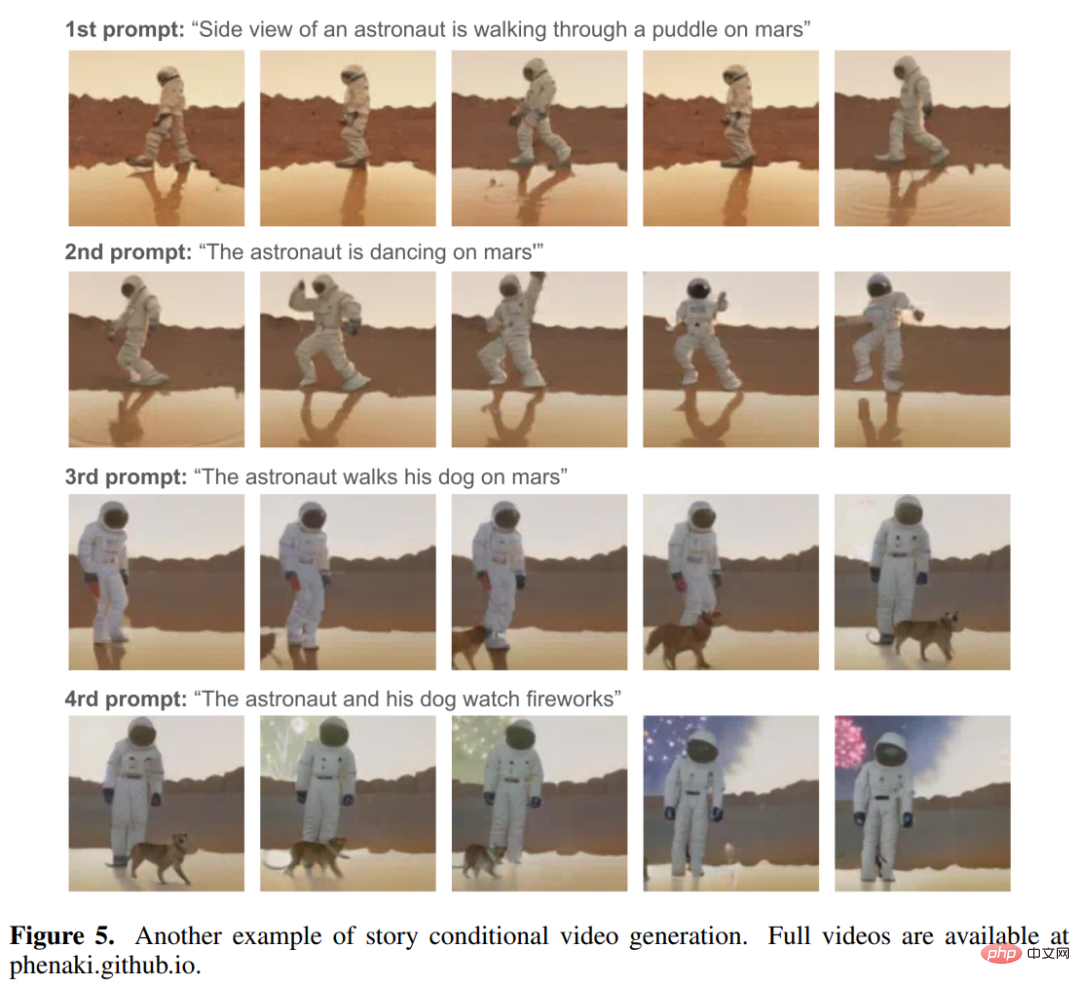

1. Générer des vidéos diverses et cohérentes dans le temps sous la condition d'une invite de domaine ouvert, même si l'invite est une nouvelle combinaison de concepts (voir la figure 3 ci-dessous). La vidéo générée peut durer plusieurs minutes, même si la vidéo utilisée pour entraîner le modèle ne dure que 1,4 seconde (8 images/seconde)

2. Générez une vidéo basée sur une histoire (c'est-à-dire une série d'invites). ), comme le montrent la figure 1 et ci-dessous. Montré dans la figure 5 :

À partir de l'animation suivante, nous pouvons voir la cohérence et la diversité des vidéos générées par Phenaki :

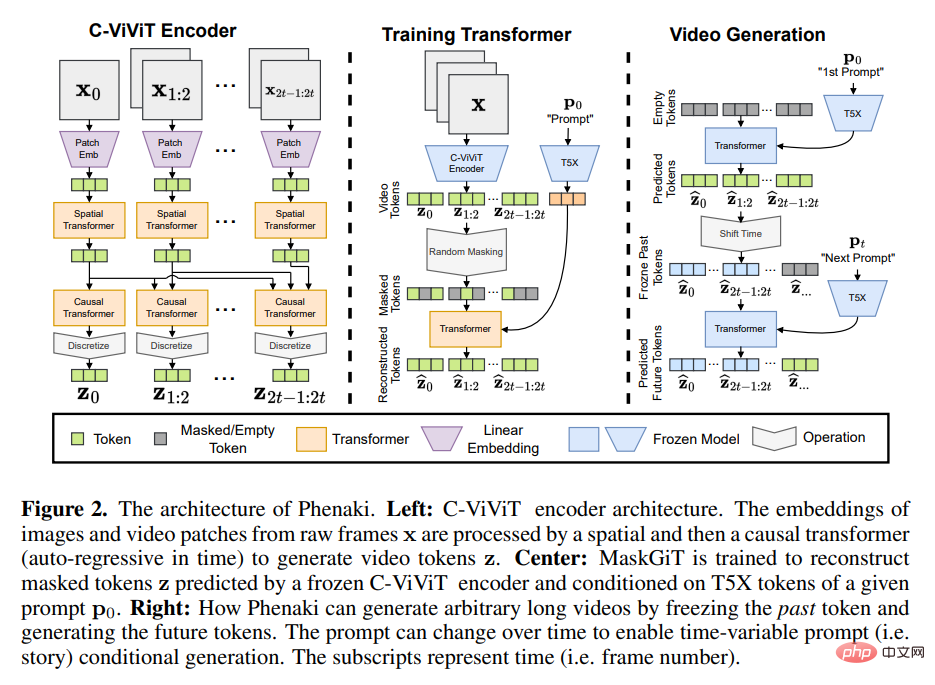

Pour mettre en œuvre ces fonctions, recherchez Vous ne pouvez pas compter sur les encodeurs vidéo existants car ces encodeurs ne peuvent décoder que des vidéos de taille fixe ou encoder des images de manière indépendante. Pour résoudre ce problème, ils ont introduit une nouvelle architecture codeur-décodeur - C-ViViT.

C-ViViT peut :

PHENAKI Model Architecture

Inspirée par des recherches antérieures sur la conversion texte-image et texte-vidéo autorégressive, la conception de Phenaki comprend principalement deux parties (voir Figure 2 ci-dessous) : L'une compresse la vidéo en discret Un modèle d'encodeur-décodeur pour l'intégration (c'est-à-dire un jeton) et un modèle de transformateur qui convertit l'intégration de texte en un jeton vidéo.

Obtenir une représentation compressée d'une vidéo est l'un des principaux défis de la génération de vidéos à partir de texte. Les travaux antérieurs utilisaient soit des encodeurs d'image par image, tels que VQ-GAN, soit des encodeurs vidéo de longueur fixe, tels que VideoVQVAE. Le premier permet la génération de vidéos de longueur arbitraire, mais dans la pratique, les vidéos doivent être courtes car l'encodeur ne peut pas compresser la vidéo dans le temps et les jetons sont hautement redondants dans les images consécutives. Ce dernier est plus performant en termes de nombre de tokens, mais il ne permet pas de générer des vidéos de longueur arbitraire.

À Phenaki, l'objectif du chercheur est de générer des vidéos de longueur variable tout en compressant autant que possible le nombre de jetons vidéo, afin que le modèle Transformer puisse être utilisé dans les limites actuelles des ressources informatiques. À cette fin, ils introduisent C-ViViT, une variante causale de ViViT avec des modifications architecturales supplémentaires pour la génération vidéo, qui peut compresser les vidéos dans les dimensions temporelles et spatiales tout en conservant l'autorégression temporelle. Cette fonctionnalité permet la génération de vidéos autorégressives de longueur arbitraire.

Afin d'obtenir des intégrations de texte, Phenaki utilise également un modèle de langage pré-entraîné-T5X.

Veuillez vous référer au document original pour des détails spécifiques.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!