Tout succès a ses traces, et ChatGPT ne fait pas exception.

Il n'y a pas si longtemps, Yann LeCun, lauréat du prix Turing, a été inscrit sur la liste de recherche la plus recherchée en raison de son évaluation sévère de ChatGPT.

Selon lui, "En ce qui concerne la technologie sous-jacente, ChatGPT n'a aucune innovation particulière", ni "rien de révolutionnaire". De nombreux laboratoires de recherche utilisent la même technologie et effectuent le même travail. De plus, ChatGPT et le GPT-3 qui le sous-tend sont à bien des égards composés de multiples technologies développées sur de nombreuses années par plusieurs parties et sont le résultat de décennies de contributions de différentes personnes. Par conséquent, LeCun estime que ChatGPT n’est pas tant une avancée scientifique qu’un exemple d’ingénierie décent.

« Que ChatGPT soit révolutionnaire » est un sujet controversé. Mais il ne fait aucun doute qu'il est construit sur la base de nombreuses technologies accumulées précédemment. Par exemple, le noyau Transformer a été proposé par Google il y a quelques années, et Transformer s'est inspiré des travaux de Bengio sur le concept d'attention. Si nous remontons plus loin, nous pouvons également établir un lien avec des recherches menées sur des décennies encore plus anciennes.

Bien sûr, le public ne ressentira peut-être pas ce sentiment de progressivité. Après tout, tout le monde ne lira pas les journaux un par un. Mais pour les techniciens, il reste très utile de comprendre l’évolution de ces technologies.

Dans un article de synthèse récent, des chercheurs de la Michigan State University, de la Beijing Aeronautical University, de la Lehigh University et d'autres institutions ont soigneusement passé au peigne fin des centaines d'articles dans ce domaine, en se concentrant principalement sur le texte, les images et un modèle de base pré-entraîné. dans le domaine de l'apprentissage des graphes, vaut la peine d'être lu. Philip S. ), vice-président de Salesforce AI ResearchXiong Caimingdu est l'un des auteurs de l'article. Lien papier : https://arxiv.org/pdf/2302.09419.pdfLa table des matières de la thèse est la suivante :

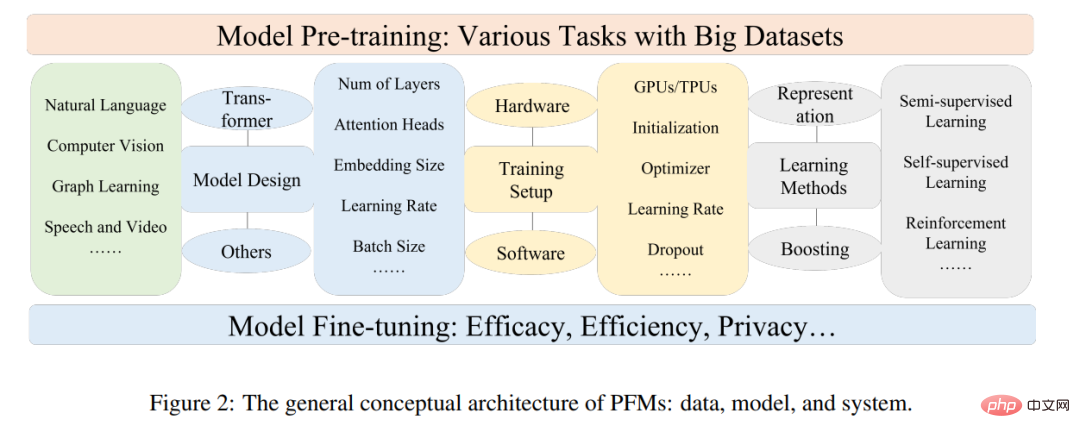

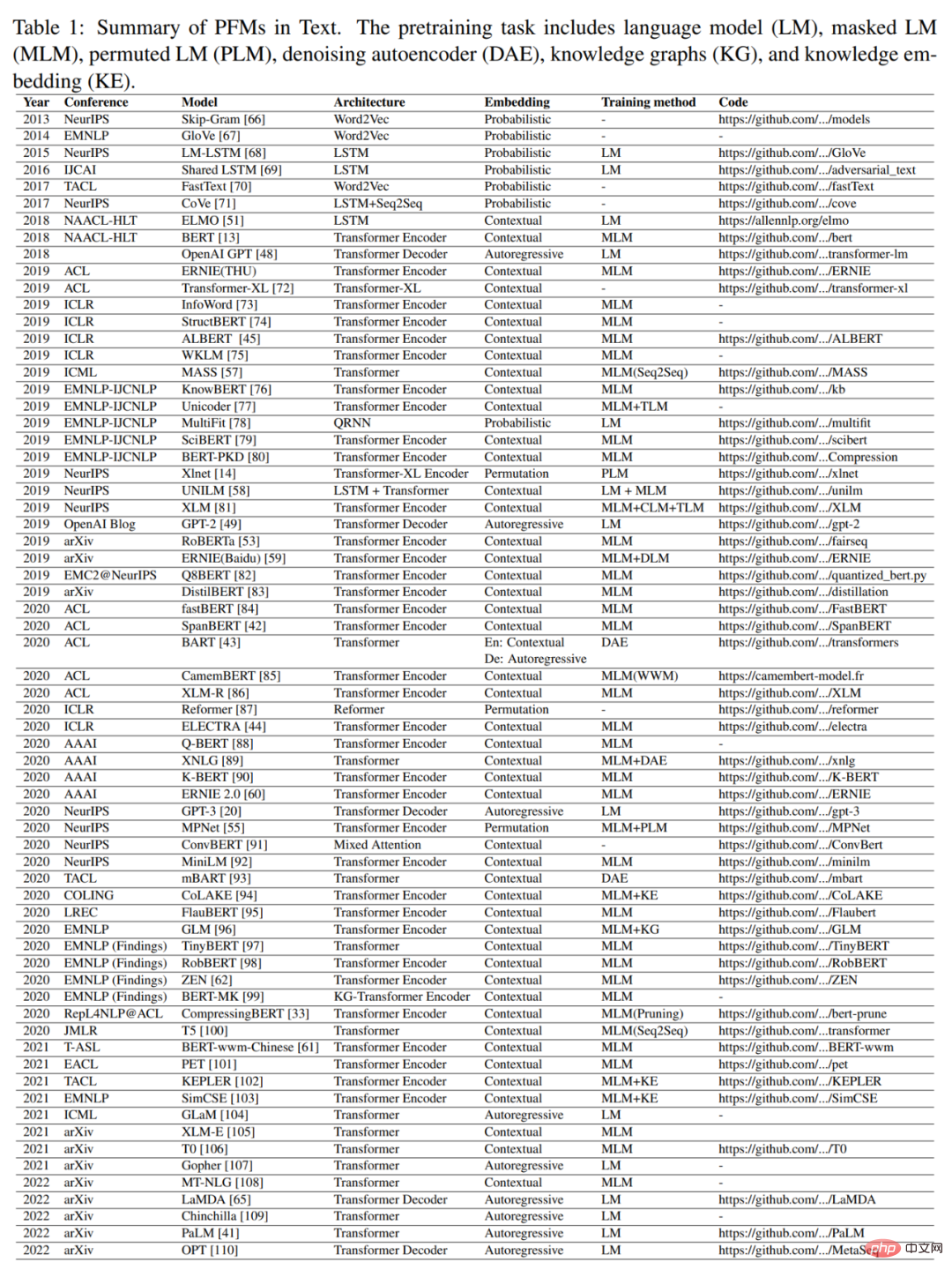

Sur les plateformes sociales à l'étranger, le co-fondateur de DAIR.AI, Elvis S., a recommandé cet avis et a reçu plus d'un millier de likes. Le modèle de base pré-entraîné (PFM) est un élément important de l'intelligence artificielle à l'ère du Big Data. Le nom « Modèle de base » vient d'une revue publiée par Percy Liang, Li Feifei et d'autres - « Sur les opportunités et les risques des modèles de fondation », qui est un terme général désignant un type de modèle et ses fonctions. La PFM a été largement étudiée dans les domaines de la PNL, du CV et de l'apprentissage des graphiques. Ils montrent un fort potentiel pour l'apprentissage de la représentation des caractéristiques dans diverses tâches d'apprentissage, telles que la classification de texte, la génération de texte, la classification d'images, la détection d'objets et la classification de graphiques. Qu'il s'agisse d'une formation sur plusieurs tâches avec de grands ensembles de données ou d'un réglage précis sur des tâches à petite échelle, PFM présente des performances supérieures, ce qui permet de démarrer rapidement le traitement des données. PFM et pré-formation PFM est basé sur une technologie de pré-formation, qui vise à exploiter une grande quantité de données et de tâches pour former un modèle général qui peut être facilement affiné dans différents processus en aval candidatures. L'idée de la pré-formation est née de l'apprentissage par transfert dans les tâches CV. Mais après avoir constaté l’efficacité de cette technologie dans le domaine du CV, les gens ont commencé à l’utiliser pour améliorer les performances des modèles dans d’autres domaines. Lorsque la technologie de pré-formation est appliquée au domaine de la PNL, un modèle de langage bien entraîné peut capturer des connaissances riches qui sont bénéfiques pour les tâches en aval, telles que les dépendances à long terme, les relations hiérarchiques, etc. De plus, l'avantage significatif de la pré-formation dans le domaine de la PNL est que les données de formation peuvent provenir de n'importe quel corpus de texte non étiqueté, c'est-à-dire qu'il existe une quantité presque illimitée de données de formation qui peuvent être utilisées pour le processus de pré-formation. . Les premières pré-formations étaient une technique statique, comme NNLM et Word2vec, mais les méthodes statiques sont difficiles à adapter à différents environnements sémantiques. Ainsi, des techniques dynamiques de pré-formation ont été proposées, telles que BERT, XLNet, etc. La figure 1 décrit l'histoire et l'évolution de la GFP dans les domaines de la PNL, de la CV et du GL. La PFM basée sur des techniques de pré-formation utilise de grands corpus pour apprendre des représentations sémantiques communes. Suite à l’introduction de ces travaux pionniers, diverses PFM ont vu le jour et ont été appliquées à des tâches et applications en aval. Le ChatGPT récemment populaire est un cas typique d'application PFM. Il est affiné à partir du modèle de transformateur génératif pré-entraîné GPT-3.5, qui a été formé à l'aide d'une grande quantité de ce document et de ce code. De plus, ChatGPT applique l'apprentissage par renforcement à partir de la rétroaction humaine (RLHF), qui s'est révélé être un moyen prometteur d'aligner les LM à grande échelle sur les intentions humaines. Les excellentes performances de ChatGPT peuvent entraîner des changements dans le paradigme de formation de chaque type de PFM, tels que l'application de la technologie d'alignement des instructions, l'apprentissage par renforcement, le réglage rapide et la chaîne de réflexion, évoluant ainsi vers l'intelligence artificielle générale. Cet article se concentrera sur la PFM dans les domaines du texte, de l'image et du graphique, qui est une méthode de classification de recherche relativement mature. Pour le texte, il s'agit d'un LM à usage général utilisé pour prédire le mot ou le caractère suivant dans une séquence. Par exemple, PFM peut être utilisé dans la traduction automatique, les systèmes de questions-réponses, la modélisation de sujets, l'analyse des sentiments, etc. Pour les images, cette méthode est similaire au PFM sur le texte, utilisant d'énormes ensembles de données pour former un grand modèle adapté à de nombreuses tâches de CV. Pour les graphiques, des idées de pré-formation similaires sont utilisées pour obtenir des PFM qui sont utilisés dans de nombreuses tâches en aval. En plus des PFM pour des domaines de données spécifiques, cet article examine et développe également d'autres PFM avancés, tels que les PFM pour la voix, la vidéo et les données inter-domaines, et les PFM multimodaux. En outre, une grande convergence de PFM capables de gérer des tâches multimodales est en train d’émerger, appelée PFM unifiée. Les auteurs définissent d’abord le concept de PFM unifiée, puis examinent les recherches récentes sur les PFM unifiées qui ont atteint SOTA (telles que OFA, UNIFIED-IO, FLAVA, BEiT-3, etc.). Sur la base des caractéristiques de la GFP existante dans les trois domaines ci-dessus, l'auteur a conclu que la GFP présente les deux avantages majeurs suivants. Premièrement, pour améliorer les performances des tâches en aval, le modèle ne nécessite que des ajustements mineurs. Deuxièmement, la GFP a été examinée en termes de qualité. Au lieu de créer un modèle à partir de zéro pour résoudre un problème similaire, nous pouvons appliquer la PFM à des ensembles de données pertinents pour une tâche. Les vastes perspectives de la PFM ont inspiré un grand nombre de travaux connexes axés sur des questions telles que l’efficacité, la sécurité et la compression des modèles. Contribution et structure du papier Avant la publication de cet article, plusieurs revues ont examiné des modèles pré-entraînés dans des domaines spécifiques, tels que la génération de texte, le transformateur visuel et la détection d'objets. "Sur les opportunités et les risques des modèles de fondation" résume les opportunités et les risques des modèles de fondation. Cependant, les travaux existants ne permettent pas un examen complet de la GFP dans différents domaines (par exemple CV, PNL, GL, parole, vidéo) sur différents aspects, tels que les tâches de pré-formation, l'efficience, l'efficacité et la confidentialité. Dans cette revue, les auteurs détaillent l'évolution de la PFM dans le domaine de la PNL et comment la pré-formation a été transférée et adoptée dans les domaines CV et GL. Comparé à d’autres revues, cet article ne fournit pas une introduction et une analyse complètes de la GFP existante dans les trois domaines. À la différence de l'examen des modèles pré-entraînés précédents, les auteurs résument les modèles existants, des modèles traditionnels à la GFP, ainsi que les derniers travaux dans trois domaines. Les modèles traditionnels mettent l’accent sur l’apprentissage statique des fonctionnalités. Dynamic PFM fournit une introduction à la structure, qui est la recherche dominante. L'auteur présente en outre d'autres recherches sur la PFM, y compris d'autres PFM avancées et unifiées, l'efficacité et la compression des modèles, la sécurité et la confidentialité. Enfin, les auteurs résument les futurs défis de recherche et les questions ouvertes dans différents domaines. Ils fournissent également une introduction complète aux paramètres d’évaluation et aux ensembles de données pertinents dans les annexes F et G. En résumé, les principales contributions de cet article sont les suivantes : Le contenu principal de chaque chapitre est le suivant : Le chapitre 2 du document présente l'architecture conceptuelle générale de la PFM. Introduction

Les chapitres 3, 4 et 5 résument respectivement la PFM existante dans les domaines de la PNL, du CV et du GL. Les chapitres 6 et 7 présentent d'autres recherches de pointe en matière de PFM, notamment la PFM de pointe et unifiée, l'efficacité et la compression des modèles, ainsi que la sécurité et la confidentialité.

Le chapitre 8 résume les principaux défis de la GFP. Le chapitre 9 résume le texte intégral.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Solution contre le virus de l'exe de dossier

Solution contre le virus de l'exe de dossier

java configurer les variables d'environnement jdk

java configurer les variables d'environnement jdk

exception nullpointerexception

exception nullpointerexception

Requête de temps Internet

Requête de temps Internet

Comment restaurer le navigateur IE pour accéder automatiquement à EDGE

Comment restaurer le navigateur IE pour accéder automatiquement à EDGE

méthode de suppression de fichier hiberfil

méthode de suppression de fichier hiberfil

Plusieurs façons de capturer des données

Plusieurs façons de capturer des données

Quel logiciel est ouvert ?

Quel logiciel est ouvert ?