Même sans la magie de Poudlard, vous pouvez toujours voir ce que pensent les autres !

La méthode est très simple, et elle est basée sur la diffusion stable pour visualiser des images cérébrales.

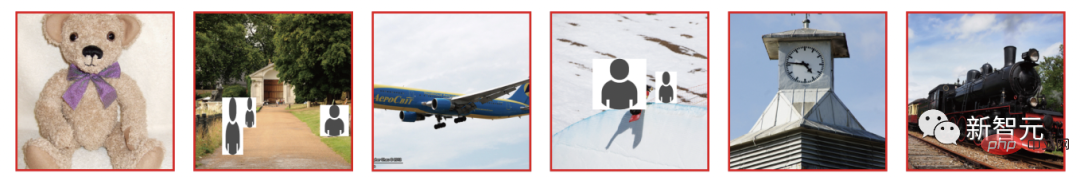

Par exemple, les ours, les avions et les trains que vous voyez ressemblent à ceci.

Lorsque l'IA voit le signal cérébral, l'image générée est la suivante, ce qui montre que tous les points nécessaires sont présents.

Cette technologie de lecture cérébrale par IA vient d'être acceptée par le CVPR 2023, offrant aux fans un "orgasme intracrânien" instantané.

C'est tellement sauvage ! Oubliez les projets incitatifs, il vous suffit désormais d'utiliser votre cerveau pour « penser » à ces images.

Imaginez utiliser la diffusion stable pour reconstruire des images visuelles à partir de données IRMf, ce qui pourrait signifier le développement d'interfaces cerveau-ordinateur non invasives à l'avenir.

Laissez l'IA ignorer directement le langage humain et percevoir ce qui pense dans le cerveau humain.

D'ici là, Neuralink développé par Musk rattrapera également ce plafond d'IA.

Alors, comment l'IA réalise-t-elle la lecture cérébrale ?

Les dernières recherches proviennent d'une équipe de recherche de l'Université d'Osaka au Japon.

Adresse papier : //m.sbmmt.com/link/0424d20160a6a558e5bf86a7bc9b67f0

École supérieure de Frontier Biosciences de l'Université d'Osaka et CiNet du Japon Les chercheurs en NTIC s’appuient sur la potentielle prolifération des modèle (LDM), plus spécifiquement, pour reconstruire l'expérience visuelle à partir de données IRMf via Stable Diffusion.

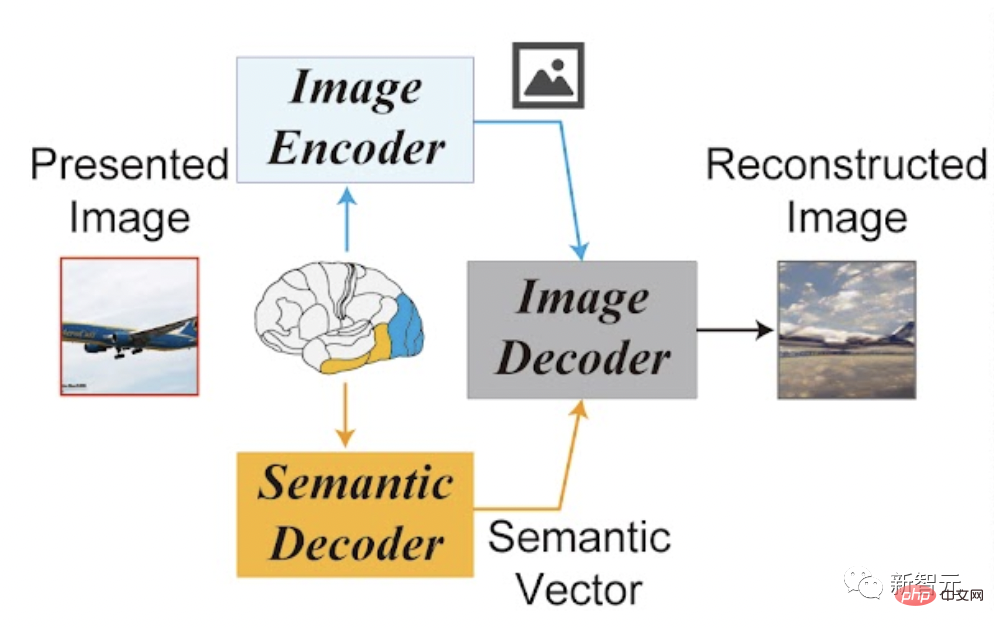

Le cadre de l'ensemble du processus opérationnel est également très simple : 1 encodeur d'image, 1 décodeur d'image et 1 décodeur sémantique.

En faisant cela, l'équipe a éliminé le besoin de former et d'affiner des modèles d'IA complexes.

Tout ce qui doit être formé est un modèle linéaire simple qui mappe les signaux IRMf des régions visuelles inférieures et supérieures du cerveau vers un seul composant de diffusion stable.

Plus précisément, les chercheurs ont cartographié des régions du cerveau comme entrée pour les encodeurs d'images et de texte. Les zones inférieures du cerveau sont mappées sur des encodeurs d’images et les zones supérieures du cerveau sont mappées sur des encodeurs de texte. Cela permet au système d'utiliser la composition de l'image et le contenu sémantique pour la reconstruction.

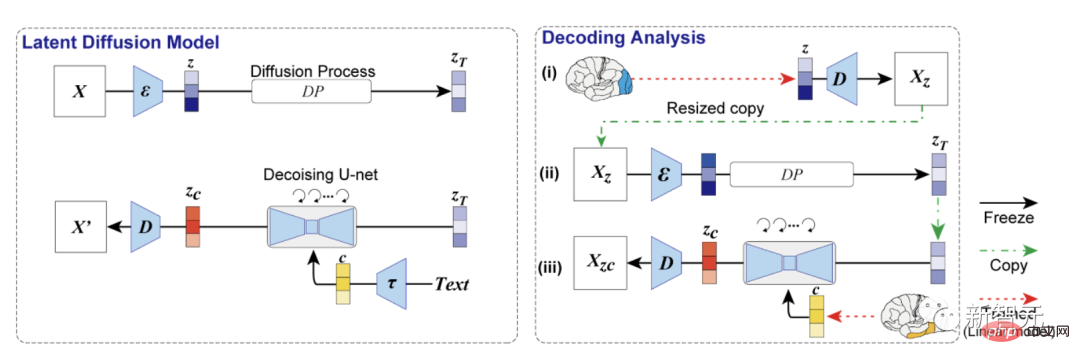

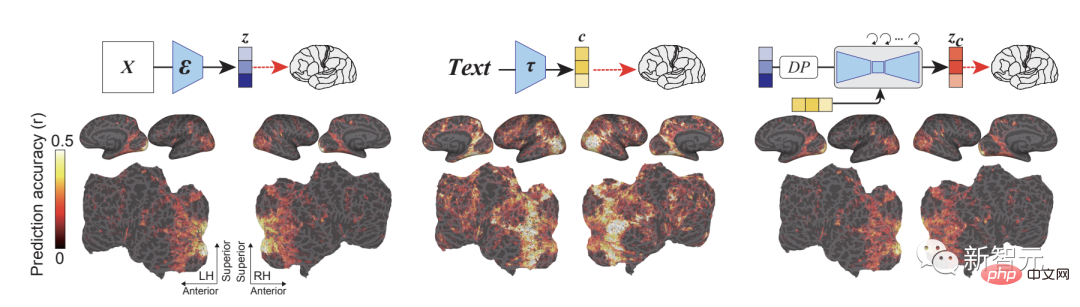

La première est l'analyse du décodage. Le modèle LDM utilisé dans l'étude se compose d'un encodeur d'image ε, d'un décodeur d'image D et d'un encodeur de texte τ.

Les chercheurs ont décodé la représentation latente de l'image reconstruite z et le texte associé c à partir des signaux IRMf du cortex visuel précoce et élevé respectivement, et les ont utilisés comme entrée pour générer l'image reproduite Xzc par l'auto-encodeur.

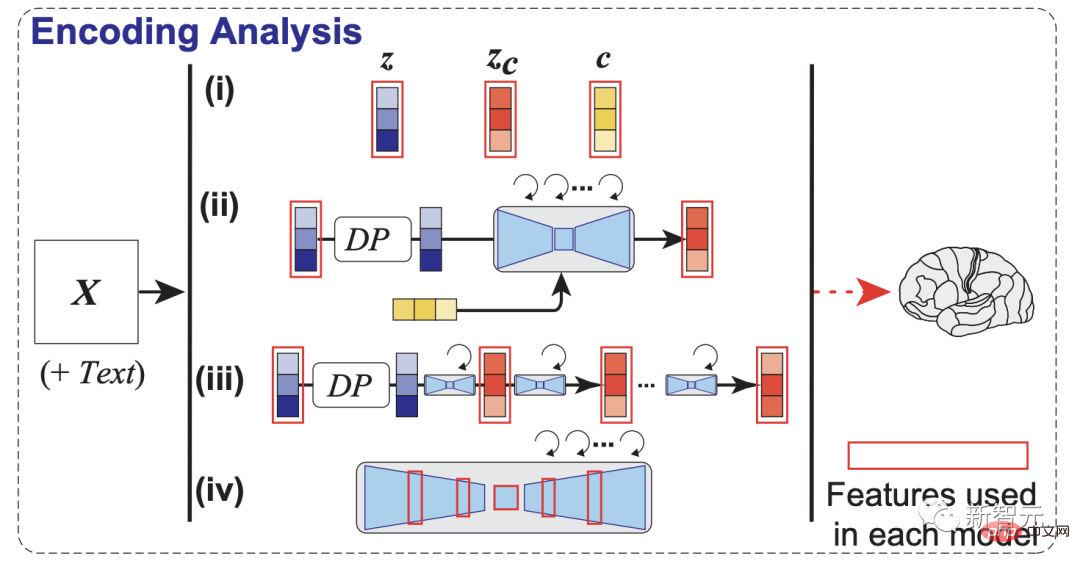

Ensuite, les chercheurs ont également construit un modèle de codage pour prédire les signaux IRMf de différents composants du LDM afin d'explorer le mécanisme de fonctionnement interne du LDM.

Les chercheurs ont mené des expériences en utilisant des images IRMf de l'ensemble de données sur les scènes naturelles (NSD) et ont testé s'ils pouvaient utiliser la diffusion stable pour reconstruire ce que les sujets ont vu.

On peut voir que le modèle de codage et la précision de prédiction des images latentes liées au LDM, le dernier modèle produit la précision de prédiction la plus élevée dans le cortex visuel à l'arrière du cerveau.

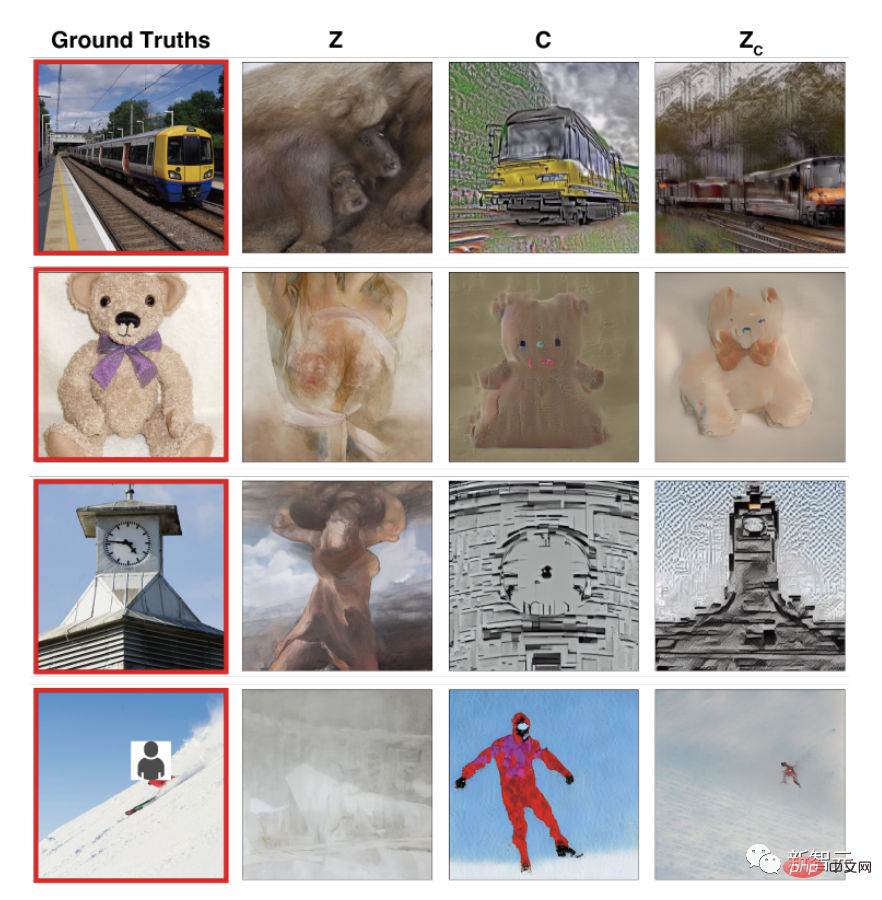

Les résultats de la reconstruction visuelle d'un sujet montrent que l'image reconstruite avec seulement z est visuellement cohérente avec l'image originale, mais ne peut pas capturer le contenu sémantique.

Bien que l'image reconstruite en utilisant uniquement c ait une meilleure fidélité sémantique, mais une mauvaise cohérence visuelle, l'image reconstruite en utilisant zc peut avoir à la fois une haute fidélité sémantique et une haute résolution.

Les résultats de reconstruction de la même image de tous les sujets montrent que l'effet de reconstruction est stable et relativement précis entre différents sujets.

Les différences dans des détails spécifiques peuvent provenir des expériences perceptuelles de différents individus ou de différences dans la qualité des données, plutôt que d'erreurs dans le processus de reconstruction.

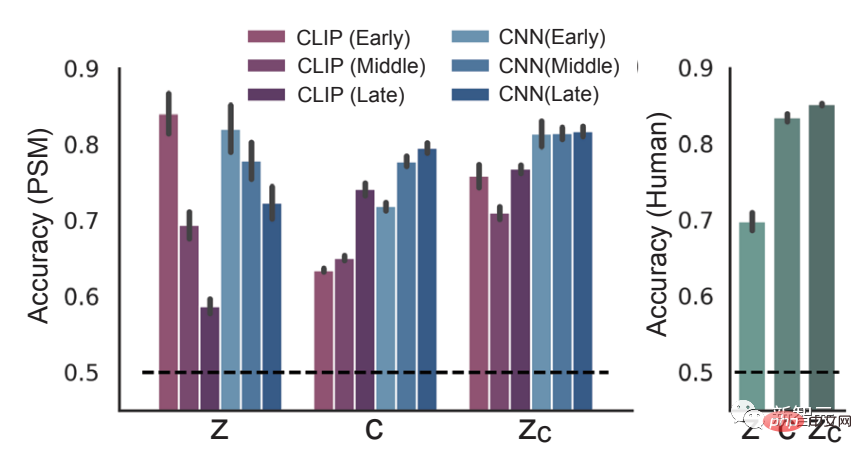

Enfin, les résultats de l'évaluation quantitative sont représentés graphiquement.

Divers résultats montrent que la méthode utilisée dans l'étude peut non seulement capturer l'apparence visuelle de bas niveau, mais également capturer le contenu sémantique de haut niveau du stimulus original.

De ce point de vue, les expériences montrent que la combinaison du décodage d'image et de texte permet une reconstruction précise.

Les chercheurs ont déclaré qu'il y avait des différences de précision entre les sujets, mais ces différences étaient liées à la qualité des images IRMf. Selon l'équipe, la qualité de la reconstruction est comparable aux méthodes SOTA actuelles, mais ne nécessite pas de formation du modèle d'IA utilisé.

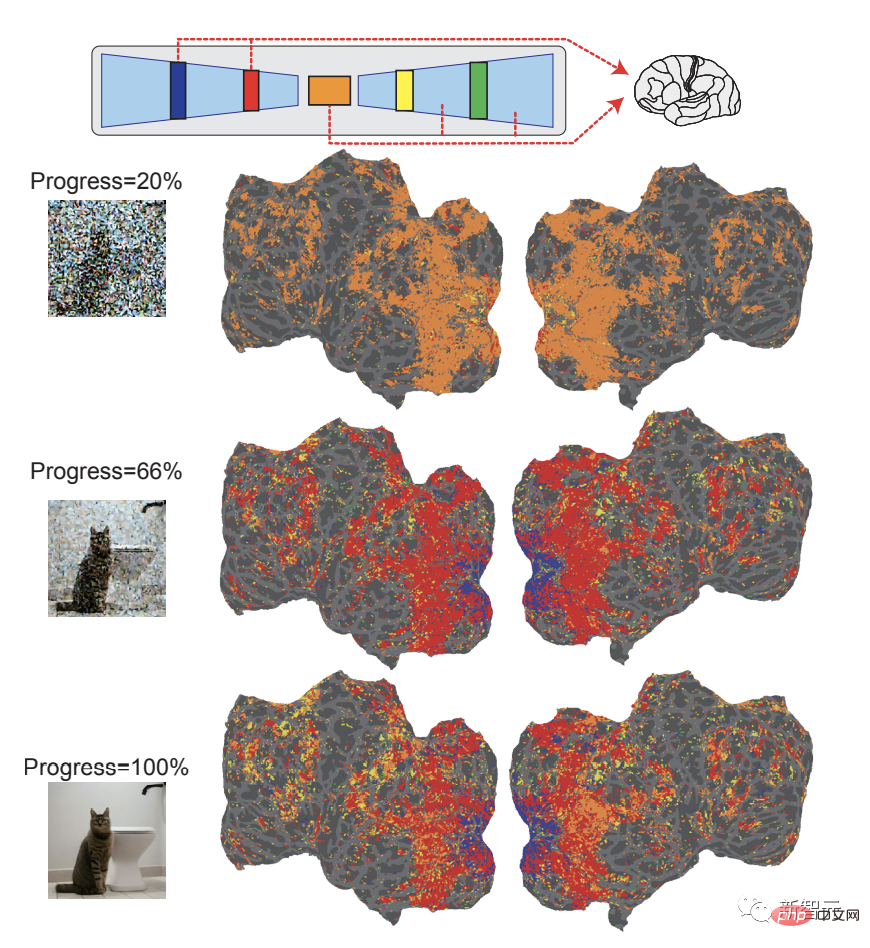

Dans le même temps, l'équipe utilise également des modèles dérivés des données IRMf pour étudier les éléments constitutifs individuels de la diffusion stable, tels que la manière dont le contenu sémantique est généré pendant le processus de rétrodiffusion ou ce qui se passe dans le processus U-Net. .

Dans les premiers stades du processus de débruitage, la couche de goulot d'étranglement (orange) d'U-Net produit les performances de prédiction les plus élevées. Au fur et à mesure que le processus de débruitage progresse, les premières couches (bleues) effectuent des prédictions sur l'activité précoce du cortex visuel. La couche de goulot d'étranglement se tourne vers le cortex visuel de haut niveau.

Cela signifie qu'au début du processus de diffusion, les informations de l'image sont compressées dans la couche du goulot d'étranglement, et avec le débruitage, la séparation entre les couches U-Net apparaît dans le cortex visuel.

De plus, l'équipe travaille sur une explication quantitative des transformations d'images à différentes étapes de diffusion. Les chercheurs visent ainsi à contribuer à une meilleure compréhension des modèles de diffusion d’un point de vue biologique, largement utilisés mais dont la compréhension est encore limitée.

Les images du cerveau humain ont déjà été décodées par l'IA ?

Depuis des années, les chercheurs utilisent des modèles d'intelligence artificielle pour décoder les informations du cerveau humain.

Le cœur de la plupart des méthodes consiste à utiliser des images IRMf préenregistrées comme entrée dans des modèles d'IA génératifs de texte ou d'images.

Par exemple, début 2018, une équipe de chercheurs japonais a démontré comment un réseau neuronal pouvait reconstruire des images à partir d’enregistrements IRMf.

En 2019, un groupe a reconstruit des images de neurones de singe, et le groupe de recherche de Meta, dirigé par Jean-Remi King, a publié de nouveaux travaux tels que la dérivation de texte à partir de données IRMf.

En octobre 2022, une équipe de l'Université du Texas à Austin a montré qu'un modèle GPT pouvait déduire un texte à partir d'analyses IRMf qui décrit le contenu sémantique de ce qu'une personne a vu dans une vidéo.

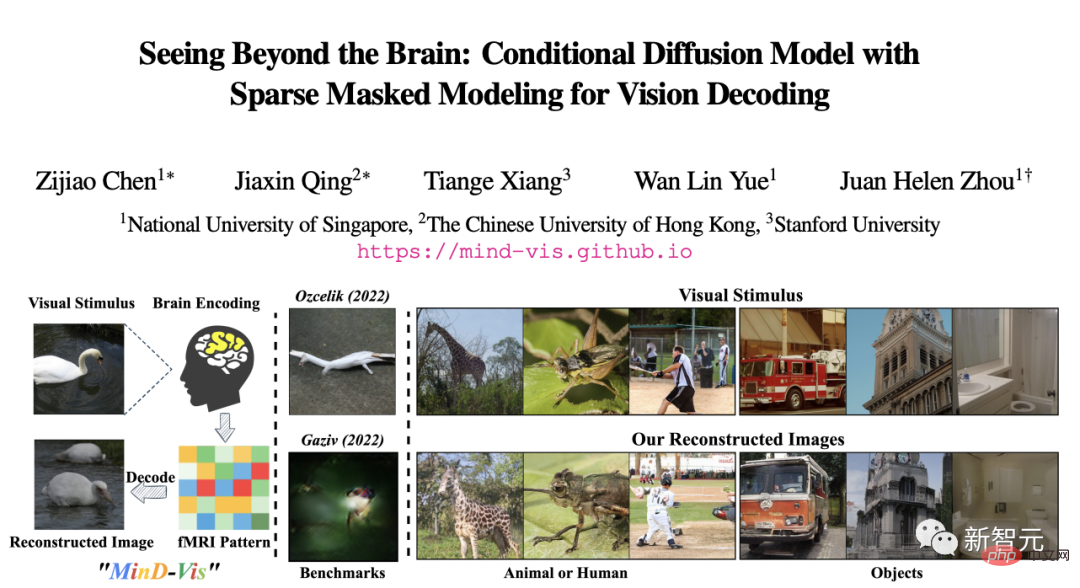

En novembre 2022, des chercheurs de l'Université nationale de Singapour, de l'Université chinoise de Hong Kong et de l'Université de Stanford ont utilisé le modèle de diffusion MinD-Vis pour reconstruire des images à partir d'analyses IRMf avec une précision nettement supérieure à celle des méthodes disponibles à l'époque.

Si vous remontez plus loin, certains internautes ont souligné que "la génération d'images basées sur les ondes cérébrales existe depuis au moins 2008, ce qui implique d'une manière ou d'une autre que la diffusion stable peut lire les pensées des gens. C'est tout simplement ridicule. ”

Cet article publié dans Nature par l'Université de Californie à Berkeley, affirme que l'activité des ondes cérébrales humaines peut être convertie en images à l'aide d'un décodeur visuel.

Pour retracer l'histoire, certaines personnes ont directement cité une étude de 1999 de Stanford Li Feifei sur la reconstruction d'images à partir du cortex cérébral.

Li Feifei l'a également commenté et transmis, disant qu'elle était encore stagiaire universitaire à l'époque.

Également en 2011, une étude de l'UC Berkeley a utilisé l'imagerie par résonance magnétique fonctionnelle (IRMf) et des modèles informatiques pour reconstruire initialement « l'image visuelle dynamique » du cerveau.

C'est-à-dire qu'ils ont recréé des clips que les gens ont vus.

Mais par rapport aux dernières recherches, cette reconstruction n'est pas du tout "haute définition" et est presque méconnaissable.

Présentation de l'auteur

Yu Takagi

Yu Takagi est professeur adjoint à l'Université d'Osaka. Ses intérêts de recherche se situent à l’intersection des neurosciences computationnelles et de l’intelligence artificielle.

Au cours de son doctorat, il a étudié des techniques permettant de prédire différentes différences individuelles à partir de la connectivité fonctionnelle du cerveau entier à l'aide de l'imagerie par résonance magnétique fonctionnelle (IRMf) au laboratoire de recherche sur la communication et l'information cérébrale ATR.

Récemment, il a utilisé des techniques d'apprentissage automatique pour comprendre les calculs dynamiques dans des tâches de prise de décision complexes au Centre d'Oxford pour l'activité cérébrale humaine de l'Université d'Oxford et au Département de psychologie de l'Université de Tokyo.

Shinji Nishimoto

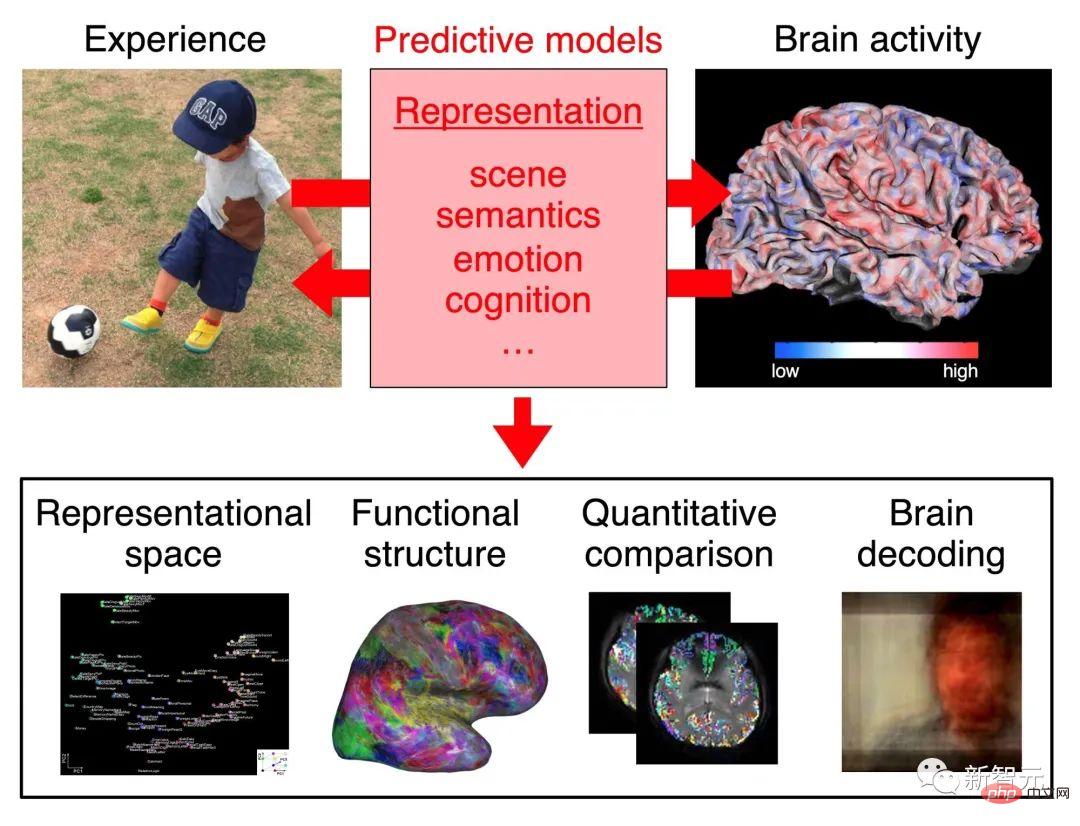

Shinji Nishimoto est professeur à l'Université d'Osaka. Ses recherches portent sur la compréhension quantitative des processus visuels et cognitifs dans le cerveau.

Plus précisément, l'objectif de recherche de l'équipe du professeur Nishimoto est de comprendre le traitement et la représentation neuronaux en construisant des modèles prédictifs de l'activité cérébrale évoquée dans des conditions perceptuelles et cognitives naturelles.

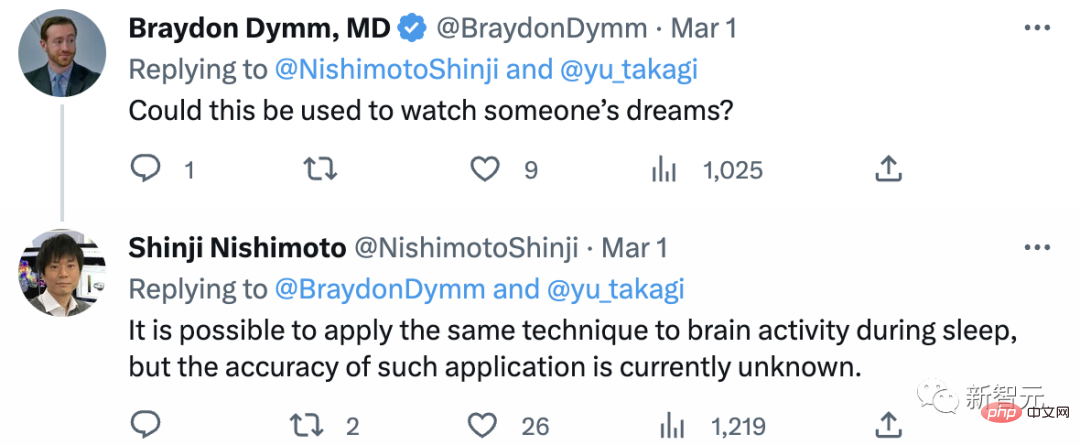

Certains internautes ont demandé à l'auteur si cette recherche pouvait être utilisée pour interpréter les rêves ?

"Il est possible d'appliquer la même technologie à l'activité cérébrale pendant le sommeil, mais l'exactitude d'une telle application n'est actuellement pas claire." .

Référence :

Référence :

//m.sbmmt.com/link/0424d20160a6a558e5bf86a7bc9b67f0

https://www . php.cn/link/02d72b702eed900577b953ef7a9c1182

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

supprimer le dossier sous Linux

supprimer le dossier sous Linux

Introduction à la signification d'un mot de passe invalide

Introduction à la signification d'un mot de passe invalide

Présentation du serveur PHP

Présentation du serveur PHP

Comment utiliser la fonction norme en python

Comment utiliser la fonction norme en python

Solution au code Java qui ne fonctionne pas

Solution au code Java qui ne fonctionne pas

lien du serveur émule

lien du serveur émule

Tutoriel du portefeuille Eou web3

Tutoriel du portefeuille Eou web3

Quelle est la fonction du diviseur de fréquence

Quelle est la fonction du diviseur de fréquence