Ces dernières années, la recherche sur la génération d'images basée sur le Generative Adversarial Network (GAN) a fait des progrès significatifs. En plus de pouvoir générer des images réalistes de haute résolution, de nombreuses applications innovantes ont également vu le jour, telles que l'édition d'images personnalisées, l'animation d'images, etc. Cependant, comment utiliser le GAN pour la génération de vidéos reste un problème difficile.

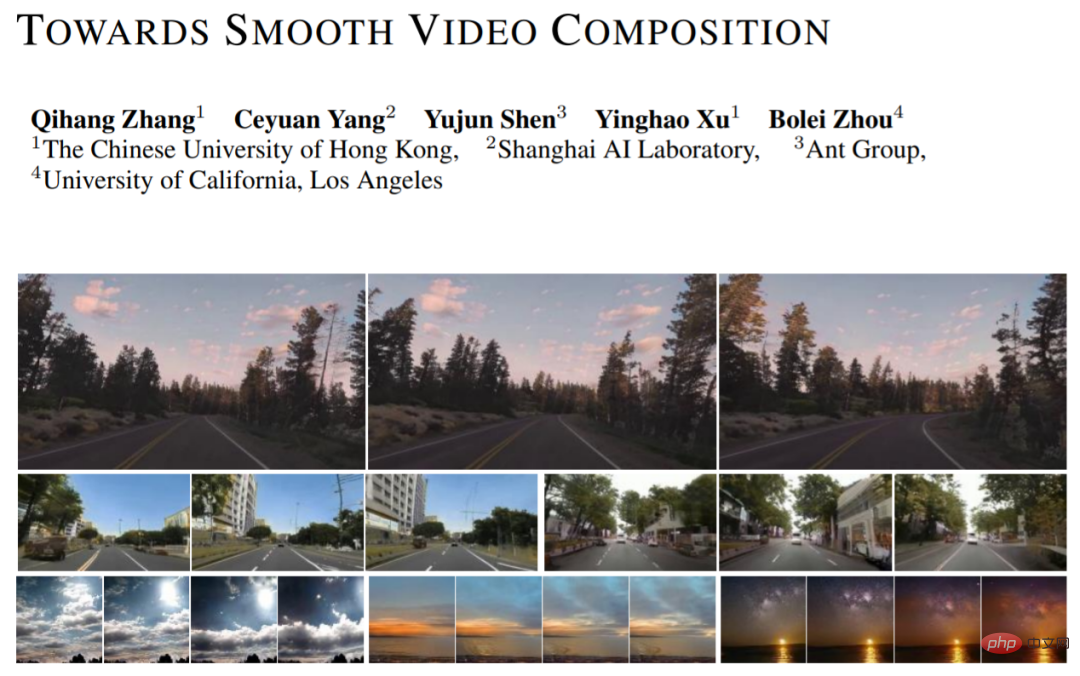

En plus de modéliser des images à image unique, la génération vidéo nécessite également l'apprentissage de relations temporelles complexes. Récemment, des chercheurs de l'Université chinoise de Hong Kong, du Laboratoire d'intelligence artificielle de Shanghai, de l'Ant Technology Research Institute et de l'Université de Californie à Los Angeles ont proposé une nouvelle méthode de génération vidéo (Towards Smooth Video Composition). Dans l’article, ils ont effectué une modélisation détaillée et amélioré les relations des séries chronologiques de différentes durées (court terme, modéré, long terme) et ont obtenu des améliorations significatives par rapport aux travaux antérieurs sur plusieurs ensembles de données. Ce travail fournit une nouvelle référence simple et efficace pour la génération vidéo basée sur le GAN.

Le réseau de génération d'images basé sur GAN peut être exprimé comme suit : I=G(Z), où Z est une variable aléatoire, G est le réseau de génération et I est l'image générée. Nous pouvons simplement étendre ce cadre à la catégorie de génération vidéo : I_i=G(z_i), i=[1,...,N], où nous échantillonnons N variables aléatoires z_i à la fois, et chaque variable aléatoire z_i génère un correspondant Un cadre d'image I_i. La vidéo générée peut être obtenue en empilant les images générées dans la dimension temporelle.

MoCoGAN, StyleGAN-V et d'autres travaux ont proposé une expression découplée sur cette base : I_i=G(u, v_i), i=[1,...,N], où u représente le contenu du contrôle. variable, v_i représente la variable aléatoire qui contrôle l'action. Cette représentation considère que toutes les images partagent le même contenu et ont un mouvement unique. Grâce à cette expression découplée, nous pouvons mieux générer des vidéos d’action avec des styles de contenu cohérents et un réalisme variable. Le nouveau travail adopte la conception de StyleGAN-V et l'utilise comme base de référence.

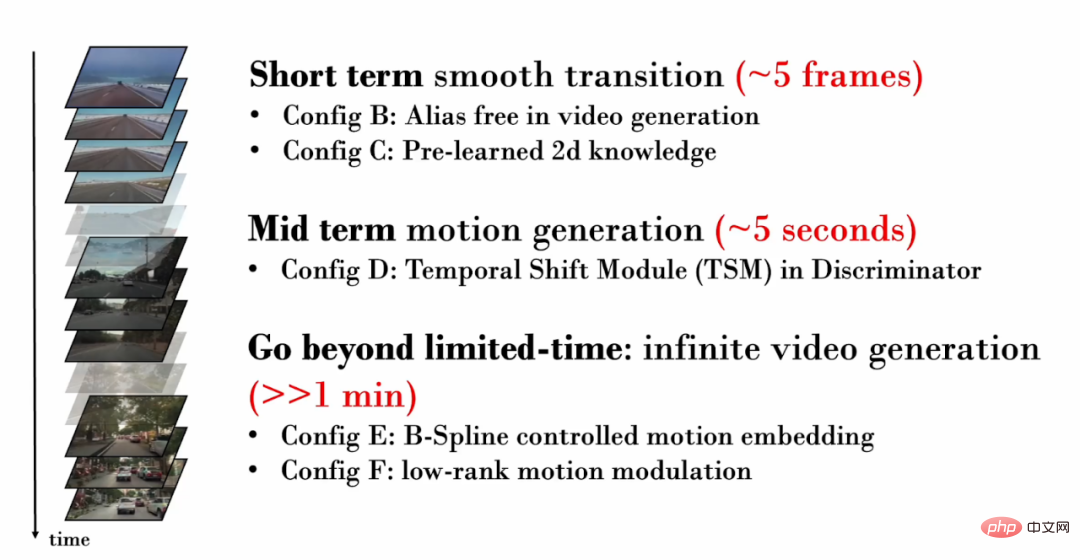

Le nouveau travail se concentre sur les relations temporelles de différentes durées (courte plage de temps, moyenne portée, longue portée) et effectue respectivement une modélisation et une amélioration détaillées :

Courte durée (~ 5 images. ) Relation temporelle

Considérons d'abord une vidéo comportant seulement quelques images. Ces courtes images vidéo contiennent souvent un contenu très similaire, ne montrant que des mouvements très subtils. Il est donc crucial de générer de manière réaliste des mouvements subtils entre les images. Cependant, de sérieux problèmes de texture se produisent dans les vidéos générées par StyleGAN-V.

L'adhésion de texture fait référence au fait qu'une partie du contenu généré dépend de coordonnées précises, provoquant le phénomène de "collage" à une zone fixe. Dans le domaine de la génération d'images, StyleGAN3 atténue le problème de l'adhésion des textures grâce à un traitement détaillé du signal, une plage de remplissage étendue et d'autres opérations. Ce travail vérifie que la même technique est toujours efficace pour la génération vidéo.

Dans la visualisation ci-dessous, nous suivons les pixels au même endroit dans chaque image de la vidéo. Il est facile de constater que dans la vidéo StyleGAN-V, certains contenus sont restés « collants » à des coordonnées fixes pendant une longue période et n'ont pas bougé au fil du temps, produisant ainsi un « phénomène de pinceau » dans la visualisation. Dans les vidéos générées par la nouvelle œuvre, tous les pixels présentent un mouvement naturel.

Cependant, les chercheurs ont découvert que le référencement à l'épine dorsale de StyleGAN3 réduirait la qualité de la génération d'images. Pour atténuer ce problème, ils ont introduit une pré-formation au niveau de l’image. Au cours de la phase de pré-formation, le réseau n'a besoin que de prendre en compte la qualité de génération d'une certaine image dans la vidéo et n'a pas besoin d'apprendre la modélisation de la plage temporelle, ce qui facilite l'apprentissage des connaissances sur la distribution des images.

2. Relation temporelle de durée moyenne (~ 5 secondes)

Comme la vidéo générée comporte plus d'images, elle pourra afficher des actions plus spécifiques. Par conséquent, il est important de s’assurer que la vidéo générée présente un mouvement réaliste. Par exemple, si nous voulons générer une vidéo de conduite à la première personne, nous devons générer une scène de sol et de rue qui s'éloigne progressivement, et la voiture qui s'approche doit également suivre une trajectoire de conduite naturelle.

Dans la formation contradictoire, afin de garantir que le réseau génératif bénéficie d'un encadrement suffisant de la formation, le réseau discriminant est crucial. Par conséquent, lors de la génération vidéo, afin de garantir que le réseau génératif puisse générer des actions réalistes, le réseau discriminant doit modéliser les relations temporelles dans plusieurs images et capturer le mouvement irréaliste généré. Cependant, dans des travaux antérieurs, le réseau discriminant utilisait uniquement une simple opération de concaténation pour effectuer une modélisation temporelle : y = cat (y_i), où y_i représente la caractéristique à image unique et y représente la caractéristique après la fusion du domaine temporel.

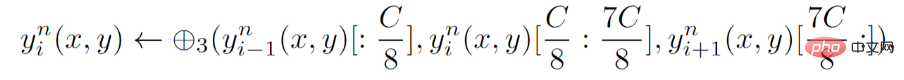

Pour le réseau discriminant, le nouveau travail propose une modélisation temporelle explicite, c'est-à-dire l'introduction du module de décalage temporel (TSM) à chaque couche du réseau discriminant. TSM vient du domaine de la reconnaissance d'actions et réalise l'échange d'informations temporelles grâce à de simples opérations de décalage :

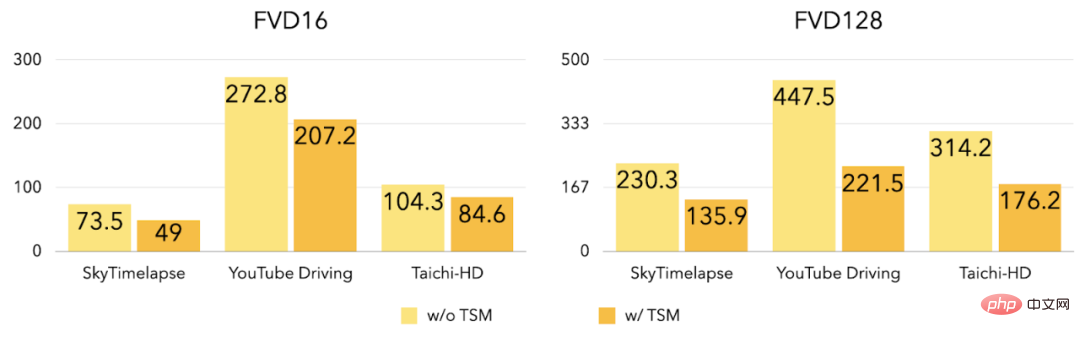

Les expériences montrent qu'après l'introduction de TSM, FVD16 et FVD128 sur les trois ensembles de données ont été considérablement réduits.

3. Génération de vidéos illimitées

Les améliorations introduites précédemment se concentrent principalement sur la génération de vidéos de courte et moyenne durée, et le nouveau travail explore plus en détail comment générer des vidéos de haute qualité. vidéos vidéos de n'importe quelle longueur (y compris une durée illimitée). Les travaux antérieurs (StyleGAN-V) peuvent générer des vidéos infiniment longues, mais la vidéo contient une gigue périodique très évidente :

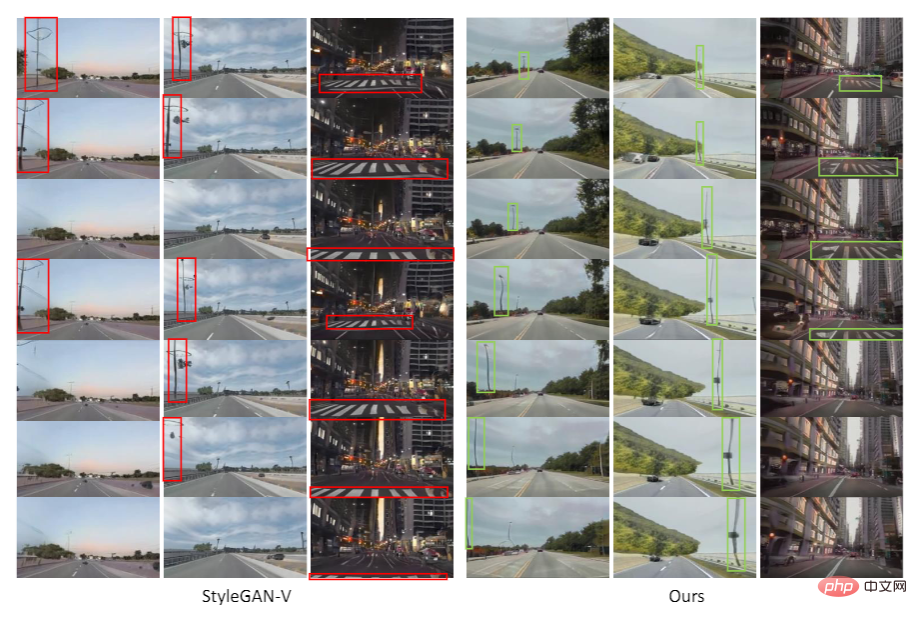

Comme le montre la figure, la vidéo générée dans StyleGAN-V Dans la vidéo, comme le véhicule avance, le passage piéton s'est initialement déplacé vers l'arrière normalement, mais a ensuite soudainement changé pour avancer. Ce travail a révélé que la discontinuité des caractéristiques du mouvement (intégration du mouvement) était à l'origine de ce phénomène de gigue.

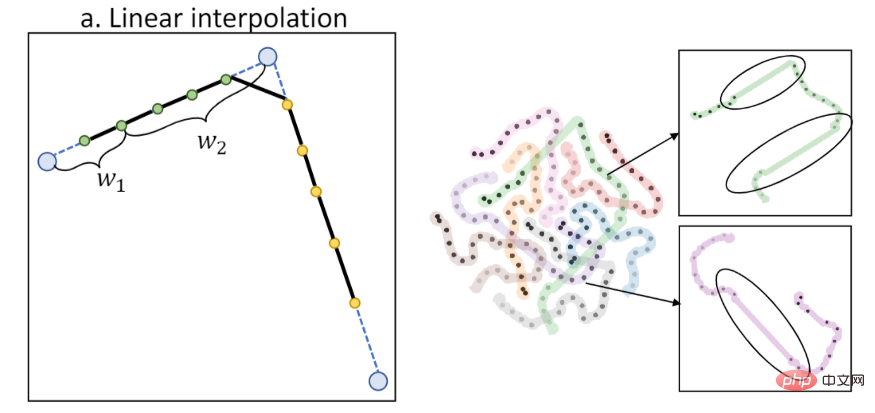

Les travaux précédents utilisaient l'interpolation linéaire pour calculer les caractéristiques d'action. Cependant, l'interpolation linéaire conduira à une discontinuité de premier ordre, comme le montre la figure suivante (la gauche est le diagramme d'interpolation, la droite est la visualisation des caractéristiques T-SNE). :

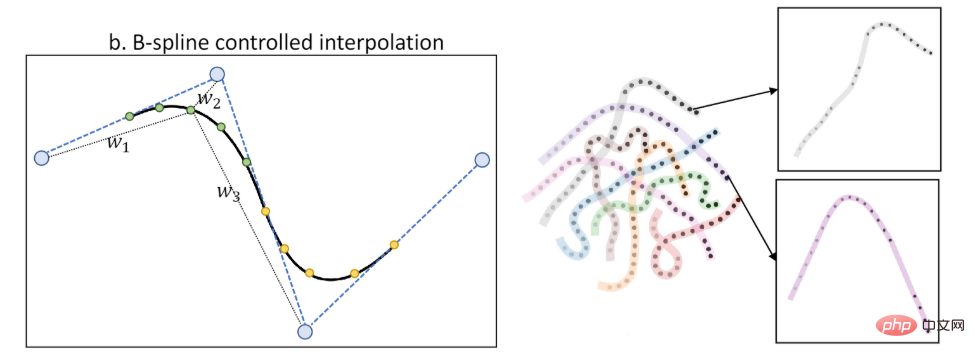

Ce travail propose les caractéristiques de mouvement du contrôle B-spline (B-Spline based motion embedding). L'interpolation via B-spline peut obtenir des caractéristiques d'action plus fluides par rapport au temps, comme le montre la figure (la gauche est le diagramme d'interpolation, la droite est la visualisation des caractéristiques T-SNE) :

En introduisant les caractéristiques d'action du contrôle B-spline, le nouveau travail atténue le phénomène de gigue :

Comme le montre la figure, dans la vidéo générée par StyleGAN-V, les lampadaires et le le sol changera soudainement la direction du mouvement. Dans les vidéos générées par la nouvelle œuvre, la direction du mouvement est cohérente et naturelle.

Dans le même temps, le nouveau travail propose également une contrainte de faible rang sur les fonctionnalités d'action pour atténuer davantage l'apparition de contenu répétitif périodique.

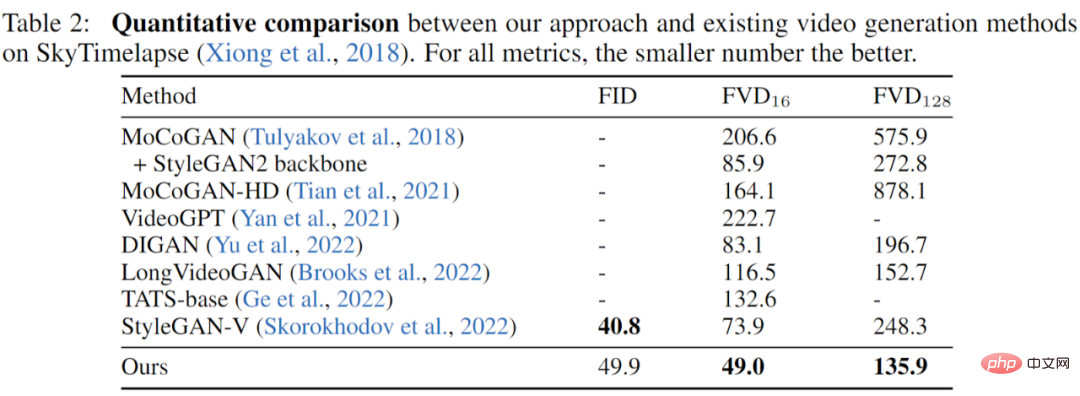

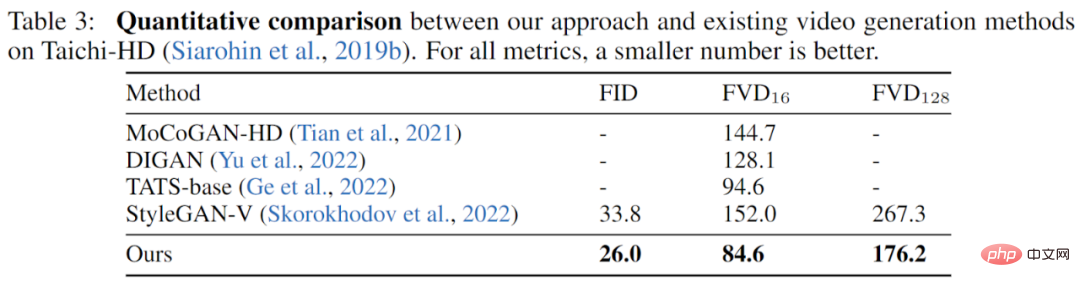

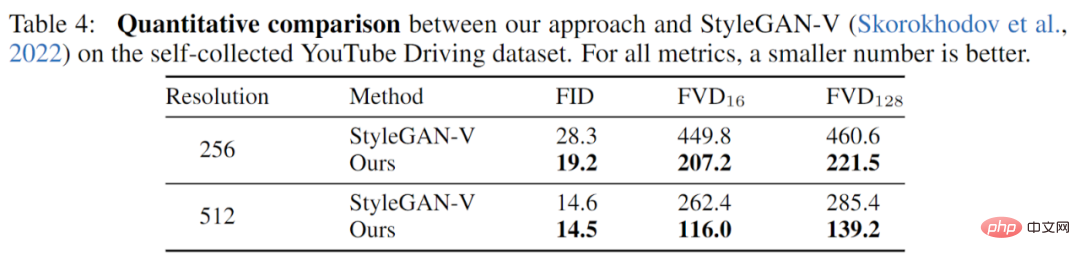

Le travail a été entièrement expérimenté sur trois ensembles de données (YouTube Driving, Timelapse, Taichi-HD) et entièrement comparé aux travaux précédents. Les résultats montrent que le nouveau travail a de meilleures performances en qualité d'image (FID). et la qualité vidéo (FVD) a été entièrement améliorée.

SkyTimelapse Résultats expérimentaux :

Taichi-HD Résultats expérimentaux :

Résultats des expériences de conduite YouTube :

Le nouveau travail propose un nouveau benchmark de génération vidéo basé sur le modèle GAN À partir de la relation temporelle de différentes échelles, il propose des améliorations nouvelles et efficaces. Des expériences sur plusieurs ensembles de données montrent que le nouveau travail atteint avec succès une qualité vidéo qui dépasse largement les travaux précédents.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Que faire avec la carte vidéo

Que faire avec la carte vidéo

Comment télécharger des vidéos de Douyin

Comment télécharger des vidéos de Douyin

Comment résoudre le problème de l'écran noir après avoir allumé l'ordinateur et impossible d'accéder au bureau

Comment résoudre le problème de l'écran noir après avoir allumé l'ordinateur et impossible d'accéder au bureau

l'explorateur Windows a cessé de fonctionner

l'explorateur Windows a cessé de fonctionner

Comment résoudre l'échec de la résolution DNS

Comment résoudre l'échec de la résolution DNS

Les principaux composants qui composent le CPU

Les principaux composants qui composent le CPU

geforce 940mx

geforce 940mx

solution de panique du noyau

solution de panique du noyau