Cette entreprise a fabriqué un produit qui pourrait déclencher la quatrième révolution industrielle, mais elle est perplexe : pourquoi ses produits sont-ils si populaires ?

Ce n’est vraiment pas Versailles.

Récemment, MIT Technology Review a interviewé plusieurs développeurs de ChatGPT, nous donnant un aperçu plus approfondi de l'histoire de ce produit d'IA populaire.

C'est si populaire qu'il n'y a aucune défense du tout

Lorsque OpenAI a discrètement lancé ChatGPT fin novembre 2022, la startup n'avait pas de grandes attentes.

Les employés d'OpenAI n'auraient jamais pensé que leur modèle serait en passe de devenir un modèle de premier ordre.

ChatGPT semble être devenu populaire du jour au lendemain, déclenchant une ruée vers l'or mondiale pour les grands modèles de langage. Cependant, OpenAI n'est pas du tout préparé et ne peut que se précipiter pour rattraper ses meilleurs modèles et tenter de saisir l'opportunité commerciale. .

Sandhini Agarwal, qui travaille sur les politiques chez OpenAI, a déclaré qu'au sein d'OpenAI, ChatGPT a toujours été considéré comme un « aperçu de la recherche » - il s'agit d'une version plus complète de la technologie vieille de deux ans, et plus important encore, l’entreprise essaie de transmettre les commentaires du public pour éliminer certaines des lacunes du modèle.

Qui aurait pensé qu'un tel produit « avant-première » deviendrait populaire après ses débuts par accident.

Les scientifiques d'OpenAI sont très confus à ce sujet, et ils sont également très conscients des fleurs et des applaudissements du monde extérieur.

"Nous ne voulons pas exagérer cela en le considérant comme un énorme progrès fondamental", a déclaré Liam Fedus, un scientifique d'OpenAI qui a participé au développement de ChatGPT.

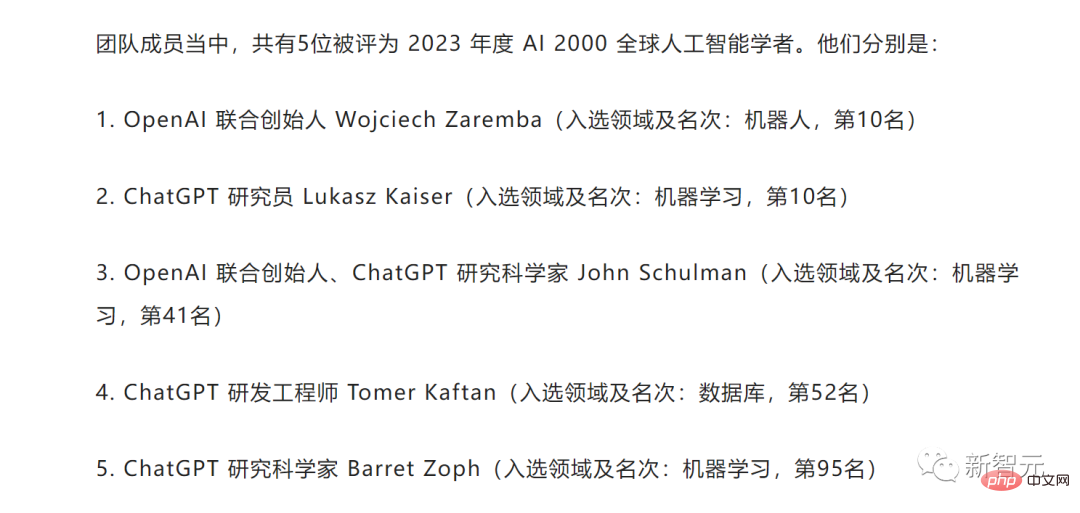

Parmi les membres de l'équipe ChatGPT, 5 ont été nommés AI 2000 Global Artificial Intelligence Scholars en 2023

Pour cette raison, le journaliste du MIT Technology Review, Will Douglas Heaven, a interviewé la coentreprise de John Schulman, fondateur d'OpenAI, les développeurs Agarwal et Fedus et le chef de l'équipe d'alignement Jan Leike.

Le fondateur John Schulman a déclaré que quelques jours après la sortie de ChatGPT, il consultait Twitter de temps en temps. Il y a eu une période folle où le fil Twitter était rempli de captures d'écran de ChatGPT.

Il pensait que c'était un produit très intuitif pour les utilisateurs et qu'il aurait quelques fans, mais il ne s'attendait pas à ce qu'il devienne si courant.

Jan Leike a déclaré que tout était si soudain et que tout le monde était surpris et s'efforçait de suivre la popularité de ChatGPT. Il était curieux de savoir ce qui était à l’origine de sa popularité croissante. Y avait-il quelqu’un dans les coulisses ? Après tout, OpenAI lui-même ne comprend pas pourquoi ChatGPT est si populaire.

Liam Fedus a expliqué pourquoi ils étaient si surpris, car ChatGPT n'est pas le premier chatbot à usage général, et beaucoup de gens l'ont déjà essayé, donc Liam Fedus estime que leurs chances ne sont pas grandes. Cependant, la version bêta privée lui a également donné confiance - peut-être que ce A est quelque chose que les utilisateurs apprécieront vraiment.

Sandhini Agarwal a conclu que le succès instantané de ChatGPT a été une surprise pour tout le monde. Tant de travail a été réalisé sur ces modèles qu’on oublie à quel point ils sont étonnants pour le grand public extérieur à l’entreprise.

En effet, la plupart des technologies au sein de ChatGPT ne sont pas nouvelles. Il s'agit d'une version affinée de GPT-3.5, publiée par OpenAI quelques mois avant ChatGPT. GPT-3.5 lui-même est une version mise à jour de GPT-3, apparue en 2020.

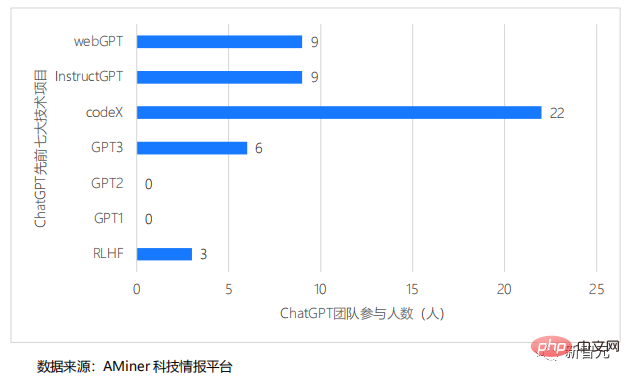

L'équipe ChatGPT a participé aux sept précédents numéros majeurs de R&D technologique

Sur le site Web, OpenAI fournit ces modèles sous forme d'interfaces de programmation d'applications ou d'API, et d'autres développeurs peuvent facilement insérer les modèles dans votre propre code.

En janvier 2022, OpenAI a également publié InstructGPT, une précédente version affinée de GPT-3.5. Cependant, ces technologies ne sont pas promues auprès du public.

Selon l'introduction de Liam Fedus, le modèle ChatGPT est affiné à partir du même modèle de langage qu'InstructGPT, et la méthode de réglage fin utilisée est similaire. Les chercheurs ont ajouté quelques données de conversation et apporté quelques ajustements au processus de formation. Ils ne veulent donc pas exagérer cela en le considérant comme une énorme avancée fondamentale.

Il s'avère que ce qui joue un rôle important dans ChatGPT, ce sont les données de conversation.

Selon l'évaluation des benchmarks standards, il n'y a en fait pas de grande différence dans les capacités techniques brutes entre les deux modèles. La plus grande différence entre ChatGPT est qu'il est plus facile à obtenir et à utiliser.

Jan Leike a expliqué que dans un sens, ChatGPT peut être compris comme une version du système d'IA qu'OpenAI possède depuis un certain temps. ChatGPT n'est pas plus performant. Le même modèle de base était utilisé sur l'API depuis près d'un an avant la sortie de ChatGPT.

Les améliorations apportées par les chercheurs peuvent se résumer à, dans un sens, le rendre plus conforme à l'utilisation que les humains souhaitent en faire. Il parle à l'utilisateur dans une conversation, constitue une interface de chat et est facilement accessible. Cela facilite la déduction de l'intention et les utilisateurs peuvent expérimenter d'avant en arrière pour obtenir ce qu'ils veulent.

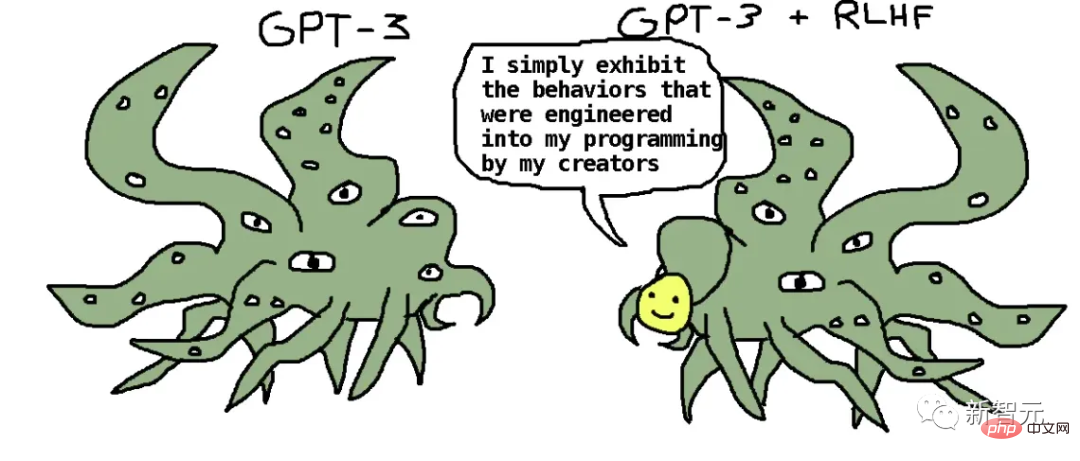

Le secret réside dans la technologie d'apprentissage par renforcement avec feedback humain (RLHF), qui est très similaire à la méthode de formation d'InstructGPT - lui apprenant ce que les utilisateurs humains aiment réellement.

Jan Leike a déclaré avoir demandé à un grand groupe de personnes de lire les invites et les réponses de ChatGPT, puis de choisir l'une des deux réponses pour voir quelle réponse tout le monde pensait être la meilleure. Ensuite, toutes ces données sont combinées en une seule session de formation.

La plupart sont les mêmes que ce qu'ils font sur InstructGPT. Comme si vous espériez que c'est utile, vous espérez que c'est vrai, vous espérez que ce n'est pas vicieux.

Il y a aussi quelques détails. Par exemple, si la requête de l'utilisateur n'est pas claire, il doit poser des questions de suivi pour l'affiner. Il devrait également préciser qu’il s’agit d’un système d’intelligence artificielle et qu’il ne doit pas assumer une identité qu’il n’a pas ni prétendre avoir des capacités qu’il ne possède pas. Lorsque l’utilisateur lui demande d’effectuer une tâche qu’il n’est pas censé faire, il doit explicitement refuser.

C'est-à-dire qu'il existe une liste de divers critères dont disposent les évaluateurs humains pour classer les modèles, tels que l'authenticité. Mais ils préféreront aussi certaines pratiques, comme l’IA qui ne prétend pas être humaine.

En général, ChatGPT utilise des technologies qu'OpenAI a déjà utilisées, l'équipe n'a donc rien fait de spécial lors de la préparation de la publication de ce modèle au public. Selon eux, les normes fixées pour les modèles précédents étaient suffisantes et GPT-3.5 était suffisamment sécurisé.

Dans la formation des préférences humaines de ChatGPT, il a appris par lui-même le comportement de rejet et a rejeté de nombreuses demandes.

OpenAI a rassemblé quelques « chanteurs » pour ChatGPT : tout le monde dans l'entreprise s'est assis et a essayé de casser le modèle. Il existe également des groupes extérieurs qui font la même chose. Les premiers utilisateurs de confiance fournissent également des commentaires.

Sandhini Agarwal a déclaré avoir constaté que cela produisait des résultats indésirables, mais ce sont des choses que GPT-3.5 produit également. Par conséquent, si l’on examine uniquement les risques, ChatGPT constitue un « aperçu de recherche » suffisant.

John Schulman a également déclaré qu'il est impossible d'attendre qu'un système soit parfait à 100% avant de le publier. Ils testent les premières versions bêta depuis plusieurs mois et les bêta-testeurs ont été très impressionnés par ChatGPT.

Ce qui inquiète le plus OpenAI, ce sont en fait les problèmes factuels, car ChatGPT aime trop fabriquer des choses. Mais ces problèmes existent dans InstructGPT et d’autres grands modèles de langage, donc aux yeux des chercheurs, tant que ChatGPT est meilleur que ces modèles en termes de factualité et d’autres problèmes de sécurité, c’est suffisant.

Et sur la base d'une évaluation limitée, avant la sortie, il peut être confirmé que ChatGPT est plus réaliste et plus sécurisé que les autres modèles, c'est pourquoi OpenAI a décidé de poursuivre la sortie.

Après la sortie de ChatGPT, OpenAI a observé comment les utilisateurs l'utilisent.

Un grand modèle de langage est placé entre les mains de dizaines de millions d'utilisateurs. C'est la première fois dans l'histoire.

Les utilisateurs deviennent également fous et veulent tester les limites de ChatGPT et où se trouvent les bugs.

La popularité de ChaatGPT a également fait émerger de nombreux problèmes, tels que des problèmes de biais et des problèmes induits par les invites.

Jan Leike a déclaré que certaines des choses qui sont devenues virales sur Twitter ont en fait été discrètement prises en charge par OpenAI.

Par exemple, le problème du jailbreak est définitivement quelque chose qu'ils doivent résoudre. Les utilisateurs aiment simplement essayer de faire dire de mauvaises choses au modèle à travers quelques rebondissements. Cela correspond aux attentes d'OpenAI et c'est également la seule voie à suivre.

Lorsque des jailbreaks seront découverts, OpenAI ajoutera ces conditions aux données de formation et de test, et toutes les données seront incorporées dans les futurs modèles.

Jan Leike a déclaré que chaque fois qu'il y aurait un meilleur modèle, ils voudront le sortir et le tester.

Ils sont très optimistes quant au fait qu'une formation contradictoire ciblée peut grandement améliorer la situation du jailbreak. Même s'il n'est pas clair si ces problèmes disparaîtront complètement, ils pensent qu'ils peuvent rendre difficiles de nombreux jailbreaks.

Quand un système « fait officiellement ses débuts », il est difficile de prévoir tout ce qui va réellement se passer.

Ils peuvent donc uniquement se concentrer sur la surveillance de la raison pour laquelle les gens utilisent le système, voir ce qui se passe, puis réagir en conséquence.

Maintenant, Microsoft a lancé Bing Chat, que beaucoup de gens pensent être une version du GPT-4 officiellement inopiné d'OpenAI.

Partant de cette prémisse, Sandhini Agarwal a déclaré que le niveau auquel ils sont confrontés aujourd'hui est certainement beaucoup plus élevé qu'il y a six mois, mais toujours inférieur au niveau d'un an plus tard.

Le contexte dans lequel ces modèles sont utilisés est extrêmement important.

Pour les grandes entreprises comme Google et Microsoft, même si une chose n'est pas vraie, cela devient un énorme problème car elles sont elles-mêmes des moteurs de recherche.

Paul Buchheit, le 23ème employé de Google, qui a créé Gmail, a une attitude pessimiste envers Google

En tant que grand modèle de langage pour un moteur de recherche, il est complètement différent d'un chatbot juste pour le plaisir. Les chercheurs d’OpenAI travaillent également dur pour comprendre comment passer d’une utilisation à l’autre et créer quelque chose de vraiment utile aux utilisateurs.

John Schulman a admis qu'OpenAI avait sous-estimé à quel point les gens se soucient des questions politiques dans ChatGPT. À cette fin, ils espèrent prendre de meilleures décisions lors de la collecte de données sur la formation afin de réduire les problèmes dans ce domaine.

Jan Leike a déclaré que de son propre point de vue, ChatGPT échoue souvent. Il y a tellement de problèmes à résoudre, mais OpenAI ne les résout pas. Cela, a-t-il admis franchement.

Bien que les modèles linguistiques existent depuis un certain temps, ils en sont encore à leurs débuts.

Ensuite, il y a encore d'autres choses qu'OpenAI doit faire.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!