L'algorithme d'apprentissage par renforcement hors ligne (Offline RL) est l'une des sous-directions les plus populaires de l'apprentissage par renforcement. L'apprentissage par renforcement hors ligne n'interagit pas avec l'environnement et vise à apprendre les politiques cibles à partir de données précédemment enregistrées. L'apprentissage par renforcement hors ligne est particulièrement intéressant par rapport à l'apprentissage par renforcement en ligne (Online RL) dans les domaines où la collecte de données est coûteuse ou dangereuse, mais où il peut y avoir une grande quantité de données (par exemple, robotique, contrôle industriel, conduite autonome).

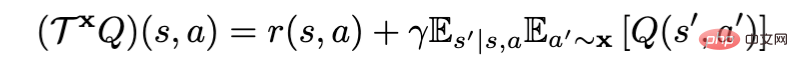

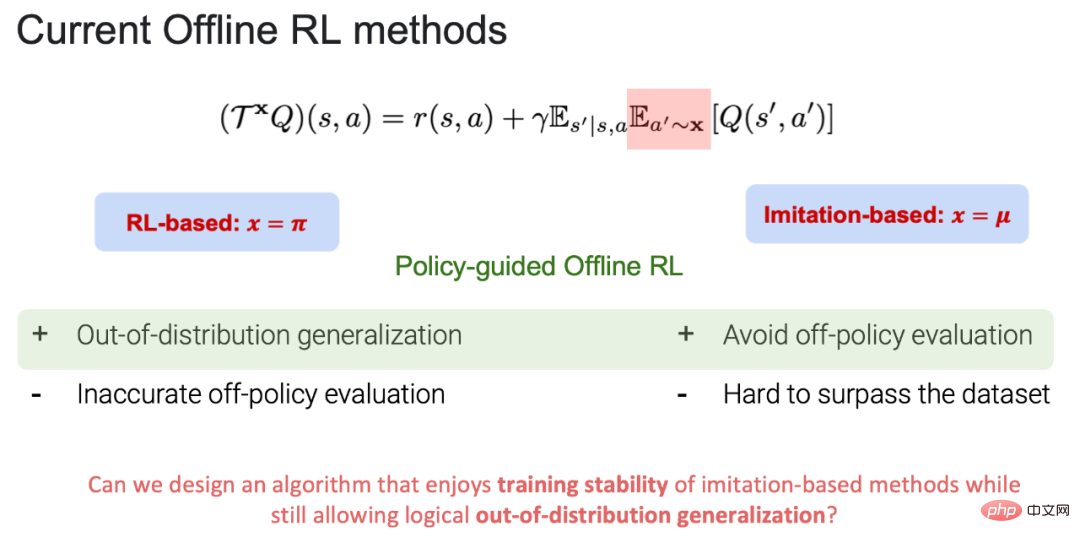

Lors de l'utilisation de l'opérateur d'évaluation de politique Bellman pour l'évaluation de politique, l'algorithme d'apprentissage par renforcement hors ligne actuel peut être divisé en basé sur RL (x = π) et basé sur l'imitation (x = μ ), où π est le stratégie cible et μ est la stratégie comportementale (Remarque : stratégie cible : la stratégie d'apprentissage et de mise à jour ; stratégie comportementale : la stratégie dans les données hors ligne). Actuellement, les systèmes basés sur RL et basés sur l'imitation ont leurs propres avantages et inconvénients :

1. Avantage basé sur RL : il peut se généraliser au-delà des données et enfin atteindre l'objectif d'apprendre une stratégie cible au-delà des stratégies comportementales. Inconvénients : il existe un compromis entre une estimation précise de la valeur dans l'évaluation des politiques (plus de régularisation comportementale) et une amélioration des politiques (moins de régularisation comportementale). Au cours du processus d'évaluation des politiques, si une action en dehors de la distribution des données est sélectionnée, la fonction de valeur de l'action (valeur de l'état d'action) ne peut pas être estimée avec précision, ce qui conduit finalement à l'échec de l'apprentissage politique cible.

2.Avantages basés sur l'imitation : étant donné que dans le processus d'évaluation des politiques, toutes les actions se situent dans la distribution des données, cela peut non seulement apporter de la stabilité à la formation, mais également éviter l'évaluation des politiques en dehors de la distribution des données et peut apprendre comportements proches Les meilleures stratégies de la bibliothèque de stratégies. Inconvénients : étant donné que toutes les actions sont prises au sein de la distribution des données, il est difficile de surpasser les stratégies comportementales existantes dans les données d'origine.

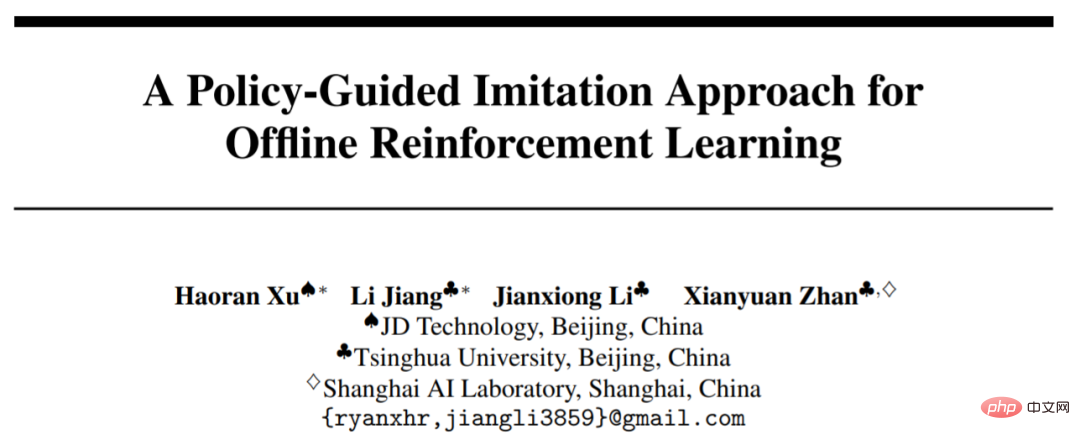

POR Sur cette base, il peut non seulement éviter les compromis dans le processus d'évaluation de la stratégie, mais également avoir la capacité de généraliser en dehors des données. Ce travail a été accepté par NeurIPS 2022 et invité pour une présentation orale. L'article et le code ont été open source.

état- Couture contre couture d'action

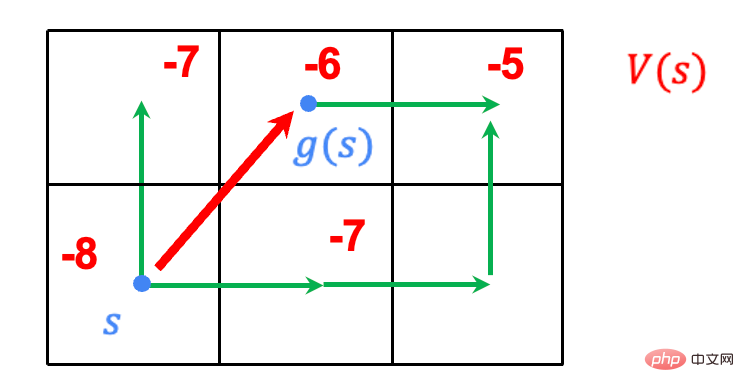

Les algorithmes précédents basés sur l'imitation utilisaient tous l'assemblage d'actions : reconstituer les trajectoires disponibles dans les données pour atteindre un apprentissage politique cible. Par exemple, la trajectoire bleue dans la vidéo est la meilleure trajectoire qui puisse être apprise grâce à l'assemblage d'actions, mais elle ne peut pas être généralisée efficacement en dehors des données, de manière à apprendre la stratégie cible au-delà de la stratégie comportementale dans les données. Cependant, la POR peut généraliser efficacement la stratégie cible grâce à un paradigme d'apprentissage découplé, dépassant ainsi les performances des stratégies comportementales.

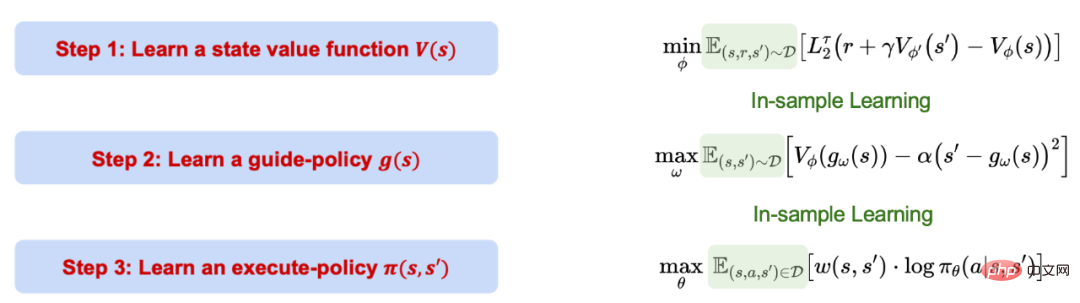

Le processus d'apprentissage hors ligne (POR) guidé par des politiques est divisé en trois étapes. Ces trois étapes sont découplées séparément et ne s'affectent pas. Il convient de noter que l'ensemble du processus de POR est basé sur un apprentissage basé sur l'imitation, c'est-à-dire un apprentissage au sein d'un échantillon, et n'évalue pas la valeur des actions en dehors de la distribution des données.

1. Utilisez la régression quantile pour connaître la limite supérieure de confiance de la fonction valeur.

2. Utilisez la fonction de valeur apprise pour apprendre une stratégie de guidage, qui peut générer la ou les prochaines positions d'état optimales dans l'échantillon étant donné l'état actuel. Ce dernier élément sert de contrainte pour garantir que l'état généré satisfait à la condition MDP.

3. Utilisez tous les échantillons dans les données pour apprendre une stratégie d'exécution qui peut prendre les actions correctes à partir du ou des états actuels étant donné le ou les états actuels et le ou les états suivants) pour passer au suivant. état(s').

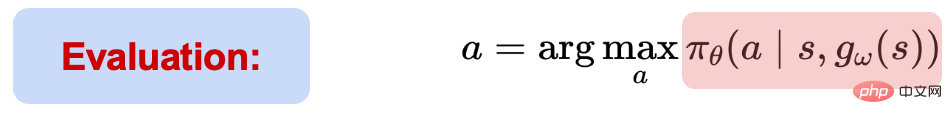

Pendant le processus de test, sur la base de la ou des informations sur l'état actuel, le ou les prochains états optimaux sont d'abord donnés via la stratégie de guidage.

Étant donné (s, s'), la stratégie d'exécution peut sélectionner et exécuter des actions. Bien que l'ensemble du processus d'apprentissage du POR soit un apprentissage au sein de l'échantillon, les performances de généralisation du réseau neuronal peuvent être utilisées pour effectuer un apprentissage de généralisation en dehors des données, et finalement réaliser un assemblage d'état.

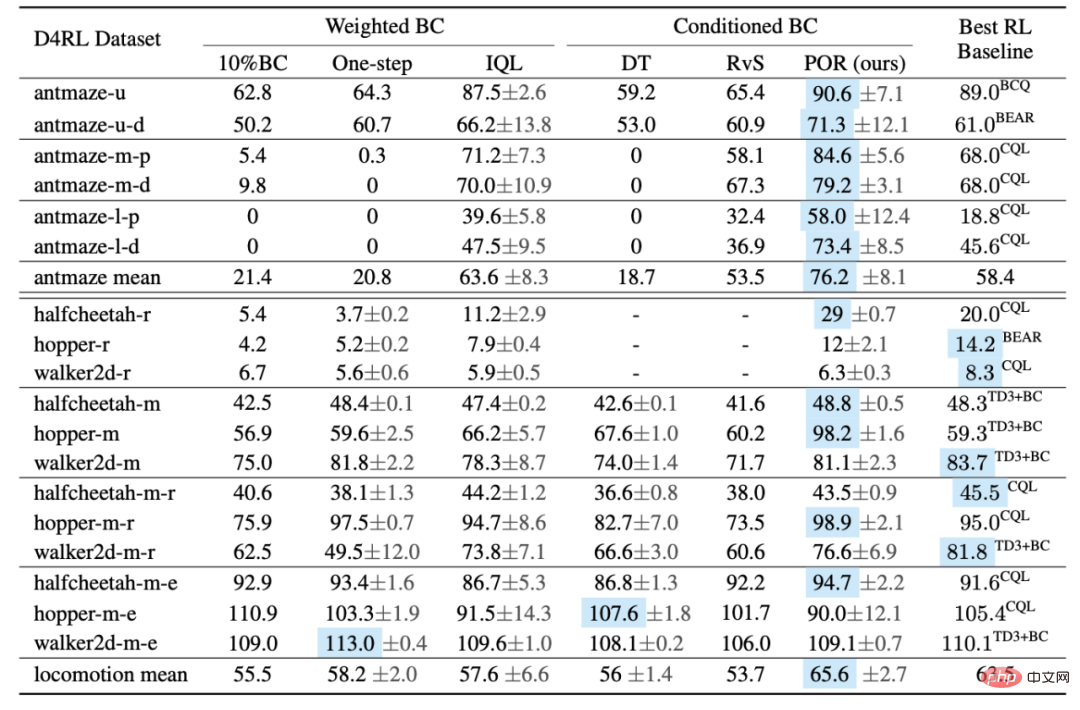

L'auteur a comparé les performances de POR et d'autres algorithmes sur D4RL Benchmark. À en juger par le tableau, POR fonctionne très bien sur des données sous-optimales et atteint des performances algorithmiques optimales sur des tâches Antmaze plus difficiles.

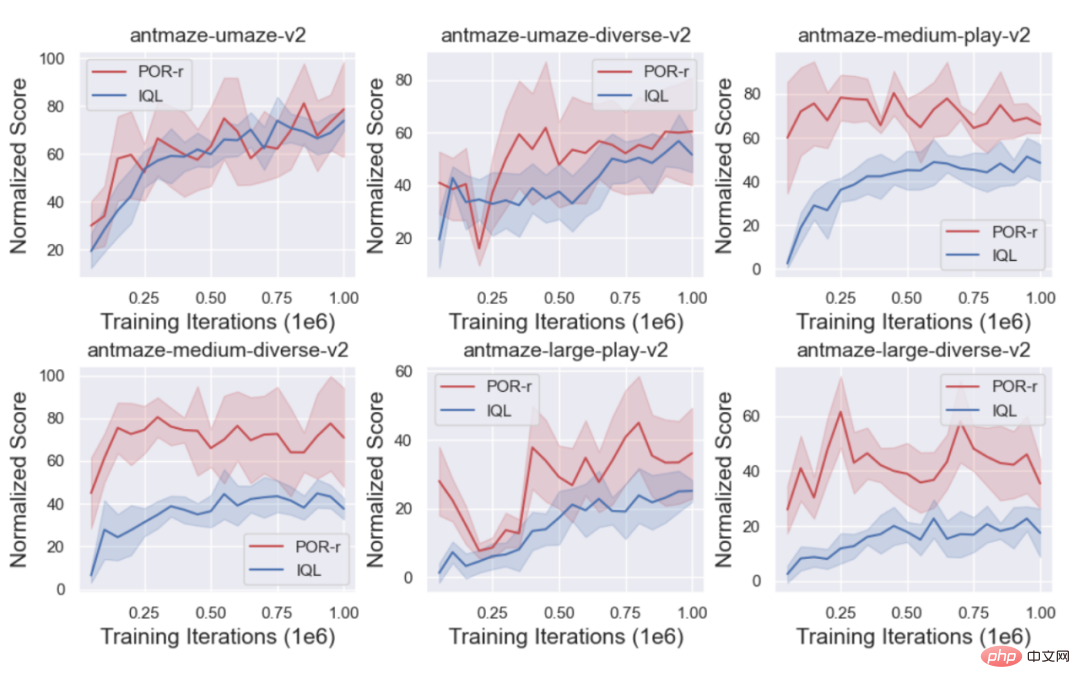

Dans le même temps, l'auteur a comparé les courbes d'entraînement du POR (state-stitching) et de l'IQL (action-stitching) pour montrer les avantages du state-stitching.

1 Réapprenez la stratégie de guidage pour obtenir de meilleures performances de l'algorithme.

Il existe souvent un grand nombre d'ensembles de données sous-optimaux ou même aléatoires (D_o) dans le monde réel. S'ils sont directement introduits dans l'ensemble de données d'origine (D_e) en cours d'apprentissage, cela peut entraîner l'apprentissage d'une mauvaise stratégie. , mais pour les algorithmes d'apprentissage découplés, différents composants sont ciblés et différents ensembles de données sont appris pour améliorer les performances. Lors de l'apprentissage de la fonction valeur, plus il y a d'ensembles de données, mieux c'est, car la fonction valeur peut être apprise avec plus de précision, au contraire, l'apprentissage de la stratégie ne veut pas introduire (D_o) ;

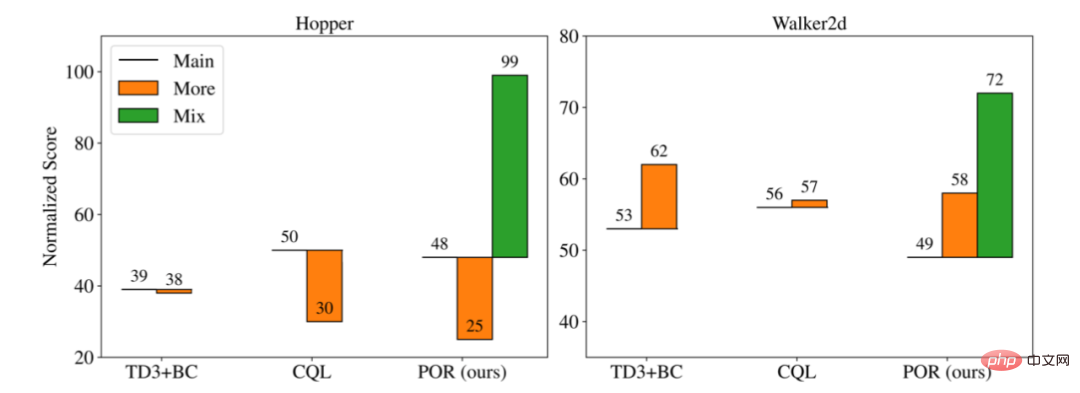

L'auteur a comparé les performances de trois algorithmes différents dans différents scénarios de formation :

1. Principal : Apprenez sur l'ensemble de données d'origine (D_e) sans introduire d'ensembles de données sous-optimaux supplémentaires.

2. Plus : Mélangez l'ensemble de données d'origine (D_e) et le nouvel ensemble de données (D_o) pour apprendre en tant que nouvel ensemble de données.

3. Mix : Pour les algorithmes découplés, différents ensembles de données peuvent être utilisés pour l'apprentissage de différentes parties d'apprentissage, de sorte que seul POR peut avoir le paradigme d'apprentissage Mix.

Comme vous pouvez le voir sur la figure ci-dessus, lorsque de nouvelles données sous-optimales sont ajoutées pour l'entraînement ensemble (Plus), cela peut entraîner des performances meilleures ou pires que l'ensemble de données d'origine (Principal) seul, mais Visant une forme de formation découplée pour réapprendre la stratégie de guidage (D_o+D_e), les expériences de l'auteur montrent que davantage de données peuvent améliorer la sélectivité et la capacité de généralisation de la stratégie de guidage tout en gardant la stratégie comportementale inchangée, permettant ainsi d'améliorer les stratégies d'exécution.

4. Face à une nouvelle tâche, parce que la stratégie d'exécution n'a rien à voir avec la tâche, il suffit de réapprendre la stratégie de guidage.

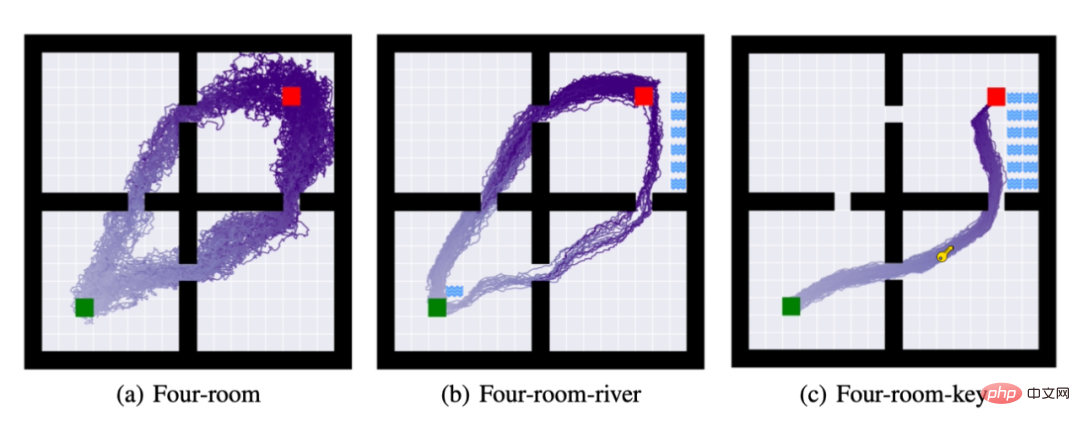

Pour cela, l'auteur a proposé trois tâches : (a) : quatre pièces : obliger l'agent à passer du carré vert au carré rouge. (b) En plus d'accomplir la tâche (a), l'agent doit ne pas toucher la rivière. (c) En plus d'accomplir les tâches (a) et (b), l'agent doit obtenir la clé pour accomplir la tâche.

L'image ci-dessus est la trajectoire de 50 déploiements de la stratégie après avoir terminé l'apprentissage de la stratégie. Dans les tâches (b) et la tâche (c), l'auteur a continué à utiliser la stratégie d'exécution de la tâche (a) et. je l'ai seulement réappris. Comme le montre la figure ci-dessus, la méthode d'apprentissage découplé peut effectuer la migration des tâches en utilisant le moins de ressources informatiques possible.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

écran de téléphone portable tft

écran de téléphone portable tft

Comment installer le filtre PS

Comment installer le filtre PS

Comment désactiver la complétion automatique sublime

Comment désactiver la complétion automatique sublime

Comment aligner les zones de texte en HTML

Comment aligner les zones de texte en HTML

ps supprimer la zone sélectionnée

ps supprimer la zone sélectionnée

Comment acheter et vendre du Bitcoin sur Binance

Comment acheter et vendre du Bitcoin sur Binance

Étapes WeChat

Étapes WeChat

Classement des dix principaux échanges de devises numériques

Classement des dix principaux échanges de devises numériques