Avec le développement accéléré de la technologie, l’intelligence artificielle (IA) joue un rôle de plus en plus important dans le processus décisionnel. Les humains s’appuient de plus en plus sur des algorithmes pour traiter les informations, recommander certaines actions et même agir en leur nom.

Cependant, si l’IA nous aide réellement, voire nous remplace, dans la prise de décisions, notamment celles impliquant des décisions subjectives, morales et éthiques, pouvez-vous l’accepter ?

Récemment, une équipe de recherche de l'Université d'Hiroshima a exploré les réactions humaines à l'introduction de la prise de décision par l'intelligence artificielle. Plus précisément, en étudiant les interactions humaines avec les voitures autonomes, ils ont exploré la question : « La société est-elle prête pour une prise de décision éthique par l'intelligence artificielle ? » L'équipe a rapporté le 6 mai 2022 dans le Journal leurs conclusions. publié dans Économie comportementale et expérimentale.

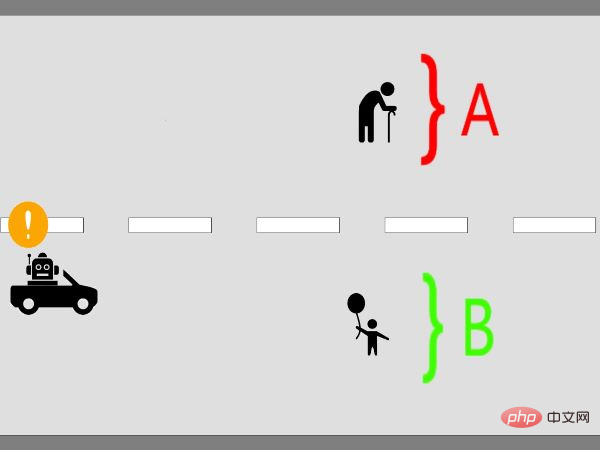

Dans la première expérience, les chercheurs ont présenté à 529 sujets humains des dilemmes éthiques auxquels les conducteurs pourraient être confrontés. Dans le scénario créé par les chercheurs, un automobiliste devait décider s’il devait percuter un groupe de personnes ou un autre, et une collision était inévitable. Autrement dit, un accident causera des dommages graves à un groupe de personnes, mais sauvera la vie d’un autre groupe de personnes.

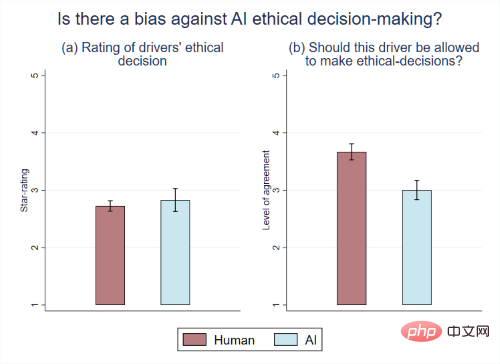

Dans leur deuxième expérience, 563 sujets humains ont répondu à un certain nombre de questions posées par les chercheurs pour déterminer ce que les gens pensent de la prise de décision éthique de l'IA une fois qu'elle fait partie de la société.

Les chercheurs estiment que la différence entre les deux résultats est causée par une combinaison de deux facteurs.

Graphique | En moyenne, les gens ont évalué les décisions éthiques des conducteurs IA de la même manière que celles des conducteurs humains. Cependant, les gens ne veulent pas que l’IA prenne des décisions éthiques sur la route

Les chercheurs pensent que ce rejet des nouvelles technologies, principalement dû à des convictions personnelles concernant l’opinion de la société, est susceptible de s’appliquer à d’autres machines et robots. "Il est donc important de déterminer comment les préférences individuelles se regroupent en préférences sociales. De plus, comme le montrent nos résultats, ces conclusions doivent également différer selon les pays", a déclaré Kaneko.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Application de l'intelligence artificielle dans la vie

Application de l'intelligence artificielle dans la vie

Quel est le concept de base de l'intelligence artificielle

Quel est le concept de base de l'intelligence artificielle

Quelles compétences sont nécessaires pour travailler dans l'industrie PHP ?

Quelles compétences sont nécessaires pour travailler dans l'industrie PHP ?

Comment créer du HTML avec Webstorm

Comment créer du HTML avec Webstorm

Les principaux composants qui composent le CPU

Les principaux composants qui composent le CPU

La différence entre PowerShell et cmd

La différence entre PowerShell et cmd

Utilisation de la fonction fgets

Utilisation de la fonction fgets

Comment installer le pilote d'imprimante sous Linux

Comment installer le pilote d'imprimante sous Linux