Cet article est reproduit à partir de Lei Feng.com Si vous devez le réimprimer, veuillez vous rendre sur le site officiel de Lei Feng.com pour demander une autorisation.

Dans une caisse insonorisée se trouve l'un des pires réseaux de neurones au monde. Après avoir vu une image du chiffre 6, le réseau de neurones fait une pause un instant puis affiche le chiffre qu'il reconnaît : 0.

Peter McMahon, physicien et ingénieur à l'Université Cornell qui a dirigé le développement de ce réseau neuronal, a déclaré avec un sourire penaud que c'était parce que les chiffres manuscrits semblaient si bâclés. Logan Wright, un postdoctorant visitant le laboratoire de McMahon de l'Institut NTT, a déclaré que l'appareil donne généralement la bonne réponse, bien qu'il ait reconnu que les erreurs sont courantes. Malgré ses performances médiocres, ce réseau neuronal était une recherche révolutionnaire. Les chercheurs ont retourné la caisse, révélant non pas une puce informatique mais un microphone incliné vers une plaque de titane fixée au haut-parleur.

Contrairement aux réseaux de neurones qui fonctionnent dans le monde numérique des 0 et des 1, cet appareil fonctionne sur le principe du son. Lorsque Wright a reçu l'image d'un nombre, les pixels de l'image ont été convertis en audio et un haut-parleur a fait vibrer la plaque de titane, remplissant le laboratoire d'un léger gazouillis. C'est-à-dire que c'est l'écho métallique qui effectue l'opération de « lecture », et non le logiciel exécuté sur la puce de silicium.

Le succès de cet appareil est incroyable, même pour ses concepteurs. "Quel que soit le rôle du métal vibrant, cela ne devrait rien avoir à voir avec la classification des chiffres manuscrits", a déclaré McMahon en janvier de cette année, l'équipe de recherche de l'Université Cornell a publié un article dans la revue Nature intitulé It is "Deep". réseaux de neurones physiques entraînés avec rétropropagation".

L'introduction du journal sur les capacités de lecture brutes de l'appareil donne de l'espoir à McMahon et à d'autres, leur disant que l'appareil, avec de multiples améliorations, pourrait révolutionner l'informatique.

Lien papier : https://www.nature.com/articles/s41586-021-04223-6En ce qui concerne l'apprentissage automatique traditionnel, les informaticiens ont découvert que plus le neurone est grand réseau, mieux c'est. Les raisons spécifiques peuvent être trouvées dans l'article dans l'image ci-dessous. Cet article intitulé "Les informaticiens prouvent pourquoi les plus grands réseaux de neurones font mieux" le prouve : Si vous voulez que le réseau soit fiable en gardant à l'esprit ses données de formation, alors la surparamétrage n'est pas seulement valable, mais nécessaire à son application.

Adresse de l'article : https://www.quantamagazine.org/computer-scientists-prove-why-bigger-neural-networks-do-better-20220210/Remplissez plus d'informations dans un neuronal Un plus grand nombre de neurones artificiels (nœuds qui stockent des valeurs) pourraient améliorer sa capacité à faire la différence entre un teckel et un dalmatien, ainsi que lui permettre d'accomplir avec succès d'innombrables autres tâches de reconnaissance de formes.

Des réseaux de neurones vraiment énormes peuvent rédiger des documents (comme le GPT-3 d'OpenAI), dessiner des illustrations (comme le DALL·E d'OpenAI, le DALL·E2 de Google) et bien d'autres tâches terrifiantes à imaginer. . Avec plus de puissance de calcul, de plus grandes prouesses deviennent possibles. Cette possibilité encourage les efforts visant à développer des méthodes informatiques plus puissantes et plus efficaces. McMahon et un groupe de physiciens partageant les mêmes idées adoptent une approche non conventionnelle : laisser l'univers analyser les données pour nous.

McMahon a déclaré : « De nombreux systèmes physiques sont naturellement capables d'effectuer certains calculs plus efficacement ou plus rapidement que les ordinateurs. » Il a donné l'exemple d'une soufflerie : lorsque les ingénieurs conçoivent un avion, ils peuvent numériser les plans et y consacrer des heures. un supercalculateur simulant le flux d'air autour d'une aile d'avion. Alternativement, ils pourraient placer l’avion dans une soufflerie pour voir s’il peut voler. D'un point de vue informatique, les souffleries peuvent instantanément « calculer » l'interaction d'une aile d'avion avec l'air.

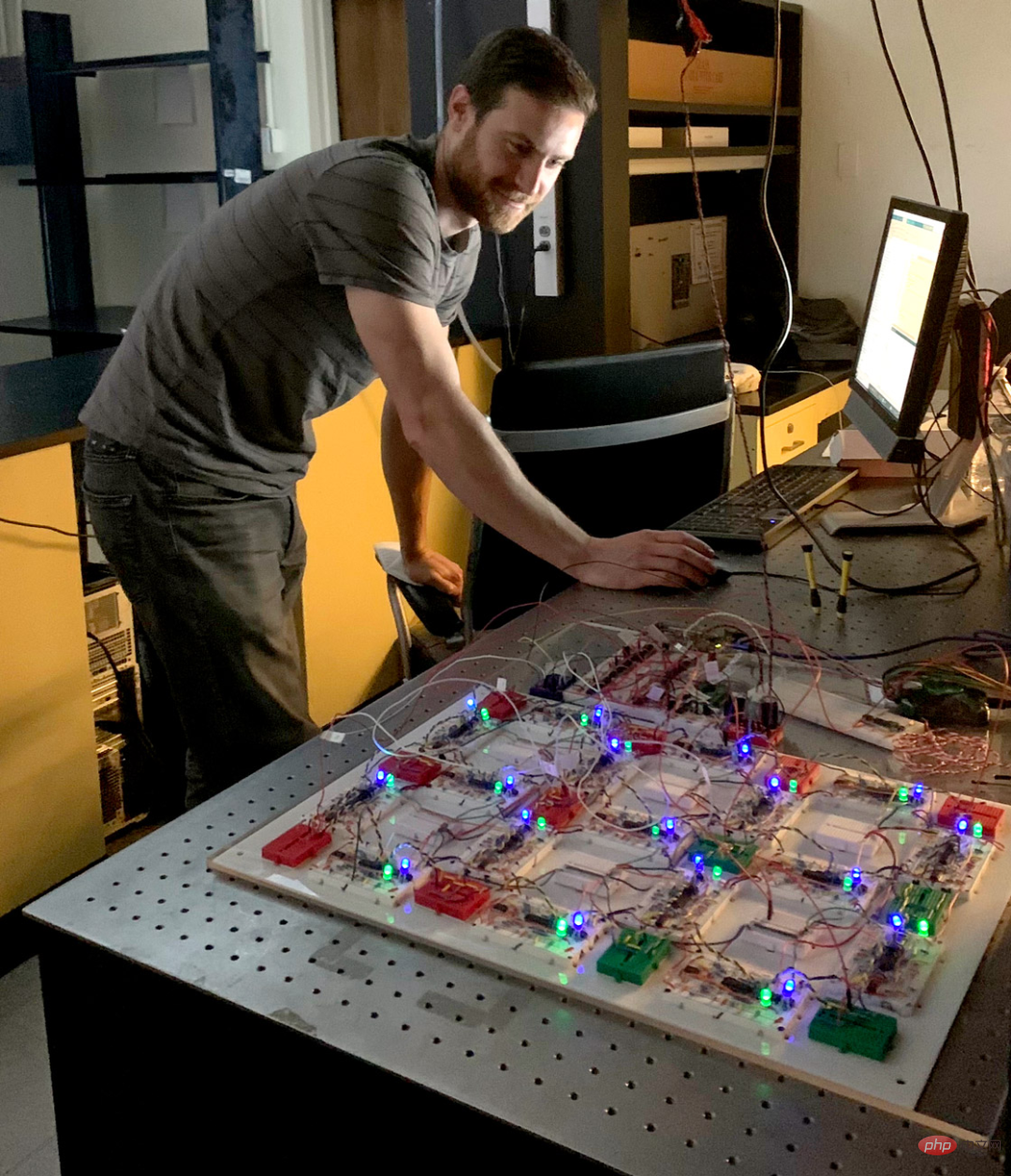

Légende : Peter McMahon et Tatsuhiro Onodera, membres de l'équipe de l'Université Cornell, écrivent des programmes pour divers systèmes physiques afin d'accomplir des tâches d'apprentissage.

Source photo : Dave BurbankLa soufflerie peut simuler l'aérodynamique et est une machine avec une fonction spécifique.

Des chercheurs comme McMahon travaillent sur un appareil capable d'apprendre à tout faire - un système capable d'ajuster son comportement par essais et erreurs pour acquérir de nouvelles capacités, comme classer des chiffres manuscrits ou distinguer une voyelle d'une autre voyelle. et d'autres capacités.

Les dernières recherches montrent que les systèmes physiques comme les ondes lumineuses, les réseaux supraconducteurs et les flux de ramification d'électrons peuvent tous être appris. "Nous ne réinventons pas seulement le matériel, nous réinventons tout le paradigme informatique", déclare Benjamin Scellier, mathématicien à l'ETH Zurich en Suisse, qui a contribué à la conception d'un nouvel algorithme d'apprentissage de la physique.

L'apprentissage est un processus extrêmement unique. Il y a dix ans, le cerveau était le seul système capable d'apprendre. C’est la structure du cerveau qui a en partie inspiré les informaticiens à concevoir des réseaux de neurones profonds, actuellement le modèle d’apprentissage artificiel le plus populaire. Un réseau neuronal profond est un programme informatique qui apprend par la pratique.

Un réseau neuronal profond peut être considéré comme une grille : les couches de nœuds utilisées pour stocker les valeurs sont appelées neurones, et les neurones sont connectés aux neurones des couches adjacentes par des lignes, également appelées « synapses ». Initialement, ces synapses ne sont que des nombres aléatoires appelés « poids ». Si vous souhaitez que le réseau lise 4, vous pouvez faire en sorte que la première couche de neurones représente l'image originale de 4 et vous pouvez stocker l'ombre de chaque pixel sous forme de valeur dans le neurone correspondant.

Ensuite, le réseau "pense", se déplaçant couche par couche, remplissant la couche suivante de neurones avec des valeurs de neurones multipliées par des poids synaptiques. Le neurone ayant la plus grande valeur dans la dernière couche est la réponse du réseau neuronal. Par exemple, s’il s’agit du deuxième neurone, le réseau devine qu’il en a vu 2. Pour apprendre au réseau à faire des suppositions plus intelligentes, l’algorithme d’apprentissage fonctionne à l’envers. Après chaque essai, il calcule la différence entre la réponse correcte et la bonne réponse (dans notre cas, cette différence sera représentée par une valeur élevée dans le quatrième neurone de la dernière couche et une valeur faible ailleurs).

L'algorithme parcourt ensuite le réseau, couche par couche, calculant comment ajuster les poids afin que la valeur du neurone final augmente ou diminue selon les besoins. Ce processus est appelé rétropropagation et constitue le cœur de l’apprentissage profond. En devinant et en ajustant à plusieurs reprises, la rétropropagation guide les poids vers un ensemble de nombres qui seront générés via une cascade de multiplications initiées par une image.

Source : Quanta Magazine Merrill ShermanMais comparé à la pensée du cerveau, l'apprentissage numérique dans les réseaux de neurones artificiels semble très inefficace. Avec moins de 2 000 calories par jour, un enfant humain peut apprendre à parler, lire, jouer à des jeux et bien plus encore en quelques années seulement. Dans des conditions énergétiques aussi limitées, le réseau neuronal GPT-3 capable de converser couramment peut mettre mille ans à apprendre à discuter.

Du point de vue d’un physicien, un grand réseau de neurones numériques essaie simplement de faire trop de mathématiques. Les plus grands réseaux de neurones actuels doivent enregistrer et manipuler plus de 500 milliards de nombres. Ce nombre stupéfiant provient de l'article « Pathways Language Model (PaLM) : Scaling to 540 Billion Parameters for Breakthrough Performance) » illustré ci-dessous :

Lien papier : https://ai.googleblog.com/2022 /04/pathways-lingual-model-palm-scaling-to.htmlDans le même temps, les tâches omniprésentes de l'univers dépassent de loin les limites de la maigre puissance de calcul d'un ordinateur. Il peut y avoir des milliards de molécules d’air qui rebondissent dans une pièce.

Pour une simulation de collision à part entière, il s'agit du nombre d'objets en mouvement que l'ordinateur ne peut pas suivre, mais l'air lui-même détermine facilement son propre comportement à chaque instant. Notre défi actuel est de construire un système physique capable de compléter naturellement les deux processus requis par l'intelligence artificielle : la « pensée » pour classer les images et la « pensée » requise pour classer correctement de telles images".

Un système qui maîtrise ces deux tâches exploite véritablement la puissance mathématique de l'univers, et ne se contente pas d'effectuer des calculs mathématiques. "Nous n'avons jamais calculé quelque chose comme 3,532 fois 1,567", a déclaré Scellier. "Le système calcule, mais implicitement en suivant les lois de la physique."

McMahon et ses collègues ont progressé sur la partie "pensée" du puzzle. Dans les mois qui ont précédé la pandémie de COVID-19, McMahon a installé son laboratoire à l’Université Cornell et a réfléchi à une étrange découverte. Au fil des années, les réseaux de neurones les plus performants en matière de reconnaissance d’images sont devenus de plus en plus profonds. Autrement dit, un réseau avec plus de couches est plus efficace pour prendre un groupe de pixels et lui donner une étiquette, comme « caniche ».

Cette tendance a inspiré les mathématiciens à étudier la transformation mise en œuvre par les réseaux de neurones (des pixels aux « caniches »). En 2017, plusieurs groupes ont publié un article « Architectures réversibles pour des réseaux de neurones résiduels arbitrairement profonds » propose. que le comportement d'un réseau neuronal est une version approximative d'une fonction mathématique fluide.

Adresse papier : https://arxiv.org/abs/1709.03698En mathématiques, une fonction convertit une entrée (généralement une valeur x) en une sortie (la valeur y du courbe à cet endroit ou en hauteur). Dans certains types de réseaux neuronaux, davantage de couches fonctionnent mieux car la fonction est moins irrégulière et plus proche d'une courbe idéale. La recherche a fait réfléchir McMahon.

Peut-être qu'avec un système physique évoluant en douceur, on pourra contourner le blocage inhérent aux méthodes numériques. L’astuce consiste à trouver un moyen d’apprivoiser un système complexe, c’est-à-dire d’ajuster son comportement grâce à l’entraînement. McMahon et ses collaborateurs ont choisi des plaques de titane pour un tel système car leurs nombreux modes de vibration mélangent les sons entrants de manière complexe.

Pour que la dalle fonctionne comme un réseau neuronal, ils ont introduit un son qui codait l'image d'entrée (comme un 6 manuscrit) et un autre son qui représentait les poids synaptiques. Les pics et les creux du son doivent frapper la plaque de titane au bon moment pour que l'appareil combine les sons et donne une réponse - par exemple, un nouveau son qui est le plus fort en six millisecondes représente une classification de « 6 ».

Légende : Une équipe de recherche de l'Université Cornell a entraîné trois systèmes physiques différents à « lire » des nombres manuscrits : de gauche à droite, une plaque vibrante en titane, un cristal et un circuit électronique. Source : La photo de gauche et celle du milieu ont été prises par Rob Kurcoba de l'Université Cornell ; la photo de droite a été prise par Charlie Wood de Quanta Magazine. L'équipe a également mis en œuvre son système dans un système optique - où l'image d'entrée et les poids sont codés dans deux faisceaux mélangés par un cristal - et dans un circuit électronique qui peut transformer de la même manière l'entrée.

En principe, n'importe quel système ayant un comportement byzantin pourrait faire cela, mais les chercheurs pensent que les systèmes optiques sont particulièrement prometteurs. Non seulement les cristaux mélangent la lumière extrêmement rapidement, mais la lumière contient également de riches données sur le monde. McMahon imagine que des versions miniatures de ses réseaux de neurones optiques serviront un jour d'yeux aux voitures autonomes, capables de reconnaître les panneaux d'arrêt et les piétons, puis d'introduire l'information dans les puces informatiques de la voiture, un peu comme nos rétines font une vision de base pour lumière entrante. Traité de la même manière.

Cependant, le talon d'Achille de ces systèmes, c'est que leur formation nécessite un retour au monde numérique. La rétropropagation implique l'exécution d'un réseau neuronal à l'envers, mais les films et les cristaux ne peuvent pas facilement résoudre le son et la lumière. L’équipe a donc construit un modèle numérique de chaque système physique. En inversant ces modèles sur un ordinateur portable, ils peuvent utiliser l’algorithme de rétropropagation pour calculer comment ajuster les poids afin de donner des réponses précises.

Grâce à cette formation, cette plaque de titane a appris à classer les nombres manuscrits avec un taux de précision de 87%. La précision du circuit et du laser dans l'image ci-dessus atteint respectivement 93 % et 97 %. Les résultats montrent que « les réseaux neuronaux standards ne peuvent pas être formés uniquement par rétropropagation », explique la physicienne Julie Grollier du Centre national de la recherche scientifique (CNRS). Cette carte ne rend pas encore l'informatique aussi efficace que le cerveau et l'appareil. n'est même pas proche de la vitesse des réseaux neuronaux numériques. Mais McMahon pense que son appareil est étonnant car il prouve que les gens peuvent penser avec plus que leur cerveau ou leurs puces informatiques. "Tout système physique peut être un réseau neuronal."

Il a dit.3 Partie apprentissage

Adresse papier : https://arxiv.org/abs/2103.04992

Adresse papier : https://arxiv.org/abs/2103.04992

Pour prouver que cela est réalisable, ils ont utilisé la technologie numérique pour simuler un appareil laser similaire à l'appareil McMahon, qui sera capable de Le poids du ton est codé dans une onde lumineuse, qui est mélangée à une autre onde d'entrée (codage, comme une image). Ils rapprochent le résultat de la bonne réponse et utilisent des composants optiques pour briser les ondes, inversant ainsi le processus. "La magie," a déclaré Marquardt, "lorsque vous essayez à nouveau l'appareil avec la même entrée, la sortie a tendance à être plus proche de l'endroit où vous voulez qu'elle soit." Ensuite, ils travaillent avec des expérimentateurs pour construire un tel appareil. un système. Mais en se concentrant sur les systèmes fonctionnant avec des options de limites inversées, d’autres chercheurs ont complètement laissé de côté la rétropropagation.

Parce qu'ils savaient que la façon dont le cerveau apprend n'est pas une rétropropagation standard, leurs recherches n'ont pas été touchées, mais sont allées plus loin. "Le cerveau ne se propage pas", a déclaré Scellier. Lorsque le neurone A communique avec le neurone B, "la propagation est à sens unique". Légende : Julie Grollier, physicienne au CNRS, a mis en place un algorithme d'apprentissage de la physique considéré comme une alternative prometteuse à la rétropropagation. Source de l'image : Christophe CaudroyEn 2017, Scellier et Yoshua Bengio, informaticien à l'Université de Montréal, ont développé une méthode d'apprentissage à sens unique appelée propagation équilibrée. On peut comprendre comment cela fonctionne ainsi : imaginez un réseau de flèches comme des neurones, leurs directions représentant 0 ou 1, reliées dans une grille par des ressorts qui agissent comme des poids synaptiques. Plus le ressort est lâche, plus il sera difficile pour les flèches de connexion de s'aligner. Tout d’abord, faites pivoter la rangée de flèches la plus à gauche pour refléter les pixels des chiffres manuscrits, puis faites pivoter les autres flèches tout en laissant la rangée de flèches la plus à gauche inchangée et laissez cette perturbation se propager à travers les ressorts. Lorsque le retournement s'arrête, la flèche la plus à droite donne la réponse. Le fait est que nous n’avons pas besoin d’inverser les flèches pour entraîner ce système. Au lieu de cela, nous pouvons connecter un autre ensemble de flèches au bas du réseau qui montrent la bonne réponse. Ces flèches correctes feront basculer l’ensemble de flèches supérieur et la grille entière entrera dans un nouvel état d’équilibre. Enfin, comparez la nouvelle direction de la flèche à l'ancienne direction et serrez ou desserrez chaque ressort en conséquence. Après de nombreuses expériences, les ressorts ont acquis des tensions plus intelligentes, ce qui, selon Scellier et Bengio, équivaut à une rétropropagation. "Les gens pensaient qu'il ne pouvait y avoir aucun lien entre les réseaux neuronaux physiques et la rétropropagation", a déclaré Grollier. "Cela a changé récemment, ce qui est très excitant. Les travaux originaux sur la propagation équilibrée étaient entièrement théoriques." Mais dans un prochain article, Grollier et Jérémie Laydevant, physicien au CNRS, décrivent l'exécution de l'algorithme sur une machine de recuit quantique construite par D-Wave. L'appareil dispose d'un réseau de milliers de supraconducteurs en interaction qui fonctionnent comme des flèches reliées par des ressorts, calculant naturellement la manière dont le « ressort » doit se mettre à jour. Cependant, le système ne peut pas mettre à jour automatiquement ces poids synaptiques. Au moins une équipe a assemblé certains composants pour construire un circuit électronique qui utilise la physique pour faire tout le gros du travail de réflexion, d'apprentissage et de mise à jour des poids. "Nous avons réussi à boucler la boucle pour un petit système", a déclaré Sam Dillavou, physicien au circuit modifié de l'Université de Pennsylvanie. Le but de Dillavou et de ses collaborateurs est d'imiter le cerveau, qui est la véritable intelligence. C'est un système relativement unifié qui ne nécessite aucune structure unique pour donner des ordres. "Chaque neurone fait son propre travail", a-t-il déclaré. Pour ce faire, ils ont construit un circuit d’auto-apprentissage dans lequel les poids synaptiques étaient des résistances variables et les neurones étaient des tensions mesurées entre les résistances. Pour classer une entrée donnée, ce circuit convertit les données en tensions appliquées à plusieurs nœuds. Le courant électrique circule dans le circuit, recherchant le chemin qui dissipe le moins d’énergie, modifiant ainsi la tension à mesure qu’elle se stabilise. La réponse est de spécifier la tension au nœud de sortie. L'innovation de cette idée réside dans l'étape d'apprentissage difficile, pour laquelle ils ont conçu un schéma similaire à la propagation équilibrée, appelé apprentissage couplé. Lorsqu'un circuit reçoit des données et « devine » un résultat, un autre circuit identique démarre avec la bonne réponse et l'intègre dans son comportement. Enfin, l'électronique reliant chaque paire de résistances compare automatiquement leurs valeurs et les ajuste pour une configuration « plus intelligente ». Le groupe a décrit son circuit de base dans une prépublication l'été dernier (illustré ci-dessous) intitulée « Démonstration d'un apprentissage décentralisé basé sur la physique ». L'article montre que ce circuit peut apprendre à distinguer trois types de fleurs avec une précision de 95 % . Et maintenant, ils travaillent sur un appareil plus rapide et plus puissant. Adresse papier : https://arxiv.org/abs/2108.00275Même cette mise à niveau ne peut pas battre les puces de silicium les plus avancées. Mais les physiciens qui construisent ces systèmes soupçonnent que, aussi puissants qu'ils paraissent aujourd'hui, les réseaux de neurones numériques finiront par paraître lents et inadéquats par rapport aux réseaux analogiques. Les réseaux de neurones numériques ne peuvent être étendus que dans une certaine mesure avant de s'enliser dans la surcalculation, mais les réseaux physiques plus vastes doivent simplement être eux-mêmes. "Il s'agit d'un domaine très vaste, en croissance rapide et en constante évolution, et je crois fermement que des ordinateurs très puissants seront construits en utilisant ces principes", a déclaré Dillavou.

4 Boucler la boucle

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Cache mybatis de premier niveau et cache de deuxième niveau

Cache mybatis de premier niveau et cache de deuxième niveau

Comment utiliser le paramètre Oracle

Comment utiliser le paramètre Oracle

Solution au problème xlive.dll manquant

Solution au problème xlive.dll manquant

Qu'est-ce que la certification 3c

Qu'est-ce que la certification 3c

Combien coûte un Bitcoin en RMB ?

Combien coûte un Bitcoin en RMB ?

Comment ouvrir le fichier img

Comment ouvrir le fichier img

Les données entre le système Hongmeng et le système Android peuvent-elles être interopérables ?

Les données entre le système Hongmeng et le système Android peuvent-elles être interopérables ?

Tutoriel C#

Tutoriel C#