L'apprentissage auto-supervisé est-il vraiment une étape clé vers l'AGI ?

Yann LeCun, scientifique en chef de l'IA chez Meta, n'a pas oublié les objectifs à long terme lorsqu'il a évoqué "les mesures spécifiques à prendre en ce moment". Il a déclaré dans une interview : « Nous voulons construire des machines intelligentes qui apprennent comme les animaux et les humains. » Ces dernières années, Meta a publié une série d'articles sur l'apprentissage auto-supervisé (SSL) des systèmes d'IA. LeCun croit fermement que SSL est une condition préalable nécessaire aux systèmes d'IA, qui peut aider les systèmes d'IA à construire des modèles mondiaux pour acquérir des capacités semblables à celles de l'humain, telles que la rationalité, le bon sens et la capacité de transférer des compétences et des connaissances d'un environnement à un autre.

Leur nouvel article montre comment un système auto-supervisé appelé auto-encodeur masqué (MAE) peut apprendre à reconstruire des images, des vidéos et même de l'audio à partir de données très fragmentées et incomplètes. Bien que les MAE ne soient pas une idée nouvelle, Meta a étendu ce travail à de nouveaux domaines.

LeCun a déclaré qu'en étudiant comment prédire les données manquantes, qu'il s'agisse d'images fixes ou de séquences vidéo ou audio, les systèmes MAE construisent un modèle du monde. Il a déclaré : « S'il peut prédire ce qui est sur le point de se passer dans la vidéo, il doit comprendre que le monde est tridimensionnel, que certains objets sont inanimés et ne bougent pas d'eux-mêmes, et que d'autres objets sont vivants et difficiles à prédire. , jusqu'à la prédiction du comportement complexe des êtres vivants." Une fois qu'un système d'IA dispose d'un modèle précis du monde, il peut utiliser ce modèle pour planifier des actions.

LeCun a déclaré : « L'essence de l'intelligence est d'apprendre à prédire. » Bien qu'il n'ait pas affirmé que le système MAE de Meta était proche de l'intelligence artificielle générale, il estime qu'il s'agit d'une étape importante vers l'intelligence artificielle générale.

Mais tout le monde n’est pas d’accord pour dire que les chercheurs Meta sont sur la bonne voie vers l’intelligence artificielle générale. Yoshua Bengio s'engage parfois dans des débats amicaux avec LeCun sur les grandes idées de l'IA. Dans un e-mail adressé à IEEE Spectrum, Bengio a exposé certaines des différences et des similitudes dans leurs objectifs.

Bengio a écrit : « Je ne pense vraiment pas que nos méthodes actuelles (qu'elles soient auto-supervisées ou non) soient suffisantes pour combler le fossé entre les niveaux d'intelligence artificielle et humaine. » Il a déclaré que le domaine doit faire des « progrès qualitatifs » pour y parvenir. véritablement promouvoir La technologie se rapproche de l’intelligence artificielle à l’échelle humaine.

Bengio est d’accord avec le point de vue de LeCun selon lequel « la capacité de raisonner sur le monde est l’élément central de l’intelligence ». Cependant, son équipe ne se concentre pas sur des modèles capables de prédire, mais sur des modèles capables de prédire en langage naturel. présente les connaissances sous une forme. Il a noté que de tels modèles nous permettraient de combiner ces éléments de connaissances pour résoudre de nouveaux problèmes, effectuer des simulations contrefactuelles ou étudier des futurs possibles. L'équipe de Bengio a développé un nouveau cadre de réseau neuronal plus modulaire que celui privilégié par LeCun, qui travaille sur l'apprentissage de bout en bout.

Le populaire Transformer

Bien sûr, Meta n'est pas la première équipe à utiliser avec succès Transformer pour des tâches visuelles. Ross Girshick, chercheur chez Meta AI, a déclaré que les recherches de Google sur Visual Transformer (ViT) ont inspiré l'équipe Meta : « L'adoption de l'architecture ViT nous a aidés à éliminer certains obstacles rencontrés au cours de l'expérience.

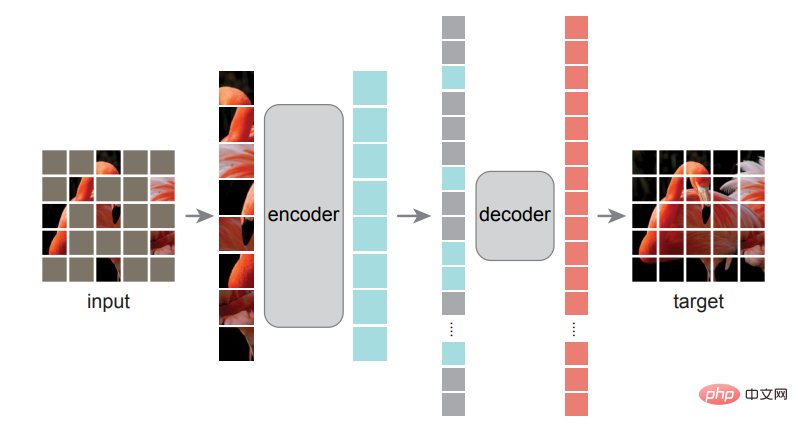

Girshick est l'un des auteurs du premier article sur le système MAE de Meta. L'un des auteurs de cet article est He Kaiming. Ils discutent d'une méthode très simple : masquer les blocs aléatoires de l'image d'entrée et reconstruire les pixels manquants.

La formation de ce modèle est similaire à celle de BERT et de certains autres modèles de langage basés sur Transformer. Les chercheurs leur montreront d'énormes bases de données de texte, mais certains mots sont manquants ou "masqués". Le modèle doit prédire lui-même les mots manquants, puis les mots masqués sont révélés afin que le modèle puisse vérifier son travail et mettre à jour ses paramètres. Ce processus ne cesse de se répéter. Pour faire quelque chose de similaire visuellement, l'équipe a divisé l'image en patchs, puis a masqué certains patchs et a demandé au système MAE de prédire les parties manquantes de l'image, a expliqué Girshick.

La formation de ce modèle est similaire à celle de BERT et de certains autres modèles de langage basés sur Transformer. Les chercheurs leur montreront d'énormes bases de données de texte, mais certains mots sont manquants ou "masqués". Le modèle doit prédire lui-même les mots manquants, puis les mots masqués sont révélés afin que le modèle puisse vérifier son travail et mettre à jour ses paramètres. Ce processus ne cesse de se répéter. Pour faire quelque chose de similaire visuellement, l'équipe a divisé l'image en patchs, puis a masqué certains patchs et a demandé au système MAE de prédire les parties manquantes de l'image, a expliqué Girshick.

L’une des avancées majeures de l’équipe a été la prise de conscience que le masquage de la majeure partie de l’image obtiendrait les meilleurs résultats, une différence essentielle par rapport aux transformateurs de langage, qui ne masquent que 15 % des mots. "Le langage est un système de communication extrêmement dense et efficace, et chaque symbole a beaucoup de sens", a déclaré Girshick. "Mais les images - ces signaux du monde naturel - ne sont pas conçues pour éliminer la redondance. compressez bien le contenu lors de la création d'images JPG."

Les chercheurs de Meta AI ont expérimenté combien d'images devaient être masquées pour obtenir les meilleurs résultats.

Girshick a expliqué qu'en masquant plus de 75 % des correctifs de l'image, ils ont éliminé la redondance dans l'image qui rendrait autrement la tâche trop triviale pour la formation. Leur système MAE en deux parties utilise d'abord un encodeur pour apprendre les relations entre les pixels d'un ensemble de données d'entraînement, puis un décodeur fait de son mieux pour reconstruire l'image originale à partir de l'image masquée. Une fois ce programme de formation terminé, l'encodeur peut également être affiné pour des tâches de vision telles que la classification et la détection d'objets.

Girshick a déclaré : « Ce qui nous passionne en fin de compte, c'est que nous voyons les résultats de ce modèle dans les tâches en aval. » Lorsque nous utilisons l'encodeur pour effectuer des tâches telles que la reconnaissance d'objets, « les gains que nous constatons sont très substantiels. » Continuer à augmenter le modèle peut conduire à de meilleures performances, ce qui constitue une orientation potentielle pour les modèles futurs, car SSL "a le potentiel d'utiliser de grandes quantités de données sans avoir besoin d'annotation manuelle".

S'efforcer d'apprendre à partir d'ensembles de données massifs et non filtrés est peut-être la stratégie de Meta pour améliorer les résultats SSL, mais c'est aussi une approche de plus en plus controversée. Des chercheurs en éthique de l’IA tels que Timnit Gebru ont attiré l’attention sur les biais inhérents aux ensembles de données non conservés à partir desquels les grands modèles de langage apprennent, ce qui peut parfois conduire à des résultats désastreux.

Dans les systèmes vidéo MAE, les masques masquent 95 % de chaque image vidéo car la similitude entre les images signifie que les signaux vidéo ont plus de redondance que les images statiques. Le méta-chercheur Christoph Feichtenhofer a déclaré qu'en matière de vidéo, l'un des principaux avantages de l'approche MAE est que la vidéo nécessite souvent beaucoup de calculs, et MAE réduit les coûts de calcul jusqu'à 95 % en masquant jusqu'à 95 % du contenu de chaque image. .

Les clips vidéo utilisés dans ces expériences ne duraient que quelques secondes, mais Feichtenhofer a déclaré que la formation de systèmes d'intelligence artificielle avec des vidéos plus longues est un sujet de recherche très actif. Imaginez que vous ayez un assistant virtuel qui possède une vidéo de votre maison et peut vous dire où vous avez laissé vos clés il y a une heure.

Plus directement, nous pouvons imaginer que les systèmes d'image et de vidéo sont tous deux utiles pour les tâches de classification nécessaires à la modération du contenu sur Facebook et Instagram. Feichtenhofer a déclaré que « l'intégrité » est une application possible : « Nous travaillons avec l'équipe produit Communication, mais c'est très nouveau et nous n'avons pas encore de projets spécifiques. »

Pour le travail audio MAE, l'équipe de Meta AI a annoncé qu'elle publierait bientôt les résultats de la recherche sur arXiv. Ils ont trouvé une manière astucieuse d’appliquer la technique du masquage. Ils ont converti les fichiers sonores en spectrogrammes, qui sont des représentations visuelles du spectre de fréquences d'un signal, puis ont masqué des parties des images à des fins de formation. L'audio reconstruit est impressionnant, même si le modèle ne peut actuellement gérer que des clips de quelques secondes. Bernie Huang, chercheur en système audio, a déclaré que les applications potentielles de cette recherche incluent les tâches de classification, l'assistance à la transmission voix sur IP (VoIP) en comblant l'audio perdu lorsque les paquets sont abandonnés ou la recherche d'une méthode de compression de fichier audio plus efficace.

Meta a mené des recherches open source sur l'IA, telles que ces modèles MAE, et fournit également un grand modèle de langage pré-entraîné à la communauté de l'intelligence artificielle. Mais les critiques soulignent que, malgré son ouverture à la recherche, Meta n’a pas rendu disponibles à l’étude ses algorithmes de base : ceux qui contrôlent les flux d’actualités, les recommandations et le placement des publicités.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!