L'apprentissage par renforcement multi-agents (MARL) est un problème difficile qui nécessite non seulement d'identifier la direction de l'amélioration des politiques pour chaque agent, mais également de combiner conjointement les mises à jour des politiques des agents individuels pour améliorer les performances globales. Récemment, ce problème a été initialement résolu et certains chercheurs ont introduit la méthode d'exécution décentralisée de formation centralisée (CTDE), qui permet à l'agent d'accéder à des informations globales pendant la phase de formation. Cependant, ces méthodes ne peuvent pas couvrir toute la complexité des interactions multi-agents.

En fait, certaines de ces méthodes se sont révélées être des échecs. Afin de résoudre ce problème, quelqu’un a proposé le théorème de décomposition de dominance multi-agents. Sur cette base, les algorithmes HATRPO et HAPPO sont dérivés. Cependant, ces approches présentent des limites, qui reposent toujours sur des objectifs de maximisation soigneusement conçus.

Ces dernières années, les modèles de séquence (SM) ont fait des progrès substantiels dans le domaine du traitement du langage naturel (NLP). Par exemple, les séries GPT et BERT fonctionnent bien sur un large éventail de tâches en aval et obtiennent de bonnes performances sur des tâches de généralisation de petits échantillons.

Étant donné que les modèles de séquence s'adaptent naturellement aux caractéristiques de séquence du langage, ils peuvent être utilisés pour des tâches linguistiques, mais les méthodes de séquence ne se limitent pas aux tâches de PNL, mais constituent un modèle de base général largement applicable. Par exemple, en vision par ordinateur (CV), on peut diviser une image en sous-images et les organiser dans une séquence comme s'il s'agissait de jetons dans une tâche PNL. Les modèles récents les plus connus comme Flamingo, DALL-E, GATO, etc. ont tous l'ombre de la méthode séquence.

Avec l'émergence d'architectures de réseau telles que Transformer, la technologie de modélisation de séquence a également attiré une grande attention de la communauté RL, qui a promu une série de développements RL hors ligne basés sur l'architecture Transformer. Ces méthodes montrent un grand potentiel pour résoudre certains des problèmes de formation RL les plus fondamentaux.

Malgré le succès notable de ces méthodes, aucune n'a été conçue pour modéliser l'aspect le plus difficile (et propre à MARL) des systèmes multi-agents : les interactions entre agents. En fait, si nous donnons simplement à tous les agents une politique Transformer et les formons individuellement, cela n’est toujours pas garanti pour améliorer les performances communes de MARL. Par conséquent, bien qu’il existe un grand nombre de modèles de séquence puissants disponibles, MARL ne tire pas vraiment parti des performances des modèles de séquence.

Comment utiliser le modèle de séquence pour résoudre le problème MARL ? Des chercheurs de l'Université Jiao Tong de Shanghai, du Digital Brain Lab, de l'Université d'Oxford, etc. ont proposé une nouvelle architecture de transformateur multi-agent (MAT, Multi-Agent Transformer), qui peut transformer efficacement les problèmes MARL collaboratifs en problèmes de modèle de séquence. séquence d'observation de l'agent à la séquence d'action optimale de l'agent.

L'objectif de cet article est de construire un pont entre MARL et SM afin de débloquer les capacités de modélisation des modèles de séquence modernes pour MARL. Le cœur de MAT est l'architecture codeur-décodeur, qui utilise le théorème de décomposition des avantages multi-agents pour transformer le problème de recherche de stratégie conjointe en un processus de prise de décision séquentiel, de sorte que le problème multi-agent présente une complexité temporelle linéaire, et la plupart plus important encore, cela garantit une amélioration monotone des performances de MAT. Contrairement aux techniques précédentes telles que Decision Transformer qui nécessitent des données hors ligne pré-collectées, MAT est formé de manière stratégique en ligne par essais et erreurs en ligne à partir de l'environnement.

Pour vérifier MAT, les chercheurs ont mené des expériences approfondies sur StarCraftII, Multi-Agent MuJoCo, Dexterous Hands Manipulation et Google Research Football benchmarks. Les résultats montrent que MAT a de meilleures performances et une meilleure efficacité des données par rapport aux bases de référence solides telles que MAPPO et HAPPO. En outre, cette étude a également prouvé que, quel que soit l'évolution du nombre d'agents, MAT est plus performant sur des tâches invisibles, mais on peut dire qu'il est un excellent apprenant sur petit échantillon.

Dans cette section, le chercheur présente d'abord la formule collaborative du problème MARL et le théorème de décomposition de dominance multi-agents, qui sont les pierres angulaires de cet article. Ensuite, ils examinent les méthodes MARL existantes liées à MAT, menant finalement à Transformer.

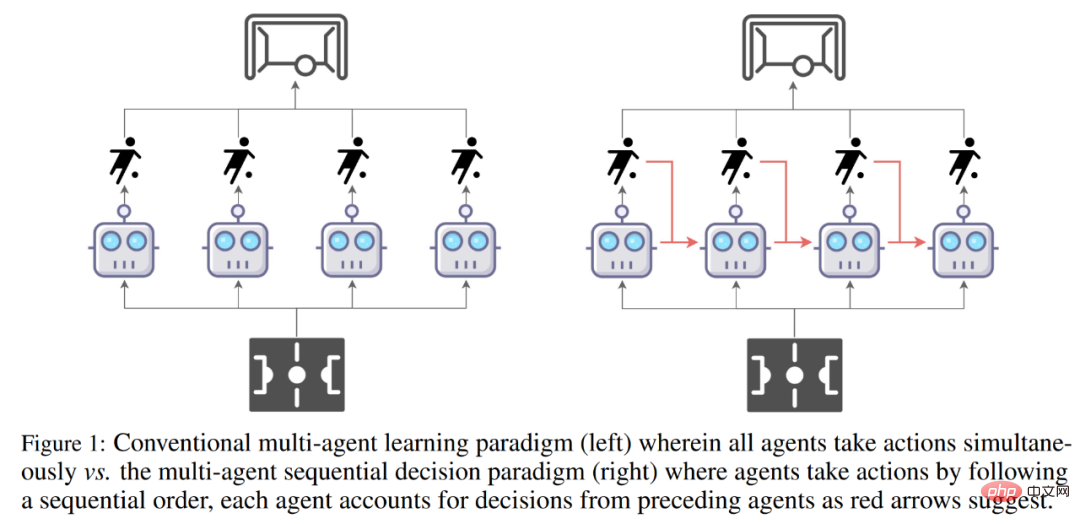

Comparaison du paradigme d'apprentissage multi-agent traditionnel (à gauche) et du paradigme de prise de décision en séquence multi-agent (à droite).

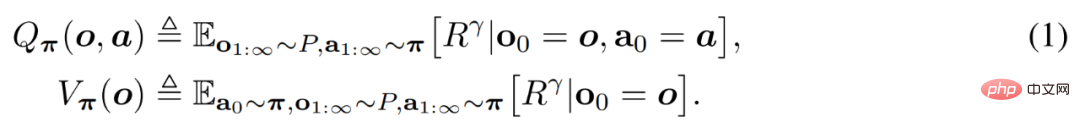

Les problèmes MARL collaboratifs sont généralement modélisés par des processus décisionnels de Markov discrets partiellement observables (Dec-POMDP)  .

.

Les agents évaluent les valeurs des actions et des observations à travers Q_π(o, a) et V_π(o), qui sont définis comme suit.

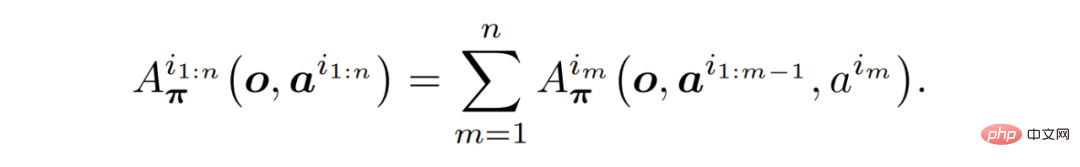

Théorème 1 (Décomposition de dominance multi-agents) : Soit i_1:n l'arrangement des agents. La formule suivante est toujours valable sans autres hypothèses.

Il est important de noter que le théorème 1 fournit une intuition sur la manière de choisir des actions d'amélioration incrémentielle.

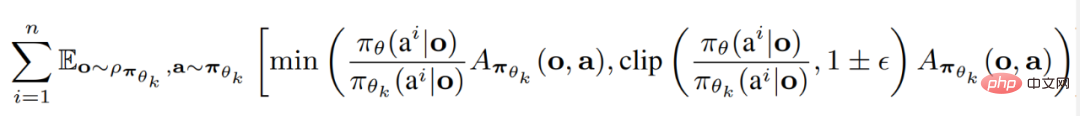

Les chercheurs ont résumé les deux algorithmes SOTA MARL actuels, tous deux basés sur l'optimisation de politique proximale (PPO). PPO est une méthode RL connue pour sa simplicité et sa stabilité des performances.

L'optimisation des politiques proximales multi-agents (MAPPO) est la première et la plus directe méthode pour appliquer le PPO à MARL.

L'optimisation de la politique proximale d'agent hétérogène (HAPPO) est l'un des algorithmes SOTA actuels, qui peut utiliser pleinement le théorème (1) pour réaliser un apprentissage de domaine de confiance multi-agent avec une garantie d'amélioration monotone.

Modèle Transformer

Basé sur les propriétés de séquence décrites dans le théorème (1) et le principe derrière HAPPO, il est désormais intuitif d'envisager d'utiliser le modèle Transformer pour implémenter une région de confiance multi-agents apprentissage. En traitant une équipe d'agents comme une séquence, l'architecture Transformer permet de modéliser des équipes d'agents avec des nombres et des types variables tout en évitant les défauts de MAPPO/HAPPO.

Afin de réaliser le paradigme de modélisation de séquence de MARL, la solution proposée par les chercheurs est le transformateur multi-agent (MAT). L'idée d'appliquer l'architecture Transformer vient du fait que l'agent observe la relation entre l'entrée de la séquence (o^i_1,..., o^i_n) et la sortie de la séquence d'action (a^i_1, . ., a^i_n) Le mappage est une tâche de modélisation de séquence similaire à la traduction automatique. Comme l'évite le théorème (1), l'action a^i_m dépend des décisions précédentes de tous les agents a^i_1:m−1.

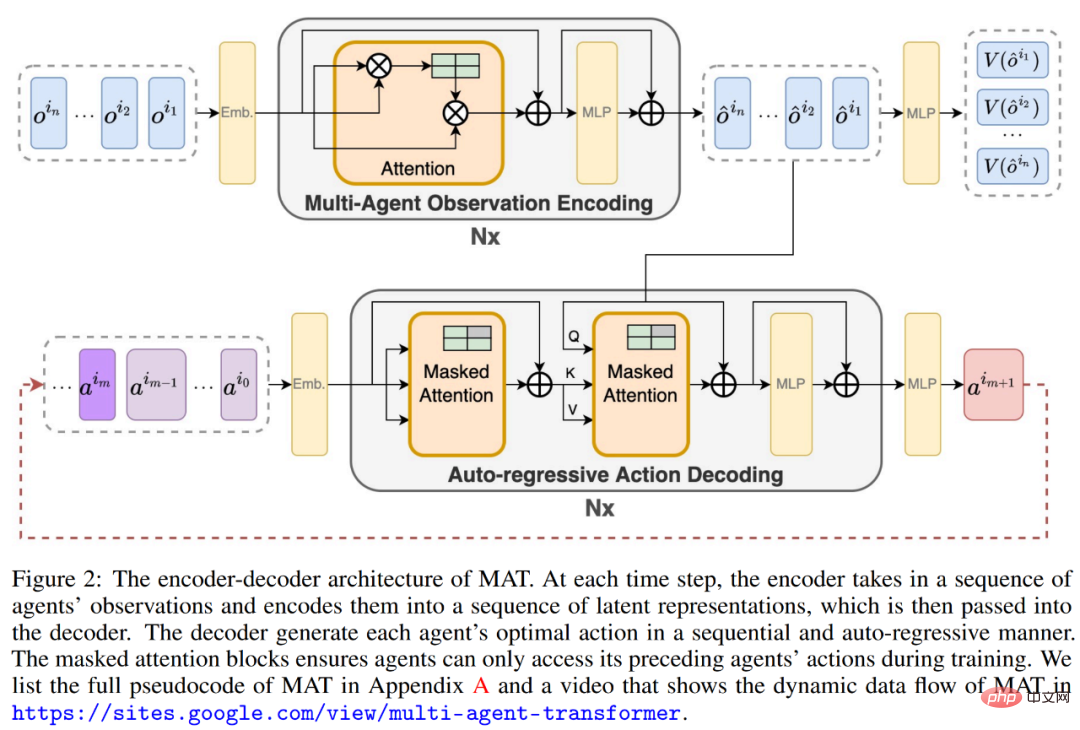

Par conséquent, comme le montre la figure (2) ci-dessous, MAT contient un encodeur pour apprendre une représentation d'observation conjointe et un décodeur qui génère des actions pour chaque agent de manière autorégressive.

Les paramètres de l'encodeur sont notés φ, qui prend une séquence d'observations (o^i_1, . . . , o^i_n) dans un ordre arbitraire et les transmet à travers plusieurs calculs. blocs. Chaque bloc se compose d'un mécanisme d'auto-attention, d'un perceptron multicouche (MLP) et de connexions résiduelles pour empêcher la disparition des gradients et la dégradation du réseau avec l'augmentation de la profondeur. Les paramètres du décodeur

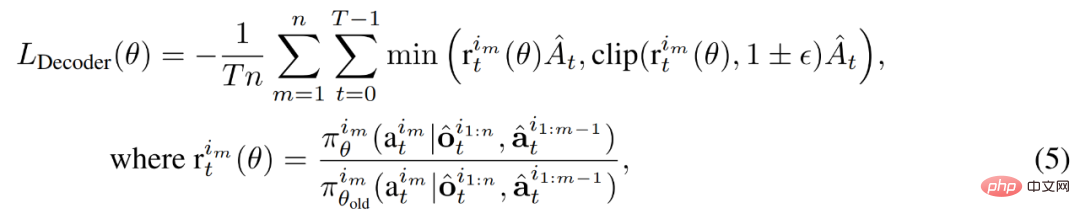

sont représentés par θ, qui transmet l'action conjointe intégrée a^i_0:m−1 , m = {1, . n} (où a^i_0 est un symbole arbitraire indiquant le début. de décodage) à la séquence de blocs décodée. Fondamentalement, chaque bloc de décodage possède un mécanisme d’auto-attention masqué. Pour entraîner le décodeur, nous minimisons l'objectif PPO recadré comme suit. Le flux de données détaillé dans

MAT est présenté dans l'animation ci-dessous.

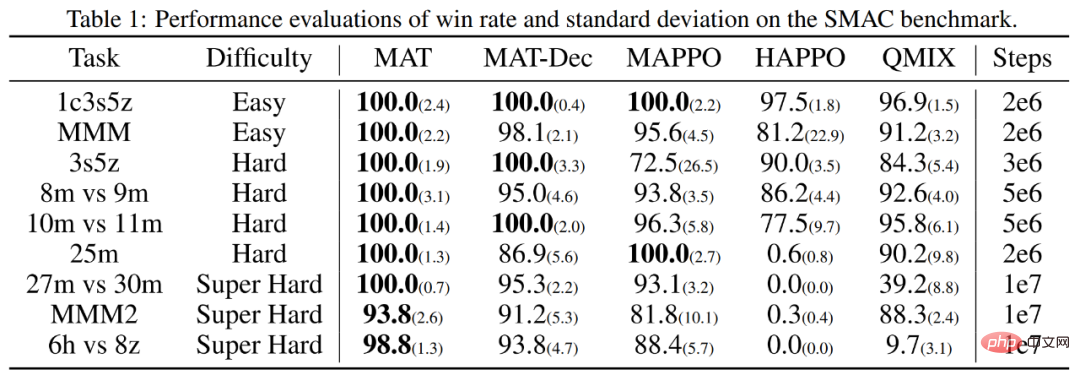

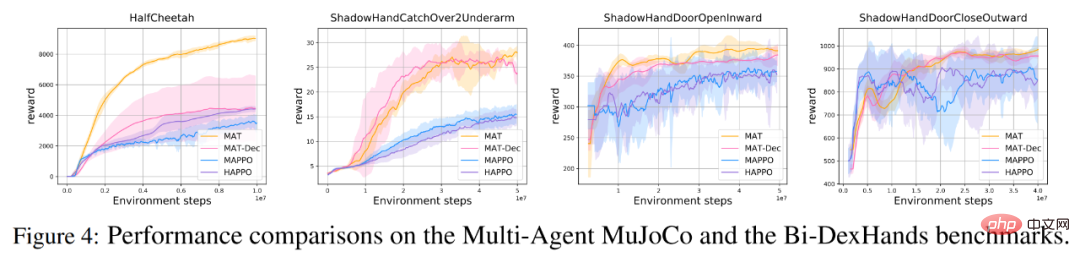

Pour évaluer si MAT répond aux attentes, les chercheurs ont effectué des expériences sur le benchmark StarCraft II Multi-Agent Challenge (SMAC) (MAPPO a des performances supérieures) et le benchmark multi-agent MuJoCo (HAPPO sur MAT a été testé avec les performances SOTA ci-dessus.

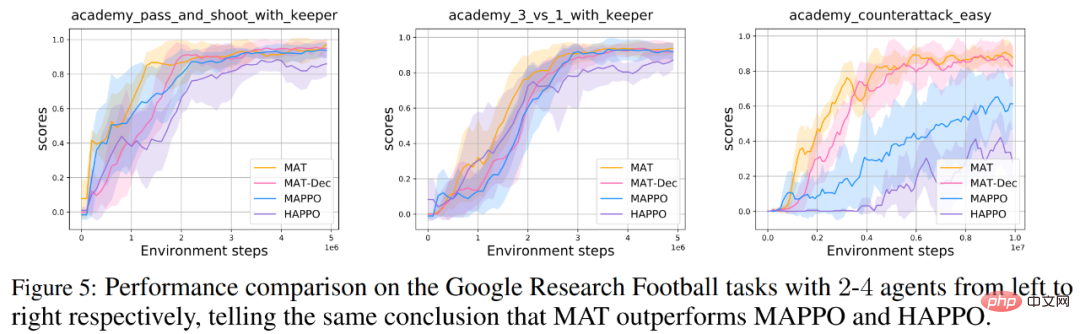

De plus, les chercheurs ont également mené des tests étendus sur MAT sur la manipulation bimanuelle des mains (Bi-DexHands) et les benchmarks Google Research Football. Le premier propose une gamme de tâches difficiles à deux mains, et le second propose une gamme de scénarios coopératifs dans un match de football.

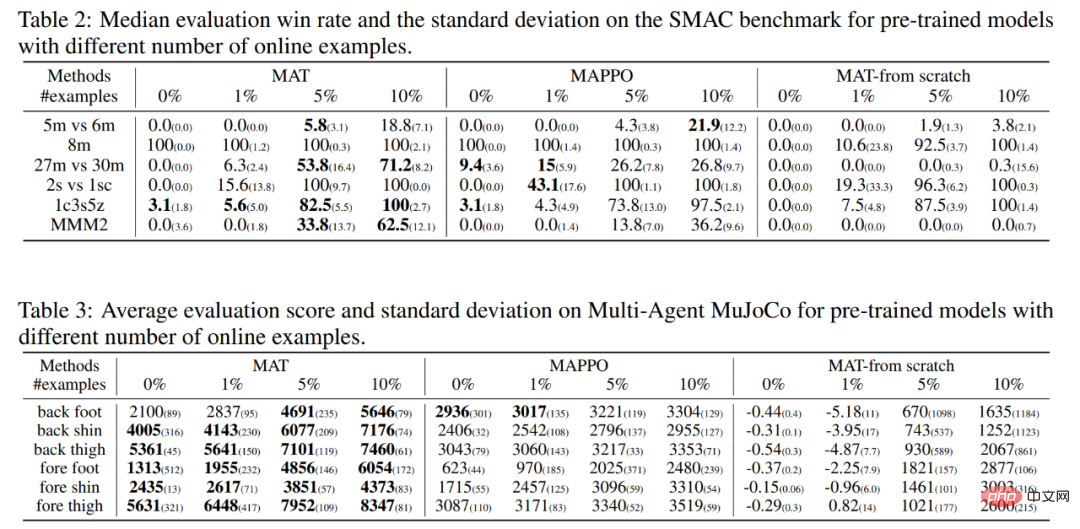

Enfin, étant donné que le modèle Transformer montre généralement de fortes performances de généralisation sur de petits échantillons de tâches, les chercheurs pensent que MAT peut également avoir des capacités de généralisation tout aussi fortes sur des tâches MARL invisibles. Par conséquent, ils ont conçu des expériences à tir nul et à petit tir sur les tâches SMAC et MuJoCo multi-agents.

Comme le montrent le tableau 1 et la figure 4 ci-dessous, pour les benchmarks SMAC, MuJoCo multi-agents et Bi-DexHands, MAT surpasse considérablement MAPPO et HAPPO sur presque toutes les tâches, il montre sa construction puissante capacité sur des tâches d’agents homogènes et hétérogènes. De plus, MAT atteint également de meilleures performances que MAT-Dec, ce qui indique l'importance de l'architecture du décodeur dans la conception de MAT.

De même, les chercheurs ont également obtenu des résultats de performance similaires sur le benchmark Google Research Football, comme le montre la figure 5 ci-dessous.

Les résultats zéro et quelques coups pour chaque algorithme sont résumés dans les tableaux 2 et 3, où les chiffres en gras indiquent les meilleures performances.

Les chercheurs ont également fourni les performances de MAT dans les mêmes conditions de données, qui ont été formées à partir de zéro comme le groupe témoin. Comme le montre le tableau ci-dessous, MAT obtient la plupart des meilleurs résultats, ce qui démontre les solides performances de généralisation de l'apprentissage en quelques étapes de MAT.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Page d'erreur 404 de l'ordinateur

Page d'erreur 404 de l'ordinateur

Solution à l'invite de table de partition non valide au démarrage de Windows 10

Solution à l'invite de table de partition non valide au démarrage de Windows 10

Comment résoudre le problème de ssleay32.dll manquant

Comment résoudre le problème de ssleay32.dll manquant

Comment définir l'IP

Comment définir l'IP

Comment ouvrir le fichier d'état

Comment ouvrir le fichier d'état

Pourquoi le disque dur mobile est-il si lent à s'ouvrir ?

Pourquoi le disque dur mobile est-il si lent à s'ouvrir ?

Quelles sont les unités de base du langage C ?

Quelles sont les unités de base du langage C ?

Quelle plateforme est Kuai Tuan Tuan ?

Quelle plateforme est Kuai Tuan Tuan ?