Cet article résume les innovations dans la structure des réseaux lors de l'utilisation des CNN pour la segmentation sémantique des images. Ces innovations incluent principalement la conception de nouvelles architectures neuronales (différentes profondeurs, largeurs, connexions et topologies) et la conception de nouveaux composants ou couches. Le premier utilise des composants existants pour assembler des réseaux complexes à grande échelle, tandis que le second préfère concevoir des composants sous-jacents. Tout d’abord, nous introduisons quelques réseaux de segmentation sémantique classiques et leurs innovations, puis introduisons quelques applications de la conception de structures de réseaux dans le domaine de la segmentation d’images médicales.

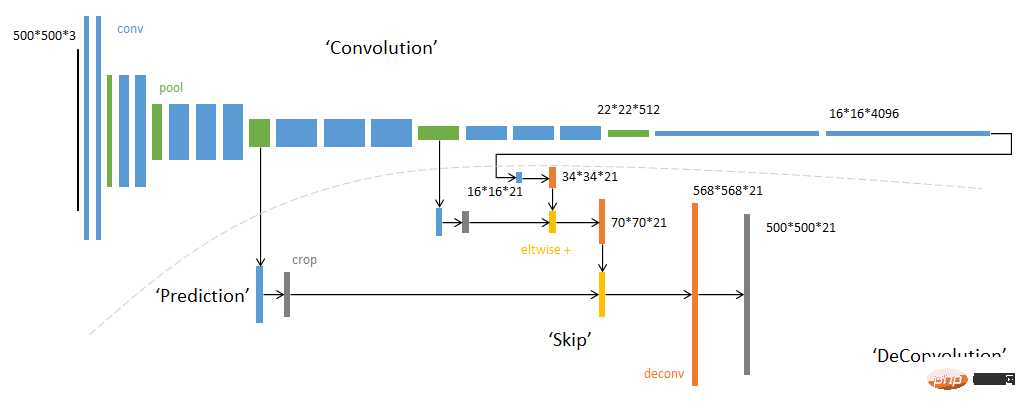

Architecture globale du FCN

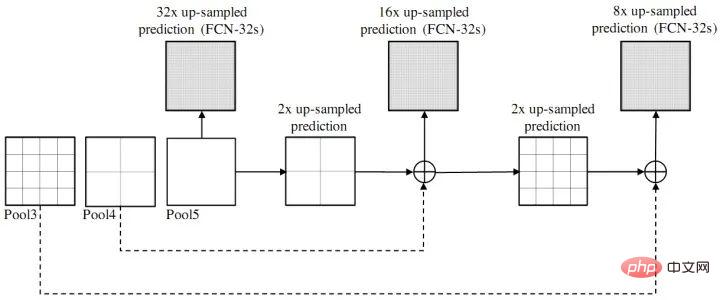

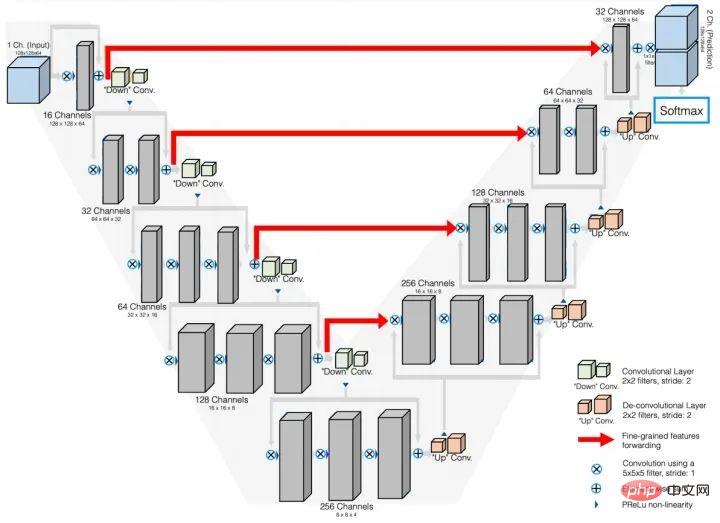

Schéma simplifiéLe réseau FCN est répertorié séparément car le réseau FCN est le premier de Un réseau pour résoudre les problèmes de segmentation sémantique dans une toute nouvelle perspective. Les réseaux de segmentation sémantique d'images précédents basés sur des réseaux de neurones utilisent des blocs d'images centrés sur le pixel à classer pour prédire l'étiquette du pixel central. Le réseau est généralement construit à l'aide d'une stratégie CNN+FC. Évidemment, cette méthode ne peut pas utiliser les informations de contexte global. de l'image, et la vitesse de raisonnement pixel par pixel est très faible ; tandis que le réseau FCN abandonne la couche FC entièrement connectée et utilise des couches convolutives pour construire le réseau grâce à la stratégie de convolution transposée et de fusion de caractéristiques de différentes couches. la sortie du réseau est directement le masque de prédiction de l'image d'entrée. L'efficacité et la précision ont été grandement améliorées.

Diagramme de fusion de caractéristiques de différentes couches FCN

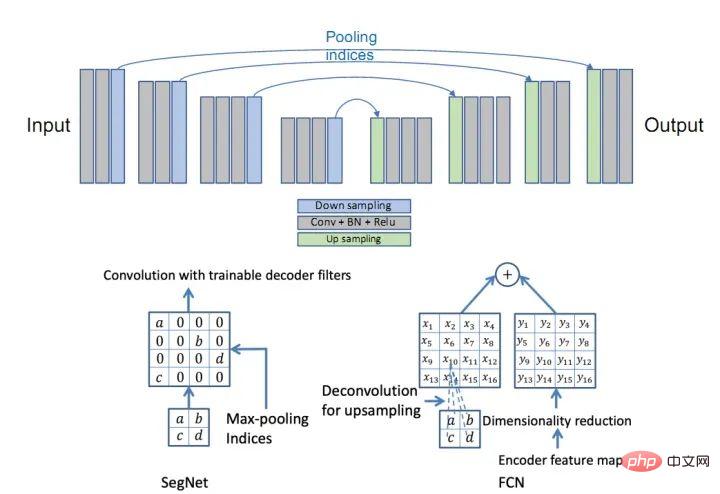

Points d'innovation : réseau entièrement convolutionnel (à l'exclusion de la couche FC) ; Structure d'encodage (Enconder-decoder)

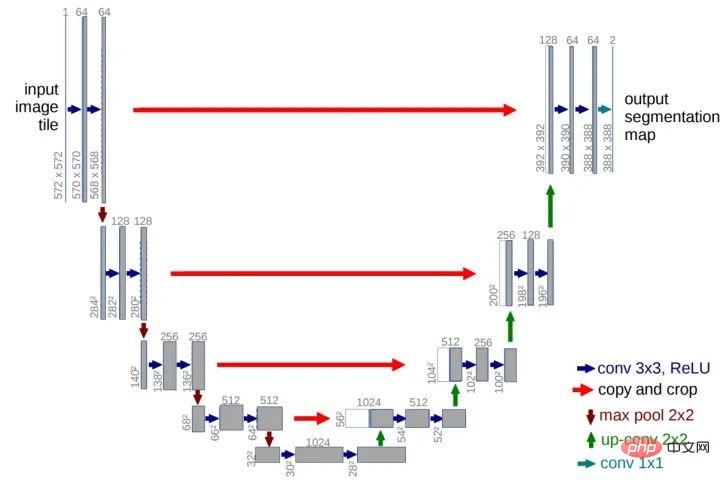

: Structure Encodeur-Décodeur ;

Réseau SegNet

Comparaison de la méthode Upsample entre SegNet et FCN

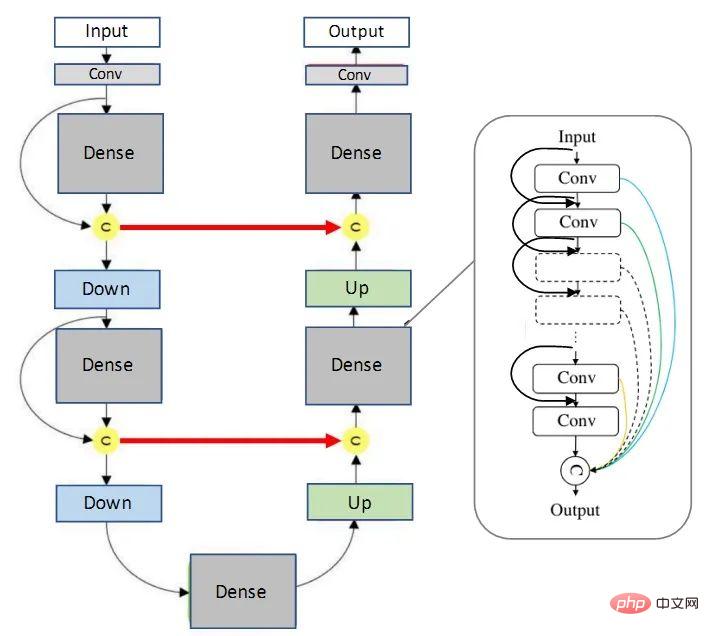

, maintenant UNet et ses variantes ont été largement utilisées dans divers sous-domaines du CV. Le réseau UNet se compose d'un canal U et d'une connexion sautée. Le canal U est similaire à la structure de codage et de décodage de SegNet. La partie de codage (chemin de contraction) effectue l'extraction de fonctionnalités et capture les informations de contexte, et la partie de décodage (chemin d'expansion). ) utilise des fonctionnalités de décodage graphique pour prédire les étiquettes de pixels. Le canal de court-circuit améliore la précision du modèle et résout le problème de disparition du gradient. Il est particulièrement important de noter que la carte de caractéristiques du canal de court-circuit et la carte de caractéristiques utilisée ci-dessus sont assemblées plutôt qu'ajoutées (différentes de FCN).: Structure en forme de U ; canal de court-circuit (connexion par saut)

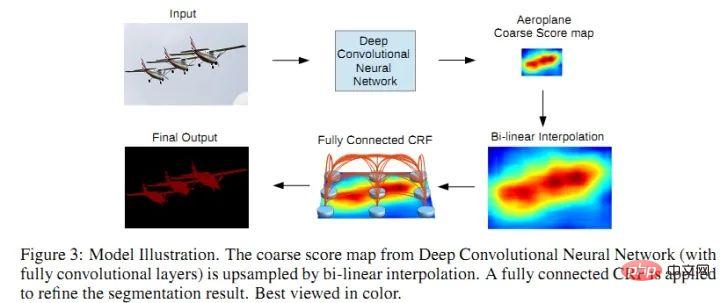

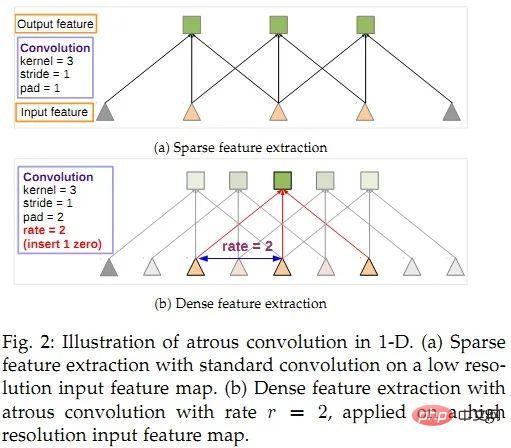

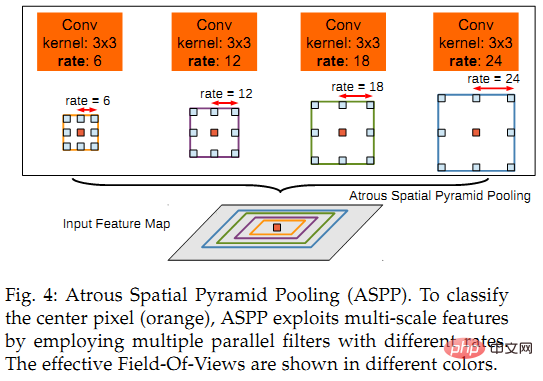

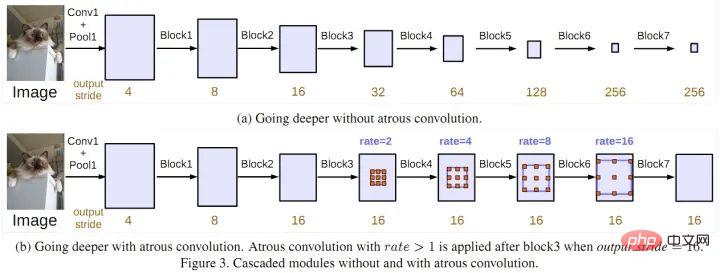

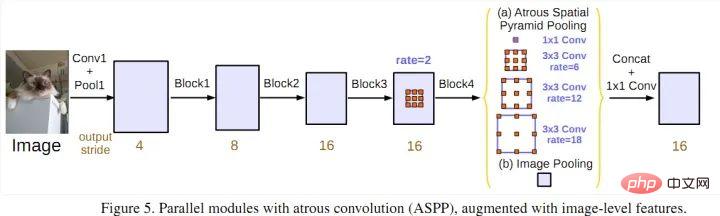

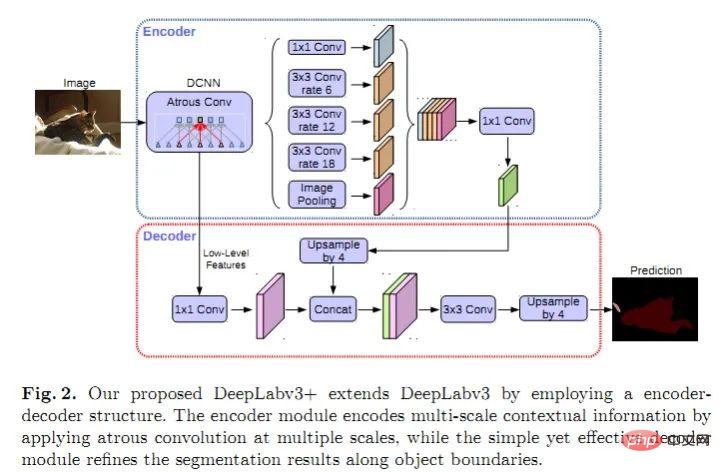

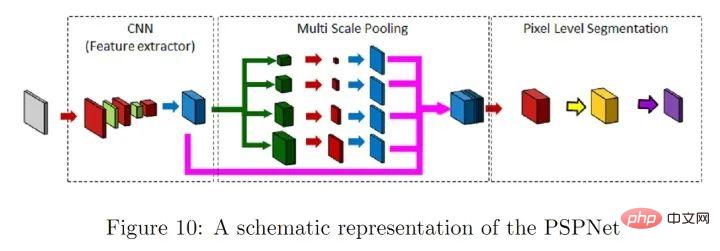

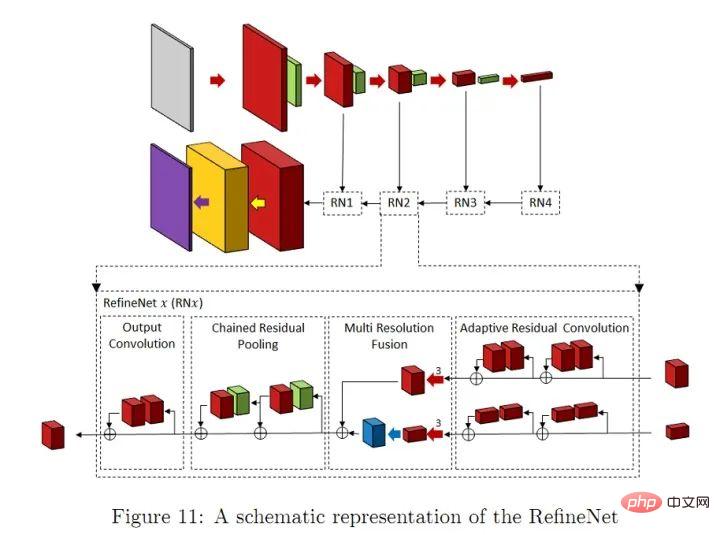

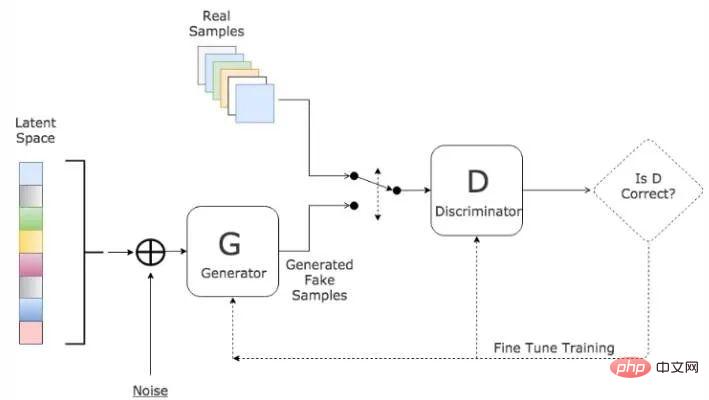

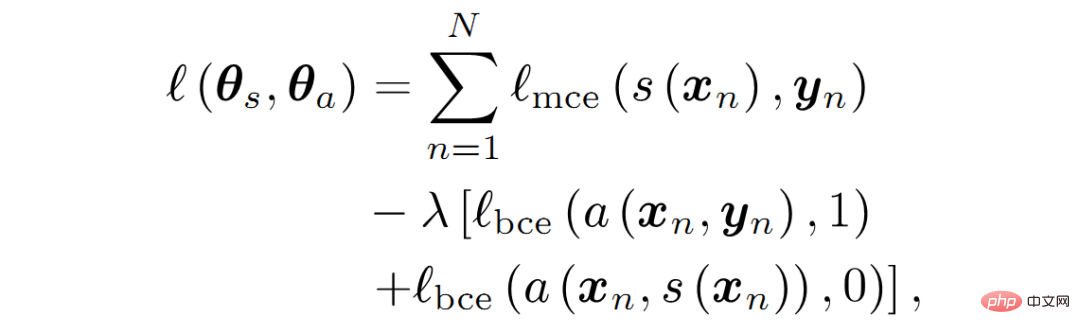

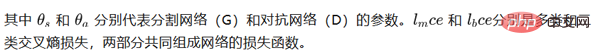

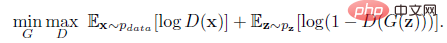

Réseau U-Net Réseau V-Net Point d'innovation : Equivalent à la version 3D du réseau U-Net FC-DenseNet (Réseau Tiramisu à Cent Couches) Point d'innovation : Intégrer les réseaux DenseNet et U-Net (du point de vue de l'échange d'informations, les connexions denses sont en effet plus puissantes que les structures résiduelles) 1) DeepLabV1 : Fusion d'un réseau neuronal convolutif et d'un modèle de graphe de probabilité : CNN+CRF, qui améliore la précision de la segmentation et du positionnement 2) DeepLabV2 : ASPP (extension ; Regroupement de pyramides spatiales ); CNN+CRF 3) DeepLabV3 : ASPP amélioré, ajoutant une convolution 1*1 et un regroupement moyen global (pool moyen global comparé à l'effet cumulatif des volumes atreux en cascade et parallèles). Convolution Atrous en Cascade Convolution Atrous Parallèle (ASPP) 4) DeepLabV3+ : Ajouter l'idée d'architecture codec et ajouter un décodeur module pour étendre DeepLabv3 ; Appliquez des convolutions séparables en profondeur aux modules ASPP et décodeur ; Xception améliorée en tant que backbone. DeepLabV3+ En général, les principales contributions de la DeepLab series : convolution atreuse ; ASPP ; réseau profond Pour les problèmes de flou, l'effet est meilleur que l'ajout de CRF) Réseau PSPNet Points d'innovation : Regroupement multi-échelles pour mieux utiliser les connaissances préalables globales au niveau de l'image pour comprendre les scènes complexes Réseau RefineNet Point d'innovation : module Affiner De nombreux travaux sont également consacrés à la réduction de la complexité informatique des réseaux de segmentation sémantique. Quelques méthodes pour simplifier la structure des réseaux profonds : décomposition tensorielle ; élagage des connexions clairsemées canal/réseau ; Il y en a aussi qui utilisent le NAS (Neural Architecture Search) pour remplacer la conception manuelle pour rechercher la structure des modules ou l'ensemble du réseau. Bien entendu, les ressources GPU requises par AutoDL dissuaderont un grand nombre de personnes. Par conséquent, certaines personnes utilisent la recherche aléatoire pour rechercher des modules ASPP beaucoup plus petits, puis construisent l'intégralité du modèle de réseau basé sur les petits modules. La conception de réseau légère est le consensus dans l'industrie. Pour le déploiement mobile, il est impossible d'équiper chaque machine d'un 2080ti. De plus, la consommation d'énergie, le stockage et d'autres problèmes limiteront également la promotion et l'application du modèle. Cependant, si la 5G devient populaire, toutes les données pourront être traitées dans le cloud, ce qui sera très intéressant. Bien entendu, à court terme (dix ans), on ne sait pas si le déploiement à grande échelle de la 5G est réalisable. Le mécanisme d'attention peut être défini comme : utiliser les informations de couche/carte de caractéristiques suivantes pour sélectionner et localiser la partie la plus critique (ou la plus saillante) de la carte de caractéristiques d'entrée. Cela peut simplement être considéré comme un moyen de pondérer les cartes de caractéristiques (les poids sont calculés via le réseau). Selon les différentes fonctions des poids, il peut être divisé en mécanisme d'attention de canal (CA) et mécanisme d'attention spatiale (PA). . Le réseau FPA (Feature Pyramid Attention) est un réseau de segmentation sémantique basé sur le mécanisme d'attention, qui combine le mécanisme d'attention et la pyramide spatiale pour extraire des caractéristiques précises pour un étiquetage au niveau des pixels sans utiliser de réseaux de décodeurs convolutifs et conçus par l'homme. Goodfellow et al. ont proposé une méthode contradictoire pour apprendre des modèles génératifs profonds en 2014. Dans les réseaux contradictoires génératifs (GAN), deux modèles doivent être formés en même temps : un modèle génératif qui capture la distribution des données G et un modèle discriminant D qui estime la probabilité qu'un échantillon provienne des données de formation. gird G est un réseau génératif, qui reçoit un bruit aléatoire z (nombre aléatoire), et génère une image à travers ce bruit gird D est un réseau discriminatif, qui détermine si une image est "réelle". Son paramètre d'entrée est x (une image) et la sortie D(x) représente la probabilité que x soit une image réelle. S'il vaut 1, cela signifie que 100 % est une image réelle et la sortie est 0, ce qui signifie qu'elle est réelle. ne peut pas être une image réelle. La procédure de formation de G consiste à maximiser la probabilité d'erreur D. On peut prouver que dans l'espace de toutes fonctions G et D, il existe une solution unique telle que G reproduit la distribution des données d'entraînement, et D=0,5. Lors du processus de formation, le but du réseau de génération G est d'essayer de générer des images réelles pour tromper le réseau discriminant D. Le but de D est d’essayer de distinguer les fausses images générées par G des images réelles. De cette manière, G et D constituent un « processus de jeu » dynamique et le point d’équilibre final est le point d’équilibre de Nash. Dans le cas où G et D sont définis par un réseau de neurones, l'ensemble du système peut être entraîné par rétropropagation. Illustration de la structure du réseau GANsInspirés par les GAN, Luc et al. ont formé un réseau de segmentation sémantique (G) et un réseau contradictoire (D). G) diagramme de segmentation. G et D continuent de jouer à des jeux et d'apprendre, et leur fonction de perte est définie comme : Fonction de perte des GAN https://www.cnblogs.com/walter-xh/p/10051634.html). A ce moment, seuls les paramètres de G sont mis à jour. Afin de réaliser un traitement en temps réel d'images médicales 2D/3D haute résolution (telles que des images de tomodensitométrie, d'IRM, d'histopathologie, etc.), les chercheurs ont proposé diverses méthodes pour compresser modèles. Weng et al. ont utilisé la technologie NAS pour l'appliquer au réseau U-Net et ont obtenu un petit réseau avec de meilleures performances de segmentation des organes/tumeurs sur les images CT, IRM et échographiques. Brugger a repensé l'architecture U-Net en utilisant la normalisation de groupe et Leaky-ReLU (fonction Leaky ReLU) pour rendre plus efficace l'efficacité du stockage du réseau pour la segmentation des images médicales 3D. Certaines personnes ont également conçu des modules de convolution dilatés avec moins de paramètres. Certaines autres méthodes de compression de modèle incluent la quantification du poids (quantification binaire à seize, huit bits), la distillation, l'élagage, etc. Drozdal a proposé une méthode qui applique un CNN simple pour normaliser l'image d'entrée originale avant d'introduire l'image dans le réseau de segmentation, ce qui améliore la segmentation des images de microscopie unique, la tomodensitométrie du foie et la précision de la segmentation de la prostate. IRM. Gu a proposé une méthode d'utilisation de la convolution dilatée dans le réseau fédérateur pour conserver les informations contextuelles. Vorontsov a proposé un cadre de réseau graphique à graphique qui convertit les images avec retour sur investissement en images sans retour sur investissement (par exemple, les images avec des tumeurs sont converties en images saines sans tumeurs), puis les tumeurs supprimées par le modèle sont ajoutées aux nouvelles images saines. , pour obtenir la structure détaillée de l'objet. Zhou et al. ont proposé une méthode de recâblage de connexion du réseau U-Net et l'ont réalisée sur la segmentation des nodules dans les tomodensitogrammes thoraciques à faible dose, la segmentation nucléaire dans les images microscopies, la segmentation du foie dans les tomodensitogrammes abdominaux et la coloscopie. sur une tâche de segmentation de polypes dans la vidéo d'examen. Goyal a appliqué DeepLabV3 à la segmentation dermoscopique d'images couleur afin d'extraire les zones de lésions cutanées. Nie a proposé un modèle d'attention, qui peut segmenter la prostate avec plus de précision par rapport aux modèles de base (V-Net et FCN). SinHa a proposé un réseau basé sur un mécanisme d'attention multicouche pour la segmentation des organes abdominaux dans les images IRM. Qin et al. ont proposé un module de convolution dilaté pour préserver plus de détails des images médicales 3D. Il existe de nombreux autres articles sur la segmentation des images sanguines basées sur les mécanismes d’attention. Khosravan a proposé un réseau de formation contradictoire pour la segmentation pancréatique à partir des tomodensitogrammes. Son utilise des réseaux antagonistes génératifs pour la segmentation des images rétiniennes. Xue utilise un réseau entièrement convolutionnel comme réseau de segmentation dans un cadre contradictoire génératif pour segmenter les tumeurs cérébrales à partir d’images IRM. Il existe d’autres articles qui appliquent avec succès les GAN aux problèmes de segmentation d’images médicales, je ne les énumérerai donc pas un par un. Le réseau neuronal récurrent (RNN) est principalement utilisé pour traiter les données de séquence (LSTM) est une version améliorée de LSTM qui permet le flux de gradient en introduisant des boucles automatiques. .Peut être maintenu longtemps. Dans le domaine de l'analyse d'images médicales, les RNN sont utilisés pour modéliser les dépendances temporelles dans les séquences d'images. Bin et al. ont proposé un algorithme de segmentation de séquences d'images qui intègre un réseau neuronal entièrement convolutif et un RNN, et intègre des informations dans la dimension temporelle dans la tâche de segmentation. Gao et al. ont utilisé CNN et LSTM pour modéliser les relations temporelles dans les séquences de tranches d'IRM cérébrale afin d'améliorer les performances de segmentation dans les images 4D. Li et al. ont d'abord utilisé U-Net pour obtenir la carte de probabilité de segmentation initiale, puis ont utilisé LSTM pour segmenter le pancréas à partir d'images CT 3D, ce qui a amélioré les performances de segmentation. Il existe de nombreux autres articles qui utilisent le RNN pour la segmentation d'images médicales, je ne les présenterai donc pas un par un. Cette partie du contenu concerne principalement l'application d'algorithmes de segmentation dans la segmentation d'images médicales, il n'y a donc pas beaucoup de points d'innovation. Elle se concentre principalement sur l'analyse de données dans différents formats (CT ou RVB, plage de pixels). , résolution d'image, etc.) En raison des caractéristiques des différentes parties des données (bruit, forme de l'objet, etc.), le réseau classique doit être amélioré pour différentes données afin de s'adapter au format et aux caractéristiques des données d'entrée, afin qu'il puisse mieux terminer la tâche de segmentation. Bien que l'apprentissage profond soit une boîte noire, la conception globale du modèle doit toujours suivre des règles : quelles stratégies résolvent quels problèmes et quels problèmes elles provoquent peuvent être choisies en fonction du problème de segmentation spécifique pour obtenir des performances de segmentation optimales. 1.Segmentation sémantique approfondie des images naturelles et médicales : une revue 2.NAS-Unet : Recherche d'architecture neuronale pour la segmentation d'images médicales, 7 : 44247–44257, 2019 . 3.Boosting la segmentation avec une faible supervision de la traduction d'image à image. segmentation d'images médicales. 6.Réseaux LSTM structurés entièrement convolutifs pour la segmentation conjointe d'images médicales 4D En 2018 IEEE7 https://www.cnblogs .com/walter-xh/p/10051634.html

1.3 Réduire la structure de réseau complexe sur le plan informatique

1.4 Structure du réseau basée sur le mécanisme d'attention

1.5 Structure de réseau basée sur l'apprentissage contradictoire

2.1 Méthode de segmentation basée sur la compression de modèle

2.2 Méthode de segmentation de la structure d'encodage-décodage

2.3 Méthode de segmentation basée sur le mécanisme d'attention

2.4 Réseau de segmentation basé sur l'apprentissage contradictoire

2.5 Modèle de segmentation basé sur RNN

2.6 Résumé

Quelques références :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment gérer les caractères chinois tronqués sous Linux

Comment gérer les caractères chinois tronqués sous Linux

Ordre recommandé pour apprendre le langage C++ et C

Ordre recommandé pour apprendre le langage C++ et C

Comment résoudre les caractères tronqués en PHP

Comment résoudre les caractères tronqués en PHP

Méthode de réparation des doutes sur la base de données

Méthode de réparation des doutes sur la base de données

Solution de délai d'expiration des requêtes du serveur

Solution de délai d'expiration des requêtes du serveur

Solution d'erreur inattendue IIS 0x8ffe2740

Solution d'erreur inattendue IIS 0x8ffe2740

navigateur.useragent

navigateur.useragent

Comment obtenir un jeton

Comment obtenir un jeton