La restauration d'image consiste à compléter les zones manquantes de l'image, ce qui est l'une des tâches de base de la vision par ordinateur. Cette direction a de nombreuses applications pratiques, telles que la suppression d'objets, le reciblage d'images, la synthèse d'images, etc.

Les premières méthodes d'inpainting étaient basées sur la synthèse de blocs d'images ou la diffusion de couleurs pour combler les parties manquantes de l'image. Pour réaliser des structures d'images plus complexes, les chercheurs se tournent vers des approches basées sur les données, dans lesquelles ils utilisent des réseaux génératifs profonds pour prédire le contenu visuel et l'apparence. Grâce à un entraînement sur de grands ensembles d'images et à l'aide de la reconstruction et des pertes contradictoires, il a été démontré que les modèles d'inpainting génératifs produisent des résultats plus attrayants visuellement sur divers types de données d'entrée, notamment des images naturelles et des visages humains.

Cependant, les travaux existants ne peuvent donner de bons résultats que dans la réalisation de structures d'image simples, et générer du contenu d'image avec une structure globale complexe et des détails haute fidélité reste un énorme défi, surtout lorsque l'image a des trous lorsqu'elle est grande.

Essentiellement, l'inpainting d'images est confronté à deux problèmes clés : l'un est de savoir comment propager avec précision le contexte global à des régions incomplètes, et l'autre est de synthétiser de vrais détails locaux qui sont cohérents avec des indices globaux. Pour résoudre le problème de propagation du contexte global, les réseaux existants utilisent des structures de codeur-décodeur, des convolutions atreuses, une attention contextuelle ou des convolutions de Fourier pour intégrer des dépendances de fonctionnalités à longue portée et étendre le champ de réception efficace. De plus, l’approche en deux étapes et le remplissage itératif des trous reposent sur la prévision de résultats grossiers pour améliorer la structure globale. Cependant, ces modèles ne disposent pas d’un mécanisme permettant de capturer la sémantique de haut niveau des régions non masquées et de les propager efficacement dans des trous afin de synthétiser une structure globale globale.

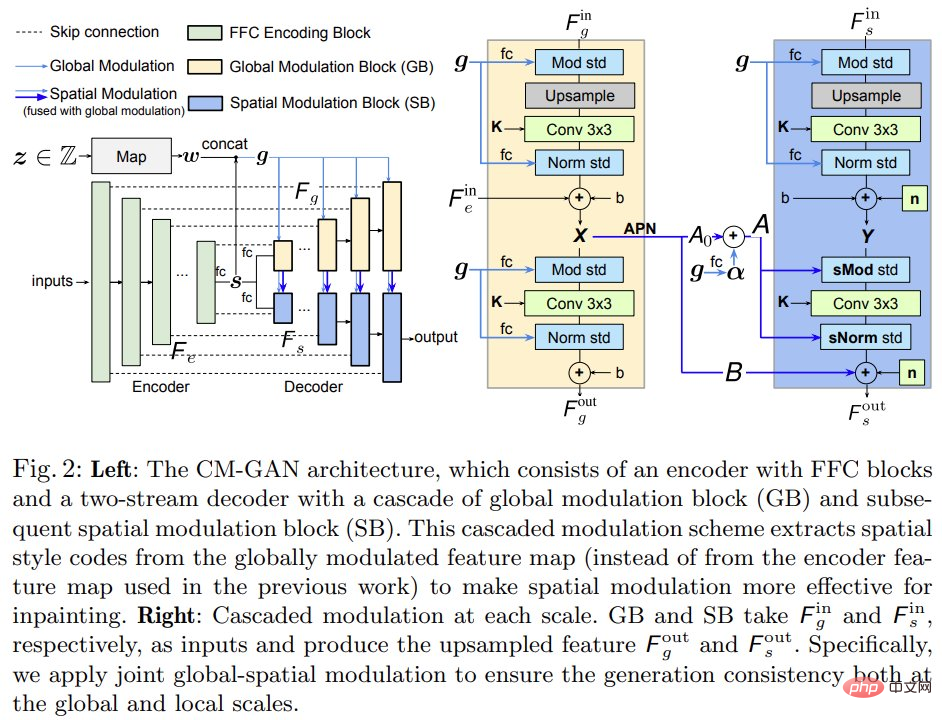

Sur cette base, des chercheurs de l'Université de Rochester et Adobe Research ont proposé un nouveau réseau génératif : CM-GAN (cascaded modulation GAN), qui peut mieux synthétiser la structure globale et les détails locaux. CM-GAN comprend un encodeur avec des blocs de convolution de Fourier pour extraire des représentations de caractéristiques multi-échelles à partir d'images d'entrée avec des trous. Il existe également un décodeur à deux flux dans CM-GAN, qui définit un nouveau bloc de modulation spatiale globale en cascade à chaque couche d'échelle.

Dans chaque bloc de décodeur, nous appliquons d'abord une modulation globale pour effectuer une synthèse de structure grossière et sémantiquement consciente, puis effectuons une modulation spatiale pour ajuster davantage la carte des caractéristiques de manière spatialement adaptative. De plus, cette étude a conçu un programme de formation à la perception des objets pour éviter les artefacts dans la cavité afin de répondre aux besoins des tâches de suppression d'objets dans des scènes réelles. L'étude a mené des expériences approfondies pour montrer que CM-GAN surpasse considérablement les méthodes existantes en matière d'évaluations quantitatives et qualitatives.

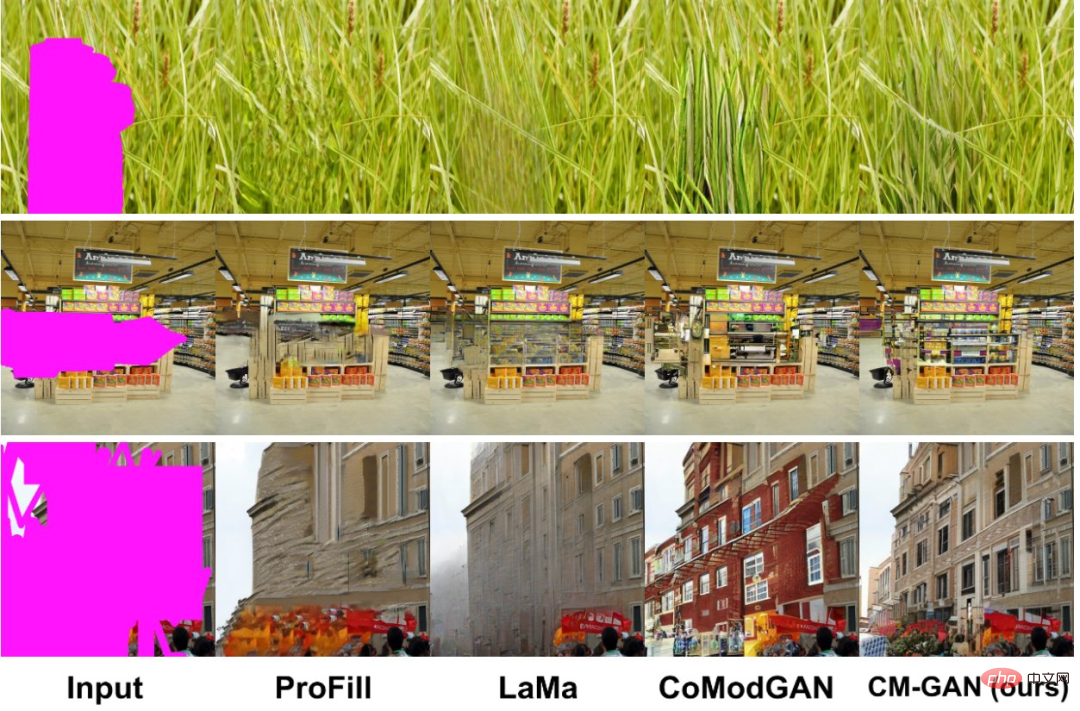

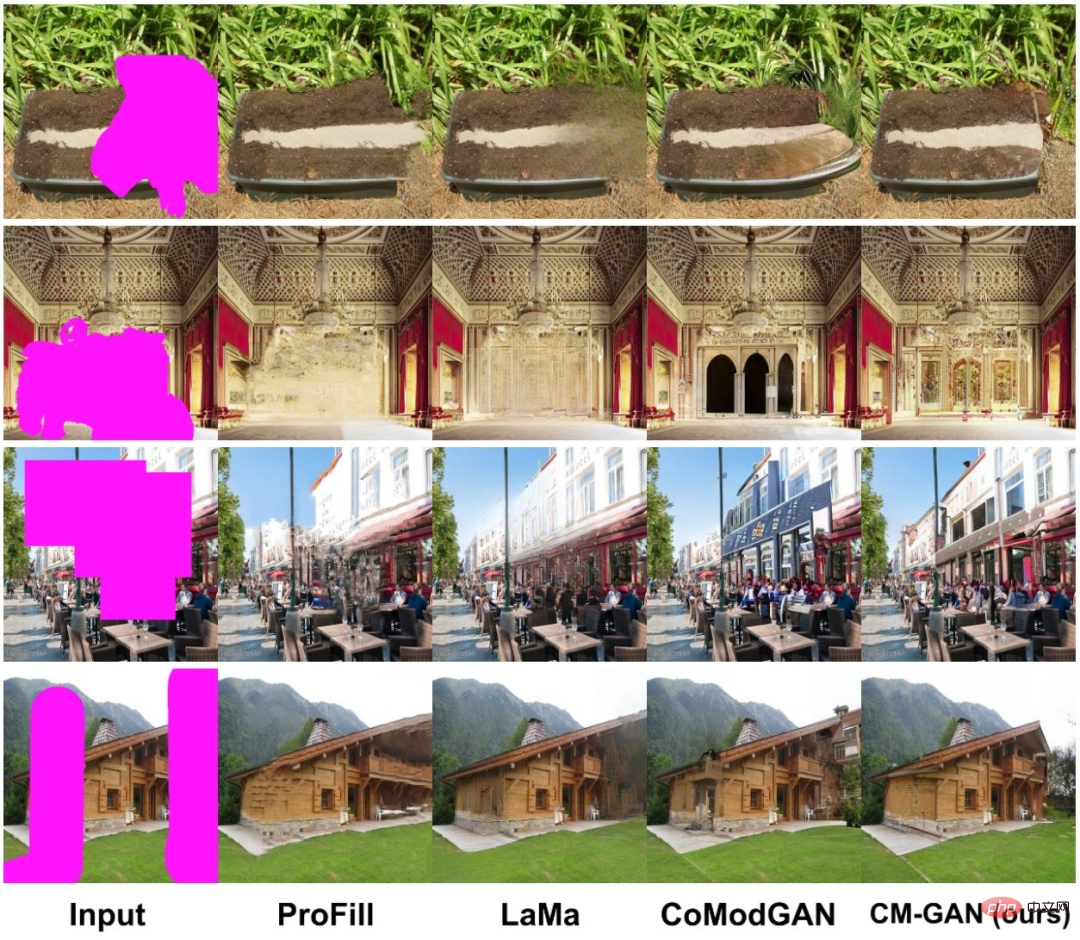

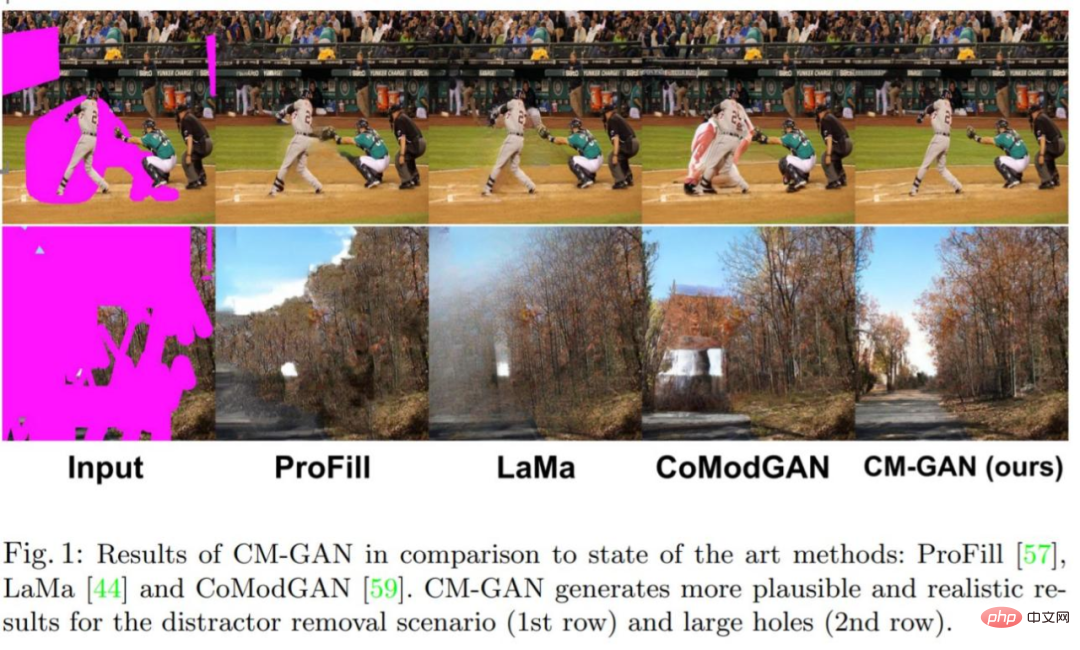

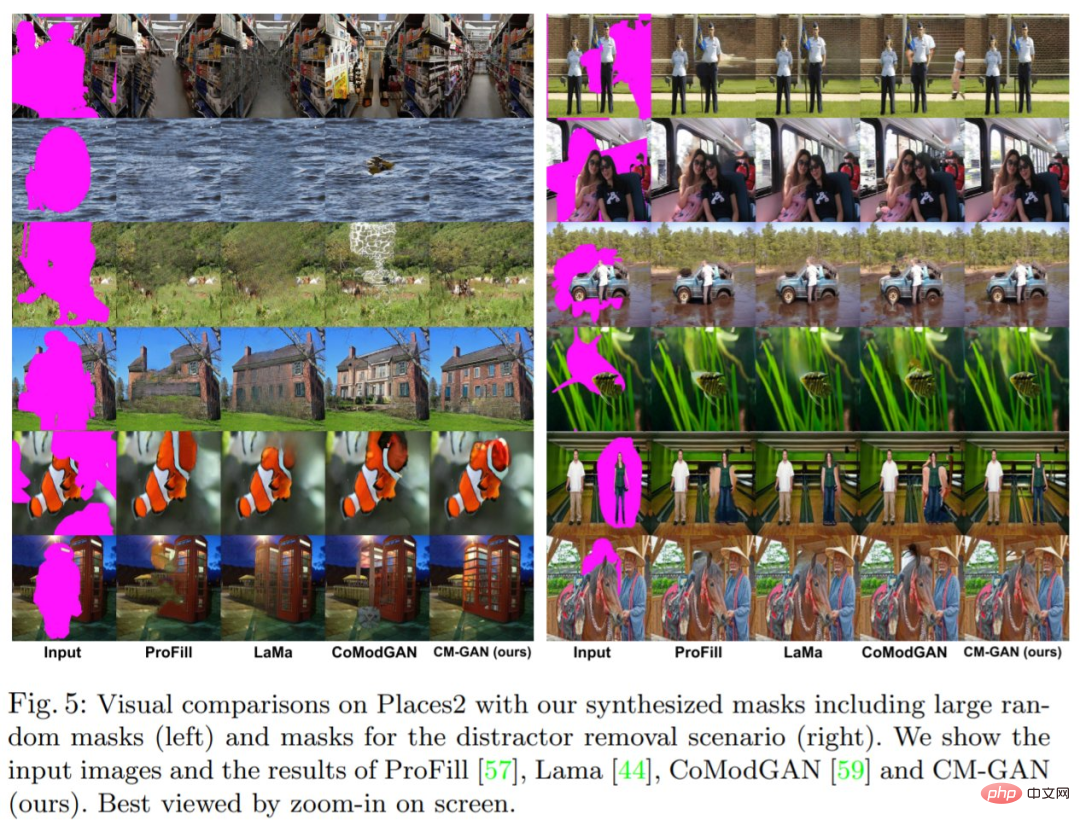

Regardons d'abord l'effet de réparation d'image. Par rapport à d'autres méthodes, CM-GAN peut reconstruire de meilleures textures :

CM-GAN peut synthétiser de meilleures structures globales :

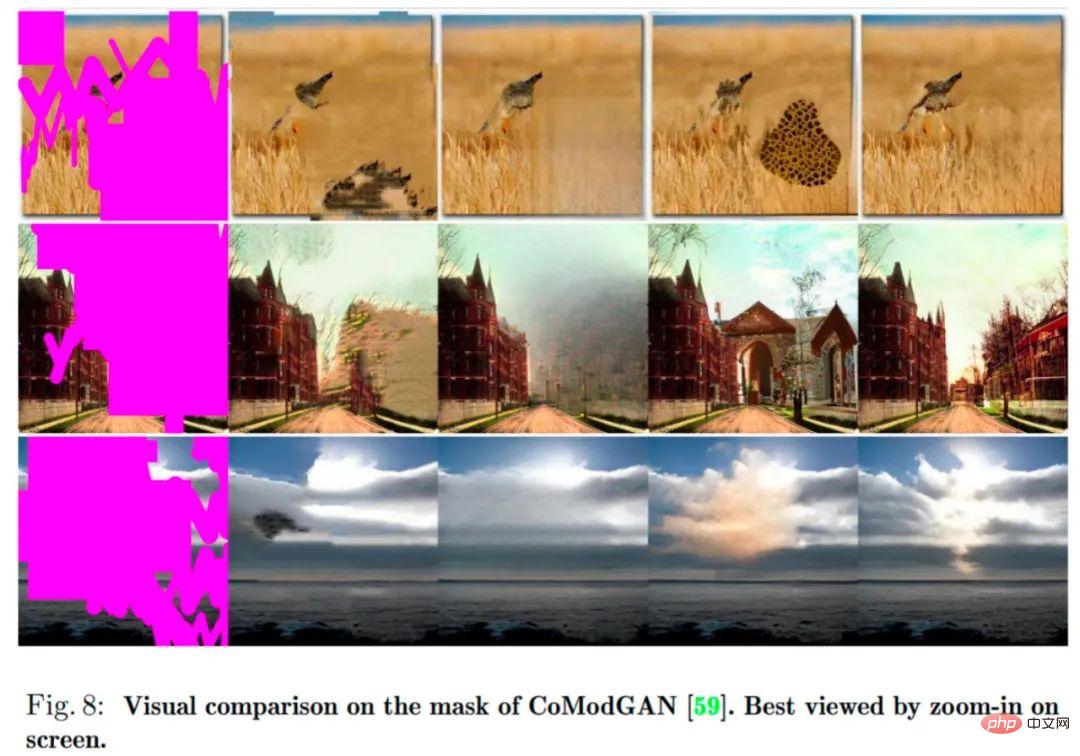

CM-GAN a de meilleures limites d'objets :

Jetons un coup d'œil à la méthode et aux résultats expérimentaux de cette étude.

Pour mieux modéliser le contexte global de complétion d'image, cette étude propose un nouveau mécanisme pour mettre en cascade la modulation de code globale avec la modulation de code spatial. Ce mécanisme permet de gérer des fonctionnalités partiellement invalides tout en mieux injectant un contexte global dans le domaine spatial. La nouvelle architecture CM-GAN peut bien synthétiser la structure globale et les détails locaux, comme le montre la figure 1 ci-dessous.

Comme le montre la figure 2 (à gauche) ci-dessous, CM-GAN est basé sur une branche d'encodeur et deux branches de décodeur en cascade parallèles pour générer une sortie visuelle. L'encodeur prend une partie de l'image et du masque en entrée et génère des cartes de caractéristiques multi-échelles  .

.

Contrairement à la plupart des méthodes d'encodeur-décodeur, afin de compléter la structure globale, cette étude extrait les codes de style globaux des fonctionnalités de plus haut niveau  de la couche entièrement connectée puis effectue

de la couche entièrement connectée puis effectue  la normalisation. De plus, un réseau de cartographie basé sur MLP génère des codes de style w à partir du bruit pour simuler le caractère aléatoire de la génération d'images. Les codes w sont combinés avec s pour produire un code global g = [s; w], qui est utilisé dans les étapes de décodage ultérieures.

la normalisation. De plus, un réseau de cartographie basé sur MLP génère des codes de style w à partir du bruit pour simuler le caractère aléatoire de la génération d'images. Les codes w sont combinés avec s pour produire un code global g = [s; w], qui est utilisé dans les étapes de décodage ultérieures.

Modulation globale en cascade spatiale. Pour mieux connecter le contexte global lors de l’étape de décodage, cette étude propose une modulation spatiale globale en cascade (CM). Comme le montre la figure 2 (à droite), l'étape de décodage est basée sur deux branches : le bloc de modulation global (GB) et le bloc de modulation spatiale (SB), et suréchantillonne les caractéristiques globales F_g et les caractéristiques locales F_s en parallèle.

Contrairement aux méthodes existantes, CM-GAN introduit une nouvelle méthode d'injection de contexte global dans les régions de trous. Au niveau conceptuel, il consiste en des modulations globales et spatiales en cascade entre les caractéristiques à chaque échelle et intègre naturellement trois mécanismes de compensation pour la modélisation du contexte global : 1) le suréchantillonnage des caractéristiques ; 2) la modulation globale ;

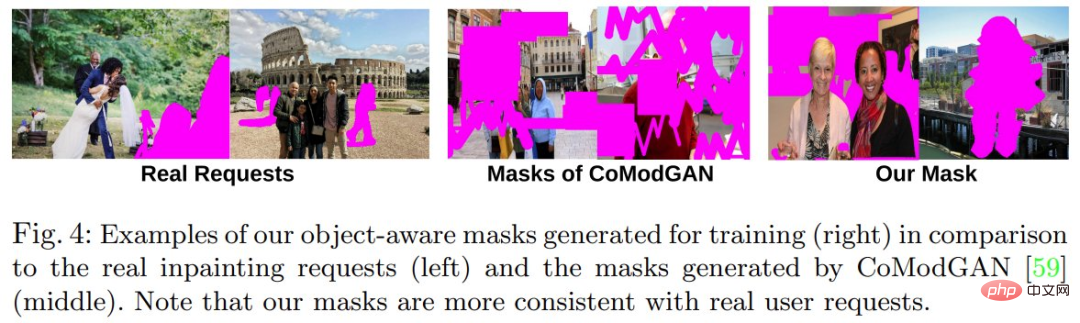

L'algorithme qui génère des masques pour l'entraînement est crucial. Essentiellement, le masque échantillonné doit être similaire au masque dessiné dans le cas d'utilisation réel, et le masque doit éviter de couvrir la totalité de l'objet ou de grandes parties de tout nouvel objet. Des schémas de masquage trop simplistes peuvent conduire à des artefacts.

Pour mieux prendre en charge les cas d'utilisation réels de suppression d'objets tout en empêchant le modèle de synthétiser de nouveaux objets dans les trous, cette étude propose un schéma de formation à la sensibilisation aux objets qui génère des masques plus réalistes pendant la formation, comme indiqué ci-dessous 4.

Plus précisément, l'étude transmet d'abord les images d'entraînement au réseau de segmentation panoramique PanopticFCN pour générer des annotations de segmentation très précises au niveau de l'instance, puis échantillonne un mélange de trous libres et de trous d'objets comme masque initial, et enfin calculer le taux de chevauchement entre le trou et chaque instance de l'image. Si le taux de chevauchement est supérieur au seuil, la méthode exclut l'instance de premier plan du trou ; sinon, le trou reste inchangé et l'objet simulé est complété avec le seuil défini sur 0,5. L'étude s'étend et traduit de manière aléatoire les masques d'objets pour éviter le surajustement. De plus, cette étude agrandit les trous sur les limites de segmentation des instances pour éviter les fuites de pixels d'arrière-plan à proximité des trous dans la région peinte.

Le modèle est entraîné avec une combinaison de perte contradictoire et de perte de perception basée sur la segmentation. Les expériences montrent que cette méthode peut également obtenir de bons résultats en utilisant uniquement des pertes adverses, mais l'ajout de pertes perceptuelles peut encore améliorer les performances.

De plus, cette étude propose une régularisation masquée-R_1 spécifiquement pour la formation contradictoire de tâches d'inpainting stables, où un masque m est utilisé pour éviter de calculer des pénalités de gradient en dehors du masque.

Cette étude a mené des expériences d'inpainting d'images sur l'ensemble de données Places2 à une résolution de 512 × 512 et a présenté les résultats d'évaluation quantitative et qualitative du modèle.

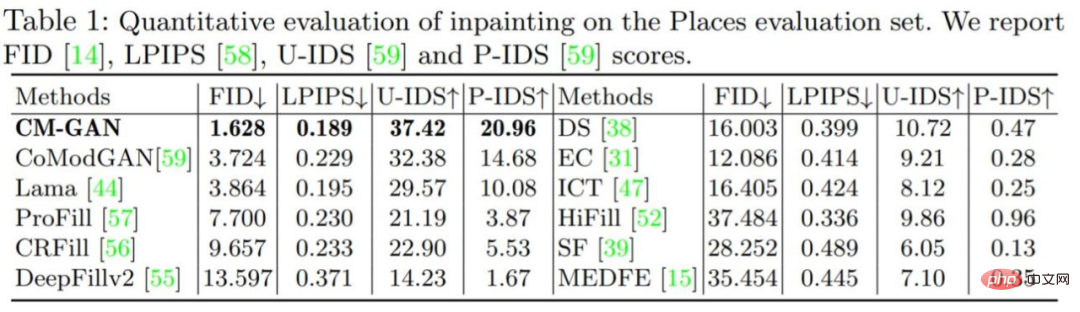

Évaluation quantitative : Le tableau 1 ci-dessous montre la comparaison entre CM-GAN et d'autres méthodes de masquage. Les résultats montrent que CM-GAN surpasse considérablement les autres méthodes en termes de FID, LPIPS, U-IDS et P-IDS. Avec l'aide de la perte de perception, LaMa, CM-GAN obtient des scores LPIPS nettement meilleurs que CoModGAN et d'autres méthodes, grâce aux conseils sémantiques supplémentaires fournis par le modèle perceptuel pré-entraîné. Par rapport à LaMa/CoModGAN, CM-GAN réduit le FID de 3,864/3,724 à 1,628.

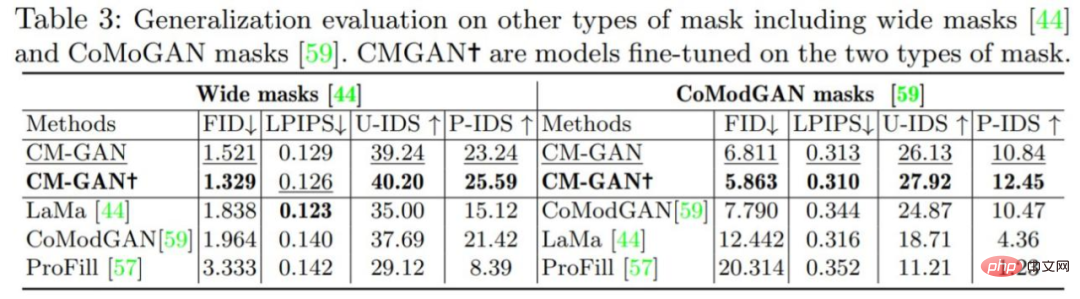

Comme le montre le tableau 3 ci-dessous, avec ou sans réglage fin, CM-GAN a obtenu des gains de performances nettement meilleurs que LaMa et CoModGAN sur les masques LaMa et CoModGAN, indiquant que le modèle a une capacité de généralisation. Il convient de noter que les performances du CM-GAN formé sur le masque CoModGAN, masque sensible aux objets, sont toujours meilleures que celles du masque CoModGAN, confirmant que CM-GAN a une meilleure capacité de génération.

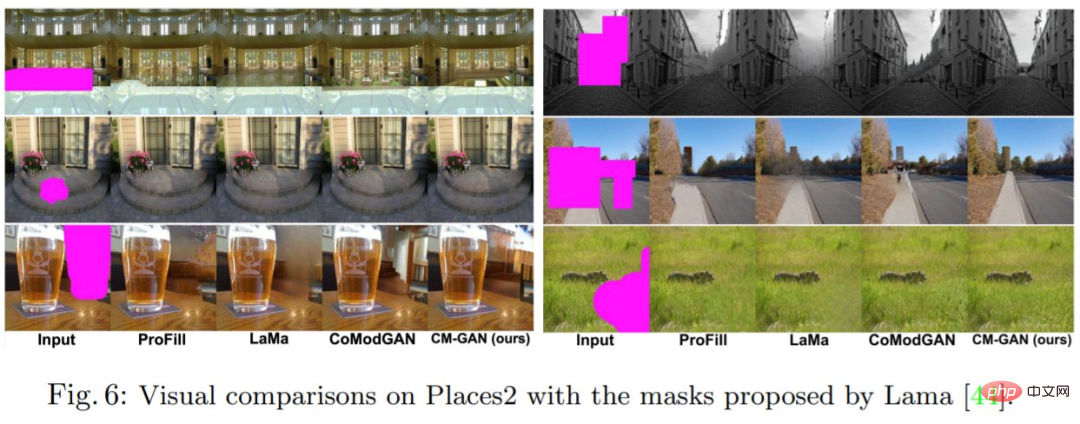

Évaluation qualitative : Figure 5, Figure 6, Figure 8 montrent les résultats de la comparaison visuelle des méthodes CM-GAN et SOTA en termes de masques synthétiques. ProFill est capable de générer des structures globales incohérentes, CoModGAN produit des artefacts structurels et des taches de couleur, et LaMa est sujet à un flou d'image important sur les scènes naturelles. En revanche, la méthode CM-GAN produit une structure sémantique plus cohérente, une texture plus claire et peut être appliquée à différents scénarios.

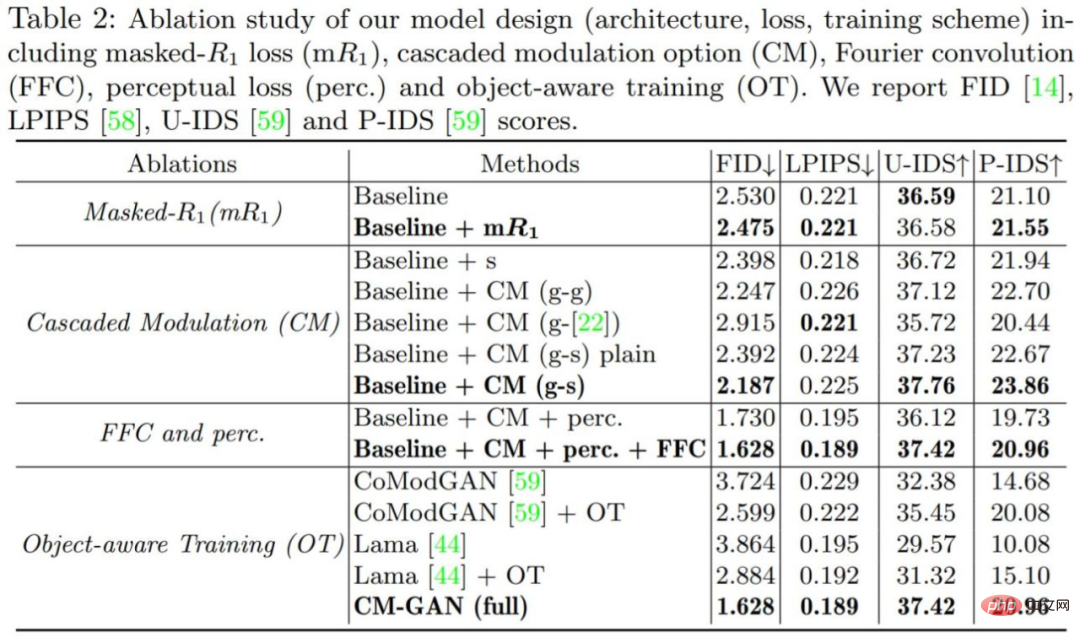

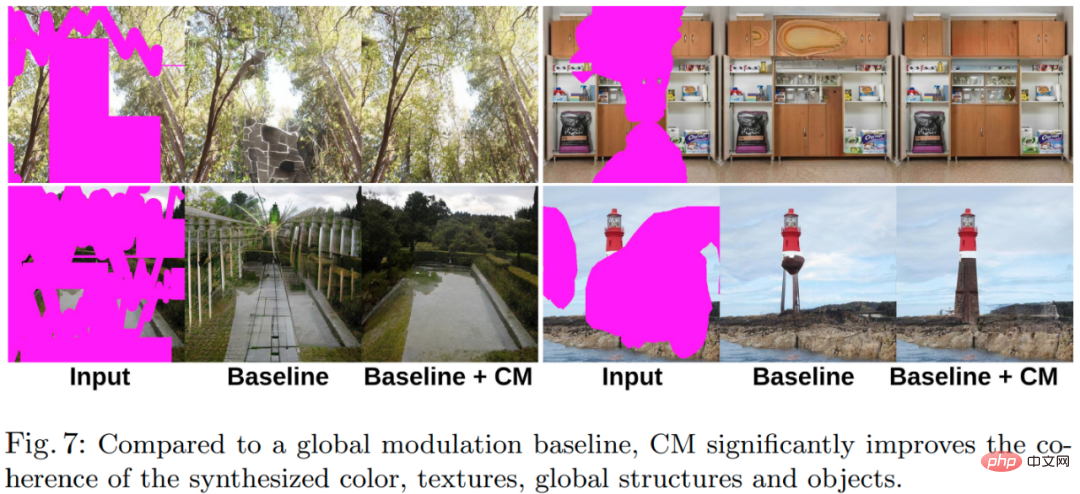

Pour vérifier l'importance de chaque composant du modèle, l'étude a mené un ensemble d'expériences d'ablation, et tous les modèles ont été formés sur l'ensemble de données Places2 et évalués. . Les résultats de l'expérience d'ablation sont présentés dans le tableau 2 et la figure 7 ci-dessous.

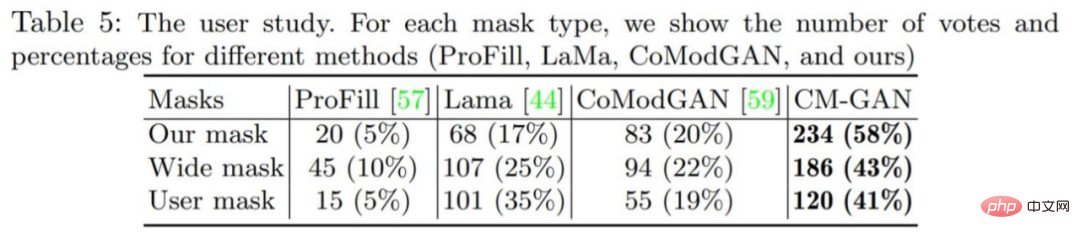

L'étude a également mené une étude utilisateur pour mieux évaluer la qualité de génération visuelle de la méthode CM-GAN, et les résultats sont présentés dans le tableau 5 ci-dessous. De plus, l'annexe fournit davantage de comparaisons visuelles et d'analyses expérimentales pour référence du lecteur.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!