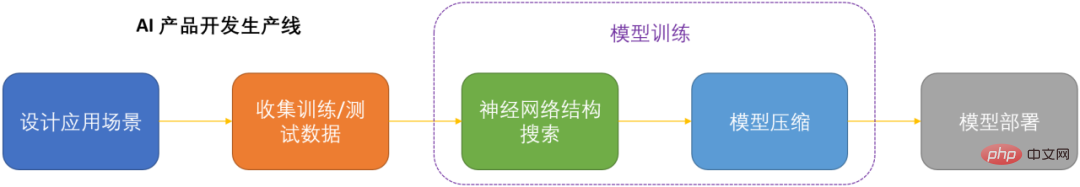

OTO est le premier cadre de formation et de compression de structure de réseaux neuronaux automatisé, unique, convivial et polyvalent du secteur.

À l'ère de l'intelligence artificielle, la manière de déployer et de maintenir les réseaux de neurones est une question clé pour la production. Compte tenu de la réduction des coûts de calcul tout en minimisant la perte de performances des modèles, la compression des réseaux de neurones est devenue l'une des clés de la production des DNN.

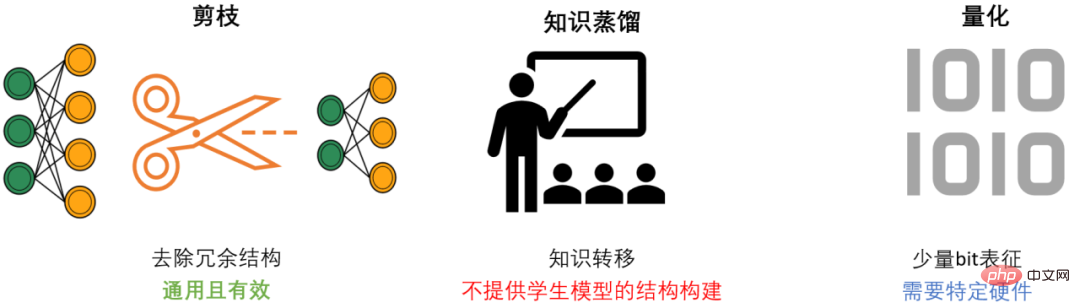

La compression DNN comporte généralement trois méthodes : l'élagage, la distillation des connaissances et la quantification. L'élagage vise à identifier et supprimer les structures redondantes, à affiner le DNN tout en conservant autant que possible les performances du modèle. Il s'agit de la méthode de compression la plus polyvalente et la plus efficace. De manière générale, les trois méthodes peuvent se compléter et fonctionner ensemble pour obtenir le meilleur effet de compression.

Cependant, la plupart des méthodes d'élagage existantes ne ciblent que des modèles et des tâches spécifiques, et nécessitent de solides connaissances professionnelles dans le domaine. Par conséquent, les développeurs d'IA doivent généralement consacrer beaucoup d'efforts pour appliquer ces méthodes à leurs propres scénarios. Cela consomme beaucoup de coûts humains et matériels.

Afin de résoudre les problèmes des méthodes d'élagage existantes et de faciliter la tâche des développeurs d'IA, l'équipe Microsoft a proposé le framework OTO Only-Train-Once. OTO est le premier cadre de formation et de compression de structure de réseaux neuronaux automatisé, unique, convivial et universel du secteur. Une série de travaux a été publiée dans ICLR2023 et NeurIPS2021.

En utilisant OTO, les ingénieurs en IA peuvent facilement entraîner des réseaux neuronaux cibles et obtenir des modèles légers et performants en un seul arrêt. OTO minimise l'investissement du développeur en temps et en efforts d'ingénierie, et ne nécessite pas de pré-formation fastidieuse ni de réglage supplémentaire du modèle que nécessitent généralement les méthodes existantes.

L'algorithme d'élagage structurel idéalisé devrait être : une solution automatisée unique pour les réseaux de neurones généraux. Facilement s'entraîner à partir de zéro tout en obtenant un modèle performant et léger sans avoir besoin de réglages ultérieurs. Mais en raison de la complexité des réseaux neuronaux, atteindre cet objectif est extrêmement difficile. Afin d'atteindre cet objectif ultime, les trois questions fondamentales suivantes doivent être systématiquement résolues :

L'équipe Microsoft a conçu et mis en œuvre trois ensembles d'algorithmes de base, résolvant systématiquement et complètement ces trois problèmes fondamentaux pour la première fois.

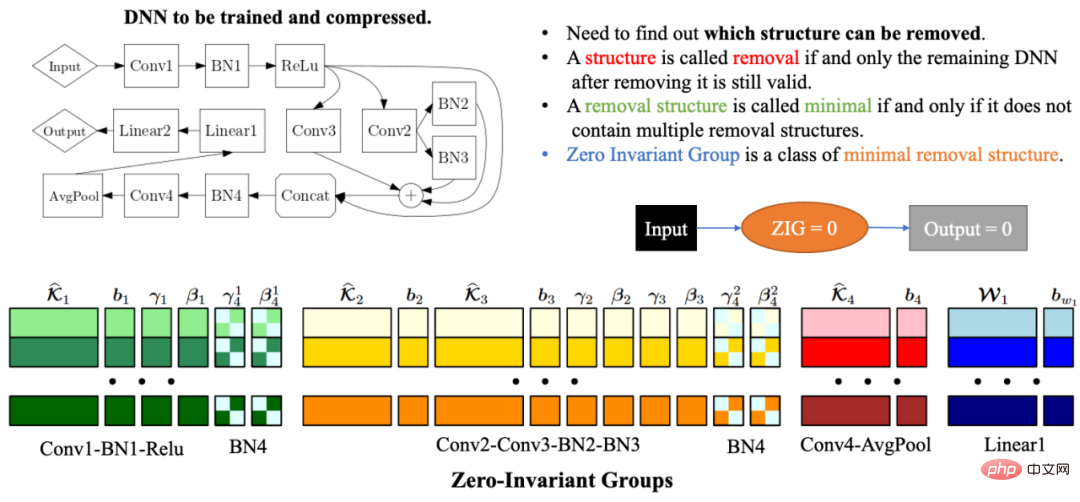

Groupes automatisés à zéro invariant

En raison de la complexité et de la corrélation de la structure du réseau, la suppression de toute structure de réseau peut rendre la structure de réseau restante invalide. Par conséquent, l’un des plus gros problèmes de la compression automatisée de la structure du réseau est de savoir comment trouver les paramètres du modèle qui doivent être élagués ensemble pour que le réseau restant soit toujours valide. Pour résoudre ce problème, l'équipe Microsoft a proposé des groupes zéro-invariant (ZIG) dans OTOv1. Le groupe invariant zéro peut être compris comme un type de plus petite unité amovible, de sorte que le réseau restant est toujours valide après la suppression de la structure de réseau correspondante du groupe. Une autre grande propriété d'un groupe invariant zéro est que si un groupe invariant zéro est égal à zéro, alors quelle que soit la valeur d'entrée, la valeur de sortie est toujours nulle. Dans OTOv2, les chercheurs ont en outre proposé et mis en œuvre un ensemble d’algorithmes automatisés pour résoudre le problème de regroupement de groupes invariants nuls dans les réseaux généraux. L'algorithme de regroupement automatisé est une combinaison soigneusement conçue d'une série d'algorithmes graphiques. L'ensemble de l'algorithme est très efficace et présente une complexité temporelle et spatiale linéaire.

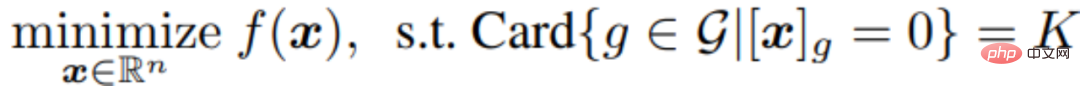

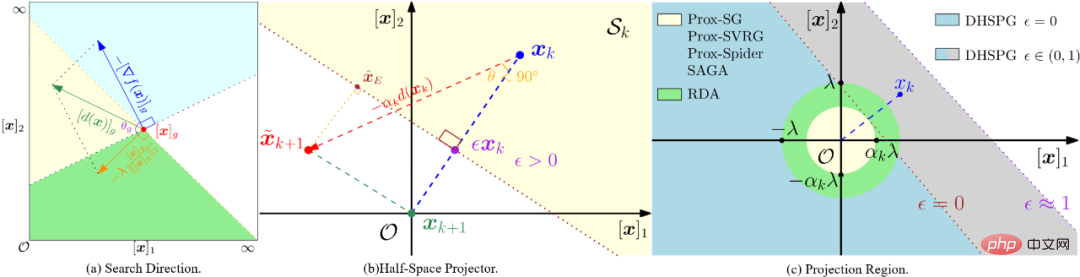

Algorithme d'optimisation de gradient projeté à double demi-plan (DHSPG)

Après avoir divisé tous les groupes zéro-invariants du réseau cible, les prochaines tâches de formation et d'élagage du modèle doivent déterminer quels groupes zéro-invariants sont redondants .Le reste, lesquels sont importants. La structure de réseau correspondant aux groupes redondants invariants zéro doit être supprimée et les groupes importants invariants zéro doivent être conservés pour garantir les performances du modèle de compression. Les chercheurs ont formulé ce problème comme un problème de sparsification structurelle et ont proposé un nouvel algorithme d’optimisation DHSPG (Dual Half-Space Projected Gradient) pour le résoudre.

DHSPG peut très efficacement trouver des groupes redondants invariants zéro et les projeter à zéro, et former en continu d'importants groupes invariants zéro pour obtenir des performances comparables au modèle d'origine.

Par rapport aux algorithmes d'optimisation clairsemés traditionnels, DHSPG dispose de capacités d'exploration de structures clairsemées plus fortes et plus stables, et étend l'espace de recherche de formation, de sorte qu'il obtient généralement des résultats de performances réelles plus élevés.

Construire automatiquement un modèle de compression léger

En utilisant DHSPG pour entraîner le modèle, nous obtiendrons une solution qui obéit à la grande parcimonie structurelle du groupe zéro invariant, c'est-à-dire qu'il y en a beaucoup dans la solution qui sont projetés dans un ensemble de zéros invariants par zéro, et cette solution aura également des performances de modèle élevées. Ensuite, les chercheurs ont supprimé toutes les structures correspondant aux groupes redondants invariants de zéro pour construire automatiquement un réseau de compression. En raison des caractéristiques des groupes invariants zéro, c'est-à-dire que si un groupe invariant zéro est égal à zéro, alors quelle que soit la valeur d'entrée, la valeur de sortie sera toujours nulle, donc la suppression des groupes redondants invariants zéro ne sera pas avoir un impact sur le réseau. Par conséquent, le réseau compressé obtenu via OTO aura le même résultat que le réseau complet, sans qu’il soit nécessaire d’affiner davantage le modèle requis par les méthodes traditionnelles.

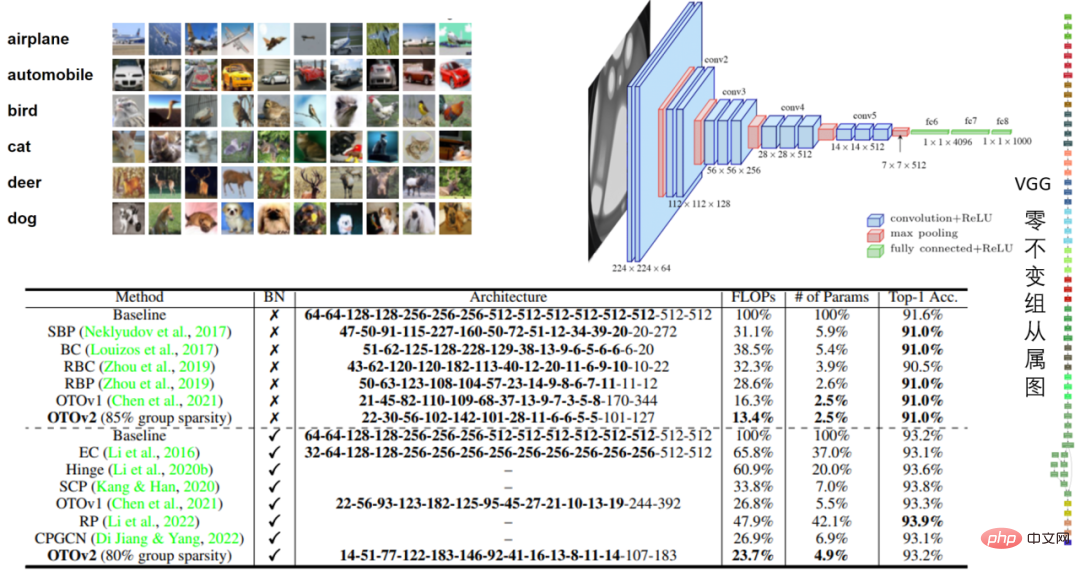

De nombreuses expériences 任 Modèles VGG16 et VGG16-BN dans CIFAR10 et modèles VGG16-BN dans CIFAR10 Dans l'expérience VGG16 de CIFAR10, le volume a été réduit de 97,5% et les performances étaient impressionnantes.

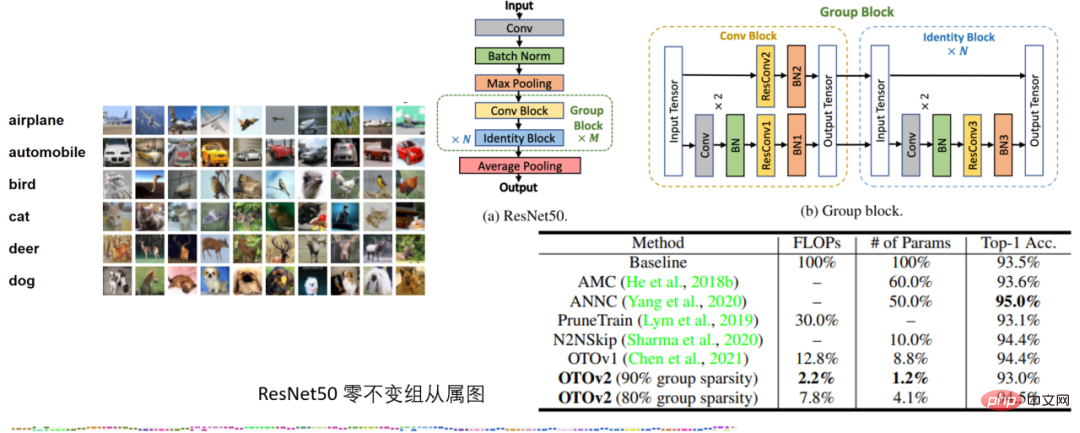

Tableau 2 : Expérience ResNet50 sur CIFAR10

Tableau 2 : Expérience ResNet50 sur CIFAR10

Dans l'expérience ResNet50 sur CIFAR10, OTO surpasse les frameworks de compression de réseau neuronal SOTA AMC et ANNC sans quantification, en utilisant seulement 7,8 % des FLOP et 4,1 % des paramètres.

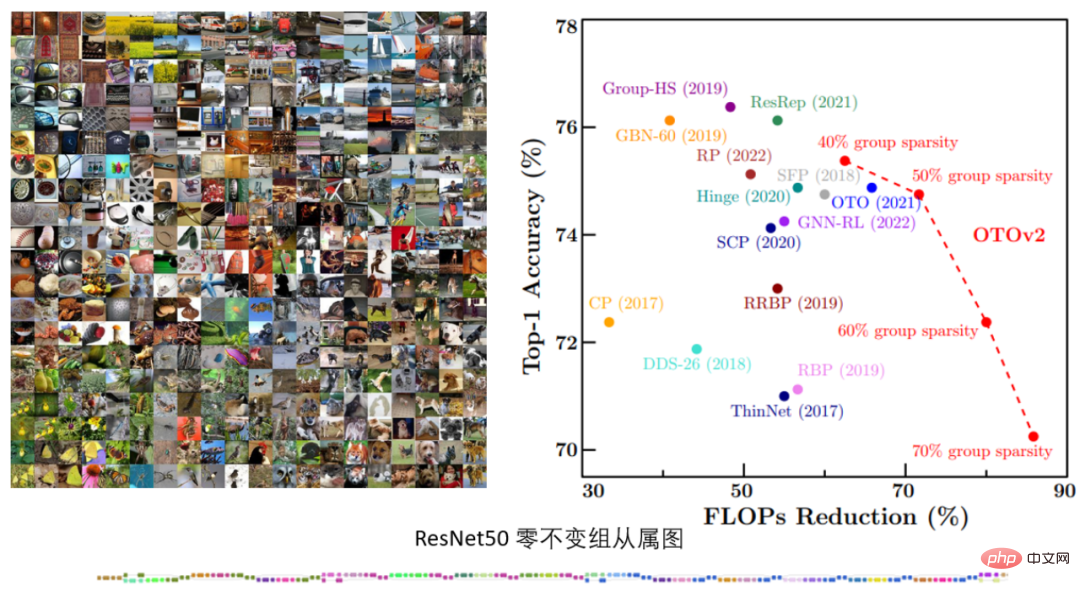

Tableau 3. Expérience ResNet50 d'ImageNet

Tableau 3. Expérience ResNet50 d'ImageNet

Dans l'expérience ResNet50 d'ImageNet, OTOv2 a montré des performances comparables, voire meilleures, que la méthode SOTA existante sous différentes cibles de sparsification structurelle.

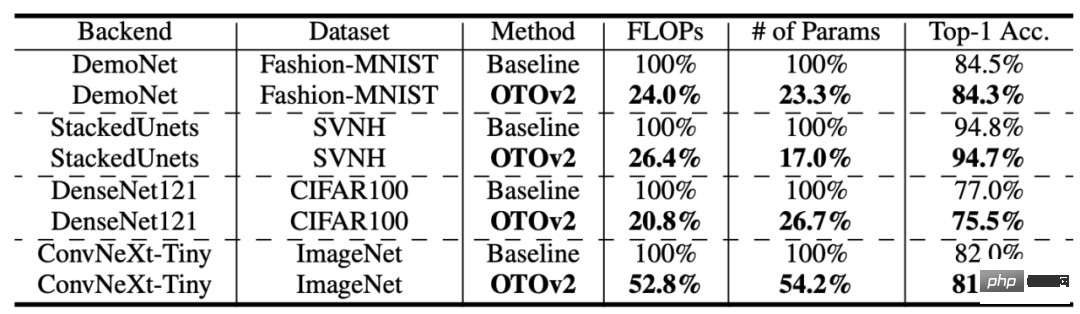

Tableau 4 : Plus de structures et d'ensembles de données

Tableau 4 : Plus de structures et d'ensembles de données

OTO obtient également de bonnes performances sur davantage d'ensembles de données et de structures de modèles.

Tâche de vision de bas niveau

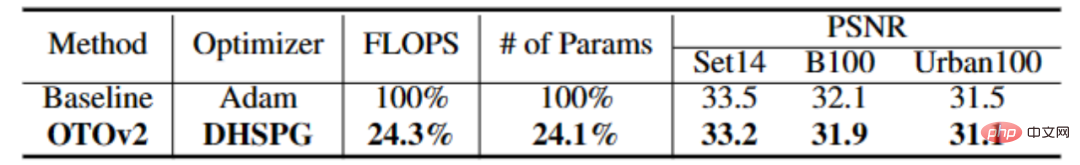

Tableau 4 : Expérience CARNx2

Dans la tâche de super-résolution, la formation à guichet unique OTO a compressé le réseau CARNx2 et a obtenu un résultat compétitif par rapport au modèle original performances et compressé la charge de travail de calcul et la taille du modèle de plus de 75 %.Tâche de modèle de langage

De plus, les chercheurs ont également mené des expériences comparatives sur Bert sur l'un des algorithmes de base, l'algorithme d'optimisation DHSPG, et ont vérifié ses hautes performances par rapport à d'autres algorithmes d'optimisation clairsemés. On peut constater que sur Squad, la réduction des paramètres et les performances du modèle obtenues en utilisant DHSPG pour la formation sont de loin supérieures à d'autres algorithmes d'optimisation clairsemés.

ConclusionL'équipe Microsoft a proposé un cadre automatisé d'élagage de structure de formation de réseau neuronal à guichet unique appelé OTO (Only-Train-Once). Il peut automatiquement compresser un réseau neuronal complet en un réseau léger tout en conservant des performances élevées. OTO simplifie considérablement le processus complexe en plusieurs étapes des méthodes d'élagage structurel existantes, convient à diverses architectures et applications de réseau et minimise l'investissement d'ingénierie supplémentaire des utilisateurs. Il est polyvalent, efficace et facile à utiliser.Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Solution à l'échec de la connexion entre wsus et le serveur Microsoft

Solution à l'échec de la connexion entre wsus et le serveur Microsoft

qu'est-ce que l'USDT

qu'est-ce que l'USDT

Win10 suspend les mises à jour

Win10 suspend les mises à jour

Site officiel d'OuYi Exchange

Site officiel d'OuYi Exchange

Langages informatiques

Langages informatiques

Quels sont les outils de classement des mots clés SEO ?

Quels sont les outils de classement des mots clés SEO ?

Que sont les frameworks d'intelligence artificielle Python ?

Que sont les frameworks d'intelligence artificielle Python ?

Quels téléphones mobiles le système d'exploitation Hongmeng prend-il en charge ?

Quels téléphones mobiles le système d'exploitation Hongmeng prend-il en charge ?