Après Alpaca, Stanford, en collaboration avec des universitaires de la CMU, de l'UC Berkeley et d'autres institutions, a de nouveau publié le modèle de 13 milliards de paramètres Vicuna, qui peut atteindre 90 % des performances de ChatGPT pour seulement 300 $.

Après que le modèle LLaMA de Meta soit devenu open source, les chercheurs de l'industrie de l'IA ont dérivé de nombreuses versions basées sur ce modèle.

Il y a quelque temps, Stanford a publié Alpaca, qui est affiné à partir du LLaMA 7B de Meta. Il n'utilise que 52 000 données et ses performances peuvent rivaliser avec GPT-3.5.

Aujourd'hui, des universitaires de Stanford se sont associés à la CMU, à l'UC Berkeley, etc. pour lancer à nouveau un nouveau modèle : la vigogne à 13 milliards de paramètres, communément appelée « petit alpaga » (lama).

Vicuna est formée en affinant LLaMA sur les conversations partagées des utilisateurs collectées par ShareGPT, et le coût de la formation est de près de 300 $ US.

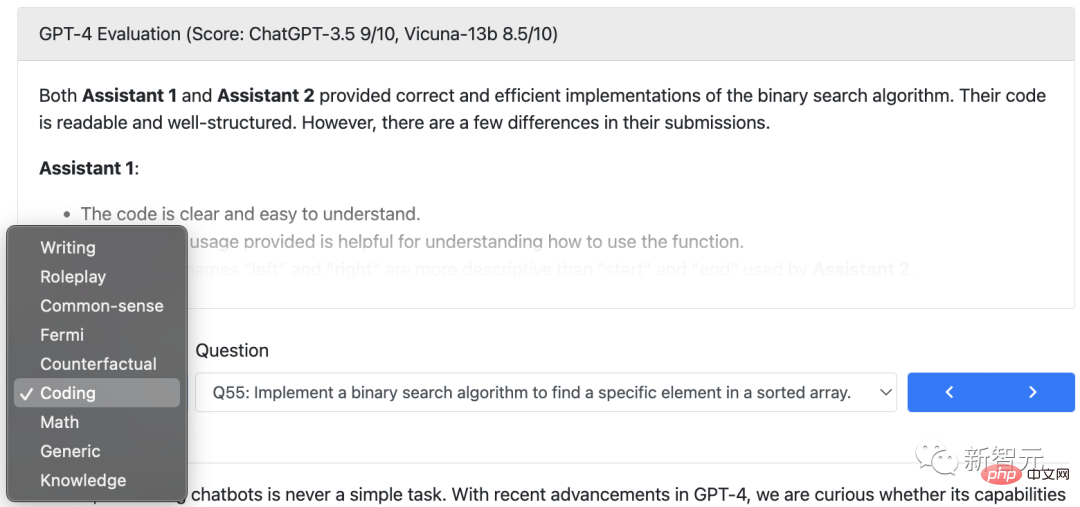

Les chercheurs ont conçu 8 catégories de questions, notamment les mathématiques, l'écriture et le codage, et ont effectué des tests de performance sur le Vicuna-13B et quatre autres modèles.

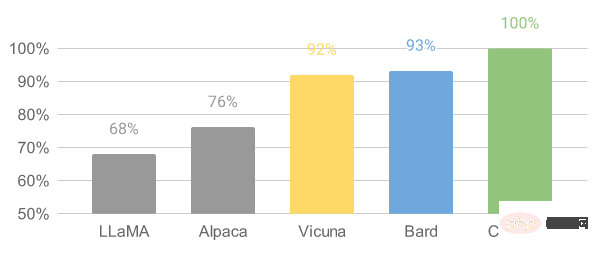

Le processus de test utilise GPT-4 comme norme d'évaluation, et les résultats montrent que Vicuna-13B atteint des capacités comparables à ChatGPT et Bard dans plus de 90 % des cas.

En même temps, il surpasse d'autres modèles tels que LLaMA et Stanford's Alpaca dans plus de 90% des cas.

Les membres de l'équipe viennent de l'UC Berkeley, de l'Université Carnegie Mellon, de l'Université Stanford, de l'UC San Diego et de l'Université Bin Zayed pour l'intelligence artificielle.

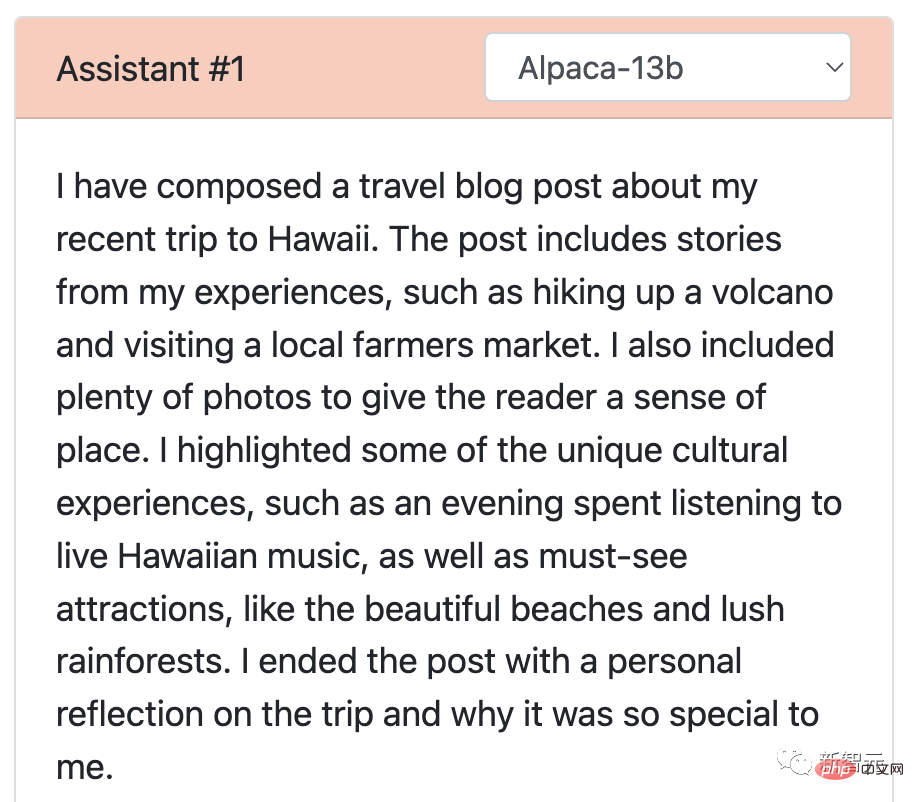

Les chercheurs ont demandé à l'alpaga et à la vigogne de Stanford d'organiser un grand concours et ont démontré respectivement les réponses aux questions de référence.

Après avoir affiné Vicuna à l'aide des données de conversation ChatGPT partagées par 70 000 utilisateurs, l'étude a révélé que Vicuna est capable de générer des réponses plus détaillées et mieux structurées qu'Alpaga.

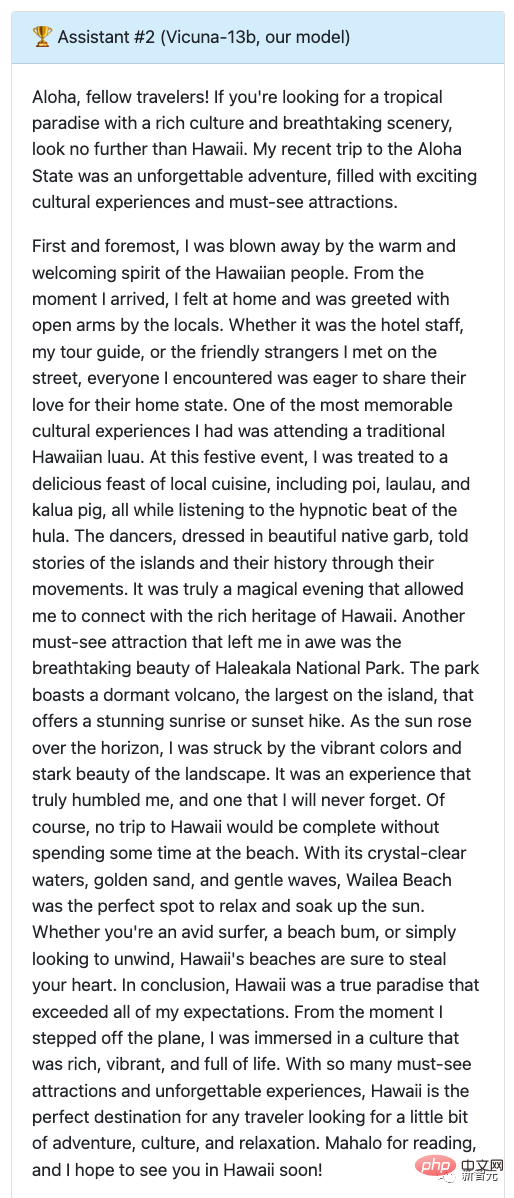

Q : Écrivez un article de blog de voyage amusant sur un récent voyage à Hawaï, en mettant l'accent sur les expériences culturelles et les attractions incontournables.

La réponse d'Alpaca peut être considérée comme une version condensée. Elle a été écrite en quelques lignes seulement et n'a pas accompli la tâche comme requis. Il mentionnait simplement qu'il avait écrit un blog et donnait un aperçu du contenu du blog.

Revenez à Vicuna, qui a écrit un article de blog de voyage détaillé et engageant qui est non seulement intéressant mais détaille également les expériences culturelles et les attractions incontournables d'Hawaï.

À partir de là, laissez GPT-4 donner le score, Alpaga obtient 7 points et Vicuna obtient la note maximale.

Alors, comment Vicuna s'est-elle comportée contre ChatGPT ?

Les deux ont marqué 9 points !

Comme vous pouvez le constater, l'article sur ces deux modèles proposant un voyage à Hawaï est non seulement engageant mais aussi rédigé avec fluidité.

De plus, le niveau de détail et de précision des deux réponses est exceptionnel, et les deux modèles transmettent efficacement l'excitation et la beauté d'un voyage à Hawaï.

De plus, les chercheurs ont également testé Vicuna avec LLaMA et le modèle Bard de Google. Les résultats du test ont montré que LLaMA a obtenu les pires résultats (1 point) et n'a eu presque aucune réponse.

L'exactitude et la pertinence des réponses de Bard sont également relativement élevées, avec un score de 9, mais en termes de réponses plus attractives, elles sont légèrement inférieures à celles de Vicuna.

En plus de l'écriture, les chercheurs ont comparé les capacités du modèle Vicuna avec les quatre autres modèles en codage, mathématiques, jeux de rôle, culture générale, etc., avec un total de 80 questions.

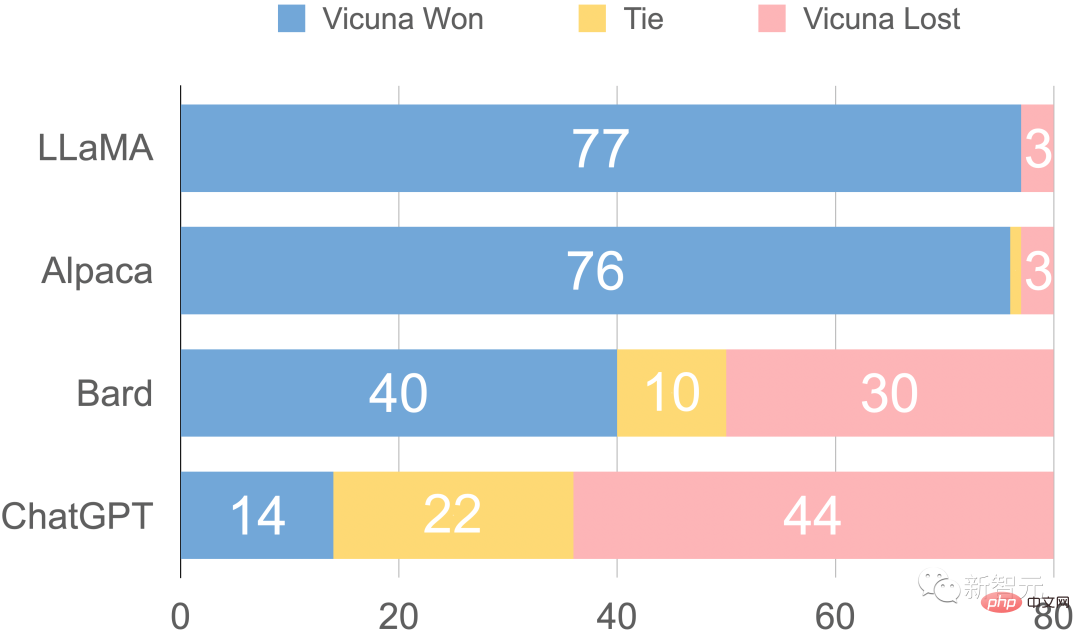

Enfin, le résumé de l'évaluation préliminaire du chercheur basé sur GPT-4 est présenté dans la figure. On peut voir que Vicuna a atteint plus de 90 % des capacités de Bard/ChatGPT.

Qualité de réponse relative évaluée par GPT-4

Fait intéressant, dans cette démo Vicuna, l'équipe a également rejoint l'essai d'Alpaca et de LLaMA, et la première vient d'être arrêtée.

Adresse de démonstration : https://chat.lmsys.org/

L'émergence de ChatGPT excite les gens, mais le fait qu'OpenAI ne soit pas ouvert rend les gens de l'industrie vraiment contrariés.

Exactement, le modèle LLaMA de Meta est open source, offrant à de nombreux chercheurs la possibilité de développer leurs propres modèles.

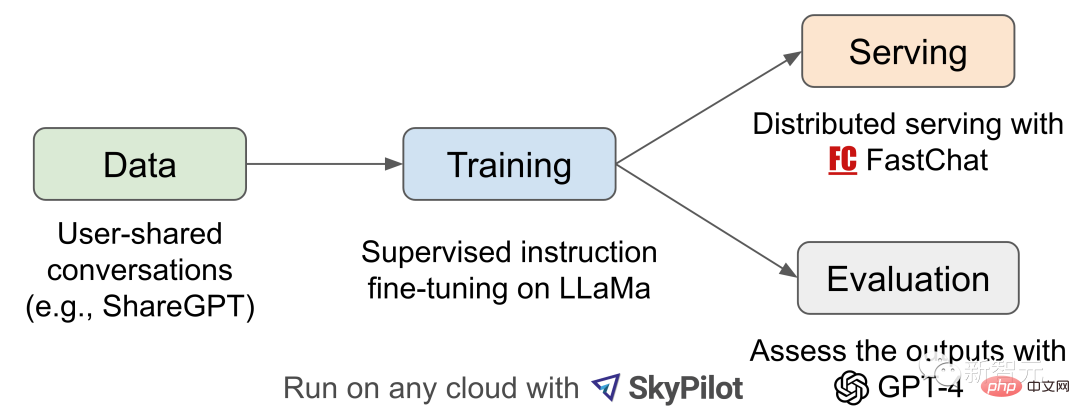

La naissance de Vicuna-13B a été inspirée par les projets LLaMA et Stanford Alpaca. Il s'agit d'un chatbot open source basé sur des ensembles de données augmentés et une infrastructure évolutive facile à utiliser.

Les données d'entraînement de ce modèle proviennent des conversations partagées par les utilisateurs collectées par ShareGPT, puis les chercheurs ont affiné le modèle de base LLaMA, et Vicuna-13B est né.

Vicuna-13B démontre des performances comparables à d'autres modèles open source tels que Stanford Alpaca.

Les chercheurs ont mené une évaluation préliminaire des performances du Vicuna-13B et ont décrit son infrastructure de formation et de maintenance.

Parallèlement, ce modèle de démonstration a été lancé, et tous les chercheurs peuvent participer à des interactions de démonstration en ligne pour tester les capacités de ce chatbot.

Aperçu du flux de travail

Pour le processus de formation Vicuna-13B, les détails sont les suivants :

Tout d'abord, les chercheurs ont collecté environ 70 000 conversations sur le site Web de partage de conversations ChatGPT ShareGPT.

Ensuite, les chercheurs ont optimisé le script de formation fourni par Alpaca afin que le modèle puisse mieux gérer plusieurs cycles de dialogue et de longues séquences. Ensuite, PyTorch FSDP a été utilisé pour une journée de formation sur 8 GPU A100.

En termes d'évaluation de la qualité du modèle, les chercheurs ont créé 80 questions différentes et évalué les résultats du modèle à l'aide de GPT-4.

Pour comparer différents modèles, les chercheurs ont combiné les résultats de chaque modèle en une seule invite, puis ont laissé GPT-4 évaluer quel modèle donnait la meilleure réponse.

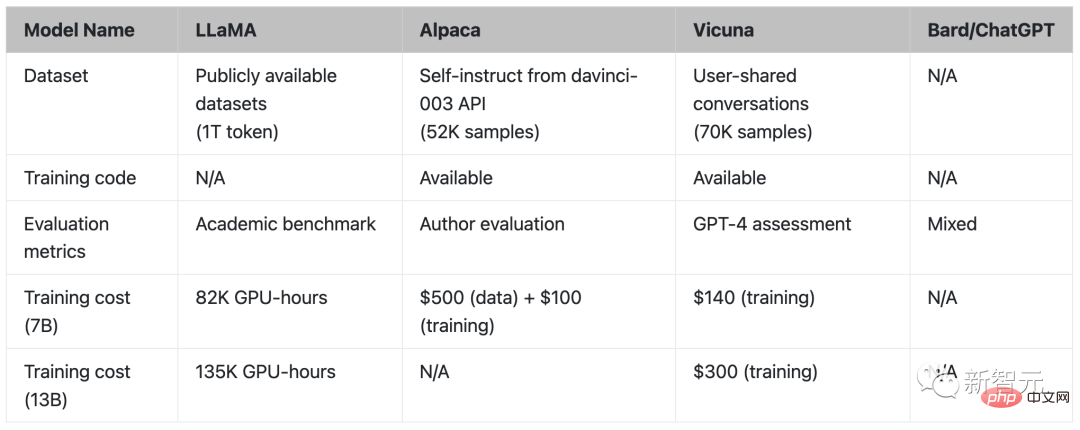

Comparaison de LLaMA, Alpaca, Vicuna et ChatGPT

Training

Vicuna a été créée en affinant à l'aide d'environ 70 000 données de conversation partagées par les utilisateurs collectées à partir de l'API publique ShareGPT.

Pour garantir la qualité des données, les chercheurs ont reconverti le HTML en markdown et filtré certains échantillons inappropriés ou de moindre qualité.

De plus, les chercheurs ont divisé les conversations plus longues en segments plus petits pour s'adapter à la longueur maximale du contexte du modèle.

La méthode d'entraînement de Vicuna est basée sur l'Alpaga de Stanford avec les améliorations suivantes :

Pour permettre à Vicuna de comprendre les contextes longs, la longueur maximale du contexte est étendue de 512 à 2048 pour Alpaca, ce qui augmente considérablement le GPU. besoins en mémoire. Ici, les chercheurs abordent la pression de la mémoire en utilisant des points de contrôle de gradient et une attention flash.

en ajustant la perte d'entraînement pour tenir compte de plusieurs cycles de conversation et en calculant la perte de réglage précis uniquement sur la sortie du chatbot.

40 fois l'ensemble de données et 4 fois la longueur de la séquence posent des défis considérables à la formation. Les chercheurs ont utilisé des instances Spot hébergées par SkyPilot pour réduire les coûts en tirant parti de la préemption de récupération automatique et du changement automatique de zone.

Cette solution réduit le coût de formation du modèle 7B de 500 $ à environ 140 $, et le coût de formation du modèle 13B d'environ 1 000 $ à 300 $.

Évaluation

Évaluer les chatbots IA est une tâche difficile car elle nécessite de vérifier la compréhension du langage, le raisonnement et la conscience du contexte. À mesure que les chatbots IA deviennent plus avancés, les benchmarks ouverts existants pourraient ne plus suffire.

Par exemple, les chatbots SOTA peuvent répondre efficacement à l'auto-instruction de l'ensemble de données d'évaluation utilisé dans Stanford Alpaca, ce qui rend difficile pour les humains de faire la différence de performances. D'autres limitations incluent la contamination des données de formation/test et le coût potentiellement élevé de la création de nouveaux tests de référence.

Pour résoudre ces problèmes, les chercheurs ont proposé un cadre d'évaluation basé sur GPT-4 pour réaliser une évaluation automatique des performances du chatbot.

Premièrement, GPT-4 est capable de générer des questions diverses et stimulantes grâce à des invites soigneusement conçues. Au total, 80 questions réparties dans 8 catégories différentes, telles que les jeux de rôle, les tâches de codage/mathématiques, etc., ont été utilisées pour tester les performances de ces modèles (LLaMA, Alpaca, ChatGPT, Bard et Vicuna) dans différents domaines.

Les chercheurs ont ensuite demandé à GPT-4 d'évaluer la qualité des réponses en fonction de leur utilité, de leur pertinence, de leur exactitude et de leurs détails. Les résultats montrent que GPT-4 peut non seulement produire des scores relativement cohérents, mais également fournir des explications détaillées sur les raisons pour lesquelles il attribue ce score. Cependant, GPT-4 n’est pas efficace pour juger les tâches de codage/mathématiques.

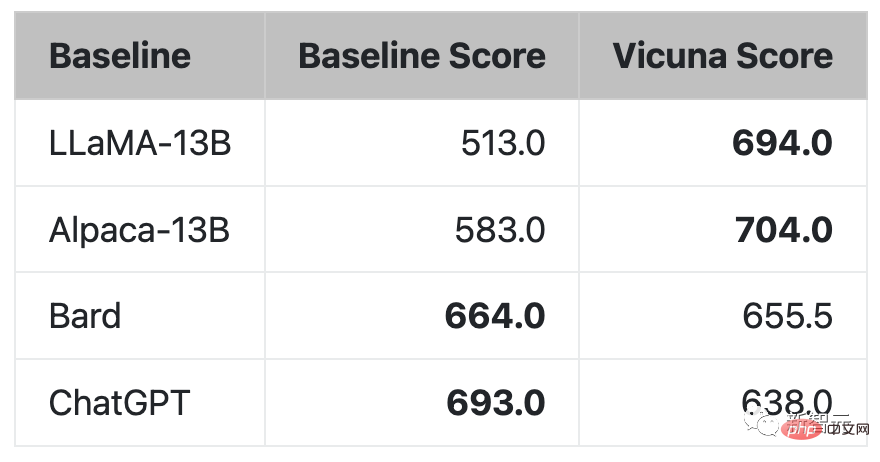

Comparaison des réponses évaluées par GPT-4

GPT-4 préfère Vicuna aux modèles open source SOTA existants (LLaMA, Alpaca) dans plus de 90 % des problèmes.

Dans 45 % des questions, GPT-4 pensait que les réponses de Vicuna étaient similaires, voire meilleures, que celles de ChatGPT.

Dans l’ensemble, le score total de Vicuna atteint 92 % de ChatGPT.

Limitations

Les chercheurs ont souligné que, à l'instar d'autres grands modèles de langage, Vicuna présente également certaines limites.

Par exemple, Vicuna a obtenu de mauvais résultats dans les tâches impliquant la programmation, le raisonnement, les mathématiques et l'exactitude des faits.

De plus, il n'est pas entièrement optimisé pour garantir la sécurité ou atténuer la toxicité ou les biais potentiels.

Pour résoudre les problèmes de sécurité, les chercheurs ont utilisé l'API de censure d'OpenAI dans la démo pour filtrer les entrées inappropriées des utilisateurs.

Maintenant, en plus de lama (LLaMA), d'alpaga (Alpaca) et de vigogne (Vicuna), ils sont tous arrangés.

Chercheurs, dépêchez-vous car il ne vous reste plus beaucoup de noms (1).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!