Cet article présente principalement l'utilisation détaillée de Tensorflow's Saver. Maintenant, je le partage avec vous et le donne comme référence. Venez jeter un oeil

Utilisation de Saver

Introduction générale à Saver

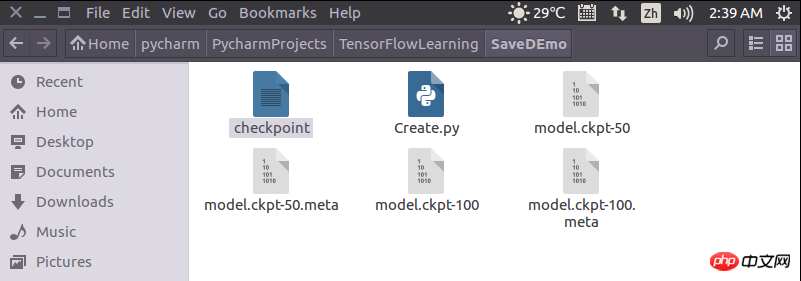

Nous souhaitons souvent sauvegarder les résultats de la formation après la formation d'un modèle. Ces résultats font référence aux paramètres du modèle pour la formation ou le test lors de l'itération suivante. Tensorflow fournit la classe Saver pour cette exigence.2. Instance Saver

Ce qui suit est un exemple de la façon d'utiliser la classe Saverimport tensorflow as tf

import numpy as np

x = tf.placeholder(tf.float32, shape=[None, 1])

y = 4 * x + 4

w = tf.Variable(tf.random_normal([1], -1, 1))

b = tf.Variable(tf.zeros([1]))

y_predict = w * x + b

loss = tf.reduce_mean(tf.square(y - y_predict))

optimizer = tf.train.GradientDescentOptimizer(0.5)

train = optimizer.minimize(loss)

isTrain = False

train_steps = 100

checkpoint_steps = 50

checkpoint_dir = ''

saver = tf.train.Saver() # defaults to saving all variables - in this case w and b

x_data = np.reshape(np.random.rand(10).astype(np.float32), (10, 1))

with tf.Session() as sess:

sess.run(tf.initialize_all_variables())

if isTrain:

for i in xrange(train_steps):

sess.run(train, feed_dict={x: x_data})

if (i + 1) % checkpoint_steps == 0:

saver.save(sess, checkpoint_dir + 'model.ckpt', global_step=i+1)

else:

ckpt = tf.train.get_checkpoint_state(checkpoint_dir)

if ckpt and ckpt.model_checkpoint_path:

saver.restore(sess, ckpt.model_checkpoint_path)

else:

pass

print(sess.run(w))

print(sess.run(b))

Tensorflow utilise des indicateurs pour définir les paramètres de ligne de commande

Sauvegarde et restauration du modèle d'apprentissage Tensorflow1.0 (Saver)_python

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Que signifie le routage Java ?

Que signifie le routage Java ?

Que faire s'il n'y a aucun son provenant du microphone de l'ordinateur

Que faire s'il n'y a aucun son provenant du microphone de l'ordinateur

Quelle est la différence entre php et java

Quelle est la différence entre php et java

Que signifie le serveur racine ?

Que signifie le serveur racine ?

chaîne js en tableau

chaîne js en tableau

Comment acheter, vendre et échanger du Bitcoin

Comment acheter, vendre et échanger du Bitcoin

Les étincelles Douyin peuvent-elles être rallumées si elles sont éteintes depuis plus de trois jours ?

Les étincelles Douyin peuvent-elles être rallumées si elles sont éteintes depuis plus de trois jours ?

Quelle est la différence entre USB-C et TYPE-C

Quelle est la différence entre USB-C et TYPE-C