Je ne l'ai pas utilisé depuis longtempsrequests, car j'écrirai un simple robot plus tard, donc je Je vais juste écrire une petite critique.

import requests r = requests.get('https://api.github.com/user', auth=('haiyu19931121@163.com', 'Shy18137803170'))print(r.status_code) # 状态码200print(r.json()) # 返回json格式print(r.text) # 返回文本print(r.headers) # 头信息print(r.encoding) # 编码方式,一般utf-8# 当写入文件比较大时,避免内存耗尽,可以一次写指定的字节数或者一行。# 一次读一行,chunk_size=512为默认值for chunk in r.iter_lines():print(chunk)# 一次读取一块,大小为512for chunk in r.iter_content(chunk_size=512):print(chunk)

Notez que iter_lines et iter_content renvoient des données en octets. Si vous souhaitez écrire un fichier, qu'il s'agisse de texte ou d'image, vous devez commencer. avec wb manière d'ouvrir.

Venons-en au fait. J'entends parler de cette célèbre bibliothèque depuis longtemps, même si dans le passé, il n'était pas gênant d'utiliser des expressions régulières pour écrire des robots. , parfois la correspondance serait inexacte. Utilisez Beautifulsoup pour extraire avec précision les données des balises HTML. Bien qu’il soit un peu lent, il est simple et facile à utiliser.

from bs4 import BeautifulSoup html_doc = """<html><head><title>The Dormouse's story</title></head><body><p class="title"><b>The Dormouse's story</b></p><p class="story">Once upon a time there were three little sisters; and their names were<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;and they lived at the bottom of a well.</p><p class="story">...</p>"""# 就注意一点,第二个参数指定解析器,必须填上,不然会有警告。推荐使用lxmlsoup = BeautifulSoup(html_doc, 'lxml')

En suivant le code ci-dessus, examinez quelques opérations simples ci-dessous. En utilisant le comportement des attributs de point, vous obtiendrez les premières données trouvées qui remplissent les conditions. C'est l'abréviation de find méthode.

soup.a soup.find('p')

Les deux phrases ci-dessus sont équivalentes.

# soup.body是一个Tag对象。是body标签中所有html代码print(soup.body)

1 2 3 4 5 6 7 8 9 |

|

# 获取body里所有文本,不含标签print(soup.body.text)# 等同于下面的写法soup.body.get_text()# 还可以这样写,strings是所有文本的生成器for string in soup.body.strings:print(string, end='')

1 2 3 4 5 6 7 |

|

# 获得该标签里的文本。print(soup.title.string)

1 |

|

# Tag对象的get方法可以根据属性的名称获得属性的值,此句表示得到第一个p标签里class属性的值print(soup.p.get('class'))# 和下面的写法等同print(soup.p['class'])

1 |

|

# 查看a标签的所有属性,以字典形式给出print(soup.a.attrs)

1 |

|

# 标签的名称soup.title.name

1 |

|

La méthode la plus utilisée est certainement la méthode find_all / find, trouve la première toutes les données qui remplissent les conditions sont renvoyées sous forme de liste. Cette dernière est la première donnée de cette liste. find_all a un paramètre limit qui limite la longueur de la liste (c'est-à-dire le nombre de données qui remplissent les conditions trouvées). Quand limit=1 devient réellement la méthode find.

find_all a également des abréviations.

soup.find_all('a', id='link1') soup('a', id='link1')

Les deux façons d'écrire ci-dessus sont équivalentes, et la deuxième façon d'écrire est une abréviation.

1 2 |

|

name est la balise que vous souhaitez rechercher. Par exemple, ce qui suit consiste à trouver toutes les balises p. Non seulement vous pouvez remplir des chaînes, mais vous pouvez également transmettre des expressions régulières, des listes, des fonctions et True. Si

# 传入字符串soup.find_all('p')# 传入正则表达式import re# 必须以b开头for tag in soup.find_all(re.compile("^b")):print(tag.name)# body# b# 含有t就行for tag in soup.find_all(re.compile("t")):print(tag.name)# html# title# 传入列表表示,一次查找多个标签soup.find_all(["a", "b"])# [The Dormouse's story,# Elsie,# Lacie,# Tillie] est passé dans True, il n'y aura pas de limite et tout sera recherché.

Lors de l'appel de la méthode find_all() de la balise, Beautiful Soup récupérera tous les nœuds descendants de la balise actuelle. Si vous souhaitez rechercher uniquement les nœuds enfants directs de la balise, vous peut utiliser le paramètre recursive=False.

# title不是html的直接子节点,但是会检索其下所有子孙节点soup.html.find_all("title")# [The Dormouse's story ]# 参数设置为False,只会找直接子节点soup.html.find_all("title", recursive=False)# []# title就是head的直接子节点,所以这个参数此时无影响a = soup.head.find_all("title", recursive=False)# [The Dormouse's story ]Utilisez un mot-clé et ajoutez une ou plusieurs conditions de qualification pour affiner la portée de la recherche.

# 查看所有id为link1的p标签soup.find_all('a', id='link1')

Si vous effectuez une recherche par classe, Python l'a déjà utilisé à cause du mot-clé class. Vous pouvez utiliser class_, ou ne pas spécifier de mots-clés, ou utiliser attrs pour remplir le dictionnaire.

soup.find_all('p', class_='story')

soup.find_all('p', 'story')

soup.find_all('p', attrs={"class": "story"})Les trois méthodes ci-dessus sont équivalentes. class_Peut accepter des chaînes, des expressions régulières, des fonctions et True.

Recherchez une valeur de texte, il semble que l'utilisation du paramètre string donne également le même résultat.

a = soup.find_all(text='Elsie')# 或者,4.4以上版本请使用texta = soup.find_all(string='Elsie')

Le paramètre text peut également accepter des chaînes, des expressions régulières, True et des listes.

Vous pouvez également utiliser le sélecteur CSS. Utilisez simplement la méthode select, select renvoie toujours une liste.

Énumérez plusieurs opérations courantes.

# 所有div标签soup.select('div')# 所有id为username的元素soup.select('.username')# 所有class为story的元素soup.select('#story')# 所有div元素之内的span元素,中间可以有其他元素soup.select('div span')# 所有div元素之内的span元素,中间没有其他元素soup.select('div > span')# 所有具有一个id属性的input标签,id的值无所谓soup.select('input[id]')# 所有具有一个id属性且值为user的input标签soup.select('input[id="user"]')# 搜索多个,class为link1或者link2的元素都符合soup.select("#link1, #link2")Ce qui précède présente l'utilisation de base des requêtes et de beautifulsoup4. En les utilisant, vous pouvez déjà écrire quelques robots simples. Venez l'essayer.

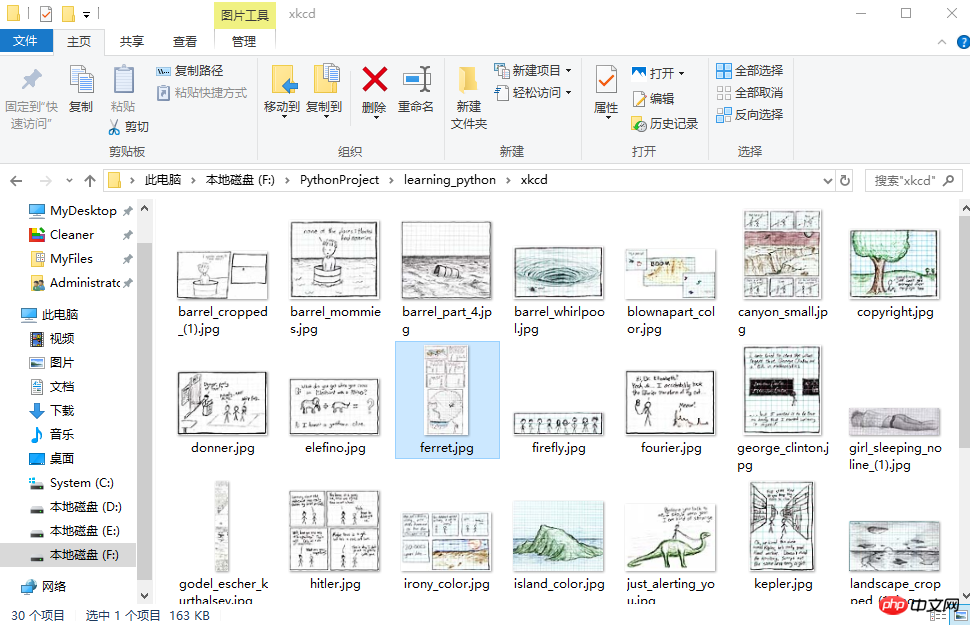

Cet exemple provient de "Démarrez rapidement avec la programmation Python - Automatisez les travaux fastidieux" [US] AI Sweigart

Ce robot téléchargera des images depuis XKCD Comics Network par lots . Vous pouvez spécifier le nombre de pages à télécharger.

import osimport requestsfrom bs4 import BeautifulSoup# exist_ok=True,若文件夹已经存在也不会报错os.makedirs('xkcd')

url = 'https://xkcd.com/'headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) ' 'Chrome/57.0.2987.98 Safari/537.36'}def save_img(img_url, limit=1):

r = requests.get(img_url, headers=headers)

soup = BeautifulSoup(r.text, 'lxml')try:

img = 'https:' + soup.find('div', id='comic').img.get('src')except AttributeError:print('Image Not Found')else:print('Downloading', img)

response = requests.get(img, headers=headers)with open(os.path.join('xkcd', os.path.basename(img)), 'wb') as f:for chunk in response.iter_content(chunk_size=1024*1024):

f.write(chunk)# 每次下载一张图片,就减1limit -= 1# 找到上一张图片的网址if limit > 0:try:

prev = 'https://xkcd.com' + soup.find('a', rel='prev').get('href')except AttributeError:print('Link Not Exist')else:

save_img(prev, limit)if __name__ == '__main__':

save_img(url, limit=20)print('Done!')1 2 3 4 5 6 7 8 9 10 11 |

|

La vitesse du monothread est un peu lente, par exemple, le multithreading peut être utilisé, car quand on obtient prev, connaître l'URL de chaque page web est très régulier. Ça se passe comme ça. Seul le dernier numéro est différent, nous pouvons donc facilement utiliser range pour parcourir.

import osimport threadingimport requestsfrom bs4 import BeautifulSoup

os.makedirs('xkcd')

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) ' 'Chrome/57.0.2987.98 Safari/537.36'}def download_imgs(start, end):for url_num in range(start, end):

img_url = 'https://xkcd.com/' + str(url_num)

r = requests.get(img_url, headers=headers)

soup = BeautifulSoup(r.text, 'lxml')try:

img = 'https:' + soup.find('div', id='comic').img.get('src')except AttributeError:print('Image Not Found')else:print('Downloading', img)

response = requests.get(img, headers=headers)with open(os.path.join('xkcd', os.path.basename(img)), 'wb') as f:for chunk in response.iter_content(chunk_size=1024 * 1024):

f.write(chunk)if __name__ == '__main__':# 下载从1到30,每个线程下载10个threads = []for i in range(1, 30, 10):

thread_obj = threading.Thread(target=download_imgs, args=(i, i + 10))

threads.append(thread_obj)

thread_obj.start()# 阻塞,等待线程执行结束都会等待for thread in threads:

thread.join()# 所有线程下载完毕,才打印print('Done!')来看下结果吧。

selenium用来作自动化测试。使用前需要下载驱动,我只下载了Firefox和Chrome的。网上随便一搜就能下载到了。接下来将下载下来的文件其复制到将安装目录下,比如Firefox,将对应的驱动程序放到C:\Program Files (x86)\Mozilla Firefox,并将这个路径添加到环境变量中,同理Chrome的驱动程序放到C:\Program Files (x86)\Google\Chrome\Application并将该路径添加到环境变量。最后重启IDE开始使用吧。

下面这个例子会打开Chrome浏览器,访问百度首页,模拟输入The Zen of Python,随后点击百度一下,当然也可以用回车代替。Keys下是一些不能用字符串表示的键,比如方向键、Tab、Enter、Esc、F1~F12、Backspace等。然后等待3秒,页面跳转到知乎首页,接着返回到百度,最后退出(关闭)浏览器。

from selenium import webdriverfrom selenium.webdriver.common.keys import Keysimport time browser = webdriver.Chrome()# Chrome打开百度首页browser.get('https://www.baidu.com/')# 找到输入区域input_area = browser.find_element_by_id('kw')# 区域内填写内容input_area.send_keys('The Zen of Python')# 找到"百度一下"search = browser.find_element_by_id('su')# 点击search.click()# 或者按下回车# input_area.send_keys('The Zen of Python', Keys.ENTER)time.sleep(3) browser.get('https://www.zhihu.com/') time.sleep(2)# 返回到百度搜索browser.back() time.sleep(2)# 退出浏览器browser.quit()

send_keys模拟输入内容。可以使用element的clear()方法清空输入。一些其他模拟点击浏览器按钮的方法如下

browser.back() # 返回按钮browser.forward() # 前进按钮browser.refresh() # 刷新按钮browser.close() # 关闭当前窗口browser.quit() # 退出浏览器

以下列举常用的查找Element的方法。

| 方法名 | 返回的WebElement |

|---|---|

| find_element_by_id(id) | 匹配id属性值的元素 |

| find_element_by_name(name) | 匹配name属性值的元素 |

| find_element_by_class_name(name) | 匹配CSS的class值的元素 |

| find_element_by_tag_name(tag) | 匹配标签名的元素,如div |

| find_element_by_css_selector(selector) | 匹配CSS选择器 |

| find_element_by_xpath(xpath) | 匹配xpath |

| find_element_by_link_text(text) | 完全匹配提供的text的a标签 |

| find_element_by_partial_link_text(text) | 提供的text可以是a标签中文本中的一部分 |

以下代码可以模拟输入账号密码,点击登录。整个过程还是很快的。

browser = webdriver.Chrome() browser.get('https://passport.csdn.net/account/login') browser.find_element_by_id('username').send_keys('haiyu19931121@163.com') browser.find_element_by_id('password').send_keys('**********') browser.find_element_by_class_name('logging').click()

以上差不多都是API的罗列,其中有自己的理解,也有照搬官方文档的。

by @sunhaiyu

2017.7.13

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils courants pour les tests de logiciels

Outils courants pour les tests de logiciels

Quels sont les outils de test Java ?

Quels sont les outils de test Java ?

Méthode de robot d'exploration Python pour obtenir des données

Méthode de robot d'exploration Python pour obtenir des données

Comment définir des chaînes en php

Comment définir des chaînes en php

Recommandation du logiciel de programmation PHP

Recommandation du logiciel de programmation PHP

Quel élément est li ?

Quel élément est li ?

Comment connecter VB pour accéder à la base de données

Comment connecter VB pour accéder à la base de données

Comment utiliser le commutateur Java

Comment utiliser le commutateur Java