Cet article a été rédigé à l'origine par MaNong.com – Xiao Hao Veuillez lire les exigences de réimpression à la fin de l'article pour la réimpression. Bienvenue pour participer à notre plan de contribution payante !

J'ai toujours eu l'habitude de regarder des séries télé américaines. D'un côté, je peux pratiquer mon écoute en anglais et, de l'autre, je passe le temps. Autrefois, il était possible de regarder des films en ligne sur des sites de vidéo, mais depuis l'ordonnance de restriction imposée par l'Administration d'État de la radio, du cinéma et de la télévision, les fictions américaines et britanniques importées ne semblent plus être mises à jour simultanément comme avant. Cependant, en tant que nerd, comment puis-je être prêt à ne pas suivre les drames, alors j'ai vérifié en ligne et trouvé un site Web de téléchargement de drames américains [Tiantian American Drama] qui peut être téléchargé à l'aide de Thunder. Je peux télécharger diverses ressources à volonté. Je suis obsédé par le documentaire haute définition de la BBC, la nature est si belle.

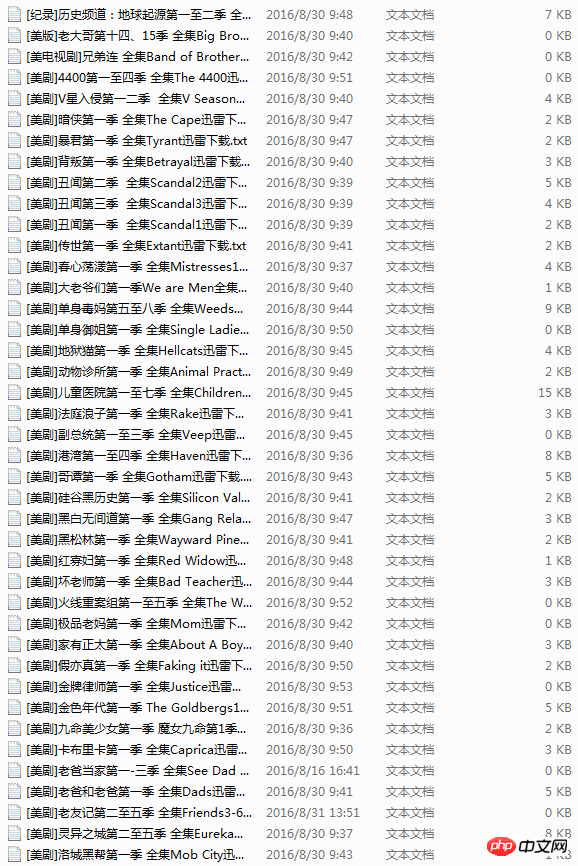

Bien que j'ai trouvé un site Web de ressources qui peut être téléchargé, mais à chaque fois je dois ouvrir le navigateur, saisir l'URL, trouver le drame américain, puis cliquer sur le lien pour télécharger. Après une longue période, le processus devient très fastidieux et parfois le lien du site Web ne peut pas être ouvert, ce qui est un peu gênant. Il se trouve que j'ai appris le crawler Python, alors aujourd'hui, j'ai écrit un robot sur un coup de tête pour récupérer tous les liens de drames américains sur le site Web et les enregistrer dans un document texte. Si vous voulez un drame, ouvrez-le simplement. et copiez le lien vers Vous pouvez le télécharger via Thunder.

En fait, j'avais initialement prévu d'écrire une méthode qui trouve une URL, utilise des requêtes pour ouvrir et explorer le lien de téléchargement, et explore l'ensemble du site à partir de la page d'accueil. Cependant, il y a beaucoup de liens répétés et l'URL du site Web n'est pas aussi régulière que je le pensais. Après avoir écrit pendant longtemps, je n'ai toujours pas écrit le type de robot d'exploration divergent que je souhaite. prêt, alors continuez à travailler dur. . .

Plus tard, j'ai découvert que les liens vers la série télévisée sont tous dans l'article, et qu'il y a un numéro après l'URL de l'article, comme celui-ci http://cn163.net/archives/24016/, J'ai donc intelligemment utilisé l'expérience du robot que j'ai écrite auparavant. La solution est de générer automatiquement l'URL. Le numéro derrière ne peut-il pas être modifié et chaque drame est unique, j'ai donc essayé de savoir combien d'articles il y a. , puis utilisez la fonction range pour générer directement des nombres en continu afin de construire l'URL.

Mais de nombreuses URL n'existent pas, donc elles raccrocheront directement. Ne vous inquiétez pas, nous utilisons des requêtes, et son status_code intégré est utilisé pour déterminer l'état renvoyé par la requête, donc aussi longtemps. comme c'est le statut renvoyé, nous ignorons tous ceux avec le code 404 et explorons les autres liens, ce qui résout le problème d'URL.

Ce qui suit est le code de mise en œuvre des étapes ci-dessus.

def get_urls(self):

try:

for i in range(2015,25000):

base_url='http://cn163.net/archives/'

url=base_url+str(i)+'/'

if requests.get(url).status_code == 404:

continue

else:

self.save_links(url)

except Exception,e:

passLe reste s'est bien passé. J'ai trouvé un robot d'exploration similaire écrit par quelqu'un auparavant sur Internet, mais il n'a exploré qu'un seul article, j'ai donc emprunté ses expressions régulières. J'ai utilisé BeautifulSoup mais l'effet n'était pas aussi bon que la méthode habituelle, j'ai donc abandonné de manière décisive. Il n'y a pas de limite à mon apprentissage. Cependant, l’effet n’est pas si idéal. Environ la moitié des liens ne peuvent pas être explorés correctement et doivent continuer à être optimisés.

# -*- coding:utf-8 -*-

import requests

import re

import sys

import threading

import time

reload(sys)

sys.setdefaultencoding('utf-8')

class Archives(object):

def save_links(self,url):

try:

data=requests.get(url,timeout=3)

content=data.text

link_pat='"(ed2k://\|file\|[^"]+?\.(S\d+)(E\d+)[^"]+?1024X\d{3}[^"]+?)"'

name_pat=re.compile(r'<h2 class="entry_title">(.*?)</h2>',re.S)

links = set(re.findall(link_pat,content))

name=re.findall(name_pat,content)

links_dict = {}

count=len(links)

except Exception,e:

pass

for i in links:

links_dict[int(i[1][1:3]) * 100 + int(i[2][1:3])] = i#把剧集按s和e提取编号

try:

with open(name[0].replace('/',' ')+'.txt','w') as f:

print name[0]

for i in sorted(list(links_dict.keys())):#按季数+集数排序顺序写入

f.write(links_dict[i][0] + '\n')

print "Get links ... ", name[0], count

except Exception,e:

pass

def get_urls(self):

try:

for i in range(2015,25000):

base_url='http://cn163.net/archives/'

url=base_url+str(i)+'/'

if requests.get(url).status_code == 404:

continue

else:

self.save_links(url)

except Exception,e:

pass

def main(self):

thread1=threading.Thread(target=self.get_urls())

thread1.start()

thread1.join()

if __name__ == '__main__':

start=time.time()

a=Archives()

a.main()

end=time.time()

print end-startLa version complète du code, qui utilise également le multi-threading, mais cela semble inutile, probablement à cause du GIL de Python. Il semble y avoir plus de 20 000 drames. Je pensais que cela prendrait beaucoup de temps. Il est temps de l'attraper. La récupération est terminée, mais en excluant les erreurs d'URL et les URL sans correspondance, la durée totale de récupération est inférieure à 20 minutes. Au départ, je voulais utiliser Redis pour explorer deux machines Linux, mais après beaucoup d'agitation, j'ai pensé que c'était inutile, alors je l'ai laissé là et je le ferai plus tard lorsque j'aurai besoin de plus de données.

Un autre problème qui m'a troublé pendant le processus était la sauvegarde des noms de fichiers. Je dois me plaindre ici. Les noms de fichiers au format texte txt peuvent avoir des espaces, mais ils ne peuvent pas avoir de barres obliques inverses, ou de crochets, etc. C'est là le problème. J'ai passé toute la matinée là-dessus. Au début, j'ai pensé que c'était une erreur lors de l'exploration des données. Après une longue vérification, j'ai découvert que le titre du drame analysé contenait une barre oblique. misérable. .

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!