1. Introduction

Dans les articles précédents, j'ai présenté comment analyser le code source Python pour blogs d'exploration, InfoBox Wikipédia et images, le lien de l'article est le suivant :

[Apprentissage Python] Exploration simple de la boîte de message du langage de programmation Wikipédia

[Apprentissage Python] Analyse simple des articles de blog par un robot d'exploration Web et introduction d'idées

[Apprentissage Python] Exploration simple des images dans la galerie d'images du site Web

Le code de base est le suivant :

# coding=utf-8

import urllib

import re

#下载静态HTML网页

url='http://www.csdn.net/'

content = urllib.urlopen(url).read()

open('csdn.html','w+').write(content)

#获取标题

title_pat=r'(?<=<title>).*?(?=</title>)'

title_ex=re.compile(title_pat,re.M|re.S)

title_obj=re.search(title_ex, content)

title=title_obj.group()

print title

#获取超链接内容

href = r'<a href=.*?>(.*?)</a>'

m = re.findall(href,content,re.S|re.M)

for text in m:

print unicode(text,'utf-8')

break #只输出一个urlCopier après la connexion

Le résultat de sortie est le suivant :

>>>

CSDN.NET - 全球最大中文IT社区,为IT专业技术人员提供最全面的信息传播和服务平台

登录

>>>

Copier après la connexion

Le code de base pour le téléchargement d'images est le suivant :

import os

import urllib

class AppURLopener(urllib.FancyURLopener):

version = "Mozilla/5.0"

urllib._urlopener = AppURLopener()

url = "http://creatim.allyes.com.cn/imedia/csdn/20150228/15_41_49_5B9C9E6A.jpg"

filename = os.path.basename(url)

urllib.urlretrieve(url , filename)Copier après la connexion

Mais la méthode ci-dessus d'analyse HTML pour explorer le contenu d'un site Web présente de nombreux inconvénients, tels que :

1. Les expressions régulières sont contraint par le code source HTML, et non Dépend de la structure plus abstraite ; de petits changements dans la structure de la page Web peuvent entraîner un arrêt du programme.

2. Le programme doit analyser le contenu en fonction du code source HTML réel. Il peut rencontrer des fonctionnalités HTML telles que des entités de caractères telles que &, et doit spécifier un traitement tel que , hyperliens d’icônes, indices, etc. Contenu différent.

3. Les expressions régulières ne sont pas entièrement lisibles et les codes HTML et expressions de requête plus complexes deviendront compliqués.

Comme "Python Basics Tutorial (2nd Edition)" adopte deux solutions : la première consiste à utiliser le programme Tidy (bibliothèque Python) et l'analyse XHTML ; la seconde est pour utiliser la bibliothèque BeautifulSoup.

2. Installation et introduction Bibliothèque Beautiful Soup

Beautiful Soup est un analyseur HTML/XML écrit en Python , qui peut gérez bien les balises irrégulières et générez des arbres d’analyse. Il fournit des opérations simples et couramment utilisées pour naviguer, rechercher et modifier les arbres d'analyse. Cela peut considérablement économiser votre temps de programmation.

Comme le dit le livre : "Vous n'avez pas écrit ces mauvaises pages Web, vous avez simplement essayé d'en obtenir des données. Maintenant, vous vous en fichez". à quoi ressemble le code HTML, l'analyseur vous aide à y parvenir."

Adresse de téléchargement :

http://www .php.cn/

setup.py installer

Il est recommandé de se référer au chinois pour les méthodes d'utilisation spécifiques : //m.sbmmt.com/

Il est recommandé de se référer au chinois pour les méthodes d'utilisation spécifiques : //m.sbmmt.com/

Parmi elles, l'utilisation de BeautifulSoup est brièvement expliqué, en utilisant l'exemple officiel de "Alice au pays des merveilles":

Contenu de sortie

#!/usr/bin/python

# -*- coding: utf-8 -*-

from bs4 import BeautifulSoup

html_doc = """

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

"""

#获取BeautifulSoup对象并按标准缩进格式输出

soup = BeautifulSoup(html_doc)

print(soup.prettify())

Copier après la connexion

Sortie selon la structure de format indenté standard

Comme suit : Ce qui suit est une introduction simple et rapide à la bibliothèque BeautifulSoup : (Référence : Documentation officielle)

<html>

<head>

<title>

The Dormouse's story

</title>

</head>

<body>

<p class="title">

<b>

The Dormouse's story

</b>

</p>

<p class="story">

Once upon a time there were three little sisters; and their names were

<a class="sister" href="http://example.com/elsie" id="link1">

Elsie

</a>

,

<a class="sister" href="http://example.com/lacie" id="link2">

Lacie

</a>

and

<a class="sister" href="http://example.com/tillie" id="link3">

Tillie

</a>

;

and they lived at the bottom of a well.

</p>

<p class="story">

...

</p>

</body>

</html>Copier après la connexion

Si vous souhaitez obtenir tout le contenu textuel dans l'article, le code est le suivant :

'''获取title值'''

print soup.title

# <title>The Dormouse's story</title>

print soup.title.name

# title

print unicode(soup.title.string)

# The Dormouse's story

'''获取<p>值'''

print soup.p

# <p class="title"><b>The Dormouse's story</b></p>

print soup.a

# <a class="sister" href="http://example.com/elsie" id="link1">Elsie</a>

'''从文档中找到<a>的所有标签链接'''

print soup.find_all('a')

# [<a class="sister" href="http://example.com/elsie" id="link1">Elsie</a>,

# <a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>,

# <a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>]

for link in soup.find_all('a'):

print(link.get('href'))

# //m.sbmmt.com/

# //m.sbmmt.com/

# //m.sbmmt.com/

print soup.find(id='link3')

# <a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>Copier après la connexion

'''从文档中获取所有文字内容'''

print soup.get_text()

# The Dormouse's story

#

# The Dormouse's story

#

# Once upon a time there were three little sisters; and their names were

# Elsie,

# Lacie and

# Tillie;

# and they lived at the bottom of a well.

#

# ...

Copier après la connexion

同时在这过程中你可能会遇到两个典型的错误提示:

1.ImportError: No module named BeautifulSoup

当你成功安装BeautifulSoup 4库后,“from BeautifulSoup import BeautifulSoup”可能会遇到该错误。

其中的原因是BeautifulSoup 4库改名为bs4,需要使用“from bs4 import BeautifulSoup”导入。

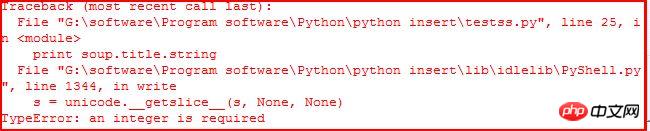

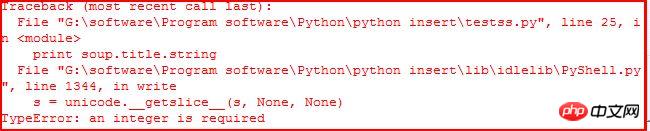

2.TypeError: an integer is required

当你使用“print soup.title.string”获取title的值时,可能会遇到该错误。如下:

它应该是IDLE的BUG,当使用命令行Command没有任何错误。参考:stackoverflow。同时可以通过下面的代码解决该问题:

print unicode(soup.title.string)

print str(soup.title.string)

三. Beautiful Soup常用方法介绍

Beautiful Soup将复杂HTML文档转换成一个复杂的树形结构,每个节点都是Python对象,所有对象可以归纳为4种:Tag、NavigableString、BeautifulSoup、Comment|

1.Tag标签

tag对象与XML或HTML文档中的tag相同,它有很多方法和属性。其中最重要的属性name和attribute。用法如下:

#!/usr/bin/python

# -*- coding: utf-8 -*-

from bs4 import BeautifulSoup

html = """

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title" id="start"><b>The Dormouse's story</b></p>

"""

soup = BeautifulSoup(html)

tag = soup.p

print tag

# <p class="title" id="start"><b>The Dormouse's story</b></p>

print type(tag)

# <class 'bs4.element.Tag'>

print tag.name

# p 标签名字

print tag['class']

# [u'title']

print tag.attrs

# {u'class': [u'title'], u'id': u'start'}Copier après la connexion

使用BeautifulSoup每个tag都有自己的名字,可以通过.name来获取;同样一个tag可能有很多个属性,属性的操作方法与字典相同,可以直接通过“.attrs”获取属性。至于修改、删除操作请参考文档。

2.NavigableString

字符串常被包含在tag内,Beautiful Soup用NavigableString类来包装tag中的字符串。一个NavigableString字符串与Python中的Unicode字符串相同,并且还支持包含在遍历文档树和搜索文档树中的一些特性,通过unicode()方法可以直接将NavigableString对象转换成Unicode字符串。

print unicode(tag.string)

# The Dormouse's story

print type(tag.string)

# <class 'bs4.element.NavigableString'>

tag.string.replace_with("No longer bold")

print tag

# <p class="title" id="start"><b>No longer bold</b></p>Copier après la connexion

这是获取“The Dormouse's story

”中tag = soup.p的值,其中tag中包含的字符串不能编辑,但可通过函数replace_with()替换。

NavigableString 对象支持遍历文档树和搜索文档树 中定义的大部分属性, 并非全部。尤其是一个字符串不能包含其它内容(tag能够包含字符串或是其它tag),字符串不支持 .contents 或 .string 属性或 find() 方法。

如果想在Beautiful Soup之外使用 NavigableString 对象,需要调用 unicode() 方法,将该对象转换成普通的Unicode字符串,否则就算Beautiful Soup已方法已经执行结束,该对象的输出也会带有对象的引用地址。这样会浪费内存。

3.Beautiful Soup对象

该对象表示的是一个文档的全部内容,大部分时候可以把它当做Tag对象,它支持遍历文档树和搜索文档树中的大部分方法。

注意:因为BeautifulSoup对象并不是真正的HTML或XML的tag,所以它没有name和 attribute属性,但有时查看它的.name属性可以通过BeautifulSoup对象包含的一个值为[document]的特殊实行.name实现——soup.name。

Beautiful Soup中定义的其它类型都可能会出现在XML的文档中:CData , ProcessingInstruction , Declaration , Doctype 。与 Comment 对象类似,这些类都是 NavigableString 的子类,只是添加了一些额外的方法的字符串独享。

4.Command注释

Tag、NavigableString、BeautifulSoup几乎覆盖了html和xml中的所有内容,但是还有些特殊对象容易让人担心——注释。Comment对象是一个特殊类型的NavigableString对象。

markup = "<b><!--Hey, buddy. Want to buy a used parser?--></b>"

soup = BeautifulSoup(markup)

comment = soup.b.string

print type(comment)

# <class 'bs4.element.Comment'>

print unicode(comment)

# Hey, buddy. Want to buy a used parser?

Copier après la connexion

介绍完这四个对象后,下面简单介绍遍历文档树和搜索文档树及常用的函数。

5.遍历文档树

一个Tag可能包含多个字符串或其它的Tag,这些都是这个Tag的子节点。BeautifulSoup提供了许多操作和遍历子节点的属性。引用官方文档中爱丽丝例子:

操作文档最简单的方法是告诉你想获取tag的name,如下:

soup.head# <head><title>The Dormouse's story</title></head>soup.title# <title>The Dormouse's story</title>soup.body.b# <b>The Dormouse's story</b>

Copier après la connexion

注意:通过点取属性的放是只能获得当前名字的第一个Tag,同时可以在文档树的tag中多次调用该方法如soup.body.b获取标签中第一个标签。

如果想得到所有的标签,使用方法find_all(),在前面的Python爬取维基百科等HTML中我们经常用到它+正则表达式的方法。

soup.find_all('a')# [<a class="sister" href="http://example.com/elsie" id="link1">Elsie</a>,# <a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>,# <a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>]

Copier après la connexion

子节点:在分析HTML过程中通常需要分析tag的子节点,而tag的 .contents 属性可以将tag的子节点以列表的方式输出。字符串没有.contents属性,因为字符串没有子节点。

head_tag = soup.head

head_tag

# <head><title>The Dormouse's story</title></head>

head_tag.contents

[<title>The Dormouse's story</title>]

title_tag = head_tag.contents[0]

title_tag

# <title>The Dormouse's story</title>

title_tag.contents

# [u'The Dormouse's story']

Copier après la connexion

通过tag的 .children 生成器,可以对tag的子节点进行循环:

for child in title_tag.children:

print(child)

# The Dormouse's storyCopier après la connexion

子孙节点:同样 .descendants 属性可以对所有tag的子孙节点进行递归循环:

for child in head_tag.descendants:

print(child)

# <title>The Dormouse's story</title>

# The Dormouse's storyCopier après la connexion

父节点:通过 .parent 属性来获取某个元素的父节点.在例子“爱丽丝”的文档中,标签是标签的父节点,换句话就是增加一层标签。<br/> <span style="color:#ff0000">注意:文档的顶层节点比如<html>的父节点是 BeautifulSoup 对象,BeautifulSoup 对象的 .parent 是None。</span><br/></span></strong></p><div class="code" style="position:relative; padding:0px; margin:0px;"><pre style="overflow-x:auto; overflow-y:hidden; padding:5px; line-height:15.6000003814697px; border-top-width:1px; border-bottom-width:1px; border-style:solid none; border-top-color:rgb(170,204,153); border-bottom-color:rgb(170,204,153); background-color:rgb(238,255,204)">title_tag = soup.titletitle_tag# <title>The Dormouse's story</title>title_tag.parent# <head><title>The Dormouse's story</title></head>title_tag.string.parent# <title>The Dormouse's story</title></pre><div class="contentsignin">Copier après la connexion</div></div><p><strong><span style="font-size:18px"> <span style="color:#ff0000">兄弟节点</span>:因为<b>标签和<c>标签是同一层:他们是同一个元素的子节点,所以<b>和<c>可以被称为兄弟节点。一段文档以标准格式输出时,兄弟节点有相同的缩进级别.在代码中也可以使用这种关系。</span></strong><br/></p><div class="code" style="position:relative; padding:0px; margin:0px;"><pre style="overflow-x:auto; overflow-y:hidden; padding:5px; color:rgb(51,51,51); line-height:15.6000003814697px; border-top-width:1px; border-bottom-width:1px; border-style:solid none; border-top-color:rgb(170,204,153); border-bottom-color:rgb(170,204,153); background-color:rgb(238,255,204)">sibling_soup = BeautifulSoup("<a><b>text1</b><c>text2</c></b></a>")print(sibling_soup.prettify())# <html># <body># <a># <b># text1# </b># <c># text2# </c># </a># </body># </html></pre><div class="contentsignin">Copier après la connexion</div></div><p><strong><span style="font-size:18px"> <span style="color:#ff0000">在文档树中,使用 .next_sibling 和 .previous_sibling 属性来查询兄弟节点。<b>标签有.next_sibling 属性,但是没有.previous_sibling 属性,因为<b>标签在同级节点中是第一个。同理<c>标签有.previous_sibling 属性,却没有.next_sibling 属性:</span></span></strong><br/></p><div class="code" style="position:relative; padding:0px; margin:0px;"><pre style="overflow-x:auto; overflow-y:hidden; padding:5px; color:rgb(51,51,51); line-height:15.6000003814697px; border-top-width:1px; border-bottom-width:1px; border-style:solid none; border-top-color:rgb(170,204,153); border-bottom-color:rgb(170,204,153); background-color:rgb(238,255,204)">sibling_soup.b.next_sibling# <c>text2</c>sibling_soup.c.previous_sibling# <b>text1</b></pre><div class="contentsignin">Copier après la connexion</div></div><p><strong><span style="font-size:18px"> 介绍到这里基本就可以实现我们的BeautifulSoup库爬取网页内容,而网页修改、删除等内容建议大家阅读文档。下一篇文章就再次爬取维基百科的程序语言的内容吧!希望文章对大家有所帮助,如果有错误或不足之处,还请海涵!建议大家阅读官方文档和《Python基础教程》书。</span><br><span style="font-size:18px; color:rgb(51,51,51); font-family:Arial; line-height:26px"> </span><span style="font-size:18px; font-family:Arial; line-height:26px"><span style="color:#ff0000"> (By:Eastmount 2015-3-25 下午6点</span></span><span style="font-size:18px; color:rgb(51,51,51); font-family:Arial; line-height:26px">

</span>//m.sbmmt.com/<span style="font-family:Arial; color:#ff0000"><span style="font-size:18px; line-height:26px">)</span></span></strong><br></p>

<p></p>

<p><br></p>

<p class="pmark"><br></p>

<p>

</p><p>Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!</p> </div>

</div>

<div style="height: 25px;">

<div class="wzconBq" style="display: inline-flex;">

<span>Étiquettes associées:</span>

<div class="wzcbqd">

<a onclick="hits_log(2,'www',this);" href-data="//m.sbmmt.com/fr/search?word=beautifulsoup" target="_blank">beautifulsoup</a> <a onclick="hits_log(2,'www',this);" href-data="//m.sbmmt.com/fr/search?word=python" target="_blank">python</a> <a onclick="hits_log(2,'www',this);" href-data="//m.sbmmt.com/fr/search?word=知识" target="_blank">知识</a> </div>

</div>

<div style="display: inline-flex;float: right; color:#333333;">source:php.cn</div>

</div>

<div class="wzconOtherwz">

<a href="//m.sbmmt.com/fr/faq/355982.html" title="Explication détaillée des méthodes, propriétés et itérateurs en Python">

<span>Article précédent:Explication détaillée des méthodes, propriétés et itérateurs en Python</span>

</a>

<a href="//m.sbmmt.com/fr/faq/356004.html" title="Utilisation des fonctions map() et réduire() en Python">

<span>Article suivant:Utilisation des fonctions map() et réduire() en Python</span>

</a>

</div>

<div class="wzconShengming">

<div class="bzsmdiv">Déclaration de ce site Web</div>

<div>Le contenu de cet article est volontairement contribué par les internautes et les droits d'auteur appartiennent à l'auteur original. Ce site n'assume aucune responsabilité légale correspondante. Si vous trouvez un contenu suspecté de plagiat ou de contrefaçon, veuillez contacter admin@php.cn</div>

</div>

<ins class="adsbygoogle"

style="display:block"

data-ad-format="autorelaxed"

data-ad-client="ca-pub-5902227090019525"

data-ad-slot="2507867629"></ins>

<script>

(adsbygoogle = window.adsbygoogle || []).push({});

</script>

<div class="wzconZzwz">

<div class="wzconZzwztitle">Derniers articles par auteur</div>

<ul>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots"></span>

<a target="_blank" href="//m.sbmmt.com/fr/faq/354750.html">Exemples de paramètres HTML pour les effets de police gras, italique, souligné, barré et autres</a>

</div>

<div>1970-01-01 08:00:00</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots"></span>

<a target="_blank" href="//m.sbmmt.com/fr/faq/338018.html">实现一个 Java 版的 Redis</a>

</div>

<div>1970-01-01 08:00:00</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots"></span>

<a target="_blank" href="//m.sbmmt.com/fr/faq/353509.html">La démo d'applet WeChat la plus simple</a>

</div>

<div>1970-01-01 08:00:00</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots"></span>

<a target="_blank" href="//m.sbmmt.com/fr/faq/356272.html">Introduction aux méthodes de fonctionnement simples de pandas.DataFrame (créer, indexer, ajouter et supprimer) en python</a>

</div>

<div>1970-01-01 08:00:00</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots"></span>

<a target="_blank" href="//m.sbmmt.com/fr/faq/354839.html">WeChat Mini Program : Exemple de mise en œuvre de l'effet d'onglets</a>

</div>

<div>1970-01-01 08:00:00</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots"></span>

<a target="_blank" href="//m.sbmmt.com/fr/faq/354423.html">Python construit des méthodes personnalisées pour embellir la sortie de la structure du dictionnaire</a>

</div>

<div>1970-01-01 08:00:00</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots"></span>

<a target="_blank" href="//m.sbmmt.com/fr/faq/350853.html">HTML5 : utilisez Canvas pour traiter la vidéo en temps réel</a>

</div>

<div>1970-01-01 08:00:00</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots"></span>

<a target="_blank" href="//m.sbmmt.com/fr/faq/346502.html">Asp.net utilise SignalR pour envoyer des images</a>

</div>

<div>1970-01-01 08:00:00</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots"></span>

<a target="_blank" href="//m.sbmmt.com/fr/faq/354842.html">Tutoriel de développement de programmes WeChat Mini-App() et Page() Présentation des fonctions</a>

</div>

<div>1970-01-01 08:00:00</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots"></span>

<a target="_blank" href="//m.sbmmt.com/fr/faq/356574.html">Explication détaillée de l'utilisation de Python Redis</a>

</div>

<div>1970-01-01 08:00:00</div>

</li>

</ul>

</div>

<div class="wzconZzwz">

<div class="wzconZzwztitle">Derniers numéros</div>

<div class="wdsyContent">

<div class="wdsyConDiv flexRow wdsyConDiv1">

<div class="wdcdContent flexColumn">

<a href="//m.sbmmt.com/fr/wenda/175783.html" target="_blank" title="Comment récupérer un texte Google Weather spécifique à l'aide de BeautifulSoup ?" class="wdcdcTitle">Comment récupérer un texte Google Weather spécifique à l'aide de BeautifulSoup ?</a>

<a href="//m.sbmmt.com/fr/wenda/175783.html" class="wdcdcCons">Comment trouver le texte du cours « New York City, USA » en Python à l'aide de BeautifulSo...</a>

<div class="wdcdcInfo flexRow">

<div class="wdcdcileft">

<span class="wdcdciSpan"> Depuis 2024-04-01 14:06:14</span>

</div>

<div class="wdcdciright flexRow">

<div class="wdcdcirdz flexRow ira"> <b class="wdcdcirdzi"></b>0 </div>

<div class="wdcdcirpl flexRow ira"><b class="wdcdcirpli"></b>1</div>

<div class="wdcdcirwatch flexRow ira"><b class="wdcdcirwatchi"></b>308</div>

</div>

</div>

</div>

</div>

<div class="wdsyConLine wdsyConLine2"></div>

</div>

</div>

<div class="wzconZt" >

<div class="wzczt-title">

<div>Rubriques connexes</div>

<a href="//m.sbmmt.com/fr/faq/zt" target="_blank">Plus>

</a>

</div>

<div class="wzcttlist">

<ul>

<li class="ul-li">

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythonkfgj"><img src="https://img.php.cn/upload/subject/202407/22/2024072214424826783.jpg?x-oss-process=image/resize,m_fill,h_145,w_220" alt="outils de développement Python" /> </a>

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythonkfgj" class="title-a-spanl" title="outils de développement Python"><span>outils de développement Python</span> </a>

</li>

<li class="ul-li">

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythondb"><img src="https://img.php.cn/upload/subject/202407/22/2024072214312147925.jpg?x-oss-process=image/resize,m_fill,h_145,w_220" alt="python emballé dans un fichier exécutable" /> </a>

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythondb" class="title-a-spanl" title="python emballé dans un fichier exécutable"><span>python emballé dans un fichier exécutable</span> </a>

</li>

<li class="ul-li">

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythonnzsm"><img src="https://img.php.cn/upload/subject/202407/22/2024072214301218201.jpg?x-oss-process=image/resize,m_fill,h_145,w_220" alt="ce que python peut faire" /> </a>

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythonnzsm" class="title-a-spanl" title="ce que python peut faire"><span>ce que python peut faire</span> </a>

</li>

<li class="ul-li">

<a target="_blank" href="//m.sbmmt.com/fr/faq/formatzpython"><img src="https://img.php.cn/upload/subject/202407/22/2024072214275096159.jpg?x-oss-process=image/resize,m_fill,h_145,w_220" alt="Comment utiliser le format en python" /> </a>

<a target="_blank" href="//m.sbmmt.com/fr/faq/formatzpython" class="title-a-spanl" title="Comment utiliser le format en python"><span>Comment utiliser le format en python</span> </a>

</li>

<li class="ul-li">

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythonjc"><img src="https://img.php.cn/upload/subject/202407/22/2024072214254329480.jpg?x-oss-process=image/resize,m_fill,h_145,w_220" alt="tutoriel python" /> </a>

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythonjc" class="title-a-spanl" title="tutoriel python"><span>tutoriel python</span> </a>

</li>

<li class="ul-li">

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythonhjblbz"><img src="https://img.php.cn/upload/subject/202407/22/2024072214252616529.jpg?x-oss-process=image/resize,m_fill,h_145,w_220" alt="Configuration des variables d'environnement Python" /> </a>

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythonhjblbz" class="title-a-spanl" title="Configuration des variables d'environnement Python"><span>Configuration des variables d'environnement Python</span> </a>

</li>

<li class="ul-li">

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythoneval"><img src="https://img.php.cn/upload/subject/202407/22/2024072214251549631.jpg?x-oss-process=image/resize,m_fill,h_145,w_220" alt="évaluation python" /> </a>

<a target="_blank" href="//m.sbmmt.com/fr/faq/pythoneval" class="title-a-spanl" title="évaluation python"><span>évaluation python</span> </a>

</li>

<li class="ul-li">

<a target="_blank" href="//m.sbmmt.com/fr/faq/scratchpyt"><img src="https://img.php.cn/upload/subject/202407/22/2024072214235344903.jpg?x-oss-process=image/resize,m_fill,h_145,w_220" alt="La différence entre scratch et python" /> </a>

<a target="_blank" href="//m.sbmmt.com/fr/faq/scratchpyt" class="title-a-spanl" title="La différence entre scratch et python"><span>La différence entre scratch et python</span> </a>

</li>

</ul>

</div>

</div>

</div>

</div>

<div class="phpwzright">

<ins class="adsbygoogle"

style="display:block"

data-ad-client="ca-pub-5902227090019525"

data-ad-slot="3653428331"

data-ad-format="auto"

data-full-width-responsive="true"></ins>

<script>

(adsbygoogle = window.adsbygoogle || []).push({});

</script>

<div class="wzrOne">

<div class="wzroTitle">Recommandations populaires</div>

<div class="wzroList">

<ul>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots wzrolr"></span>

<a style="height: auto;" title="Que signifie eval en python ?" href="//m.sbmmt.com/fr/faq/419793.html">Que signifie eval en python ?</a>

</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots wzrolr"></span>

<a style="height: auto;" title="Comment lire le contenu d'un fichier txt en python" href="//m.sbmmt.com/fr/faq/479676.html">Comment lire le contenu d'un fichier txt en python</a>

</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots wzrolr"></span>

<a style="height: auto;" title="fichier py ?" href="//m.sbmmt.com/fr/faq/418747.html">fichier py ?</a>

</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots wzrolr"></span>

<a style="height: auto;" title="Que signifie str en python" href="//m.sbmmt.com/fr/faq/419809.html">Que signifie str en python</a>

</div>

</li>

<li>

<div class="wzczzwzli">

<span class="layui-badge-dots wzrolr"></span>

<a style="height: auto;" title="Comment utiliser le format en python" href="//m.sbmmt.com/fr/faq/471817.html">Comment utiliser le format en python</a>

</div>

</li>

</ul>

</div>

</div>

<script src="https://sw.php.cn/hezuo/cac1399ab368127f9b113b14eb3316d0.js" type="text/javascript"></script>

<div class="wzrThree">

<div class="wzrthree-title">

<div>Tutoriels populaires</div>

<a target="_blank" href="//m.sbmmt.com/fr/course.html">Plus>

</a>

</div>

<div class="wzrthreelist swiper2">

<div class="wzrthreeTab swiper-wrapper">

<div class="check tabdiv swiper-slide" data-id="one">Tutoriels associés <div></div></div>

<div class="tabdiv swiper-slide" data-id="two">Recommandations populaires<div></div></div>

<div class="tabdiv swiper-slide" data-id="three">Derniers cours<div></div></div>

</div>

<ul class="one">

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/812.html" title="Le dernier didacticiel vidéo ThinkPHP 5.1 en première mondiale (60 jours pour devenir un expert PHP en ligne)" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/041/620debc3eab3f377.jpg" alt="Le dernier didacticiel vidéo ThinkPHP 5.1 en première mondiale (60 jours pour devenir un expert PHP en ligne)"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Le dernier didacticiel vidéo ThinkPHP 5.1 en première mondiale (60 jours pour devenir un expert PHP en ligne)" href="//m.sbmmt.com/fr/course/812.html">Le dernier didacticiel vidéo ThinkPHP 5.1 en première mondiale (60 jours pour devenir un expert PHP en ligne)</a>

<div class="wzrthreerb">

<div>1427568 <b class="kclbcollectb"></b></div>

<div class="courseICollection" data-id="812">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/74.html" title="Premier tutoriel d'introduction à PHP : Apprenez PHP en une semaine" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/068/6253d1e28ef5c345.png" alt="Premier tutoriel d'introduction à PHP : Apprenez PHP en une semaine"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Premier tutoriel d'introduction à PHP : Apprenez PHP en une semaine" href="//m.sbmmt.com/fr/course/74.html">Premier tutoriel d'introduction à PHP : Apprenez PHP en une semaine</a>

<div class="wzrthreerb">

<div>4277974 <b class="kclbcollectb"></b></div>

<div class="courseICollection" data-id="74">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/286.html" title="Tutoriel vidéo JAVA pour débutants" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/068/62590a2bacfd9379.png" alt="Tutoriel vidéo JAVA pour débutants"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Tutoriel vidéo JAVA pour débutants" href="//m.sbmmt.com/fr/course/286.html">Tutoriel vidéo JAVA pour débutants</a>

<div class="wzrthreerb">

<div>2578544 <b class="kclbcollectb"></b></div>

<div class="courseICollection" data-id="286">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/504.html" title="Tutoriel vidéo d'introduction base zéro à l'apprentissage de Python de Little Turtle" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/068/62590a67ce3a6655.png" alt="Tutoriel vidéo d'introduction base zéro à l'apprentissage de Python de Little Turtle"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Tutoriel vidéo d'introduction base zéro à l'apprentissage de Python de Little Turtle" href="//m.sbmmt.com/fr/course/504.html">Tutoriel vidéo d'introduction base zéro à l'apprentissage de Python de Little Turtle</a>

<div class="wzrthreerb">

<div>510352 <b class="kclbcollectb"></b></div>

<div class="courseICollection" data-id="504">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/2.html" title="Tutoriel d'introduction PHP base zéro" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/068/6253de27bc161468.png" alt="Tutoriel d'introduction PHP base zéro"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Tutoriel d'introduction PHP base zéro" href="//m.sbmmt.com/fr/course/2.html">Tutoriel d'introduction PHP base zéro</a>

<div class="wzrthreerb">

<div>867542 <b class="kclbcollectb"></b></div>

<div class="courseICollection" data-id="2">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

</ul>

<ul class="two" style="display: none;">

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/812.html" title="Le dernier didacticiel vidéo ThinkPHP 5.1 en première mondiale (60 jours pour devenir un expert PHP en ligne)" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/041/620debc3eab3f377.jpg" alt="Le dernier didacticiel vidéo ThinkPHP 5.1 en première mondiale (60 jours pour devenir un expert PHP en ligne)"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Le dernier didacticiel vidéo ThinkPHP 5.1 en première mondiale (60 jours pour devenir un expert PHP en ligne)" href="//m.sbmmt.com/fr/course/812.html">Le dernier didacticiel vidéo ThinkPHP 5.1 en première mondiale (60 jours pour devenir un expert PHP en ligne)</a>

<div class="wzrthreerb">

<div >1427568 temps d'étude</div>

<div class="courseICollection" data-id="812">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/286.html" title="Tutoriel vidéo JAVA pour débutants" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/068/62590a2bacfd9379.png" alt="Tutoriel vidéo JAVA pour débutants"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Tutoriel vidéo JAVA pour débutants" href="//m.sbmmt.com/fr/course/286.html">Tutoriel vidéo JAVA pour débutants</a>

<div class="wzrthreerb">

<div >2578544 temps d'étude</div>

<div class="courseICollection" data-id="286">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/504.html" title="Tutoriel vidéo d'introduction base zéro à l'apprentissage de Python de Little Turtle" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/068/62590a67ce3a6655.png" alt="Tutoriel vidéo d'introduction base zéro à l'apprentissage de Python de Little Turtle"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Tutoriel vidéo d'introduction base zéro à l'apprentissage de Python de Little Turtle" href="//m.sbmmt.com/fr/course/504.html">Tutoriel vidéo d'introduction base zéro à l'apprentissage de Python de Little Turtle</a>

<div class="wzrthreerb">

<div >510352 temps d'étude</div>

<div class="courseICollection" data-id="504">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/901.html" title="Introduction rapide au développement web front-end" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/067/64be28a53a4f6310.png" alt="Introduction rapide au développement web front-end"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Introduction rapide au développement web front-end" href="//m.sbmmt.com/fr/course/901.html">Introduction rapide au développement web front-end</a>

<div class="wzrthreerb">

<div >216284 temps d'étude</div>

<div class="courseICollection" data-id="901">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/234.html" title="Maîtrisez les didacticiels vidéo PS à partir de zéro" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/068/62611f57ed0d4840.jpg" alt="Maîtrisez les didacticiels vidéo PS à partir de zéro"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Maîtrisez les didacticiels vidéo PS à partir de zéro" href="//m.sbmmt.com/fr/course/234.html">Maîtrisez les didacticiels vidéo PS à partir de zéro</a>

<div class="wzrthreerb">

<div >899574 temps d'étude</div>

<div class="courseICollection" data-id="234">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

</ul>

<ul class="three" style="display: none;">

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/1648.html" title="[Web front-end] Démarrage rapide de Node.js" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/067/662b5d34ba7c0227.png" alt="[Web front-end] Démarrage rapide de Node.js"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="[Web front-end] Démarrage rapide de Node.js" href="//m.sbmmt.com/fr/course/1648.html">[Web front-end] Démarrage rapide de Node.js</a>

<div class="wzrthreerb">

<div >8224 temps d'étude</div>

<div class="courseICollection" data-id="1648">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/1647.html" title="Collection complète de cours full-stack de développement Web étranger" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/067/6628cc96e310c937.png" alt="Collection complète de cours full-stack de développement Web étranger"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Collection complète de cours full-stack de développement Web étranger" href="//m.sbmmt.com/fr/course/1647.html">Collection complète de cours full-stack de développement Web étranger</a>

<div class="wzrthreerb">

<div >6558 temps d'étude</div>

<div class="courseICollection" data-id="1647">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/1646.html" title="Aller au langage pratique GraphQL" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/067/662221173504a436.png" alt="Aller au langage pratique GraphQL"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Aller au langage pratique GraphQL" href="//m.sbmmt.com/fr/course/1646.html">Aller au langage pratique GraphQL</a>

<div class="wzrthreerb">

<div >5410 temps d'étude</div>

<div class="courseICollection" data-id="1646">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/1645.html" title="Le maître du ventilateur de 550 W apprend JavaScript à partir de zéro, étape par étape" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/067/662077e163124646.png" alt="Le maître du ventilateur de 550 W apprend JavaScript à partir de zéro, étape par étape"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Le maître du ventilateur de 550 W apprend JavaScript à partir de zéro, étape par étape" href="//m.sbmmt.com/fr/course/1645.html">Le maître du ventilateur de 550 W apprend JavaScript à partir de zéro, étape par étape</a>

<div class="wzrthreerb">

<div >746 temps d'étude</div>

<div class="courseICollection" data-id="1645">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

<li>

<a target="_blank" href="//m.sbmmt.com/fr/course/1644.html" title="Le maître Python Mosh, un débutant sans aucune connaissance de base peut commencer en 6 heures" class="wzrthreelaimg">

<img src="https://img.php.cn/upload/course/000/000/067/6616418ca80b8916.png" alt="Le maître Python Mosh, un débutant sans aucune connaissance de base peut commencer en 6 heures"/>

</a>

<div class="wzrthree-right">

<a target="_blank" title="Le maître Python Mosh, un débutant sans aucune connaissance de base peut commencer en 6 heures" href="//m.sbmmt.com/fr/course/1644.html">Le maître Python Mosh, un débutant sans aucune connaissance de base peut commencer en 6 heures</a>

<div class="wzrthreerb">

<div >27661 temps d'étude</div>

<div class="courseICollection" data-id="1644">

<b class="nofollow small-nocollect"></b>

</div>

</div>

</div>

</li>

</ul>

</div>

<script>

var mySwiper = new Swiper('.swiper2', {

autoplay: false,//可选选项,自动滑动

slidesPerView : 'auto',

})

$('.wzrthreeTab>div').click(function(e){

$('.wzrthreeTab>div').removeClass('check')

$(this).addClass('check')

$('.wzrthreelist>ul').css('display','none')

$('.'+e.currentTarget.dataset.id).show()

})

</script>

</div>

<div class="wzrFour">

<div class="wzrfour-title">

<div>Derniers téléchargements</div>

<a href="//m.sbmmt.com/fr/xiazai">Plus>

</a>

</div>

<script>

$(document).ready(function(){

var sjyx_banSwiper = new Swiper(".sjyx_banSwiperwz",{

speed:1000,

autoplay:{

delay:3500,

disableOnInteraction: false,

},

pagination:{

el:'.sjyx_banSwiperwz .swiper-pagination',

clickable :false,

},

loop:true

})

})

</script>

<div class="wzrfourList swiper3">

<div class="wzrfourlTab swiper-wrapper">

<div class="check swiper-slide" data-id="onef">effets Web <div></div></div>

<div class="swiper-slide" data-id="twof">Code source du site Web<div></div></div>

<div class="swiper-slide" data-id="threef">Matériel du site Web<div></div></div>

<div class="swiper-slide" data-id="fourf">Modèle frontal<div></div></div>

</div>

<ul class="onef">

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a target="_blank" title="Code de contact du formulaire de message d'entreprise jQuery" href="//m.sbmmt.com/fr/toolset/js-special-effects/8071">[bouton de formulaire] Code de contact du formulaire de message d'entreprise jQuery</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a target="_blank" title="Effets de lecture de boîte à musique HTML5 MP3" href="//m.sbmmt.com/fr/toolset/js-special-effects/8070">[Effets spéciaux du joueur] Effets de lecture de boîte à musique HTML5 MP3</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a target="_blank" title="Effets spéciaux du menu de navigation d'animation de particules cool HTML5" href="//m.sbmmt.com/fr/toolset/js-special-effects/8069">[Navigation dans les menus] Effets spéciaux du menu de navigation d'animation de particules cool HTML5</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a target="_blank" title="Code d'édition par glisser-déposer du formulaire visuel jQuery" href="//m.sbmmt.com/fr/toolset/js-special-effects/8068">[bouton de formulaire] Code d'édition par glisser-déposer du formulaire visuel jQuery</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a target="_blank" title="Code du lecteur de musique Kugou imitation VUE.JS" href="//m.sbmmt.com/fr/toolset/js-special-effects/8067">[Effets spéciaux du joueur] Code du lecteur de musique Kugou imitation VUE.JS</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a target="_blank" title="Jeu de boîte de poussée HTML5 classique" href="//m.sbmmt.com/fr/toolset/js-special-effects/8066">[effets spéciaux HTML5] Jeu de boîte de poussée HTML5 classique</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a target="_blank" title="défilement jQuery pour ajouter ou réduire des effets d'image" href="//m.sbmmt.com/fr/toolset/js-special-effects/8065">[Effets spéciaux d'image] défilement jQuery pour ajouter ou réduire des effets d'image</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a target="_blank" title="Effet de zoom de survol de la couverture de l'album personnel CSS3" href="//m.sbmmt.com/fr/toolset/js-special-effects/8064">[Effets d'album photo] Effet de zoom de survol de la couverture de l'album personnel CSS3</a>

</div>

</li>

</ul>

<ul class="twof" style="display:none">

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8328" title="Modèle de site Web d'entreprise de services de nettoyage et de réparation de décoration intérieure" target="_blank">[Modèle frontal] Modèle de site Web d'entreprise de services de nettoyage et de réparation de décoration intérieure</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8327" title="Modèle de page de guide de CV personnel aux couleurs fraîches" target="_blank">[Modèle frontal] Modèle de page de guide de CV personnel aux couleurs fraîches</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8326" title="Modèle Web de CV de travail créatif de concepteur" target="_blank">[Modèle frontal] Modèle Web de CV de travail créatif de concepteur</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8325" title="Modèle de site Web d'entreprise de construction d'ingénierie moderne" target="_blank">[Modèle frontal] Modèle de site Web d'entreprise de construction d'ingénierie moderne</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8324" title="Modèle HTML5 réactif pour les établissements de services éducatifs" target="_blank">[Modèle frontal] Modèle HTML5 réactif pour les établissements de services éducatifs</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8323" title="Modèle de site Web de centre commercial de boutique de livres électroniques en ligne" target="_blank">[Modèle frontal] Modèle de site Web de centre commercial de boutique de livres électroniques en ligne</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8322" title="La technologie informatique résout le modèle de site Web d'entreprise Internet" target="_blank">[Modèle frontal] La technologie informatique résout le modèle de site Web d'entreprise Internet</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8321" title="Modèle de site Web de service de trading de devises de style violet" target="_blank">[Modèle frontal] Modèle de site Web de service de trading de devises de style violet</a>

</div>

</li>

</ul>

<ul class="threef" style="display:none">

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-materials/3078" target="_blank" title="Matériau vectoriel d'éléments d'été mignons (EPS+PNG)">[Matériau PNG] Matériau vectoriel d'éléments d'été mignons (EPS+PNG)</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-materials/3077" target="_blank" title="Matériel vectoriel de quatre badges de graduation rouges 2023 (AI+EPS+PNG)">[Matériau PNG] Matériel vectoriel de quatre badges de graduation rouges 2023 (AI+EPS+PNG)</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-materials/3076" target="_blank" title="Oiseau chantant et chariot rempli de fleurs design matériel vectoriel de bannière de printemps (AI + EPS)">[image de bannière] Oiseau chantant et chariot rempli de fleurs design matériel vectoriel de bannière de printemps (AI + EPS)</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-materials/3075" target="_blank" title="Matériau vectoriel de chapeau de graduation doré (EPS+PNG)">[Matériau PNG] Matériau vectoriel de chapeau de graduation doré (EPS+PNG)</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-materials/3074" target="_blank" title="Matériel vectoriel d'icône de montagne de style noir et blanc (EPS+PNG)">[Matériau PNG] Matériel vectoriel d'icône de montagne de style noir et blanc (EPS+PNG)</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-materials/3073" target="_blank" title="Matériel vectoriel de silhouette de super-héros (EPS+PNG) avec des capes de couleurs différentes et des poses différentes">[Matériau PNG] Matériel vectoriel de silhouette de super-héros (EPS+PNG) avec des capes de couleurs différentes et des poses différentes</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-materials/3072" target="_blank" title="Matériel vectoriel de bannière Arbor Day de style plat (AI + EPS)">[image de bannière] Matériel vectoriel de bannière Arbor Day de style plat (AI + EPS)</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-materials/3071" target="_blank" title="Matériel vectoriel de neuf bulles de discussion explosives de style bande dessinée (EPS+PNG)">[Matériau PNG] Matériel vectoriel de neuf bulles de discussion explosives de style bande dessinée (EPS+PNG)</a>

</div>

</li>

</ul>

<ul class="fourf" style="display:none">

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8328" target="_blank" title="Modèle de site Web d'entreprise de services de nettoyage et de réparation de décoration intérieure">[Modèle frontal] Modèle de site Web d'entreprise de services de nettoyage et de réparation de décoration intérieure</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8327" target="_blank" title="Modèle de page de guide de CV personnel aux couleurs fraîches">[Modèle frontal] Modèle de page de guide de CV personnel aux couleurs fraîches</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8326" target="_blank" title="Modèle Web de CV de travail créatif de concepteur">[Modèle frontal] Modèle Web de CV de travail créatif de concepteur</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8325" target="_blank" title="Modèle de site Web d'entreprise de construction d'ingénierie moderne">[Modèle frontal] Modèle de site Web d'entreprise de construction d'ingénierie moderne</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8324" target="_blank" title="Modèle HTML5 réactif pour les établissements de services éducatifs">[Modèle frontal] Modèle HTML5 réactif pour les établissements de services éducatifs</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8323" target="_blank" title="Modèle de site Web de centre commercial de boutique de livres électroniques en ligne">[Modèle frontal] Modèle de site Web de centre commercial de boutique de livres électroniques en ligne</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8322" target="_blank" title="La technologie informatique résout le modèle de site Web d'entreprise Internet">[Modèle frontal] La technologie informatique résout le modèle de site Web d'entreprise Internet</a>

</div>

</li>

<li>

<div class="wzrfourli">

<span class="layui-badge-dots wzrflr"></span>

<a href="//m.sbmmt.com/fr/toolset/website-source-code/8321" target="_blank" title="Modèle de site Web de service de trading de devises de style violet">[Modèle frontal] Modèle de site Web de service de trading de devises de style violet</a>

</div>

</li>

</ul>

</div>

<script>

var mySwiper = new Swiper('.swiper3', {

autoplay: false,//可选选项,自动滑动

slidesPerView : 'auto',

})

$('.wzrfourlTab>div').click(function(e){

$('.wzrfourlTab>div').removeClass('check')

$(this).addClass('check')

$('.wzrfourList>ul').css('display','none')

$('.'+e.currentTarget.dataset.id).show()

})

</script>

</div>

</div>

</div>

<footer>

<div class="footer">

<div class="footertop">

<img src="/static/imghw/logo.png" alt="">

<p>Formation PHP en ligne sur le bien-être public,Aidez les apprenants PHP à grandir rapidement!</p>

</div>

<div class="footermid">

<a href="//m.sbmmt.com/fr/about/us.html">À propos de nous</a>

<a href="//m.sbmmt.com/fr/about/disclaimer.html">Clause de non-responsabilité</a>

<a href="//m.sbmmt.com/fr/update/article_0_1.html">Sitemap</a>

</div>

<div class="footerbottom">

<p>

© php.cn All rights reserved

</p>

</div>

</div>

</footer>

<input type="hidden" id="verifycode" value="/captcha.html">

<script>layui.use(['element', 'carousel'], function () {var element = layui.element;$ = layui.jquery;var carousel = layui.carousel;carousel.render({elem: '#test1', width: '100%', height: '330px', arrow: 'always'});$.getScript('/static/js/jquery.lazyload.min.js', function () {$("img").lazyload({placeholder: "/static/images/load.jpg", effect: "fadeIn", threshold: 200, skip_invisible: false});});});</script>

<script src="/static/js/common_new.js"></script>

<script type="text/javascript" src="/static/js/jquery.cookie.js?1736708178"></script>

<script src="https://vdse.bdstatic.com//search-video.v1.min.js"></script>

<link rel='stylesheet' id='_main-css' href='/static/css/viewer.min.css?2' type='text/css' media='all'/>

<script type='text/javascript' src='/static/js/viewer.min.js?1'></script>

<script type='text/javascript' src='/static/js/jquery-viewer.min.js'></script>

<script type="text/javascript" src="/static/js/global.min.js?5.5.53"></script>

<!-- Matomo -->

<script>

var _paq = window._paq = window._paq || [];

/* tracker methods like "setCustomDimension" should be called before "trackPageView" */

_paq.push(['trackPageView']);

_paq.push(['enableLinkTracking']);

(function() {

var u="https://tongji.php.cn/";

_paq.push(['setTrackerUrl', u+'matomo.php']);

_paq.push(['setSiteId', '9']);

var d=document, g=d.createElement('script'), s=d.getElementsByTagName('script')[0];

g.async=true; g.src=u+'matomo.js'; s.parentNode.insertBefore(g,s);

})();

</script>

<!-- End Matomo Code -->

</body>

</html>

Il est recommandé de se référer au chinois pour les méthodes d'utilisation spécifiques : //m.sbmmt.com/

Il est recommandé de se référer au chinois pour les méthodes d'utilisation spécifiques : //m.sbmmt.com/