Deepseek publie Deepgemm: une bibliothèque GEMM FP8 haute performance pour Ai

Dans le cadre de #OpenSourceweek, Deepseek a dévoilé DeepgeMM, une bibliothèque de pointe optimisée pour les multiplications efficaces de la matrice générale FP8 (GEMMS). Cette bibliothèque prend en charge les gemmes denses et du mélange de mélange (MOE), se révélant inestimable pour la formation et l'inférence du modèle V3 / R1. Deepgemm vise à augmenter considérablement les performances et l'efficacité des charges de travail de l'IA, renforçant l'engagement de Deepseek à l'innovation open source.

? Jour 3 de #OpenSourceweek: Deepgemm

Présentation de DeepgeMM - Une bibliothèque GEMM FP8 prenant en charge les gemms denses et Moe, alimentant la formation et l'inférence V3 / R1.

⚡ Jusqu'à 1350 fp8 tflops sur les gpus de trémie

✅ Dépendances minimales, conçues pour la facilité d'utilisation

✅ Compilé entièrement juste à temps…- Deepseek (@deepseek_ai) 26 février 2025

Cette version suit les lancements réussis de Deepseek Flashml (Jour 1) et Deepseek DeepPe (Jour 2).

Table des matières

Qu'est-ce que GEMM?

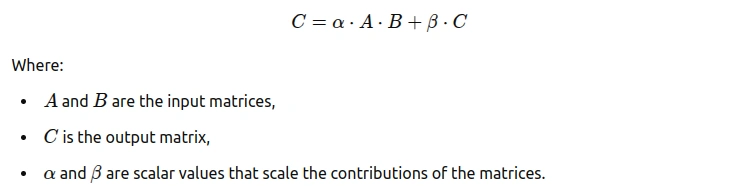

La multiplication de la matrice générale (GEMM) est une opération d'algèbre linéaire fondamentale multipliant deux matrices pour en produire un troisième. Largement utilisé dans de nombreuses applications, sa formule est:

GEMM est crucial pour l'optimisation des performances du modèle, en particulier dans l'apprentissage en profondeur pour la formation et l'inférence du réseau neuronal.

Cette illustration montre GEMM, mettant en évidence le carrelage (divisant les matrices en blocs plus petits - mtile, ntile, ktile) pour une utilisation optimisée du cache. Cela améliore les performances grâce à une localité et à un parallélisme améliorées.

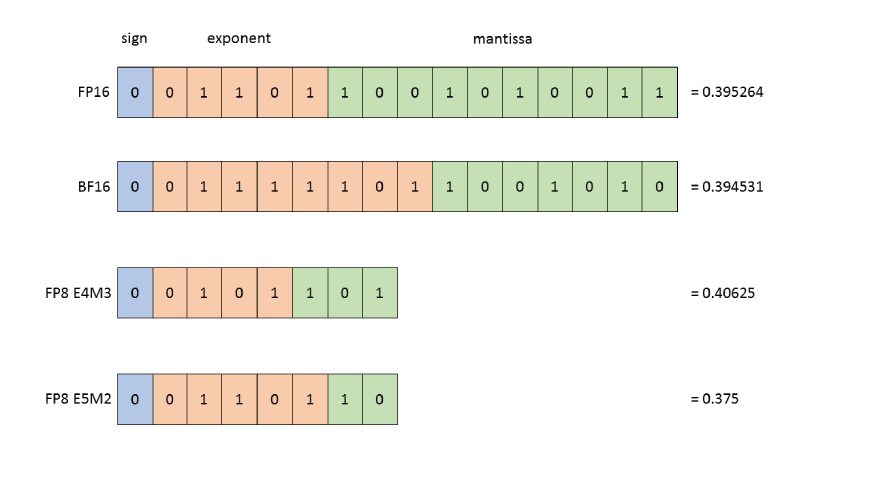

Qu'est-ce que FP8?

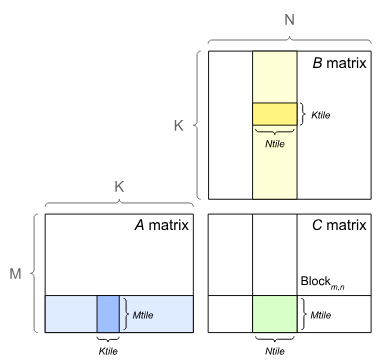

FP8 (point flottant 8 bits) est un format informatique haute performance offrant une précision réduite et une représentation efficace des données numériques. Il est particulièrement avantageux pour gérer les demandes de calcul des grands ensembles de données dans l'apprentissage automatique.

Le format FP8 typique comprend:

Cette structure compacte permet des calculs plus rapides et une utilisation réduite de la mémoire, idéale pour la formation de grands modèles. Bien que la précision puisse être légèrement compromise, cela est souvent acceptable, conduisant même à des gains de performance en raison d'une réduction des frais de calcul.

Cette image compare les formats FP8 (E4M3 et E5M2) avec FP16 et BF16, illustrant les compromis entre précision et plage pour différents formats à virgule flottante.

La nécessité de Deepgemm

Deepgemm relève des défis de multiplication de la matrice en offrant une bibliothèque légère, haute performance et conviviale pour diverses opérations GEMM.

Caractéristiques clés de Deepgemm

Les forces de Deepgemm incluent:

Benchmarks de performance

L'efficacité de Deepgemm sur diverses configurations de matrice est illustrée ci-dessous:

Tableau 1: Benchmarks de performance DeepGemm

Instructions d'installation

L'installation Deepgemm est simple:

Étape 1: Prérequis

Étape 2: cloner le référentiel

git clone --recursive [email protected]:deepseek-ai/DeepGEMM.git

Étape 3: Installez la bibliothèque

python setup.py install

Étape 4: Importer Deepgemm

import deep_gemm

Voir le référentiel DeepGemm Github pour des instructions détaillées.

Conclusion

Deepgemm est une bibliothèque FP8 GEMM FP8 à haute performance et conviviale idéale pour les tâches avancées d'apprentissage automatique. Sa conception légère, sa vitesse et sa flexibilité en font un outil précieux pour les développeurs d'IA. Consultez le blog Analytics Vidhya pour les mises à jour sur la version du jour 4 de Deepseek!

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

méthode d'appel du service Web

méthode d'appel du service Web

Introduction à l'utilisation de la fonction stickline

Introduction à l'utilisation de la fonction stickline

Que signifie Apache ?

Que signifie Apache ?

utilisation du format_numéro

utilisation du format_numéro

Comment supprimer des éléments de tableau en JavaScript

Comment supprimer des éléments de tableau en JavaScript

Introduction aux fournisseurs de services proposant des prix de serveur cloud rentables

Introduction aux fournisseurs de services proposant des prix de serveur cloud rentables

Comment acheter des pièces fil

Comment acheter des pièces fil

effondrement des frontières

effondrement des frontières