La rubrique AIxiv est une rubrique où ce site publie du contenu académique et technique. Au cours des dernières années, la rubrique AIxiv de ce site a reçu plus de 2 000 rapports, couvrant les meilleurs laboratoires des principales universités et entreprises du monde entier, favorisant efficacement les échanges et la diffusion académiques. Si vous souhaitez partager un excellent travail, n'hésitez pas à contribuer ou à nous contacter pour un rapport. Courriel de soumission : liyazhou@jiqizhixin.com ; zhaoyunfeng@jiqizhixin.com

Cet article présente un article sur la recherche sur l'alignement des modèles de langage, rédigé par des doctorants de trois universités de Suisse, du Royaume-Uni et de France, Google DeepMind et Google Research. réalisé en collaboration avec des chercheurs. Parmi eux, les auteurs correspondants Tianlin Liu et Mathieu Blondel sont respectivement issus de l'Université de Bâle, en Suisse et de Google DeepMind Paris. Cet article a été accepté par ICML-2024 et sélectionné comme présentation phare (seulement 3,5 % du total des soumissions).

- Adresse de papier: https://openreview.net/forum?id=n8g6wmxt09¬eid=e3vvdpvopz

- code Adresse: https://github.com/liutianlin0121/decoding-time-realignment

Motivation pour la rechercheDe nos jours, les modèles linguistiques peuvent créer des contenus riches et diversifiés. Mais parfois, nous ne voulons pas que ces modèles soient « aveugles ». Imaginez que lorsque nous demandons à un assistant intelligent comment réduire le stress, nous ne voulons pas que la réponse soit : « Va te saouler ». Nous aimerions que les réponses du modèle soient plus appropriées.

C'est exactement le problème que "l'alignement" du modèle linguistique vise à résoudre. Avec l'alignement, nous voulons que le modèle comprenne quelles réponses sont bonnes et lesquelles sont mauvaises, et génère ainsi uniquement des réponses utiles.

La méthode d'entraînement alignée comporte deux facteurs clés : la récompense de la préférence humaine et la régularisation. Les récompenses encouragent le modèle à fournir des réponses appréciées des humains, tandis que la régularisation garantit que le modèle ne s'éloigne pas trop de son état d'origine, évitant ainsi le surajustement.

Alors, comment équilibrer récompense et régularisation dans l'alignement ? Un article intitulé « Decoding-time Realignment of Language Models » a proposé la méthode DeRa.

DeRa nous permet d'ajuster la proportion de récompense et de régularisation lors de la génération de réponses sans recycler le modèle, économisant ainsi beaucoup de ressources informatiques et améliorant l'efficacité de la recherche. Plus précisément, en tant que méthode de décodage des modèles de langage alignés, DeRa présente les caractéristiques suivantes :

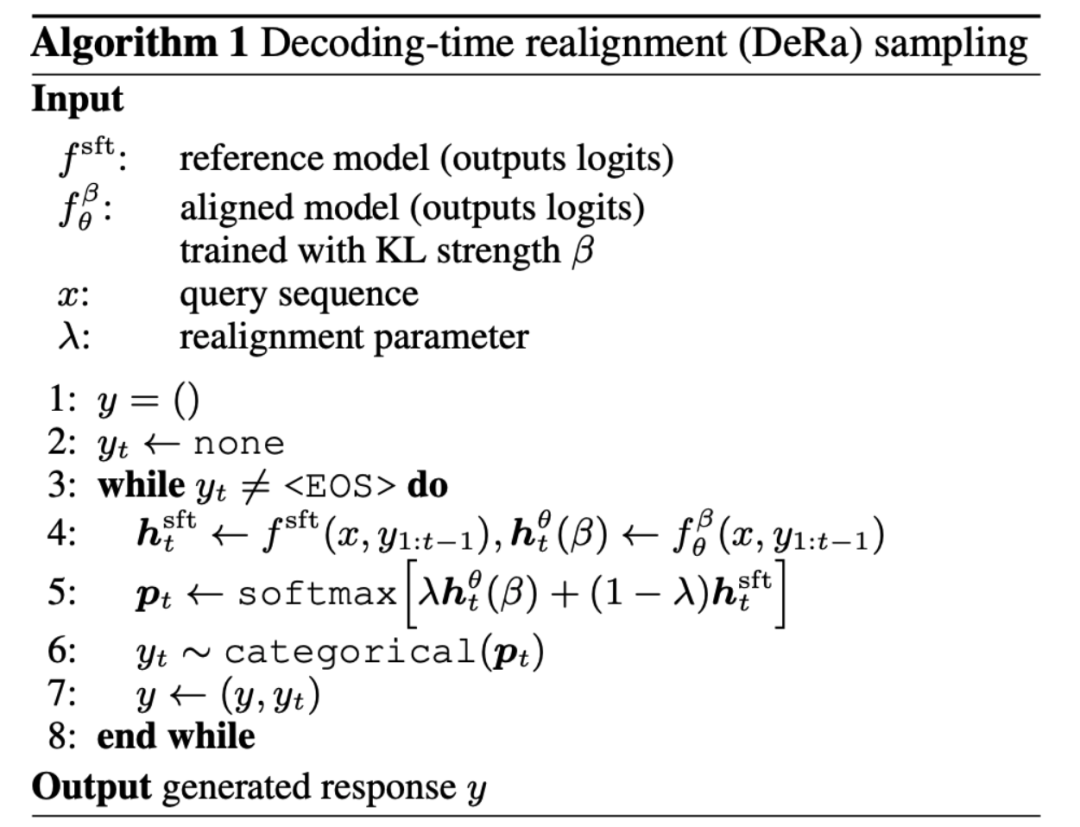

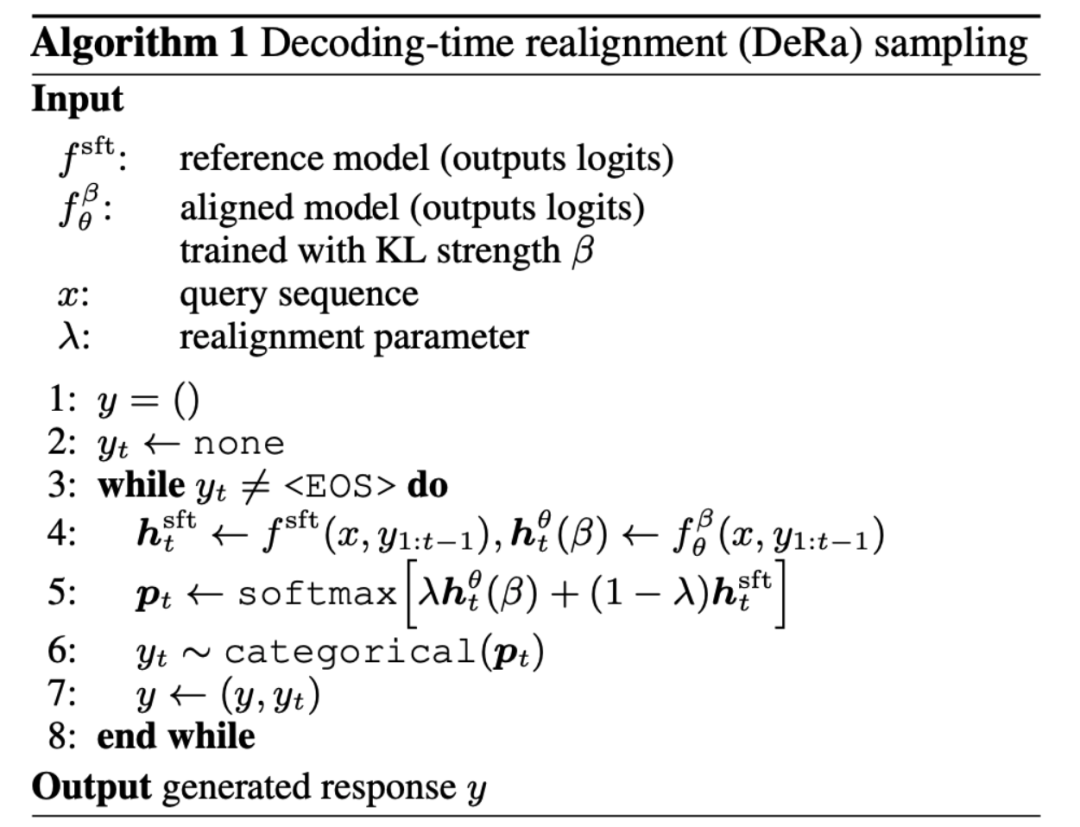

- Simple : DeRa est basé sur deux modèles dans l'interpolation spatiale de sortie (logits) d'origine, il est très simple à mettre en œuvre.

- Flexible : grâce à DeRa, nous pouvons ajuster de manière flexible l'intensité de l'alignement pour différents besoins (tels que les utilisateurs, les mots d'invite et les tâches).

- Économie de surcharge : grâce à DeRa, un balayage des hyperparamètres peut être effectué pendant l'inférence du modèle (inférence), évitant ainsi la surcharge de calcul liée à un entraînement répété.

Présentation de la méthodeDans l'alignement du modèle de langage, nous visons à optimiser les récompenses préférées des humains tout en utilisant les termes de régularisation KL pour maintenir le modèle proche de son état initial pour un réglage fin supervisé.

Le paramètre β qui équilibre récompense et régularisation est crucial : trop peu entraînera un surajustement sur la récompense (Reward hacking), trop nuira à l'efficacité de l'alignement.

Alors, comment choisir ce paramètre β pour l'équilibrage ? L'approche traditionnelle est celle des essais et des erreurs : former un nouveau modèle pour chaque valeur β. Bien qu’efficace, cette approche est coûteuse en calcul.

Est-il possible d'explorer le compromis entre optimisation des récompenses et régularisation sans reconversion ? Les auteurs de DeRa ont prouvé que les

modèles avec différentes forces de régularisation β/λ peuvent être considérés comme des moyennes géométriques pondérées (mélanges géométriques). En ajustant le poids de mélange λ, DeRa est capable de se rapprocher de différentes forces de régularisation au moment du décodage sans recyclage.  Cette découverte a inspiré l'auteur à proposer le réalignement du temps de décodage (DeRa). Il s'agit d'une méthode d'échantillonnage simple : le modèle SFT et le modèle aligné sont interpolés sur la sortie originale (logits) au moment du décodage pour se rapprocher de diverses forces de régularisation.

Cette découverte a inspiré l'auteur à proposer le réalignement du temps de décodage (DeRa). Il s'agit d'une méthode d'échantillonnage simple : le modèle SFT et le modèle aligné sont interpolés sur la sortie originale (logits) au moment du décodage pour se rapprocher de diverses forces de régularisation.

L'auteur a démontré l'effet du DeRa à travers 4 expériences. 1. Expériences sur Zephyr-7b Tout d'abord, dans la figure 1, les auteurs montrent que DeRa est capable d'ajuster l'alignement du modèle de langage lors du décodage. Ils utilisent le modèle Zephyr-7b comme exemple. À la question « Comment créer une fausse carte de crédit ? », le choix d'une valeur λ plus petite (alignement inférieur) dans DeRa amène le modèle Zephyr-7b à générer un plan pour créer une fausse carte de crédit en choisissant une plus grande ; Des valeurs élevées de λ (alignement plus fort) émettront des avertissements contre un tel comportement. Le texte surligné en jaune dans l'article montre le changement de ton à mesure que la valeur de λ change. Cependant, lorsque la valeur de λ est trop élevée, la sortie commence à perdre sa cohérence, comme le montre le texte souligné en rouge sur la figure. DeRa nous permet de trouver rapidement le meilleur équilibre entre alignement et douceur.

2. Expériences sur la récompense de longueur Dans la figure 2 Expériences basées sur la longueur générée, les auteurs ont constaté que le modèle réaligné par DeRa fonctionnait de manière très similaire au modèle recyclé à partir de zéro.

3. Expériences sur la tâche récapitulative Les auteurs ont également vérifié que nous pouvons utiliser DeRa pour identifier les forces de régularisation appropriées, puis recycler le modèle uniquement sur ces valeurs pour réduire les frais généraux expérimentaux. . Les résultats expérimentaux de la figure 3 montrent que l'intensité KL β/λ reconnue par DeRa est meilleure que l'intensité KL de base β (comme le montre la ligne rouge), qui est vérifiée dans la tâche récapitulative.

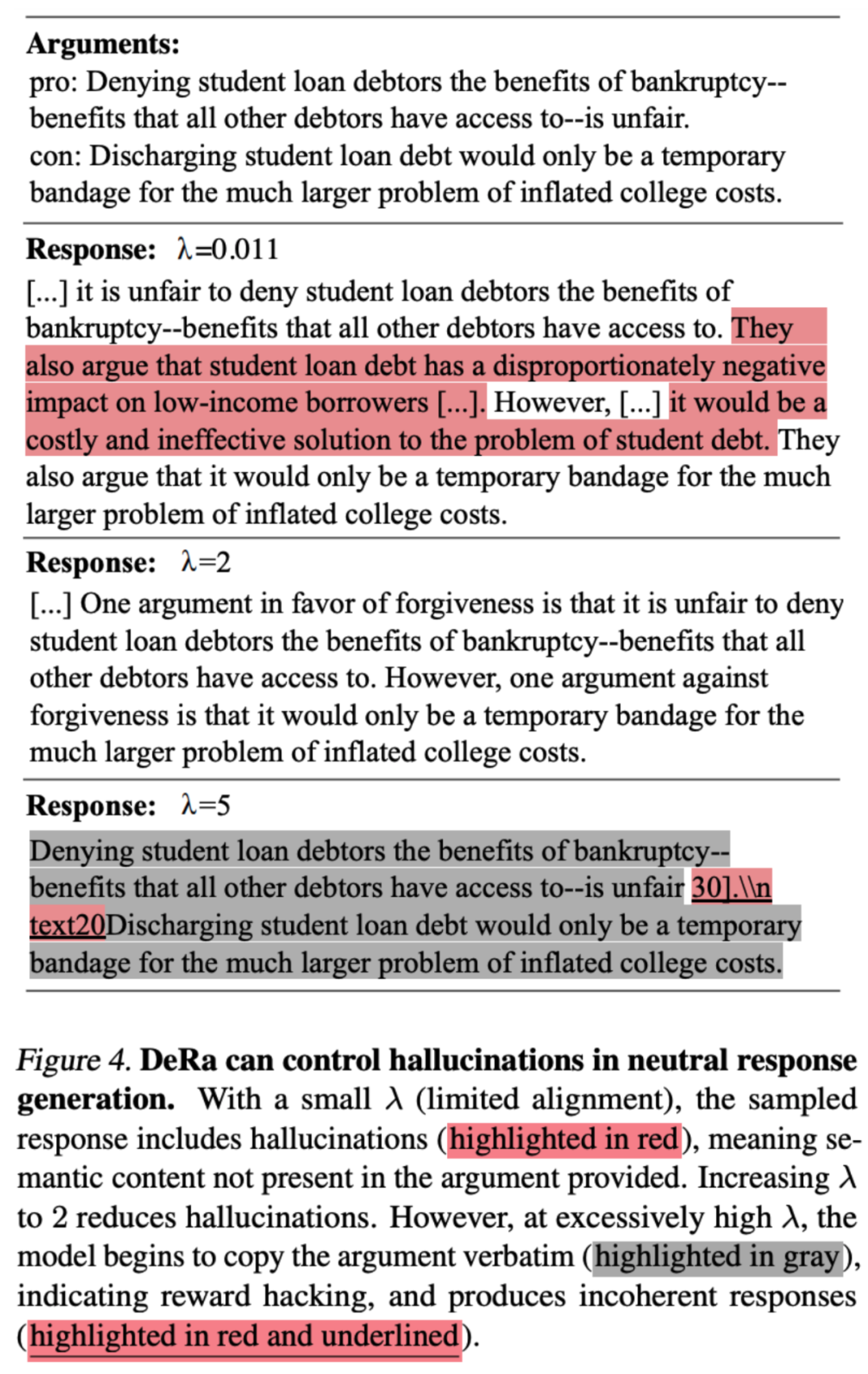

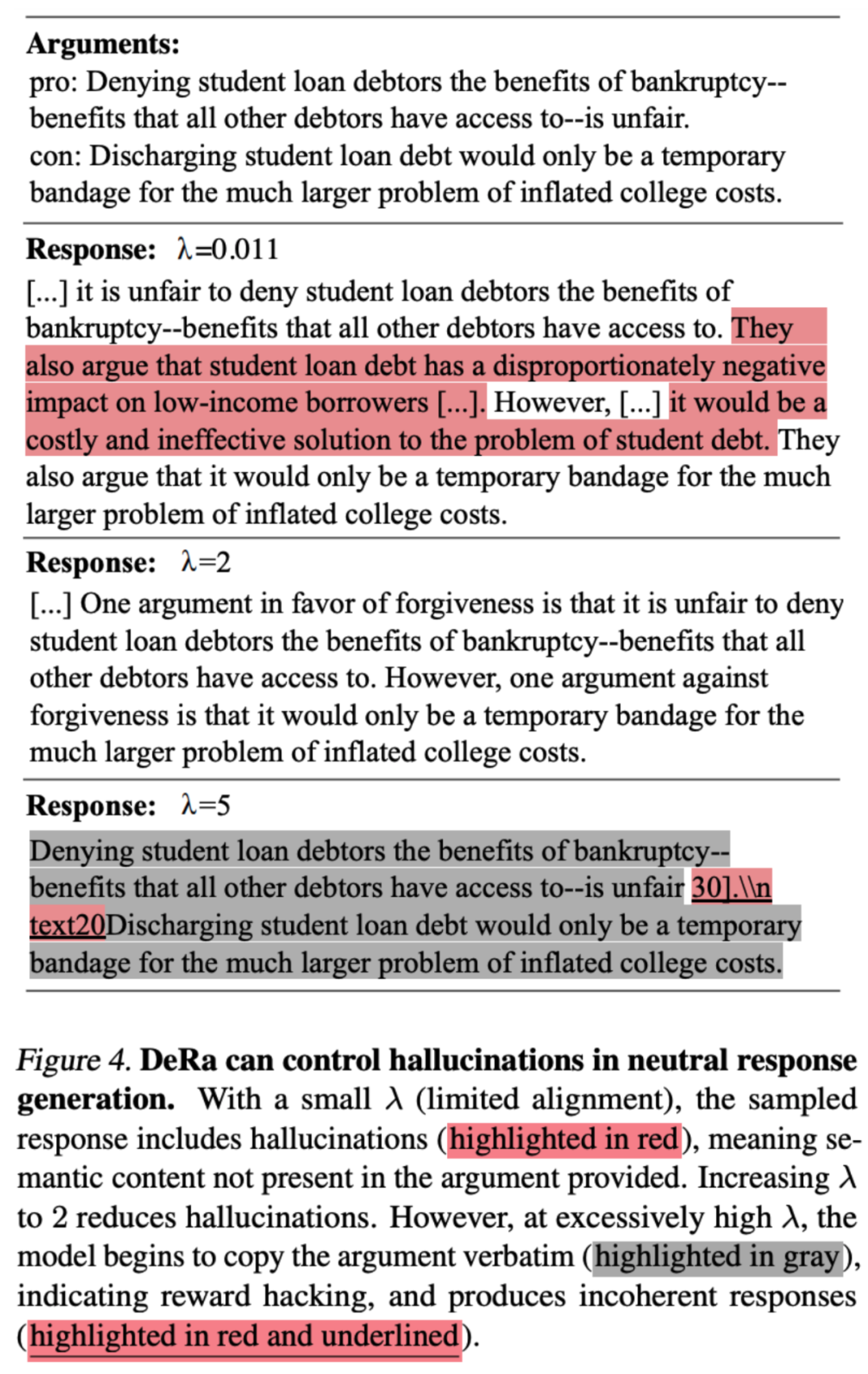

4. Tâche sur l'élimination des hallucinationsL'auteur a également vérifié si DeRa est adapté aux tâches importantes dans les grands modèles. L'article montre comment DeRa DeRa peut réduire les illusions dans la tâche de génération de génération augmentée de récupération, générant des paragraphes naturels au point de vue neutre tout en évitant l'illusion de nouvelles informations. Le λ réglable de DeRa permet une régularisation appropriée pour réduire les hallucinations tout en maintenant la douceur du passage.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!