DiT peut être utilisé pour générer des vidéos sans perte de qualité et sans formation requise.

La génération de vidéos IA en temps réel est arrivée !

Mercredi, l'équipe de You Yang de l'Université nationale de Singapour a proposé la première méthode de génération vidéo basée sur DiT du secteur pouvant être produite en temps réel.

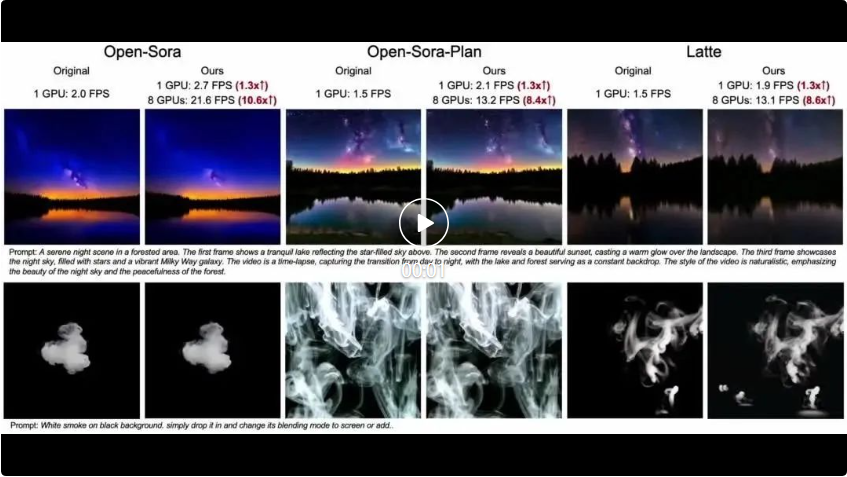

La technologie s'appelle Pyramid Attention Broadcast (PAB). En réduisant les calculs d'attention redondants, PAB atteint des fréquences d'images allant jusqu'à 21,6 FPS et une accélération de 10,6x sans sacrifier les avantages des modèles de génération vidéo populaires basés sur DiT, notamment la qualité Open-Sora, Open-Sora-Plan et Latte. Il convient de noter qu'en tant que méthode ne nécessitant pas de formation, PAB peut accélérer tout futur modèle de génération vidéo basé sur DiT, lui donnant la possibilité de générer de la vidéo en temps réel.

Depuis cette année, Sora d'OpenAI et d'autres modèles de génération vidéo basés sur DiT ont provoqué une autre vague dans le domaine de l'IA. Cependant, par rapport à la génération d'images, la génération vidéo se concentre essentiellement sur la qualité, et peu d'études se concentrent sur la manière d'accélérer l'inférence du modèle DiT. Accélérer l’inférence de modèles génératifs vidéo est déjà une priorité pour les applications d’IA générative.

L'émergence de la méthode PAB nous a ouvert une voie. Comparaison de la méthode originale et de la vitesse de génération vidéo PAB. L'auteur a testé 5 vidéos de résolution 480p 4s (192 images) sur Open-Sora.

diffusion d'attention de la pyramide

Récemment, Sora et d'autres modèles de génération vidéo basés sur DiT ont attiré une large attention. Cependant, par rapport à la génération d’images, peu d’études se sont concentrées sur l’accélération de l’inférence de modèles de génération vidéo basés sur DiT. De plus, le coût d’inférence lié à la génération d’une seule vidéo peut être élevé.散 Figure 1 : Différences entre les étapes de diffusion actuelles et les étapes de diffusion précédentes, et l'erreur différentielle (MSE) est quantifiée.Mise en œuvre

Cette étude révèle deux observations clés du mécanisme d'attention dans le transformateur de diffusion vidéo : Premièrement, la différence d'attention à différents pas de temps présente un motif en forme de U, au début et aux 15 dernières Le pourcentage de pas change de manière significative, tandis que les 70 % de pas du milieu sont très stables avec de petites différences.

Premièrement, la différence d'attention à différents pas de temps présente un motif en forme de U, au début et aux 15 dernières Le pourcentage de pas change de manière significative, tandis que les 70 % de pas du milieu sont très stables avec de petites différences.

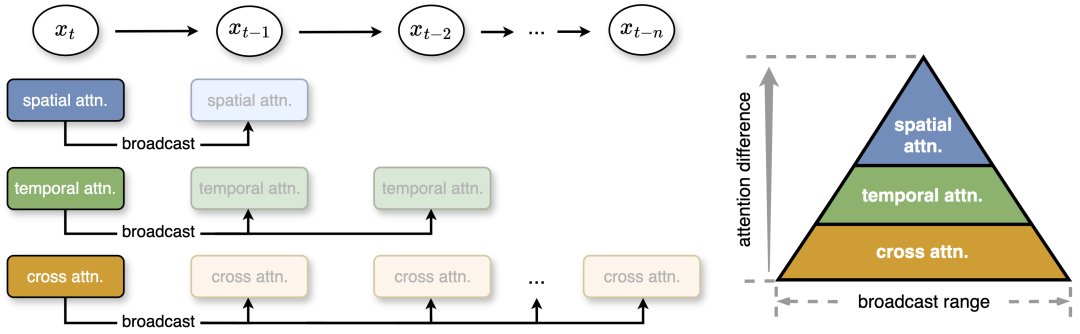

Deuxièmement, au sein du segment intermédiaire stable, il existe des différences entre les types d'attention : l'attention spatiale change le plus, impliquant des éléments à haute fréquence tels que les bords et les textures ; l'attention temporelle montre des changements à moyenne fréquence liés au mouvement et à la dynamique dans la vidéo ; L'attention intermodale est la plus stable, reliant le texte au contenu vidéo, similaire aux signaux basse fréquence reflétant la sémantique du texte. Sur cette base, l'équipe de recherche a proposé une diffusion pyramidale de l'attention pour réduire les calculs d'attention inutiles. Dans la partie médiane, l'attention montre de petites différences et l'étude diffuse le résultat de l'attention d'une étape de diffusion vers plusieurs étapes suivantes, réduisant ainsi considérablement le coût de calcul. De plus, pour un calcul plus efficace et une perte de qualité minimale, l'auteur définit différentes plages de diffusion en fonction de la stabilité et de la différence des différentes attentions. Même sans post-formation, cette stratégie simple mais efficace permet d'obtenir des accélérations allant jusqu'à 35 % avec une perte de qualité négligeable dans le contenu généré.

Figure 2 : Cette étude propose une diffusion d'attention pyramidale, dans laquelle différentes plages de diffusion sont définies pour trois attentions en fonction des différences d'attention. Plus le changement d’attention est faible, plus la portée de diffusion est large. Au moment de l'exécution, la méthode diffuse les résultats de l'attention aux étapes suivantes pour éviter les calculs d'attention redondants. x_t fait référence aux caractéristiques au pas de temps t.

Parallèle

La figure 3 ci-dessous montre la comparaison entre la méthode décrite dans cet article et la Dynamic Sequence Paralle (DSP) originale. Lorsque l’attention temporelle se propage, alors toute communication peut être évitée.

Afin d'améliorer encore la vitesse de génération vidéo, cet article utilise le DSP pour améliorer le parallélisme des séquences. Sequence Parallel divise la vidéo en différentes parties sur plusieurs GPU, réduisant ainsi la charge de travail sur chaque GPU et la latence de construction. Cependant, le DSP introduit une surcharge de communication importante, nécessitant du temps et de l'attention pour préparer deux communications tout-à-tout.

En propageant l'attention temporelle dans PAB, cet article n'a plus besoin de calculer l'attention temporelle, réduisant ainsi la communication. En conséquence, la surcharge de communication est considérablement réduite de plus de 50 %, permettant une inférence distribuée plus efficace pour la génération vidéo en temps réel.

Résultats de l'évaluation

Accélération

La figure suivante montre la latence PAB totale mesurée par différents modèles lors de la génération d'une seule vidéo sur 8 GPU NVIDIA H100. En utilisant un seul GPU, les auteurs ont obtenu une accélération de 1,26 à 1,32x et sont restés stables sur différents planificateurs.

Lorsqu'elle est étendue à plusieurs GPU, cette méthode a atteint une accélération de 10,6x et a bénéficié d'améliorations efficaces du parallélisme séquentiel pour obtenir une expansion quasi linéaire avec le nombre de GPU.

Résultats qualitatifs

Les trois vidéos suivantes sont respectivement Open-Sora, Open-Sora-Plan et Latte. Trois modèles différents utilisent la méthode originale pour comparer les effets de la méthode présentée dans cet article. On peut voir que la méthode décrite dans cet article permet d'atteindre différents degrés d'accélération FPS sous différents nombres de GPU.

Résultats quantitatifs

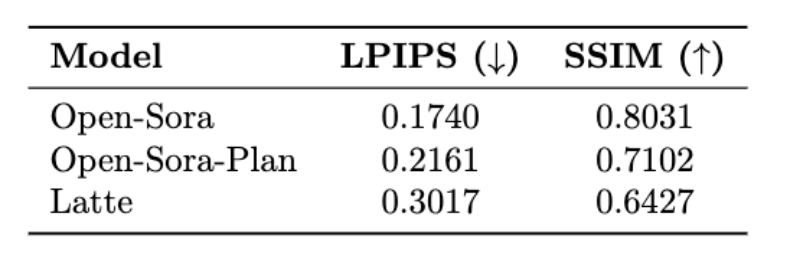

Le tableau suivant présente les LPIPS (Learning Perceptual Image Patch Similarity) et SSIM (Structural Similarity) des trois modèles d'Open-Sora, Open-Sora-Plan et Latte ).

Plus de détails techniques et de résultats d'évaluation seront disponibles dans le prochain article.

Adresse du projet : https://oahzxl.github.io/PAB/

Lien de référence :

https://oahzxl.github.io/PAB/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment devenir un ami proche sur TikTok

Comment devenir un ami proche sur TikTok

Comment configurer Douyin pour empêcher tout le monde de voir l'œuvre

Comment configurer Douyin pour empêcher tout le monde de voir l'œuvre

Introduction aux commandes courantes de postgresql

Introduction aux commandes courantes de postgresql

utilisation du champ d'application de la transaction

utilisation du champ d'application de la transaction

Comment vérifier le plagiat sur CNKI Étapes détaillées pour vérifier le plagiat sur CNKI

Comment vérifier le plagiat sur CNKI Étapes détaillées pour vérifier le plagiat sur CNKI

Que signifie le concept de métaverse ?

Que signifie le concept de métaverse ?

Tableau de comparaison des codes ASCII

Tableau de comparaison des codes ASCII

Comment ouvrir Python après son installation

Comment ouvrir Python après son installation