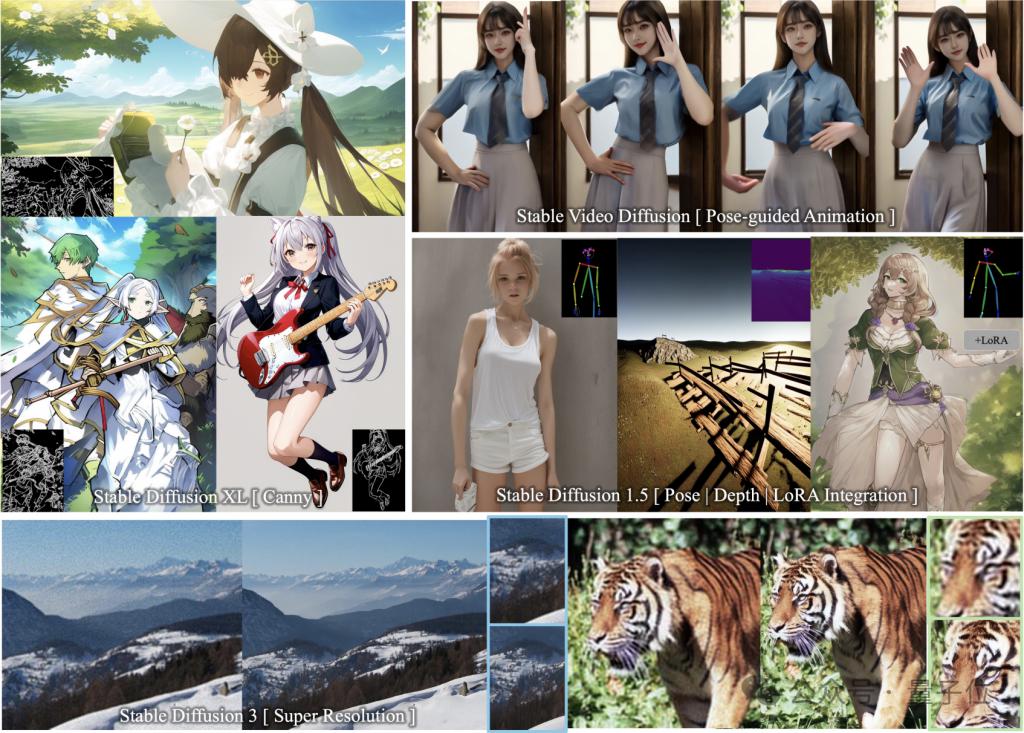

Use less than 10% of the training parameters to achieve the same controllable generation as ControlNet!

And common models of the Stable Diffusion family such as SDXL and SD1.5 can be adapted, and it is still plug-and-play.

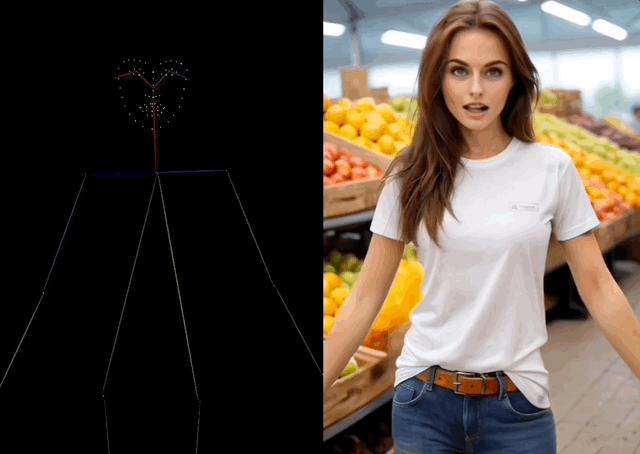

At the same time, it can also be used with SVD to control video generation, and the movement details can be controlled accurately down to the fingers.

Behind these images and videos is ControlNeXt, an open source image/video generation guidance tool launched by the Hong Kong Chinese Jiajiaya team.

You can see from the name that the R&D team has positioned it as the next generation ControlNet.

Like the classic work ResNeXt (an extension of ResNet) by the great gods He Kaiming and Xie Saining, the name is also based on this method.

Some netizens believe that this name is well deserved and it is indeed the next generation product, raising ControlNet to a higher level.

Some people also bluntly said that ControlNeXt is a game changer, which has greatly improved the efficiency of controllable generation. They look forward to seeing the works created by people using it.

Spider-Man dances with beauty

ControlNeXt supports a variety of SD series models and is plug-and-play.

It includes image generation models SD1.5, SDXL, SD3 (supporting Super Resolution), and video generation model SVD.

Not much to say, let’s just look at the results.

You can see that by adding edge (Canny) guidance in SDXL, the drawn two-dimensional girl and the control lines fit almost perfectly.

Even if the control contours are numerous and detailed, the model can still draw pictures that meet the requirements.

And seamlessly integrates with other LoRA weights without additional training.

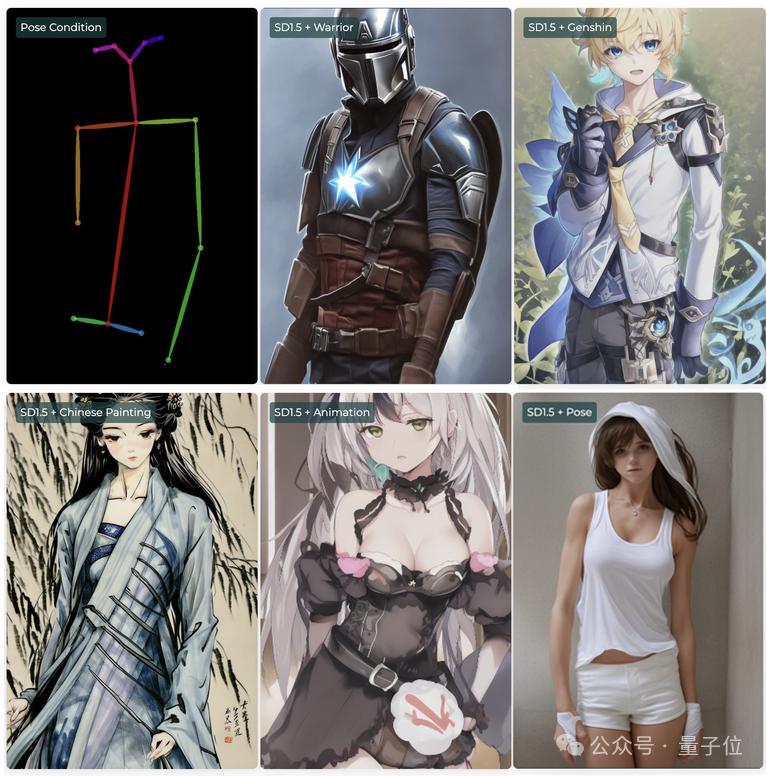

For example, in SD1.5, you can use posture (Pose) control conditions with various LoRA to form characters with different styles or even across dimensions, but with the same actions.

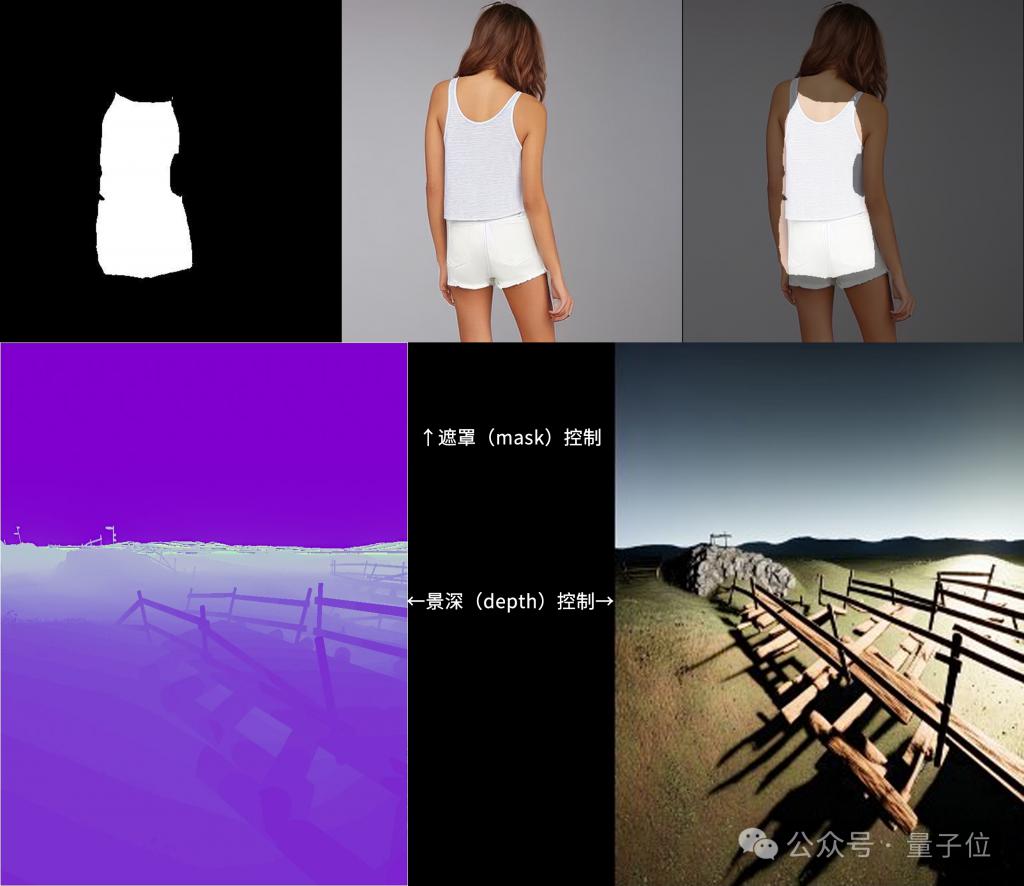

In addition, ControlNeXt also supports mask and depth control modes.

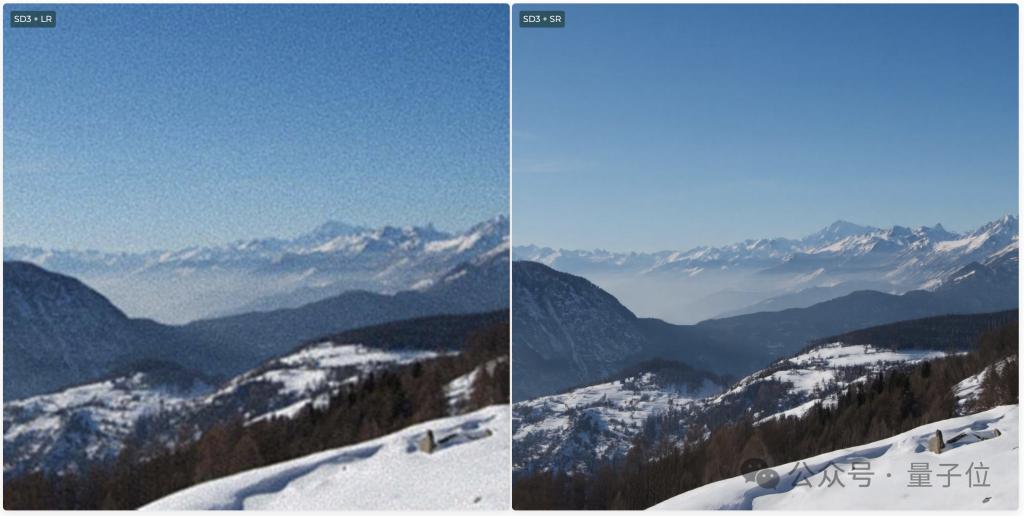

SD3 also supports Super Resolution, which can generate ultra-high-definition images.

During video generation, ControlNeXt can control character movements.

For example, let Spider-Man dance the beautiful dance in TikTok, and even the finger movements are imitated quite accurately.

He even made a chair grow hands and perform the same dance. Although it is a bit abstract, the action reproduction is pretty good.

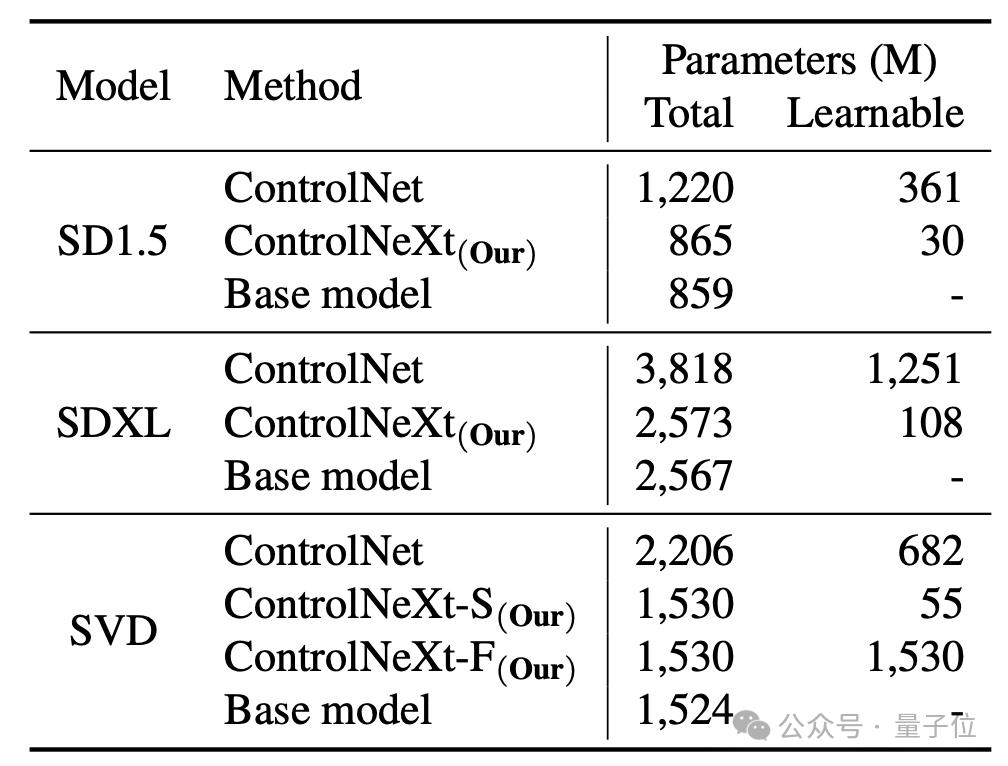

And compared to the original ControlNet, ControlNeXt requires fewer training parameters and converges faster.

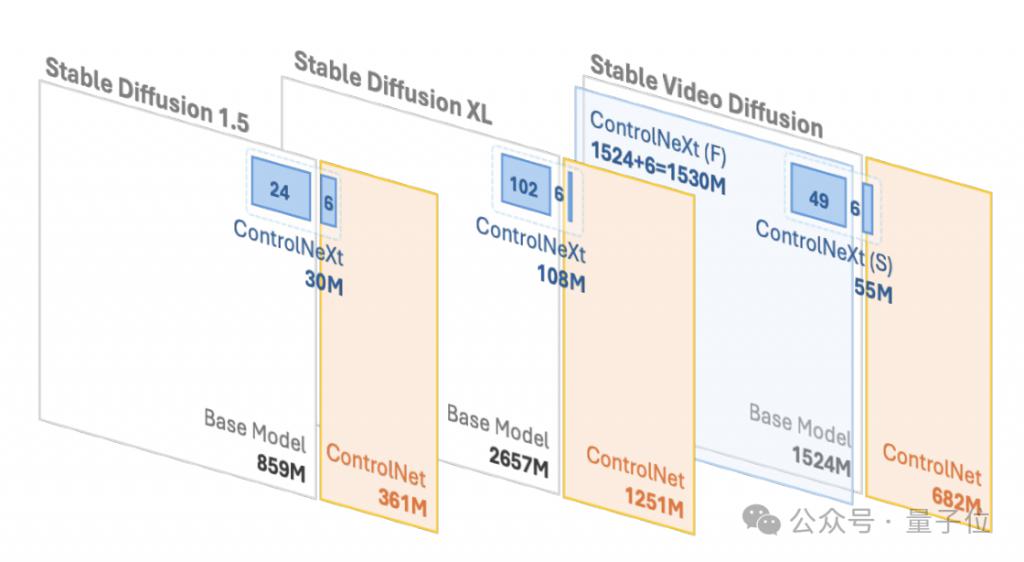

For example, in SD1.5 and SDXL, ControlNet requires 361 million and 1.251 billion learnable parameters respectively, but ControlNeXt only requires 30 million and 108 million respectively, less than 10% of ControlNet.

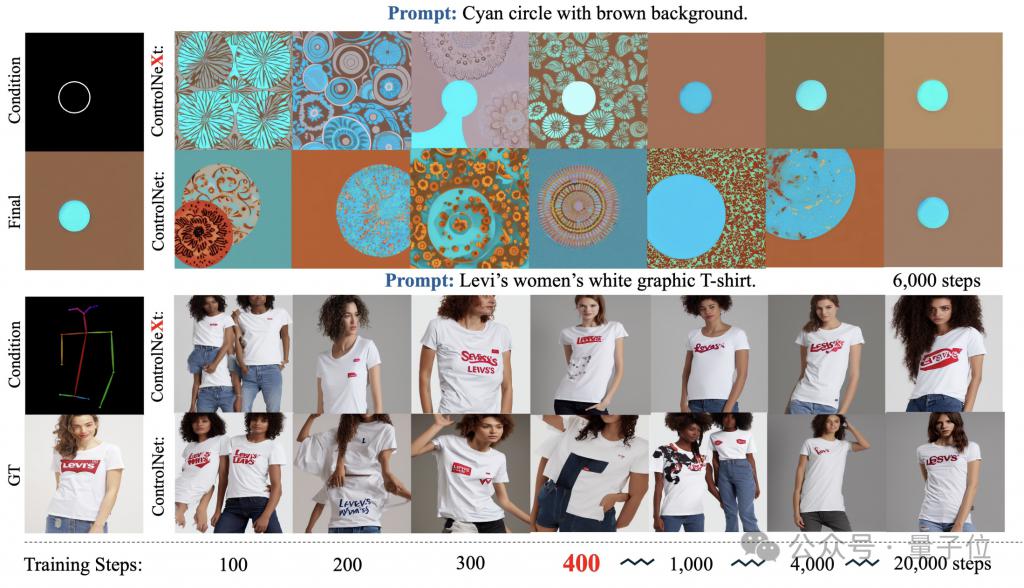

トレーニング プロセス中、ControlNeXt は約 400 ステップで収束に近づきますが、ControlNet はその 10 倍、場合によっては数十倍のステップ数を必要とします。

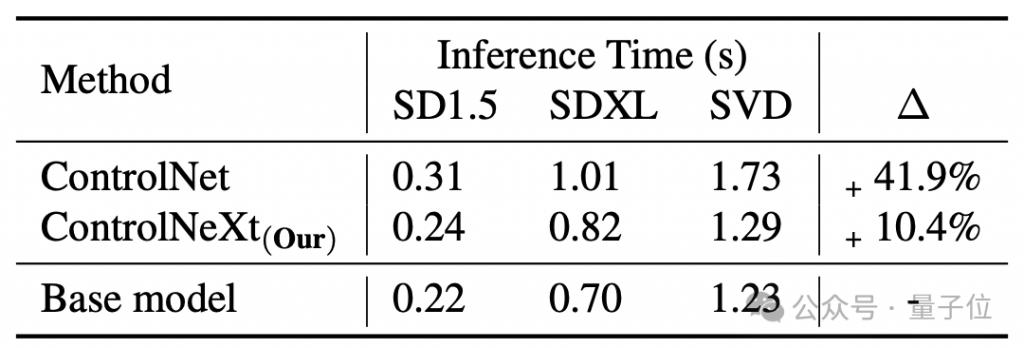

平均すると、ControlNet は基本モデルと同等であり、41.9% の遅延が生じますが、ControlNeXt はわずかです。 10.4%。

それでは、ControlNeXt はどのように実装され、ControlNet にはどのような改善が加えられたのでしょうか?

より軽量な条件付き制御モジュール

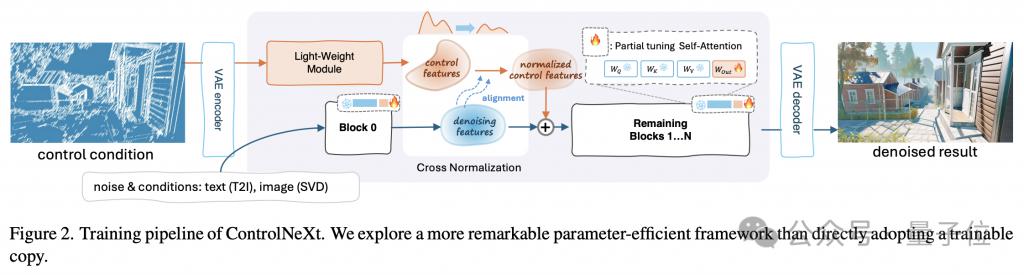

最初に図を使用して、ControlNeXt のワークフロー全体を理解します。

軽量化の鍵は、ControlNeXt が ControlNet の巨大な制御ブランチを削除し、代わりに少数の ResNet レベルで構成される軽量の制御ブランチを導入することです。畳み込みモジュール。

このモジュールは、制御条件の特徴表現 (セマンティック セグメンテーション マスク、キー ポイント事前分布など) を抽出する役割を果たします。

トレーニング パラメーターの量は通常、ControlNet の事前トレーニング済みモデルの 10% 未満ですが、それでも入力された条件付き制御情報を十分に学習できるこの設計により、コンピューティングのオーバーヘッドとメモリ使用量が大幅に削減されます。 。

具体的には、事前トレーニングされたモデルのさまざまなネットワーク層から等間隔でサンプリングして、トレーニングに使用されるパラメーターのサブセットを形成しますが、残りのパラメーターはフリーズされます。

さらに、研究チームは ControlNeXt のアーキテクチャを設計する際に、元のアーキテクチャとのモデル構造の一貫性も維持し、プラグインを実現しました。そして遊ぶ。

ControlNet であっても ControlNeXt であっても、条件付き制御情報の注入は重要なリンクです。

このプロセス中、ControlNeXt 研究チームは、注入位置の選択と注入方法の設計という 2 つの重要な問題について徹底的な調査を実施しました。

研究チームは、ほとんどの制御可能な生成タスクでは、生成をガイドするための条件付き情報の形式が比較的単純で、ノイズ除去プロセスの機能と高度に相関していることを観察しました。

そこでチームは、ノイズ除去ネットワークのすべての層に制御情報を注入する必要はないと考え、条件付き機能とノイズ除去機能をネットワークの中間層にのみ集約することにしました。

集計方法も可能な限りシンプルです。相互正規化を使用して 2 つの特徴セットの分布を調整した後、それらを直接追加します。

これにより、制御信号がノイズ除去プロセスに確実に影響を与えるだけでなく、追加の学習パラメーターの導入やアテンション メカニズムなどの複雑な操作による不安定性も回避されます。

クロス正規化も ControlNeXt のもう 1 つのコア テクノロジであり、これまで一般的に使用されていたゼロ畳み込みなどのプログレッシブ初期化戦略に代わるものです。

従来の方法では、新しいモジュールの影響を最初から徐々に解放することで崩壊の問題を軽減しますが、その結果、多くの場合、収束が遅くなります。

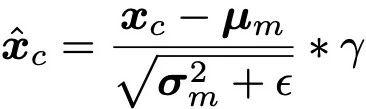

相互正規化では、バックボーン ネットワークのノイズ除去特徴の平均 μ と分散 σ を直接使用して、制御モジュールによって出力された特徴を正規化し、2 つのデータ分布が可能な限り揃うようにします。

(注: は数値安定性のために追加される小さな定数であり、γ はスケーリング パラメーターです。)

Normalization 正規化された次に、制御機能は、スケールおよびオフセット パラメーターを通じて振幅とベースラインが調整され、ノイズ除去機能に追加されます。これにより、パラメーターの初期化の感度が回避されるだけでなく、トレーニングの初期段階で制御条件が有効になるため、トレーニングが高速化されます。収束プロセス。

さらに、ControlNeXt は、制御モジュールを使用して条件情報の潜在空間特徴へのマッピングを学習し、より抽象的かつセマンティックにし、目に見えない制御条件への一般化を促進します。

プロジェクトホームページ:

https://pbihao.github.io/projects/controlnext/index.html

紙のアドレス: # #

https://arxiv.org/abs/2408.06070 GitHub: https://github.com/dvlab-research/ControlNeXt# #The above is the detailed content of Spider-Man dances seductively, and the next generation of ControlNet is here! Launched by the Jiajiaya team, it is plug-and-play and can also control video generation. For more information, please follow other related articles on the PHP Chinese website!