Vor nicht allzu langer Zeit wurde OpenAI Sora mit seinen erstaunlichen Videogenerierungseffekten schnell populär, machte seine Unterschiede zu anderen Vincent-Videomodellen deutlich und rückte in den Mittelpunkt weltweiter Aufmerksamkeit.

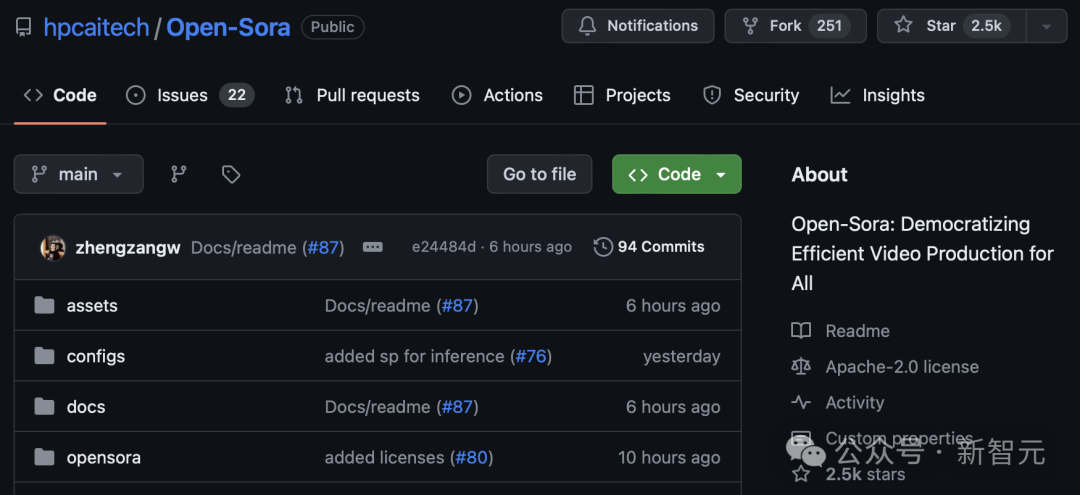

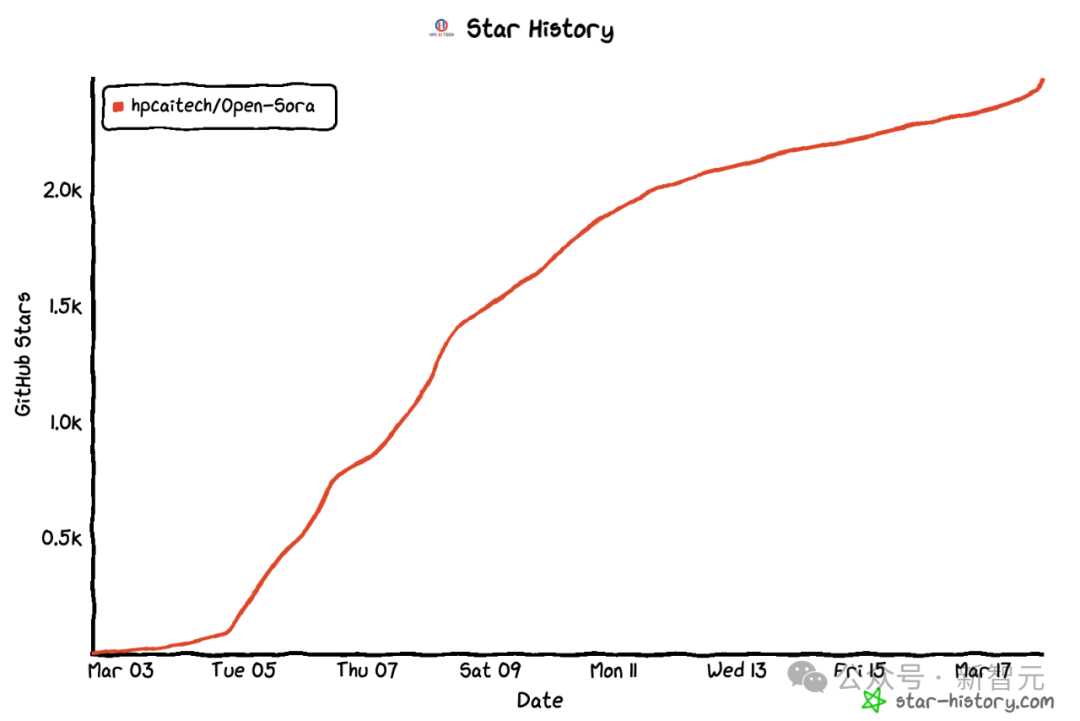

Nach der Einführung des Prozesses zur Reproduktion von Sora-Trainingsinferenzen mit einer Kostenreduzierung von 46 % vor zwei Wochen hat das Colossal-AI-Team das weltweit erste Sora-ähnliche Architektur-Videogenerierungsmodell „Open-Sora 1.0“ vollständig als Open-Source-Lösung bereitgestellt - deckt den gesamten Trainingsprozess ab, einschließlich der Datenverarbeitung, aller Trainingsdetails und Modellgewichte. Schließen Sie sich mit globalen KI-Enthusiasten zusammen, um eine neue Ära der Videoerstellung voranzutreiben.

Open-Sora Open-Source-Adresse: https://github.com/hpcaitech/Open-Sora

Open-Sora Open-Source-Adresse: https://github.com/hpcaitech/Open-Sora

Für einen kleinen Vorgeschmack werfen wir einen Blick auf „Open-Sora“, veröffentlicht von Das vom Colossal-AI-Team 1.0" modellgenerierte Schnappschussvideo der geschäftigen Stadt.

... oben Wensheng-Video Schulungsdetails, Datenvorverarbeitungsprozess, Demo-Anzeige und detailliertes Tutorial für die ersten Schritte Das Colossal-AI-Team wurde vollständig und kostenlos als Open Source auf GitHub bereitgestellt.

Xinzhiyuan kontaktierte das Team so schnell wie möglich und erfuhr, dass es weiterhin Open-Sora-bezogene Lösungen und neueste Entwicklungen aktualisieren wird. Interessierte Freunde können über die Open-Source-Community von Open-Sora auf dem Laufenden bleiben. Umfassende Interpretation der Replikationslösung von Sora Optimierungsstrategien.

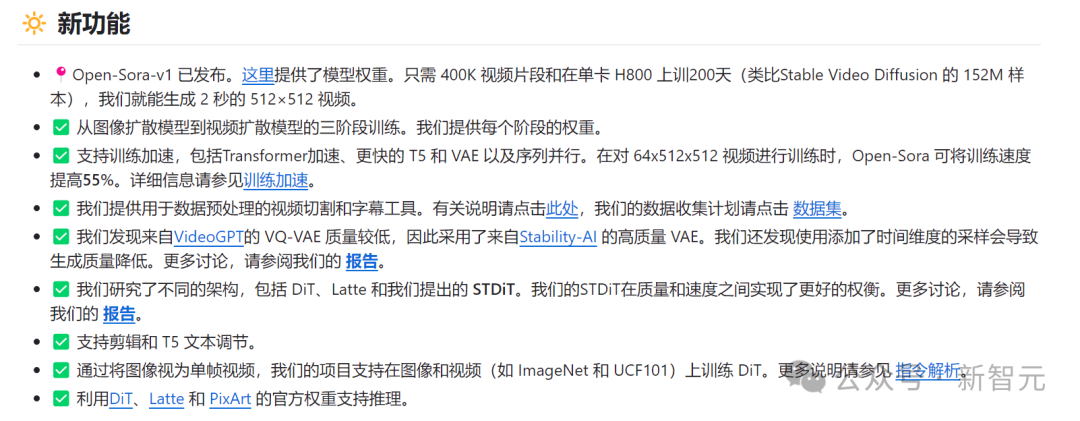

Modellarchitekturdesign

Das Modell übernimmt die derzeit beliebte Diffusion Transformer (DiT) [1]-Architektur.

Das Autorenteam verwendet das hochwertige Open-Source-Vincent-Graphmodell PixArt-α [2], das ebenfalls die DiT-Architektur als Basis verwendet, führt auf dieser Basis die zeitliche Aufmerksamkeitsschicht ein und erweitert sie auf Videodaten .

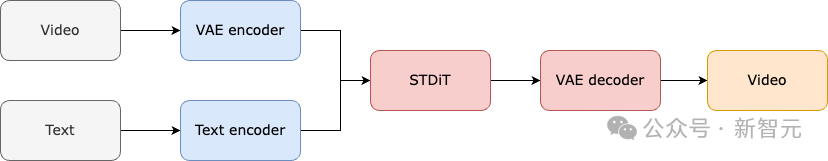

Konkret umfasst die gesamte Architektur ein vortrainiertes VAE, einen Text-Encoder und ein STDiT-Modell (Spatial Temporal Diffusion Transformer), das den räumlich-zeitlichen Aufmerksamkeitsmechanismus nutzt.

Konkret umfasst die gesamte Architektur ein vortrainiertes VAE, einen Text-Encoder und ein STDiT-Modell (Spatial Temporal Diffusion Transformer), das den räumlich-zeitlichen Aufmerksamkeitsmechanismus nutzt.

Unter diesen ist die Struktur jeder Schicht von STDiT in der folgenden Abbildung dargestellt. Es verwendet eine serielle Methode, um ein eindimensionales zeitliches Aufmerksamkeitsmodul mit einem zweidimensionalen räumlichen Aufmerksamkeitsmodul zu überlagern und so zeitliche Beziehungen zu modellieren.

Nach dem zeitlichen Aufmerksamkeitsmodul wird das Kreuzaufmerksamkeitsmodul verwendet, um die Semantik des Textes auszurichten. Im Vergleich zum Vollaufmerksamkeitsmechanismus reduziert eine solche Struktur den Trainings- und Inferenzaufwand erheblich.

STDiT-Strukturdiagramm

Der Trainings- und Inferenzprozess des gesamten Modells ist wie folgt. Es versteht sich, dass in der Trainingsphase zunächst der vorab trainierte Variational Autoencoder (VAE)-Encoder zum Komprimieren der Videodaten verwendet wird und dann das STDiT-Diffusionsmodell zusammen mit der Texteinbettung im komprimierten latenten Raum trainiert wird.

In der Inferenzphase wird ein Gaußsches Rauschen zufällig aus dem latenten Raum von VAE abgetastet und zusammen mit einer sofortigen Einbettung in STDiT eingegeben, um die entrauschten Merkmale zu erhalten. Schließlich wird es in den Decoder von VAE eingegeben und dekodiert, um ein Video zu erhalten.

Modelltrainingsprozess

Wir haben vom Team erfahren, dass sich das Replikationsschema von Open-Sora auf die Arbeit Stable Video Diffusion (SVD) [3] bezieht. Es umfasst drei Phasen , nämlich:

1. Groß angelegtes Bild-Vortraining;

3. Feinabstimmung von hochwertigen Videos Daten.

In jeder Stufe wird das Training basierend auf den Gewichten der vorherigen Stufe fortgesetzt. Im Vergleich zum einstufigen Training von Grund auf erreicht das mehrstufige Training das Ziel einer qualitativ hochwertigen Videogenerierung effizienter, indem die Daten schrittweise erweitert werden.

Drei Stufen des Trainingsplans

Die erste Stufe erfolgt durch groß angelegtes Bild-Vortraining, mit dem Mithilfe eines ausgereiften vinzentinischen Diagrammmodells können die Kosten für das Video-Vortraining effektiv gesenkt werden. Das Autorenteam hat uns gezeigt, dass wir durch die umfangreichen, großformatigen Bilddaten im Internet und die fortschrittliche Vincent-Graph-Technologie ein hochwertiges Vincent-Graph-Modell trainieren können, das als Initialisierungsgewicht für die nächste Stufe dient des Video-Vortrainings.

Da es derzeit keine qualitativ hochwertige räumlich-zeitliche VAE gibt, verwendeten sie gleichzeitig die durch das Modell Stable Diffusion [5] vorab trainierte Bild-VAE. Diese Strategie stellt nicht nur die überlegene Leistung des ursprünglichen Modells sicher, sondern reduziert auch die Gesamtkosten für das Video-Vortraining erheblich.

Zweite Stufe: groß angelegtes Video-Vortraining

In der zweiten Stufe wird ein groß angelegtes Video-Vortraining durchgeführt, um die Fähigkeiten zur Modellverallgemeinerung zu verbessern und die Zeitreihenkorrelation von Videos effektiv zu erfassen. Wir verstehen, dass diese Phase die Verwendung einer großen Menge an Videodaten für das Training erfordert, um die Vielfalt der Videothemen sicherzustellen und dadurch die Generalisierungsfähigkeit des Modells zu erhöhen. Das Modell der zweiten Stufe fügt dem vinzentinischen Graphenmodell der ersten Stufe ein zeitliches Aufmerksamkeitsmodul hinzu, um zeitliche Beziehungen in Videos zu lernen.

Die verbleibenden Module stimmen mit der ersten Stufe überein und laden die Gewichte der ersten Stufe als Initialisierung. Gleichzeitig wird die Ausgabe des zeitlichen Aufmerksamkeitsmoduls auf Null initialisiert, um eine effizientere und schnellere Konvergenz zu erreichen.

Das Colossal-AI-Team verwendete die Open-Source-Gewichte von PixArt-alpha[2] als Initialisierung des STDiT-Modells der zweiten Stufe und das T5[6]-Modell als Text-Encoder. Gleichzeitig verwendeten sie für das Vortraining eine kleine Auflösung von 256 x 256, was die Konvergenzgeschwindigkeit weiter erhöhte und die Trainingskosten senkte.

Die dritte Stufe: Feinabstimmung hochwertiger Videodaten

Die dritte Stufe optimiert hochwertige Videodaten, um die Qualität der Videogenerierung deutlich zu verbessern. Das Autorenteam erwähnte, dass die Größe der in der dritten Stufe verwendeten Videodaten eine Größenordnung geringer ist als die in der zweiten Stufe, aber die Dauer, Auflösung und Qualität des Videos sind höher. Durch diese Feinabstimmung erreichten sie eine effiziente Skalierung der Videoerzeugung von kurz auf lang, von niedriger auf hohe Auflösung und von niedriger auf hohe Wiedergabetreue.

Das Autorenteam gab an, dass sie im Open-Sora-Reproduktionsprozess 64 H800-Blöcke für das Training verwendet haben.

Der Gesamtumfang des Trainings in der zweiten Stufe beträgt 2808 GPU-Stunden, was etwa 7.000 US-Dollar entspricht. Das Trainingsvolumen der dritten Stufe beträgt 1920 GPU-Stunden, was etwa 4500 US-Dollar entspricht. Nach vorläufiger Schätzung kontrollierte der gesamte Trainingsplan den Open-Sora-Reproduktionsprozess erfolgreich auf etwa 10.000 US-Dollar.

Um den Schwellenwert und die Komplexität der Sora-Wiederholung weiter zu reduzieren, stellt das Colossal-AI-Team außerdem ein praktisches Videodaten-Vorverarbeitungsskript im Code Warehouse bereit, sodass jeder problemlos mit dem Vortraining für Sora-Wiederholungen beginnen kann , einschließlich des Downloads öffentlicher Videodatensätze, werden lange Videos basierend auf der Aufnahmekontinuität in kurze Videoclips segmentiert und das Open-Source-Großsprachenmodell LLaVA [7] wird verwendet, um präzise Aufforderungswörter zu generieren.

Das Autorenteam erwähnte, dass der von ihnen bereitgestellte Code zur Batch-Videotitelgenerierung ein Video mit zwei Karten in 3 Sekunden mit Anmerkungen versehen kann und die Qualität nahe an GPT-4V liegt. Die resultierenden Video-/Textpaare können direkt für das Training verwendet werden.

Mit dem Open-Source-Code, den sie auf GitHub bereitstellen, können wir einfach und schnell die für das Training erforderlichen Video-/Textpaare auf unserem eigenen Datensatz generieren und so den technischen Schwellenwert und die vorbereitende Vorbereitung für den Start des Sora-Replikationsprojekts erheblich reduzieren.

Video-/Textpaar wird automatisch basierend auf einem Datenvorverarbeitungsskript generiert

Werfen wir einen Blick auf den tatsächlichen Videogenerierungseffekt von Open-Sora. Lassen Sie Open-Sora beispielsweise Luftaufnahmen von Meerwasser erstellen, das an Felsen an einer Klippenküste plätschert.

Lassen Sie Open-Sora den herrlichen Blick aus der Vogelperspektive auf Berge und Wasserfälle einfangen, die von den Klippen herabstürzen und schließlich in den See fließen.

Sie können nicht nur in den Himmel steigen, sondern auch ins Meer gehen und Open-Sora eine Aufnahme der Unterwasserwelt erstellen lassen Korallenriffe.

Open-Sora kann uns auch die sternenklare Milchstraße durch Zeitrafferfotografie zeigen.

Wenn Sie weitere interessante Ideen für die Videogenerierung haben, können Sie die Open-Source-Community Open-Sora besuchen, um die Modellgewichte für ein kostenloses Erlebnis zu erhalten.

Link: https://github.com/hpcaitech/Open-Sora

Es ist erwähnenswert, dass das Autorenteam auf Github erwähnt hat, dass die aktuelle Version nur 400.000 Trainingsdaten verwendet, Modell Both Die Generierungsqualität und die Fähigkeit, dem Text zu folgen, müssen verbessert werden. Im obigen Schildkrötenvideo hat die resultierende Schildkröte beispielsweise ein zusätzliches Bein. Open-Sora 1.0 ist auch nicht gut darin, Porträts und komplexe Bilder zu erstellen.

Das Autorenteam listete eine Reihe von Plänen auf, die auf Github umgesetzt werden sollen, mit dem Ziel, bestehende Mängel kontinuierlich zu beheben und die Qualität der Produktion zu verbessern. Effiziente Trainingsunterstützung -KI-Beschleunigung Das System bietet effiziente Trainingsunterstützung für Soras Wiederholung.

Durch effiziente Trainingsstrategien wie Bedieneroptimierung und Hybridparallelität wurde beim Training der Verarbeitung von Videos mit 64 Bildern und einer Auflösung von 512 x 512 ein 1,55-facher Beschleunigungseffekt erzielt.

Durch effiziente Trainingsstrategien wie Bedieneroptimierung und Hybridparallelität wurde beim Training der Verarbeitung von Videos mit 64 Bildern und einer Auflösung von 512 x 512 ein 1,55-facher Beschleunigungseffekt erzielt.

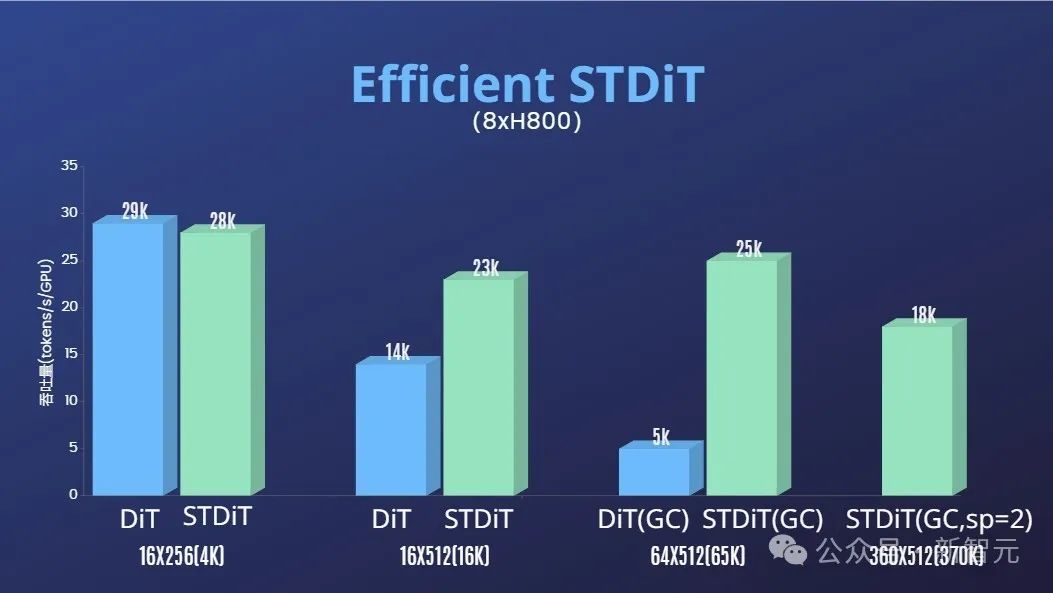

Darüber hinaus haben wir im Bericht des Autorenteams auch festgestellt, dass die STDiT-Modellarchitektur auch während des Trainings eine hervorragende Effizienz zeigte.

Im Vergleich zu DiT, das den Vollaufmerksamkeitsmechanismus nutzt, erreicht STDiT mit zunehmender Anzahl von Bildern eine bis zu fünffache Beschleunigung, was besonders bei realen Aufgaben wie der Verarbeitung langer Videosequenzen von entscheidender Bedeutung ist.

huanWillkommen, weiterhin auf das Open-Sora-Open-Source-Projekt zu achten: https://github.com /hpcaitech/Open-Sora

Das Autorenteam erwähnte, dass es das Open-Sora-Projekt weiterhin pflegen und optimieren wird und voraussichtlich mehr Videotrainingsdaten verwenden wird, um qualitativ hochwertigere, längere Videoinhalte zu generieren und Multi zu unterstützen -Auflösungsfunktionen, die praktisch sind. Fördern Sie die Implementierung der KI-Technologie in Filmen, Spielen, Werbung und anderen Bereichen.

Das obige ist der detaillierte Inhalt vonWarten Sie nicht auf OpenAI, das weltweit erste Sora-ähnliche Gerät ist Open Source First! Alle Trainingsdetails/Modellgewichte werden vollständig offengelegt und die Kosten betragen nur 10.000 US-Dollar. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!