Stability AI hat kürzlich sein erstes KI-Modell im Jahr 2024 namens Stable Code 3B veröffentlicht. Dieses Modell verfügt über 3 Milliarden Parameter und konzentriert sich auf Hilfscodeaufgaben.

Laufen Sie nativ auf einem Laptop, ohne dass eine dedizierte GPU erforderlich ist, und liefern Sie dennoch eine konkurrenzfähige Leistung mit großen Modellen wie dem CodeLLaMA 7B von Meta.

Ende 2023 begann Stability AI, die Entwicklung kleinerer, kompakterer und leistungsfähigerer Modelle voranzutreiben, wie beispielsweise das StableLM Zephyr 3B-Modell zur Textgenerierung.

Anfang 2024 veröffentlichte Stability AI ein wichtiges Sprachmodell namens Stable Code 3B. Tatsächlich wurde die Vorschauversion, Stable Code Alpha 3B, bereits im August letzten Jahres veröffentlicht. Seitdem hat Stability AI die Technologie kontinuierlich verbessert. Diese neue Version von Stable Code 3B ist speziell für die Code-Vervollständigung konzipiert und verfügt außerdem über eine Vielzahl zusätzlicher Funktionen.

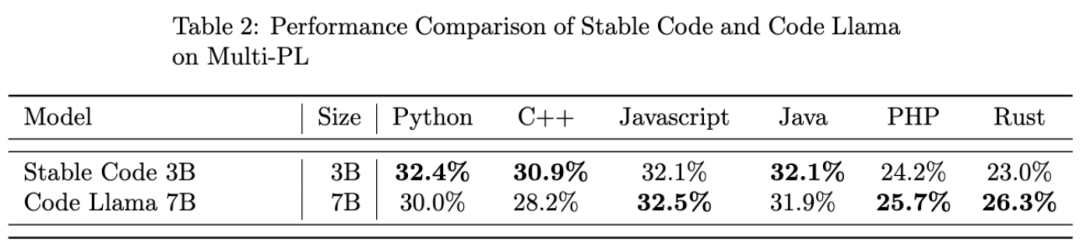

Im Vergleich zu CodeLLaMA 7b ist Stable Code 3B 60 % kleiner, erreicht aber bei Programmieraufgaben eine mit ersterem vergleichbare Leistung.

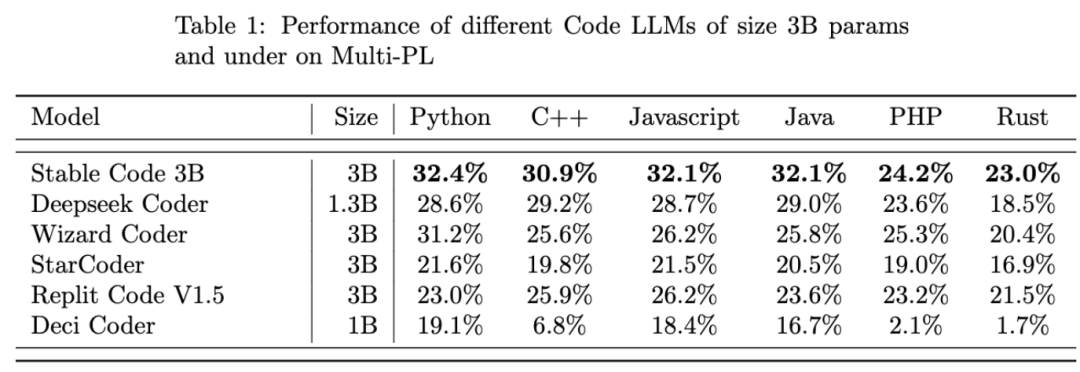

Stable Code 3B erreicht SOTA-Leistung (im Vergleich zu Modellen ähnlicher Größe) beim MultiPL-E-Benchmark, wie z. B. Stable Code 3B bei den Programmiersprachen Python, C++, JavaScript, Java, PHP und Rust. Die Leistung ist besser als StarCoder.

Stable Code 3B wird auf der Grundlage von Stable LM 3B trainiert, das über eine Trainingstokenzahl von bis zu 4 Billionen verfügt. Darüber hinaus nutzt Stable Code auch Software-Engineering-spezifische Daten für das Training.

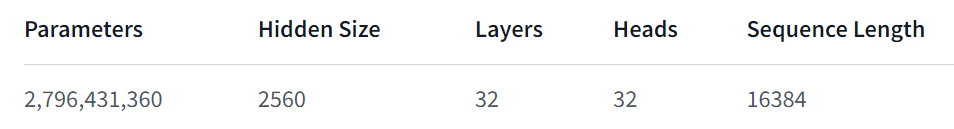

Stable Code 3B bietet mehr Funktionen, funktioniert auch in mehreren Sprachen gut und hat auch andere Vorteile, wie z. B. die Unterstützung der FIM-Funktion (Fill in the Middle, eine neue Trainingstechnik) und die Möglichkeit, die Kontextgröße zu erweitern. Der grundlegende Stable Code wird auf bis zu 16.384 Token-Sequenzen trainiert und folgt einem ähnlichen Ansatz wie CodeLlama, d .

In Bezug auf die Modellarchitektur ist das Stable Code 3B-Modell ein reiner Decoder-Transformator, ähnlich der LLaMA-Architektur, mit den folgenden Modifikationen:

Hardware: Stable Code 3B wird auf einem Stability AI-Cluster mit 256 NVIDIA A100 40 GB GPUs trainiert.

Software: Stable Code 3B übernimmt einen Zweig von gpt-neox, verwendet ZeRO-1 zum Trainieren unter 2D-Parallelität (Daten- und Tensorparallelität) und verlässt sich auf den Rotationseinbettungskern von Flash-Attention, SwiGLU und FlashAttention- 2 .

Abschließend werfen wir einen Blick auf die Leistung von Stable Code 3B:

Das obige ist der detaillierte Inhalt vonStability AI veröffentlicht stabiles Code-3B-Modell, das lokal ausgeführt wird und keine GPU erfordert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Audiokomprimierung

Audiokomprimierung

Inländische Plattform für digitale Währungen

Inländische Plattform für digitale Währungen

Isolationsstufe für MySQL-Transaktionen

Isolationsstufe für MySQL-Transaktionen

Welche sind die am häufigsten verwendeten Drittanbieter-Bibliotheken in PHP?

Welche sind die am häufigsten verwendeten Drittanbieter-Bibliotheken in PHP?

Die Rolle von Serverlet in Java

Die Rolle von Serverlet in Java

Komplementalgorithmus für negative Zahlen

Komplementalgorithmus für negative Zahlen

So lösen Sie das Problem, dass JS-Code nach der Formatierung nicht ausgeführt werden kann

So lösen Sie das Problem, dass JS-Code nach der Formatierung nicht ausgeführt werden kann

Was lohnt sich mehr zu lernen, C-Sprache oder Python?

Was lohnt sich mehr zu lernen, C-Sprache oder Python?