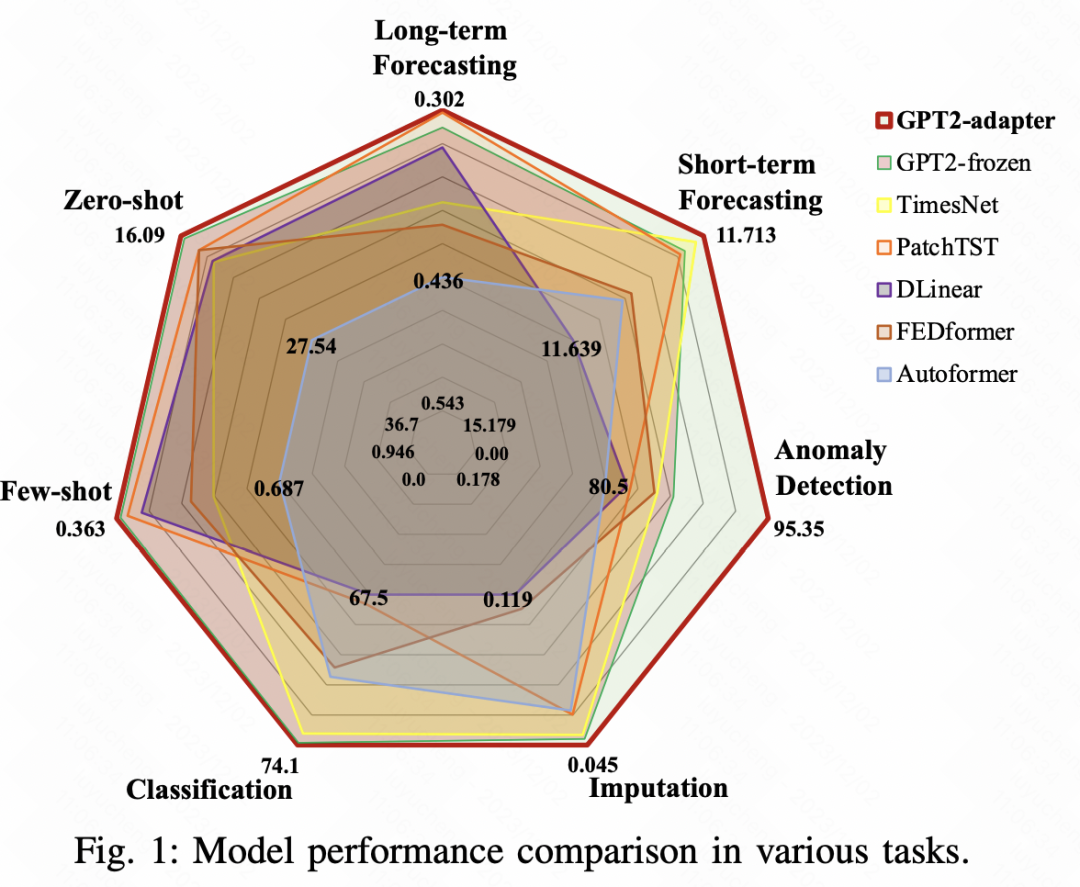

Heute möchte ich mit Ihnen über die neuesten Arbeiten zur Vorhersage großer Modellzeitreihen sprechen. Sie stammen von der Alibaba Damo Academy, die ein universelles Zeitreihenanalyse-Framework auf Basis von Adaptern vorschlägt, das in Langzeitprognosen verwendet werden kann. Kurzzyklusvorhersage, Zero-Shot und wenige bemerkenswerte Ergebnisse wurden bei 7 Zeitreihenaufgaben erzielt, darunter -Shot, Anomalieerkennung, Zeitreihenklassifizierung und Zeitreihenfüllung.

Papiertitel: Einheitsgröße: Universelle Zeitreihenanalyse mit vorab trainierten Sprachmodellen und speziell entwickelten Adaptern

Herunterladbarer Link: https://arxiv.org/pdf/2311.14782v1.pdf

Im Bereich der Zeitreihenvorhersage ist eine der Schwierigkeiten bei der Erstellung groß angelegter Modelle der Mangel an ausreichenden Trainingsdaten wie im NLP- oder CV-Bereich. Dieser Artikel schlägt eine Lösung vor, die auf groß angelegten Modellen basiert, die im Bereich NLP oder CV trainiert wurden, in Kombination mit der Adaptertechnologie, um sie an Zeitreihen anzupassen und verschiedene Zeitreihenprobleme zu lösen.

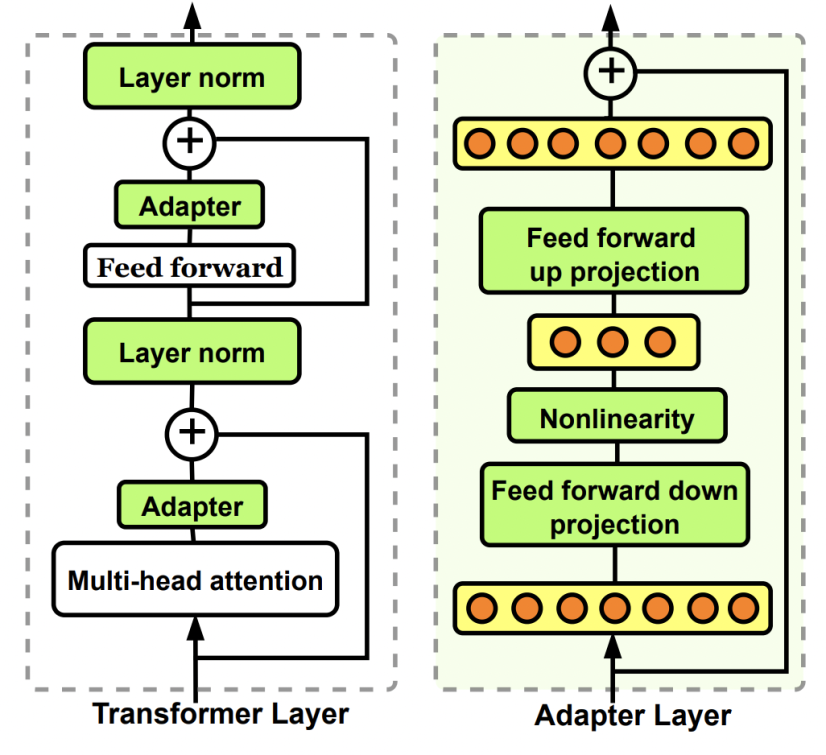

Adapter in NLP, Es ist weit verbreitet In Bereichen wie CV, insbesondere in neueren Großmodellanwendungen, werden Adapter häufig verwendet, um eine leichte Feinabstimmung großer Modelle durchzuführen. Der Adapter ist ein leichtgewichtiges Netzwerk, indem Sie ihn in einige Module im großen Modell einfügen, dann die Parameter des großen Modells festlegen und nur die Parameter des Adapters aktualisieren, um eine leichte Feinabstimmung des großen Modells zu erreichen.

Bilder

Bilder

Jetzt möchte ich Ihnen vorstellen, wie wir in dieser Arbeit der Alibaba Damo Academy Adapter verwenden, um vorab trainierte NLP- und CV-Modelle zu kombinieren, um ein einheitliches Zeitreihenmodell zu erstellen.

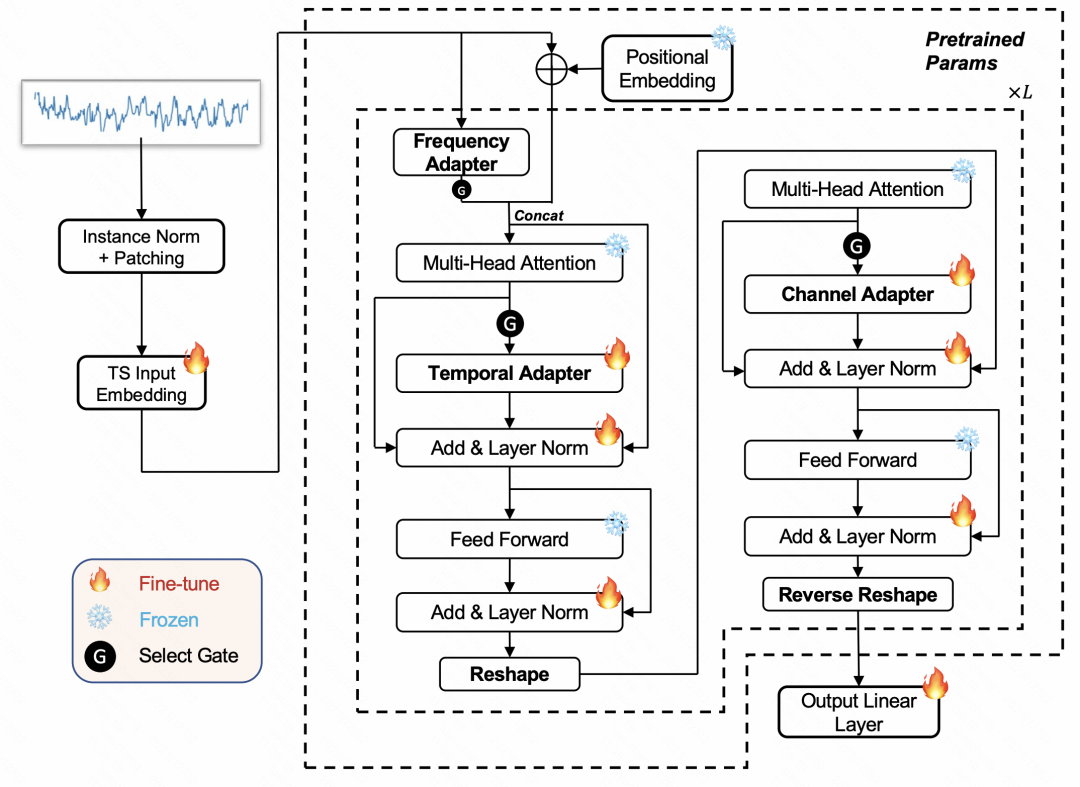

Das in diesem Artikel vorgeschlagene Modell basiert auf dem vorab trainierten Sprachmodell der Freeze-Parameter und wird durch die Kombination von 4 Adaptertypen implementiert. Die Gesamtstruktur des Modells ist in der folgenden Abbildung dargestellt.

Bilder

Bilder

Zunächst verwenden wir für die Eingabezeitreihe die RevIN-Methode zur Normalisierung. Das bedeutet, dass wir von jeder Zeitreihe den Mittelwert subtrahieren und durch die Varianz dividieren. Als Nächstes verwenden wir die PatchTST-Methode, um die Zeitreihe durch Schiebefenster in mehrere Segmente aufzuteilen und Segmenteinbettungen zu generieren. Die verarbeiteten Zeitreihen werden in ein vorab trainiertes Sprachmodell im NLP-Bereich eingegeben. Während des gesamten Trainingsprozesses bleiben die ursprünglichen Parameter des Sprachmodells unverändert und wir werden nur die neu hinzugefügten 4 Arten von Adapterparametern aktualisieren

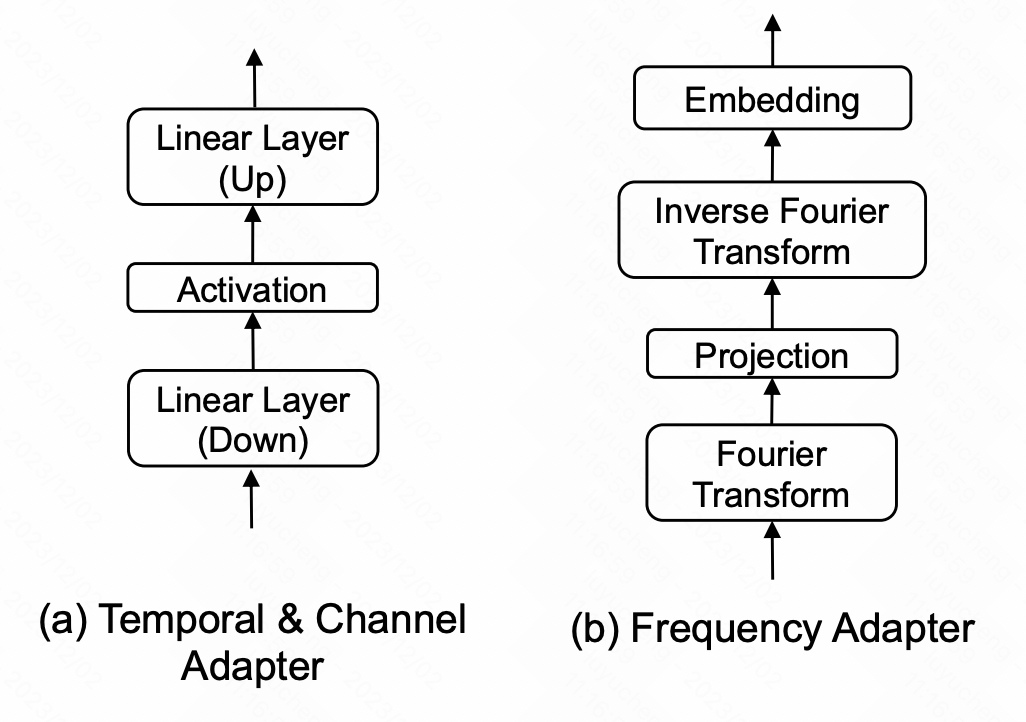

In diesem Artikel werden vier Arten von Adaptern vorgestellt, die angeschlossen werden können NLP und verschiedene Positionen großer Modelle im CV-Bereich, um das Ziel der Anpassung von Zeitreihen zu erreichen. Diese vier Adapter sind Zeitadapter, Kanaladapter, Frequenzadapter und Ausnahmeadapter. Zeitadapter: Zeitadapter ist ein MLP-Netzwerk, das zum Zusammenführen von Zeitdimensionsinformationen verwendet wird. In diesem Artikel verwenden wir eine Engpassstruktur, um hochdimensionale Informationen in der Zeitdimension oder Raumdimension zunächst einem niedrigdimensionalen Raum zuzuordnen und sie dann wieder dem hochdimensionalen Raum zuzuordnen. Der Zweck besteht darin, das Risiko einer Überanpassung beim Extrahieren zeitlicher Beziehungen zu vermeiden. Kanaladapter: Die Struktur des Kanaladapters ähnelt der des zeitlichen Adapters. Der Unterschied besteht darin, dass er in der räumlichen Dimension ausgeführt wird wird verwendet, um die Beziehung zwischen den Variablen der multivariaten Sequenz zu extrahieren.

Bild

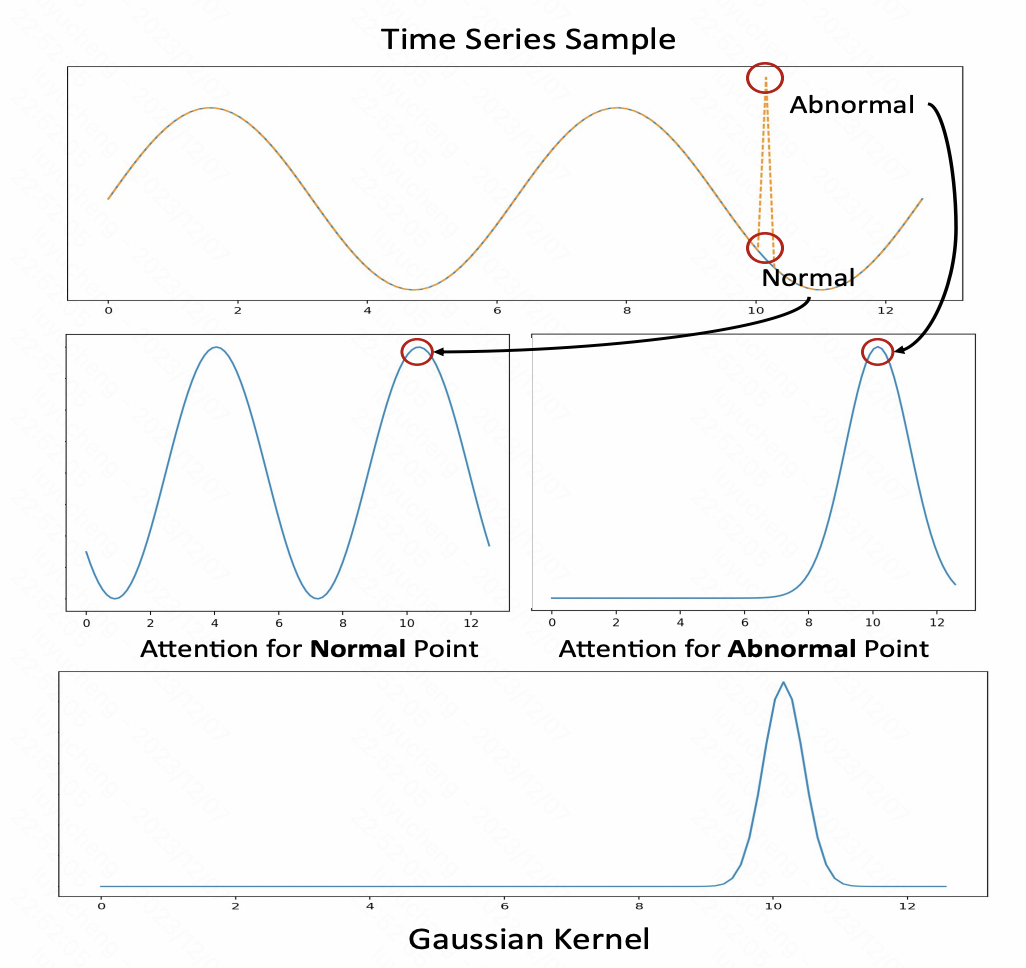

Frequenzadapter: Dieser Teil ordnet die Zeitreiheninformationen im Frequenzbereich zu Im Frequenzbereich führt MLP im Frequenzbereich durch und ordnet es dann wieder dem Zeitbereich zu, um die Extraktion globaler Informationen wie des Frequenzbereichs zu erreichen. Anomalie-Adapter: Dieser Teil implementiert hauptsächlich eine neue Methode zur Erkennung von Zeitreihenanomalien. Die Aufmerksamkeits-Score-Matrix zeigt hier periodische Wiederholungsmerkmale, abnormale Sequenzen jedoch nicht a Der Gaußsche Kernel dient als Anomalieadapter und verwendet die Ausgabeergebnisse der Aufmerksamkeit und ihre berechnete KL-Divergenz zur Erkennung von Zeitreihenanomalien.

Frequenzadapter: Dieser Teil ordnet die Zeitreiheninformationen im Frequenzbereich zu Im Frequenzbereich führt MLP im Frequenzbereich durch und ordnet es dann wieder dem Zeitbereich zu, um die Extraktion globaler Informationen wie des Frequenzbereichs zu erreichen. Anomalie-Adapter: Dieser Teil implementiert hauptsächlich eine neue Methode zur Erkennung von Zeitreihenanomalien. Die Aufmerksamkeits-Score-Matrix zeigt hier periodische Wiederholungsmerkmale, abnormale Sequenzen jedoch nicht a Der Gaußsche Kernel dient als Anomalieadapter und verwendet die Ausgabeergebnisse der Aufmerksamkeit und ihre berechnete KL-Divergenz zur Erkennung von Zeitreihenanomalien.

Bilder

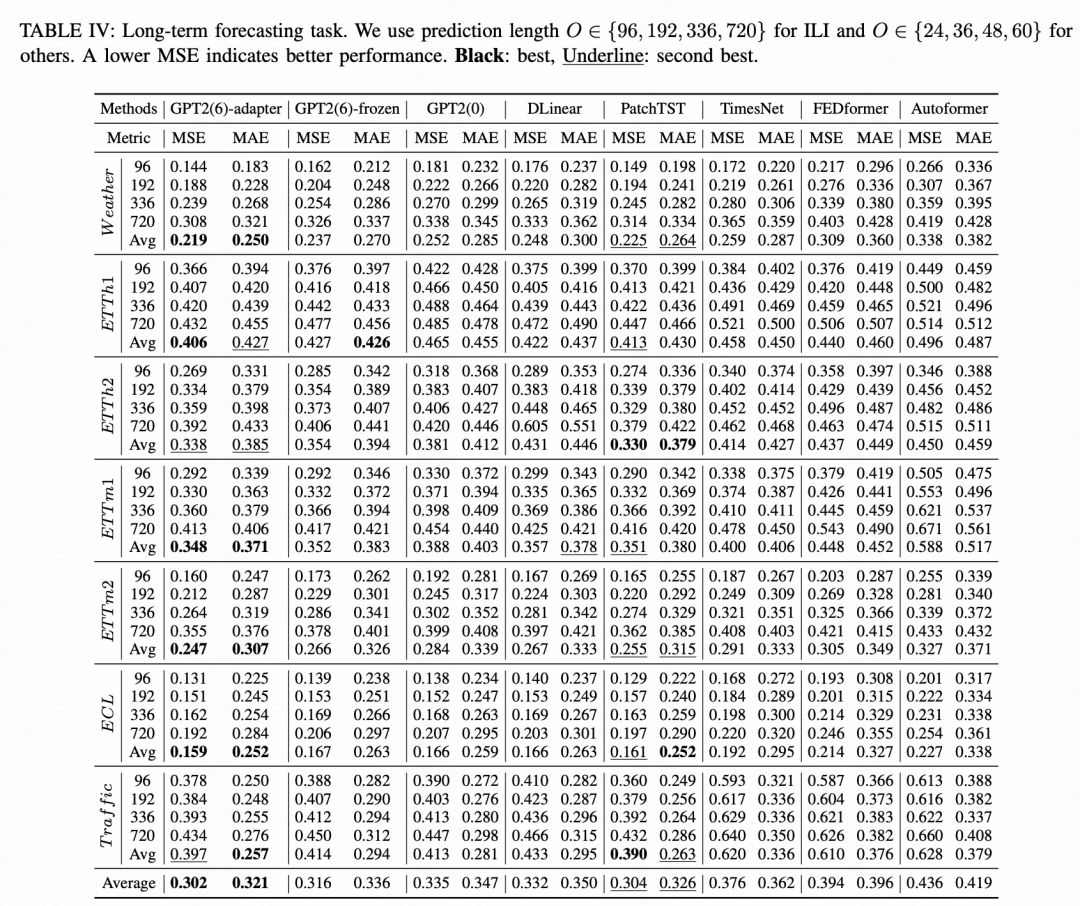

Darüber hinaus werden unterschiedliche Daten von jedem Adapter in unterschiedlichem Maße beeinflusst. Daher wird in dem Artikel ein Gated-Netzwerk verwendet, um selektiv Adapter zu verwenden4 der Zeitreihenaufgaben wurden verglichen. Das in diesem Artikel vorgeschlagene vereinheitlichte Zeitreihenmodell erzielte bei jeder Aufgabe bessere Ergebnisse als verschiedene SOTA-Modelle in der Branche. Am Beispiel der Langzeitvorhersageaufgabe schneidet das einheitliche Modell auf Basis von GPT2+Adapter am besten ab

Darüber hinaus werden unterschiedliche Daten von jedem Adapter in unterschiedlichem Maße beeinflusst. Daher wird in dem Artikel ein Gated-Netzwerk verwendet, um selektiv Adapter zu verwenden4 der Zeitreihenaufgaben wurden verglichen. Das in diesem Artikel vorgeschlagene vereinheitlichte Zeitreihenmodell erzielte bei jeder Aufgabe bessere Ergebnisse als verschiedene SOTA-Modelle in der Branche. Am Beispiel der Langzeitvorhersageaufgabe schneidet das einheitliche Modell auf Basis von GPT2+Adapter am besten ab

Bilder

Bilder

Das obige ist der detaillierte Inhalt vonZeitreihen-Multitasking-integriertes Großmodell basierend auf Adapter und GPT. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Hauptzweck des Dateisystems

Hauptzweck des Dateisystems

Was bedeutet BIOS?

Was bedeutet BIOS?

Gängige Verschlüsselungsmethoden für die Speicherung verschlüsselter Daten

Gängige Verschlüsselungsmethoden für die Speicherung verschlüsselter Daten

Was sind die ERP-Systeme für Unternehmen?

Was sind die ERP-Systeme für Unternehmen?

Einführung in die Beziehung zwischen PHP und Frontend

Einführung in die Beziehung zwischen PHP und Frontend

Was ist ein Gastgeber?

Was ist ein Gastgeber?

So lösen Sie ein Tastendruckereignis aus

So lösen Sie ein Tastendruckereignis aus

So implementieren Sie die CSS-Karussellfunktion

So implementieren Sie die CSS-Karussellfunktion