Schau! Nun stehen vor Ihnen vier junge Damen, die ihre heißen Tänze vorführen:

Dachten Sie, es wäre ein Werk, das von einigen Moderatoren auf einer Kurzvideoplattform veröffentlicht wurde?

Nein, nein, nein.

Die eigentliche Antwort lautet: gefälscht, generiert und die Art, die nur auf einem Bild beruht!

Der wahre Weg, es einzuschalten, ist dieser:

Dies ist die neueste Forschung der National University of Singapore und Bytedance, genannt Magic Animate.

Seine Funktion lässt sich in einer einfachen Formel zusammenfassen: ein Bild + eine Reihe von Aktionen = ein Video ohne jegliches Gefühl einer Verletzung.

Mit der Ankündigung dieser Technologie kam es zu Aufruhr im Technologiekreis, und viele Technologieriesen und Geeks haben sich angeschlossen. Sogar

HuggingFace CTOhat es mit seinem eigenen Avatar versucht:

Von Übrigens habe ich auch auf humorvolle Art und Weise einen Witz gemacht:

Von Übrigens habe ich auch auf humorvolle Art und Weise einen Witz gemacht:

Es gibt auch recht aktuelle Internetnutzer, die mit den Charakteren im Trailer des neu veröffentlichtenGTA6

(Grand Theft Auto 6):

Sogar die Emoticons sind zu The geworden Von Internetnutzern gewähltes Ziel...

Sogar die Emoticons sind zu The geworden Von Internetnutzern gewähltes Ziel...

Man kann sagen, dass Magic Animate die Aufmerksamkeit des Technologiekreises auf sich selbst gelenkt hat, daher scherzten einige Internetnutzer:

Man kann sagen, dass Magic Animate die Aufmerksamkeit des Technologiekreises auf sich selbst gelenkt hat, daher scherzten einige Internetnutzer:

Feuer, wirklich Feuer.

Feuer, wirklich Feuer.

Sie können mit nur einem Bild einen Tanz erstellen

Lass es uns ohne weitere Umschweife Schritt für Schritt erleben.

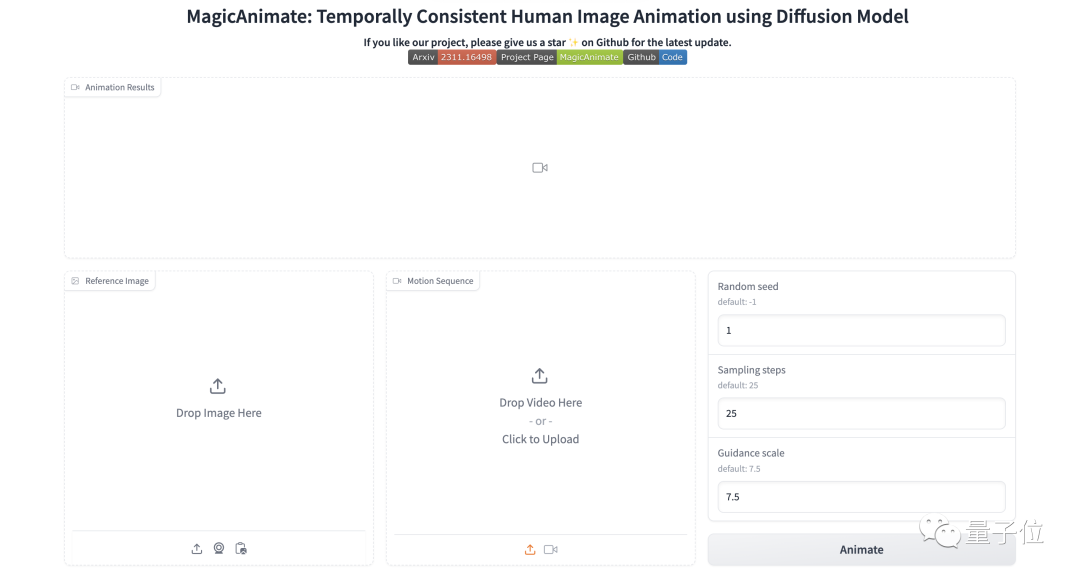

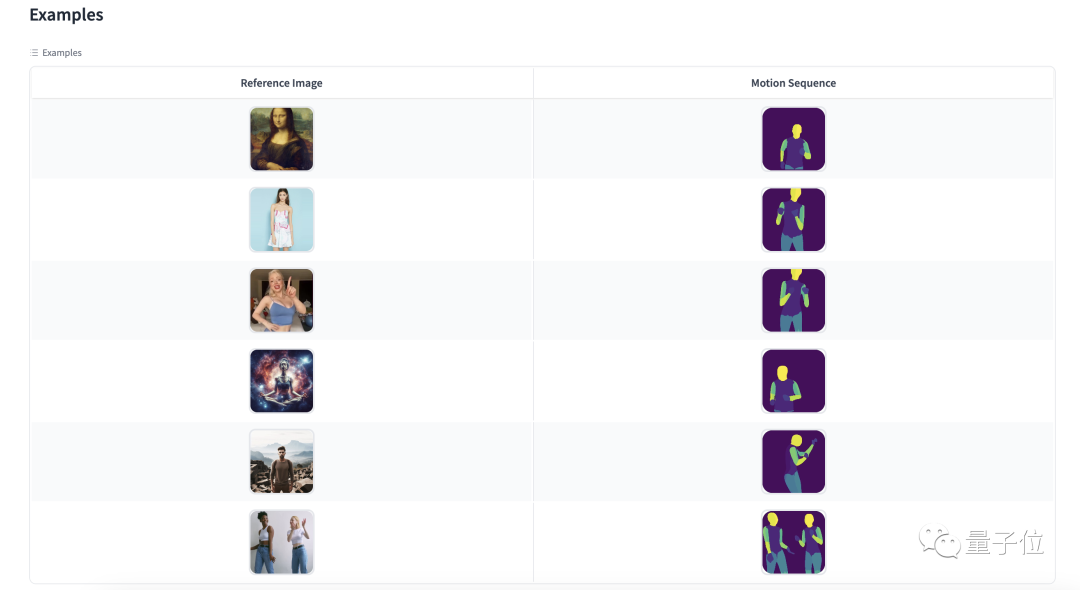

Aktuell hat unser Projektteam eine Online-Erlebnisseite auf HuggingFace eröffnet

Die Bedienung ist sehr einfach und erfordert nur drei Schritte:

Die Bedienung ist sehr einfach und erfordert nur drei Schritte:

△ Videoquelle: Douyin (ID: QC0217)

Allerdings ist zu beachten, dass MagicAnimate dies ist derzeit zu beliebt, in Während des Generierungsprozesses kann es zu „Ausfallzeiten“ kommen:

Selbst wenn Sie es erfolgreich „essen“, müssen Sie sich möglicherweise anstellen

...

Dann ist die nächste Frage:

Wie hat es geklappt?

Diffusionsmodell

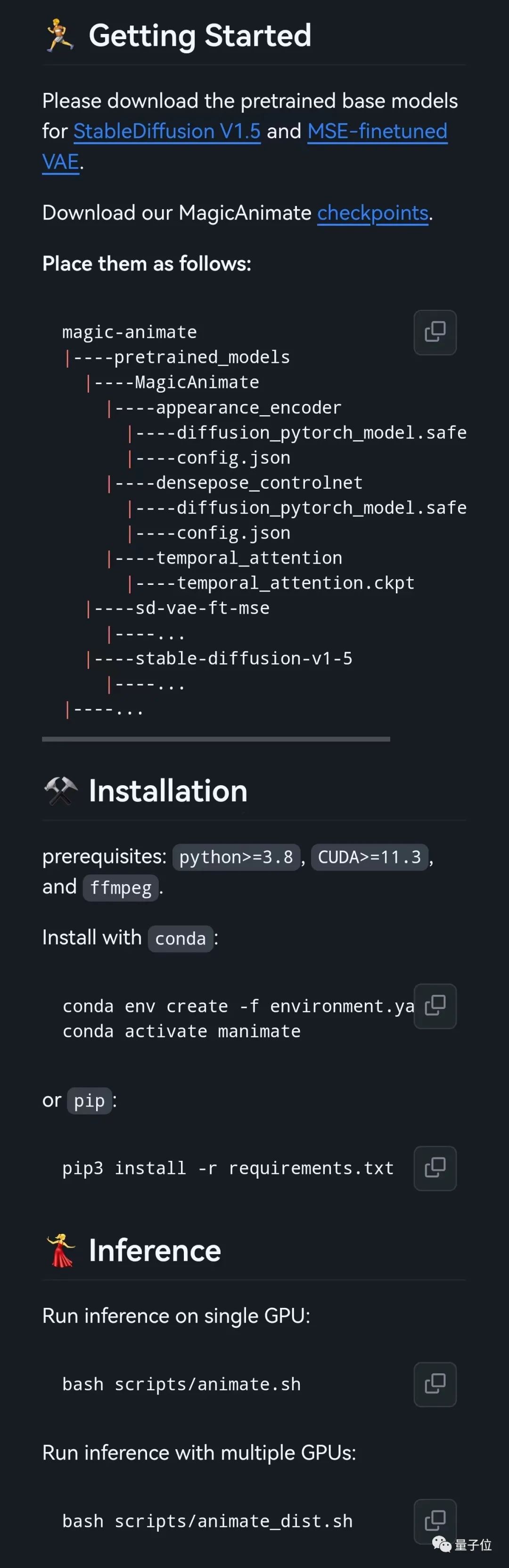

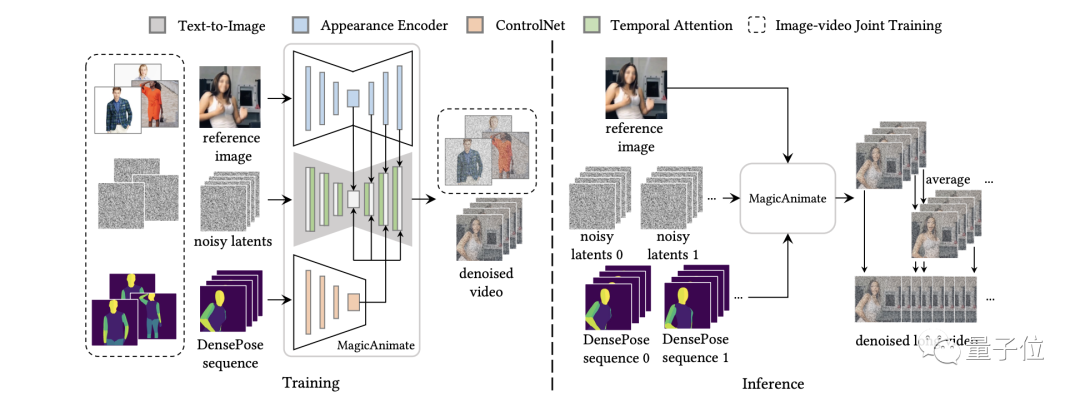

Zu diesem Zweck entwickelte das Team zunächst ein

Videodiffusionsmodell (Temporal Consistency Modeling)

(Temporal Consistency Modeling)

Dieses Modell kodiert zeitliche Informationen, indem es dem Diffusionsnetzwerk ein zeitliches Aufmerksamkeitsmodul hinzufügt, um die zeitliche Konsistenz zwischen Bildern in der Animation sicherzustellen. Zweitens führte das Team einen neuen Appearance Encoder

(Appearance Encoder)

ein, um die Konsistenz des Erscheinungsbilds zwischen den Frames aufrechtzuerhalten, um die komplexen Details des Referenzbilds beizubehalten.Dieser Encoder unterscheidet sich von früheren Methoden der CLIP-Kodierung. Er ist in der Lage, dichtere visuelle Merkmale zu extrahieren, um die Animationsproduktion zu steuern und so Informationen wie Identität, Hintergrund und Kleidung besser zu bewahren. In diesen beiden innovativen Technologien Darüber hinaus hat das Team eine einfache Videofusionstechnologie (Video Fusion Technique)

eingeführt, um den reibungslosen Übergang langer Videoanimationen zu fördern. Abschließend zeigen die Ergebnisse nach der Verifizierung durch zwei Benchmark-Experimente, dass MagicAnimate frühere Methoden bei weitem übertrifft.Insbesondere beim anspruchsvollen TikTok-Tanzdatensatz übertrifft MagicAnimate die stärkste Basislinie in Bezug auf die Videotreue. Mit mehr als 38 %!

Das Folgende ist ein qualitativer Vergleich des Teams:Und im Vergleich zum hochmodernen Basismodell von Cross-ID lauten unsere Ergebnisse wie folgt:

Ich muss sagen, dass Projekte wie MagicAnimate in letzter Zeit wirklich sehr beliebt sind Projekt erfordert auch nur „ein Bild“ und „die gewünschte Aktion“:

Daraus haben einige Internetnutzer auch Fragen aufgeworfen:

Dies scheint ein Krieg zwischen MagicAnimate und AnimateAnyone zu sein.  Wer ist besser?

Wer ist besser?

Was meint ihr?

Bitte klicken Sie auf den folgenden Link, um das Papier anzuzeigen: https://arxiv.org/abs/2311.16498

Das obige ist der detaillierte Inhalt vonFür den Douyin-Tanz müssen keine echten Menschen vor der Kamera erscheinen, nur ein Foto kann ein qualitativ hochwertiges Video erzeugen! Sogar der gesichtsbedeckende CTO hat die neue Technologie von Byte erlebt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!