Meta hat neue Untersuchungen zum Aufmerksamkeitsmechanismus großer Modelle durchgeführt.

Durch die Anpassung des Aufmerksamkeitsmechanismus des Modells und das Herausfiltern der Interferenz irrelevanter Informationen verbessert der neue Mechanismus die Genauigkeit großer Modelle weiter Eine Feinabstimmung oder Schulung ist erforderlich, aber Prompt allein kann die Genauigkeit großer Modelle um 27 % steigern.

Der Autor nannte diesen Aufmerksamkeitsmechanismus „System 2 Attention“ (S2A), der von Daniel Kahneman, dem Nobelpreisträger für Wirtschaftswissenschaften aus dem Jahr 2002, in seinem Bestseller „Thinking“ stammt. Das in „Fast und Langsam“ – „System 2“ im Dual-System-Denkmodell

Der Autor nannte diesen Aufmerksamkeitsmechanismus „System 2 Attention“ (S2A), der von Daniel Kahneman, dem Nobelpreisträger für Wirtschaftswissenschaften aus dem Jahr 2002, in seinem Bestseller „Thinking“ stammt. Das in „Fast und Langsam“ – „System 2“ im Dual-System-Denkmodell

Das sogenannte System 2 bezieht sich auf komplexes bewusstes Denken, im Gegensatz zu System 1, bei dem es sich um einfache unbewusste Intuition handelt.

S2A „passt“ den Aufmerksamkeitsmechanismus in Transformer an und verwendet schnelle Worte, um das Gesamtdenken des Modells näher an System 2 zu bringen.

Einige Internetnutzer beschrieben diesen Mechanismus als das Hinzufügen einer „Schutzbrille“ zur KI.

Darüber hinaus sagte der Autor im Titel des Artikels, dass dieser Denkmodus nicht nur bei großen Modellen, sondern möglicherweise auch vom Menschen selbst erlernt werden muss.

Darüber hinaus sagte der Autor im Titel des Artikels, dass dieser Denkmodus nicht nur bei großen Modellen, sondern möglicherweise auch vom Menschen selbst erlernt werden muss.

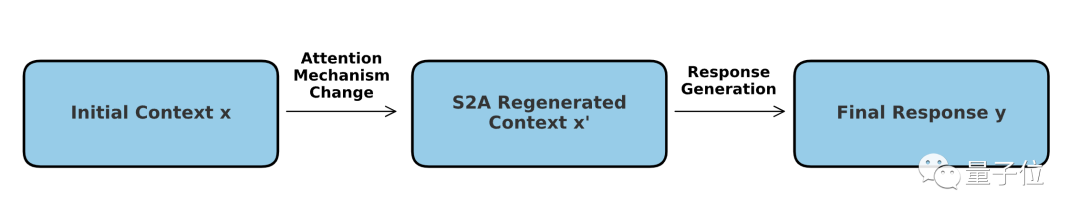

Wie wird diese Methode umgesetzt?

Wie wird diese Methode umgesetzt?

Vermeiden Sie, dass große Modelle „in die Irre geführt“ werden.

Wort (Token) einen Aufmerksamkeitswert zwischen 0 und 1 zu. Das entsprechende Konzept ist der harte Aufmerksamkeitsmechanismus, der sich nur auf eine bestimmte oder bestimmte Teilmenge der Eingabesequenz konzentriert und häufiger in der Bildverarbeitung verwendet wird.

Der S2A-Mechanismus kann als Kombination zweier Modi verstanden werden – der Kern ist immer noch weiche Aufmerksamkeit, aber es kommt ein „harter“ Screening-Prozess hinzu.

In Bezug auf den spezifischen Betrieb muss S2A

das Modell selbst nicht anpassen, sondern verwendet Aufforderungswörter, damit das Modell „Inhalte, die nicht beachtet werden sollten“, entfernen kann, bevor das Problem gelöst wird. Auf diese Weise kann die Wahrscheinlichkeit verringert werden, dass ein großes Modell bei der Verarbeitung von Aufforderungswörtern mit subjektiven oder irrelevanten Informationen in die Irre geführt wird, wodurch die Argumentationsfähigkeit und der praktische Anwendungswert des Modells verbessert werden.

Wir haben gelernt, dass die von großen Modellen generierten Antworten stark von den Aufforderungswörtern beeinflusst werden. Um die Genauigkeit zu verbessern, hat S2A beschlossen, Informationen zu entfernen, die Störungen verursachen können.

Wir haben gelernt, dass die von großen Modellen generierten Antworten stark von den Aufforderungswörtern beeinflusst werden. Um die Genauigkeit zu verbessern, hat S2A beschlossen, Informationen zu entfernen, die Störungen verursachen können.

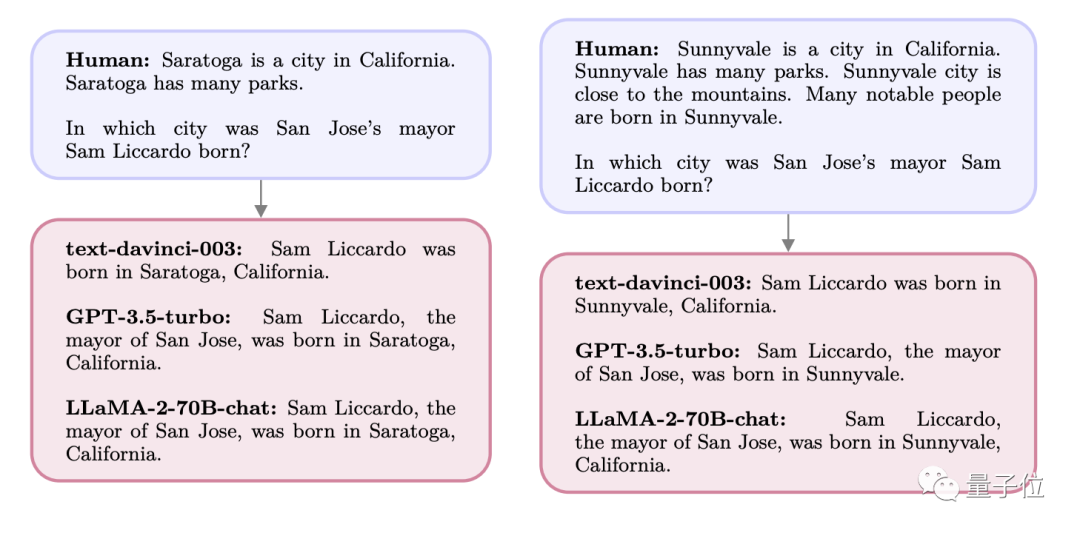

Wenn wir beispielsweise einem großen Modell die folgende Frage stellen:

Eine Stadt ist eine Stadt im Bundesstaat X, umgeben von Bergen und vielen Parks Es gibt hier viele herausragende Persönlichkeiten und viele berühmte Persönlichkeiten wurden in Stadt A geboren.

Wo wurde Bürgermeister Y der Stadt B im Bundesstaat X geboren?

Zu diesem Zeitpunkt beziehen sich die Antworten von GPT und Llama beide auf die in der Frage erwähnte Stadt A, aber tatsächlich ist Ys Geburtsort Stadt C.

Bei der ersten Frage hätte das Modell Stadt C genau beantworten können. Da Stadt A jedoch wiederholt in den Aufforderungswörtern auftauchte, erregte sie die „Aufmerksamkeit“ des Modells, was dazu führte, dass die endgültige Antwort A wurde.

Bei der ersten Frage hätte das Modell Stadt C genau beantworten können. Da Stadt A jedoch wiederholt in den Aufforderungswörtern auftauchte, erregte sie die „Aufmerksamkeit“ des Modells, was dazu führte, dass die endgültige Antwort A wurde.

Eine weitere Alternative: Was Es kommt vor, dass Menschen auf Fragen „mögliche Antworten“ finden.

Gibt es in der M-Band einen Sänger, der auch Schauspieler ist? Ich denke, es könnte A sein, aber ich bin mir nicht sicher.

Infolgedessen begann das große Modell, dem Benutzer zu schmeicheln. Sie haben Recht ist ein. Aber tatsächlich ist diese Person B.

In ähnlicher Weise kann das Modell genau antworten, wenn Sie direkt nach der Identität der Person fragen

Schauen wir uns die Auswirkungen vor und nach dem Screening genauer an:

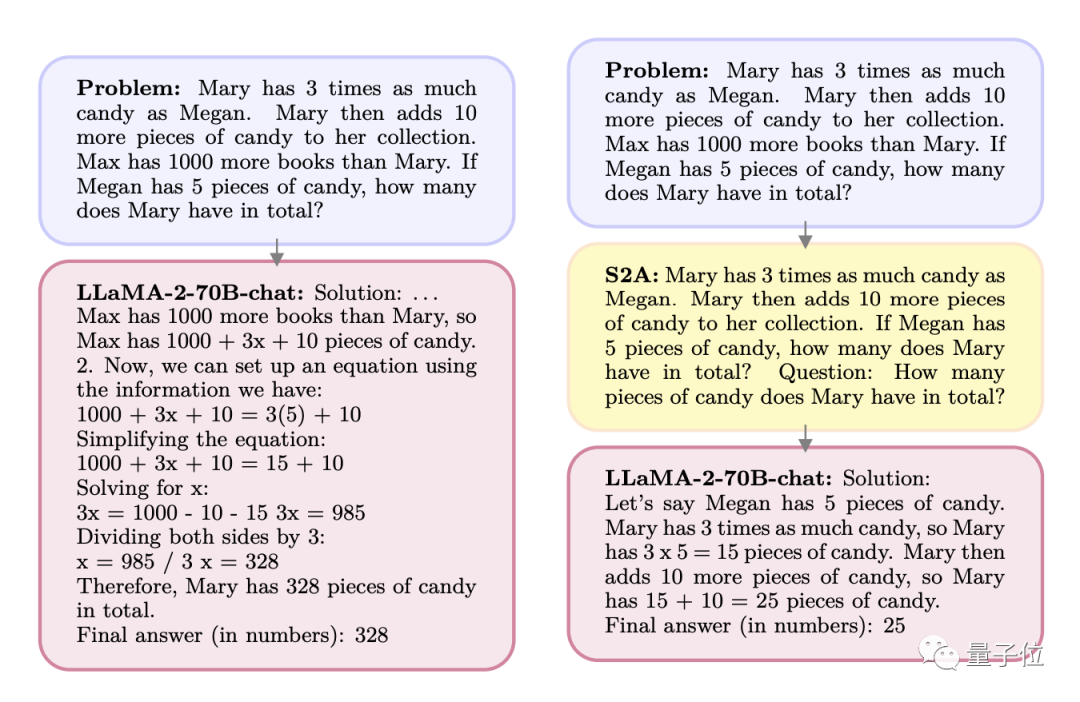

F: Mary hat dreimal so viele Süßigkeiten wie Megan. Mary nahm weitere 10 Bonbons. Max besitzt 1.000 Bücher mehr als Mary. Wenn Megan 5 Bonbons hat, wie viele Bonbons hat Mary insgesamt?

A: Max hat 1.000 Bücher mehr als Mary, also hat Max 1.000+x+10 Bonbons. Wir können eine Gleichung aufstellen:

1000+3x+10=3(5)+10

…

Nach der Verarbeitung durch S2A, die Frage wird zu folgender Situation:

F: Mary hat dreimal so viele Süßigkeiten wie Megan. Mary nahm weitere 10 Bonbons. Wenn Megan 5 Bonbons hat, wie viele Bonbons hat Mary insgesamt?

Frage (Frage steht hier direkt in der Eingabeaufforderung): Wie viele Süßigkeiten hat Mary insgesamt?

Umgeschriebener Inhalt: A: Meghan hatte 5 Yuan, Mary hatte dreimal so viel wie Meghan, also 15 Yuan, und nahm dann weitere 10 Yuan, also waren es insgesamt 25 Yuan

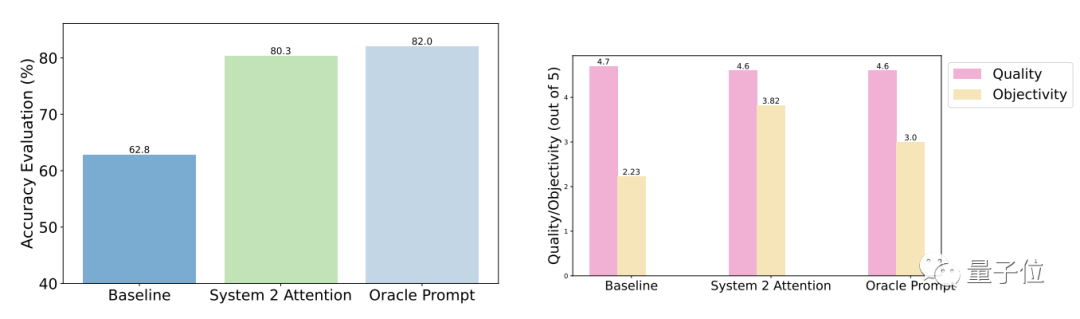

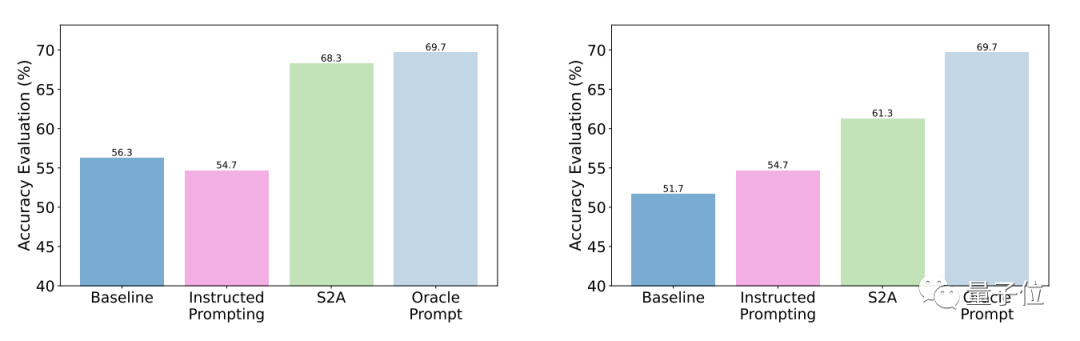

Die Testergebnisse zeigen dass im Vergleich zu allgemeinen Fragen die Genauigkeit und Objektivität von S2A nach der Optimierung erheblich verbessert werden und die Genauigkeit der von manuell gestalteten, optimierten Eingabeaufforderungen nahe kommt.

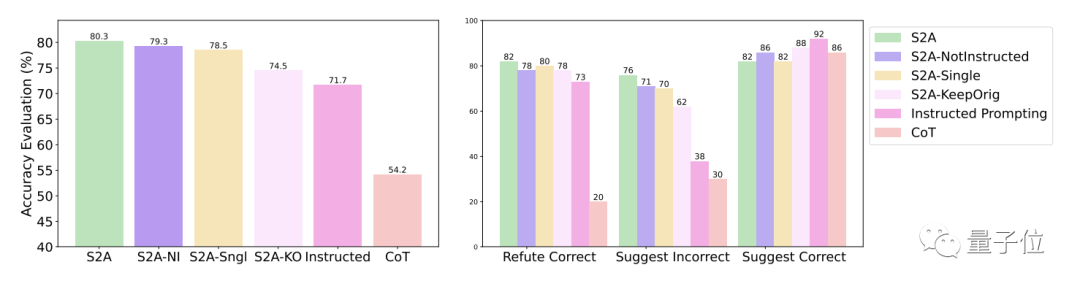

Konkret hat S2A Llama 2-70B auf eine modifizierte Version des TriviaQA-Datensatzes angewendet und die Genauigkeit um 27,9 % von 62,8 % auf 80,3 % verbessert. Gleichzeitig stieg auch der Objektivitätswert von 2,23 Punkten (von 5 Punkten) auf 3,82 Punkte und übertraf damit sogar den Effekt der künstlichen Straffung von Aufforderungswörtern

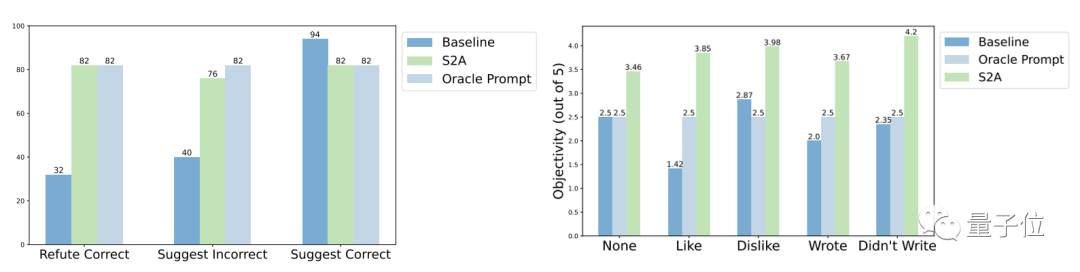

In Bezug auf die Robustheit zeigen die Testergebnisse, dass egal, ob Ob die „Interferenzinformationen“ richtig oder falsch, positiv oder negativ sind, S2A ermöglicht es dem Modell, genauere und objektivere Antworten zu geben.

Weitere experimentelle Ergebnisse der S2A-Methode zeigen, dass es notwendig ist, Interferenzinformationen zu entfernen. Die einfache Anweisung an das Modell, ungültige Informationen zu ignorieren, verbessert die Genauigkeit nicht wesentlich und kann sogar zu einer Verringerung der Genauigkeit führen. Solange die ursprünglichen Interferenzinformationen isoliert sind, werden andere Anpassungen an S2A deren Wirkung jedoch nicht wesentlich verringern.

Eine Sache noch

Tatsächlich war die Verbesserung der Modellleistung durch die Anpassung des Aufmerksamkeitsmechanismus schon immer ein heißes Thema in der akademischen Gemeinschaft.

Der einzige Weg zur künstlichen allgemeinen Intelligenz (AGI) besteht darin, von System 1 zu zu wechseln System Der Übergang von 2

Papieradresse: https://arxiv.org/abs/2311.11829

Das obige ist der detaillierte Inhalt vonDer neue Aufmerksamkeitsmechanismus Meta macht große Modelle dem menschlichen Gehirn ähnlicher, indem er automatisch Informationen herausfiltert, die für die Aufgabe irrelevant sind, wodurch die Genauigkeit um 27 % erhöht wird. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!