(Nweon, 19. Oktober 2023) Tiefenerfassungssysteme wie Time-of-Flight-ToF-Kameras können verwendet werden, um Tiefenbilder der Umgebung für HoloLens 2 zu erzeugen, wobei jedes Pixel des Tiefenbildes die Entfernung zum entsprechenden Punkt in der Umgebung darstellt Umfeld . Bei der ToF-Bildgebung hängt die Entfernung eines Punktes auf der Bildoberfläche in der Umgebung von der Länge des Zeitintervalls ab, das das Licht von der ToF-Kamera benötigt, um zu diesem Punkt zu gelangen und dann zum ToF-Kamerasensor zurückzukehren.

Phasenbasierte ToF-Bildgebung ist eine Variante der ToF-Bildgebung, bei der die Tiefe basierend auf der Phasenverschiebung des vom Objekt zurückreflektierten amplitudenmodulierten Lichts berechnet wird. Aufgrund der Bewegung der ToF-Kamera zwischen Phasendatenerfassungen können die Phasendaten innerhalb eines Bildes relativ verschoben sein. Beispielsweise kann ein Pixel bei einer ersten Intra-Frame-Phasendatenerfassung Phasendaten bei einer ersten Modulationsfrequenz an einem Ort innerhalb der Szene erfassen. Während der Phasendatenerfassung innerhalb des nächsten Frames können die Pixel dann Phasendaten an einem anderen Szenenort mit einer zweiten Modulationsfrequenz erfassen. Die Phasendaten bei verschiedenen Frequenzen werden inkonsistent, was als Bewegungsunschärfe bezeichnet werden kann.

In der Patentanmeldung mit dem Titel „Bewegungskorrektur für Flugzeit-Tiefenbildgebung“ schlug Microsoft daher eine Bewegungskorrekturmethode für die ToF-Bildgebung vor.

Zu diesem Zweck wird das aktive Helligkeits-AB-Bild, das der ersten Beleuchtungslichtmodulationsfrequenz entspricht, mit dem AB-Bild verglichen, das der zweiten Beleuchtungslichtmodulationsfrequenz entspricht, um die zweidimensionale Intra-Frame-Translation zu bestimmen. Die 2D-Übersetzung innerhalb eines Bildes entspricht der geschätzten Bewegung der Kamera relativ zur abgebildeten Szene.

Intra-Frame-2D-Übersetzung wird dann auf die Phasendaten angewendet, um die Ausrichtung der Phasenbilder und die Bildung korrigierter Phasendaten zu unterstützen. Als nächstes wird eine Phasenentpackung an den korrigierten Phasendaten durchgeführt, um ein intraframe-korrigiertes dreidimensionales Tiefenbild zu erhalten. Die Intra-Frame-2D-Übersetzung kann auch verwendet werden, um eine Bewegungskorrektur an Intra-Frame-AB-Bildern durchzuführen. Beispielsweise kann das intraframe-korrigierte AB-Bild durch Mittelung der korrigierten AB-Bilder erhalten werden.

In einem Beispiel wie diesem wird das erste AB-Bild aus dem ersten Frame mit dem zweiten AB-Bild aus dem zweiten Frame verglichen, um die 2D-Translation zwischen Frames zu bestimmen. Die Inter-Frame-Übersetzung ist eine Schätzung der Bewegung zwischen Frames. Anschließend kann eine 2D-Übersetzung zwischen Bildern auf das Tiefenbild des ersten Bildes angewendet werden, um ein zwischen Bildern erzeugtes Tiefenbild zu erzeugen. Die zweidimensionale Inter-Frame-Translation kann aus dem intra-Frame-korrigierten AB-Bild bestimmt werden.

Darüber hinaus kann als Schätzung der Kamerabewegung die 2D-Übersetzung zwischen Bildern ausgegeben und in verschiedenen zeitlichen Nachbearbeitungsroutinen oder Softwarediensten verwendet werden. Daher können die im Patent beschriebenen Ausführungsformen dazu beitragen, eine Bewegungsunschärfekorrektur von 3D-Tiefendaten mithilfe von 2D-Intra-Frame-AB-Bilddaten zu erreichen. Durch die Verwendung von 2D-Daten kann die Bewegungskorrektur in Echtzeit mit relativ effizienter Rechenleistung durchgeführt werden, verglichen mit der Verwendung von 3D-Tiefendaten zur Bewegungsunschärfekorrektur.

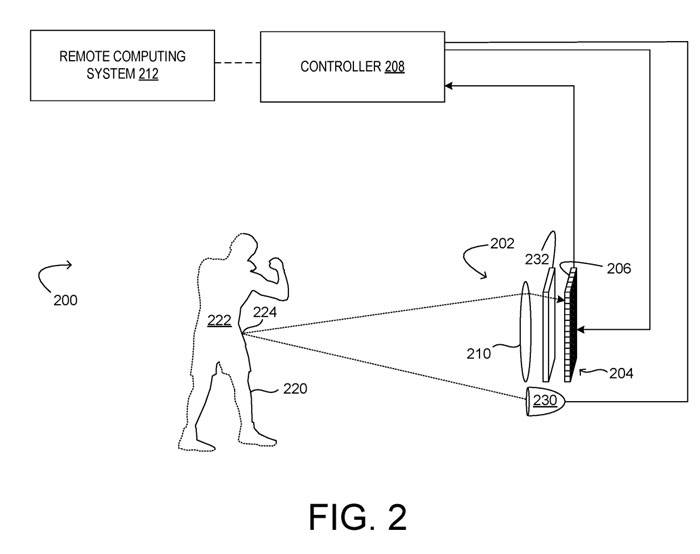

Abbildung 2 zeigt ein Beispiel mit einer ToF-Kamera 202. Unter ihnen ist die ToF-Kamera ein phasenbasiertes ToF-Tiefenbildsystem 200 . Die ToF-Kamera 202 umfasst ein Sensorarray 204 mit mehreren ToF-Pixeln 206, von denen jedes dazu konfiguriert ist, eine Lichtprobe zu erfassen, die Phasendaten erfasst, eine Steuerung 208 und ein Objektivsystem 210.

Der Controller 208 ist so konfiguriert, dass er Daten von den ToF-Pixeln 206 des Sensorarrays 204 sammelt und verarbeitet, um ein Tiefenbild zu erstellen. Der Controller 208 kann ausführbare Anweisungen enthalten, um Rauschunterdrückung und/oder Phasenentfaltung durchzuführen.

Das Tiefenabbildungssystem 200 umfasst sowohl einen modulierten Lichtemitter 230 als auch einen analog und/oder digital modulierten elektronischen Verschluss 232 für das Sensorarray 204, um die Integration von Licht durch das Sensorarray 204 zu steuern. Der modulierte Lichtemitter 230 kann so konfiguriert sein, dass er elektromagnetische Strahlung jeder vom ToF-Pixel 206 erkennbaren Frequenz emittiert.

Das modulierte Licht kann nacheinander oder gleichzeitig mit verschiedenen Frequenzen moduliert werden, und das Sensorarray 204 ist so konfiguriert, dass es das vom modulierten Lichtemitter 230 zur Oberfläche 220 und zurück zur Kamera reflektierte Licht abtastet. Jedes ToF-Erfassungspixel 206 des Sensorarrays 204 kann einen oder mehrere Pixelabgriffe umfassen, um reflektierte Lichtsignale in unterschiedlichen Zeitintervallen zu integrieren und dadurch Phasenverschiebungen zu bestimmen.

Für jede Modulationsfrequenz wird das Sensorarray 204 so gesteuert, dass es das Licht bei mehreren Phasenwinkeln des amplitudenmodulierten Lichts von der Lichtquelle abtastet und aus den mehreren Lichtabtastwerten für die Modulationsfrequenz den Phasenabtastwert für jede Modulationsfrequenz bestimmt. Die Phasenproben können dann entpackt werden, um einen Tiefenwert für jedes Pixel zu erhalten.

Aufgrund der Periodizität des modulierten Lichts wiederholt sich die gemessene Gesamtphase alle 2π. Da n(k) nicht direkt durch phasenbasierte ToF-Pixel gemessen werden kann, sind die Gesamtphase und damit der mit der Messung verbundene tatsächliche Abstand nicht eindeutig. Daher ist bei der phasenbasierten ToF-Bildgebung der messbare Abstand (unschärfefreier Bereich) durch die Modulationsfrequenz begrenzt.

Zwei oder mehr unterschiedliche Modulationsfrequenzen können verwendet werden, um die mehrdeutigkeitsfreie Reichweite zu erhöhen, und dann können die gesammelten Phasenverschiebungsdaten verteilt werden, um die Entfernung genau zu bestimmen.

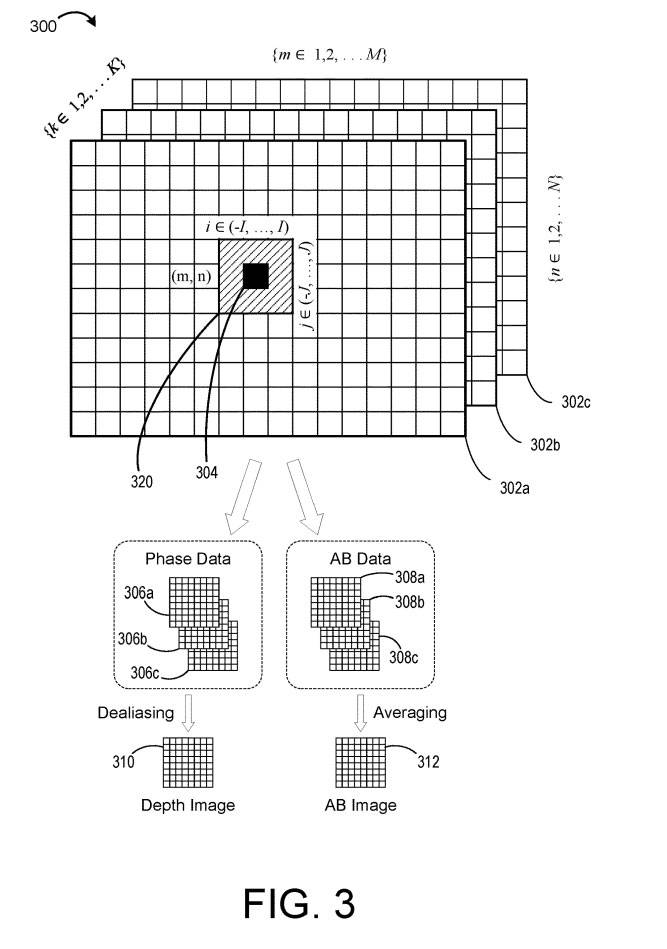

Abbildung 3 zeigt schematisch beispielhafte ToF-Bilddaten 300 für mehrere K Modulationsfrequenzen. Die Daten 300 stellen Daten dar, die vom Tiefenbildgebungssystem 200 während der Mehrfrequenz-Bilderfassung erfasst werden können.

In dem gezeigten Beispiel enthalten die Tiefendaten ein M×N-Array von Daten für jede der K Modulationsfrequenzen, was zu einem M×N-Raster von Intra-Frame-Tiefendaten 302a-c führt, wobei in jedem Raster jedes Pixel 304 repräsentiert ein Messwert, der bei einer entsprechenden Beleuchtungslichtmodulationsfrequenz K von K Modulationsfrequenzen erhalten wird.

Die gemessene Phase wird zur Berechnung des dem Pixel zugeordneten Tiefenwerts verwendet. Aber wie oben erwähnt, ist bei der phasenbasierten ToF-Bildgebung der messbare Abstand (unschärfefreier Bereich) durch die Modulationsfrequenz begrenzt. Daher kann ein Satz von K ≥ 2 Modulationsfrequenzen K verwendet werden, um die Reichweite zu erhöhen, wodurch die Phaseninformationen entschlüsselt werden können, um die Entfernung genau zu bestimmen.

Phase Unwrapping ist eine Methode zur Disambiguierung von Phasenverschiebungsdaten und zur Identifizierung korrekter Entfernungswerte durch Beleuchtung einer Szene mit mehreren amplitudenmodulierten Lichtern unterschiedlicher Frequenz, da die Entfernungsmehrdeutigkeit für jede Frequenz des Beleuchtungslichts unterschiedlich ist.

Wenn sich die ToF-Tiefenkamera jedoch in Bewegung befindet, können, wie oben erwähnt, Fehler beim Phasenauspacken auftreten. Da die Tiefendatenerfassung bei jeder Frequenz nacheinander erfolgt, werden das Phasenbild und das AB-Bild vorübergehend innerhalb eines Frames getrennt.

Zum Beispiel kann das Intra-Frame-Phasenbild 306a Phasendaten der ersten Frequenz ƒ1 enthalten, die zu Beginn des Frames erfasst wurden, und das Intra-Frame-Phasenbild 306b kann Phasendaten der zweiten Frequenz ƒ2 enthalten, die zur Mitte des Frames erfasst wurden, die Intra-Frame-Phase Das Bild 306b kann Phasendaten der dritten Frequenz ƒ3 enthalten, die gegen Ende des Rahmens erfasst wurden.

Wenn sich die ToF-Tiefenkamera zwischen Intra-Frame-Aufnahmen bewegt, können die Phasendaten bei den drei verschiedenen Frequenzen verschoben und falsch ausgerichtet sein. Inkonsistente Phasendaten können zu Fehlern beim Phasenabrollen führen.

Daher schlug Microsoft eine Lösung vor, die AB-Bilddaten nutzt, um die Bewegung abzuschätzen und die 2D-Translation zu bestimmen.

Das Unternehmen weist darauf hin, dass zwar Tiefendaten verwendet werden können, die Bestimmung der 2D-Übersetzung auf der Grundlage von AB-Bilddaten jedoch aufgrund aktiver Helligkeitsunterschiede zwischen Objekten in der Szene robuster sein kann. Mithilfe der 2D-Übersetzung kann dann eine Intra-Frame-Bewegungskorrektur an den Phasendaten durchgeführt werden. Das Durchführen des Phasen-Unwrappings für Intra-Frame-korrigierte Phasendaten kann dazu beitragen, Unwrapping-Fehler aufgrund von Bewegungsunschärfe zu vermeiden.

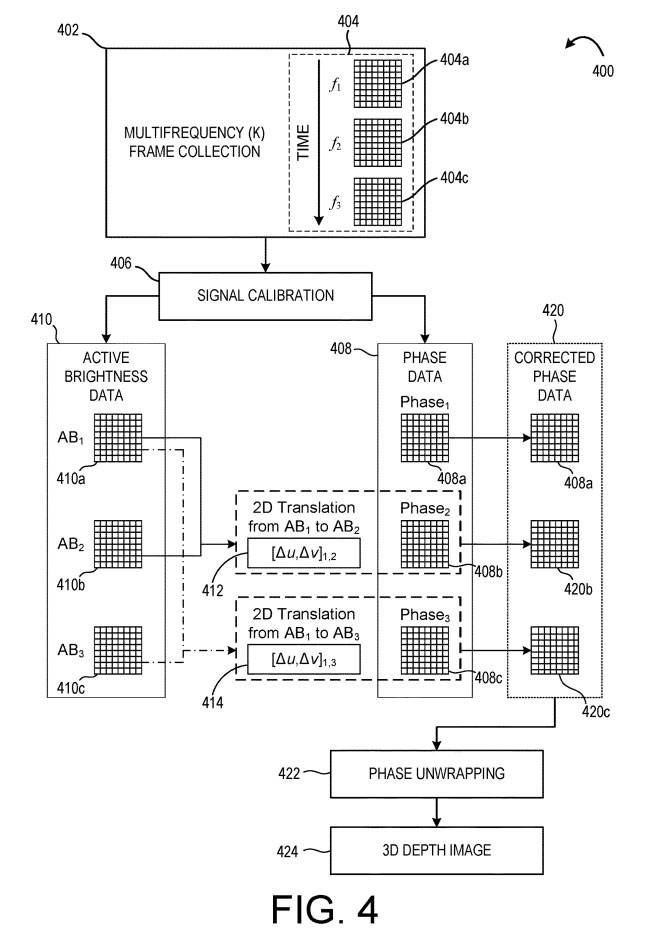

Abbildung 4 zeigt eine Beispielmethode zur Durchführung einer solchen Korrektur an Tiefendaten vor dem Phasenentpacken. Methode 400 kann in einem Computersystem implementiert werden, das Daten von einer ToF-Tiefenkamera empfängt.

Bei 402 wird eine Multifrequenz-Frame-Sammlung durchgeführt, bei der mehrere Intra-Frame-Phasenproben vom ToF-Bildsensor gesammelt werden. Für jede einer Vielzahl von Beleuchtungslichtmodulationsfrequenzen (f1, f2, f3) werden Intra-Frame-Phasenabtastwerte gesammelt, um entsprechende Intra-Frame-Tiefendaten 404a-c zu bilden. In diesem Beispiel werden zuerst die Intra-Frame-Tiefendaten 404a, als Zweites die Intra-Frame-Tiefendaten 404b und als Drittes die Intra-Frame-Tiefendaten 404c erhalten, wie durch den Zeitpfeil dargestellt.

Bei 406 wird eine Signalkalibrierungskorrektur durchgeführt, um Phasendaten 408 und aktive Helligkeitsdaten 410 zu erhalten. Wie oben erwähnt, können Intra-Frame-Tiefendaten bei unterschiedlichen Frequenzen aufgrund der Kamerabewegung relativ verschoben sein. Daher vergleicht das Verfahren 400 die aktiven Helligkeitsdaten 410, um die Bewegung abzuschätzen und zu korrigieren.

Hier wird das Intra-AB-Bild 410a mit dem Intra-AB-Bild 410b verglichen, um die erste Intra-Frame-2D-Translation 412 zu bestimmen. Die zweidimensionale Übersetzung von AB1 nach AB2 kann als [Δu, Δv]1,2 ausgedrückt werden, wobei Δu die Pixelverschiebung in x-Richtung und Δv die Pixelverschiebung in y-Richtung ist. Die Intra-2D-Übersetzung 412 ist eine Schätzung der Bewegung zwischen den Intra-Frame-Tiefendaten 404a und den Intra-Frame-Tiefendaten 404b.

Als nächstes wird das Intra-AB-Bild 410a mit dem Intra-AB-Bild 410c verglichen, um eine zweite Intra-2D-Translation 414 zu bestimmen, die als [Δu, Δv] 13 bezeichnet wird.

In einer Ausführungsform kann das Intra-AB-Bild 410b mit dem Intra-AB-Bild 410c verglichen werden, um eine dritte Intra-Frame-2D-Translation zu bestimmen. In anderen Beispielen können alle geeigneten Intra-Frame-AB-Bildpaare verglichen werden, um entsprechende Intra-Frame-2D-Translationen zu bestimmen. Um die AB-Bilder zu vergleichen und die Übersetzung zu bestimmen, kann jede geeignete Methode verwendet werden. In einem Beispiel werden Merkmale aus AB-Bildern extrahiert, zu Merkmalskarten geformt und zum Vergleichen von Bildern verwendet.

Nach der Ermittlung der 2D-Übersetzung können die Phasendaten anhand der ermittelten Übersetzung korrigiert werden. In der in FIG. 4 gezeigten Ausführungsform wird eine zweidimensionale Intra-Frame-Translation 412 auf das Phasenbild 408b angewendet, um das Phasenbild zu korrigieren, um ein korrigiertes Phasenbild 420b zu erzeugen. In ähnlicher Weise wird eine zweidimensionale Intra-Frame-Translation 414 am Phasenbild 408c durchgeführt, um das Phasenbild zu korrigieren und ein korrigiertes Phasenbild 420c zu erzeugen.

Daher stellen die korrigierten Phasendaten 420 die Phasendaten dar, die auf das Phasenbild 408a „neu ausgerichtet“ wurden. In einem Beispiel können eine oder mehrere zweidimensionale Verschiebungen angewendet werden, um ein korrigiertes Phasenbild zu erzeugen, das mit dem Phasenbild 408b oder 408c ausgerichtet ist.

Bei 422 umfasst das Verfahren 400 auch das Durchführen einer Phasenentfaltung an den korrigierten Phasendaten 420, um ein Tiefenbild 424 zu erstellen. Da die korrigierten Phasenbilder 420b, 420c mit dem Phasenbild 408a neu ausgerichtet werden können, kann das Phasen-Unwrapping bei 422 relativ weniger Unwrapping-Fehler erzeugen als in dem Beispiel, in dem die Bewegungsunschärfekorrektur ignoriert wird.

Methode 400 kann also dazu beitragen, eine bessere Leistung bei der Verarbeitung der Tiefendaten 404 zur Bildung des Tiefenbilds 424 zu erzielen.

Außerdem kann die Anwendung der Intra-Frame-2D-Übersetzung über Faltung durchgeführt werden und kann daher mit räumlichen und zeitlichen Filterprozessen kombiniert werden, die ebenfalls Faltung nutzen. Gleichzeitig kann die ermittelte Intra-Frame-2D-Translation als Schätzung der Kamerabewegung für verschiedene Nachbearbeitungsanwendungen nützlich sein, wie z. B. zeitliche Filter, Trajektorienschätzung, dynamische Regionsschätzung oder Kartierung. Ähnliche Techniken können verwendet werden, um Intra-AB-Bilder zu korrigieren und intra-korrigierte AB-Bilder zu erstellen.

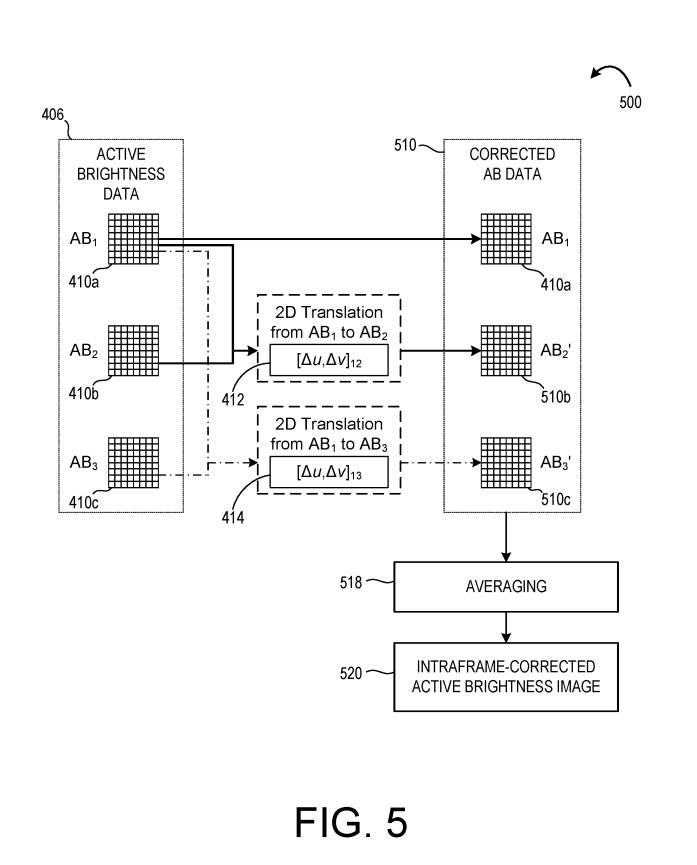

Unter Bezugnahme auf Abbildung 5 nutzt die Methode 500 die zweidimensionale Intra-Frame-Übersetzung 412, 414, um korrigierte AB-Daten 510 zu bilden. In einem Beispiel wird Methode 500 zusammen mit Methode 400 durchgeführt. In anderen Beispielen wird Methode 500 getrennt von Methode 400 durchgeführt.

Wie in Abbildung 5 gezeigt, wird eine zweidimensionale Intra-Frame-Translation 412 auf das Intra-Frame-AB-Bild 410b angewendet, um das Bild zu korrigieren und ein korrigiertes AB-Bild 510b zu erzeugen. Darüber hinaus wird eine zweidimensionale Intra-Frame-Translation 414 auf das AB-Bild 410c angewendet, um das korrigierte AB-Bild 510c zu erzeugen. Zusammen mit dem Intra-AB-Bild 408a bilden die korrigierten AB-Bilder 510b-c die korrigierten AB-Daten 510.

Bei 518 umfasst das Verfahren 500 außerdem die Mittelung der korrigierten AB-Daten 510, um ein Intra-Frame-korrigiertes AB-Bild 520 zu bilden. Das intrakorrigierte AB-Bild 520 kann zur weiteren Verarbeitung und/oder Ausgabe an eine Anzeige ausgegeben werden.

Intra-Frame-korrigierte AB-Bilder können auch zur Erstellung von Inter-Frame-Tiefenbildern verwendet werden. Zusätzlich zur Korrektur von Bewegungsunschärfe innerhalb von Tiefenbildbildern kann eine Korrektur auch zwischen Bildern durchgeführt werden.

Verwandte Patente: Microsoft-Patent |. Bewegungskorrektur für Flugzeit-Tiefenbildgebung

Die Microsoft-Patentanmeldung mit dem Titel „Motion Correction for Time-of-Flight Depth Imaging“ wurde ursprünglich im März 2022 eingereicht und kürzlich vom US-Patent- und Markenamt veröffentlicht.

Das obige ist der detaillierte Inhalt vonMicrosoft AR/VR-Patent teilt Bewegungskorrekturmethode für ToF-Bildgebung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!