Großformatige Modelle schaffen den Sprung zwischen Sprache und Vision und versprechen, Text- und Bildinhalte nahtlos zu verstehen und zu generieren. Einer Reihe aktueller Studien zufolge ist die Integration multimodaler Funktionen nicht nur ein wachsender Trend, sondern hat bereits zu wichtigen Fortschritten geführt, die von multimodalen Gesprächen bis hin zu Tools zur Inhaltserstellung reichen. Große Sprachmodelle haben beispiellose Fähigkeiten beim Verstehen und Generieren von Texten gezeigt. Die gleichzeitige Generierung von Bildern mit kohärenten Texterzählungen ist jedoch noch ein Bereich, der noch entwickelt werden muss

Kürzlich hat ein Forschungsteam der University of California, Santa Cruz, MiniGPT-5 vorgeschlagen, das auf dem innovativen Konzept der „generativen Abstimmung“ basiert Technologie zur Erzeugung verschachtelter visueller Sprache.

Durch die Kombination eines stabilen Diffusionsmechanismus mit LLM durch ein spezielles visuelles Token „generative Abstimmung“ läutet MiniGPT-5 einen neuen Weg für ein kompetentes multimodales Generationsmodell ein. Gleichzeitig betont die in diesem Artikel vorgeschlagene zweistufige Trainingsmethode die Bedeutung der beschreibungsfreien Grundphase, damit das Modell auch bei knappen Daten erfolgreich sein kann. Die allgemeine Phase der Methode erfordert keine domänenspezifischen Anmerkungen, wodurch sich unsere Lösung von bestehenden Methoden unterscheidet. Um sicherzustellen, dass der generierte Text und die Bilder harmonisch sind, kommt die Doppelverluststrategie dieses Artikels ins Spiel, die durch die generative Abstimmungsmethode und die Klassifizierungsmethode weiter verbessert wird

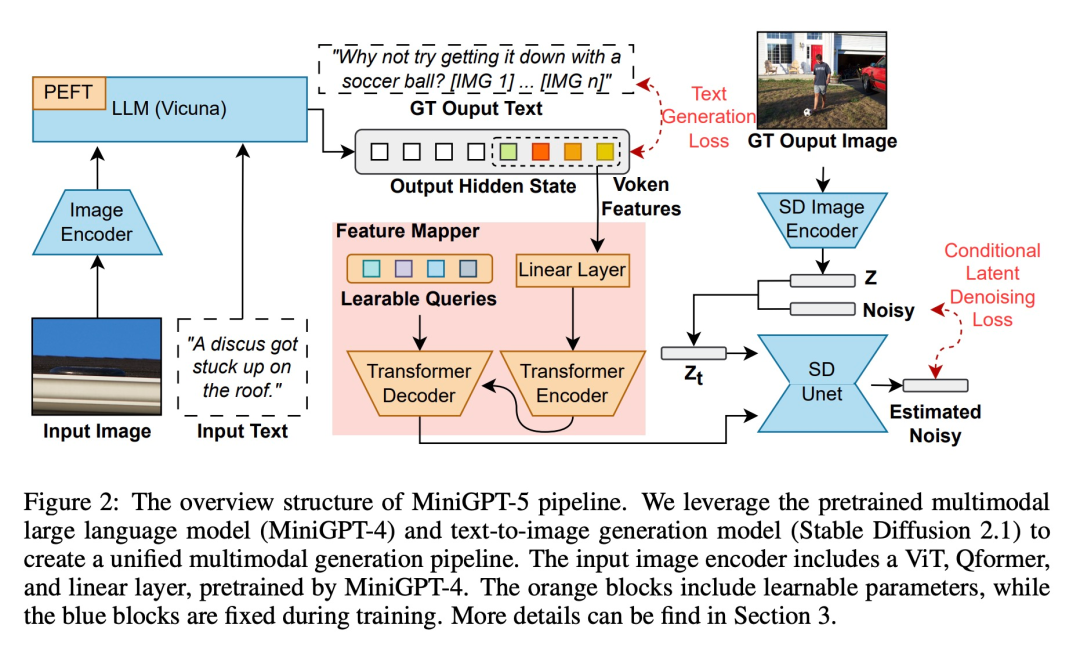

Basierend auf diesen Techniken markiert diese Arbeit a Transformativer Ansatz. Mithilfe von ViT (Vision Transformer) und Qformer sowie einem großen Sprachmodell wandelt das Forschungsteam multimodale Eingaben in generative Abstimmungen um und kombiniert sie nahtlos mit der hochauflösenden Stable Diffusion2.1, um eine kontextbewusste Bildgenerierung zu erreichen. Dieses Papier kombiniert Bilder als Hilfseingabe mit Methoden zur Befehlsanpassung und leistet Pionierarbeit bei der Verwendung von Text- und Bildgenerierungsverlusten, wodurch die Synergie zwischen Text und Vision erweitert wird. MiniGPT-5 passt Modelle wie CLIP-Einschränkungen an und kombiniert das Diffusionsmodell geschickt mit MiniGPT-4 erzielt bessere multimodale Ergebnisse, ohne auf domänenspezifische Annotationen angewiesen zu sein. Am wichtigsten ist, dass unsere Strategie Fortschritte in den zugrunde liegenden Modellen multimodaler visueller Sprache nutzen kann, um einen neuen Entwurf für die Verbesserung multimodaler generativer Fähigkeiten bereitzustellen.

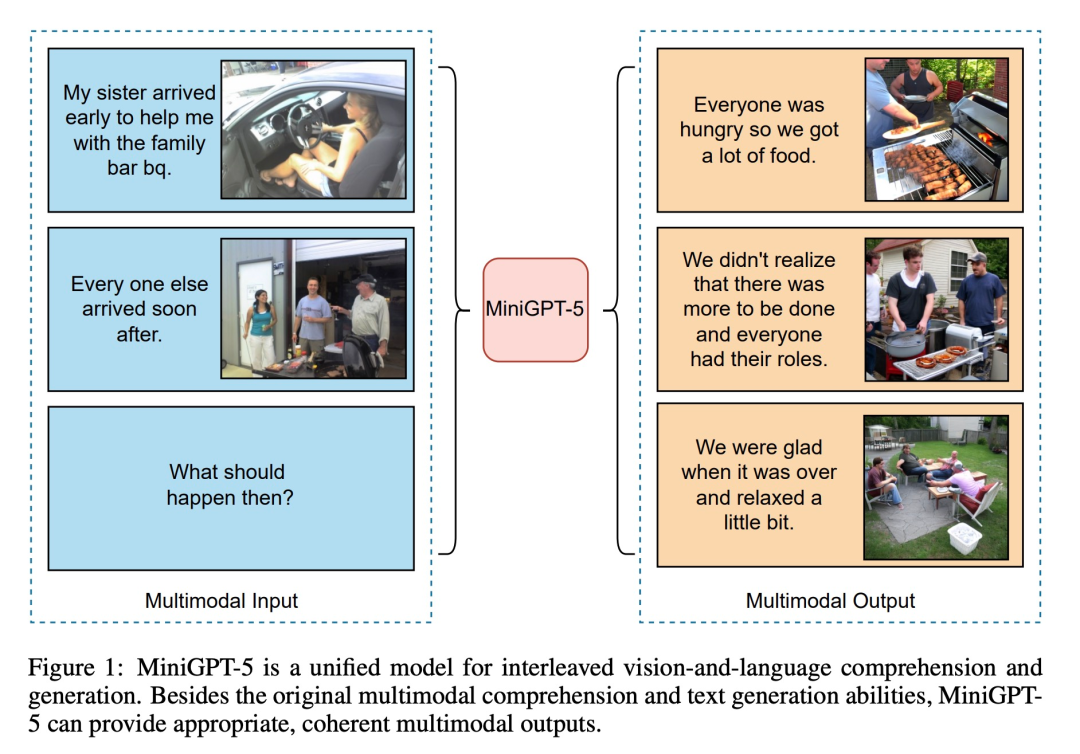

Wie in der folgenden Abbildung gezeigt, kann MiniGPT5 zusätzlich zu den ursprünglichen multimodalen Verständnis- und Textgenerierungsfunktionen auch eine vernünftige und kohärente multimodale Ausgabe bereitstellen:

Der Beitrag dieses Artikels ist spiegelt sich in drei Aspekten wider:

Es wird vorgeschlagen, einen multimodalen Encoder zu verwenden, der eine neuartige allgemeine Technik darstellt und sich als effektiver als LLM und inverse generative Vokens erwiesen hat, und ihn mit stabiler Diffusion zu kombinieren, um Interleaved zu erzeugen visuelle und sprachliche Ausgabe (ein multimodales Sprachmodell, das multimodal generiert werden kann).

Übersicht über die Methode Vorab trainierte multimodale groß angelegte Sprachmodelle und Text-zu-Bild-Generierungsmodelle sind integriert. Um die Unterschiede zwischen verschiedenen Modellfeldern zu lösen, führten sie spezielle visuelle Symbole „generative Stimmen“ ein, die direkt auf den Originalbildern trainiert werden können. Darüber hinaus wird eine zweistufige Trainingsmethode in Kombination mit einer klassifikatorfreien Bootstrapping-Strategie weiterentwickelt, um die Generierungsqualität weiter zu verbessern.

Multimodale Eingabephase

Jüngste Fortschritte bei großen multimodalen Modellen (wie MiniGPT-4) konzentrieren sich hauptsächlich auf das multimodale Verständnis und die Fähigkeit, Bilder als kontinuierliche Eingaben zu verarbeiten. Um seine Fähigkeiten auf die multimodale Generierung zu erweitern, führten die Forscher generative Vokens ein, die speziell für die Ausgabe visueller Merkmale entwickelt wurden. Darüber hinaus haben sie auch eine Parameter-effiziente Feinabstimmungstechnologie im Rahmen des Large Language Model (LLM) für multimodales Output-Lernen übernommen Token ist Um eine präzise Ausrichtung der Modelle zu erzeugen, entwickelten die Forscher ein kompaktes Zuordnungsmodul für den Dimensionsabgleich und führten mehrere überwachte Verluste ein, darunter Textraumverlust und latente Diffusionsmodellverluste. Der Textraumverlust hilft dem Modell, die Position von Token genau zu lernen, während der latente Diffusionsverlust Token direkt an geeigneten visuellen Merkmalen ausrichtet. Da die Merkmale generativer Symbole direkt durch Bilder gesteuert werden, erfordert diese Methode keine vollständige Bildbeschreibung und ermöglicht ein beschreibungsfreies Lernen Durch die Verschiebung der Textdomäne und der Bilddomäne fanden Forscher heraus, dass das Training direkt an einem begrenzten verschachtelten Text- und Bilddatensatz zu einer Fehlausrichtung und einer Verschlechterung der Bildqualität führen kann.

Also nutzten sie zwei unterschiedliche Trainingsstrategien, um dieses Problem zu mildern. Die erste Strategie beinhaltet den Einsatz klassifikatorfreier Bootstrapping-Techniken, um die Wirksamkeit der generierten Token während des gesamten Diffusionsprozesses zu verbessern. Die zweite Strategie gliedert sich in zwei Phasen: eine anfängliche Vortrainingsphase, die sich auf die grobe Merkmalsausrichtung konzentriert, gefolgt von einer Feinabstimmungsphase zum Thema komplexes Feature-Learning.

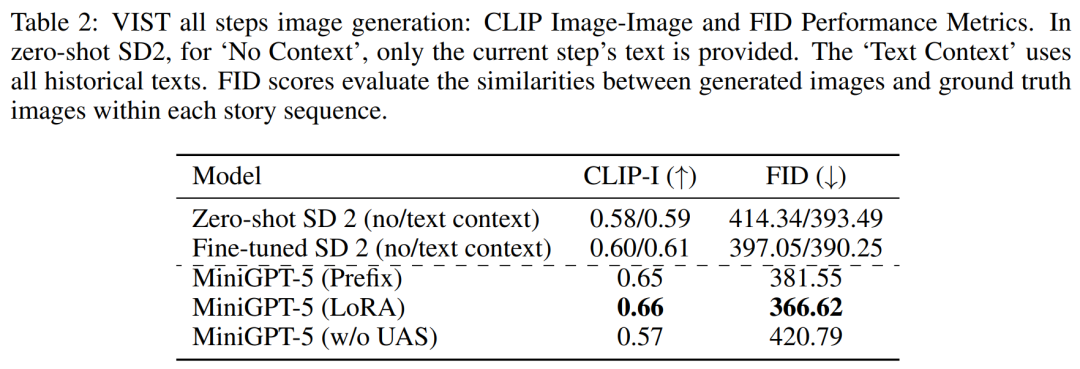

Experimente und ErgebnisseUm die Wirksamkeit des Modells zu bewerten, wählten die Forscher mehrere Benchmarks aus und führten eine Reihe von Bewertungen durch. Der Zweck des Experiments besteht darin, mehrere Schlüsselfragen zu beantworten: Kann

MiniGPT-5 glaubwürdige Bilder und vernünftigen Text erzeugen?

Wie schneidet MiniGPT-5 im Vergleich zu anderen SOTA-Modellen bei ein- und mehrrundigen verschachtelten visuellen Sprachgenerierungsaufgaben ab?

Welche Auswirkungen hat das Design jedes Moduls auf die Gesamtleistung?

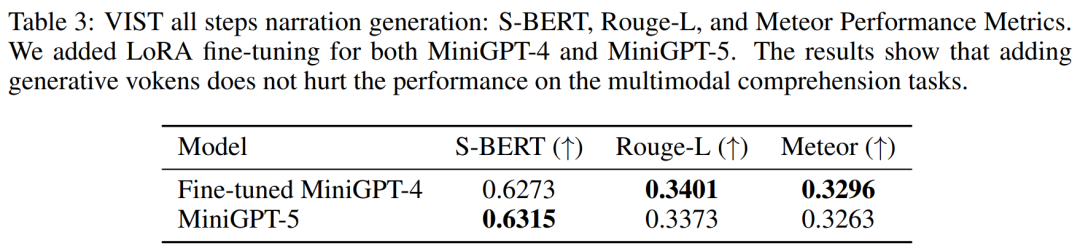

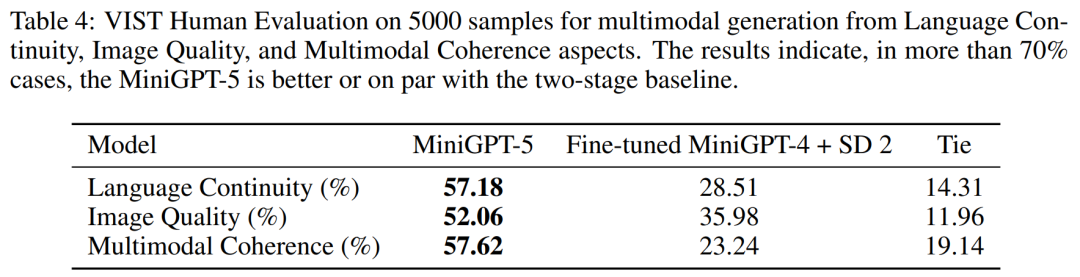

Tabelle 2 und Tabelle 3 fassen die Ergebnisse dieser Experimente zusammen und bieten einen Überblick über die Leistung bei Bild- bzw. Sprachmetriken. Experimentelle Ergebnisse zeigen, dass MiniGPT-5 in der Lage ist, multimodale Eingabehinweise auf langer Ebene zu nutzen, um kohärente, qualitativ hochwertige Bilder über alle Daten hinweg zu erzeugen, ohne die multimodalen Verständnisfähigkeiten des Originalmodells zu beeinträchtigen. Dies unterstreicht die Wirksamkeit von MiniGPT-5 in verschiedenen Umgebungen 0,18 % generierten mehr Relevanz Texterzählungen in 52,06 % der Fälle, eine bessere Bildqualität in 52,06 % der Fälle und eine kohärentere multimodale Ausgabe in 57,62 % der Szenen. Verglichen mit einer zweistufigen Basislinie, die eine Text-zu-Bild-Erzählung ohne Konjunktivstimmung anwendet, zeigen diese Daten deutlich die stärkeren Fähigkeiten zur multimodalen Generierung.

MMDialog Mehrere Bewertungsrunden

MMDialog Mehrere Bewertungsrunden

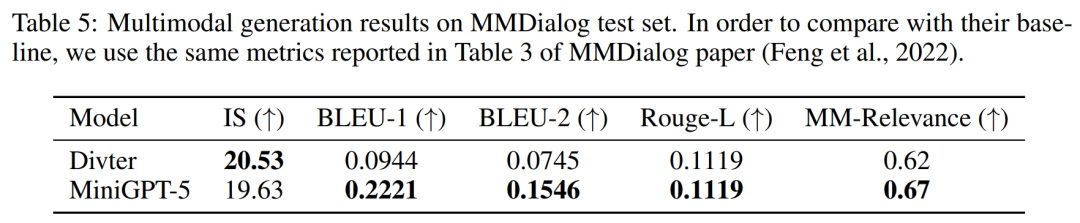

Gemäß den Ergebnissen in Tabelle 5 ist MiniGPT-5 bei der Generierung von Textantworten genauer als das Basismodell Divter. Obwohl die generierten Bilder von ähnlicher Qualität sind, übertrifft MiniGPT-5 das Basismodell in Bezug auf MM-Korrelationen, was darauf hindeutet, dass es besser lernen kann, die Bilderzeugung angemessen zu positionieren und hochkonsistente multimodale Antworten zu generieren

Werfen wir einen Blick auf die Ausgabe von MiniGPT-5 und sehen, wie effektiv es ist. Abbildung 7 unten zeigt den Vergleich zwischen MiniGPT-5 und dem Basismodell auf dem CC3M-Verifizierungssatz.

Abbildung 8 unten zeigt den Vergleich zwischen MiniGPT-5 und dem Basismodell auf dem VIST-Verifizierungssatz

Abbildung 9 unten zeigt den Vergleich zwischen MiniGPT-5 und dem Basismodell im MMDialog-Testsatz.

Weitere Forschungsdetails finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonMiniGPT-5, das Bild- und Textgenerierung vereinheitlicht, ist da: Aus Token wird Voken, und das Modell kann nicht nur weiterschreiben, sondern auch automatisch Bilder hinzufügen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So binden Sie Daten in einer Dropdown-Liste

So binden Sie Daten in einer Dropdown-Liste

Was ist der Unterschied zwischen PHP7 und PHP8?

Was ist der Unterschied zwischen PHP7 und PHP8?

Methode zum Löschen von Hiberfil-Dateien

Methode zum Löschen von Hiberfil-Dateien

vcruntime140.dll kann nicht gefunden werden und die Codeausführung kann nicht fortgesetzt werden

vcruntime140.dll kann nicht gefunden werden und die Codeausführung kann nicht fortgesetzt werden

So erhalten Sie Daten in HTML

So erhalten Sie Daten in HTML

Überprüfen Sie die Portbelegung unter Linux

Überprüfen Sie die Portbelegung unter Linux

Was soll ich tun, wenn mein Laufwerk C rot wird?

Was soll ich tun, wenn mein Laufwerk C rot wird?

Win10 unterstützt die Festplattenlayoutlösung der Uefi-Firmware nicht

Win10 unterstützt die Festplattenlayoutlösung der Uefi-Firmware nicht