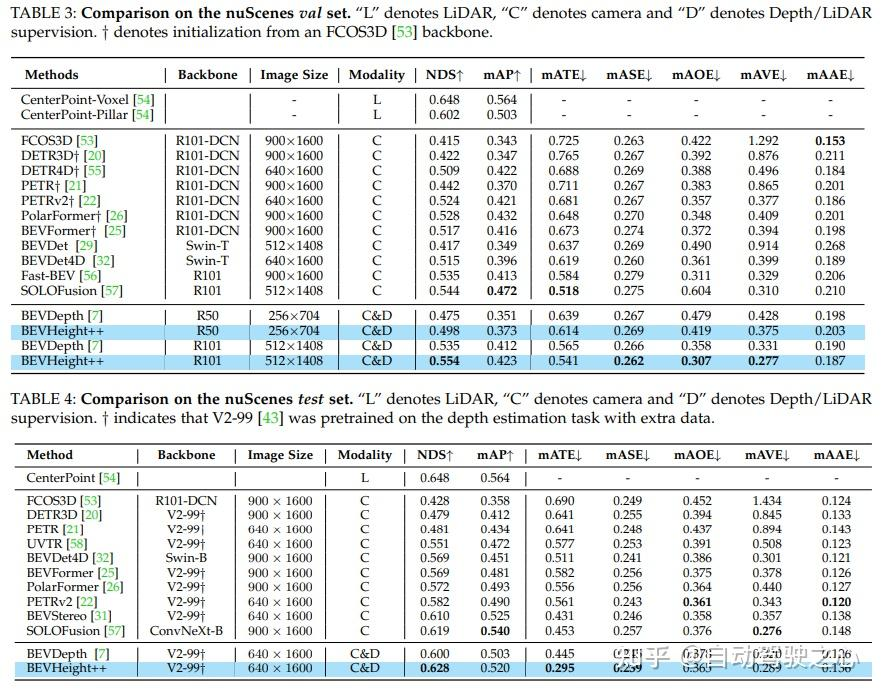

Regress auf die Höhe des Bodens, um eine entfernungsunabhängige Formulierung zu erreichen und so den Optimierungsprozess für nur kamerabewusste Methoden zu vereinfachen. Beim 3D-Erkennungs-Benchmark von Straßenkameras übertrifft die Methode alle bisherigen sichtzentrierten Methoden deutlich. Es führt zu erheblichen Verbesserungen von +1,9 % NDS und +1,1 % mAP gegenüber BEVDepth. Auf dem nuScenes-Testset erzielte die Methode erhebliche Fortschritte, wobei NDS und mAP um +2,8 % bzw. +1,7 % anstiegen.

Titel: BEVHeight++: Auf dem Weg zu einer robusten visionszentrierten 3D-Objekterkennung

Link zum Papier: https://arxiv.org/pdf/2309.16179.pdf

Autorenzugehörigkeit: Tsinghua University, Sun Yat-sen University, Cainiao Network, Peking Universität

Von der ersten autonomen Fahrgemeinschaft in China: Der Bau von mehr als 20 technischen Richtungslernrouten (BEV-Wahrnehmung/3D-Erkennung/Multisensor-Fusion/SLAM und Planung usw.) wurde endlich abgeschlossen.

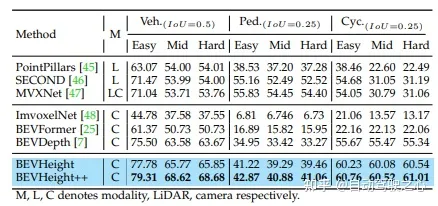

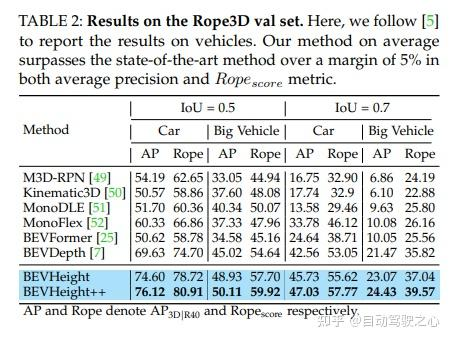

Obwohl die jüngsten autonomen Fahrsystem konzentriert sich auf die Entwicklung von Erfassungsmethoden für Fahrzeugsensoren, aber eine oft übersehene Alternative ist der Einsatz intelligenter Straßenkameras, um die Erfassungsfähigkeiten über den Sichtbereich hinaus zu erweitern. Die Autoren stellten fest, dass hochmoderne visionszentrierte BEV-Erkennungsmethoden bei Straßenkameras schlecht funktionieren. Dies liegt daran, dass sich diese Methoden hauptsächlich auf die Wiederherstellung der Tiefe um die Kameramitte konzentrieren, wo der Tiefenunterschied zwischen dem Auto und dem Boden mit der Entfernung schnell abnimmt. In diesem Artikel schlägt der Autor eine einfache, aber effektive Methode namens BEVHeight++ vor, um dieses Problem zu lösen. Im Wesentlichen regressieren die Autoren auf die Höhe des Bodens, um eine entfernungsunabhängige Formulierung zu erreichen und dadurch den Optimierungsprozess für rein kamerabewusste Methoden zu vereinfachen. Durch die Kombination von Höhen- und Tiefenkodierungstechniken wird eine genauere und robustere Projektion vom 2D- in den BEV-Raum erreicht. Die Methode übertrifft alle bisherigen sichtzentrierten Methoden beim beliebten 3D-Erkennungs-Benchmark für Straßenkameras deutlich. Bei Selbstfahrzeugszenen übertrifft BEVHeight++ reine Tiefenmethoden. Insbesondere führt es zu deutlichen Verbesserungen von +1,9 % NDS und +1,1 % mAP gegenüber BEVDepth, wenn es mit dem nuScenes-Validierungssatz ausgewertet wird. Darüber hinaus erzielt die Methode im nuScenes-Testset erhebliche Fortschritte, wobei NDS und mAP um +2,8 % bzw. +1,7 % anstiegen.

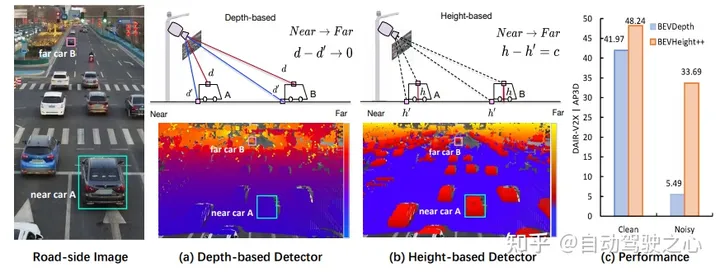

Abbildung 1: (a) Um 3D-Begrenzungsrahmen aus monokularen Bildern zu generieren, sagen moderne Methoden zunächst die Tiefe pro Pixel voraus, entweder explizit oder implizit, um die 3D-Position von Vordergrundobjekten im Vergleich zu zu bestimmen Hintergrund. Als wir jedoch die Tiefe pro Pixel auf dem Bild aufzeichneten, stellten wir fest, dass der Unterschied zwischen Punkten auf dem Dach und dem umgebenden Boden schnell kleiner wird, wenn sich das Auto von der Kamera entfernt, was die Optimierung insbesondere für entfernte Objekte suboptimal macht . (b) Stattdessen zeichnen wir die Höhe pro Pixel zum Boden auf und stellen fest, dass dieser Unterschied unabhängig von der Entfernung unabhängig ist und für das Netzwerk visuell besser geeignet ist, Objekte zu erkennen. Die 3D-Position kann jedoch nicht direkt durch die Vorhersage der Höhe allein zurückgeführt werden. (c) Zu diesem Zweck schlagen wir ein neues Framework BEVHeight++ vor, um dieses Problem zu lösen. Empirische Ergebnisse zeigen, dass unsere Methode die beste Methode bei sauberen Einstellungen um 5,49 % und bei lauten Einstellungen um 28,2 % übertrifft.

Abbildung 1: (a) Um 3D-Begrenzungsrahmen aus monokularen Bildern zu generieren, sagen moderne Methoden zunächst die Tiefe pro Pixel voraus, entweder explizit oder implizit, um die 3D-Position von Vordergrundobjekten im Vergleich zu zu bestimmen Hintergrund. Als wir jedoch die Tiefe pro Pixel auf dem Bild aufzeichneten, stellten wir fest, dass der Unterschied zwischen Punkten auf dem Dach und dem umgebenden Boden schnell kleiner wird, wenn sich das Auto von der Kamera entfernt, was die Optimierung insbesondere für entfernte Objekte suboptimal macht . (b) Stattdessen zeichnen wir die Höhe pro Pixel zum Boden auf und stellen fest, dass dieser Unterschied unabhängig von der Entfernung unabhängig ist und für das Netzwerk visuell besser geeignet ist, Objekte zu erkennen. Die 3D-Position kann jedoch nicht direkt durch die Vorhersage der Höhe allein zurückgeführt werden. (c) Zu diesem Zweck schlagen wir ein neues Framework BEVHeight++ vor, um dieses Problem zu lösen. Empirische Ergebnisse zeigen, dass unsere Methode die beste Methode bei sauberen Einstellungen um 5,49 % und bei lauten Einstellungen um 28,2 % übertrifft.

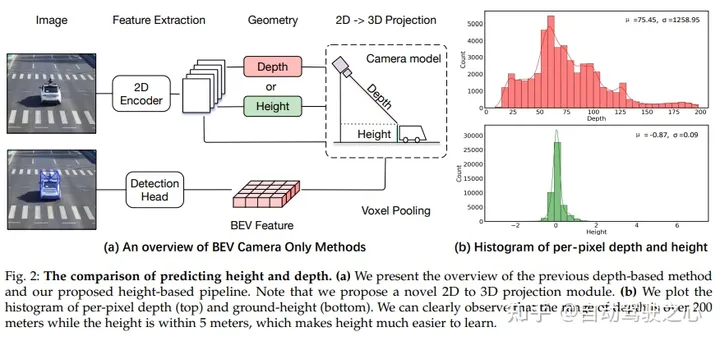

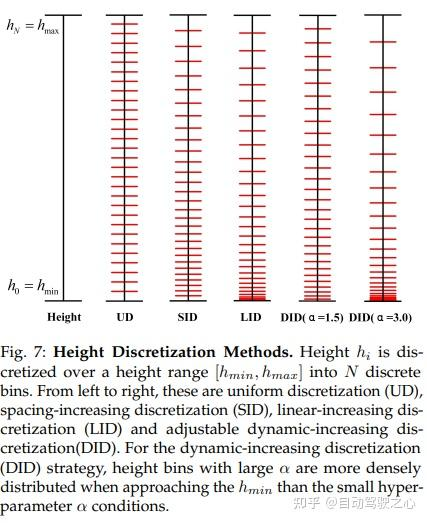

Vergleich der Vorhersagehöhe und -tiefe. (a) Überblick über frühere tiefenbasierte Methoden und unsere vorgeschlagene höhenbasierte Pipeline. Bitte beachten Sie, dass in diesem Artikel ein neuartiges 2D-zu-3D-Projektionsmodul vorgeschlagen wird. (b) Wenn man Histogramme der Tiefe pro Pixel (oben) und der Bodenhöhe (unten) zeichnet, kann man deutlich erkennen, dass der Tiefenbereich über 200 Meter liegt, während die Höhe innerhalb von 5 Metern liegt, was das Erlernen der Höhe erleichtert.

Vergleich der Vorhersagehöhe und -tiefe. (a) Überblick über frühere tiefenbasierte Methoden und unsere vorgeschlagene höhenbasierte Pipeline. Bitte beachten Sie, dass in diesem Artikel ein neuartiges 2D-zu-3D-Projektionsmodul vorgeschlagen wird. (b) Wenn man Histogramme der Tiefe pro Pixel (oben) und der Bodenhöhe (unten) zeichnet, kann man deutlich erkennen, dass der Tiefenbereich über 200 Meter liegt, während die Höhe innerhalb von 5 Metern liegt, was das Erlernen der Höhe erleichtert.

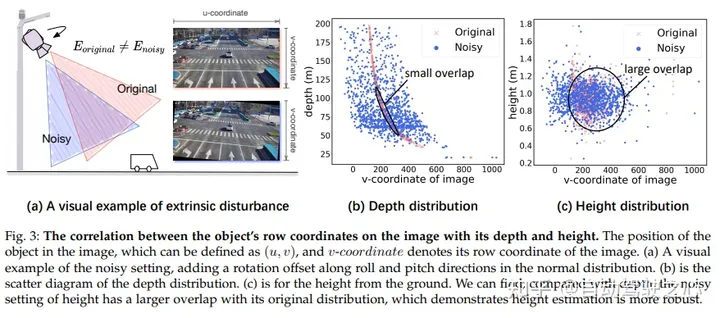

Im Bild besteht ein Zusammenhang zwischen den Reihenkoordinaten des Ziels und seiner Tiefe und Höhe. Die Position des Ziels im Bild kann durch (u, v) definiert werden, wobei v die Zeilenkoordinate des Bildes darstellt. In (a) zeigen wir ein visuelles Beispiel für die Einführung von Lärm durch Hinzufügen von Rotationsversätzen in Roll- und Nickrichtung zu einer Normalverteilung. In (b) zeigen wir ein Streudiagramm der Tiefenverteilung. In (c) zeigen wir die Höhe über dem Boden. Wir können beobachten, dass die Rauscheinstellung für die Höhe im Vergleich zur Tiefe eine größere Überlappung mit ihrer ursprünglichen Verteilung aufweist, was darauf hindeutet, dass die Höhenschätzung robuster ist

Im Bild besteht ein Zusammenhang zwischen den Reihenkoordinaten des Ziels und seiner Tiefe und Höhe. Die Position des Ziels im Bild kann durch (u, v) definiert werden, wobei v die Zeilenkoordinate des Bildes darstellt. In (a) zeigen wir ein visuelles Beispiel für die Einführung von Lärm durch Hinzufügen von Rotationsversätzen in Roll- und Nickrichtung zu einer Normalverteilung. In (b) zeigen wir ein Streudiagramm der Tiefenverteilung. In (c) zeigen wir die Höhe über dem Boden. Wir können beobachten, dass die Rauscheinstellung für die Höhe im Vergleich zur Tiefe eine größere Überlappung mit ihrer ursprünglichen Verteilung aufweist, was darauf hindeutet, dass die Höhenschätzung robuster ist

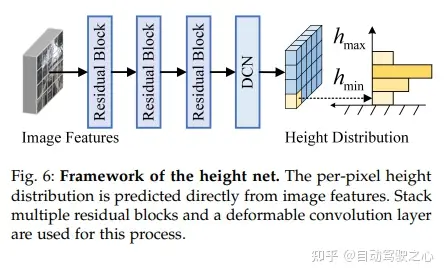

Das Gesamtgerüst von BEVHeight++ enthält drei Teilnetzwerke, nämlich den tiefenbasierten Zweig (Cyan), den höhenbasierten Zweig (grün) und den Feature-Fusion-Prozess (grau). Die tiefenbasierte Pipeline wandelt Bildansichtsmerkmale unter Verwendung der geschätzten Tiefe pro Pixel in tiefenbasierte BEV-Merkmale (D-basiertes BEV) um. Die höhenbasierte Pipeline generiert höhenbasierte BEV-Merkmale (H-basiertes BEV) mithilfe von Bodenhöhenvorhersagen von Hebemerkmalen in Bildansichten. Die Feature-Fusion umfasst die Bildfusion und die Fusion aus der Vogelperspektive. Durch die Bild-Ansicht-Fusion werden Fusionsmerkmale durch kaskadierende Höhenverteilung und Bildmerkmale erhalten, die für nachfolgende Aktualisierungsvorgänge verwendet werden. Die Fusion aus der Vogelperspektive erhält durch verformbare Queraufmerksamkeit fusionierte BEV-Merkmale aus höhenbasierten BEV-Merkmalen und tiefenbasierten BEV-Merkmalen und verwendet sie dann als Eingabe des Erkennungskopfes

Der Inhalt, der neu geschrieben werden muss, ist: Originallink: https://mp.weixin.qq.com/s/AdCXYzHIy2lTfAHk2AZ4_w

Das obige ist der detaillierte Inhalt vonWeit voraus! BEVHeight++: Eine neue Lösung für die visuelle 3D-Zielerkennung am Straßenrand!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Welches System ist Honor?

Welches System ist Honor?

So reparieren Sie LSP

So reparieren Sie LSP

Löschen Sie redundante Tabellen in der Tabelle

Löschen Sie redundante Tabellen in der Tabelle

Ist es schwierig, Java selbst zu lernen?

Ist es schwierig, Java selbst zu lernen?

Detaillierte Erklärung des Befehls imp in Oracle

Detaillierte Erklärung des Befehls imp in Oracle

Tabellendurchschnitt

Tabellendurchschnitt

Was soll ich tun, wenn das CAD-Bild nicht verschoben werden kann?

Was soll ich tun, wenn das CAD-Bild nicht verschoben werden kann?

So öffnen Sie die Hosts-Datei

So öffnen Sie die Hosts-Datei