Videokonferenzsysteme wurden erstmals vor mehr als 50 Jahren kommerzialisiert und ermöglichten es Menschen, audiovisuell mit Kollegen, Freunden oder Familienmitgliedern zu kommunizieren, die Tausende Kilometer entfernt waren. Das ultimative Ziel von Videokonferenzen besteht darin, eine immersive Kommunikation zwischen Remote-Teilnehmern zu ermöglichen, als ob sie alle am selben Ort wären

Bestehende 3D-Videokonferenzsysteme zeigen zwar Potenzial für die Erfassung von Augenkontakt und anderen nonverbalen Hinweisen, erfordern jedoch teure 3D-Erfassungsgeräte

In einem Projekt namens „AI-Mediated 3D Video Conferencing“ haben Teams von NVIDIA, der University of California, San Diego und der University of North Carolina at Chapel Hill erfolgreich ein hochauflösendes, kostengünstiges 3D-Videokonferenzsystem entwickelt KI-Technologie der künstlichen Intelligenz. Telepräsenz-Methode und bietet neue Funktionen, die auf Basis von 3D-Scanning nicht erreicht werden können

Darüber hinaus ist die Lösung des Teams mit einer Vielzahl vorhandener 3D-Displays kompatibel, darunter stereoskopische Displays und Lichtfelddisplays

Erweiterte Lektüre: Mithilfe von KI zur Reduzierung der Größe demonstriert Google eine neue Iteration des Lichtfeld-Aufrufprojekts Project Starline

Es ist erwähnenswert, dass Google künstliche Intelligenz verwendet, um sein Lichtfeldanrufprojekt Project Starline zu verbessern. Einfach ausgedrückt ist Project Starline ein 3D-Video-Chatroom, der mithilfe der Lichtfeldtechnologie das Gefühl erzeugt, als ob die andere Partei Ihnen tatsächlich gegenübersitzt. Dieses innovative Remote-Kommunikationstool kombiniert die Hardware- und Software-Fortschritte von Google, um Freunde, Familie und Kollegen bei der Remote-Kommunikation noch intensiver zu machen

Das NVIDIA-Team ist zurück bei seinem Projekt „AI-Mediated 3D Video Conferencing“, hat den Aufbau bei SIGGRAPH demonstriert und darüber geschrieben

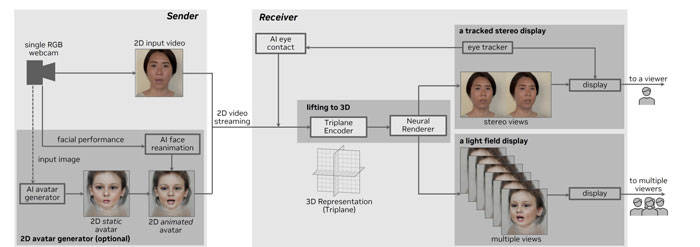

Das dargestellte System umfasst einen Sender zum Aufzeichnen und Übertragen von 2D-Videos von einer einzelnen RGB-Webcam und einen Empfänger zum Empfangen und Konvertieren von 2D-Videos in 3D und zur Darstellung einer neuartigen 3D-Ansicht

Durch die Verwendung eines One-Shot-Ansatzes können Forscher in Echtzeit aus einem einzelnen ungestellten Bild eine realistische 3D-Darstellung ableiten und rendern und Lichtfeldbilder auf einem NVIDIA RTX A5000-Laptop erzeugen. Dank der sofortigen KI-Superauflösungstechnologie können die Teilnehmer sofort ihr 3D-Selbstbild sehen. In Echtzeit können die Teilnehmer zusehen, wie das 2D-Webcam-Bild mit Headtracking in eine stereoskopische 3D-Ansicht umgewandelt wird

Benutzer haben die Möglichkeit, zusätzlich zur Verwendung von Webcam-Bildern das 2D-Avatar-Generator-Modul zu verwenden, um benutzergesteuerte 2D-Avatare zu generieren und anzupassen.

Forscher haben wichtige Fortschritte beim 3D-Lifting erzielt, indem sie einen neuen Encoder auf Basis von Vision Transformer zur Umwandlung von 2D-Eingaben in effiziente dreiplanare implizite 3D-Darstellungen vorgeschlagen haben. Ausgehend von einem einzelnen RGB-Bild eines Benutzers ist diese Methode in der Lage, automatisch eine frontale 3D-Darstellung des Benutzers zu erstellen und diese durch volumetrisches 3D-Rendering effizient aus einem neuen Blickwinkel zu rendern

Eine Neuformulierung dieses Satzes lautet wie folgt: Der Triplanar-Encoder verlässt sich beim Training vollständig auf synthetische Daten, die von vorab trainiertem EG3D generiert werden, während das 3D-Lifting-Modul die generierten Priors verwendet, um sicherzustellen, dass die generierten Ansichten mehrere Ansichten konsistent und fotorealistisch sind und kann auf einmal bei jedem angewendet werden, ohne dass eine persönliche Schulung erforderlich ist

Das Team verwendete modernste neuronale Methoden, um Augenkontakt herzustellen, indem es den umgeleiteten Blick eines bestimmten Benutzerbildes synthetisierte und das 2D-Bild durch Blickkorrektur in ein 3D-Bild aufwertete, wie in der Abbildung dargestellt

Das System unterstützt eine Vielzahl von handelsüblichen 3D-Displays, darunter stereoskopische Einzelpersonen-Displays und Lichtfeld-Displays für mehrere Personen

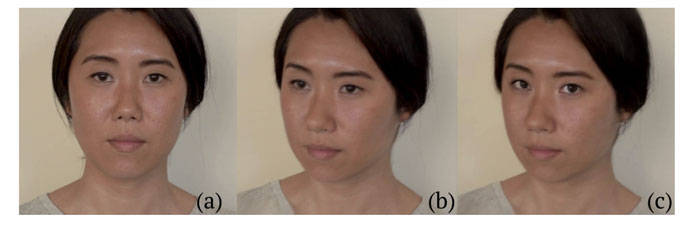

Dieses Bild zeigt die Verwendung eines 32-Zoll-3D-Stereomonitors von Dimenco. Es nutzt Eye-Tracking und Linsentechnologie, um stereoskopische Bilder zu erzeugen, die die Position der Augen des Benutzers genau wiedergeben. A gibt einen Überblick, während B und C die Fähigkeit des Systems demonstrieren, stereoskopische Bilder von Teilnehmern aus der richtigen Perspektive aufzunehmen. Unterdessen veranschaulichen d und e, dass diese Methode bei einem einzelnen RGB-Bild realistische Telepräsenzeffekte erzeugen kann

Zusätzlich verwendeten die Forscher einen 32-Zoll-Looking-Glass-Monitor, um das KI-System zu bewerten. Auf dem Display kann gleichzeitig ein lebensgroßer sprechender Kopf angezeigt werden, sodass mehrere Personen ihn deutlich sehen können. Dieses Lichtfelddisplay bietet eine anschauliche Demonstration der Technologie sowohl für das allgemeine Publikum als auch für diejenigen, die auf Demos warten

Als nächstes können die Schlangestehenden die dreidimensionalen Displays an verschiedenen Ständen ausprobieren und mehrkanalige, durch künstliche Intelligenz gesteuerte 3D-Videokonferenzgespräche erleben

Erweiterte Lektüre: KI-vermittelte 3D-Videokonferenzen

Erweiterte Lektüre: Live-3D-Porträt: Echtzeit-Strahlungsfelder für die Synthese von Einzelbild-Porträtansichten

Bemerkenswert ist, dass das Team den Encoder mithilfe von NVIDIA TensorRT optimiert hat, um Echtzeitinferenz auf NVIDIA A6000 GPUs der Ada-Generation zu ermöglichen. Das gesamte System läuft in weniger als 100 Millisekunden, inklusive Aufnahme, Streaming und Rendering

Das obige ist der detaillierte Inhalt vonNVIDIA entwickelt KI-3D-Video-Chat-Lösung für Remote-Konferenzgespräche. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Das Telefon kann keine Verbindung zum Bluetooth-Headset herstellen

Das Telefon kann keine Verbindung zum Bluetooth-Headset herstellen

Was tun, wenn der Bluescreen-Code 0x0000007e auftritt?

Was tun, wenn der Bluescreen-Code 0x0000007e auftritt?

Was bedeutet Ping?

Was bedeutet Ping?

Welche Währung ist USDT?

Welche Währung ist USDT?

stackoverflowatline1

stackoverflowatline1

Der Unterschied zwischen null und NULL in der C-Sprache

Der Unterschied zwischen null und NULL in der C-Sprache

Cloud-Computing-Technologie

Cloud-Computing-Technologie

Verwendung zum Löschen der Datenbank

Verwendung zum Löschen der Datenbank