IT Home berichtete am 11. Juli, dass Baichuan Intelligence, eine Tochtergesellschaft von Wang Xiaochuan, heute das große Modell Baichuan-13B veröffentlicht hat, das angeblich „13 Milliarden Parameter Open Source und im Handel erhältlich“ ist.

▲ Bildquelle Baichuang-13B GitHub-Seite

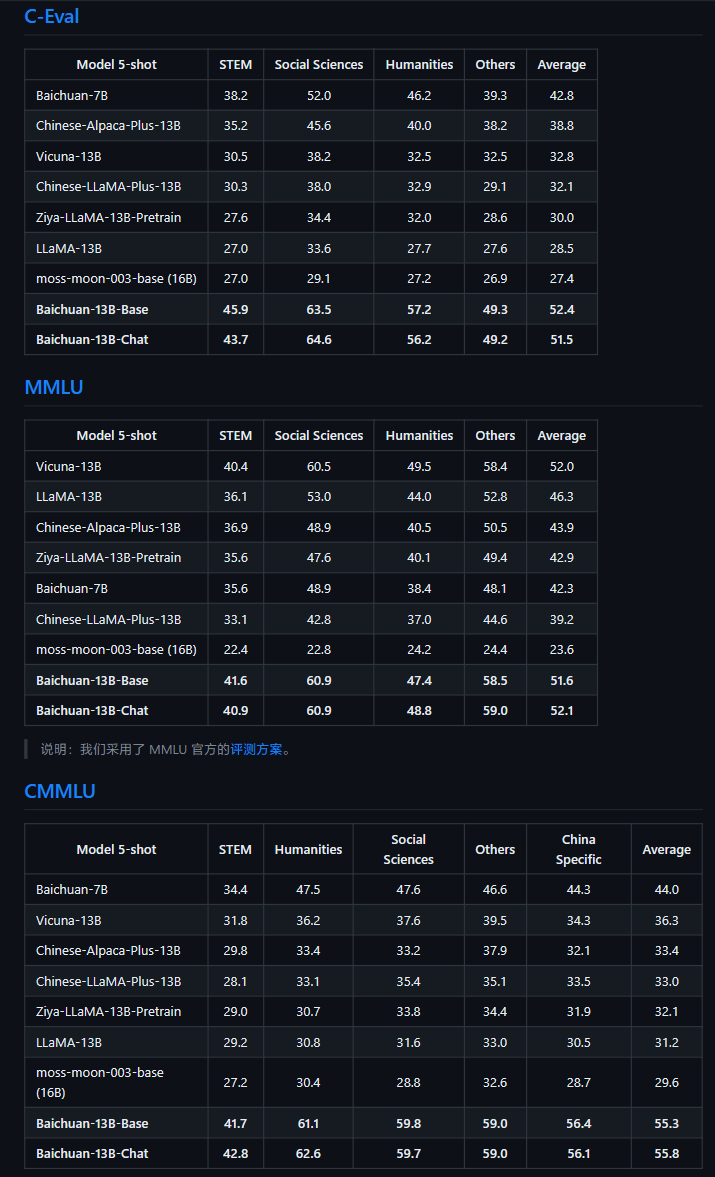

Laut der offiziellen Einführung ist Baichuan-13B ein kommerziell verfügbares Open-Source-Sprachmodell mit 13 Milliarden Parametern, das von Baichuan Intelligence nach Baichuan-7B entwickelt wurde. Es hat die besten Ergebnisse unter Modellen gleicher Größe sowohl auf Chinesisch als auch auf Chinesisch erzielt Englische Benchmarks. Diese Version enthält zwei Versionen: Vortraining (Baichuan-13B-Base) und Ausrichtung (Baichuan-13B-Chat).

▲ Bildquelle Baichuang-13B GitHub-Seite

Offiziell wurde behauptet, dass Baichuan-13B die folgenden Eigenschaften aufweist:

- Größere Größe, mehr Daten: Baichuan-13B hat die Anzahl der Parameter basierend auf Baichuan-7B weiter erweitert und 1,4 Billionen Token auf einem hochwertigen Korpus trainiert, was LLaMA-13B um 40 % übertrifft. Es ist die aktuelle Open Source Das Modell mit der größten Menge an Trainingsdaten bei einer Größe von 13B. Unterstützt zweisprachig Chinesisch und Englisch, verwendet die ALiBi-Positionskodierung und die Länge des Kontextfensters beträgt 4096.

- Open-Source-Pre-Training- und Alignment-Modelle gleichzeitig: Das Pre-Training-Modell ist eine „Basis“ für Entwickler, während die Mehrheit der normalen Benutzer einen stärkeren Bedarf an Alignment-Modellen mit Dialogfunktionen hat. Daher verfügt das Projekt auch über ein Ausrichtungsmodell (Baichuan-13B-Chat), das über starke Konversationsfunktionen verfügt. Es kann sofort verwendet werden und kann mit wenigen Codezeilen problemlos bereitgestellt werden.

- Effizientere Argumentation: Um die Nutzung eines breiteren Benutzerkreises zu unterstützen, hat das Projekt auch die quantisierten Versionen von int8 und int4 als Open-Source-Version bereitgestellt, wodurch der Schwellenwert für die Maschinenressourcen für die Bereitstellung erheblich reduziert wird nahezu kein Effektverlust und kann in Consumer-Grafikkarten wie NVIDIA RTX3090 eingesetzt werden.

- Open Source, kostenlos für die kommerzielle Nutzung: Baichuan-13B steht nicht nur der akademischen Forschung vollständig offen, sondern Entwickler können es auch kostenlos nutzen, nachdem sie sich per E-Mail beworben und eine offizielle kommerzielle Lizenz erhalten haben.

Derzeit ist das Modell auf HuggingFace, GitHub und Model Scope veröffentlicht. Interessierte IT-Home-Freunde können mehr erfahren.

Das obige ist der detaillierte Inhalt vonBaichuan Intelligent veröffentlichte das KI-Modell Baichuan-13B und behauptete, dass „13 Milliarden Parameter Open Source sind und kommerziell genutzt werden können'.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was ist ein MySQL-Index?

Was ist ein MySQL-Index?

Was wird in jquery hervorgehoben?

Was wird in jquery hervorgehoben?

Blockchain-Abfrage des Ethereum-Browsers

Blockchain-Abfrage des Ethereum-Browsers

Wie kann man Douyin-Flammen wiederherstellen, nachdem sie verschwunden sind?

Wie kann man Douyin-Flammen wiederherstellen, nachdem sie verschwunden sind?

So lösen Sie das Problem von 400 fehlerhaften Anfragen, wenn die Webseite angezeigt wird

So lösen Sie das Problem von 400 fehlerhaften Anfragen, wenn die Webseite angezeigt wird

Häufig verwendete Suchwerkzeuge

Häufig verwendete Suchwerkzeuge

Kostenlose Software zum Erstellen von Websites

Kostenlose Software zum Erstellen von Websites

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?