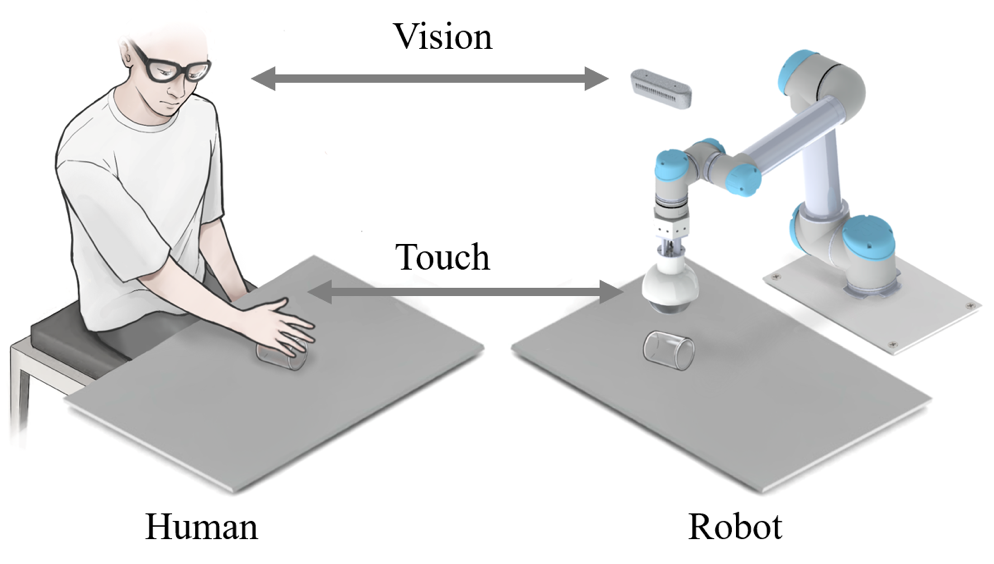

Wahrnehmung und Erfassung transparenter Objekte in komplexen Umgebungen sind anerkannte Probleme im Bereich Robotik und Computer Vision. Kürzlich schlugen ein Team und Mitarbeiter der Shenzhen International Graduate School der Tsinghua-Universität ein transparentes Rahmenwerk zum Greifen von Objekten mit visueller und taktiler Fusion vor, das auf einer RGB-Kamera und einer mechanischen Klaue TaTa mit taktilen Sensorfunktionen basiert und sim2real verwendet, um die Erkennung der Greifposition zu realisieren von transparenten Objekten. Dieses Framework kann nicht nur das Problem des Erfassens unregelmäßiger transparenter Objekte wie Glassplitter lösen, sondern auch das Problem des Ergreifens überlappender, gestapelter, unebener Sandhaufen und sogar hochdynamischer transparenter Unterwasserobjekte.

Bilder

Bilder

Transparente Objekte werden aufgrund ihrer Schönheit, Einfachheit und anderer Eigenschaften häufig im Leben verwendet. Man findet sie beispielsweise in Küchen, Geschäften und Fabriken. Obwohl transparente Objekte weit verbreitet sind, ist das Ergreifen transparenter Objekte für Roboter ein sehr schwieriges Problem. Dafür gibt es drei Hauptgründe:

Bilder

Bilder

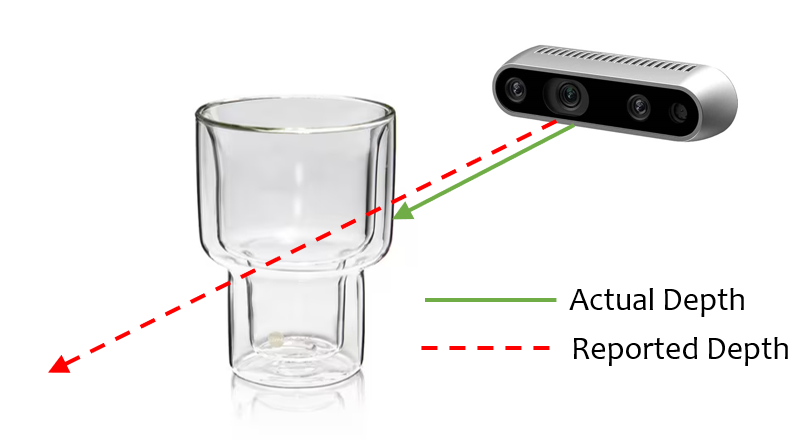

1 Es hat keine eigenen Texturattribute. Die Informationen auf der Oberfläche transparenter Objekte ändern sich mit der Änderung der Umgebung, und die erzeugte Textur wird hauptsächlich durch Lichtbrechung und -reflexion verursacht, was die Erkennung transparenter Objekte stark erschwert.

2. Die Annotation transparenter Datensätze ist schwieriger als die Annotation gewöhnlicher Objekte. In tatsächlichen Szenen ist es für Menschen manchmal schwierig, transparente Objekte wie Glas zu unterscheiden, geschweige denn Bilder von transparenten Objekten zu beschriften.

3. Die Oberfläche transparenter Objekte ist glatt. Schon eine kleine Abweichung in der Greifposition kann zum Scheitern der Greifaufgabe führen.

Daher ist die Lösung des Problems, transparente Objekte in verschiedenen komplexen Szenen mit möglichst geringen Kosten zu erfassen, zu einem sehr wichtigen Thema im Bereich der transparenten Objektforschung geworden. Kürzlich hat das Intelligent Perception and Robotics Team der Tsinghua University Shenzhen International Graduate School ein transparentes Objekterfassungs-Framework vorgeschlagen, das auf visueller und taktiler Fusion basiert, um die Erkennung und Erfassung transparenter Objekte zu realisieren. Diese Methode weist nicht nur eine sehr hohe Erfolgsquote beim Greifen auf, sondern kann auch zum Greifen transparenter Objekte in verschiedenen komplexen Szenen angepasst werden.

Bilder

Bilder

Bitte überprüfen Sie den folgenden Papierlink: https://ieeexplore.ieee.org/document/10175024

Assoziierter Professor Ding Wenbo von der Shenzhen International Graduate School der Tsinghua-Universität, korrespondierender Autor In dem Papier heißt es: „Roboter haben im Bereich der häuslichen Dienstleistungen einen großen Anwendungswert gezeigt, aber die meisten aktuellen Roboter konzentrieren sich auf einen einzigen Bereich. Der Vorschlag eines universellen Roboter-Greifmodells wird eine enorme Förderung für die Förderung mit sich bringen.“ und Anwendung der Robotertechnologie. Obwohl wir transparente Objekte als Forschungsobjekt verwenden, kann dieser Rahmen leicht auf das Erfassen von Aufgaben alltäglicher Objekte im Leben ausgeweitet werden und der Tsinghua University Shenzhen International Graduate School, sagten: „In Familienszenen. Die unstrukturierte Umgebung bringt große Herausforderungen für die praktische Anwendung von Robotern mit sich. Wir integrieren Vision und Tastwahrnehmung, um den Wahrnehmungsprozess weiter zu simulieren, wenn Menschen mit der Außenwelt interagieren, und bieten so mehr.“ Stabilität für Roboteranwendungen in komplexen Szenarien. Das von uns vorgeschlagene Framework kann auch auf weitere Modalitäten wie das Hören ausgeweitet werden Für diese Aufgabe sollten neben der Erfassung der Position des Objekts während des Greifvorgangs auch die Greifposition und der Greifwinkel berücksichtigt werden. Gegenwärtig werden die meisten Arbeiten zum Erfassen transparenter Objekte auf einer Ebene mit einem einfachen Hintergrund ausgeführt, aber im wirklichen Leben werden die meisten Szenen nicht so ideal sein wie unsere experimentelle Umgebung. Einige spezielle Szenen wie Glassplitter, Pfähle, Überlappungen, Wellen, Sand und Unterwasserszenen sind anspruchsvoller.

Grasping Framework

Grasping Framework

Ähnlich wie beim menschlichen Verhalten beim Greifen können wir, wenn das Sehen direkt die genaue Position eines Objekts ermitteln kann, die Hand steuern, um das Objekt direkt zu erreichen und den Griff abzuschließen, wie in der Abbildung unten (A) gezeigt. Wenn das Sehen die Positionsinformationen eines Objekts nicht genau ermitteln kann, verwenden wir nach dem Abschätzen der Position des Objekts mithilfe des Sehvermögens die taktile Erfassungsfunktion der Hand, um die Greifposition langsam anzupassen, bis das Objekt berührt wird und die geeignete Greifposition erreicht ist erreicht, wie unten (B) dargestellt. Beim Greifen von Objekten unter eingeschränkten Sehbedingungen, wie in der Abbildung unten (C) gezeigt, verwenden wir die reichen Tastnerven der Hand, um innerhalb der möglichen Reichweite des Ziels zu suchen, obwohl dies sehr ineffizient ist , Aber es ist eine effektive Methode, um das Objekt-Grabbing in diesen speziellen Szenarien zu lösen.

Ähnlich wie beim menschlichen Verhalten beim Greifen können wir, wenn das Sehen direkt die genaue Position eines Objekts ermitteln kann, die Hand steuern, um das Objekt direkt zu erreichen und den Griff abzuschließen, wie in der Abbildung unten (A) gezeigt. Wenn das Sehen die Positionsinformationen eines Objekts nicht genau ermitteln kann, verwenden wir nach dem Abschätzen der Position des Objekts mithilfe des Sehvermögens die taktile Erfassungsfunktion der Hand, um die Greifposition langsam anzupassen, bis das Objekt berührt wird und die geeignete Greifposition erreicht ist erreicht, wie unten (B) dargestellt. Beim Greifen von Objekten unter eingeschränkten Sehbedingungen, wie in der Abbildung unten (C) gezeigt, verwenden wir die reichen Tastnerven der Hand, um innerhalb der möglichen Reichweite des Ziels zu suchen, obwohl dies sehr ineffizient ist , Aber es ist eine effektive Methode, um das Objekt-Grabbing in diesen speziellen Szenarien zu lösen.

Bilder

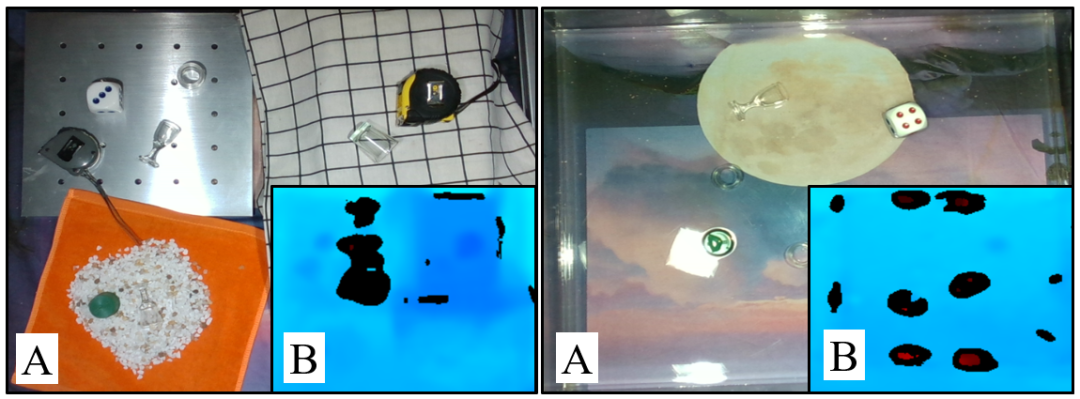

Inspiriert von menschlichen Greifstrategien unterteilen wir die Greifaufgaben transparenter Objekte in drei Typen: Ebenen mit komplexem Hintergrund, unregelmäßige Szenen und Szenen, die visuell nicht erkannt werden können, wie unten gezeigt. Beim ersten Typ spielt das Sehen eine Schlüsselrolle, und wir definieren die Erfassungsmethode in diesem Szenario als eine Erfassungsmethode, bei der das Sehen zuerst im Vordergrund steht. Beim zweiten Typ können Sehen und Fühlen zusammenarbeiten, und wir definieren die Greifmethode in diesem Szenario als visuell-taktiles Greifen. Beim letzten Typ kann das Sehen versagen und die Berührung wird in der Aufgabe dominant. Wir definieren die Greifmethode in diesem Szenario als eine Greifmethode, bei der die Berührung zuerst erfolgt.

Bilder

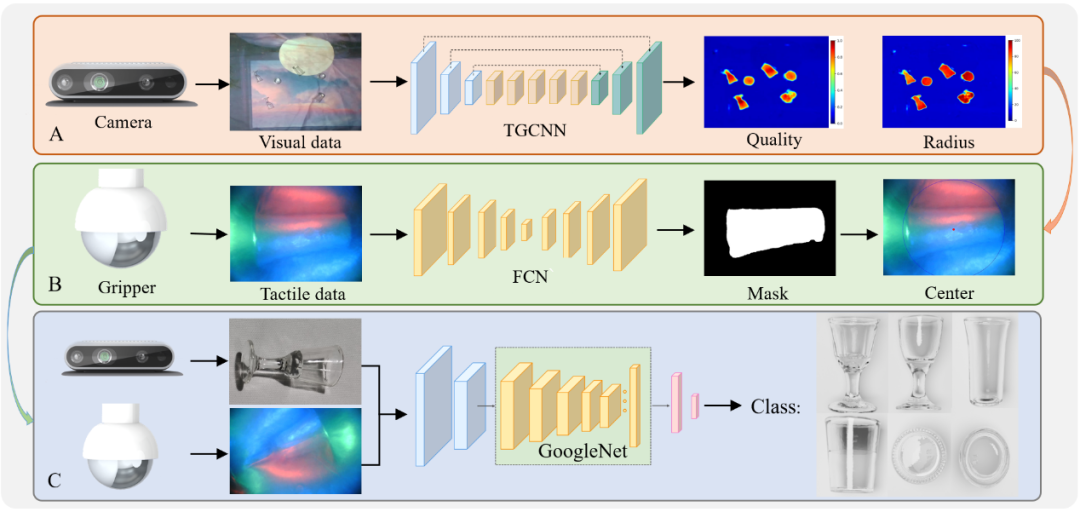

Der Prozess der Vision-First-Greifmethode ist in der folgenden Abbildung dargestellt. Zuerst wird TGCNN verwendet, um die Greifposition und -höhe zu ermitteln, und dann werden die taktilen Informationen verwendet, um die Greifposition zu kalibrieren und schließlich wird der visuell-taktile Fusionsalgorithmus zur Klassifizierung verwendet. Das visuell-taktile Erfassen basiert auf dem vorherigen und fügt das THS-Modul hinzu, das den Tastsinn nutzen kann, um die Höhe des Objekts zu ermitteln. Der haptisch-erste Greifansatz wurde durch ein TPE-Modul ergänzt, das den Tastsinn nutzt, um die Position transparenter Objekte zu ermitteln.

Um die Wirksamkeit unseres vorgeschlagenen Frameworks und Algorithmus zu überprüfen, haben wir eine große Anzahl von Verifizierungsexperimenten durchgeführt.

Um die Wirksamkeit unseres vorgeschlagenen transparenten Objektdatensatzes, der Annotationsmethode und des Erfassungsnetzwerks zur Erfassung der Position zu testen, führten wir zunächst Experimente zur Erkennung synthetischer Daten und Experimente zur Erfassung der Position transparenter Objekte unter verschiedenen Hintergründen und Helligkeiten durch. Zweitens haben wir zur Überprüfung der Wirksamkeit des visuell-taktilen Fusions-Erfassungsrahmens ein transparentes Objektklassifizierungsexperiment und ein transparentes Fragment-Erfassungsexperiment entworfen. Drittens haben wir ein Experiment zum Erfassen transparenter Objekte in unregelmäßigen und visuell eingeschränkten Szenen entworfen, um die Wirksamkeit des Frameworks nach dem Hinzufügen des THS-Moduls und des TPE-Moduls zu testen.

Um das anspruchsvolle Problem der Erkennung, Erfassung und Klassifizierung transparenter Objekte zu lösen, schlägt diese Studie ein visuell-haptisches Fusionsrahmenwerk vor, das auf synthetischen Datensätzen basiert. Erstens wird die Blender-Simulations-Engine zum Rendern synthetischer Datensätze anstelle manuell kommentierter Datensätze verwendet.

Darüber hinaus wird die Gaußsche Maske anstelle der herkömmlichen binären Annotationsmethode verwendet, um die Generierung von Greifpositionen genauer zu machen. Um die Greifposition transparenter Objekte zu ermitteln, schlug der Autor einen Algorithmus namens TGCNN vor und führte mehrere Vergleichsexperimente durch. Die Ergebnisse zeigen, dass der Algorithmus auch bei unterschiedlichen Hintergründen und Lichtverhältnissen gute Ergebnisse erzielen kann Voraussetzungen für eine gute Erkennung.

Angesichts der Greifschwierigkeiten, die durch die Einschränkungen der visuellen Erkennung verursacht werden, schlägt diese Studie eine taktile Kalibrierungsmethode in Kombination mit dem weichen Greifer TaTa vor, um die Erfolgsquote beim Greifen zu verbessern, indem die Greifposition mit taktilen Informationen angepasst wird. Im Vergleich zum rein visuellen Greifen verbessert diese Methode die Greiferfolgsquote um 36,7 %.

Um das Problem der Klassifizierung transparenter Objekte in komplexen Szenen zu lösen, schlägt diese Studie eine Klassifizierungsmethode für transparente Objekte vor, die auf der Vision-Tast-Fusion basiert und die Genauigkeit im Vergleich zur Klassifizierung allein auf der Grundlage des Sehens um 39,1 % verbessert.

Um das Erfassen transparenter Objekte in unregelmäßigen und visuell nicht erkennbaren Szenen zu erreichen, schlägt diese Studie außerdem THS- und TPE-Module vor, die das Problem des Erfassens transparenter Objekte ohne visuelle Informationen kompensieren können. Die Forscher konzipierten systematisch eine große Anzahl von Experimenten, um die Wirksamkeit des vorgeschlagenen Rahmenwerks in komplexen Szenen wie verschiedenen Überlagerungen, Überlappungen, Wellen, Sandgebieten und Unterwasserszenen zu überprüfen. Die Studie geht davon aus, dass der vorgeschlagene Rahmen auch auf die Objekterkennung in Umgebungen mit schlechten Sichtverhältnissen wie Rauch und trübem Wasser angewendet werden kann, wo die taktile Wahrnehmung den Mangel an visueller Erkennung ausgleichen und die Klassifizierungsgenauigkeit durch visuell-taktile Fusion verbessern kann.

Der Dozent des Visual-Touch-Fusion-Projekts zum Erfassen transparenter Objekte ist Ding Wenbo. Derzeit ist er außerordentlicher Professor an der Shenzhen International Graduate School der Tsinghua-Universität und leitet die intelligente Wahrnehmung und Robotik-Forschungsgruppe. Seine Forschungsinteressen umfassen hauptsächlich Signalverarbeitung, maschinelles Lernen, tragbare Geräte, flexible Mensch-Computer-Interaktion und maschinelle Wahrnehmung. Zuvor schloss er sein Studium an der Fakultät für Elektrotechnik der Tsinghua-Universität mit einem Bachelor-Abschluss und einem Doktortitel ab und arbeitete als Postdoktorand am Georgia Institute of Technology, wo er bei Akademiker Wang Zhonglin studierte. Er hat zahlreiche Auszeichnungen gewonnen, darunter den Sonderpreis der Tsinghua-Universität, die Goldmedaille der 47. Internationalen Erfindungsausstellung in Genf, den IEEE Scott Helt Memorial Award, den zweiten Preis des Natural Science Award der China Electronics Society usw. und hat in den Bereichen Naturkommunikation, wissenschaftliche Fortschritte, Energie- und Umweltwissenschaften sowie fortgeschrittene Energie gearbeitet. Er hat mehr als 70 Artikel in maßgeblichen Fachzeitschriften in den Bereichen Materialien, IEEE TRO/RAL und anderen Bereichen veröffentlicht und wurde mehr als 6.000 Mal von Google zitiert Wissenschaftler und Autor von mehr als 10 Patenten in China und den Vereinigten Staaten. Er ist Mitherausgeber der renommierten internationalen Signalverarbeitungszeitschrift Digital Signal Processing, Chefgastredakteur der IEEE JSTSP Special Issue on Robot Perception und Mitglied des Applied Signal Processing Systems Technical Committee der IEEE Signal Processing Society.

Homepage der Forschungsgruppe: http://ssr-group.net/.

Von links nach rechts: Shoujie Li, Haixin Yu, Houde Liu

Die Co-Autoren des Artikels sind Shoujie Li (Doktorand an der Tsinghua-Universität) und Haixin Yu (Masterstudent an der Tsinghua-Universität). Zu den weiteren Autoren gehören Linqi Ye (Shanghai-Universität). Chongkun Xia (Tsinghua-Universität), Xueqian Wang (Tsinghua-Universität), Xiao-Ping Zhang (Tsinghua-Universität). Zu den Hauptforschungsrichtungen von Shoujie Li gehören das Greifen von Robotern, die taktile Wahrnehmung und das tiefe Lernen. Als Erstautor hat er zahlreiche Artikel in renommierten Fachzeitschriften und Konferenzen für Robotik und Steuerung wie Soft Robotics, TRO, RAL, ICRA, IROS usw. veröffentlicht ., und hat 10 Erfindungspatente genehmigt. Die relevanten Forschungsergebnisse wurden als erster Autor in den „ICRA 2022 Outstanding Mechanisms and Design Paper Finalists“ ausgewählt Zukunftsstipendium der Tsinghua-Universität und nationales Stipendium.

Das obige ist der detaillierte Inhalt vonEs kann Glasfragmente und transparente Unterwasserobjekte greifen. Tsinghua hat ein universelles Rahmenwerk zum Greifen transparenter Objekte mit einer sehr hohen Erfolgsquote vorgeschlagen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So legen Sie die Schriftfarbe in HTML fest

So legen Sie die Schriftfarbe in HTML fest

Welche Auflösung ist 1080p?

Welche Auflösung ist 1080p?

So überprüfen Sie tote Links auf Websites

So überprüfen Sie tote Links auf Websites

Die Rolle der PHP-Sonde

Die Rolle der PHP-Sonde

Funktion des Windows-Treiberassistenten

Funktion des Windows-Treiberassistenten

Detaillierte Erläuterung der Nginx-Konfiguration

Detaillierte Erläuterung der Nginx-Konfiguration

Liste der Mac-Tastenkombinationen

Liste der Mac-Tastenkombinationen

Welche Software zum Online-Testen der Computerleistung gibt es?

Welche Software zum Online-Testen der Computerleistung gibt es?