Die Wirkung einer Vorschulung ist direkt und die erforderlichen Ressourcen sind oft unerschwinglich. Wenn diese Vorschulungsmethode existiert, erfordert ihr Start sehr wenig Rechenleistung, Daten und Personalressourcen oder sogar nur den ursprünglichen Korpus einer einzelnen Person und einer einzelnen Karte. Nach einer unbeaufsichtigten Datenverarbeitung und einer Übertragung vor dem Training in Ihre eigene Domäne können Sie Null-Stichproben-NLG-, NLG- und Vektordarstellungs-Fähigkeiten erhalten. Die Rückruffähigkeiten anderer Vektordarstellungen übersteigen BM25. Sind Sie daran interessiert, es auszuprobieren?

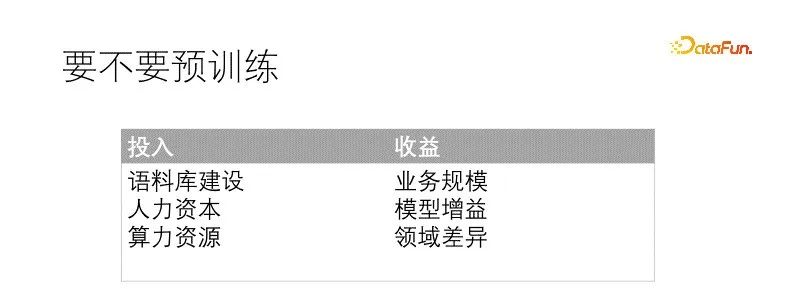

Ob man etwas tun möchte, muss durch die Messung des Inputs und Outputs entschieden werden. Vorschulung ist eine große Sache und erfordert einige Voraussetzungen und Ressourcen sowie ausreichend erwartete Vorteile, bevor sie umgesetzt werden kann. Die in der Regel erforderlichen Bedingungen sind: Qualität ist seltener als Quantität, daher muss die Qualität des Korpus ausreichend sein Im Vergleich dazu sind kleine Modelle einfacher zu trainieren und haben weniger Hindernisse, während große Modelle auf mehr Probleme stoßen. Je nach Szenario und Talentanpassung ist es am besten, eine zu haben große Speichergrafikkarte. Die Vorteile, die das Vortraining mit sich bringt, sind auch sehr intuitiv. Der Grad der Verbesserung steht in direktem Zusammenhang mit den Investitionen vor dem Training und den Domänenunterschieden .

In unserem Szenario unterscheidet sich das Datenfeld stark vom allgemeinen Feld, und selbst das Vokabular muss erheblich ersetzt werden, und der Geschäftsumfang ist ausreichend. Wenn das Modell nicht vorab trainiert ist, wird es auch speziell für jede nachgelagerte Aufgabe feinabgestimmt. Die erwarteten Vorteile einer Vorschulung sind sicher. Unser Korpus ist qualitativ schlecht, aber quantitativ ausreichend. Die Rechenleistungsressourcen sind sehr begrenzt und können durch entsprechende Talentreserven ausgeglichen werden. Zu diesem Zeitpunkt sind die Voraussetzungen für die Vorschulung bereits erfüllt.

Der Faktor, der direkt bestimmt, wie wir mit dem Vortraining beginnen, ist, dass zu viele nachgelagerte Modelle gewartet werden müssen, was insbesondere Maschinen- und Personalressourcen in Anspruch nimmt. Es müssen große Datenmengen vorbereitet werden Für jede Aufgabe muss ein dediziertes Modell trainiert werden. Die Komplexität der Governance hat dramatisch zugenommen. Deshalb untersuchen wir das Vortraining und hoffen, eine einheitliche Vortrainingsaufgabe zu erstellen, die allen nachgelagerten Modellen zugute kommt. Wenn wir dies tun, ist dies nicht über Nacht möglich. Je mehr Modelle gepflegt werden müssen, desto größer ist auch die Erfahrung aus mehreren früheren Projekten, einschließlich selbstüberwachtem Lernen, kontrastivem Lernen und mehr Modelle, nach wiederholten Experimenten und Iterationen entstand Fusion.

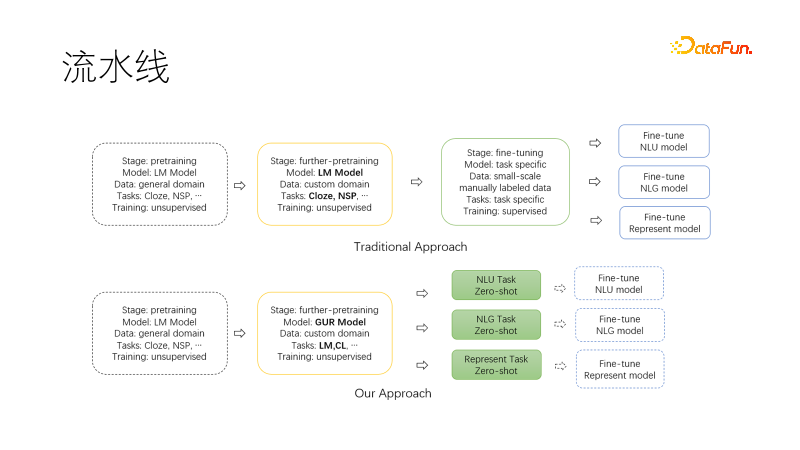

Das obige Bild ist das traditionelle NLP-Pipeline-Paradigma, das auf dem vorhandenen allgemeinen Vortrainingsmodell basiert. Nach Abschluss des optionalen Migrationsvortrainings werden Datensätze für jede nachgelagerte Aufgabe gesammelt. Das Optimieren des Trainings erfordert viel Arbeit und Grafikkarten, um mehrere nachgelagerte Modelle und Dienste aufrechtzuerhalten.

Das Bild unten ist das neue Paradigma, das wir vorgeschlagen haben. Bei der Migration in unser Fachgebiet verwenden wir gemeinsame Sprachmodellierungsaufgaben und vergleichende Lernaufgaben, um das Ausgabemodell über NLU, NLG und Nullstichproben zu verfügen. und Vektordarstellungsfähigkeiten, diese Fähigkeiten werden modelliert und können bei Bedarf abgerufen werden. Auf diese Weise müssen weniger Modelle gepflegt werden, insbesondere wenn das Projekt gestartet ist, können sie direkt für die Forschung verwendet werden. Wenn eine weitere Feinabstimmung erforderlich ist, wird auch die erforderliche Datenmenge erheblich reduziert.

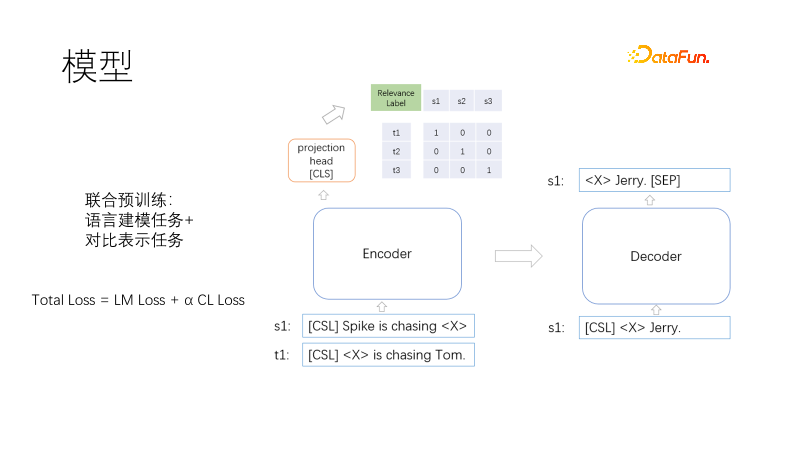

Dies ist unsere Modellarchitektur vor dem Training, einschließlich des Encoders, Decoders und Vektordarstellungskopfs des Transformers.

Zu den Zielen des Vortrainings gehören Sprachmodellierung und kontrastive Darstellung. Die Verlustfunktion ist Gesamtverlust = LM-Verlust + α CL-Verlust. Sie wird gemeinsam mit Sprachmodellierungsaufgaben und kontrastiven Darstellungsaufgaben trainiert, wobei α den Gewichtskoeffizienten darstellt. Die Sprachmodellierung verwendet ein Maskenmodell, ähnlich wie T5, das nur den Maskenteil dekodiert. Die kontrastive Darstellungsaufgabe ähnelt CLIP. Für jedes Probenpaar (i, I) gibt es ein positives Probenpaar und ein anderes Bei den Proben handelt es sich um negative Proben, bei denen ein symmetrischer Kreuzentropieverlust verwendet wird, um zu erzwingen, dass die Darstellung positiver Proben nahe beieinander liegt und die Darstellung negativer Proben weit auseinander liegt. Die Verwendung der T5-Dekodierung kann die Dekodierungslänge verkürzen. Über dem Head-Loading-Encoder wird eine nichtlineare Vektordarstellung platziert. Zum einen muss die Vektordarstellung im Szenario schneller sein, zum anderen wirken die beiden gezeigten Funktionen weit entfernt, um Trainingszielkonflikte zu vermeiden. Hier stellt sich also die Frage. Lückentexte sind sehr häufig und erfordern keine Stichproben. Wie entstehen also ähnliche Stichprobenpaare?

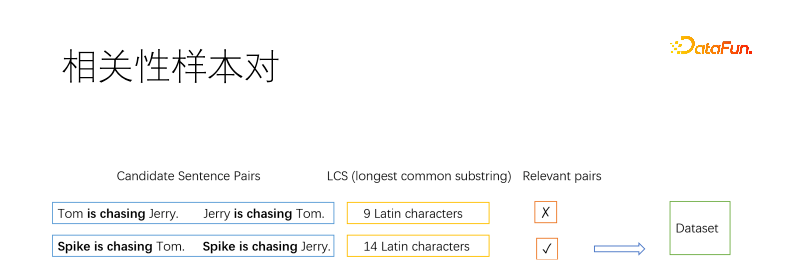

Natürlich müssen die Probenpaare als Vortrainingsmethode durch einen unbeaufsichtigten Algorithmus ermittelt werden. Im Allgemeinen wird im Bereich des Informationsabrufs zur Gewinnung positiver Proben die grundlegende Methode „Reverse Cloze“ verwendet, die mehrere Fragmente in einem Dokument durchsucht und davon ausgeht, dass sie miteinander in Zusammenhang stehen. Hier teilen wir das Dokument in Sätze auf und zählen dann die Satzpaare auf. Wir verwenden die längste gemeinsame Teilzeichenfolge, um zu bestimmen, ob zwei Sätze zusammenhängen. Wie in der Abbildung gezeigt, werden zwei positive und negative Satzpaare verwendet. Wenn die längste gemeinsame Teilzeichenfolge bis zu einem gewissen Grad lang genug ist, wird sie als ähnlich beurteilt, andernfalls ist sie nicht ähnlich. Der Schwellenwert wird von Ihnen selbst gewählt. Für einen langen Satz sind beispielsweise drei chinesische Schriftzeichen erforderlich. Ein kurzer Satz kann entspannter sein.

Wir verwenden Korrelation als Stichprobenpaar anstelle der semantischen Äquivalenz, da die beiden Ziele im Widerspruch stehen. Wie in der Abbildung oben gezeigt, sind die Bedeutungen von „Katze fängt Maus“ und „Maus fängt Katze“ gegensätzlich, aber verwandt. Unsere Szenariosuche konzentriert sich hauptsächlich auf die Relevanz. Darüber hinaus ist die Korrelation umfassender als die semantische Äquivalenz, und die semantische Äquivalenz eignet sich besser für eine kontinuierliche Feinabstimmung auf der Grundlage der Korrelation.

Einige Sätze werden mehrfach gefiltert, andere nicht. Wir begrenzen die Häufigkeit der Auswahl von Sätzen. Für die nicht erfolgreichen Sätze können diese als positive Proben kopiert, in die ausgewählten Sätze eingefügt oder umgekehrte Lückentexte als positive Proben verwendet werden.

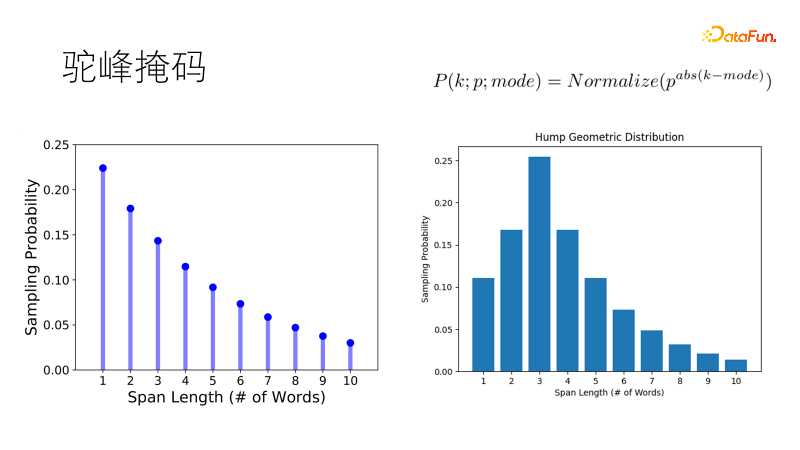

Traditionelle Maskierungsmethoden wie SpanBert verwenden eine geometrische Verteilung, um die Maskenlänge abzutasten. Kurze Masken haben eine hohe Wahrscheinlichkeit, lange Masken eine niedrige Wahrscheinlichkeit und eignen sich für lange Sätze. Aber unser Korpus ist fragmentiert, wenn es um kurze Sätze mit einem oder zwanzig Wörtern geht. Die traditionelle Tendenz besteht darin, zwei einzelne Wörter statt eines Doppelworts zu maskieren, was unseren Erwartungen nicht entspricht. Deshalb haben wir diese Verteilung so verbessert, dass sie die höchste Wahrscheinlichkeit aufweist, die optimale Länge abzutasten, und die Wahrscheinlichkeit anderer Längen allmählich abnimmt, genau wie bei einem Kamelhöcker, und zu einer geometrischen Kamelhöckerverteilung wird, die in unserem kurzen Satz robuster ist. reichhaltige Szenarien.

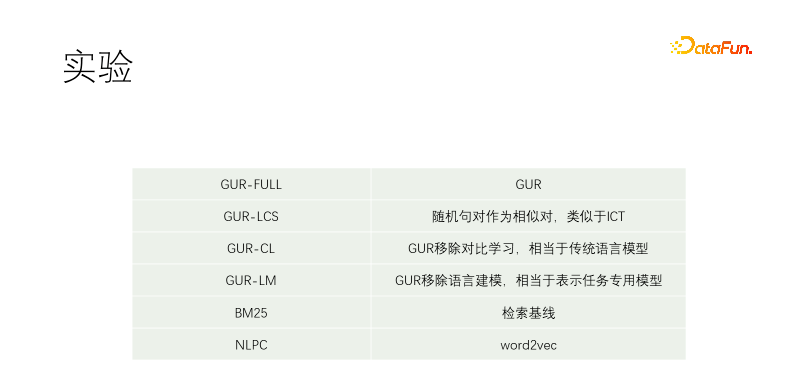

Wir haben ein kontrolliertes Experiment durchgeführt. Einschließlich GUR-FULL, das Sprachmodellierung und vektorielle Kontrastdarstellung verwendet; UR-CL verfügt nicht über kontrastives Darstellungslernen, was einem herkömmlichen Sprachmodell entspricht, das nur über Vektoren verfügt Kontrastives Repräsentationslernen ohne Sprachmodellierungslernen entspricht einer Feinabstimmung speziell für nachgelagerte Aufgaben. NLPC ist ein Word2VEC-Operator in Baidu.

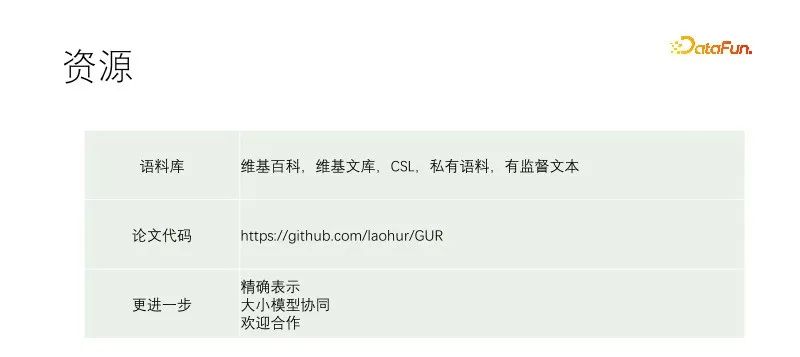

Das Experiment begann mit einem T5-Small und setzte das Vortraining fort. Zu den Schulungskorpora gehören Wikipedia, Wikisource, CSL und unsere eigenen Korpora. Unser eigener Korpus wird aus der Materialbibliothek erfasst und die Qualität ist sehr schlecht. Der qualitativ beste Teil ist der Titel der Materialbibliothek. Daher wird bei der Suche nach positiven Beispielen in anderen Dokumenten fast jedes Textpaar durchsucht, während in unserem Korpus der Titel verwendet wird, um jeden Satz des Textes abzugleichen. GUR-LCS wurde nicht von LCS ausgewählt. Wenn dies nicht der Fall ist, ist das Probenpaar zu schlecht. Wenn dies auf diese Weise erfolgt, ist der Unterschied zu GUR-FULL viel geringer.

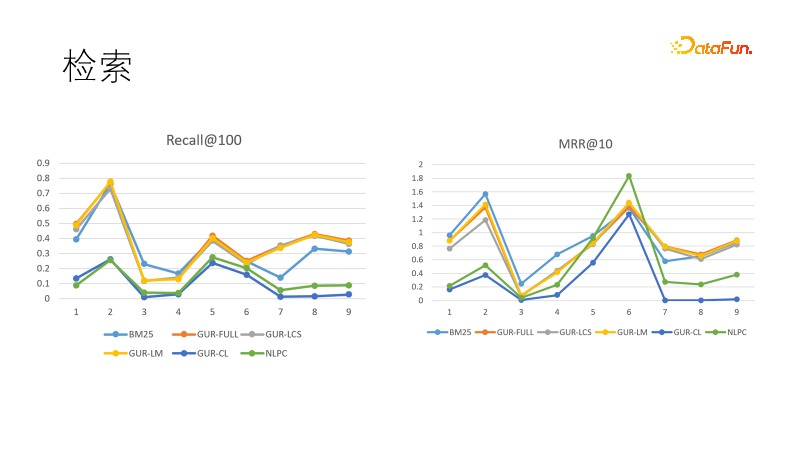

Wir bewerten den Vektordarstellungseffekt des Modells bei mehreren Abrufaufgaben. Das Bild links zeigt die Leistung mehrerer Modelle im Rückruf. Wir haben festgestellt, dass die durch Vektordarstellung erlernten Modelle die beste Leistung erbringen und BM25 übertreffen. Wir haben auch die Ranglistenziele verglichen, und dieses Mal kam BM25 zurück und gewann. Dies zeigt, dass das dichte Modell über eine starke Generalisierungsfähigkeit und das spärliche Modell über einen starken Determinismus verfügt und dass sich beide ergänzen können. Tatsächlich werden bei nachgelagerten Aufgaben im Bereich des Informationsabrufs häufig dichte Modelle und spärliche Modelle gemeinsam verwendet.

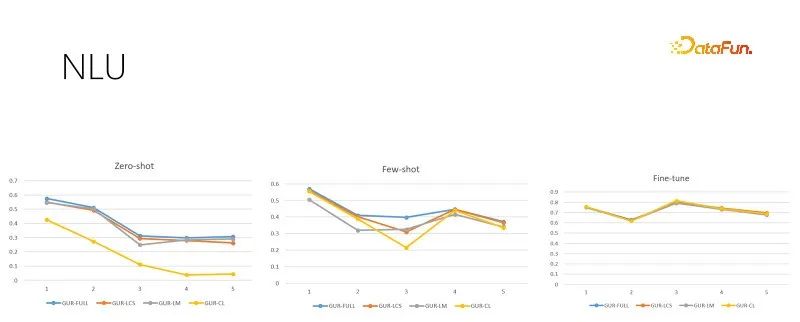

Das obige Bild ist eine NLU-Bewertungsaufgabe mit unterschiedlichen Trainingsstichprobengrößen. Jede Aufgabe hat Dutzende bis Hunderte von Kategorien, und der ACC-Score wird zur Bewertung des Effekts verwendet. Das GUR-Modell wandelt außerdem die Klassifizierungsbezeichnungen in Vektoren um, um für jeden Satz die nächstgelegene Bezeichnung zu finden. Die obige Abbildung zeigt von links nach rechts eine Nullstichprobe, eine kleine Stichprobe und eine ausreichende Feinabstimmungsauswertung entsprechend der zunehmenden Trainingsstichprobengröße. Das Bild rechts zeigt die Modellleistung nach ausreichender Feinabstimmung, die die Schwierigkeit jeder Unteraufgabe zeigt und auch die Obergrenze der Leistung bei Nullstichproben und kleinen Stichproben darstellt. Es ist ersichtlich, dass das GUR-Modell bei einigen Klassifizierungsaufgaben eine Argumentation ohne Stichprobe erreichen kann, indem es sich auf die Vektordarstellung verlässt. Und die Fähigkeit des GUR-Modells, kleine Proben aufzunehmen, ist das herausragendste.

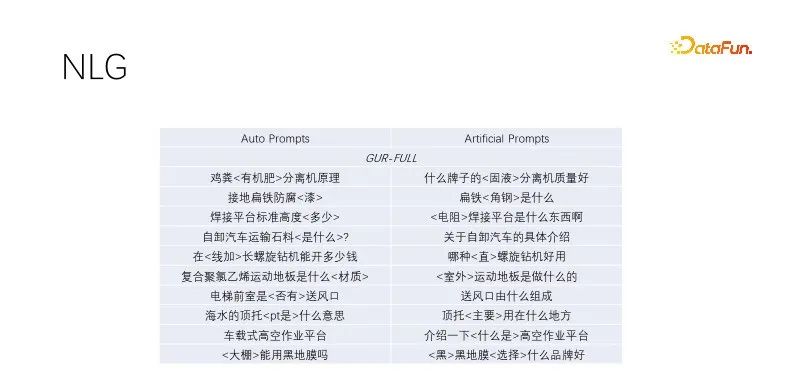

Dies ist eine Nullbeispielleistung in NLG. Bei der Titelgenerierung und Abfrageerweiterung ermitteln wir Titel mit qualitativ hochwertigem Traffic, behalten Schlüsselwörter bei und maskieren nach dem Zufallsprinzip Nicht-Schlüsselwörter. Die durch Sprachmodellierung trainierten Modelle funktionieren gut. Dieser automatische Prompt-Effekt ähnelt dem manuell erstellten Zieleffekt, weist jedoch eine größere Vielfalt auf und ist für die Massenproduktion geeignet. Mehrere Modelle, die die Sprachmodellierungsaufgabe bestanden haben, funktionieren ähnlich. Die obige Abbildung verwendet das GUR-Modellbeispiel.

Dieser Artikel schlägt ein neues Pre-Training-Paradigma vor. Die obigen Kontrollexperimente zeigen, dass gemeinsames Training keine Zielkonflikte verursacht. Wenn das GUR-Modell weiterhin vorab trainiert wird, kann es seine Vektordarstellungsfähigkeiten verbessern und gleichzeitig seine Sprachmodellierungsfähigkeiten beibehalten. Einmaliges Vortraining, Inferenz mit null Originalproben überall. Geeignet für kostengünstige Vorschulungen für Fachabteilungen.

Der obige Link enthält unsere Schulungsdetails. Weitere Informationen finden Sie im Papierzitat. Die Codeversion ist etwas neuer als das Papier. Ich hoffe, einen kleinen Beitrag zur Demokratisierung der KI zu leisten. Große und kleine Modelle haben ihre eigenen Anwendungsszenarien. Das GUR-Modell kann nicht nur direkt für nachgelagerte Aufgaben verwendet werden, sondern auch in Kombination mit großen Modellen. In der Pipeline verwenden wir zunächst das kleine Modell zur Erkennung und dann das große Modell zum Anweisen von Aufgaben. Das große Modell kann auch Stichproben für das kleine Modell erzeugen, und das kleine GUR-Modell kann den Vektorabruf für das große Modell bereitstellen.

Das Modell in der Arbeit ist ein kleines Modell, das zur Untersuchung mehrerer Experimente ausgewählt wurde. Wenn in der Praxis ein größeres Modell ausgewählt wird, ist der Gewinn offensichtlich. Unsere Erkundung reicht nicht aus und es sind weitere Arbeiten erforderlich. Wenn Sie dazu bereit sind, können Sie sich an laohur@gmail.com wenden und sich darauf freuen, gemeinsam mit allen Fortschritten zu machen.

Das obige ist der detaillierte Inhalt vonArmut bereitet mich vor. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Grundlegende Verwendung von FTP

Grundlegende Verwendung von FTP

Welche Mobiltelefone unterstützt Hongmeng OS?

Welche Mobiltelefone unterstützt Hongmeng OS?

So verwenden Sie den Fragezeichenausdruck in der C-Sprache

So verwenden Sie den Fragezeichenausdruck in der C-Sprache

Was ist eine relationale Datenbank?

Was ist eine relationale Datenbank?

Universeller PCI-Gerätetreiber

Universeller PCI-Gerätetreiber

Win7 meldet, dass auf Anwendungsdaten nicht zugegriffen werden kann

Win7 meldet, dass auf Anwendungsdaten nicht zugegriffen werden kann

NullpointerException-Ausnahme

NullpointerException-Ausnahme

So richten Sie die automatische Aktualisierung einer Webseite ein

So richten Sie die automatische Aktualisierung einer Webseite ein