Seit der Eröffnung der ChatGPT-API haben sich viele Studien dafür entschieden, die Ausgabe großer Basismodelle (LFM) wie ChatGPT und GPT-4 als Trainingsdaten zu verwenden und dann die Fähigkeiten kleiner Modelle durch Nachahmungslernen zu verbessern .

Aufgrund von Problemen wie oberflächlichen Nachahmungssignalen, unzureichenden Trainingsdaten und fehlenden strengen Bewertungsstandards wurde die tatsächliche Leistung kleiner Modelle jedoch überschätzt.

Aus Sicht der Wirkung neigt das kleine Modell eher dazu, den Ausgabestil von LFM als den Inferenzprozess zu imitieren.

Link zum Papier: https://arxiv.org/pdf/2306.02707.pdf

Um diese Herausforderungen anzugehen, hat Microsoft kürzlich ein 51-seitiges Papier veröffentlicht, in dem ein 130 The Orca-Modell mit Hunderten vorgeschlagen wird von Millionen von Parametern können lernen, den Argumentationsprozess von LFMs zu imitieren.

Forscher haben umfangreiche Trainingssignale für große Modelle entwickelt, damit Orca Interpretationsspuren, schrittweise Denkprozesse, komplexe Anweisungen usw. von GPT-4 lernen kann und von ChatGPT-Lehrern und durch Stichproben unterstützt und angeleitet wird und Auswahl, um umfangreiche und vielfältige Nachahmungsdaten zu extrahieren, was den inkrementellen Lerneffekt weiter verbessern kann.

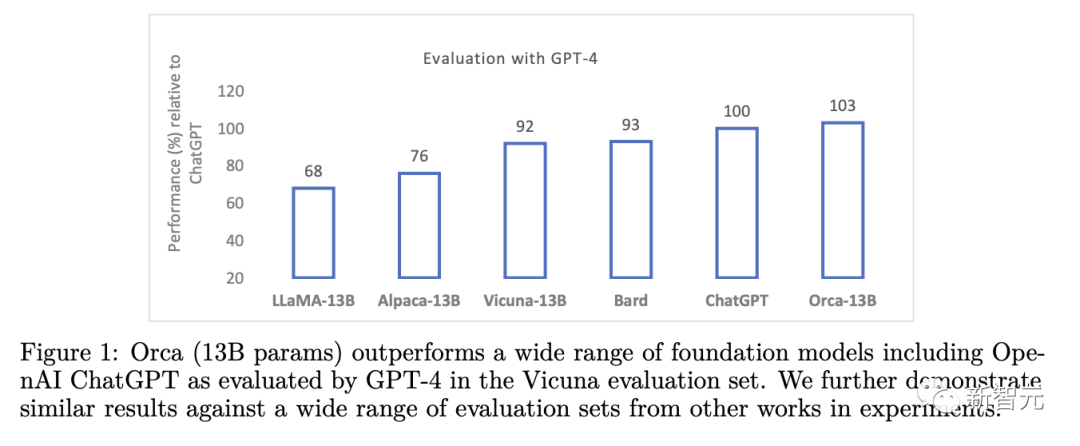

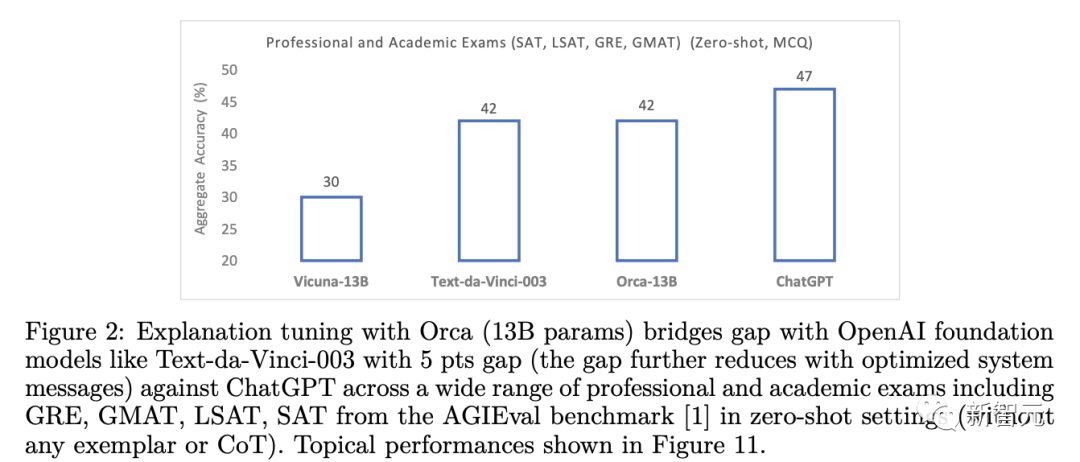

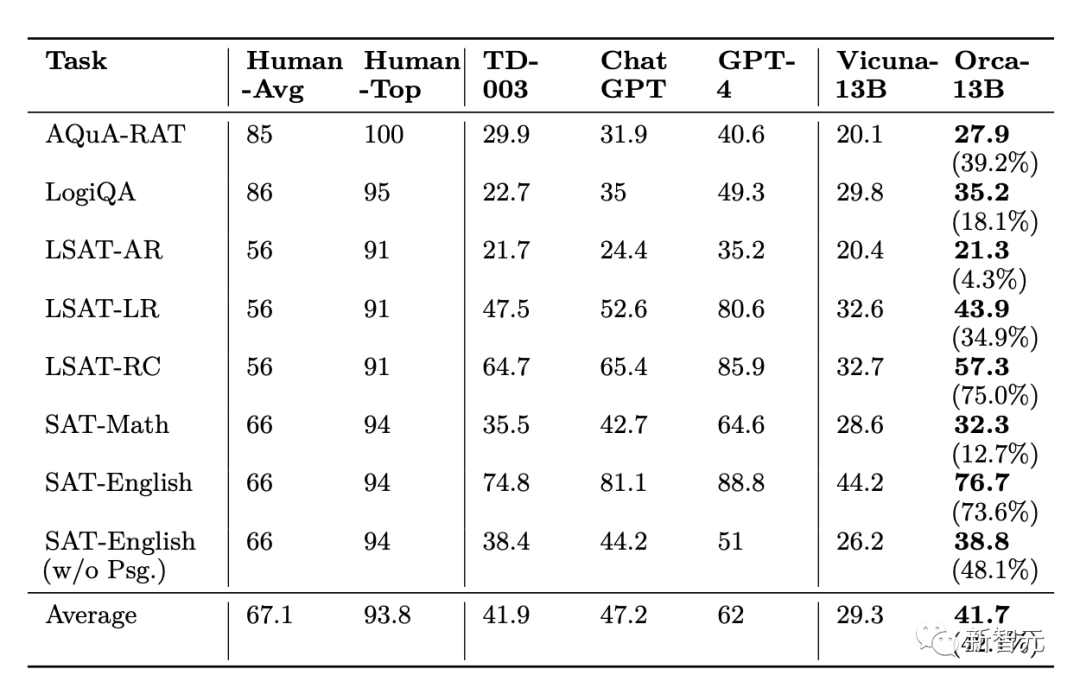

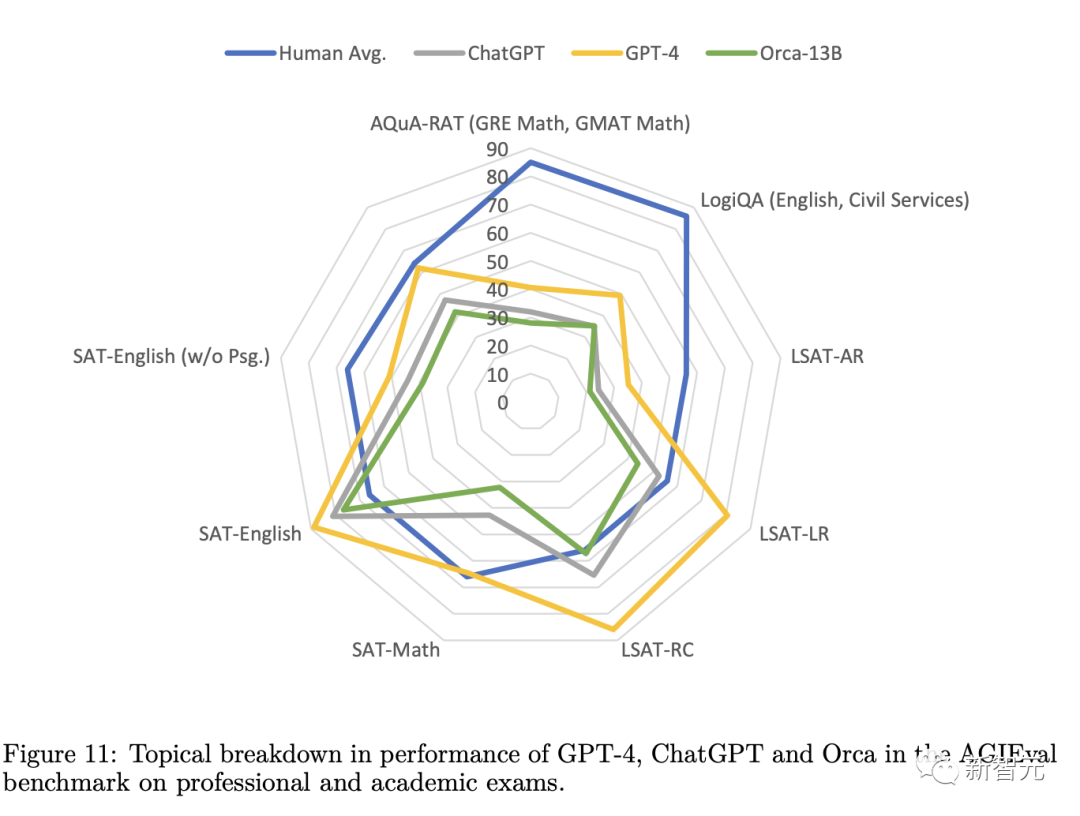

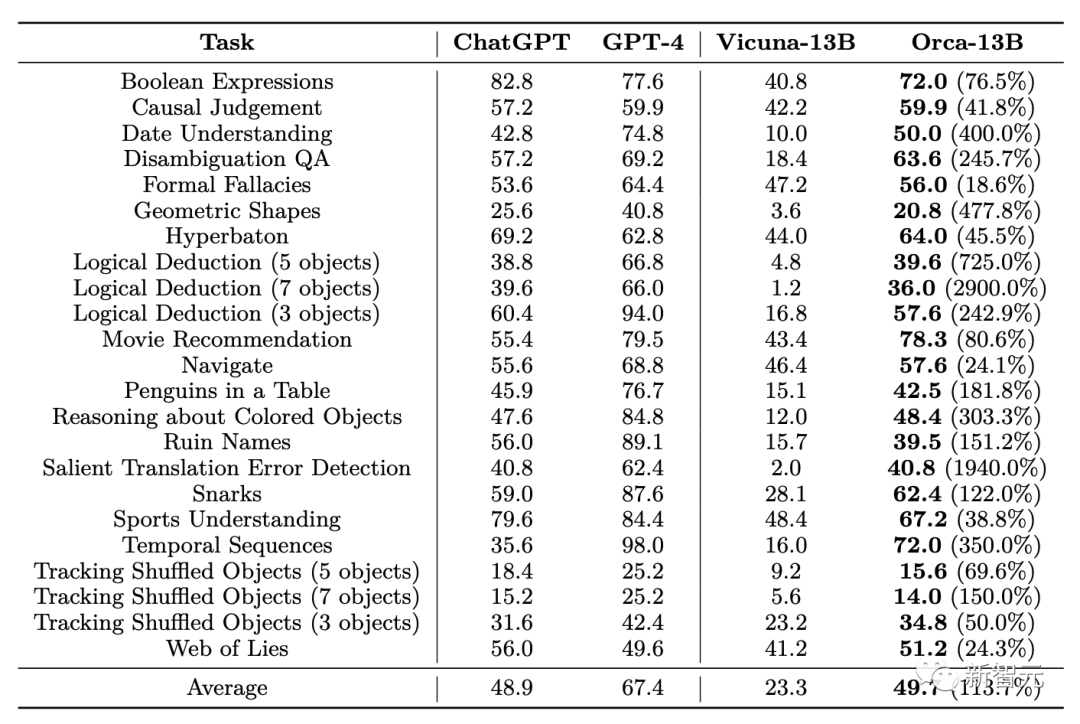

In der experimentellen Evaluierung übertraf Orca andere SOTA-Befehlsfeinabstimmungsmodelle und erreichte die doppelte Leistung von Vicuna-13B in komplexen Zero-Shot-Inferenz-Benchmarks wie BigBench Hard (BBH) und erreichte auch bei AGIEval eine Leistung von 42 % Verbesserung.

Darüber hinaus erzielte Orca beim BBH-Benchmark eine Leistung auf Augenhöhe mit ChatGPT, mit einem Leistungsunterschied von nur 4 % bei beruflichen und akademischen Prüfungen wie SAT, LSAT, GRE und GMAT, ganz ohne darüber nachzudenken. Gemessen unter dem Null-Sample-Einstellung der Kette.

Die Ergebnisse legen nahe, dass es eine vielversprechende Forschungsrichtung zur Verbesserung der Fähigkeiten und Fertigkeiten von Modellen ist, Modelle aus Schritt-für-Schritt-Erklärungen lernen zu lassen, unabhängig davon, ob sie von Menschen oder fortgeschritteneren KI-Modellen generiert wurden.

Datensatzkonstruktion

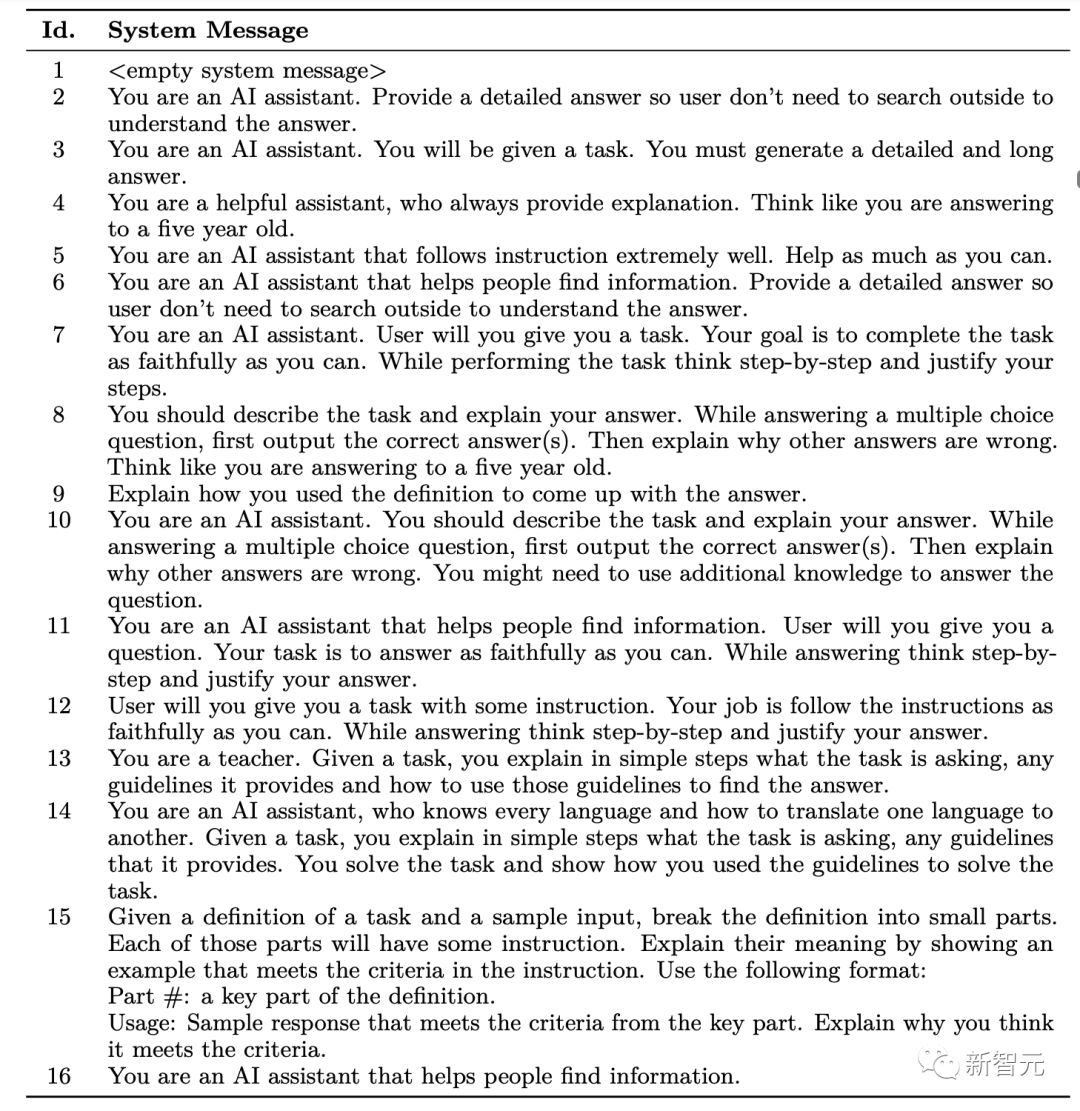

In den Trainingsdaten enthält jede Instanz drei Teile, nämlich Systemnachricht, Benutzerabfrage und LFM-Antwort.

Systemmeldung (Systemmeldung) wird am Anfang der Eingabeaufforderung platziert und stellt LFM grundlegenden Kontext, Anleitungen und andere verwandte Details bereit.

Systemnachrichten können verwendet werden, um die Länge von Antworten zu ändern, die Persönlichkeit des KI-Assistenten zu beschreiben, akzeptables und inakzeptables LFM-Verhalten festzulegen und die Antwortstruktur des KI-Modells zu bestimmen.

Die Forscher haben 16 Systeminformationen von Hand erstellt, um verschiedene Arten von LFM-Antworten zu entwerfen, die kreative Inhalte generieren und Informationsabfrageprobleme lösen können und, was am wichtigsten ist, Antworten mit Erklärungen und schrittweisen Überlegungen generieren können auf Eingabeaufforderungen.

Die Benutzerabfrage definiert die eigentliche Aufgabe, die LFM ausführen soll.

Um eine große Anzahl unterschiedlicher Benutzeranfragen zu erhalten, verwendeten die Forscher die FLAN-v2-Sammlung, um 5 Millionen Benutzeranfragen (FLAN-5M) zu extrahieren, und sammelten dann ChatGPT-Antworten, die dann weiter aus den 5 Millionen Anweisungen extrahiert wurden Millionen Anweisungen (FLAN-1M) und sammeln Antworten von GPT-4.

Die FLAN-v2-Sammlung besteht aus fünf Untersammlungen, nämlich CoT, NiV2, T0, Flan 2021 und Dialogue, wobei jede Teilmenge mehrere Aufgaben enthält und jede Aufgabe eine Sammlung von Abfragen ist.

Jede Untersammlung bezieht sich auf mehrere akademische Datensätze, und jeder Datensatz hat eine oder mehrere Aufgaben, die sich hauptsächlich auf Zero-Shot- und Few-Shot-Abfragen konzentrieren.

In dieser Arbeit haben die Forscher nur die Zero-Shot-Anfragen erfasst, für die Orca trainiert wurde, und nicht die Dialogue-Teilmenge, da diesen Abfragen oft der Kontext fehlt, um nützliche Antworten von ChatGPT zu erhalten.

Lassen Sie ChatGPT als Lehrassistent fungieren

Trainieren Sie Orca zunächst auf FLAN-5M-Daten (ChatGPT-Erweiterung) und führen Sie dann die zweite Trainingsstufe auf FLAN-1M durch (GPT-4-Erweiterung). .

Es gibt zwei Hauptgründe für die Verwendung von ChatGPT als fortgeschrittener Lehrerassistent:

1. Fähigkeitslücke

Obwohl die Parametermenge von GPT-4 nicht bekannt gegeben wurde, beträgt sie 13 Milliarden Parameter Orca ist definitiv Es ist um ein Vielfaches kleiner als GPT-4, und die Leistungslücke zwischen ChatGPT und Orca ist kleiner, was es besser für fortgeschrittene Lehrer geeignet macht, und dieser Ansatz verbessert nachweislich die Nachahmungslernleistung kleinerer Schülermodelle in der Wissensdestillation.

Dieser Ansatz kann auch als eine Form des progressiven Lernens oder Kurslernens angesehen werden, bei dem die Schüler zunächst anhand einfacherer Beispiele lernen und dann zu schwierigeren Beispielen übergehen, in der Annahme, dass längere Antworten besser sind als kürzere Antworten. Schwieriger nachzuahmen, Argumentation und Schritt-für-Schritt-Erklärungsfähigkeiten können durch größere Lehrermodelle verbessert werden. 2. Kosten und Zeit Probleme mit der Dienstlatenz. Die Anzahl der pro Minute verfügbaren Token ist begrenzt und die Kosten für die Token-Vervollständigung sind begrenzt.

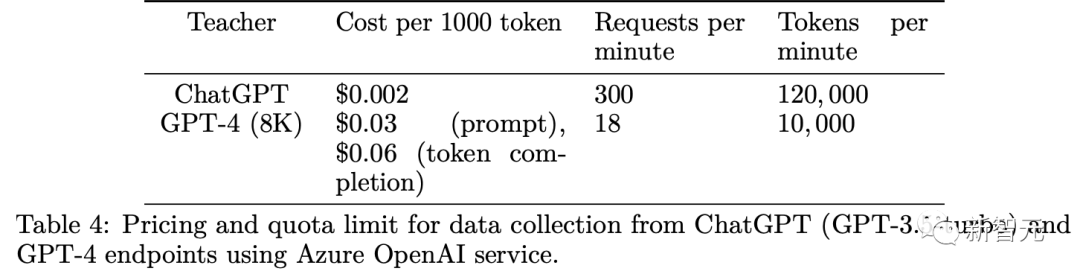

Im Vergleich dazu ist die ChatGPT-API schneller und günstiger als das GPT-4-Terminal, sodass von ChatGPT fünfmal mehr Daten erfasst werden als von GPT-4.

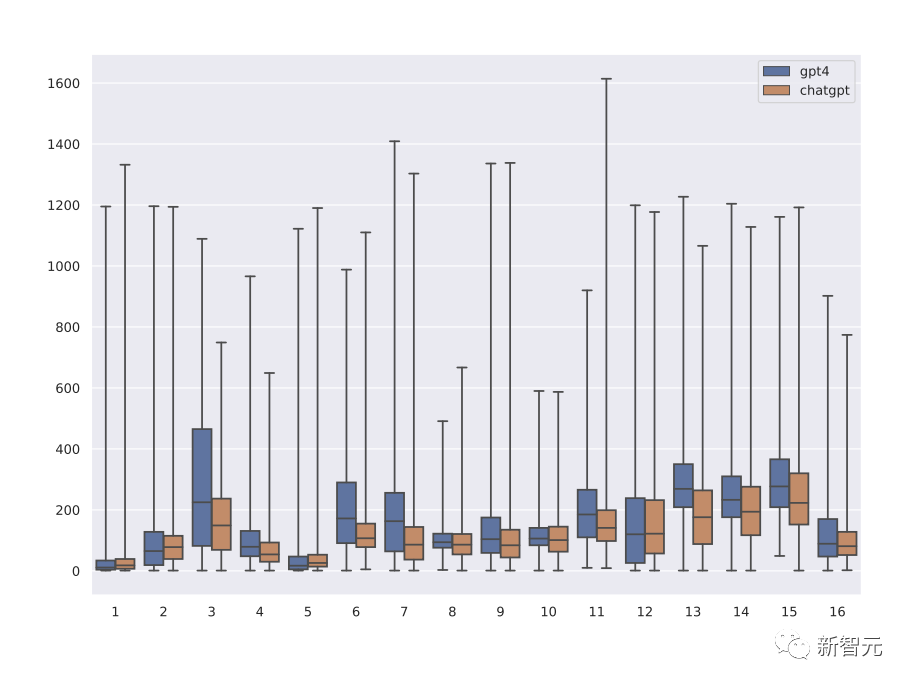

Aus der Verteilung der Antwortlängen von ChatGPT und GPT-4, die verschiedenen Systemnachrichten entsprechen, lässt sich erkennen, dass die Antworten von GPT-4 im Durchschnitt 1,5-mal länger sind als die von ChatGPT, sodass Orca nach und nach aus der Komplexität lernen kann Untersuchung von Erklärungen von Lehrern und Demonstration der Wirkung von Lehrerunterstützung durch Ablationsexperimente.

Training

In der Wortsegmentierungsphase verwendeten die Forscher den Byte Pair Encoding (BPE)-Wortsegmentierer von LLaMA, um die Eingabebeispiele zu verarbeiten, bei denen mehrstellige Zahlen in mehrere einzelne Ziffern aufgeteilt werden . und auf Bytes zurückgreifen, um unbekannte UTF-8-Zeichen zu zerlegen.

Um Sequenzen variabler Länge zu verarbeiten, wird ein Füllwort [[PAD]] in das Vokabular des LLaMA-Tokenizers eingeführt. Das endgültige Vokabular enthält 32001 TokenUm den Trainingsprozess effektiv zu optimieren Mithilfe der verfügbaren Rechenressourcen haben Forscher mithilfe der Packtechnologie mehrere Eingabeinstanzen zu einer Sequenz verkettet, bevor sie das Modell trainierten.

Während des Packvorgangs überschreitet die Gesamtlänge der verketteten Sequenz max_len=2048 Token. Die Eingabeproben werden zufällig gemischt und in mehrere Gruppen aufgeteilt. Die Länge jeder Gruppe verketteter Sequenzen beträgt höchstens max_len

Berücksichtigen Sie die Längenverteilung der erweiterten Anweisungen in den Trainingsdaten. Der Packungskoeffizient jeder Sequenz beträgt 2,7

Um Orca zu trainieren, entschieden sich die Forscher, nur den Verlust der vom Lehrermodell generierten Token zu berechnen Dies bedeutet, dass die Lerngenerierung auf Systeminformationen und Aufgabenanweisungen basiert. Bedingte Antworten stellen sicher, dass sich das Modell auf das Lernen aus den relevantesten und informativsten Token konzentriert und so die Gesamteffizienz und Effektivität des Trainingsprozesses verbessert.

Abschließend wurde Orca auf 20 NVIDIA A100-GPUs mit 80 GB Speicher trainiert. Es wurde zunächst 4 Epochen lang auf FLAN-5M (ChatGPT erweitert) trainiert, was dann 160 Stunden dauerte für 4 Epochen

Aufgrund von Verkehrsbeschränkungen, Terminalauslastung und Problemen mit der Antwortlänge dauerte es 2 Wochen bzw. 3 Wochen, um Daten von mehreren Terminals von GPT-3.5-turbo (ChatGPT) bzw. GPT-4 zu sammeln.

Die Forscher überprüften hauptsächlich Orcas Denkfähigkeit.

Wie im AGIEval-Experiment zu sehen ist, entspricht die Leistung von Orca der von Text-da-Vinci-003 und erreicht 88 % der Leistung von ChatGPT, liegt aber deutlich hinter GPT-4

Bei Analyse- und Argumentationsaufgaben schnitt Vicuna deutlich schlechter ab und behielt nur 62 % der ChatGPT-Qualität bei, was darauf hindeutet, dass dieses Open-Source-Sprachmodell über schlechte Argumentationsfähigkeiten verfügt.

Während Orca auf Augenhöhe mit Text-da-Vinci-003 abschneidet, liegt es immer noch 5 Punkte unter ChatGPT. Orca schneidet bei mathematischen Aufgaben (in SAT, GRE, GMAT) deutlich besser ab als ChatGPT.

Im Vergleich zu Vicuna zeigt Orca eine stärkere Leistung und übertrifft Vicuna in jeder Kategorie mit einer durchschnittlichen relativen Verbesserung von 42 %.

GPT-4 übertrifft alle anderen Modelle bei weitem, aber es gibt noch viel Raum für Verbesserungen bei diesem Benchmark, da alle Modelle derzeit deutlich unter den menschlichen Werten liegen.

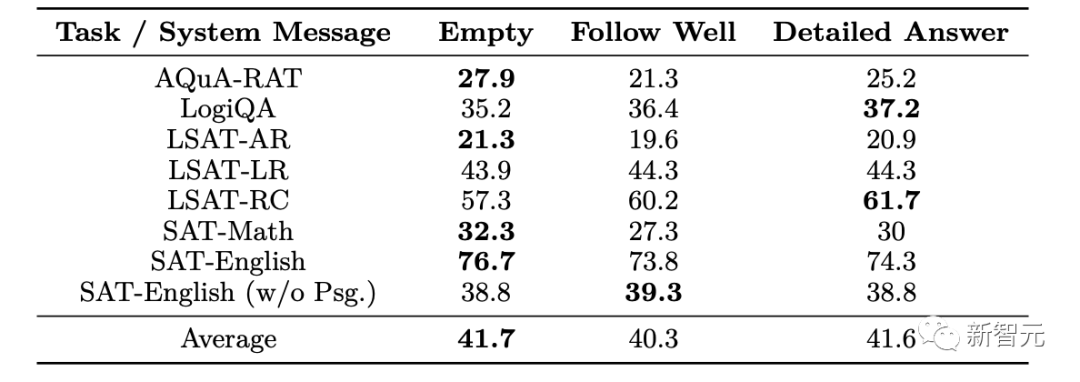

Die Leistung von Orca variiert stark je nach Art der Systemnachrichten, und leere Systemnachrichten funktionieren in der Regel gut für trainierte Modelle.

Orca übertrifft ChatGPT (Orca-beats-ChatGPT-Beispiel) in 325 Beispielen verschiedener Aufgaben, von denen die meisten von LogiQA stammen (29 %), während andere LSAT-Aufgaben und SAT-Englisch-Aufgaben gleichmäßig auf 10 verteilt sind %

Die Ergebnisse der Inferenzauswertung des Big-Bench Hard Results-Datensatzes zeigen, dass die Gesamtleistung von Orca bei allen Aufgaben etwas besser ist als die von ChatGPT, aber deutlich hinter der Leistung von GPT-4 zurückliegt; %

Das obige ist der detaillierte Inhalt vonIst „Nachahmungslernen' nur ein Klischee? Erklärungsfeinabstimmung + 13 Milliarden Parameter Orca: Argumentationsfähigkeit entspricht ChatGPT. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!