Lassen Sie uns zunächst das Szenario in diesem Artikel vorstellen – das „Gute-Ware“-Szenario. Seine Position befindet sich im Vierquadratraster auf der Homepage von Taobao, die in eine One-Hop-Auswahlseite und eine Two-Hop-Akzeptanzseite unterteilt ist. Es gibt zwei Hauptformen von Akzeptanzseiten: eine ist die Bild- und Text-Akzeptanzseite und die andere ist die kurze Video-Akzeptanzseite. Das Ziel dieses Szenarios besteht hauptsächlich darin, den Benutzern zufriedenstellende Waren bereitzustellen und das Wachstum des GMV voranzutreiben, wodurch das Angebot an Experten weiter genutzt wird.

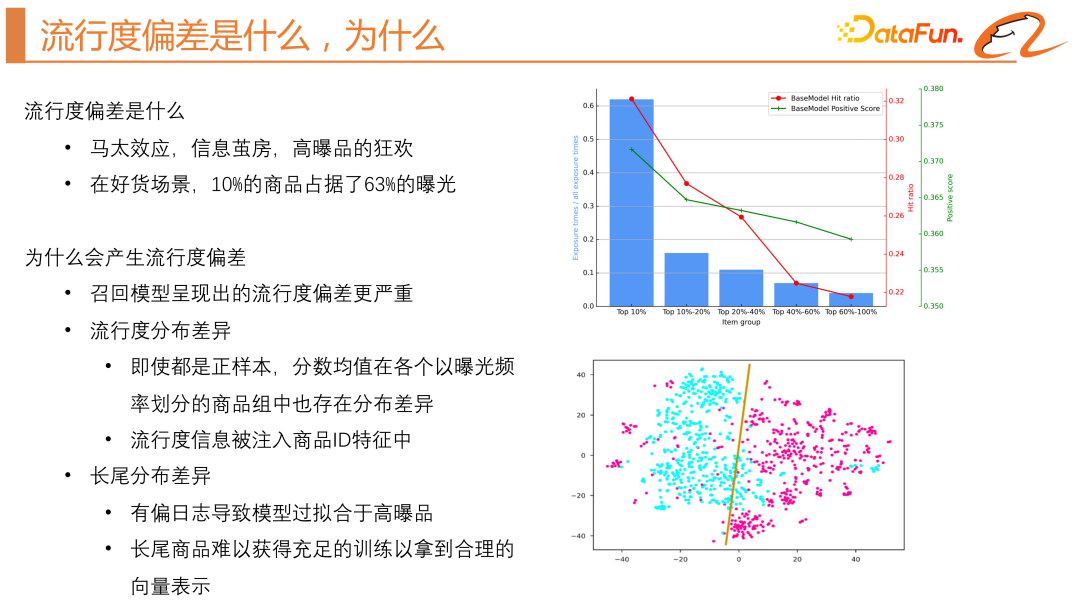

Als nächstes kommt der Fokus dieses Artikels: Beliebtheitsbias. Was ist ein Beliebtheitsbias? Warum kommt es zu einem Beliebtheitsbias?

2. Warum tritt der Beliebtheitsbias auf?

Als nächstes beschreiben wir, warum der Beliebtheitsbias auftritt. Zunächst müssen wir klären, warum wir die Beliebtheitsverzerrung bei der Rückrufkürzung abschwächen. Das Ranking-Modell passt sich der CTR des Produkts an und seine Trainingsproben umfassen positive und negative Proben. Produkte mit höherer CTR gewinnen eher an Bekanntheit. In der Rückrufphase verwenden wir jedoch normalerweise das Twin-Tower-Modell. Die erste ist die negative Stichprobe innerhalb einer Charge gleich Eine Charge verwendet andere Belichtungsprotokolle positiver Proben als negative Proben, sodass der Matthew-Effekt bis zu einem gewissen Grad gemildert werden kann. Durch Experimente haben wir jedoch herausgefunden, dass der tatsächliche Online-Effizienzeffekt der globalen Negativstichprobe besser sein wird. Globale zufällige negative Stichproben in Empfehlungssystemen können jedoch zu einer Beliebtheitsverzerrung führen, da sie nur positives Feedback für das Modell liefern. Diese Verzerrung kann auf Unterschiede in der Beliebtheitsverteilung und Interferenzen mit Vorwissen zurückgeführt werden, d. h. Benutzer neigen dazu, auf beliebtere Elemente zu klicken. Daher empfiehlt das Modell möglicherweise bevorzugt beliebte Artikel, unabhängig von ihrer Relevanz.

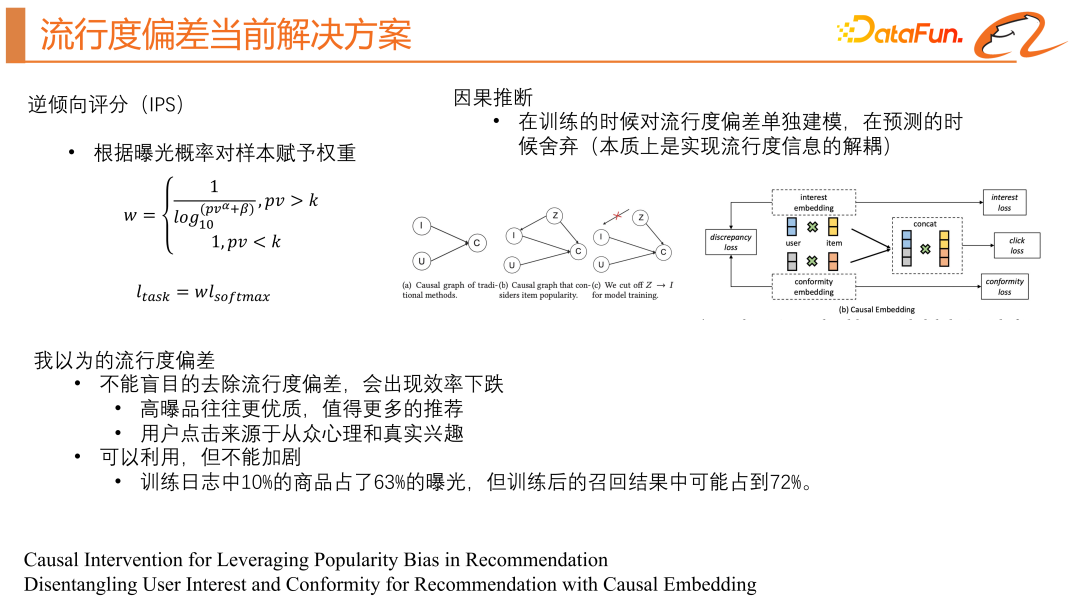

Die aktuellen Branchenlösungen umfassen hauptsächlich zwei Arten, nämlich den Inverse Propensity Score (IPS) und den kausalen Rückschluss. 1. Inverse Propensity Score (IPS) dass das gesamte Produkt gleichmäßiger auf eine positive Probenverteilung geachtet werden kann. Diese Methode erfordert jedoch die Vorhersage der Expositionswahrscheinlichkeit im Voraus, was instabil und anfällig für Fehler oder große Schwankungen ist.

Die einfachere Methode besteht darin, einige statistische Merkmale des Produkts zu verwenden, um einen separaten Bias-Turm zu erhalten. Zu diesem Zeitpunkt gibt das Modell zwei Bewertungen aus, eine ist die tatsächliche Klickrate und die andere ist die Beliebtheitswert des Produkts, online Bei der Vorhersage wird der Beliebtheitswert des Produkts entfernt, um eine Entkopplung der Beliebtheitsabweichung zu erreichen.

Die zweite Methode besteht darin, Benutzerklicks in zwei Kategorien einzuteilen, eine ist Herdeninteresse und die andere ist echtes Interesse, und jeweils ein gemeinsames Training von Proben aufzubauen. Dies entspricht dem Erhalten von zwei Modellen, einem Modell zum Erhalten des Herdeninteressens-Scores des Benutzers und einem Modell zum Erhalten des wahren Interessenscores des Benutzers. Es gibt tatsächlich Probleme mit der kausalen Schlussfolgerung. Es löst den Unterschied in der Beliebtheitsverteilung, kann jedoch nicht das Problem des Mangels an Trainingsdaten für Long-Tail-Produkte lösen. Aktuelle Lösungen neigen dazu, Beliebtheitsverzerrungen zu beseitigen, aber dies ist möglicherweise nicht immer von Vorteil für Empfehlungssysteme, die den „Matthew-Effekt“ zum Überleben benötigen. Daher empfehlen wir, den Beliebtheitsbias im Empfehlungssystem nicht vollständig zu beseitigen, da beliebte Artikel in der Regel von höherer Qualität sind und Benutzer sowohl eine Herdenmentalität als auch ein echtes Interesse haben . Der Beliebtheitsbias sollte rational genutzt werden, ohne den Bias zu verschärfen. 4. Grundgerüst von CD2AN „Wie extrahiert man eine unvoreingenommene und vollständig erlernte Produktdarstellung? „Um Unterschiede in der Beliebtheitsverteilung zu berücksichtigen, müssen wir den tatsächlichen Inhaltsvektor und den Beliebtheitsvektor von der Produkt-ID entkoppeln. Um Long-Tail-Verteilungsunterschiede anzugehen, greifen wir auf das Paradigma der Domänenanpassung zurück, um die Gesamtverteilung auszurichten, und auf das Paradigma des kontrastiven Lernens, um die Instanzverteilungen auszurichten.

Lassen Sie uns zunächst den Grundaufbau des Basismodells vorstellen. Das Basismodell ist eigentlich ein klassisches Twin-Tower-Modell. Als nächstes werden wir im Detail vorstellen, wie wir die beiden zuvor genannten Probleme lösen (Unterschiede in der Beliebtheitsverteilung und Unterschiede in der Long-Tail-Verteilung).

1. Das Feature-Entkopplungsmodul mildert Unterschiede in der Beliebtheitsverteilung

Das Feature-Entkopplungsmodul ist eine in diesem Artikel vorgeschlagene Lösung, um das Problem der Beliebtheitsverzerrung in Empfehlungssystemen anzugehen. Dieses Modul reduziert den Einfluss der Beliebtheit auf die Elementvektordarstellung, indem es Beliebtheitsinformationen von Attributinformationen in der Elementvektordarstellung trennt. Insbesondere umfasst dieses Modul einen Popularitäts-Encoder und einen Attribut-Encoder und lernt die Attribut- und Popularitätsvektordarstellung jedes Elements durch eine Kombination mehrschichtiger Perzeptrone. Die Eingabe dieses Moduls sind die Attributmerkmale des Artikels, wie z. B. Artikel-ID, Artikelkategorie, Marke usw., wie im rechten Teil der Modellstruktur oben dargestellt. Hier gibt es zwei Einschränkungen, einschließlich orthogonaler Regularisierung und Beliebtheitsähnlichkeitsregularisierung, mit dem Ziel, die Beliebtheitsinformationen von den Artikelattributinformationen zu trennen. Unter anderem wird das Modul durch die Beliebtheitsähnlichkeits-Regularisierung dazu ermutigt, die in Artikelattributen eingebetteten Beliebtheitsinformationen mit den tatsächlichen Beliebtheitsinformationen abzugleichen, während das Modul durch orthogonale Regularisierung dazu ermutigt wird, unterschiedliche Informationen in der Codierung beizubehalten, wodurch getrennte Beliebtheitsgradinformationen erzielt werden und Artikelattributinformationen.

Wir benötigen auch ein Modul, um die tatsächliche Popularität zu lernen, wie im linken Teil der Modellstruktur oben gezeigt, ist seine Eingabe Es handelt sich hauptsächlich um die statistischen Eigenschaften des Produkts und durchläuft dann einen MLP, um die tatsächliche Beliebtheitsdarstellung zu erhalten.

#🎜🎜 #

#🎜🎜 #

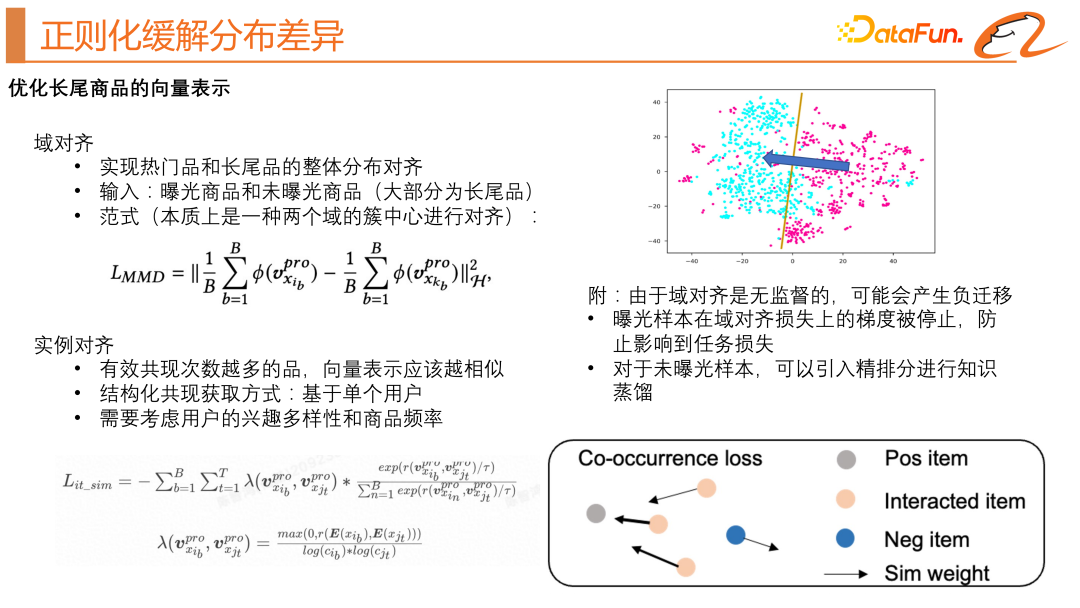

Als nächstes wollen wir das Problem der Long-Tail-Verteilungsunterschiede lösen.

Wir greifen auf die Idee der Migration zurück, um die Verbreitung beliebter Produkte langfristig zu erreichen -Schwanzprodukte Ausrichtung. Im ursprünglichen Zwei-Turm-Modell haben wir ein unbelichtetes Produkt eingeführt und die MMD-Verlustfunktion verwendet (wie oben links in der Abbildung gezeigt). Produktdomäne sind so nah wie möglich, wie oben gezeigt. Wie im schematischen Diagramm oben rechts in der Abbildung gezeigt. Da diese Art der Domänenausrichtung unbeaufsichtigt ist und zu einer negativen Übertragung führen kann, haben wir die folgenden Optimierungen vorgenommen: Der Gradient der exponierten Proben auf dem Domänenausrichtungsverlust wird gestoppt, um zu verhindern, dass er sich auf den Aufgabenverlust für unbelichtete Proben auswirkt Wissensdestillation eingeführt.

Wir greifen auch auf die Idee der Instanzausrichtung zurück, in der Hoffnung, bessere Produktvektordarstellungen zu lernen. Die Hauptidee besteht darin, dass die Vektordarstellungen umso ähnlicher sind, je effektiver das gemeinsame Vorkommen von Produkten ist . Die Schwierigkeit besteht darin, das Paar zu konstruieren. Ein solches Paar existiert natürlich in der Produktsequenz, in der sich der Benutzer in der Vergangenheit verhalten hat. Am Beispiel eines Benutzers enthält eine Stichprobe die Verhaltenssequenz und die Zielprodukte eines Benutzers. Dann können das Zielprodukt und jedes Produkt in der Verhaltenssequenz des Benutzers ein gleichzeitig auftretendes Paar bilden. Basierend auf der klassischen kontrastiven Lernverlustfunktion berücksichtigen wir auch die Interessenvielfalt und Produkthäufigkeit des Benutzers. Die spezifische Verlustfunktionsformel ist im unteren linken Teil der Abbildung oben zu sehen. Wir können uns ein intuitives schematisches Diagramm ansehen, wie unten rechts im Bild oben gezeigt. Die grauen Punkte sind die Zielprodukte, die orangefarbenen Punkte sind die Verhaltenssequenz des Benutzers und die blauen Punkte sind erhalten durch unsere zufällige negative Stichprobe. Wir hoffen, aus der kontrastiven Lernmethode zu lernen, jedes Produkt in der Benutzerverhaltenssequenz so einzuschränken, dass es nahe am Zielprodukt liegt. #🎜🎜 ## 🎜🎜 ## 🎜🎜#3. #Das obige Modul erhält effektiv die unvoreingenommene Inhaltsdarstellung und die entkoppelte Beliebtheitsdarstellung des Produkts. Wir verwenden die gemeinsame Trainingsmethode des unvoreingenommenen Modells und des voreingenommenen Modells. Um die Beliebtheitsinformationen nutzen zu können, führen wir auch die Beliebtheitsfunktion und das voreingenommene Modell ein nur erben Popularitätsbias verstärkt den Bias nicht. Für den Online-Service-Teil, wie auf der rechten Seite der Abbildung oben gezeigt, verschmelzen wir die unvoreingenommene Produktdarstellung und die voreingenommene Produktdarstellung über den Parameter α, um die Online-Produktdarstellung zu erhalten, sodass das Produkt über den Benutzervektor abgerufen werden kann Dieses α ist die Anpassung. Erinnern Sie sich daran, inwieweit den Beliebtheitsinformationen Beachtung geschenkt wird. Abschließend haben wir die Modellergebnisse visuell dargestellt. Wir haben festgestellt, dass die neue Modellstruktur tatsächlich die Verteilung hochexplosiver Produkte und Long-Tail-Produkte angleichen kann. Der entkoppelte Beliebtheitsdarstellungsvektor und die unvoreingenommene Inhaltsdarstellung des Produkts haben nahezu keine Schnittmenge, und es können mehr Produkte mit demselben Zweck vorhanden sein Durch die Anpassung von α kann das Modell direkt an die folgenden Interessen und tatsächlichen Interessen des Benutzers angepasst werden.

Abschließend haben wir die Modellergebnisse visuell dargestellt. Wir haben festgestellt, dass die neue Modellstruktur tatsächlich die Verteilung hochexplosiver Produkte und Long-Tail-Produkte angleichen kann. Der entkoppelte Beliebtheitsdarstellungsvektor und die unvoreingenommene Inhaltsdarstellung des Produkts haben nahezu keine Schnittmenge, und es können mehr Produkte mit demselben Zweck vorhanden sein Durch die Anpassung von α kann das Modell direkt an die folgenden Interessen und tatsächlichen Interessen des Benutzers angepasst werden.

Der Titel des heute veröffentlichten Papiers lautet „Co-Training des Disentangled Domain Adaptation Network for Leveraging Popularity Bias in Recommenders“.

F1: Wie werden unbelichtete Proben zur Probe hinzugefügt?

A1: Offline generiert Für eine Probe können wir die Ziel-Positivprobe und die entsprechende Kategorie abrufen und dann nach dem Zufallsprinzip mehrere Produkte in derselben Kategorie wie die Ziel-Positivprobe offline testen und sie zum Training hinzufügen Probe.

A3: Bewerten Sie das Beispiel offline mit einem guten Ranking-Modell und verwenden Sie es als Funktion. Die Leistung ist nicht schlecht.

Das obige ist der detaillierte Inhalt vonDas Geheimnis einer genauen Empfehlung: Detaillierte Erläuterung des unvoreingenommenen Rückrufmodells für die entkoppelte Domänenanpassung von Alibaba. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!