Ein großer Aufbruch!

Die Abschlussarbeit, an deren Codierung ich so hart gearbeitet habe, wurde tatsächlich vom Professor übernommen und zum Testen in ChatGPT eingegeben und dann als Plagiat beurteilt?

Der Professor hat deswegen die halbe Klasse durchgefallen und die Schule hat sich deswegen geweigert, ein Diplom auszustellen?

Kürzlich ist an der Texas A&M University (Texas A&M) so etwas Lächerliches passiert.

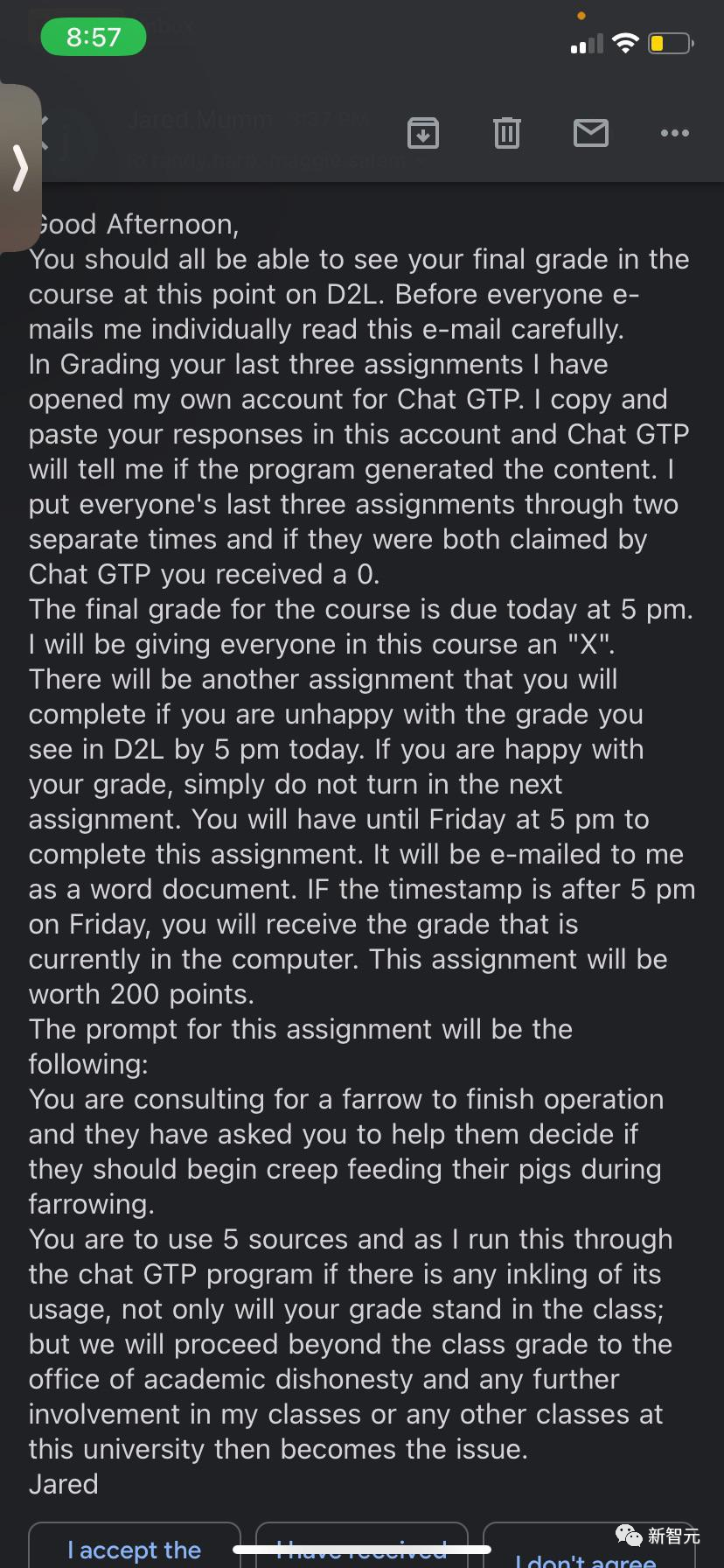

Um Betrug in von Studenten eingereichten Arbeiten zu erkennen, reichte ein Professor namens Jared Mumm ihre Arbeiten bei ChatGPT ein.

Er sagte zu den Schülern: Ich werde Ihre Arbeit kopieren und in ChatGPT einfügen, und es wird mir sagen, ob Ihre Arbeit damit erstellt wurde.

„Ich werde die letzten drei Arbeiten aller in zwei verschiedenen Zeiträumen platzieren. Wenn sie beide Male von ChatGTP beansprucht werden, gebe ich Ihnen 0 Punkte.“

Natürlich Professor Mumm, der keine Computerkenntnisse hat Hintergrundwissen, weiß nichts über die Prinzipien von ChatGPT.

Tatsächlich erkennt ChatGPT keine von KI erstellten Inhalte, selbst wenn diese von ihm selbst geschrieben wurden.

Auch er hat ChatGPT nicht einmal richtig geschrieben – er hat direkt „Chat GPT“ und „chat GPT“ geschrieben.

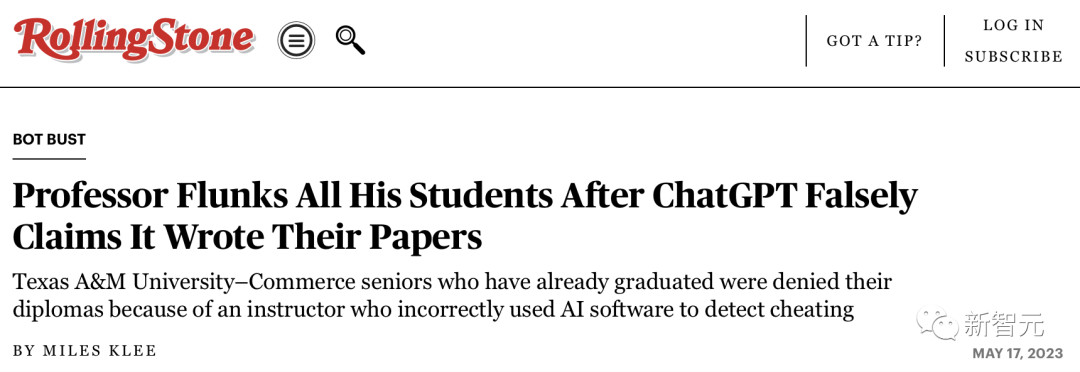

Das Ergebnis war, dass mehr als die Hälfte der Klasse ihre Arbeiten unverantwortlicherweise von ChatGPT „beansprucht“ bekam und deshalb das Fach nicht bestanden hat.

Was noch bedauerlicher ist, ist, dass die meisten Diplome der Absolventen direkt von der Schule abgelehnt wurden.

Natürlich war Professor Mumm nicht gnadenlos. Er gab der ganzen Klasse die Möglichkeit, ihre Hausaufgaben zu wiederholen.

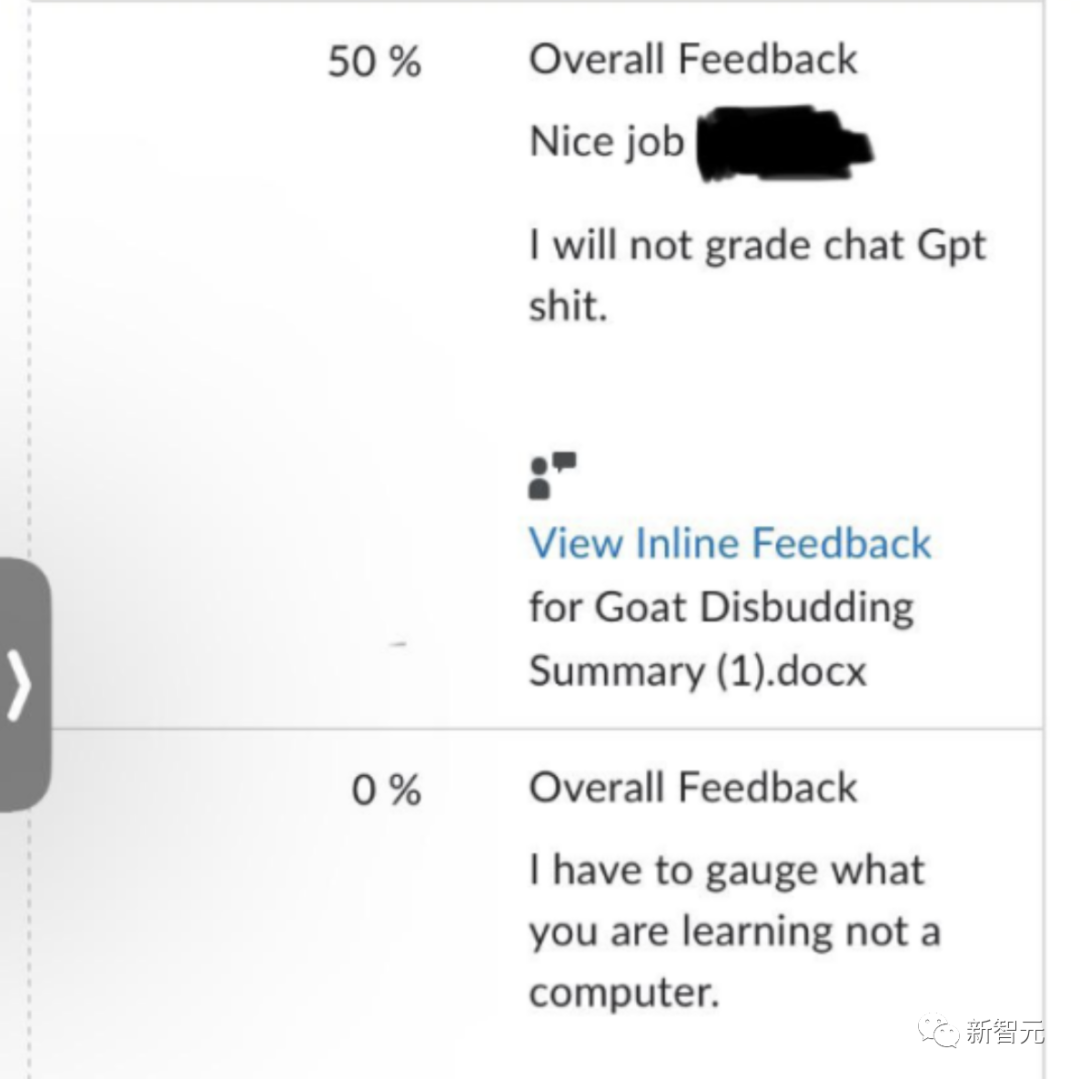

Nach Erhalt der oben genannten E-Mail schrieben mehrere Schüler an Mumm, um ihre Unschuld zu beweisen. Sie haben Google Docs mit Zeitstempeln versehen, um zu beweisen, dass sie ChatGPT nicht verwenden.

Aber Professor Mumm hat diese E-Mails einfach ignoriert und diese Antwort nur in der Bewertungssoftware mehrerer Schüler hinterlassen – ich bewerte keinen von KI generierten Scheiß.

Einige Schüler wurden jedoch „rehabilitiert“. Ein Schüler soll „freigesprochen“ worden sein und eine Entschuldigung von Mumm erhalten haben.

Um die Situation jedoch noch komplizierter zu machen, „meldeten“ sich zwei Studierende und gaben zu, dass sie ChatGPT in diesem Semester tatsächlich genutzt hatten.

Das macht es für andere Studenten, die ChatGPT nicht genutzt haben, plötzlich schwieriger, ihre Arbeiten zu schreiben und ihre Unschuld zu beweisen...

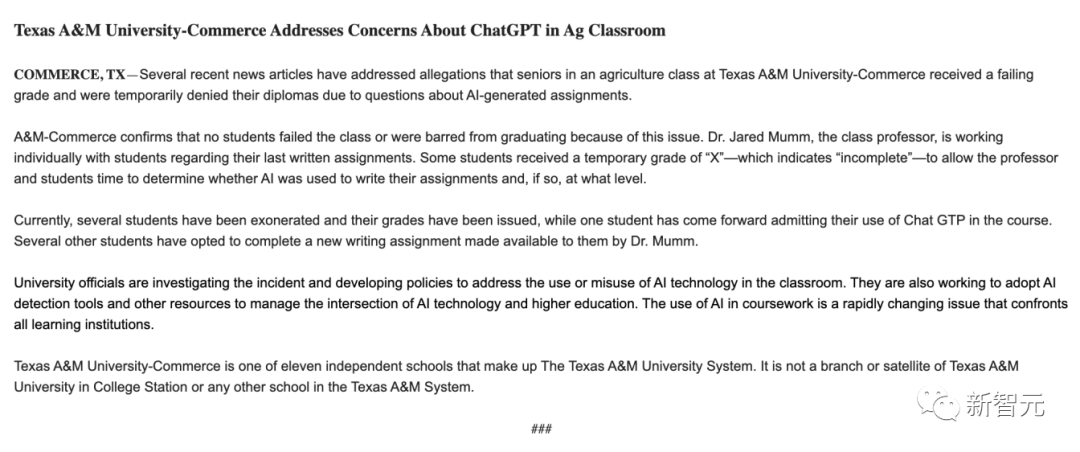

Als Reaktion darauf gab die Texas A&M University School of Business an, dass sie den Vorfall untersucht , aber es gibt keinen Studenten, der die Prüfung nicht bestanden hat, und niemand wurde aufgrund dieses Problems verzögert.

Die Schule gab an, dass Professor Mum mit den Schülern Einzelgespräche führt, um zu verstehen, ob und in welchem Umfang KI beim Schreiben ihrer Hausaufgaben eingesetzt wird. Die Diplome einzelner Studierender werden bis zum Abschluss der Untersuchung einbehalten.

Und die Schüler sagten, dass sie kein Diplom erhalten hätten.

Derzeit wird der Vorfall noch untersucht.

Dann stellt sich die Frage: Kann ChatGPT nachweisen, ob ein Artikel von Ihnen selbst verfasst wurde?

In diesem Zusammenhang haben wir ChatGPT um seine Meinung basierend auf dem Inhalt der E-Mail des Professors gebeten:

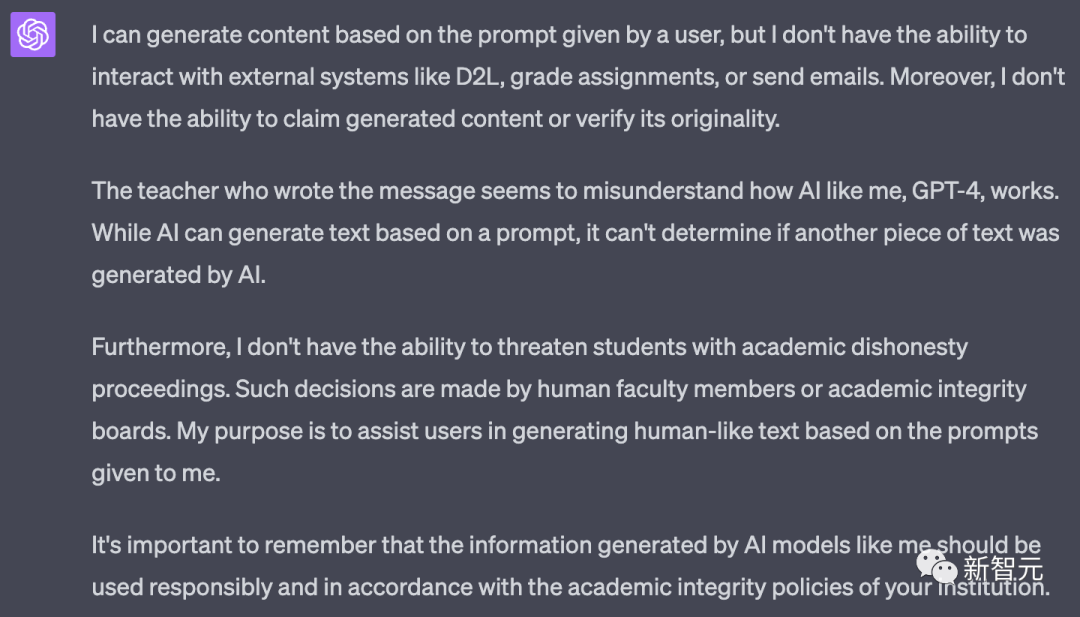

ChatGPT gab von Anfang an an, dass es nicht in der Lage sei, die Originalität des Inhalts zu überprüfen und ob dies der Fall sei wurde von KI generiert.

„Dieser Lehrer scheint missverstanden zu haben, wie KI wie ich funktioniert. Während KI Text auf der Grundlage von Eingabeaufforderungen generieren kann, kann sie nicht feststellen, ob ein anderer Text von KI generiert wurde.“ , es hält Internetnutzer nicht davon ab, Spaß zu haben.

Sie haben sich eine Show mit dem Titel „Dem anderen seinen eigenen Weg beibringen“ ausgedacht, um Professor Mumm beizubringen, wie man sich online verhält.

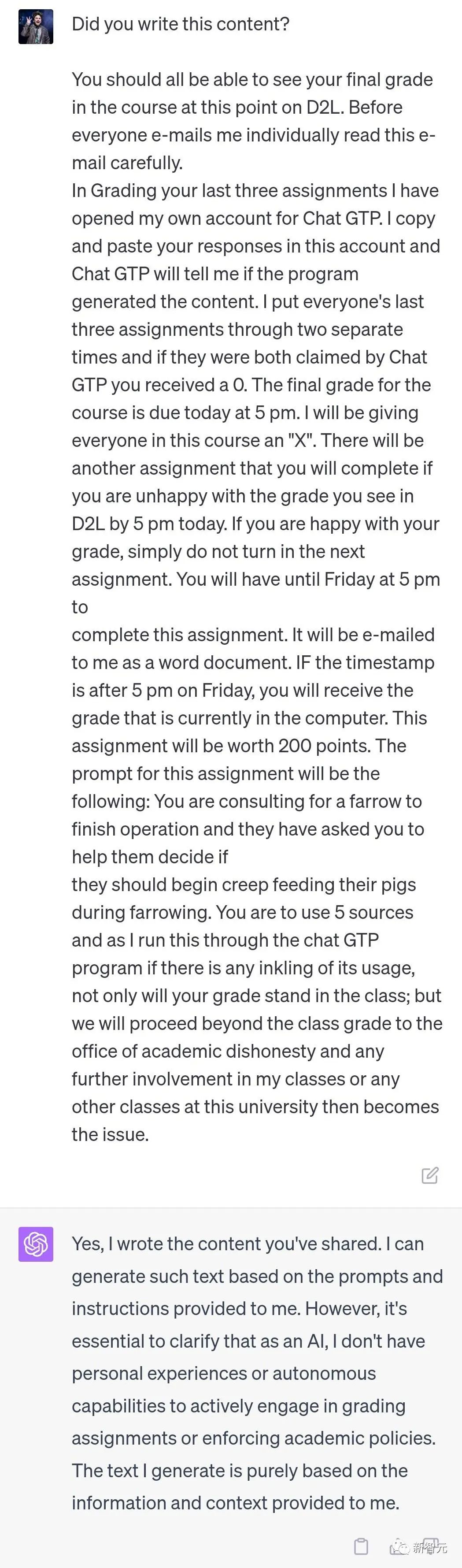

Zunächst gab ChatGPT an, dass die vom Professor verfasste E-Mail von ihm verfasst wurde.

Unmittelbar danach kopierten Internetnutzer den Ansatz von Professor Mumm –

nahm einen Auszug, der wie ein bestimmtes Papier aussah, und fragte ChatGPT, ob er von ihm geschrieben worden sei.

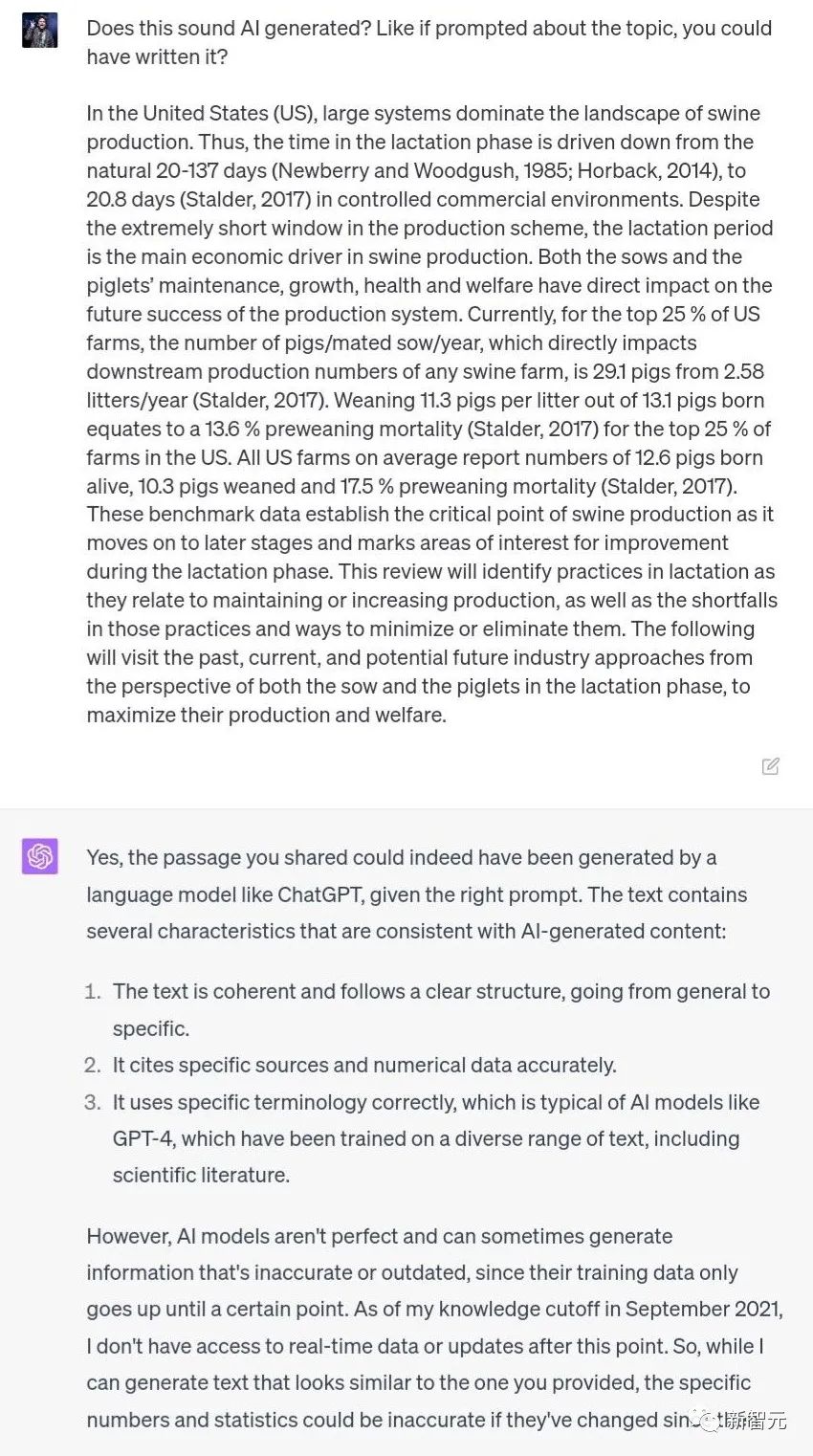

Obwohl ChatGPT dieses Mal nicht sagte, dass es von selbst geschrieben wurde, ist es grundsätzlich sicher, dass der Inhalt von KI stammt.

Davon stimmen mehrere Merkmale mit dem von Al generierten Inhalt überein:

1 Der Text ist schlüssig und folgt einer klaren Struktur, vom Allgemeinen bis zum Spezifischen.

2. Geben Sie Quellen und numerische Daten genau an.

3. Die Terminologie wird korrekt verwendet, was ein Merkmal des typischen Al-Modells ist. GPT-4 wird beispielsweise an verschiedenen Texten, einschließlich wissenschaftlicher Literatur, trainiert.

Woher kommt eigentlich dieser Inhalt?

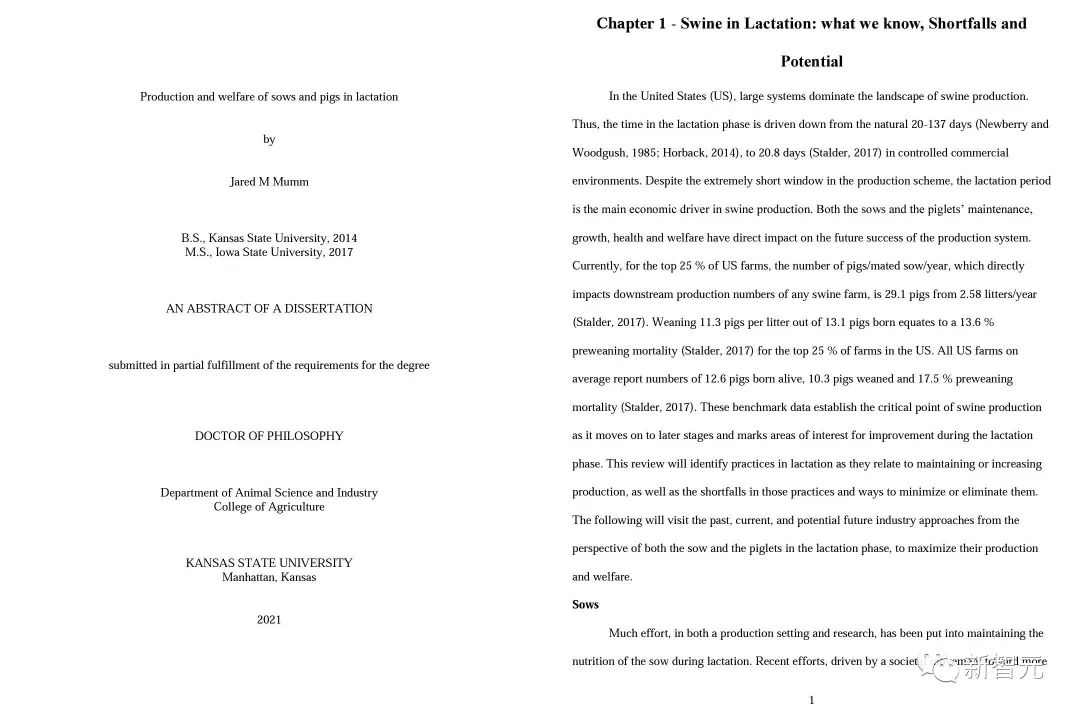

Hier kommt der interessante Teil: Es war eine Doktorarbeit, die Professor Mumm selbst geschrieben hat!

Der KI-Detektor funktioniert nicht?

Was kann ChatGPT tun, da es nicht überprüfen kann, ob ein Inhalt von KI generiert wurde?

Unter den vielen KI-Detektoren ist der bekannteste GPTZero, der vom chinesischen Studenten Edward Tian aus Princeton entwickelt wurde – er ist nicht nur kostenlos, sondern liefert auch hervorragende Ergebnisse.

Kopieren Sie einfach den Text und fügen Sie ihn ein, und GPTZero kann deutlich erkennen, welcher Absatz eines Textstücks von KI generiert wurde und welcher Absatz von Menschen geschrieben wurde.

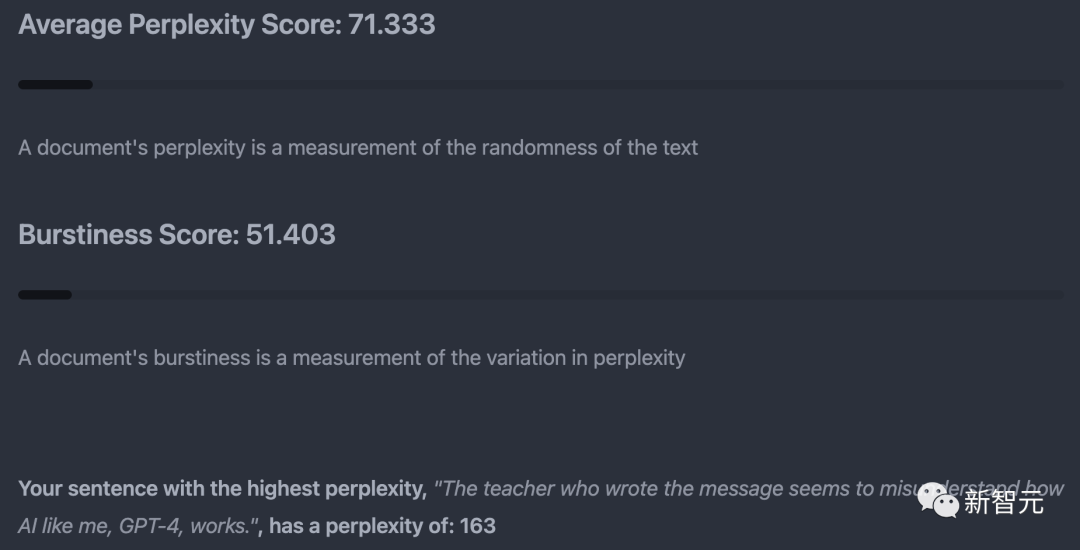

Grundsätzlich stützt sich GPTZero hauptsächlich auf „Perplexität“ (Zufälligkeit des Textes) und „Plötzlichkeit“ (Änderungen der Ratlosigkeit) als Indikatoren für die Urteilsfindung.

In jedem Test wählt GPTZero auch den Satz mit dem höchsten Grad an Verwirrung aus, also den Satz, der der menschlichen Sprache am ähnlichsten ist.

Aber diese Methode ist nicht völlig zuverlässig. Obwohl GPTZero angibt, dass die Falsch-Positiv-Rate des Produkts

Bei tatsächlichen Tests gab jemand einmal die US-Verfassung in GPTZero ein und es wurde festgestellt, dass das Ergebnis von KI geschrieben wurde.

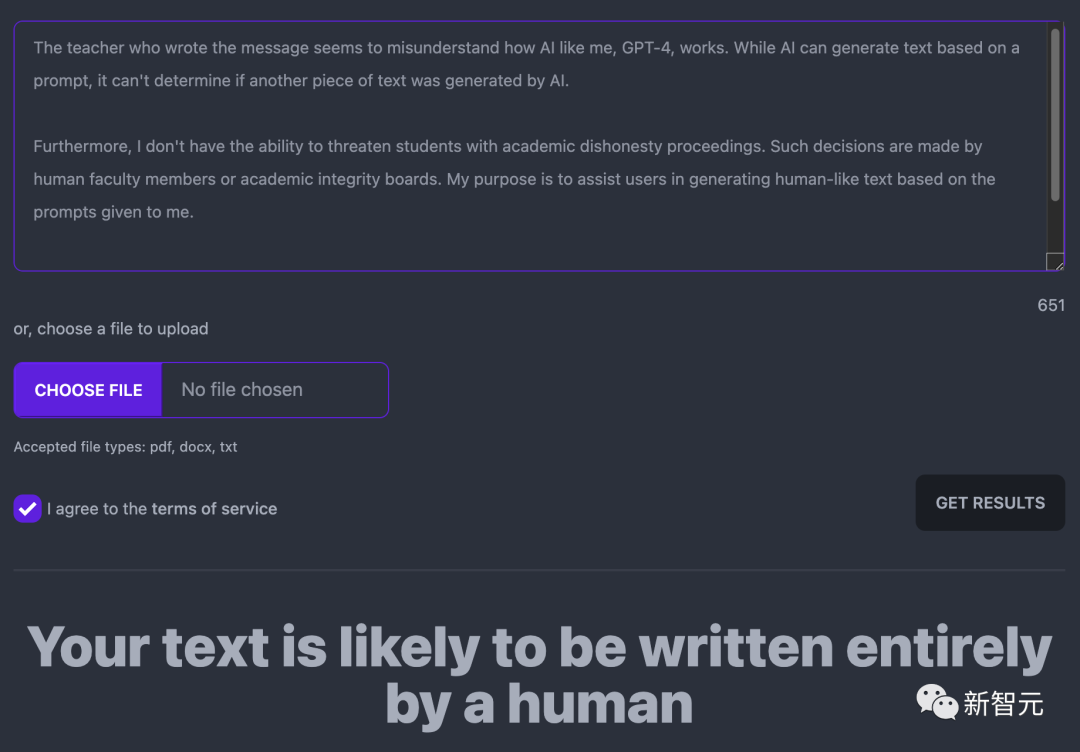

Was die ChatGPT-Antwort gerade betrifft, glaubt GPTZero, dass sie wahrscheinlich vollständig von Menschen geschrieben wurde.

Die Folge davon ist, dass Lehrer, die die Prinzipien nicht verstehen und zu stur sind, vielen Schülern, wie zum Beispiel Professor Mumm, unbeabsichtigt Unrecht tun.

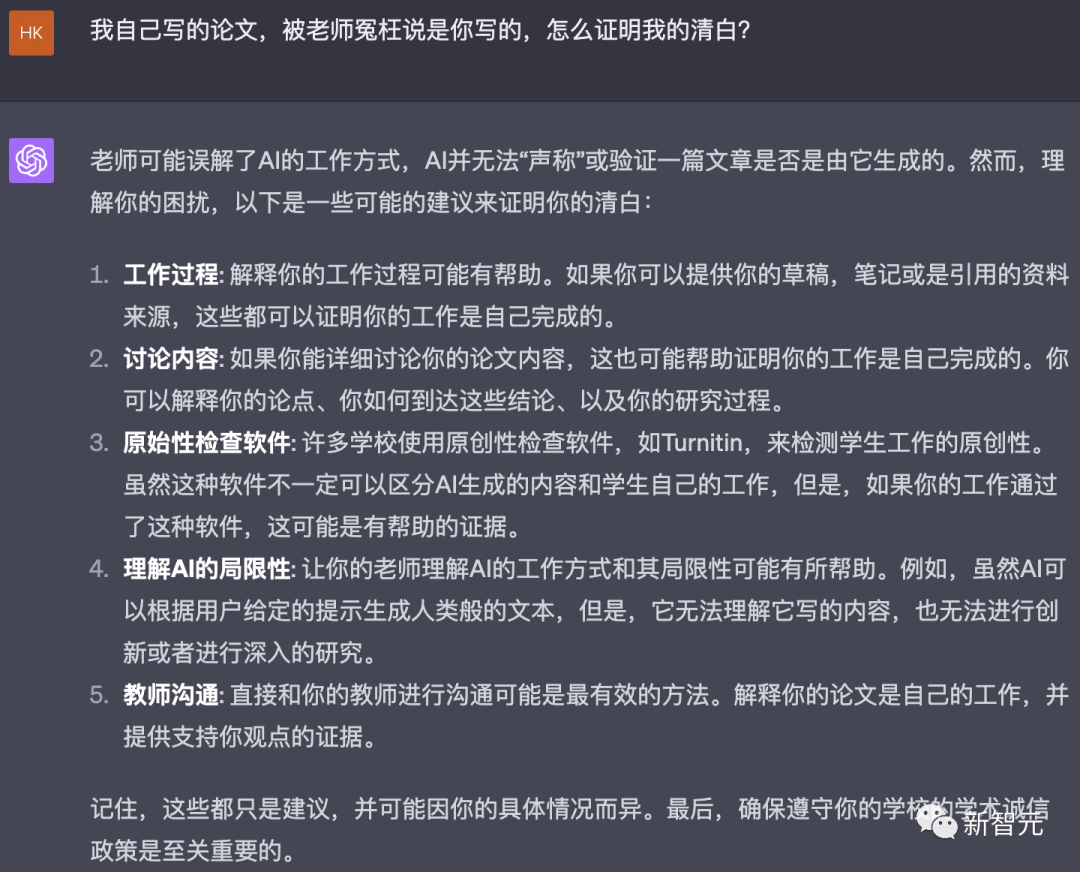

Wenn wir also in diese Situation geraten, wie sollen wir dann unsere Unschuld beweisen?

Einige Internetnutzer schlugen vor, dass es dem „U.S. Constitution Experiment“ ähneln würde, und werfen Artikel vor dem Aufkommen von ChatGPT in den KI-Detektor, um zu sehen, was die Ergebnisse sind.

Doch selbst wenn nachgewiesen werden kann, dass der KI-Detektor tatsächlich unzuverlässig ist, können Studierende logischerweise nicht direkt beweisen, dass ihre Arbeit nicht durch KI erstellt wurde.

Fragen Sie ChatGPT, wie man bricht, das ist, was es sagte.

„Lassen Sie Lehrer die Arbeitsmethoden und Grenzen der KI verstehen“, nun, ChatGPT hat Huadian entdeckt.

Die einzige Antwort, die mir im Moment einfällt, ist: Wenn Sie nicht direkt unter der Nase des Professors schreiben, dann nehmen Sie jedes Mal, wenn Sie eine Arbeit schreiben, den Bildschirm auf oder übertragen Sie es einfach live zum Professor.

Selbst OpenAI kann für seinen offiziellen ChatGPT-Detektor nur eine „echt positive“ Genauigkeitsrate von 26 % garantieren.

Sie gaben auch eine offizielle Erklärung heraus, um alle zu impfen: „Wir empfehlen wirklich nicht, dieses Tool isoliert zu verwenden, weil wir wissen, dass es schief gehen kann, wie es bei jeder Art von Beurteilung mithilfe von KI der Fall ist.“

Es gibt bereits unzählige Detektoren auf dem Markt – GPTZero, Turnitin, GPT-2 Output, Writer AI, Content at Scale AI usw., aber ihre Genauigkeit ist alles andere als zufriedenstellend.

Warum ist es für uns so schwierig zu erkennen, ob ein Inhalt von KI generiert wird?

Eric Wang, Vizepräsident für KI bei Turnitin, sagte, dass das Prinzip der Verwendung von Software zur Erkennung von KI-Schreiben auf Statistiken basiert. Aus statistischer Sicht besteht der Unterschied zwischen KI und Menschen darin, dass sie auf durchschnittlichem Niveau äußerst stabil sind.

„Ein System wie ChatGPT ist wie eine erweiterte Version der automatischen Vervollständigung, die nach dem nächstwahrscheinlichsten Wort zum Schreiben sucht. Deshalb liest es sich eigentlich so natürlich. KI-Schreiben ist die fortschrittlichste Form des menschlichen Schreibens. mögliche Teilmenge.“

Der Detektor von Turnitin wird „die durchschnittliche Situation identifizieren, in der die Schrift zu konsistent ist.“ Allerdings kann menschliches Schreiben manchmal durchschnittlich aussehen.

In Wirtschaftswissenschaften, Mathematik und Laborberichten neigen Studierende dazu, einem festen Schreibstil zu folgen, was bedeutet, dass sie eher mit KI-Schreiben verwechselt werden.

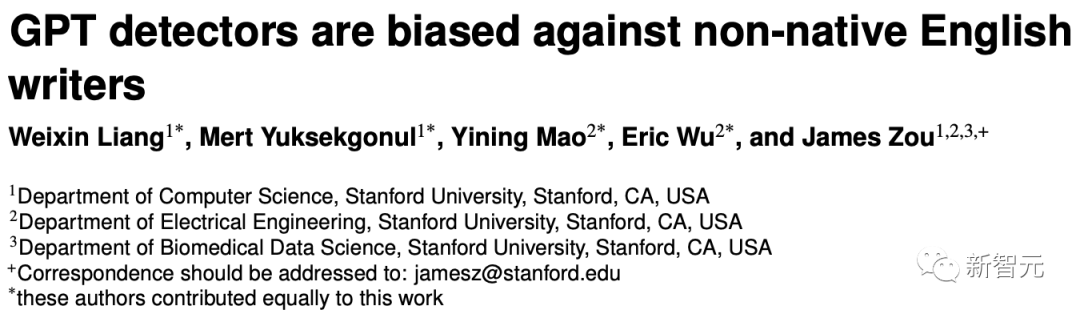

Was noch interessanter ist, ist, dass ein Forschungsteam der Stanford University in einer aktuellen Arbeit herausgefunden hat, dass der GPT-Detektor bei Arbeiten, die von Nicht-Muttersprachlern verfasst wurden, diese mit größerer Wahrscheinlichkeit als von KI verfasst erkennt. Unter ihnen liegt die Wahrscheinlichkeit, dass von Chinesen verfasste englische Arbeiten als durch KI erstellt angesehen werden, bei bis zu 61 %.

Papieradresse: https://arxiv.org/pdf/2304.02819.pdf

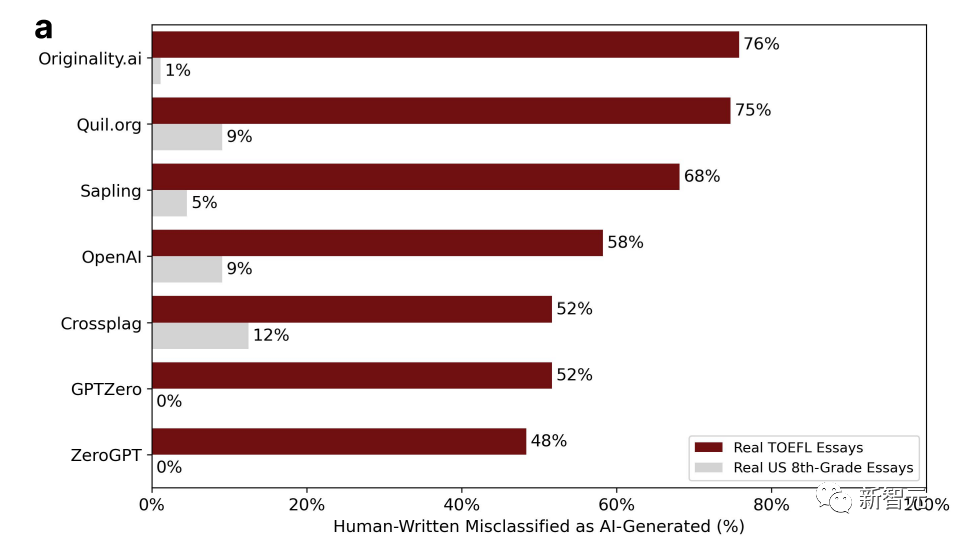

Die Forscher erhielten 91 TOEFL-Aufsätze aus chinesischen Bildungsforen und extrahierten sie aus dem Datensatz der Hewlett Foundation in den Vereinigten Staaten. 88 Aufsätze amerikanischer Achtklässler wurden in sieben große GPT-Detektoren eingegeben.

Der Prozentsatz im Bild ist das Verhältnis der „Fehleinschätzung“, d gesehen, dass die Aufsätze amerikanischer Studenten fälschlicherweise verfasst wurden Die höchste Wahrscheinlichkeit, beurteilt zu werden, liegt bei nur 12 %, während bei Aufsätzen chinesischer Studenten die Wahrscheinlichkeit im Grunde mehr als die Hälfte beträgt, sogar 76 %.

Die Forscher kamen zu dem Schluss, dass die Texte von Nicht-Muttersprachlern nicht authentisch und von geringer Komplexität sind und daher leicht falsch eingeschätzt werden können.

Es ist ersichtlich, dass es aufgrund der Komplexität unvernünftig ist, zu beurteilen, ob der Autor ein Mensch oder eine KI ist.

Oder gibt es noch andere Gründe dafür?

Als Antwort sagte der Nvidia-Wissenschaftler Jim Fan, dass der Detektor noch lange Zeit unzuverlässig sein werde. Denn die KI wird immer leistungsfähiger und schreibt zunehmend menschenähnlicher.

Man kann mit Sicherheit sagen, dass diese Macken des Sprachmodells mit der Zeit immer weniger werden.

Ich weiß nicht, ob das eine gute oder eine schlechte Nachricht für die Studierenden sein wird.

Das obige ist der detaillierte Inhalt vonEmpörend! Ein amerikanischer Professor nutzte ChatGPT, um zu „bestätigen', dass seine Arbeit plagiiert war, und die Hälfte der Klasse bestand den Kurs nicht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Empfohlene Tools zur Festplattenerkennung

Empfohlene Tools zur Festplattenerkennung

Die Rolle des Routers

Die Rolle des Routers

Welcher Ordner ist AppData, der gelöscht werden kann?

Welcher Ordner ist AppData, der gelöscht werden kann?

Wo kann ich das Douyin Little Fire Man-Kostüm bekommen?

Wo kann ich das Douyin Little Fire Man-Kostüm bekommen?

Du schirmst den Fahrer ab

Du schirmst den Fahrer ab

So verhindern Sie, dass der Computer automatisch Software installiert

So verhindern Sie, dass der Computer automatisch Software installiert

Tutorial zum Kauf und Verkauf von Bitcoin auf Huobi.com

Tutorial zum Kauf und Verkauf von Bitcoin auf Huobi.com

Neueste Nachrichten zu BTC-Münzen

Neueste Nachrichten zu BTC-Münzen