Befürchten Sie, dass sich künstliche Intelligenz zu schnell entwickelt und negative Folgen haben könnte? Wünschen Sie sich, dass es ein nationales Gesetz gäbe, das dies regelt? Heutzutage gibt es keine neuen Gesetze, die den Einsatz von KI einschränken, und oft ist Selbstregulierung die beste Option für Unternehmen, die KI einführen – zumindest vorerst. Obwohl „künstliche Intelligenz“ seit vielen Jahren „Big Data“ als heißestes Schlagwort in der Technologiewelt abgelöst hat, löste der Start von ChatGPT Ende November 2022 einen KI-Goldrausch aus, der viele KI-Beobachter, darunter auch uns, überraschte. In nur wenigen Monaten haben eine Vielzahl leistungsstarker generativer KI-Modelle dank ihrer bemerkenswerten Fähigkeit, menschliche Sprache und menschliches Verständnis nachzuahmen, die Aufmerksamkeit der Welt auf sich gezogen. Der außergewöhnliche Aufstieg generativer Modelle in der Mainstream-Kultur, der durch das Aufkommen von ChatGPT vorangetrieben wird, wirft viele Fragen darüber auf, wohin das alles führt. Das erstaunliche Phänomen der künstlichen Intelligenz, die fesselnde Poesie und skurrile Kunst hervorbringen kann, weicht der Besorgnis über die negativen Folgen der künstlichen Intelligenz, die von Verbraucherschäden und Arbeitsplatzverlusten bis hin zu Freiheitsstrafen und sogar der Zerstörung der Menschheit reichen.

Das macht einigen Menschen große Sorgen. Letzten Monat beantragte eine Koalition von KI-Forschern ein sechsmonatiges Moratorium für die Entwicklung neuer generativer Modelle, die größer als GPT-4 sind (Weiterführende Literatur: Offener Brief fordert Moratorium für KI-Forschung), GPT-4, das massive Modell, das OpenAI letzten Monat eingeführt hat Sprachmodell (LLM).

Das macht einigen Menschen große Sorgen. Letzten Monat beantragte eine Koalition von KI-Forschern ein sechsmonatiges Moratorium für die Entwicklung neuer generativer Modelle, die größer als GPT-4 sind (Weiterführende Literatur: Offener Brief fordert Moratorium für KI-Forschung), GPT-4, das massive Modell, das OpenAI letzten Monat eingeführt hat Sprachmodell (LLM).

In einem offenen Brief, der vom Turing-Preisträger Yoshua Bengio und OpenAI-Mitbegründer Elon Musk und anderen unterzeichnet wurde, heißt es: „Fortgeschrittene künstliche Intelligenz könnte eine bedeutende Veränderung in der Geschichte von darstellen.“ Tiefgreifende Veränderungen sollten mit angemessener Sorgfalt und Ressourcen geplant und bewältigt werden. „Leider wurde dieses Maß an Planung und Management nicht erreicht.“ Umfragen zeigen, dass die Amerikaner der Meinung sind, dass künstliche Intelligenz nicht vertrauenswürdig ist, und dass sie eine Regulierung wünschen, insbesondere in Bezug auf wirkungsvolle Dinge wie selbstfahrende Autos und den Zugang zu staatlichen Leistungen.

Doch trotz mehrerer neuer lokaler Gesetze, die auf KI abzielen – beispielsweise eines in New York City, das sich auf den Einsatz von KI bei der Einstellung konzentriert, wurden die Durchsetzungsbemühungen bis jetzt verzögert Monat – Der Kongress hat keine neuen Bundesvorschriften, die speziell auf künstliche Intelligenz abzielen, da diese sich der Ziellinie nähert (obwohl KI in stark regulierten Branchen wie Finanzdienstleistungen und Gesundheitswesen Eingang in die Gesetzgebung gefunden hat).

Was sollte ein Unternehmen unter der Stimulation künstlicher Intelligenz tun? Es ist keine Überraschung, dass Unternehmen die Vorteile der künstlichen Intelligenz teilen möchten. Schließlich gilt der Drang, „datengesteuert“ zu werden, als Überlebensnotwendigkeit im digitalen Zeitalter. Allerdings möchten Unternehmen auch die realen oder vermeintlichen negativen Folgen vermeiden, die sich aus einem unsachgemäßen Einsatz von KI ergeben können.

Künstliche Intelligenz ist wild „

西世界“. Andrew Burt, Gründer der Anwaltskanzlei für künstliche Intelligenz BNH.AI, sagte einmal: „Niemand weiß, wie man mit Risiken umgeht Frameworks, die Unternehmen zur Bewältigung von KI-Risiken nutzen können. Burt empfiehlt die Verwendung des Artificial Intelligence Risk Management Framework (

RMF: Risk Management Framework), das vom National Institute of Standards and Technology (NIST) stammt und Anfang dieses Jahres fertiggestellt wurde.

RMF hilft Unternehmen, darüber nachzudenken, wie ihre KI funktioniert und welche möglichen negativen Folgen sie haben kann. Es nutzt den Ansatz „Abbildung, Messung, Verwaltung und Steuerung“, um die Risiken des Einsatzes künstlicher Intelligenz in einer Vielzahl von Serviceangeboten zu verstehen und letztendlich zu mindern.Ein weiteres KI-Risikomanagement-Framework stammt von Cathy O'Neil, CEO von O'Neil Risk Advisory & Algorithmic Audit (ORCAA). ORCAA schlug ein Rahmenwerk namens „

Explainable Fairness“ vor.

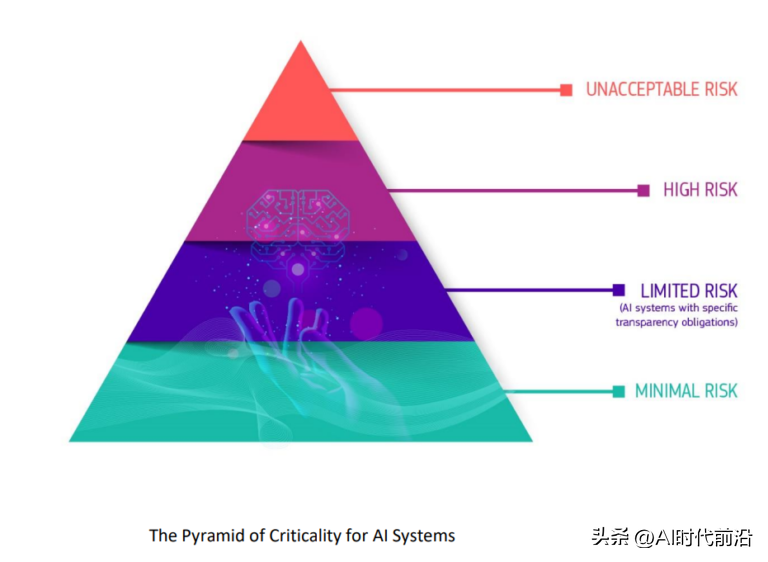

Erklärbare Fairness gibt Unternehmen die Möglichkeit, nicht nur ihre Algorithmen auf Verzerrungen zu testen, sondern auch zu untersuchen, was passiert, wenn Unterschiede in den Ergebnissen festgestellt werden. Wenn eine Bank beispielsweise über die Berechtigung für ein Studiendarlehen entscheidet, welche Faktoren können dann rechtlich herangezogen werden, um das Darlehen zu genehmigen oder abzulehnen oder höhere oder niedrigere Zinsen zu verlangen?Natürlich müssen Banken Daten nutzen, um diese Fragen zu beantworten. Aber welche Daten können sie nutzen – also welche Faktoren spiegeln einen Kreditantragsteller wider? Welche Faktoren sollten gesetzlich zulässig sein und welche nicht? Die Beantwortung dieser Fragen sei weder einfach noch einfach, sagte O'Neil. O'Neil sagte während einer Diskussion auf der Nvidia GPU Technology Conference (GTC) letzten Monat: „Darum geht es bei diesem Rahmenwerk, dass diese rechtlichen Faktoren legalisiert werden müssen.“ Daten Auch ohne Angesichts der neuen KI-Gesetze sollten sich Unternehmen fragen, wie sie KI fair und ethisch implementieren können, um bestehende Gesetze einzuhalten, sagte Triveni Gandhi, Leiterin des Analyse- und KI-Softwareanbieters Dataiku AI. „Die Leute müssen anfangen, darüber nachzudenken, okay, wie können wir die bestehenden Gesetze betrachten und sie auf die derzeit existierenden KI-Anwendungsfälle anwenden?“ „Es gibt einige Vorschriften, aber es wird auch viel darüber nachgedacht.“ was wir künstliche Intelligenz aufbauen wollen Ein ethischer und werteorientierter Ansatz für Intelligenz Das sind tatsächlich die Fragen, die sich Unternehmen stellen, auch ohne übergreifende Vorschriften Die EU stuft die potenziellen Schäden von KI ein eine „Kritikalitätspyramide“ Die EU treibt bereits eine eigene Verordnung voran, das Gesetz über künstliche Intelligenz, das noch in diesem Jahr in Kraft treten könnte. Mit dem Gesetz über künstliche Intelligenz wird ein gemeinsamer regulatorischer und rechtlicher Rahmen für den Einsatz künstlicher Intelligenz geschaffen, der sich auf EU-Bürger auswirkt, einschließlich der Art und Weise, wie KI entwickelt wird, zu welchen Zwecken Unternehmen sie verwenden können und welche Gesetze bei Nichteinhaltung von Anforderungen gelten als Ergebnis. Das Gesetz könnte von Unternehmen verlangen, dass sie in bestimmten Anwendungsfällen eine Genehmigung einholen, bevor sie KI einführen, und bestimmte andere als zu riskant erachtete KI-Anwendungen verbieten.

Das obige ist der detaillierte Inhalt vonSelbstregulierung ist heute der Kontrollstandard für künstliche Intelligenz. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

So verbinden Sie Breitband mit einem Server

So verbinden Sie Breitband mit einem Server

So erstellen Sie einen neuen Ordner in Webstorm

So erstellen Sie einen neuen Ordner in Webstorm

Eine einzelne Word-Seite ändert die Papierausrichtung

Eine einzelne Word-Seite ändert die Papierausrichtung

So reinigen Sie das Laufwerk C, wenn es rot wird

So reinigen Sie das Laufwerk C, wenn es rot wird

So konvertieren Sie PDF in das XML-Format

So konvertieren Sie PDF in das XML-Format

MySQL ändert das Root-Passwort

MySQL ändert das Root-Passwort