Es gibt ein wachsendes Ökosystem von Open-Source-Sprachmodellen, das Einzelpersonen umfassende Ressourcen zur Erstellung von Sprachanwendungen für Forschungs- und kommerzielle Zwecke bietet.

Dieser Artikel befasst sich eingehend mit GPT4ALL, das über spezifische Anwendungsfälle hinausgeht und umfassende Bausteine bereitstellt, die es jedem ermöglichen, ChatGPT-ähnliche Chatbots zu entwickeln.

GPT4ALL kann die gesamte Unterstützung bieten, die bei der Verwendung hochmoderner Open-Source-Modelle für große Sprachen erforderlich ist. Es kann auf Open-Source-Modelle und -Datensätze zugreifen, sie mithilfe des bereitgestellten Codes trainieren und ausführen, über eine Webschnittstelle oder Desktop-Anwendung mit ihnen interagieren, eine Verbindung zum Langchain-Backend für verteiltes Computing herstellen und die Python-API für eine einfache Integration verwenden.

Die Entwickler haben kürzlich den Apache-2-lizenzierten GPT4All-J-Chatbot auf den Markt gebracht, der auf einem großen und kuratierten Korpus von Assistenteninteraktionen trainiert ist, darunter Wortfragen, Gespräche mit mehreren Runden, Code, Gedichte, Lieder und Geschichten. Um es zugänglicher zu machen, veröffentlichten sie außerdem Python-Bindungen und eine Chat-Benutzeroberfläche, sodass fast jeder das Modell auf einer CPU ausführen kann.

Sie können es selbst ausprobieren, indem Sie einen lokalen Chat-Client auf Ihrem Desktop installieren.

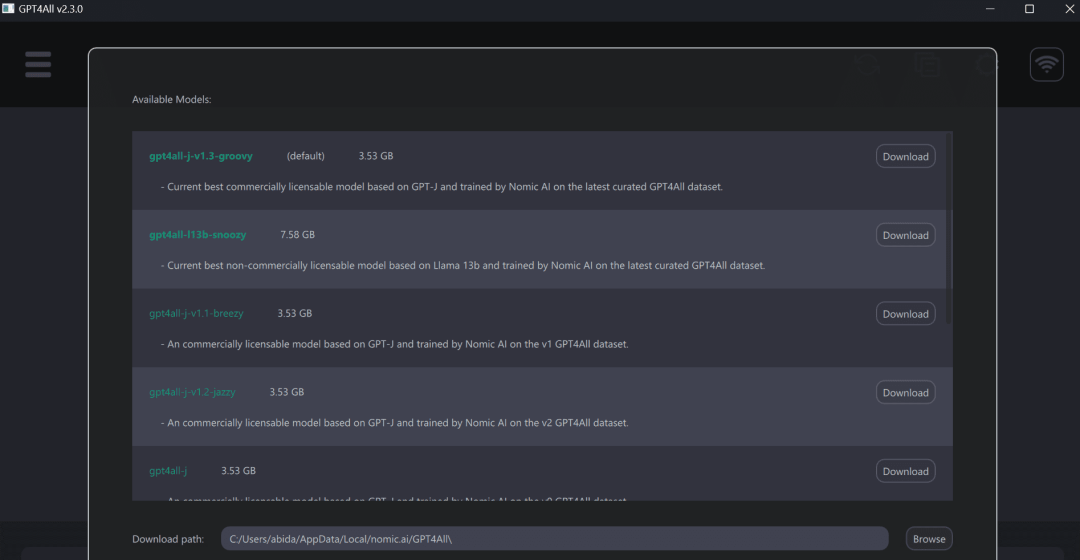

Führen Sie anschließend das GPT4ALL-Programm aus und laden Sie das Modell Ihrer Wahl herunter. Sie können das Modell auch manuell hier herunterladen (https://github.com/nomic-ai/gpt4all-chat#manual-download-of-models) und es an dem Speicherort installieren, der im Modell-Download-Dialogfeld in der GUI angegeben ist.

Die Verwendung von GPT4ALL sorgt für ein besseres Erlebnis auf Laptops und liefert schnelle und genaue Antworten. Auch technisch nicht versierte Personen können GPT4ALL problemlos nutzen, da es sehr benutzerfreundlich ist.

GPT4ALL verfügt über Python, TypeScript, Web-Chat-Schnittstelle und Langchain-Backend.

In diesem Abschnitt betrachten wir die Python-API für den Zugriff auf Modelle mithilfe von nomic-ai/pygpt4all.

<code>pip install pygpt4all</code>

<code>from pygpt4all.models.gpt4all import GPT4Alldef new_text_callback(text):print(text, end="")model = GPT4All("./models/ggml-gpt4all-l13b-snoozy.bin")model.generate("Once upon a time, ", n_predict=55, new_text_callback=new_text_callback)</code>Darüber hinaus können Konverter zum Herunterladen und Ausführen von Inferenzen verwendet werden. Geben Sie einfach den Modellnamen und die Version an. Die Beispiele in diesem Artikel beziehen sich auf das neueste und verbesserte v1.3-groovy-Modell.

<code>from transformers import AutoModelForCausalLMmodel = AutoModelForCausalLM.from_pretrained("nomic-ai/gpt4all-j", revisinotallow="v1.3-groovy")</code>Im nomic-ai/gpt4all-Repository können Sie Quellcode, Modellgewichte, Datensätze und Dokumentation für Training und Inferenz erhalten. Einige Modelle können Sie zunächst ausprobieren und dann über den Python-Client oder LangChain integrieren.

GPT4ALL stellt uns einen CPU-quantifizierten GPT4All-Modellprüfpunkt zur Verfügung. Um darauf zuzugreifen, müssen wir:

Linux: cd chat;./gpt4all-lora-quantized-linux- x86

Sie können auch zu Hugging Face Spaces gehen und die Demo von Gpt4all ausprobieren.

Bilder von Gpt4all

Das obige ist der detaillierte Inhalt vonGPT4ALL: Die ultimative Open-Source-Lösung für große Sprachmodelle. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Antivirus für Apple-Handys

Antivirus für Apple-Handys

Tutorial zum Kauf und Verkauf von Bitcoin auf Huobi.com

Tutorial zum Kauf und Verkauf von Bitcoin auf Huobi.com

Was bedeutet das Formatieren eines Mobiltelefons?

Was bedeutet das Formatieren eines Mobiltelefons?

Was sind die Python-Bibliotheken für künstliche Intelligenz?

Was sind die Python-Bibliotheken für künstliche Intelligenz?

MySQL-Ausnahmelösung

MySQL-Ausnahmelösung

Welches Format ist m4a?

Welches Format ist m4a?

Zusammenfassung der Java-Grundkenntnisse

Zusammenfassung der Java-Grundkenntnisse

Fehlerberichtslösung für den MySQL-Import einer SQL-Datei

Fehlerberichtslösung für den MySQL-Import einer SQL-Datei