Ich habe kürzlich eine sehr zufriedenstellende Arbeit fertiggestellt. Der gesamte Prozess war nicht nur angenehm und einprägsam, sondern er hat auch wirklich „wissenschaftliche Wirkung und industrielle Leistung“ erzielt. Ich glaube, dass dieser Artikel das Paradigma des Differential Privacy (DP) Deep Learning verändern wird.

Weil diese Erfahrung zu „zufällig“ ist (der Prozess ist voller Zufälle und die Schlussfolgerung äußerst clever), möchte ich meine Erfahrungen aus Beobachtung –> Konzeption –> empirische Beweise – mit meinen Klassenkameraden teilen. -> Theorie -> Kompletter Prozess für Großversuche. Ich werde versuchen, diesen Artikel kurz zu halten und nicht zu viele technische Details einzubeziehen.

Papieradresse: arxiv.org/abs/2206.07136

weicht von der im Papier dargestellten Reihenfolge ab. Das Papier stellt den Schluss manchmal bewusst an den Anfang, um Leser anzulocken, oder stellt ihn vor Ich werde zunächst den vollständigen Satz in den Anhang einfügen. In diesem Artikel möchte ich meine Erfahrungen in chronologischer Reihenfolge (das heißt in einer fortlaufenden Darstellung) aufschreiben, z Forschung, für diejenigen, die gerade erst den Weg der wissenschaftlichen Forschung eingeschlagen haben.

Der Ursprung der Sache ist ein Artikel aus Stanford, der jetzt im ICLR erfasst wurde:

Papieradresse: https://arxiv.org/abs/ 2110.05679

Der Artikel ist sehr gut geschrieben. Zusammenfassend hat er drei Hauptbeiträge:

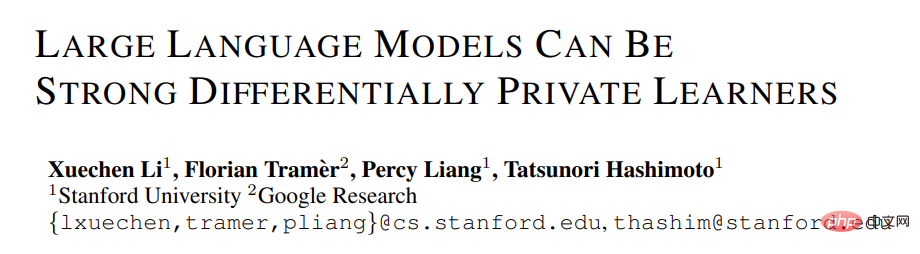

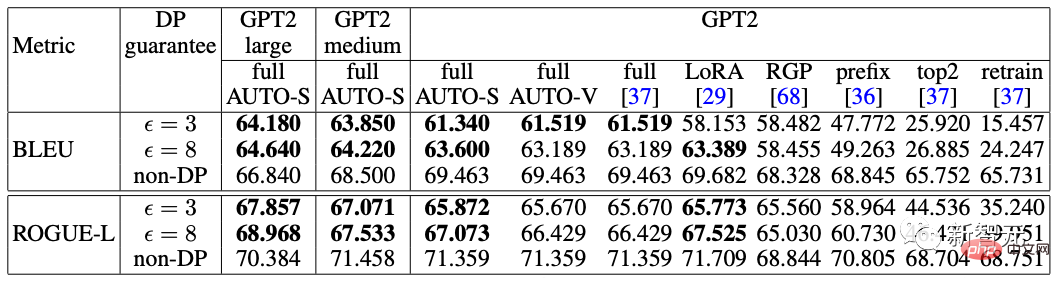

1 Bei NLP-Aufgaben ist die Genauigkeit des DP-Modells sehr hoch, was die Anwendung von Privatsphäre in der Sprache fördert Modelle. (Im Gegensatz dazu führt DP in CV zu einer sehr großen Verschlechterung der Genauigkeit. Beispielsweise hat CIFAR10 derzeit eine Genauigkeit von 80 % ohne vorheriges Training unter der DP-Grenze, kann aber ohne Berücksichtigung von DP problemlos 95 % erreichen; ImageNets derzeit beste DP-Genauigkeit war weniger als 50 %.

2. Je größer das Modell, desto besser ist die Leistung. Beispielsweise ist die Leistungsverbesserung von GPT2 von 400 Millionen Parametern auf 800 Millionen Parameter offensichtlich und es wurden auch viele SOTAs erreicht. (Aber in CV- und Empfehlungssystemen ist die Leistung größerer Modelle in vielen Fällen sehr schlecht und kommt sogar einer zufälligen Schätzung nahe. Beispielsweise wurde die beste DP-Genauigkeit von CIFAR10 zuvor durch vierschichtiges CNN und nicht durch ResNet erzielt.)

Bei NLP-Aufgaben gilt: Je größer das DP-Modell, desto besser die Leistung [Xuechen et al. 2021]

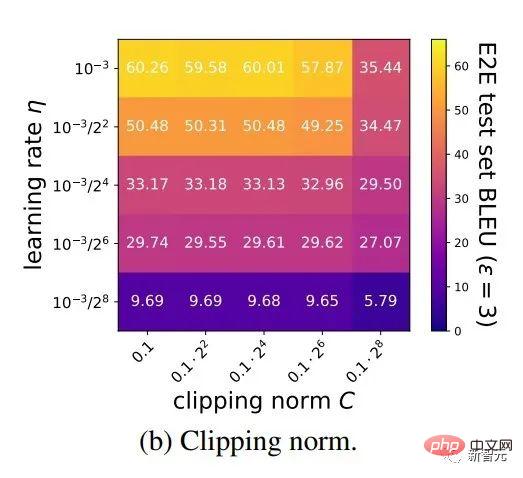

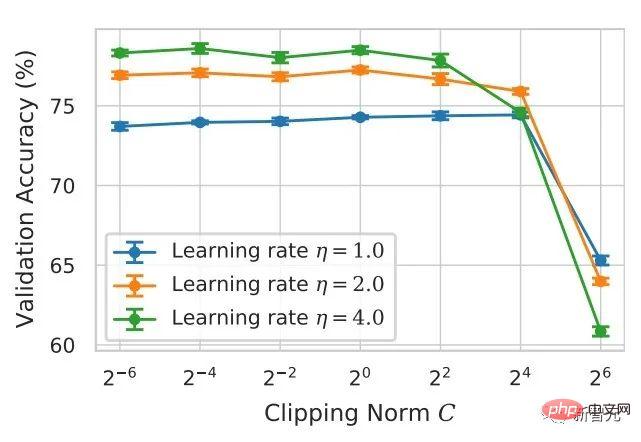

3. Die Hyperparameter zum Erhalten von SOTA bei mehreren Aufgaben sind konsistent: Der Clipping-Schwellenwert muss klein genug eingestellt werden und die Lernrate muss größer sein. (In allen vorherigen Artikeln wurde für jede Aufgabe ein Beschneidungsschwellenwert angepasst, was zeitaufwändig und arbeitsintensiv war. Es gab noch nie einen Beschneidungsschwellenwert von 0,1 wie diesen, der alle Aufgaben durchläuft, und die Leistung ist so gut.)

Die obige Zusammenfassung ist das, was ich gelesen habe, nachdem ich den Artikel gelesen hatte. Ich habe ihn sofort verstanden. Der Inhalt in Klammern stammt nicht aus diesem Artikel, sondern ist der Eindruck, der durch viele frühere Lektüren entstanden ist. Dies beruht auf einer langfristigen Leseakkumulation und einem hohen Grad an Generalisierungsfähigkeit, um schnell Assoziationen und Vergleiche zu ermöglichen.

Tatsächlich fällt es vielen Studierenden schwer, mit dem Schreiben von Artikeln zu beginnen, da sie nur den Inhalt eines Artikels sehen und kein Netzwerk bilden oder Assoziationen zu Wissenspunkten im gesamten Fachgebiet herstellen können. Einerseits lesen Studierende, die gerade erst anfangen, zu wenig und beherrschen noch nicht genügend Wissenspunkte. Dies gilt insbesondere für Studierende, die schon seit langem Projekte von Lehrern übernehmen und diese nicht selbstständig vorschlagen. Andererseits ist der Umfang der Lektüre zwar ausreichend, wird jedoch nicht von Zeit zu Zeit zusammengefasst, was dazu führt, dass die Informationen nicht zu Wissen verdichtet werden oder das Wissen nicht verknüpft wird.

Hier ist das Hintergrundwissen zum DP Deep Learning. Ich werde die Definition von DP vorerst überspringen und es wird keinen Einfluss auf das Lesen haben.

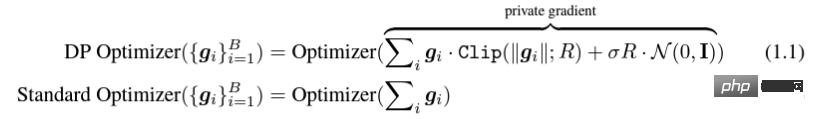

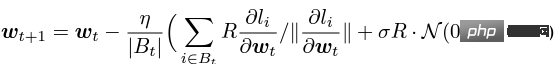

Das sogenannte DP-Deep-Learning bedeutet aus algorithmischer Sicht tatsächlich zwei zusätzliche Schritte: Gradientenbeschneidung pro Stichprobe und Gaußsche Rauschaddition; mit anderen Worten, solange Sie diese beiden Schritte befolgen für Farbverlauf Nach der Verarbeitung (der verarbeitete Farbverlauf wird als privater Farbverlauf bezeichnet) können Sie den Optimierer nach Belieben verwenden, einschließlich SGD/Adam.

Die Frage, wie privat der endgültige Algorithmus ist, ist eine Frage in einem anderen Untergebiet, der sogenannten Datenschutzbuchhaltungstheorie. Dieses Gebiet ist relativ ausgereift und erfordert eine starke theoretische Grundlage. Da sich dieser Artikel auf die Optimierung konzentriert, wird er hier nicht erwähnt.

g_i ist der Gradient eines Datenpunkts (Pro-Sample-Gradient), R ist der Clipping-Schwellenwert, Sigma ist Rauschmultiplikator.

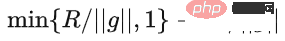

Clip wird als Clipping-Funktion bezeichnet, genau wie beim normalen Verlaufsclipping. Wenn der Verlauf länger als R ist, wird er auf R geschnitten, und wenn er kürzer als R ist , es wird sich nicht bewegen.

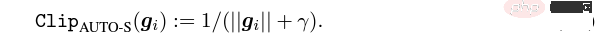

Zum Beispiel ist die DP-Version von SGD die Pionierarbeit des Privacy Deep Learning, die in allen aktuellen Arbeiten verwendet wird (Abadi, Martin, et al. „Deep Learning mit differenzierter Privatsphäre."), auch bekannt als Abadis Ausschnitt:  .

.

Aber das ist völlig unnötig. Nach den ersten Prinzipien und ausgehend von der Theorie der Datenschutzbuchhaltung muss die Clipping-Funktion tatsächlich nur das Modell von Clip(g_i) erfüllen. *g_i Kleiner oder gleich R ist in Ordnung. Mit anderen Worten: Abadis Clipping ist nur eine Funktion, die diese Bedingung erfüllt, aber keineswegs die einzige.

Es gibt viele leuchtende Punkte in einem Artikel, aber nicht alle davon können von mir verwendet werden mit meinen eigenen Bedürfnissen in Einklang gebracht werden und gut darin sein, zu beurteilen, was Ihr größter Beitrag ist.

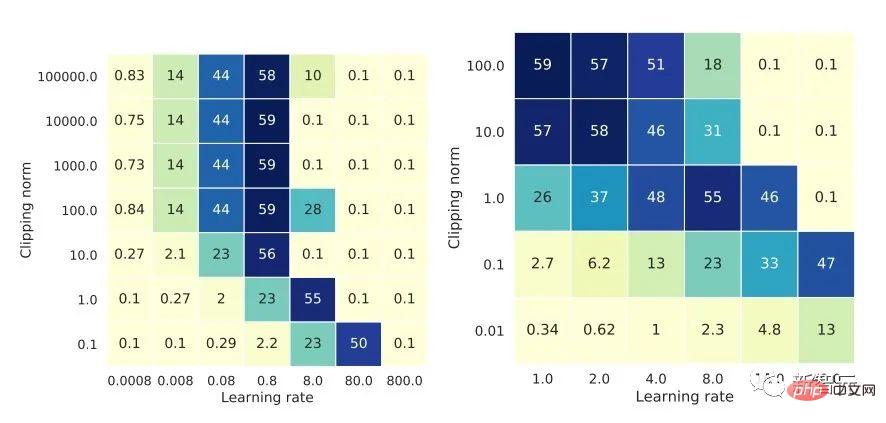

Die ersten beiden Beiträge dieses Artikels sind eigentlich sehr empirisch und schwer zu verstehen. Der letzte Beitrag ist sehr interessant. Ich habe mir die Ablationsstudie zu Hyperparametern genau angesehen und einen Punkt gefunden, den der ursprüngliche Autor nicht entdeckt hat: Wenn die Beschneidungsschwelle klein genug ist, ist die Beschneidungsschwelle (d. h. die Beschneidungsnorm C) sehr hoch , in der obigen Formel und R ist eine Variable) hat keine Auswirkung.

Längsansicht C=0,1, 0,4, 1,6 macht für DP-Adam keinen Unterschied [Xuechen et al. 2021].

Das hat mein Interesse geweckt und ich hatte das Gefühl, dass dahinter ein Prinzip stecken muss. Also habe ich den DP-Adam handgeschrieben, um zu sehen, warum. Es ist eigentlich ganz einfach:

Wenn R Klein genug, das Ausschneiden entspricht tatsächlich einer Normalisierung! Durch einfaches Ersetzen des privaten Gradienten (1.1) kann R aus dem Clipping-Teil bzw. dem Rauschteil extrahiert werden: #Und die Form von Adam lässt R sowohl im Gradienten als auch in der adaptiven Schrittgröße erscheinen, sobald sich Zähler und Nenner aufheben, R wird weg sein, und die Idee wird da sein!

Sowohl m als auch v hängen vom Gradienten ab, und das Ersetzen durch private Gradienten führt zu DP-AdamW.

Eine so einfache Substitution beweist meinen ersten Satz: In DP-AdamW schließen sich ausreichend kleine Begrenzungsschwellen gegenseitig aus Äquivalent, keine Anpassung erforderlich Parameter. Es besteht kein Zweifel, dass dies eine sehr prägnante und interessante Beobachtung ist, aber sie macht nicht genug Sinn, also muss ich darüber nachdenken, was diese Beobachtung in der Praxis hat verwenden.

Tatsächlich bedeutet dies, dass das DP-Training die Parameteranpassungsarbeit um eine Größenordnung reduziert: Unter der Annahme, dass die Lernrate und R auf jeweils 5 Werte angepasst werden (wie in der Abbildung oben gezeigt), dann 25 Kombinationen muss getestet werden, um die optimalen Hyperparameter zu finden. Jetzt müssen Sie die Lernrate nur noch auf 5 Möglichkeiten anpassen, und die Parameteranpassungseffizienz wurde mehrfach verbessert. Dies ist ein sehr wertvolles Problem für die Branche.

Die Absicht ist hoch genug, die Mathematik ist prägnant genug und eine gute Idee nimmt langsam Gestalt an.

Wenn es nur für Adam/AdamW gilt, sind die Einschränkungen dieser Arbeit immer noch zu groß, also habe ich sie schnell auf AdamW und andere adaptive Optimierer wie AdaGrad ausgeweitet. Tatsächlich kann für alle adaptiven Optimierer nachgewiesen werden, dass der Beschneidungsschwellenwert versetzt wird, sodass keine Parameteranpassung erforderlich ist, was die Fülle des Theorems erheblich erhöht.

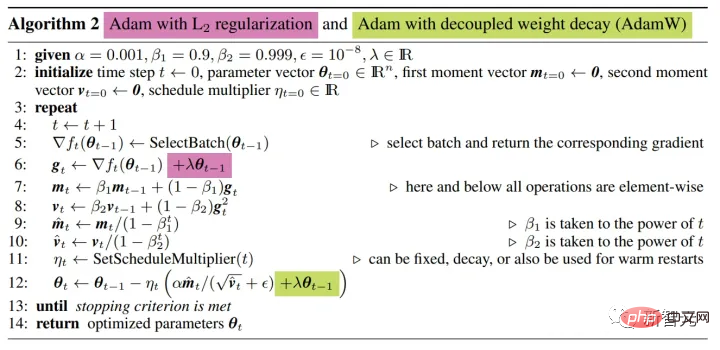

Hier gibt es noch ein weiteres interessantes kleines Detail. Wie wir alle wissen, unterscheidet sich Adam mit Gewichtsabnahme von AdamW. Letzterer verwendet auch einen Artikel über diesen Unterschied. Adam hat zwei Möglichkeiten, Gewichtsabnahme hinzuzufügen.

Eine andere Sache

Kluge Studenten haben vielleicht herausgefunden, dass ich immer wieder über SGD spreche. Die Antwort ist, dass ich schnell die Theorie des DP-Adaptivoptimierers geschrieben habe Dann habe ich einen Artikel über die Verwendung von DP-SGD im Lebenslauf gepostet und eine Ablationsstudie durchgeführt, aber die Regeln waren völlig anders als die bei Adam, was bei mir einen diagonalen Eindruck über DP-SGD und hinterlassen hat Wenn R klein genug ist, entspricht eine Erhöhung von lr um das Zehnfache einer Erhöhung von R um das Zehnfache [https://arxiv.org/abs/2201.12328].

In der wissenschaftlichen Welt stecken hinter aufeinanderfolgenden Zufällen oft versteckte Regeln.

Offensichtlich kann R erneut vorgeschlagen und mit der Lernrate kombiniert werden, was theoretisch bewiesen ist Google-Beobachtungen.

「Insbesondere wenn die Clipping-Norm k-mal verringert wird, sollte die Lernrate k-mal erhöht werden, um eine ähnliche Genauigkeit beizubehalten.」

Es ist schade, dass Google das Phänomen nur erkannt und sich nicht darauf eingelassen hat Niveau der Theorie. Auch hier gibt es einen Zufall, das heißt, sie haben im obigen Bild eine Ablationsstudie von zwei Skalen gleichzeitig gezeichnet. Nur die linke Skala kann die diagonale Linie erkennen. Allein der Blick auf die rechte Seite lässt keine Schlussfolgerung zu.

Da es keine adaptive Schrittgröße gibt, ignoriert SGD R nicht wie Adam, sondern betrachtet R als Teil der Lernrate, sodass es nicht erforderlich ist, es separat anzupassen Parameter angepasst werden.

Erweitern Sie dann die SGD-Theorie auf Momentum, und alle von Pytorch unterstützten Optimierer wurden analysiert.

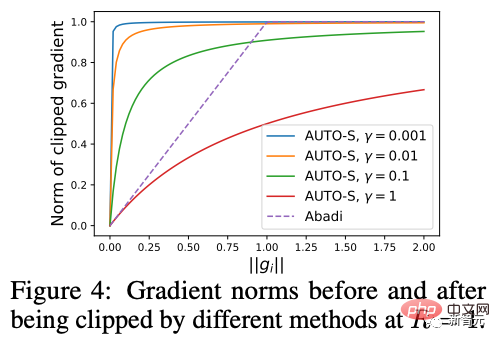

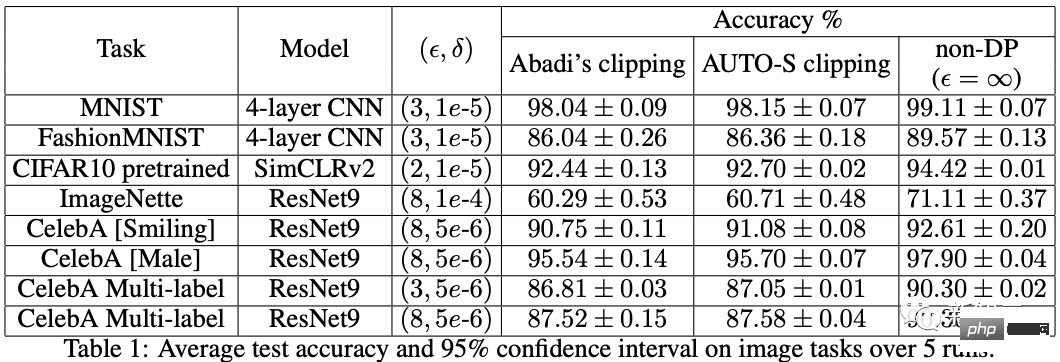

5. Von der Intuition zur Strenge

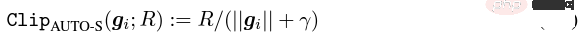

Ein innovativer Punkt ist vorhanden, aber streng genommen ist Abadis Ausschnitt nur eine ungefähre Normalisierung und kann nicht ausgeglichen werden, sodass die Konvergenz nicht abschließend analysiert werden kann.Nach dem Prinzip von Doraemons Iron Man Corps habe ich Normalisierung direkt als neue Gradienten-Clipping-Funktion pro Probe bezeichnet, die das Abadi-Clipping ersetzt, das seit 6 Jahren im gesamten Bereich verwendet wird. Nach dem Beweis gerade jetzt erfordert das neue Clipping grundsätzlich kein R, daher wird es als automatisches Clipping (AUTO-V; V für Vanille) bezeichnet. Da sich die Form von Abadis Ausschnitt unterscheidet, ist die Genauigkeit unterschiedlich und mein Ausschnitt kann Nachteile haben. Ich muss also Code schreiben, um meine neue Methode zu testen, und dafür muss nur eine Codezeile geändert werden (schließlich ist es nur Tatsächlich gibt es neben Abadis Clipping hauptsächlich drei Clipping-Funktionen in Richtung DP pro Sample. Eine davon ist das globale Clipping und die andere ist dieses automatische Clipping. In meiner vorherigen Arbeit wusste ich bereits, wie man Ausschnitte in verschiedenen gängigen Bibliotheken ändert. Die Änderungsmethode habe ich im Anhang am Ende des Artikels aufgeführt. Nach meinen Tests habe ich festgestellt, dass im Stanford-Artikel während des gesamten Trainingsprozesses von GPT2 alle Iterationen und alle Verläufe pro Stichprobe abgeschnitten werden. Mit anderen Worten: Zumindest in diesem Experiment entspricht Abadis Clipping vollständig dem automatischen Clipping. Obwohl spätere Experimente gegenüber SOTA verloren haben, hat dies gezeigt, dass meine neue Methode genug Wert hat: eine Clipping-Funktion, die den Clipping-Schwellenwert nicht anpassen muss, und manchmal wird die Genauigkeit nicht geopfert. Stanfords Artikel befasst sich mit zwei Haupttypen von Sprachmodellexperimenten: Eine ist die generative Aufgabe, bei der GPT2 das Modell ist, und die andere ist die Klassifizierungsaufgabe, bei der RoBERTa das Modell ist. Obwohl das automatische Clipping dem Clipping von Abadi bei Generierungsaufgaben entspricht, ist die Genauigkeit bei Klassifizierungsaufgaben immer um einige Punkte schlechter. Aufgrund meiner eigenen akademischen Gewohnheiten werde ich den Datensatz zu diesem Zeitpunkt nicht ändern und dann unsere dominanten Experimente zur Veröffentlichung auswählen, geschweige denn Tricks hinzufügen (wie Datenverbesserung und Änderung magischer Modelle). Ich hoffe, dass ich in einem völlig fairen Vergleich nur den Farbverlaufsausschnitt pro Probe vergleichen und den bestmöglichen feuchtigkeitsfreien Effekt erzielen kann. Tatsächlich haben wir in Gesprächen mit Mitarbeitern festgestellt, dass die reine Normalisierung und das Abadi-Clipping die Informationen zur Verlaufsgröße vollständig verwerfen. Das heißt, für das automatische Abschneiden gilt, dass das Abschneiden unabhängig von der Größe des ursprünglichen Verlaufs R ist groß, und Abadi behält Größeninformationen für Farbverläufe, die kleiner als R sind. Basierend auf dieser Idee haben wir eine kleine, aber äußerst clevere Änderung vorgenommen, genannt AUTO-S-Clipping (S steht für stabil) Die Verschmelzung von R und Lernrate wird zu Eine einfache Zeichnung kann zeigen, dass dieser kleine Wert (normalerweise auf 0,01 eingestellt, tatsächlich kann er auf jede andere positive Zahl eingestellt werden, sehr robust) die Informationen zur Gradientengröße behalten kann: Basierend darauf Algorithmus oder ändern Sie einfach eine Zeile, führen Sie den Stanford-Code erneut aus und Sie erhalten die SOTA von sechs NLP-Datensätzen. AUTO-S übertrifft alle anderen Clipping-Funktionen bei der E2E-Generierungsaufgabe sowie bei der SST2/MNLI/QNLI/QQP-Klassifizierungsaufgabe. Eine Einschränkung des Stanford-Artikels besteht darin, dass er sich nur auf NLP konzentriert. Ein Zufall ist, dass Googles Tochtergesellschaft DeepMind zwei Monate, nachdem er ImageNets DP SOTA gestrichen hat, einen Artikel veröffentlicht hat, in dem DP glänzt CV erhöht direkt die ImageNet-Genauigkeit von 48 % auf 84 %! Papieradresse: https://arxiv.org/abs/2204.13650 In diesem Artikel habe ich mich zunächst mit der Auswahl des Optimierers und der Beschneidungsschwelle befasst, bis ich mich im Anhang diesem Bild zuwende : DP-SGDs SOTA auf ImageNet erfordert außerdem, dass der Beschneidungsschwellenwert klein genug ist. Dennoch funktioniert die kleine Clipping-Schwelle am besten! Mit drei hochwertigen Artikeln, die das automatische Clipping unterstützen, bin ich bereits stark motiviert und bin mir immer sicherer, dass meine Arbeit herausragend sein wird. Zufälligerweise ist dieser Artikel von DeepMind auch ein reines Experiment ohne Theorie, was auch dazu geführt hat, dass sie fast erkannt haben, dass sie R theoretisch nicht brauchen können. Tatsächlich sind sie meiner Idee wirklich sehr nahe, und das haben sie sogar Es wurde bereits festgestellt, dass R extrahiert und in die Lernrate integriert werden kann (interessierte Schüler können sich ihre Formeln (2) und (3) ansehen). Aber die Trägheit von Abadis Ausschnitt war zu groß ... Obwohl sie die Regeln herausgefunden hatten, gingen sie nicht weiter. DeepMind hat auch herausgefunden, dass eine kleine Clipping-Schwelle am besten funktioniert, verstand aber nicht, warum. Inspiriert von dieser neuen Arbeit begann ich mit CV zu experimentieren, damit mein Algorithmus von allen DP-Forschern verwendet werden kann, anstatt einen Methodensatz für NLP und einen anderen für CV zu verwenden. Ein guter Algorithmus sollte universell und einfach zu verwenden sein. Fakten haben auch gezeigt, dass automatisches Clipping auch SOTA für CV-Datensätze erreichen kann. Bei Betrachtung aller oben genannten Papiere wurde SOTA erheblich verbessert und die technischen Auswirkungen sind voll, aber die Theorie ist völlig leer. Als ich alle Experimente abgeschlossen habe, hat der Beitrag dieser Arbeit die Anforderungen einer Top-Konferenz übertroffen: Ich habe die Parameterauswirkungen von DP-SGD und DP-Adam, die durch kleine Clipping-Schwellen in der Erfahrung verursacht werden, stark vereinfacht Die Clipping-Funktion hat keine Einbußen bei der Recheneffizienz, beim Datenschutz und ohne kleine γ-Reparaturen, die durch Abadis Clipping- und Normalisierungsexperimente eine ausreichende SOTA-Genauigkeit erreicht haben. Ich bin noch nicht zufrieden. Ein Optimierer ohne theoretische Unterstützung ist immer noch nicht in der Lage, einen wesentlichen Beitrag zum Deep Learning zu leisten. Jedes Jahr werden Dutzende neuer Optimierer vorgeschlagen, und alle werden im zweiten Jahr verworfen. Es gibt noch immer nur wenige, die offiziell von Pytorch unterstützt und tatsächlich von der Industrie genutzt werden. Aus diesem Grund verbrachten meine Mitarbeiter und ich zusätzliche zwei Monate mit der automatischen DP-SGD-Konvergenzanalyse. Der Prozess war schwierig, aber der endgültige Beweis wurde extrem vereinfacht. Die Schlussfolgerung ist ebenfalls sehr einfach: Der Einfluss von Stapelgröße, Lernrate, Modellgröße, Stichprobengröße und anderen Variablen auf die Konvergenz wird quantitativ ausgedrückt und stimmt mit allen bekannten DP-Trainingsverhalten überein. Insbesondere haben wir bewiesen, dass DP-SGD zwar langsamer konvergiert als Standard-SGD, die Konvergenzgeschwindigkeit jedoch eine Größenordnung beträgt, wenn die Iteration gegen unendlich tendiert. Dies schafft Vertrauen in die Datenschutzberechnung: Das DP-Modell konvergiert, wenn auch spät. Endlich ist der Artikel, den ich seit 7 Monaten schreibe, fertig. Unerwarteterweise haben die Zufälle noch nicht aufgehört. NeurIPS reichte das Papier im Mai ein und die internen Änderungen wurden am 14. Juni abgeschlossen und an arXiv veröffentlicht. Als Ergebnis sah ich, dass Microsoft Research Asia (MSRA) einen Artikel veröffentlichte, der mit unserem vorgeschlagenen Ausschnitt kollidierte genau das gleiche wie unser automatisches Clipping: Genau das gleiche wie unser AUTO-S. Bei genauem Hinsehen ist sogar der Konvergenzbeweis fast derselbe. Und die beiden Gruppen von uns haben keinen Schnittpunkt. Man kann sagen, dass ein Zufall auf der anderen Seite des Pazifischen Ozeans entstanden ist. Lassen Sie uns ein wenig über den Unterschied zwischen den beiden Artikeln sprechen: Der andere Artikel ist eher theoretisch und analysiert beispielsweise zusätzlich die Konvergenz von Abadi DP-SGD (ich habe nur das automatische Clipping bewiesen, bei dem es sich um DP-NSGD handelt). ihr Artikel, vielleicht weiß ich auch nicht, wie man DP-SGD anpasst); die verwendeten Annahmen sind auch etwas anders und unsere Experimente sind größer (mehr als ein Dutzend Datensätze) und die Äquivalenzbeziehung zwischen Abadis Ausschnitt und die Normalisierung wird expliziter etabliert, wie Satz 1 und 2 erklären, warum R ohne Parameteranpassung verwendet werden kann. Da wir gleichzeitig arbeiten, freue ich mich sehr, dass es Menschen gibt, die einer Meinung sind und sich gegenseitig ergänzen und diesen Algorithmus gemeinsam vorantreiben können, sodass die gesamte Community an dieses Ergebnis glauben und davon profitieren kann es so schnell wie möglich. Selbstsüchtig erinnere ich mich natürlich auch daran, dass der nächste Artikel beschleunigt wird! Wenn ich auf den kreativen Prozess dieses Artikels zurückblicke, müssen von Anfang an Grundkenntnisse die Voraussetzung sein, und eine weitere wichtige Voraussetzung ist, dass ich schon immer vom Schmerzpunkt der Parameteranpassung besessen war. Es war eine lange Dürreperiode, daher kann Ihnen die Lektüre des richtigen Artikels dabei helfen, Nektar zu finden. Was den Prozess betrifft, liegt der Kern in der Gewohnheit, Beobachtungen mathematisch zu theoretisieren. In dieser Arbeit ist die Fähigkeit, Code zu implementieren, nicht das Wichtigste. Ich werde eine weitere Kolumne schreiben, die sich auf eine weitere Kern-Codierungsarbeit konzentriert; die abschließende Konvergenzanalyse hängt auch von meinen Mitarbeitern und meiner eigenen Beharrlichkeit ab. Glücklicherweise haben Sie keine Angst davor, zu spät zu einem guten Essen zu kommen, also machen Sie weiter!  ).

). 6. Rückkehr zum abstrakten Denken

7. Erstellen Sie einen allgemeinen Algorithmus

8. Die Theorie ist der Knochen und das Experiment ist der Flügel

9. Autounfall...

10. Zusammenfassung

Das obige ist der detaillierte Inhalt vonPenn Machine Learning PhD: Wie habe ich von Grund auf eine erstklassige Arbeit geschrieben?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!