Die Liste der beliebtesten KI-Forschung im Juli ist da!

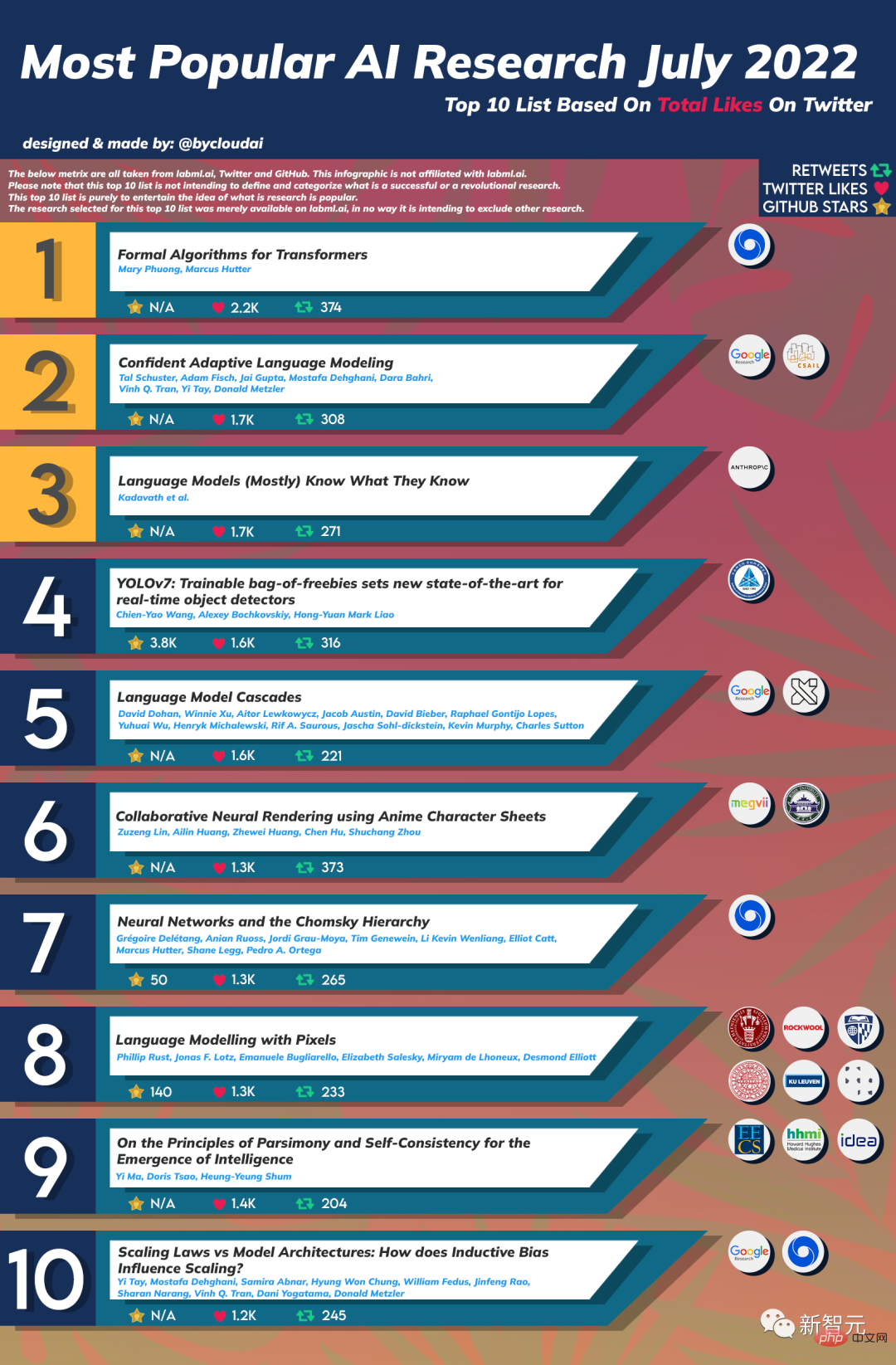

Diese vom Reddit-Benutzer @bycloudai zusammengestellte Liste listet die zehn besten KI-Forschungen im Juli 2022 auf, basierend auf Twitter-Likes, Retweets und Github-Stars, darunter DeepMind, bekannte Institutionen wie Google und MIT CSAIL.

Werfen wir einen Blick darauf, wer die Großen auf der Liste sind~

Institutionen: Google, MIT CSAIL

Zusammenfassung: Die jüngsten Fortschritte bei Transformer-basierten großen Sprachmodellen (LLMs) haben viele Aufgaben vorangetrieben Die Leistung wird deutlich verbessert. Doch während sich die Leistung verbessert, nimmt auch die Modellgröße dramatisch zu, was zu komplexen Inferenzprozessen und höheren Kosten führen kann. In der Praxis erzeugen große Sprachmodelle jedoch eine Reihe von Iterationen mit unterschiedlichen Schwierigkeitsgraden.

Zusammenfassung: Die jüngsten Fortschritte bei Transformer-basierten großen Sprachmodellen (LLMs) haben viele Aufgaben vorangetrieben Die Leistung wird deutlich verbessert. Doch während sich die Leistung verbessert, nimmt auch die Modellgröße dramatisch zu, was zu komplexen Inferenzprozessen und höheren Kosten führen kann. In der Praxis erzeugen große Sprachmodelle jedoch eine Reihe von Iterationen mit unterschiedlichen Schwierigkeitsgraden.

In dieser Arbeit stellen wir Confident Adaptive Language Modeling (CALM) vor, ein Framework, das dynamisch unterschiedliche Mengen an Computereingaben und Generierungsdauer zuweist.

Die frühe Exit-Dekodierung beinhaltet mehrere Probleme, die wir hier ansprechen, wie zum Beispiel: (1) welches Konfidenzmaß zu verwenden ist; (2) Verknüpfung von Einschränkungen auf Sequenzebene mit Exit-Entscheidungen für lokale Token; Versteckte Darstellungen gehen aufgrund der vorzeitigen Ausgabe früherer Token verloren. Durch theoretische Analysen und Experimente zu drei verschiedenen Textgenerierungsaufgaben demonstrieren wir die Wirksamkeit unseres Frameworks bei der Reduzierung des Rechenaufwands – potenziell bis zu einer Verdreifachung der Geschwindigkeit bei gleichzeitig hoher Leistung.

Top3: Sprachmodelle wissen (meistens), was sie wissen

Zusammenfassung: In diesem Artikel wird untersucht, ob Sprachmodelle die Gültigkeit ihrer eigenen Behauptungen beurteilen und vorhersagen können, welche Fragen sie beantworten können korrekt. Wir zeigen zunächst, dass größere Modelle, wenn sie im richtigen Format bereitgestellt werden, gut auf eine Vielzahl von Multiple-Choice- und Richtig/Falsch-Fragen abgestimmt sind. Daher können wir die offene Stichprobenaufgabe selbst bewerten, indem wir das Modell bitten, zunächst eine Antwort vorzuschlagen und dann die Wahrscheinlichkeit P(True) zu bewerten, dass seine Antwort richtig ist.

Top5: Sprachmodellkaskaden#🎜🎜 # Autoren: David Dohan, Winnie : Kollaboratives neuronales Rendering mit AnimeCharacter Sheets

Autoren: David Dohan, Winnie : Kollaboratives neuronales Rendering mit AnimeCharacter Sheets

Top7: Neuronale Netze und die Chomsky-Hierarchie

Autor: Grégoire Delétang, Anian Ruoss, Jordi Grau-Moya, Tim Genewein usw.

Institution: DeepMind, Jonas F. Lotz, Emanuele Bugliarello usw.

Top9: Über die Prinzipien der Sparsamkeit und Selbstkonsistenz für die Entstehung von Intelligenz

Institution: University of California, Berkeley Branch Branch, Guangdong-Hong Kong-Macao Greater Bay Area Digital Economy Research Institute

Institution: University of California, Berkeley Branch Branch, Guangdong-Hong Kong-Macao Greater Bay Area Digital Economy Research Institute  Top10: Skalierungsgesetze vs. Modellarchitekturen: Wie beeinflusst induktive Verzerrung die Skalierung? Google, DeepMind

Top10: Skalierungsgesetze vs. Modellarchitekturen: Wie beeinflusst induktive Verzerrung die Skalierung? Google, DeepMind

Da NUWA Infinity bereits im November 2021 seine erste Version veröffentlichte, zählt diese Liste nur die Anzahl der Likes der darauffolgenden zweiten Version, also nur Rang 12.

Das obige ist der detaillierte Inhalt vonDie beliebteste KI-Forschungsliste für Juli wird veröffentlicht, wobei Ma Yis neuestes „Standardmodell' den neunten Platz belegt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So fangen Sie Zeichenfolgen in der Shell ab

So fangen Sie Zeichenfolgen in der Shell ab

Vollständige Sammlung von SQL-Abfrageanweisungen

Vollständige Sammlung von SQL-Abfrageanweisungen

Window.setInterval()-Methode

Window.setInterval()-Methode

So heben Sie Bargeld bei Yiouokex ab

So heben Sie Bargeld bei Yiouokex ab

Lösung für fehlende xlive.dll

Lösung für fehlende xlive.dll

So verwenden Sie das HttpCanary-Paketerfassungstool

So verwenden Sie das HttpCanary-Paketerfassungstool

Was ist der Unterschied zwischen Golang und Python?

Was ist der Unterschied zwischen Golang und Python?

Zellsumme

Zellsumme