Datenbestände sind zu einem wichtigen Werkzeug bei der Produkt- und Servicegestaltung geworden, aber die zentralisierte Erfassung von Benutzerdaten gefährdet die Privatsphäre, was wiederum Unternehmen rechtlichen Risiken aussetzt. Ab 2016 begann man zu erforschen, wie man Eigentum und Herkunft von Daten unter Wahrung der Privatsphäre der Benutzer nutzen kann, was föderiertes Lernen und föderierte Analysen zu einem Brennpunkt der Besorgnis machte. Da der Umfang der Forschung immer weiter zunimmt, wird föderiertes Lernen zunehmend auf breitere Bereiche wie das Internet der Dinge angewendet.

Was ist also föderiertes Lernen?

Federated Learning ist eine Einrichtung für maschinelles Lernen, bei der mehrere Einheiten zusammenarbeiten, um maschinelle Lernprobleme unter der Koordination eines zentralen Servers oder Dienstanbieters zu lösen. Rohdaten werden für jeden Kunden lokal gespeichert und nicht ausgetauscht oder übertragen. Stattdessen werden gezielte Datenaktualisierungen zur sofortigen Aggregation verwendet, um Lernziele zu erreichen.

In ähnlicher Weise wird die Generierung analytischer Erkenntnisse aus den kombinierten Informationen verteilter Datensätze als föderierte Analyse bezeichnet. Die beim föderierten Lernen auftretenden Szenarien gelten auch für die föderierte Analyse.

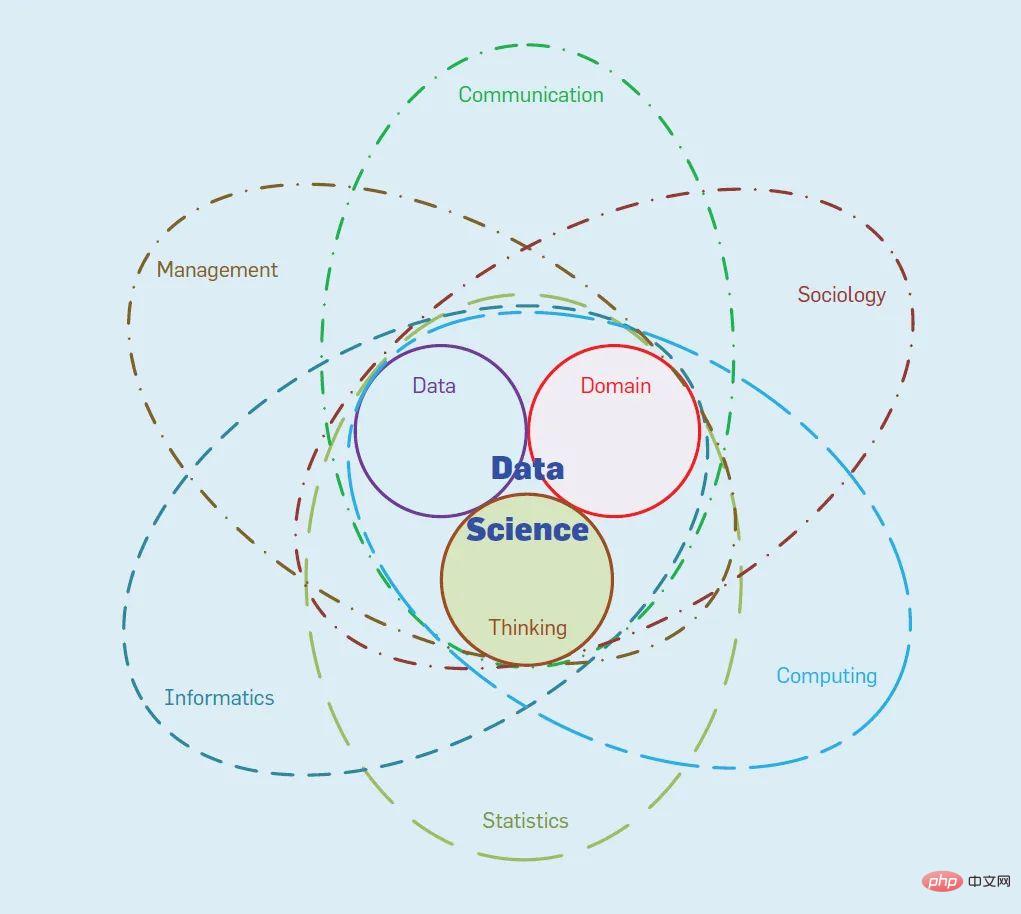

Dieser Artikel bietet eine kurze Einführung in Schlüsselkonzepte des föderierten Lernens und der Analyse. Der Schwerpunkt liegt auf der Kombination von Datenschutztechniken mit realen Systemen und der Nutzung dieser Techniken, um durch aggregierte Statistiken neue Bereiche zu erschließen . Soziale Vorteile und Minimierung der Risiken für Einzelpersonen und Datenverwalter.

Privatsphäre ist im Wesentlichen ein vielschichtiges Konzept mit drei Schlüsselkomponenten: Transparenz und Einwilligung des Nutzers; Datenminimierung und Anonymisierung.

Transparenz und Benutzereinwilligung sind die Grundlage des Datenschutzes: Sie sind die Art und Weise, wie Benutzer die Verwendung ihrer Daten verstehen und anerkennen. Technologien zum Schutz der Privatsphäre können Transparenz und Benutzereinwilligung nicht ersetzen, aber sie erleichtern die Rückleitung, welche Arten von Daten verwendet werden können oder aufgrund ihres Designs ausgeschlossen sind, wodurch Datenschutzerklärungen leichter zu verstehen, zu überprüfen und durchzusetzen sind. Die Hauptziele der Datennutzung bestehen darin, föderierte Lernmodelle zu generieren und Metriken oder andere aggregierte Statistiken von Benutzerdaten zu berechnen (z. B. föderierte Analysen).

Die auf die Aggregation angewendete Datenminimierung umfasst das Sammeln nur der Daten, die für eine bestimmte Berechnung erforderlich sind, die Beschränkung des Zugriffs auf diese Daten in allen Phasen, die Verarbeitung personenbezogener Daten so früh wie möglich und die Aufbewahrung von Daten auf ein Minimum. Das heißt, Datenminimierung bedeutet, den Zugriff auf alle Daten auf die kleinstmögliche Personengruppe zu beschränken, in der Regel durch Sicherheitsmechanismen wie Verschlüsselung, Zugriffskontrolle und sichere Mehrparteien-Berechnungs- und vertrauenswürdige Ausführungsumgebungen.

Datenanonymisierung bedeutet, dass das Endergebnis der Berechnung nichts Einzigartiges für die Person preisgibt. Bei Verwendung zur anonymen Aggregation haben die von jedem einzelnen Benutzer für die Berechnung bereitgestellten Daten nur geringe Auswirkungen auf die endgültige Aggregatausgabe. Wenn beispielsweise aggregierte Statistiken für die Öffentlichkeit freigegeben werden, sollten sich die aggregierten Statistiken, einschließlich der Modellparameter, nicht wesentlich unterscheiden, je nachdem, ob die Daten eines bestimmten Benutzers im Aggregat enthalten sind.

Das heißt, bei der Datenminimierung geht es um die Durchführung von Berechnungen und die Verarbeitung von Daten, während bei der Datenanonymisierung darum geht, was berechnet und veröffentlicht wird.

Federated Learning verkörpert strukturell die Datenminimierung. Es ist wichtig zu beachten, dass Datenerfassung und -aggregation bei einem föderierten Ansatz untrennbar miteinander verbunden sind, Kundendaten zur sofortigen Aggregation transformiert und gesammelt werden und Analysten keinen Zugriff auf die Nachrichten jedes Kunden haben. Föderiertes Lernen und föderierte Analyse sind Beispiele für allgemeine föderierte Rechenmuster, die Praktiken zur Datenminimierung verkörpern. Der traditionelle Ansatz ist die zentralisierte Verarbeitung, die die Vorverarbeitung und Aggregation auf dem Gerät durch die Datenerfassung ersetzt. Während der Verarbeitung von Protokolldaten erfolgt die Datenminimierung auf dem Server.

Die Ziele des föderierten Lernens und der föderierten Analyse stimmen mit den Zielen der anonymen Aggregation überein. Beim maschinellen Lernen besteht das Ziel darin, ein Modell zu trainieren, das alle Benutzer ohne Überanpassung genau vorhersagt. Ebenso besteht das Ziel bei statistischen Abfragen darin, Statistiken zu schätzen, die nicht stark von den Daten eines einzelnen Benutzers beeinflusst werden sollten.

Föderiertes Lernen in Kombination mit datenschutzerhaltenden Techniken wie Differential Privacy kann sicherstellen, dass veröffentlichte Aggregationen über ausreichende Anonymität verfügen. In vielen Fällen gilt die Datenanonymität möglicherweise nicht und ein direkter Zugriff von Dienstanbietern auf die sensiblen Daten einer Person ist unvermeidlich. Bei diesen Interaktionen sollten Dienstanbieter die Daten jedoch nur für den vorgesehenen Zweck verwenden.

Das Merkmal des föderierten Lernens besteht darin, dass es die Dezentralisierung der Originaldaten beibehält und durch Aggregation lernt. Lokal generierte Daten sind in Verteilung und Menge heterogen, was föderiertes Lernen von herkömmlichen verteilten Lernumgebungen auf Rechenzentrumsbasis unterscheidet. Die Daten der letzteren können beliebig verteilt und bereinigt werden, und auf jeden Knoten in der Berechnung kann zugegriffen werden. In der Praxis ist die Rolle eines Kontrollzentrums von Bedeutung und oft notwendig, beispielsweise bei mobilen Geräten, die keine festen IP-Adressen haben und für die Kommunikation einen zentralen Server benötigen.

Es gibt zwei föderierte Szenarien, denen besondere Aufmerksamkeit geschenkt wurde:

Geräteübergreifendes föderiertes Lernen, der Client ist ein große Anzahl Mobilgeräte oder IoT-Geräte.

Für organisationsübergreifendes föderiertes Lernen ist der Kunde normalerweise eine kleinere Organisation, Institution oder eine andere Dateninsel.

Tabelle 1, adaptiert von Kairouz et al.,10 fasst die wichtigsten Merkmale von FL-Einstellungen zusammen und hebt einige wichtige Unterschiede zwischen geräte- und siloübergreifenden Einstellungen sowie dem verteilten Lernkontrast im Rechenzentrum hervor .

Geräteübergreifendes föderiertes Lernen wurde auf Android- bzw. iOS-Telefonen für viele Anwendungen wie Tastaturvorhersagen verwendet. Organisationsübergreifendes föderiertes Lernen wird bei Problemen wie der Gesundheitsforschung eingesetzt. Eine weitere Anwendung auf dem Vormarsch ist das Finanzwesen mit Investitionen von WeBank, Credit Suisse, Intel und anderen.

Die Merkmale typischer föderierter Lernszenarien werden wie in der folgenden Tabelle dargestellt verglichen:

| Data Center Distributed Learning | #🎜 🎜 ##🎜 🎜# Verbundenes Lernen über Organisationen hinweg |

Verbundenes Lernen über Geräte hinweg |

# 🎜 🎜# Konfiguration |

| Trainieren Sie das Modell auf einem großen flachen Datensatz, der Client ist ein Knoten in einem Cluster oder einem Rechenzentrum #🎜 🎜# | Trainingsmodelle über Dateninseln hinweg, die Kunden sind unterschiedliche Organisationen oder Rechenzentren in unterschiedlichen Regionen Die Kunden sind massiv mobil Gerät oder IoT-Gerät | Datenverteilung |

|

| Daten werden lokal generiert und gespeichert, wodurch die Dezentralisierung gewahrt bleibt. Jeder Client kann nicht auf die Daten anderer Clients zugreifen und die Daten sind nicht unabhängig oder homogen verteilt. | Die Daten werden lokal generiert und gespeichert, wodurch die Dezentralisierung gewahrt bleibt. Jeder Client kann nicht auf die Daten anderer Clients zugreifen und die Daten sind nicht unabhängig oder homogen verteilt | ||

Orchestrierung |

Zentralisierter Orchestrierungsdienst, aber die Originaldaten sind nicht sichtbar. |

Zentraler Orchestrierungsdienst, aber die Originaldaten sind nicht sichtbar | Verteilungsskala

| 1~ 1000

2~100 |

zig Millionen |

Kundenattribute | Der Kunde ist authentisch und vertrauenswürdig, nimmt immer an Berechnungen teil und behält den Zustand in Berechnungen bei. |

Der Kunde ist authentisch und vertrauenswürdig, beteiligt sich immer an Berechnungen und behält den Stand der Berechnungen bei. |

Nicht auf allen Clients verfügbar, normalerweise zufällig von verfügbaren Geräten ausgewählt. Eine große Anzahl von Clients nimmt nur einmal an einer Berechnung teil. |

2.2 Federated-Learning-AlgorithmusMaschinelles Lernen, insbesondere Deep Learning, ist im Allgemeinen datenhungrig und rechenintensiv, sodass die Machbarkeit des gemeinsamen Trainings von Qualitätsmodellen noch lange nicht zu einem vorher festgelegten Ergebnis führt. Der föderierte Lernalgorithmus basiert auf dem klassischen stochastischen Gradientenabstiegsalgorithmus, der häufig zum Trainieren von Modellen für maschinelles Lernen in traditionellen Umgebungen verwendet wird. Das Modell ist eine Funktion von Trainingsmustern bis hin zu Vorhersagen, parametrisiert durch einen Vektor von Modellgewichten und eine Verlustfunktion, die den Fehler zwischen den Vorhersagen und der tatsächlichen Ausgabe misst. Durch Abtasten einer Reihe von Trainingsmustern (normalerweise von Zehnern bis Tausenden), Berechnen des durchschnittlichen Gradienten der Verlustfunktion relativ zu den Modellgewichten und anschließendes Anpassen der Modellgewichte in die entgegengesetzte Richtung des Gradienten. Durch entsprechendes Anpassen der Schrittgröße jeder Iteration kann auch für nicht konvexe Funktionen eine zufriedenstellende Konvergenz erzielt werden. Erweitert auf föderiertes Lernen sendet es die aktuellen Modellgewichte an eine zufällige Gruppe von Clients, sodass diese jeweils den Verlustgradienten auf lokalen Daten berechnen, diese Gradienten über die Clients auf dem Server mitteln und dann die globalen Modellgewichte aktualisieren können. Allerdings sind in der Regel mehr Iterationen erforderlich, um ein hochpräzises Modell zu erstellen. Eine grobe Berechnung zeigt, dass in einer föderierten Lernumgebung eine Iteration mehrere Minuten dauern kann, was bedeutet, dass eine föderierte Schulung zwischen einem Monat und einem Jahr dauern kann, was über den Rahmen der Praktikabilität hinausgeht. Der Schlüsselgedanke des föderierten Lernens ist intuitiv, die Kommunikations- und Startkosten zu reduzieren, indem mehrere Schritte des stochastischen Gradientenabstiegs lokal auf jedem Gerät durchgeführt werden, wodurch sich dann die durchschnittliche Anzahl von Modellaktualisierungen verringert. Wenn das Modell nach jedem lokalen Schritt einen Mittelwert ermittelt, ist es möglicherweise zu langsam. Wenn das Modell zu wenige Mittelwerte bildet, kann es zu Abweichungen kommen, und die Mittelwertbildung kann zu einem schlechteren Modell führen. Das Modelltraining kann auf die Anwendung der föderierten Aggregation vereinfacht werden, d. h. auf den Durchschnitt von Modellgradienten oder -aktualisierungen. 2.3 Typischer ArbeitsablaufEin funktionierender föderierter Algorithmus ist ein notwendiger Ausgangspunkt, aber es bedarf noch mehr, wenn geräteübergreifendes föderiertes Lernen ein effektiver Weg zur Förderung von Produktteams sein soll. Für geräteübergreifendes föderiertes Lernen sieht ein typischer Arbeitsablauf normalerweise so aus: (1) Identifizieren Sie das Problem Normalerweise bedeutet dies, dass auf dem Gerät ein Modell mittlerer Größe (1–50 MB) erforderlich ist Gerät Die Daten sind umfangreicher oder repräsentativer als das, was im Rechenzentrum verfügbar ist. Es gibt Datenschutz- oder andere Gründe, die Daten nicht zu zentralisieren. Die zum Trainieren des Modells erforderlichen Rückmeldungen sind auf dem Gerät verfügbar. (2) Modellentwicklung und -bewertung Wie bei jeder maschinellen Lernaufgabe ist die Wahl der richtigen Modellstruktur und der richtigen Hyperparameter (Lernrate, Stapelgröße, Regularisierung) entscheidend für den Erfolg des maschinellen Lernens. Beim föderierten Lernen kann die Herausforderung größer sein, da dadurch viele neue Hyperparameter eingeführt werden, z. B. die Anzahl der an jeder Runde teilnehmenden Clients, die Anzahl der auszuführenden lokalen Schritte usw. Ein üblicher Ausgangspunkt ist die Simulation mithilfe von föderiertem Lernen auf der Grundlage verfügbarer Agentendaten im Rechenzentrum mit grober Modellauswahl und -optimierung. Die endgültige Abstimmung und Bewertung muss mithilfe einer Verbundschulung an realen Geräten durchgeführt werden. Die Bewertung muss auch auf föderierte Weise erfolgen: Unabhängig vom Trainingsprozess werden globale Kandidatenmodelle an die Geräte gesendet, damit Genauigkeitsmetriken anhand der lokalen Datensätze dieser Geräte berechnet und vom Server aggregiert werden können, z. B. ein einfacher Durchschnitt von Sowohl die Leistung als auch die Histogramme jedes Kunden sind wichtig. Diese Anforderungen schaffen zwei wichtige Infrastrukturanforderungen: (1) Bereitstellung einer leistungsstarken föderierten Lernsimulationsinfrastruktur, die einen reibungslosen Übergang zur Ausführung auf realen Geräten ermöglicht; (2) eine geräteübergreifende Infrastruktur, die die Verwaltung mehrerer gleichzeitiger Schulungen und Auswertungen erleichtert; ausgeführte Aufgaben. (3) Bereitstellung Sobald in Schritt 2 ein qualitativ hochwertiges Kandidatenmodell ausgewählt wurde, folgt die Bereitstellung des Modells normalerweise dem gleichen Verfahren wie ein im Rechenzentrum trainiertes Modell, einschließlich zusätzlicher Validierung und Tests (die manuelle Qualität umfassen können). garantiert), Live-A/B-Tests mit früheren Produktionsmodellen und eine schrittweise Einführung auf die gesamte Geräteflotte (die möglicherweise um Größenordnungen mehr Geräte umfasst, als tatsächlich am Modelltraining teilgenommen haben). Es ist erwähnenswert, dass die gesamte Arbeit in Schritt 2 keine Auswirkungen auf die Benutzererfahrung der an der Schulung und Bewertung beteiligten Geräte hat. Bei Modellen, die mit föderiertem Lernen trainiert wurden, können Benutzer keine Vorhersagen sehen, es sei denn, sie schließen den Bereitstellungsschritt ab. Eine zentrale Herausforderung für die Infrastruktur besteht darin sicherzustellen, dass sich diese Verarbeitung nicht negativ auf die Ausrüstung auswirkt. Beispielsweise können intensive Berechnungen nur durchgeführt werden, wenn das Gerät und das Netzwerk im Leerlauf sind. Diese Arbeitsabläufe stellen eine erhebliche Herausforderung für den Aufbau skalierbarer Infrastruktur und APIs dar. 3. Datenschutz beim Federated ComputingFederated Learning bietet sofort verschiedene Vorteile für den Datenschutz. Nach dem Prinzip der Datenminimierung verbleiben die Rohdaten auf dem Gerät und an den Server gesendete Updates werden zielgerichtet und schnellstmöglich aggregiert. Insbesondere werden keine nicht aggregierten Daten auf dem Server gespeichert, eine Ende-zu-Ende-Verschlüsselung schützt die Daten während der Übertragung und sowohl Entschlüsselungsschlüssel als auch entschlüsselte Werte werden nur vorübergehend im RAM gespeichert. Ingenieure und Analysten für maschinelles Lernen, die mit dem System interagieren, haben nur Zugriff auf aggregierte Daten. Die Aggregation spielt eine grundlegende Rolle bei föderierten Ansätzen und macht es daher selbstverständlich, die Auswirkungen eines einzelnen Clients auf die Ausgabe zu begrenzen. Wenn das Ziel jedoch darin besteht, formellere Garantien wie z. B. differenziellen Datenschutz bereitzustellen, muss der Algorithmus sorgfältig entworfen werden. Obwohl sich grundlegende föderierte Lernmethoden als machbar erwiesen haben und weit verbreitet sind, werden sie aufgrund von Fairness, Genauigkeit, Entwicklungsgeschwindigkeit und Rechenkosten noch lange nicht standardmäßig verwendet Ansätze zur Datenminimierung und Anonymisierung. Daher benötigen wir zusammensetzbare Techniken zur Verbesserung der Privatsphäre. Letztendlich werden Entscheidungen über den Einsatz von Datenschutztechnologien vom Produkt- oder Serviceteam in Absprache mit Datenschutz-, Richtlinien- und Rechtsexperten in dem jeweiligen Bereich getroffen. Produkte können durch verfügbare föderierte Lernsysteme zusätzlichen Schutz der Privatsphäre bieten und, was vielleicht noch wichtiger ist, Politikexperten dabei helfen, Datenschutzdefinitionen und -anforderungen im Laufe der Zeit zu verbessern. Bei der Betrachtung der Datenschutzfunktionen von Verbundsystemen ist es sinnvoll, Zugriffspunkte und Bedrohungsmodelle zu berücksichtigen. Haben die Teilnehmer Zugang zu einem physischen Gerät oder Netzwerk? Über Root oder physischen Zugriff auf den Server, der FL bedient? Modelle und Metriken für Ingenieure des maschinellen Lernens freigeben? Endgültiges bereitgestelltes Modell? Während Informationen durch dieses System fließen, variiert die Anzahl potenziell böswilliger Parteien stark. Daher müssen Datenschutzerklärungen als vollständiges End-to-End-System bewertet werden. Wenn keine geeigneten Sicherheitsmaßnahmen ergriffen werden, um die Rohdaten auf dem Gerät oder den Rechenzwischenzustand während der Übertragung zu schützen, spielt die Garantie, ob das letztendlich eingesetzte Modell Benutzerdaten speichert, möglicherweise keine Rolle. Datenminimierung begegnet potenziellen Bedrohungen für Geräte, Netzwerke und Server, indem sie die Sicherheit erhöht und die Aufbewahrung von Daten und Zwischenergebnissen minimiert. Wenn Modelle und Metriken für Modellingenieure veröffentlicht oder in Produktionsumgebungen bereitgestellt werden, schützt die anonyme Aggregation personenbezogene Daten vor Parteien, die auf diese veröffentlichten Ausgaben zugreifen. 3.1 Minimierung aggregierter DatenAn mehreren Punkten im Federated Computing erwarten die Teilnehmer voneinander, dass sie geeignete Maßnahmen ergreifen, und zwar nur diese Maßnahmen. Beispielsweise erwarten Server, dass die Clients ihre Vorverarbeitungsschritte korrekt ausführen; Clients und Server erwarten, dass weder Datenanalysten noch Benutzer von bereitgestellten maschinellen Lernmodellen persönliche Daten extrahieren können; . Privatsphäre-wahrende Technologie unterstützt die strukturelle Umsetzung dieser komponentenübergreifenden Komponenten und verhindert, dass Teilnehmer davon abweichen. Tatsächlich kann das föderierte System selbst als Technologie zum Schutz der Privatsphäre angesehen werden, die den Server strukturell daran hindert, auf Clientdaten zuzugreifen, die nicht in den vom Client übermittelten Updates enthalten sind. Nehmen Sie als Beispiel die Aggregationsphase. Ein ideales System würde sich einen vollständig vertrauenswürdigen Drittanbieter vorstellen, der Aktualisierungen vom Client aggregiert und nur die endgültige Aggregation dem Server anzeigt. In der Praxis gibt es normalerweise keinen solchen gegenseitig vertrauenswürdigen Dritten, der diese Rolle spielt, aber verschiedene Techniken ermöglichen es föderierten Lernsystemen, einen solchen Dritten unter verschiedenen Bedingungen zu simulieren. Zum Beispiel kann ein Server den Aggregationsprozess innerhalb einer sicheren Enklave ausführen, bei der es sich um ein speziell konstruiertes Stück Hardware handelt, das dem Client nicht nur nachweist, welchen Code es ausführt, sondern auch sicherstellt, dass niemand kann die Ausführung von Code beobachten oder manipulieren. Allerdings ist die Verfügbarkeit sicherer Umgebungen, sei es in der Cloud oder auf Verbrauchergeräten, derzeit begrenzt und die verfügbaren Sicherheitsumgebungen implementieren möglicherweise nur wenige bestimmte Eigenschaftsbereiche. Darüber hinaus können sichere Umgebungen, selbst wenn sie verfügbar und voll funktionsfähig sind, zusätzliche Einschränkungen mit sich bringen, einschließlich sehr begrenztem Speicher oder Geschwindigkeit; Dienstleistungen des Herstellers (z. B. Schlüsselvertraulichkeit) usw. Verteilte Verschlüsselungsprotokolle für sichere Mehrparteienberechnungen können gemeinsam verwendet werden, um vertrauenswürdige Dritte zu simulieren, ohne dass spezielle Hardware erforderlich ist, sofern die Teilnehmer ehrlich genug sind. Während die sichere Mehrparteienberechnung beliebiger Funktionen in den meisten Fällen eine rechentechnische Hürde darstellt, wurden spezielle Aggregationsalgorithmen für die Vektorsummierung in Verbundumgebungen entwickelt, die die Privatsphäre selbst gegenüber einem Gegner schützen, der den Server beobachtet und die Mehrheit der Clients kontrolliert, und gleichzeitig die Privatsphäre wahren Robustheit gegenüber Client-Exit-Berechnungen: Kommunikationseffizienz – O (log n + l) Kommunikation pro Client, wobei n die Anzahl der Benutzer und l die Vektorlänge darstellt, über einen weiten Bereich von In-Anwendungen, Der durch kleine Konstanten erzeugte Datenverkehr ist weniger als doppelt so hoch wie der Gesamtdatenverkehr. Kryptografisch sichere Aggregationsprotokolle wurden in großem Umfang in kommerziellen Verbundrechnersystemen eingesetzt. Zusätzlich zu privaten Aggregationen können Techniken zur Wahrung der Privatsphäre verwendet werden, um andere Teile des föderierten Systems zu schützen. Beispielsweise können eine sichere Umgebung oder kryptografische Techniken (z. B. Zero-Knowledge-Proofs) sicherstellen, dass der Server darauf vertrauen kann, dass der Client die Vorverarbeitung wahrheitsgemäß durchgeführt hat. Sogar die Modellübertragungsphase kann davon profitieren: Bei vielen Lernaufgaben verfügt ein einzelner Client möglicherweise nur über Daten, die für einen kleinen Teil des Modells relevant sind. In diesem Fall kann der Client diesen Teil des Modells privat zum Training abrufen und erneut eine sichere Umgebung verwenden oder Verschlüsselungstechniken, um sicherzustellen, dass der Server keinen Teil des Modells lernt, der Trainingsdaten enthält, die mit dem Client verknüpft sind. 3.2 Berechnete und verifizierte anonyme AggregationenSichere Umgebungen und Datenschutz-Aggregationstechniken können zwar die Datenminimierung verbessern, sind jedoch nicht speziell für die Generierung anonymer Aggregate konzipiert. Begrenzen Sie beispielsweise den Benutzereinfluss auf das zu trainierende Modell. Tatsächlich kann das erlernte Modell in einigen Fällen vertrauliche Informationen preisgeben. Die Standardmethode der Datenanonymisierung ist Differential Privacy. Für den allgemeinen Prozess der Aggregation von Datensätzen in einer Datenbank erfordert der differenzielle Datenschutz die Begrenzung des Beitrags eines Datensatzes zur Aggregation und die anschließende Hinzufügung einer entsprechend proportionalen zufälligen Störung. Beispielsweise wird im differenziell privaten stochastischen Gradientenabstiegsalgorithmus die Norm des Gradienten abgeschnitten, die abgeschnittenen Gradienten werden aggregiert und in jeder Trainingsepoche wird Gaußsches Rauschen hinzugefügt. Differenzielle Datenschutzalgorithmen sind notwendigerweise stochastisch, sodass die Verteilung des vom Algorithmus erzeugten Modells in einem bestimmten Datensatz berücksichtigt werden kann. Intuitiv ist diese Verteilung zwischen Modellen ähnlich, wenn ein differenziell privater Algorithmus für einen einzelnen Eingabedatensatz mit unterschiedlichen Datensätzen ausgeführt wird. Formal wird die unterschiedliche Privatsphäre durch einen Privatsphärenverlustparameter (ε, δ) quantifiziert, wobei ein kleinerer Wert (ε, δ) einer erhöhten Privatsphäre entspricht. Dies geht über die bloße Beschränkung der Empfindlichkeit des Modells auf jeden Datensatz hinaus, indem Rauschen proportional zur Auswirkung eines Datensatzes hinzugefügt wird, wodurch genügend Zufälligkeit gewährleistet wird, um den Beitrag eines Datensatzes zur Ausgabe zu maskieren. Im Szenario des geräteübergreifenden Verbundlernens werden Datensätze als alle Trainingsinstanzen eines einzelnen Benutzers/Clients definiert. Der differenzielle Datenschutz kann auf Benutzerebene oder proportional erfolgen. Selbst in zentralisierten Konfigurationen eignen sich föderierte Lernalgorithmen gut für das Training mit Datenschutzgarantien auf Benutzerebene, da sie eine einzige Modellaktualisierung aus allen Daten für einen Benutzer berechnen und es so einfacher machen, den Beitrag jedes Benutzers zur Gesamtwirkung der Modellaktualisierung zu binden. Die Bereitstellung formaler (ε, δ)-Garantien im Kontext von geräteübergreifenden föderierten Lernsystemen kann eine besondere Herausforderung darstellen, da die Menge aller berechtigten Benutzer dynamisch und nicht im Voraus bekannt ist und die teilnehmenden Benutzer dies möglicherweise tun An jedem Punkt der Trainingsphase bleibt der Aufbau eines End-to-End-Protokolls, das für produktive föderierte Lernsysteme geeignet ist, ein wichtiges Problem, das gelöst werden muss. Im Szenario des organisationsübergreifenden Verbundlernens können Datenschutzeinheiten unterschiedliche Bedeutungen haben. Beispielsweise können Datensätze als alle Beispiele in einem Datensilo definiert werden, wenn teilnehmende Institutionen den Zugriff auf Modelliterationen sicherstellen möchten oder wenn das endgültige Modell nicht feststellen kann, ob der Datensatz einer bestimmten Institution zum Training des Modells verwendet wurde. Differenzierter Datenschutz auf Benutzerebene ist in organisationsübergreifenden Umgebungen immer noch sinnvoll. Wenn jedoch mehrere Institutionen über Datensätze desselben Benutzers verfügen, kann die Durchsetzung der Privatsphäre auf Benutzerebene eine größere Herausforderung darstellen. Die differenzielle Datenschutzdatenanalyse wurde in der Vergangenheit hauptsächlich für zentrale oder vertrauenswürdige Aggregatoren verwendet, bei denen Rohdaten von vertrauenswürdigen Dienstanbietern gesammelt werden, die differenzielle Datenschutzalgorithmen implementieren. Lokaler differenzieller Datenschutz macht einen vollständig vertrauenswürdigen Aggregator überflüssig, führt jedoch zu einem drastischen Rückgang der Genauigkeit. Um den Nutzen der zentralisierten differenziellen Privatsphäre wiederherzustellen, ohne auf einen vollständig vertrauenswürdigen zentralen Server angewiesen zu sein, können einige neue Methoden verwendet werden, die oft als verteilte differenzielle Privatsphäre bezeichnet werden. Das Ziel besteht darin, die Ausgabe unterschiedlich privat zu machen, bevor der Server sie sieht (im Klartext). Beim verteilten differenziellen Datenschutz berechnet der Client zunächst anwendungsspezifische Minimaldaten, stört diese Daten leicht mit zufälligem Rauschen und führt das Datenschutz-Aggregationsprotokoll aus. Der Server hat dann nur Zugriff auf die Ausgabe des Privacy Aggregation Protocol. Der durch einen einzelnen Kunden verursachte Lärm reicht in der Regel nicht aus, um sinnvolle Garantien für eine lokale Differenzierung zu bieten. Nach der Datenschutzaggregation bietet die Ausgabe des Datenschutzaggregationsprotokolls jedoch stärkere DP-Garantien basierend auf der Summe des Rauschens über alle Clients hinweg. Basierend auf den vom Privacy Aggregation Protocol geforderten Sicherheitsannahmen gilt dies sogar für Personen mit Serverzugriff. Damit ein Algorithmus formale Datenschutzgarantien auf Benutzerebene bietet, muss nicht nur die Sensibilität des Modells an die Daten jedes Benutzers gebunden sein, sondern es muss auch Rauschen hinzugefügt werden, das proportional zu dieser Sensibilität ist. Während ausreichend Zufallsrauschen hinzugefügt werden muss, um sicherzustellen, dass die Definition der differenziellen Privatsphäre ein ausreichend kleines ε hat, um starke Garantien zu bieten, kann die Einschränkung der Empfindlichkeit selbst bei geringem Rauschen die Entschlüsselung erheblich reduzieren. Denn die differenzielle Privatsphäre setzt einen „Worst-Case-Gegner“ mit unbegrenzter Rechenleistung und Zugriff auf Informationen auf beiden Seiten voraus. Diese Annahmen sind in der Praxis oft unrealistisch. Daher bietet das Training mit differenziell privaten Algorithmen erhebliche Vorteile, die den Einfluss jedes Benutzers begrenzen. Der Entwurf praktischer föderierter Lern- und föderierter Analysealgorithmen zur Erzielung kleiner ε-Garantien ist jedoch ein wichtiger Forschungsbereich. Modellaudittechniken können verwendet werden, um die Vorteile des Trainings mit differenzierter Privatsphäre weiter zu quantifizieren. Dazu gehört die Quantifizierung des Ausmaßes, in dem ein Modell überlernt oder seltene Trainingsbeispiele, und die Quantifizierung des Ausmaßes, in dem abgeleitet werden kann, ob ein Benutzer die Technik während des Trainings verwendet hat. Diese Prüfungstechniken sind auch bei Verwendung großer ε nützlich und können die Lücke zwischen unterschiedlich privaten Worst-Case-Gegnern und realistischen Gegnern mit begrenzter Rechenleistung und Nebeninformationen quantifizieren. Sie können auch als ergänzende Techniken zu Stresstests dienen: Im Gegensatz zu formalen mathematischen Behauptungen über differenziellen Datenschutz gelten diese Prüftechniken für komplette End-to-End-Systeme und können möglicherweise Softwarefehler oder falsche Parameterauswahlen erkennen. 4. VerbundanalyseZusätzlich zum Erlernen maschineller Lernmodelle sind Datenanalysten häufig daran interessiert, datenwissenschaftliche Methoden anzuwenden, um Rohdaten auf lokalen Benutzergeräten zu analysieren. Analysten könnten beispielsweise an aggregierten Modellmetriken, beliebten Trends und Aktivitäten oder Geodaten-Standort-Heatmaps interessiert sein. All dies kann mit föderierten Analysen erreicht werden. Ähnlich wie beim föderierten Lernen werden bei der föderierten Analyse lokale Berechnungen für die Daten jedes Geräts ausgeführt und nur aggregierte Ergebnisse bereitgestellt. Im Gegensatz zum föderierten Lernen ist die föderierte Analyse jedoch darauf ausgelegt, grundlegende datenwissenschaftliche Anforderungen wie Zählungen, Durchschnittswerte, Histogramme, Quantile und andere SQL-ähnliche Abfragen zu unterstützen. Für eine Anwendung, bei der ein Analyst eine Verbundanalyse verwenden möchte, um die zehn meistgespielten Songs in einer von vielen Benutzern geteilten Musikbibliothek zu erfahren. Diese Aufgabe kann mithilfe der oben erläuterten Verbund- und Datenschutztechniken ausgeführt werden. Beispielsweise könnten Clients die Songs, die sie gehört haben, in einen binären Vektor mit einer Länge kodieren, die der Größe der Bibliothek entspricht, und mithilfe der verteilten differenziellen Privatsphäre sicherstellen, dass der Server nur einen Wert dieser Vektoren sehen kann, abhängig von der Anzahl der gespielten Benutzer jedes Lied Das differenzielle Datenschutzhistogramm von . Verbundanalyseaufgaben unterscheiden sich jedoch in mehreren Aspekten von Verbundlernaufgaben: Verbundanalysealgorithmen sind normalerweise nicht interaktiv und umfassen eine große Anzahl von Clients. Mit anderen Worten: Anders als bei föderierten Lernanwendungen gibt es keine geringeren Erträge, wenn man mehr Kunden in einer Runde hat. Daher ist die Anwendung der differenziellen Privatsphäre in der Verbundanalyse weniger schwierig, da jede Runde eine größere Anzahl von Clients umfassen kann und weniger Runden erfordert. Es besteht keine Notwendigkeit, dass dieselben Kunden in nachfolgenden Runden erneut teilnehmen. Tatsächlich kann die erneute Ansprache von Kunden auch die Ergebnisse des Algorithmus beeinflussen. Daher wird die Aufgabe der Verbundanalyse am besten durch eine Infrastruktur erfüllt, die die Anzahl der Teilnahmen einzelner Personen begrenzt. Föderierte Analyseaufgaben sind oft spärlich, was eine effiziente Privacy-Sparse-Aggregation zu einem besonders wichtigen Thema macht. Es ist erwähnenswert, dass eine eingeschränkte Kundenbeteiligung und eine spärliche Aggregation zwar besonders relevant für die föderierte Analyse sind, aber auch auf föderierte Lernprobleme angewendet werden können. 5. ZusammenfassungFöderiertes Lernen wird auf mehr Datentypen und Problembereiche angewendet und gilt sogar als wichtige Methode des Privacy Computing, also des Schutzes der Privatsphäre Für KI sind die Mittel und die persönliche Energie begrenzt. In diesem Artikel werden die Herausforderungen der Personalisierung, Robustheit, Fairness und Systemimplementierung beim föderierten Lernen nicht behandelt. In Bezug auf die Praxis des föderierten Lernens könnte TensorFlow Federated ein guter Ausgangspunkt sein. |

Das obige ist der detaillierte Inhalt vonFöderiertes Lernen im Privacy Computing. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!