Das Erlernen mehrerer Aufgaben in einer offenen Umgebung ist eine wichtige Fähigkeit von Allzweckagenten. Als beliebtes Open-World-Spiel verfügt Minecraft über eine unendlich generierte komplexe Welt und eine große Anzahl offener Aufgaben. Es hat sich in den letzten Jahren zu einer wichtigen Testumgebung für die Open-Learning-Forschung entwickelt.

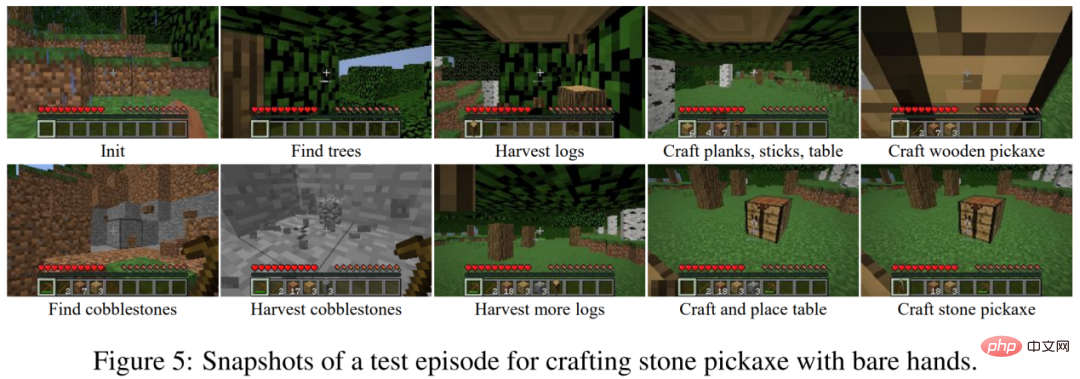

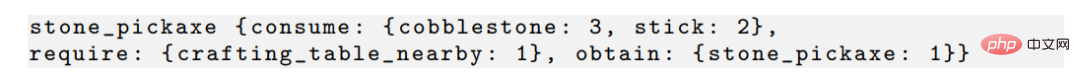

Das Erlernen komplexer Aufgaben in Minecraft ist eine große Herausforderung für aktuelle Reinforcement-Learning-Algorithmen. Einerseits sucht der Agent durch lokale Beobachtungen in einer unendlichen Welt nach Ressourcen und steht vor der Schwierigkeit der Erkundung. Andererseits erfordern komplexe Aufgaben oft lange Ausführungszeiten und erfordern die Erledigung vieler impliziter Teilaufgaben. Die Herstellung einer Steinspitzhacke umfasst beispielsweise mehr als zehn Unteraufgaben wie das Fällen von Bäumen, die Herstellung von Holzspitzhacken und das Graben von Rohsteinen usw., für deren Ausführung der Agent Tausende von Schritten ausführen muss. Der Agent kann nur Belohnungen erhalten, wenn er Aufgaben erledigt, und es ist schwierig, Aufgaben durch spärliche Belohnungen zu erlernen.

Bild: Der Prozess der Herstellung einer Steinspitzhacke in Minecraft.

Aktuelle Forschung rund um den MineRL-Diamantenabbauwettbewerb verwendet im Allgemeinen von Experten demonstrierte Datensätze, während Forschung wie VPT eine große Anzahl gekennzeichneter Datenlernstrategien verwendet. Ohne zusätzliche Datensätze ist das Trainieren von Minecraft mit Reinforcement Learning sehr ineffizient. MineAgent kann mit dem PPO-Algorithmus nur wenige einfache Aufgaben erledigen; die modellbasierte SOTA-Methode Dreamer-v3 muss außerdem 10 Millionen Schritte abtasten, um bei der Vereinfachung des Umgebungssimulators zu lernen, Rohsteine zu erhalten.

Das Team der Peking-Universität und des Beijing Zhiyuan Artificial Intelligence Research Institute schlug Plan4MCvor, eine Methode zur effizienten Lösung von Minecraft-Multitasking ohne Expertendaten. Der Autor kombiniert verstärkendes Lernen und Planungsmethoden, um die Lösung komplexer Aufgaben in zwei Teile zu zerlegen: das Erlernen grundlegender Fähigkeiten und die Fähigkeitsplanung. Die Autoren verwenden intrinsische Lernmethoden zur Belohnungsverstärkung, um drei Arten feinkörniger Grundkompetenzen zu trainieren. Der Agent verwendet ein umfangreiches Sprachmodell, um ein Fähigkeitsbeziehungsdiagramm zu erstellen, und erhält durch die Suche im Diagramm eine Aufgabenplanung. Im experimentellen Teil kann Plan4MC derzeit 24 komplexe und vielfältige Aufgaben erledigen, und die Erfolgsquote wurde im Vergleich zu allen Basismethoden erheblich verbessert.

In Minecraft können Spieler Hunderte von Gegenständen durch Erkundung erhalten. Eine Aufgabe ist als eine Kombination aus Anfangsbedingungen und Zielelementen definiert, zum Beispiel „Initialisieren Sie die

Werkbank und erhalten Sie gekochtes Rindfleisch“. Die Lösung dieser Aufgabe umfasst Schritte wie „Rindfleisch holen“ und „Ofen mit Werkbank und Rohstein bauen“. Diese unterteilten Schritte werden als Fertigkeiten bezeichnet. Menschen erwerben und kombinieren solche Fähigkeiten, um verschiedene Aufgaben auf der Welt zu erledigen, anstatt jede Aufgabe einzeln zu lernen. Das Ziel von Plan4MC besteht darin, Strategien zu erlernen, um eine große Anzahl von Fähigkeiten zu beherrschen und diese Fähigkeiten dann durch Planung zu Aufgaben zu kombinieren.

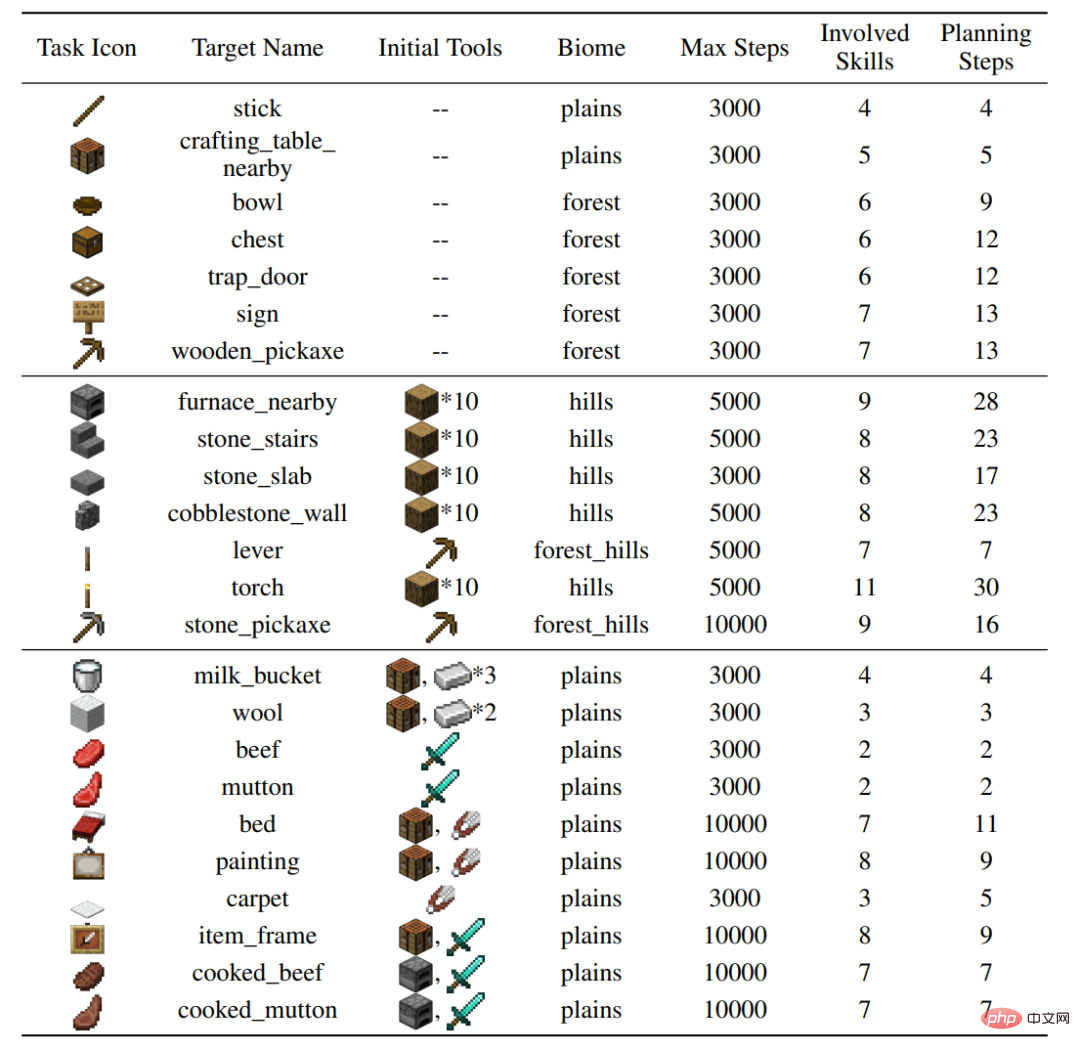

Der Autor hat 24 Testaufgaben für den MineDojo-Simulator erstellt, die eine Vielzahl von Verhaltensweisen (Bäume fällen, raue Steine graben, Interaktion mit Tieren) und verschiedene Gelände abdecken und 37 Grundfertigkeiten umfassen. Zur Erledigung einzelner Aufgaben sind Dutzende Schritte an Fertigkeiten und Tausende Schritte an Umweltinteraktionen erforderlich.务 Abbildung: Einstellungen von 24 Aufgaben

2, Plan4mc-Methode

Lernfähigkeiten

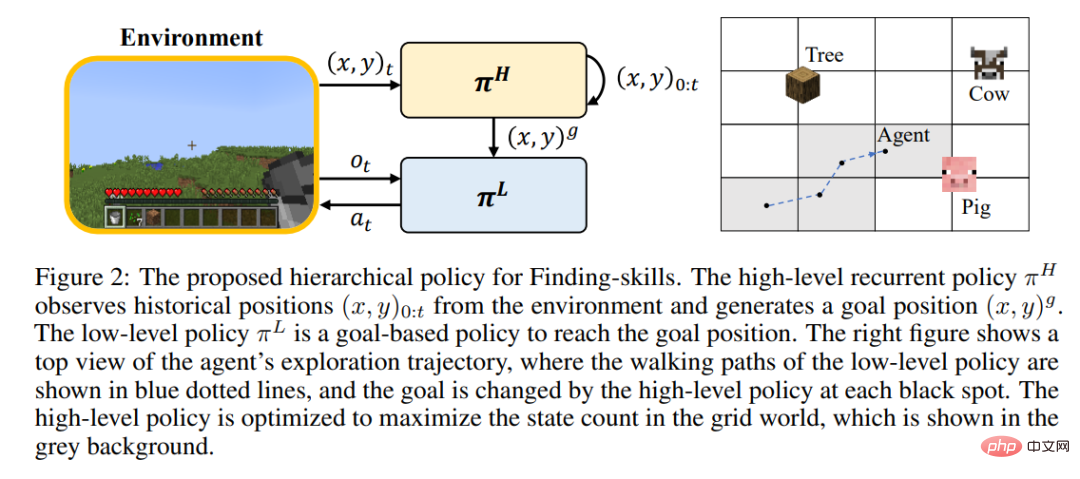

Da es Spielern durch verstärktes Lernen schwerfällt, während des Trainings zu rennen und die Welt in großem Maßstab zu erkunden, können viele Fähigkeiten immer noch nicht beherrscht werden. Der Autor schlug vor, die Schritte Erkundung und Suche zu trennen und die Fertigkeit „Baumfällen“ weiter zu verfeinern in „Bäume finden“ und „Holz beschaffen“. Alle Fertigkeiten in Minecraft sind in drei Kategorien fein abgestufter Grundfertigkeiten unterteilt:

Für jede Art von Fähigkeit entwirft der Autor ein verstärkendes Lernmodell und intrinsische Belohnungen für effizientes Lernen. Suchfähigkeiten verwenden eine hierarchische Strategie, bei der die Strategie der oberen Ebene für die Angabe des Zielorts und die Vergrößerung der Erkundungsreichweite verantwortlich ist und die Strategie der unteren Ebene für das Erreichen des Zielorts verantwortlich ist. Operative Fähigkeiten werden mithilfe des PPO-Algorithmus in Kombination mit der intrinsischen Belohnung des MineCLIP-Modells trainiert. Synthetische Fertigkeiten erfordern nur eine Aktion zum Abschließen. Auf dem unveränderten MineDojo-Simulator sind zum Erlernen aller Fertigkeiten nur 6,5 Millionen Schritte der Interaktion mit der Umgebung erforderlich.

Planungsalgorithmus

Plan4MC nutzt die Abhängigkeiten zwischen Fähigkeiten für die Planung. Beispielsweise besteht der folgende Zusammenhang zwischen der Beschaffung eines Steinpickels und der Beschaffung von Rohsteinen, Holzstäben, platzierter Werkbank und andere Fähigkeiten.

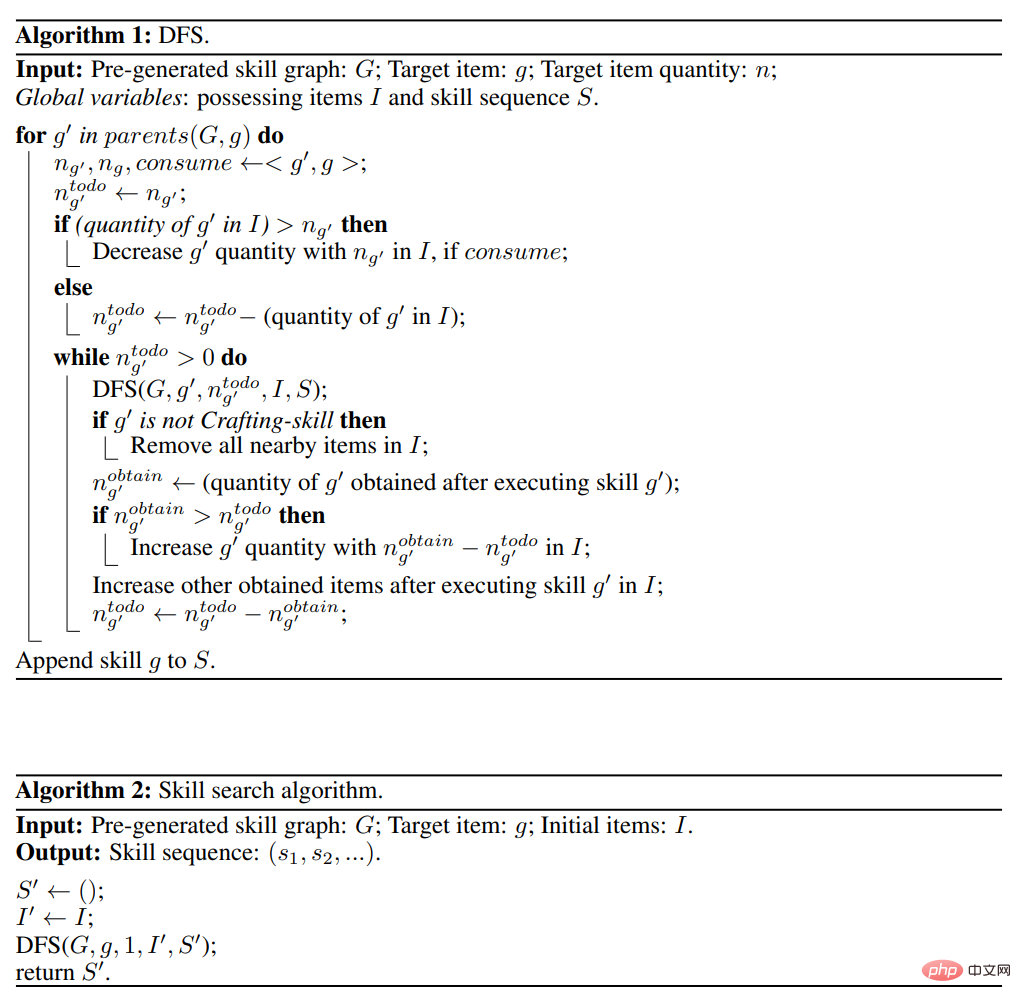

Der Autor generierte die Beziehung zwischen allen Fähigkeiten durch Interaktion mit dem großen Sprachmodell ChatGPT und erstellte einen gerichteten azyklischen Graphen der Fähigkeiten. Der Planungsalgorithmus ist eine Tiefensuche im Fähigkeitsdiagramm, wie in der folgenden Abbildung dargestellt.

Im Vergleich zu Inner Monologue, DEPS und anderen Methoden der interaktiven Planung mit großen Sprachmodellen kann Plan4MC Fehler im Planungsprozess großer Sprachmodelle effektiv vermeiden.

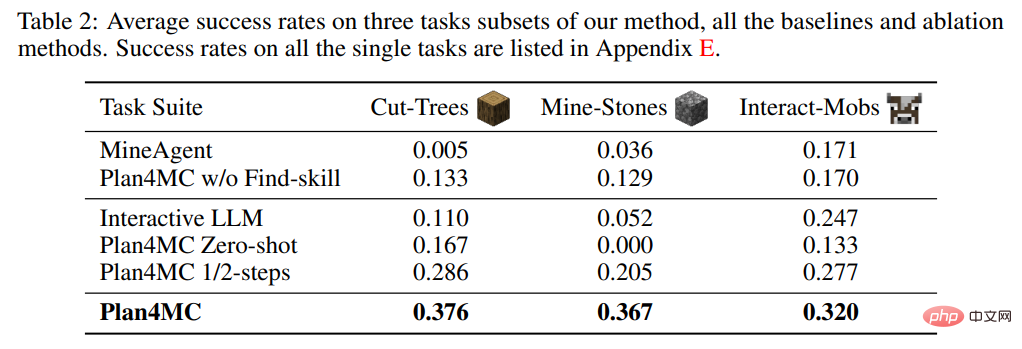

Bei der Untersuchung der Lernfähigkeiten führte der Autor MineAgent ohne Aufgabenzerlegung und ein Ablationsexperiment Plan4MC ohne Suchen ein, das die Suchfähigkeiten nicht unterteilte. Tabelle 2 zeigt, dass Plan4MC die Basismethoden bei allen drei Aufgabensätzen deutlich übertrifft. Die Leistung von MineAgent kommt bei einfachen Aufgaben wie dem Melken von Kühen und dem Scheren von Schafen der von Plan4MC nahe, kann jedoch Aufgaben wie das Fällen von Bäumen und das Graben grober Steine, die schwer zu erkunden sind, nicht erledigen. Die Methode ohne Skill-Segmentierung hat bei allen Aufgaben eine geringere Erfolgsquote als Plan4MC.

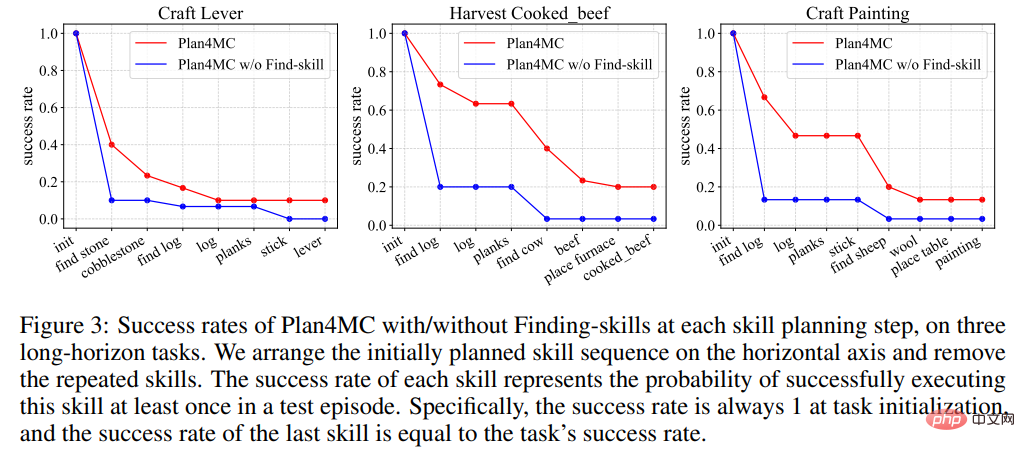

Abbildung 3 zeigt, dass jede Methode bei der Erledigung der Aufgabe eine größere Wahrscheinlichkeit aufweist, dass sie in der Phase der Zielfindung fehlschlägt, was zu einem Rückgang der Erfolgsratenkurve führt. Die Ausfallwahrscheinlichkeit der Methode ohne Skill-Segmentierung ist in diesen Phasen deutlich höher als die von Plan4MC.

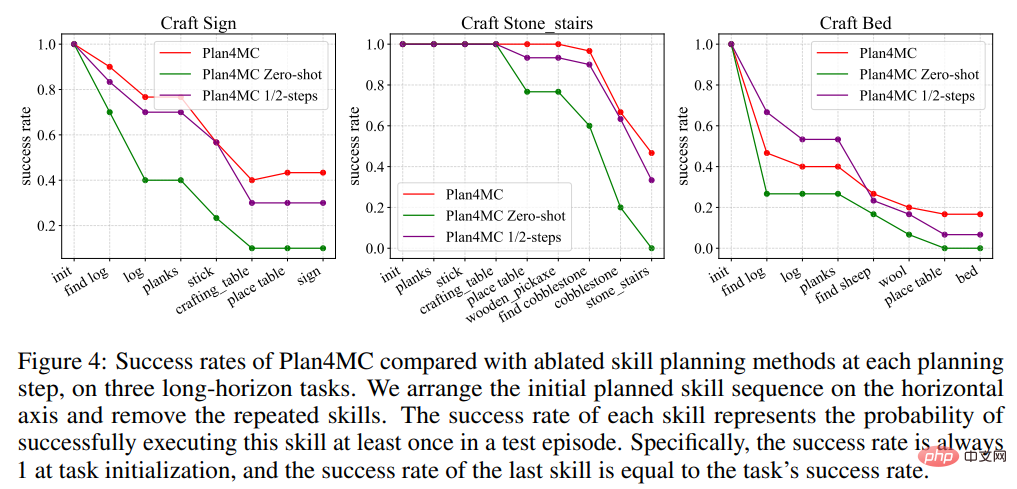

In der Planungsforschung stellte der Autor Interactive LLM vor, eine Basismethode für die interaktive Planung mit ChatGPT, und zwei Ablationsexperimente: die Zero-Shot-Methode, die nicht neu plant, wenn die Fertigkeitsausführung fehlschlägt, und die Verwendung der Hälfte des Maximums Anzahl der Interaktionsschritte Die 1/2-Schritte-Methode. Tabelle 2 zeigt, dass Interactive LLM bei der Aufgabengruppe „Interaktion mit Tieren“ ähnlich gut wie Plan4MC abschneidet, bei den anderen beiden Aufgabengruppen, die mehr Planungsschritte erfordern, jedoch eine schlechte Leistung erbringt. Zero-Shot-Methoden schneiden bei allen Aufgaben schlecht ab. Die Erfolgsquote bei der Verwendung der Hälfte der Schritte ist nicht viel geringer als die von Plan4MC. Es scheint, dass Plan4MC die Aufgabe mit weniger Schritten effizient erledigen kann.

Der Autor schlug Plan4MC vor, das Verstärkungslernen und Planung zur Lösung mehrerer Aufgaben in Minecraft nutzt. Um die Probleme der Erkundungsschwierigkeit und der Stichprobeneffizienz zu lösen, verwendet der Autor Verstärkungslernen mit intrinsischer Belohnung, um grundlegende Fähigkeiten zu trainieren, und verwendet große Sprachmodelle, um Fähigkeitsdiagramme für die Aufgabenplanung zu erstellen. Die Autoren überprüften die Vorteile von Plan4MC im Vergleich zu verschiedenen Basismethoden, einschließlich ChatGPT, bei einer Vielzahl schwieriger Minecraft-Aufgaben.

Fazit: Verstärkung der Lernfähigkeiten + große Sprachmodelle + Aufgabenplanung ermöglichen die Implementierung des von Daniel Kahneman beschriebenen menschlichen Entscheidungsfindungsmodells System1/2.

Das obige ist der detaillierte Inhalt vonVerwenden Sie ChatGPT und Reinforcement Learning, um „Minecraft' zu spielen. Plan4MC meistert 24 komplexe Aufgaben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Gründe, warum die Homepage nicht geändert werden kann

Gründe, warum die Homepage nicht geändert werden kann So erhalten Sie Bitcoin

So erhalten Sie Bitcoin Wo Sie Douyin-Live-Wiederholungen sehen können

Wo Sie Douyin-Live-Wiederholungen sehen können Lösung des Problems, dass die Eingabe beim Hochfahren des Computers nicht unterstützt wird

Lösung des Problems, dass die Eingabe beim Hochfahren des Computers nicht unterstützt wird Standarddrucker festlegen

Standarddrucker festlegen Was ist der Unterschied zwischen Datenbankansichten und Tabellen?

Was ist der Unterschied zwischen Datenbankansichten und Tabellen? Welche Währung ist STAKE?

Welche Währung ist STAKE? WeChat-Momente können nicht aktualisiert werden

WeChat-Momente können nicht aktualisiert werden